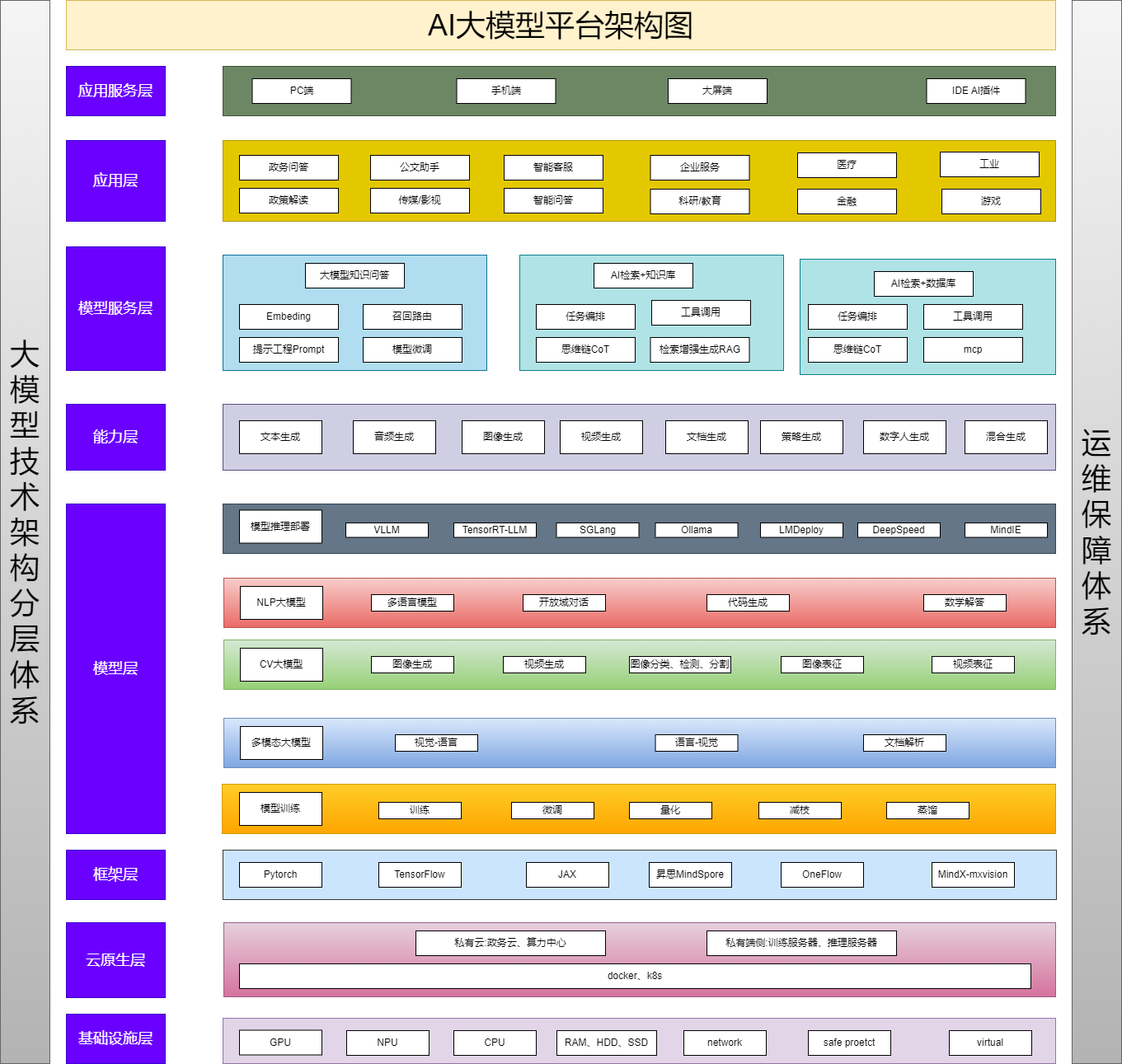

大模型应用平台架构

整个架构主要分为8个层次,分别是基础设施层、云原生层、框架层、模型层、能力层、模型服务层、应用层、应用服务层。这些层次共同构成了一个完整的技术生态系统,从底层硬件支持到顶层应用呈现,层层递进,相辅相成。

一、基础设施层

基础设施层是 AI 大模型平台运行的硬件根基。GPU(图形处理器)和 NPU(微处理器)凭借强大的并行计算能力,大幅加速深度学习模型的训练与推理过程,尤其适用于处理大规模数据和复杂算法。CPU 则负责协调和管理整个系统的运行。

RAM(随机存取存储器)为模型运行和数据处理提供快速的临时存储,保证数据能够被迅速读取和写入。HDD(机械硬盘)和 SSD(固态硬盘)作为数据的长期存储介质,HDD 适合大容量、对读写速度要求不太高的数据存储,而 SSD 以其高速读写性能,常用于存储需要频繁访问的数据。

network(网络)确保数据在平台各组件间的高效传输,无论是模型训练数据的分发,还是推理结果的返回,都依赖稳定高速的网络。security protect(安全防护)通过防火墙、加密技术、入侵检测等手段,防止数据泄露、恶意攻击和非法访问,保障平台和用户数据的安全。

二、云原生层

云原生层基于云计算技术构建,提供灵活且可扩展的资源管理与服务环境。私有云、政务云、算力中心等为平台提供了多样化的部署选择,满足不同用户对数据隐私和安全的需求。

K8S(Kubernetes)作为容器编排系统,可自动管理容器化应用的部署、扩展、更新和故障恢复。它能够根据实际需求动态分配计算资源,提高资源利用率,同时简化应用的运维管理。此外,容器技术的应用使得应用的打包、分发和部署更加便捷,不同环境下的一致性得到有效保障。

三、框架层

框架层为 AI 模型的开发提供了基础工具和平台。PyTorch 以其动态计算图的特性,受到众多科研人员和开发者的青睐,便于快速实验和迭代模型。TensorFlow 则以其高度的灵活性和广泛的生态系统,适用于从研究到生产环境的各种场景。

JAX 结合了可组合的变换函数和自动微分功能,能够在多个加速器上高效运行。MindSpore 是华为推出的深度学习框架,具有端边云协同、自动并行等特点,提升了模型开发的效率和性能。OneFlow 和 MinMaxVision 也各自具备独特的优势,为开发者提供了多样化的选择,满足不同的开发需求和应用场景。

四、模型层

(一)NLP 大模型

涵盖多语言模型、开放域对话模型等。多语言模型能够处理多种自然语言,实现跨语言的信息理解和生成。语言理解与生成技术可对文本进行语义分析、情感判断,并生成自然流畅的文本回复。语音语义理解则将语音转换为文本并进行语义解析,实现语音交互功能。多模态对话模型结合文本、图像、语音等多种信息,实现更加智能和自然的人机交互。

信息抽取与检索技术从大量文本中提取关键信息,并实现高效的信息检索。文本语义与图结构分析用于理解文本中的语义关系,并将其转化为图结构进行进一步分析。代码生成和理解模型能够根据自然语言描述生成代码,以及对代码进行语义理解和分析。

大语言模型如chatglm2-6b、Qwen-7B-Chat、Qwen-72B-Chat、baichuan-13b-chat等,支持复杂的自然语言处理任务。

(二)CV 大模型

图像表征技术用于提取图像的特征表示,为后续的分析和处理提供基础。视频表征则对视频序列进行特征提取和建模,实现对视频内容的理解。图像生成技术可根据输入条件生成逼真的图像,如风格迁移、图像修复等。视频生成能够合成动态视频内容。

图像与物体检测技术用于识别图像中的物体,并确定其位置和类别。语义分割则将图像中的每个像素进行分类,实现对图像的精细理解。图像分类技术对图像进行整体类别判断。因果推断旨在从图像数据中推断因果关系,为视觉任务提供更深入的理解。

视觉大模型如FLUX、sd3.5-large、HunyuanDiT-v1.2等。

(三)多模态大模型

融合视觉、语言、语音等多种模态信息,实现更强大的智能处理能力。例如,视觉 - 语言模型能够理解图像和文本之间的关联,用于图像描述生成、视觉问答等任务。语音 - 视觉模型结合语音和图像信息,实现更丰富的交互体验,如视频会议中的实时翻译和手势识别。

多模型大模型如CosyVoice2-0.5B、ChatTTS、FishSpeech-1.5、SenseVoiceSmall、F5-TTS、HunyuanVideo、CogVideoX-2b。

五、能力层

能力层基于模型层的基础,为平台提供了具体的应用能力。文字生成能力可用于自动写作、智能客服回复等场景,根据输入的提示或要求生成高质量的文本内容。音频生成能够合成语音、音乐等音频内容,应用于有声读物、虚拟主播等领域。

图像生成可用于艺术创作、产品设计等,快速生成各种风格的图像。视频生成技术则可用于影视制作、广告宣传等,自动生成动态视频画面。虚拟人 / 场景生成能够创建逼真的虚拟人物和场景,广泛应用于游戏、虚拟现实等领域。

代码生成能力可根据自然语言描述或需求自动生成代码,提高软件开发效率。策略生成能够根据给定的目标和条件,生成最优的决策策略,应用于智能规划、资源分配等场景。多模态生成则融合多种模态信息,生成更加丰富和多样化的内容。

六、模型服务层

模型服务层主要负责对大模型进行管理和提供服务。大模型内容管理涵盖模型的版本控制、存储和更新,确保模型的可用性和一致性。AI 搜索与问答通过对模型的调用和优化,实现智能搜索和准确的问答服务,快速响应用户的查询。

模型的服务应用一共可以分为3种模式,单纯的大模型问答、大模型+知识库问答、大模型+数据库问答。

Embedding(嵌入)技术将文本、图像等数据转换为低维向量表示,便于模型处理和计算。召回路由根据用户请求,从大量模型和数据中快速筛选出相关内容。任务编排负责对模型调用的流程进行规划和管理,确保各环节的高效运行。

RAG(检索增强生成)技术融合了检索与生成两种方法,旨在提升信息生成的精准度。它利用检索到的相关信息来增强生成模型的效能,确保所生成内容的准确性与相关性

大模型微调(Fine-tuning)技术通过对模型进行细致调整,使其更好地适应特定任务需求,在特定任务的数据集上进行微调后,模型在相关任务上的性能可以得到显著提升,实现更精准和高效的处理。

提示词工程(Prompt Engineering)专注于设计高效的提示语,以优化模型的输出结果。通过精心设计的提示词,可以引导模型生成更加符合预期的内容,从而提升生成文本的质量。

思维链(Chain-of-Thought)技术模拟人类的思考过程,以增强模型的决策和推理能力。通过逐步推理和决策,该技术使得模型能够更有效地处理复杂问题,并做出更加合理的判断

工具调用功能允许平台集成和调用外部工具,拓展模型的应用能力。性能调优则通过对模型参数和运行环境的优化,提升模型的推理速度和准确性。安全监控实时监测模型服务的运行状态,防范安全风险。

MCP 是 Model Context Protocol(模型上下文协议),是一种开放标准协议,旨在为大型语言模型与外部数据源、工具和服务,提供标准化的双向通信接口,核心特性包括支持单一协议连接多种工具和服务、AI 智能体可动态发现可用工具、基于双向通信机制实现实时交互、本地与远程兼容,以及内置标准化访问控制确保安全等。通过 MCP,能简化 AI 智能体与外部系统的集成,打破数据孤岛,提升开发效率,推动 AI 从 “对话” 向 “执行” 进化,助力 AI 在自动化工作流、跨系统数据整合等多场景的创新实践 。

七、应用层

应用层将大模型的能力应用于各个具体行业和领域。在政务领域,可实现政务问答、政策解读等功能,提高政务服务的效率和透明度。公文助手利用文字生成能力辅助公文撰写和审核。

金融行业借助智能客服、风险评估等应用,提升客户服务质量和风险防控能力。在零售电商领域,可实现智能推荐、商品描述生成等功能,促进销售增长。传媒影视行业利用图像生成、视频生成等技术,辅助内容创作和特效制作。

教育科研领域,通过智能辅导、科研助手等应用,提升教育质量和科研效率。在医疗行业,可用于疾病诊断辅助、医学影像分析等,为医疗决策提供支持。工业领域可实现智能质检、设备故障预测等,提高生产效率和质量。能源领域则可用于能源消耗预测、智能电网管理等。

八、应用服务层

服务层为不同终端用户提供访问大模型平台的接口。PC 端、手机端、大屏端和泛 AIoT 端(人工智能物联网终端)等多种终端支持,确保用户可以在不同设备上便捷地使用平台服务。针对不同终端的特点和需求,进行界面优化和功能适配,提供一致且优质的用户体验。

九、运维保障体系

运维保障体系贯穿整个大模型平台架构,负责平台的日常运行维护、性能监控、故障排除和优化升级。通过实时监控系统资源使用情况、模型运行状态等指标,及时发现潜在问题并采取相应措施。

定期对平台进行性能优化,包括硬件升级、软件更新、模型调优等,以确保平台始终保持高效稳定的运行状态。同时,制定完善的备份和恢复策略,防止数据丢失,并在系统出现故障时能够快速恢复服务。