AGI概念与实现

AGI

AGI(Artificial General Intelligence),中文名为“通用人工智能”或“强人工智能”,是指通过机器学习和数据分析等技术,使计算机具有类似于人类的认知和学习能力的技术.

多模态的大模型

(Multimodal Large Language Models,MuLLMs)是一种新兴的人工智能技术,它能够理解和生成多种类型的数据,包括文本、图像、视频等。这些模型通常基于Transformer架构,并使用大规模的数据集进行训练。

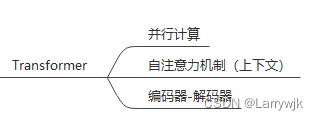

Transformer

Transformer是一种基于注意力机制的深度学习模型。Transformer模型主要用于处理序列数据,如文本、语音、图像等,其核心思想是通过自注意力机制来捕获输入序列中的依赖关系,从而实现更好的建模和预测能力。

Transformer模型主要由两部分组成:编码器和解码器。编码器将输入序列转换为一个表示,这个表示可以被解码器用来生成输出序列。解码器使用编码器的输出和目标序列(如果有的话)来生成输出序列。

Transformer模型的优点包括:

1.并行计算:Transformer模型可以并行处理输入序列中的多个元素,这使得它在处理长序列时能够更快地完成计算。

2.更好的捕获长距离依赖:Transformer模型通过注意力机制来捕获输入序列中的长距离依赖,这使得它在处理长文本、语音、图像等长序列时能够取得更好的效果。

3.更好的泛化能力:Transformer模型通过自注意力机制来学习输入序列的全局依赖,这使得它在面对新的、未见过的输入时能够更好地进行泛化.

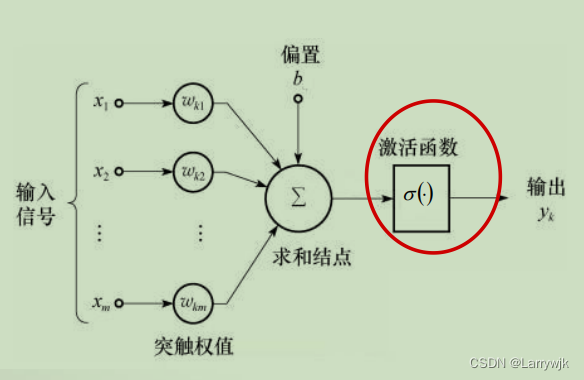

基于注意力机制

在注意力机制中,模型会为每个输入元素分配一个权重,这个权重表示了该元素对于当前任务的重要性。通过这种方式,模型可以专注于最重要的元素,从而提高整体性能。

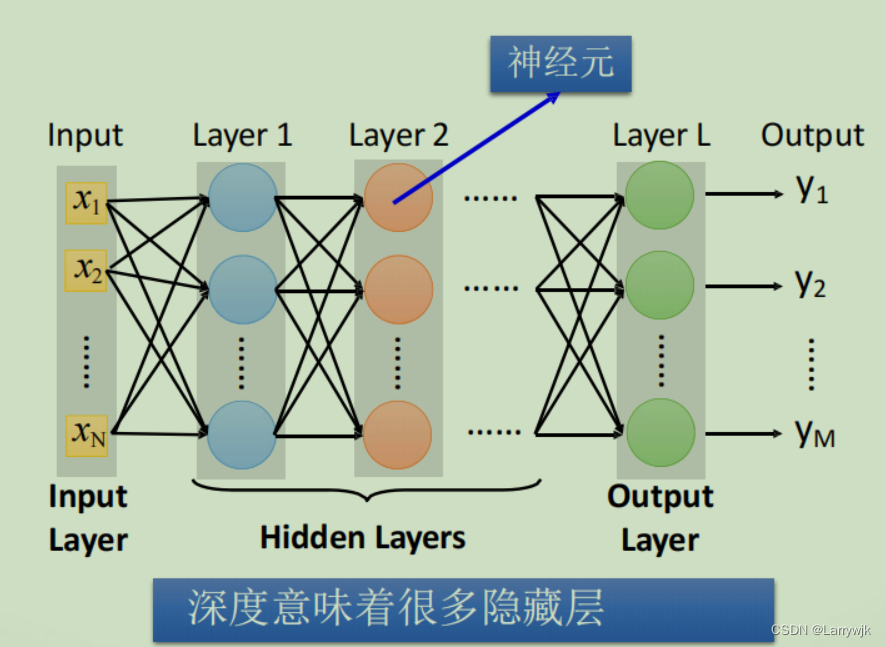

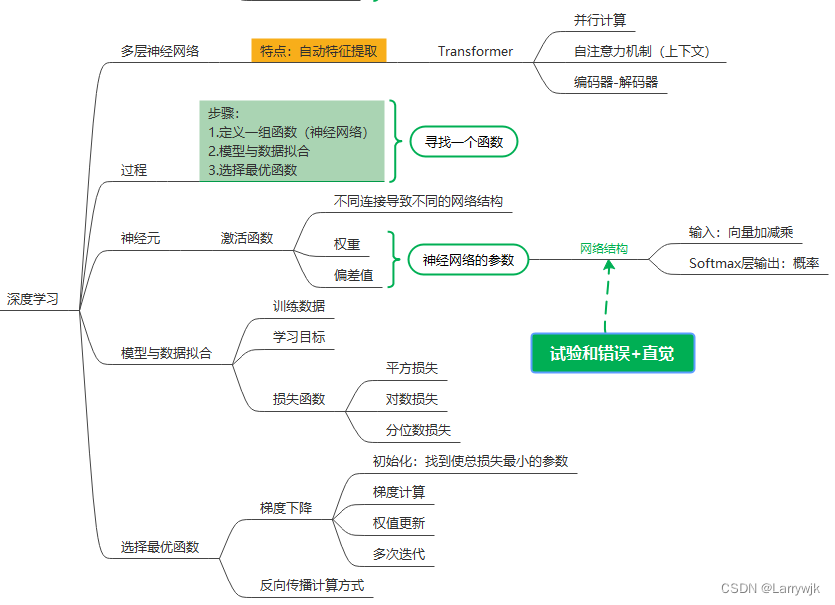

深度学习