【微服务】【Nacos 3】 ① 深度解析:架构演进、核心组件与源码剖析

📖目录

- 前言

- 1. Nacos 3.x 架构总览

- 2. 核心组件详解

- 2.1 注册中心(Naming Service)

- 2.2 配置中心(Config Service)

- 2.3 元数据中心(Metadata Service)【Nacos 3.x 新增】

- 3. Nacos 3.x 新增组件与特性

- 4. 架构图展示

- 4.1. 一致性协议

- 4.1.1. Raft协议

- 4.1.2. Distro协议

- 4.2. 插件化架构(SPI)

- 5. 关键源码剖析(附真实代码)

- 5.1. 注册中心:服务注册入口(InstanceController.java)

- 5.1.1. 注册流程

- 5.1.2. AP模式特征分析

- 5.2. 配置中心:配置监听长轮询(ConfigServletInner.java)

- 5.3. 元数据中心:元数据写入

- 6. 未来趋势与社区演进

- 6.1. Service Mesh 深度集成

- 6.2. Serverless 友好架构

- 6.3. AI 驱动的服务治理

- 6.4. 全球化部署支持

- 7. 结语与学习建议

- 7.1. 动手实践(快速搭建本地环境)

- 7.2. 调试技巧

- 7.3. 延伸阅读

- 📝 版权声明

前言

📌 文章说明:本文基于 Nacos 3.x 最新版本(截至 2025 年),系统梳理其整体架构、核心组件、新增特性,并结合关键源码进行深度剖析,适合中高级 Java 后端开发者、微服务架构师阅读。

🔖 关键词:#Nacos #微服务注册中心 #配置中心 #服务发现 #Nacos3.x #源码解析

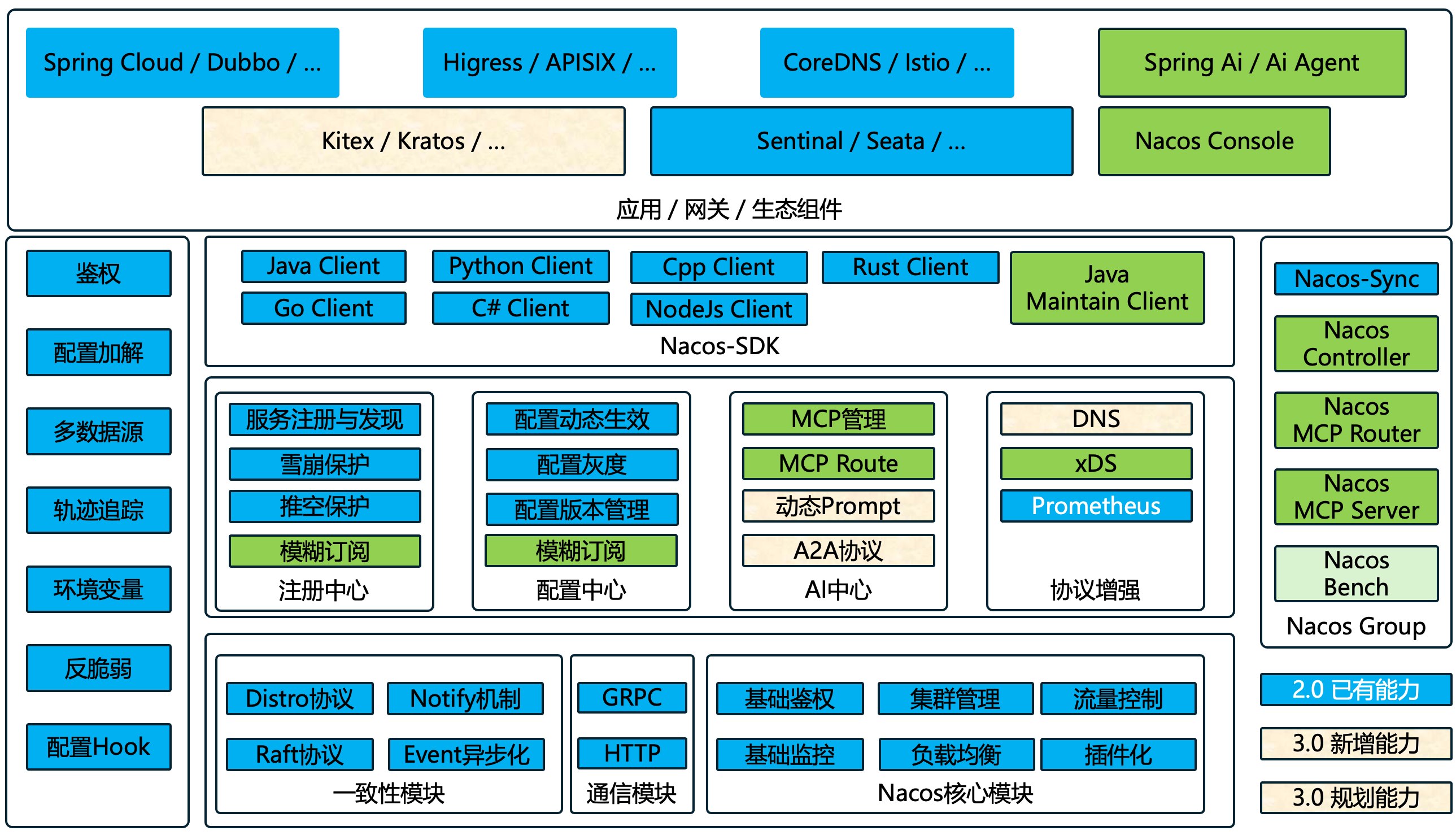

1. Nacos 3.x 架构总览

Nacos(Dynamic Naming and Configuration Service)是阿里巴巴开源的动态服务发现、配置管理和服务管理平台。自 2018 年开源以来,已成为国内微服务生态的事实标准之一。

Nacos 3.x(2024–2025 版本)的重大升级包括:

-

多语言原生支持增强(Go/Python SDK 性能提升)

-

元数据驱动的服务治理模型

-

插件化架构全面落地

-

Raft 协议优化为 JRaft + Multi-Raft Group

-

引入统一控制面(Control Plane)与数据面(Data Plane)分离

整体架构如下图所示:

2. 核心组件详解

2.1 注册中心(Naming Service)

负责服务的注册、发现与健康检查,是微服务通信的 “地址簿”,核心能力如下:

-

支持 AP/CP 模式切换(基于 Raft + Distro 协议,AP 优先保证可用性,CP 优先保证一致性)

-

支持 DNS-F 域名服务、gRPC 长连接推送(3.x 性能优化核心)

-

服务元数据支持标签化(如

env=prod、version=2.0),便于按维度筛选实例

关键能力拆解:

-

实例级健康检查:支持 TCP/HTTP/MySQL 三种检查方式,自动剔除不健康实例

-

权重路由:可通过调整实例权重实现流量分配(如给性能优的实例分配更高权重)

-

集群分组隔离:按集群维度划分服务实例,避免跨集群调用延迟

-

服务流量染色:基于元数据实现灰度发布(如仅让

version=2.0的实例接收测试流量)

2.2 配置中心(Config Service)

提供统一配置管理、动态刷新、监听推送,解决 “配置分散在各服务、修改需重启” 的痛点,核心特性如下:

-

配置版本管理:支持类似 Git 的历史快照,可回滚至任意历史版本

-

多环境隔离:基于

namespace + group + dataId三级结构,实现环境(如 dev/test/prod)、业务线、应用的配置隔离 -

配置变更监听:3.x 默认启用 gRPC 推送,替代旧版 HTTP 长轮询,降低延迟

安全增强:

-

支持 TLS 加密通信,防止配置传输过程中被篡改

-

集成 Spring Cloud Alibaba

@RefreshScope注解,实现配置变更自动刷新(无需重启应用)

2.3 元数据中心(Metadata Service)【Nacos 3.x 新增】

这是 Nacos 3.x 引入的核心创新组件,用于统一管理服务、配置、集群的元信息,解决旧版 “配置中心滥用为元数据仓库” 的问题。

核心功能:

-

存储所有服务实例的标签、权重、扩展属性(如实例所在机房、硬件规格)

-

支持与 Istio、OpenTelemetry 等生态对接,为服务网格、可观测性提供数据基础

-

提供元数据查询 API,支持按多维度筛选(如 “查询 env=prod 且机房 = shanghai 的所有实例”)

✅ 核心意义:将 “业务配置” 与 “服务元数据” 解耦,避免配置中心存储非配置类数据导致的性能问题,同时提升元数据管理的灵活性。

3. Nacos 3.x 新增组件与特性

| 组件 / 特性 | 描述 | 价值 |

|---|---|---|

| Control Plane API | 统一管理接口,替代旧版分散的 OpenAPI | 提升运维自动化能力(如通过一个 API 完成多集群配置同步) |

| Plugin SPI Framework | 支持认证、存储、协议等插件热加载(无需修改 Nacos 核心代码) | 企业可定制私有逻辑(如对接内部 LDAP 认证、使用 MongoDB 存储元数据) |

| Multi-Raft Group | 每个 Namespace 独立创建 Raft Group,独立选主、同步日志 | 避免大集群 “一个 Namespace 故障拖垮整个集群” 的问题,提升 CP 模式稳定性 |

| gRPC Data Plane | 默认使用 gRPC 替代 HTTP 长轮询,作为客户端与服务端的通信协议 | 降低配置 / 服务变更推送延迟,实测吞吐提升 30%+ |

| Metrics & Tracing | 内置 Prometheus 指标暴露、OpenTelemetry 追踪支持 | 无缝接入可观测体系,便于监控 Nacos 集群健康状态、排查调用链路问题 |

4. 架构图展示

4.1. 一致性协议

Nacos支持AP和CP两种⼀致性协议并存

Zookeeper虽然用ZAB协议保证了数据的强⼀致,但它缺乏机房容灾能力,无法适应⼀些大型场景。

Nacos因为要支持多种服务类型的注册,并能够具有机房容灾、集群扩展等必不可少的能力,所以在早期版本开始就正式支持AP和CP两种⼀致性协议并存。

具体地说,在Nacos的1.0.0版本中重构了数据的读写和同步逻辑:首先将与业务相关的CRUD与底层的⼀致性同步逻辑进行了分层隔离。然后将业务的读写(主要是写,因为读会直接使用业务层的缓存)抽象为Nacos定义的数据类型。接着调用⼀致性服务进行数据同步。在决定使用CP还是AP⼀致性时,通过代理 + 可控制的规则进行转发。

Nacos目前的⼀致性协议实现:⼀个是基于简化的Raft协议的CP⼀致性,⼀个是基于自研的Distro协议的AP⼀致性。

Distro协议,则是参考了ConfigServer和开源Eureka。在不借助第三方存储的情况下,实现基本大同小异。Distro重点做了⼀些逻辑优化和性能调优。

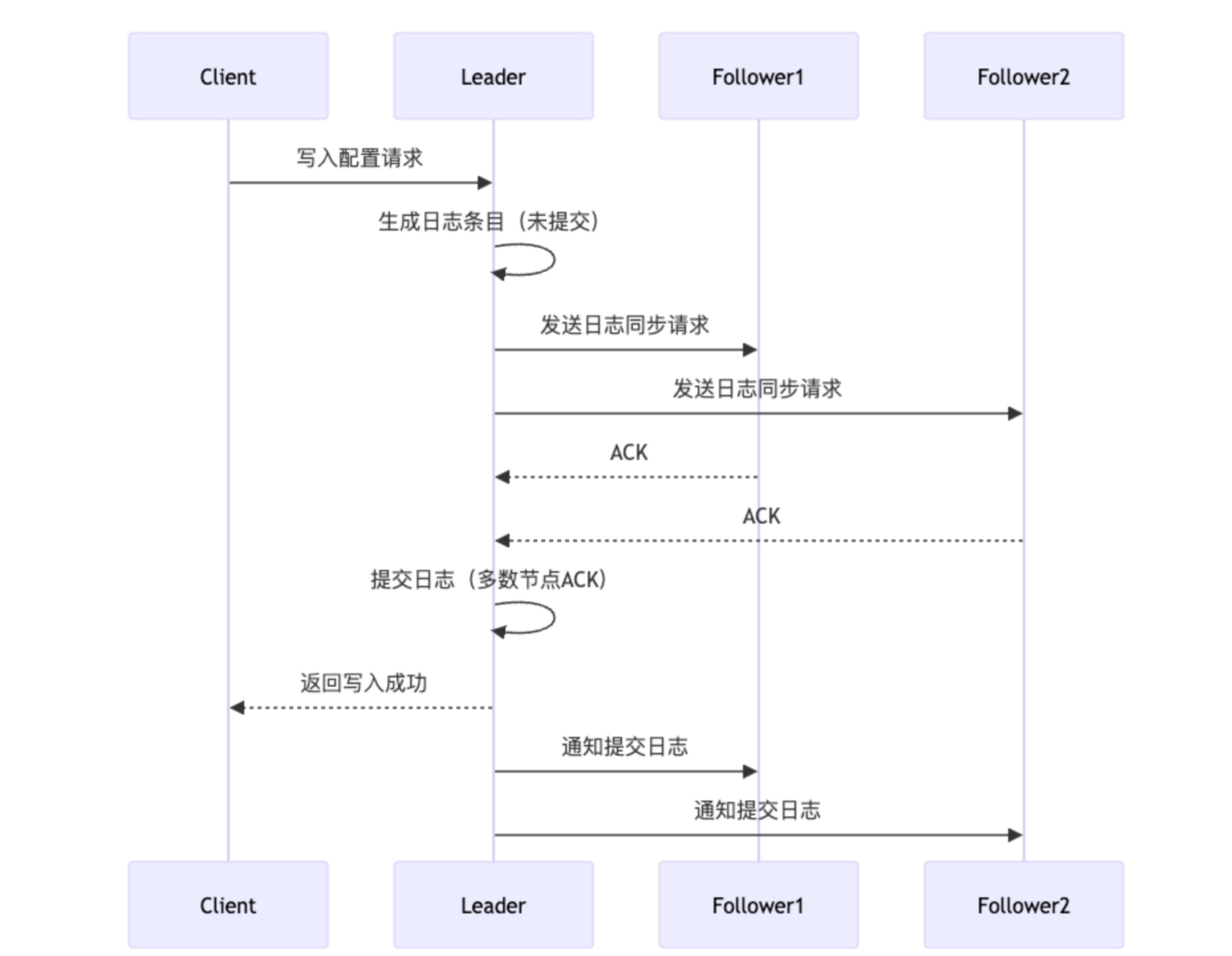

4.1.1. Raft协议

- 角色与场景

用途:Nacos 配置管理模块(Config Service)的底层一致性协议,确保配置数据的强一致性(CP)。

特点:牺牲部分可用性(如脑裂时拒绝写入),优先保证数据一致性。 - 核心机制

- Leader 选举

每个节点初始为 Follower,超时未收到 Leader 心跳则发起选举。

获得多数节点投票的 Candidate 成为新 Leader。 - 日志复制

客户端写请求必须由 Leader 处理。

Leader 将日志同步到多数节点后,才提交数据并返回成功。 - 数据持久化

所有写操作需落盘(本地文件或数据库),保证宕机后恢复一致性。

- 关键流程示例(Mermaid)

4. 关键点

4. 关键点

- 脑裂处理

若集群分裂为多个分区,只有包含多数节点的分区可选举新 Leader。 - 性能瓶颈

所有写操作必须经过 Leader,高并发场景可能成为瓶颈。

⚠️ 关键优势:每个 Namespace 独立选主,互不影响。例如,Namespace A 的 Raft Group Leader 宕机,仅影响 Namespace A 的 CP 模式服务,其他 Namespace 正常运行。

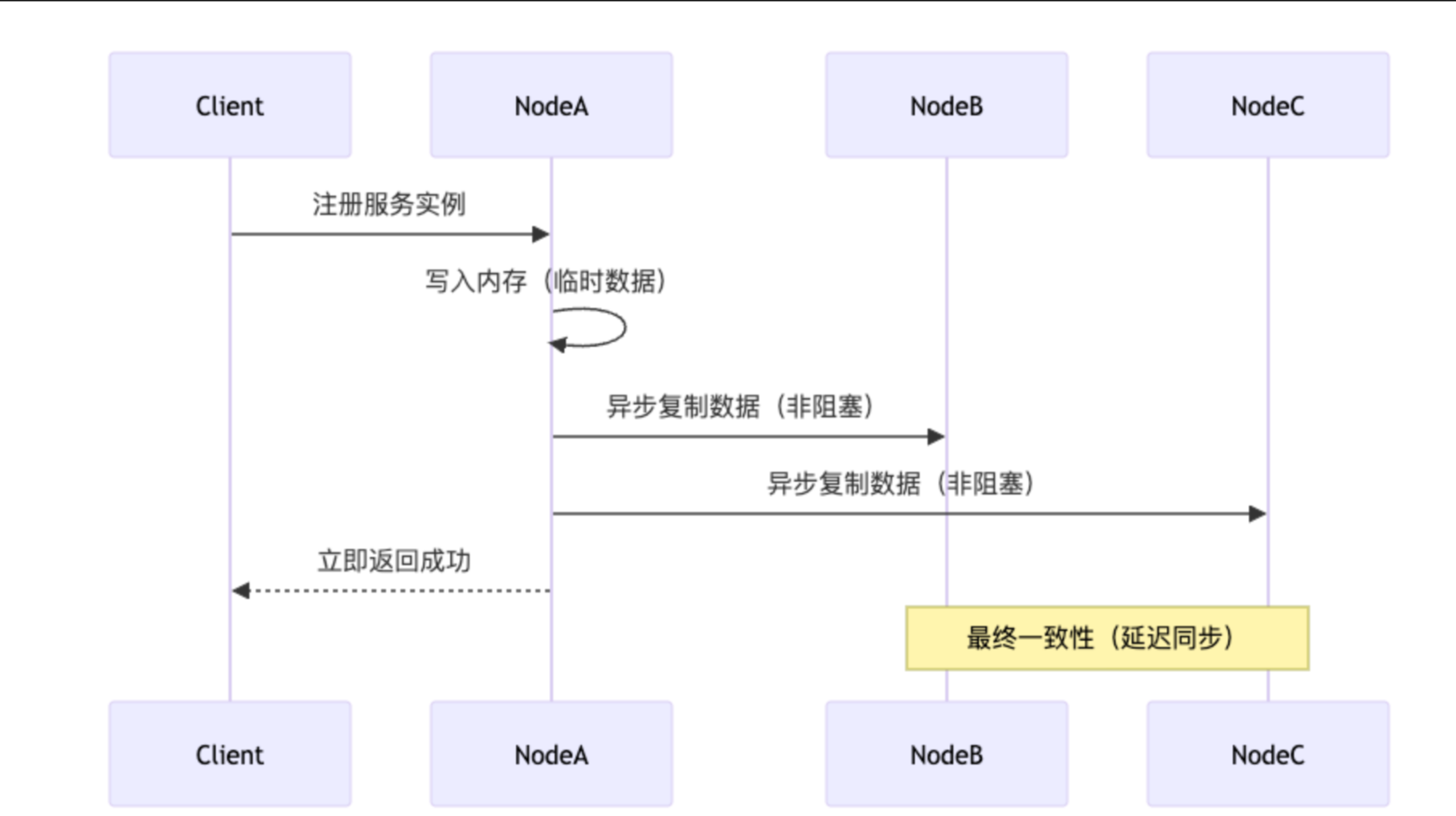

4.1.2. Distro协议

- Distro 协议(AP 模式)

- 角色与场景

用途:Nacos 服务发现模块(Naming Service)的底层一致性协议,优先保证高可用性(AP)。

特点:自研的最终一致性协议,允许短暂数据不一致,但保证服务持续可用。

- 核心机制

- 数据分片(Sharding)

每个 Nacos 节点负责一部分服务数据(通过哈希算法分配)。

节点既是数据的 Owner,也是其他数据的 Replica。 - 异步复制

节点收到注册请求后,先写入本地内存,再异步同步给其他节点。 - 健康检查与自愈

节点间定期同步元数据,检测宕机节点并重新分配其负责的数据分片。

- 关键流程示例(注册服务)

- 关键点

- 最终一致性:节点间数据可能存在短暂不一致,但最终会通过异步同步达成一致。

- 无中心化:无固定 Leader,所有节点均可处理读写请求(对自身负责的分片数据)。

4.2. 插件化架构(SPI)

Nacos Core # Nacos 核心逻辑(不包含可定制化功能)

├── Auth Plugin (JWT / LDAP) # 认证插件:支持 JWT、LDAP 等

├── Storage Plugin (MySQL / PG) # 存储插件:支持 MySQL、PostgreSQL 等

├── Protocol Plugin (gRPC / HTTP) # 协议插件:支持 gRPC、HTTP 等

└── Notify Plugin (Webhook / DingTalk) # 通知插件:支持 Webhook 回调、钉钉告警等

5. 关键源码剖析(附真实代码)

以下源码均来自 Nacos 3.1.0-SNAPSHOT(GitHub 仓库:alibaba/nacos),聚焦核心流程的入口逻辑。

5.1. 注册中心:服务注册入口(InstanceController.java)

服务注册的 HTTP 接口入口,负责接收客户端的服务注册请求,转发至核心逻辑层。

5.1.1. 注册流程

- 客户端发起注册请求到 InstanceController

- 经过 DistroFilter 判断是否为当前节点负责的数据

- 若是则直接处理,否则转发到正确节点

- 调用 ServiceManager 进行服务实例存储

- 根据实例类型(持久/临时)选择不同的一致性策略:持久,选择CP协议;临时,选择AP模式

public class InstanceController {// 注册新实例的方法@CanDistro@PostMapping@TpsControl(pointName = "NamingInstanceRegister", name = "HttpNamingInstanceRegister")@Secured(action = ActionTypes.WRITE)@Compatibility(apiType = ApiType.OPEN_API, alternatives = "POST ${contextPath:nacos}/v3/client/ns/instance")public String register(HttpServletRequest request) throws Exception {// 从请求中获取命名空间ID,如果未提供则使用默认命名空间IDfinal String namespaceId = WebUtils.optional(request, CommonParams.NAMESPACE_ID,Constants.DEFAULT_NAMESPACE_ID);// 从请求中获取必需的服务名称final String serviceName = WebUtils.required(request, CommonParams.SERVICE_NAME);// 检查服务名称格式是否正确NamingUtils.checkServiceNameFormat(serviceName);// 使用HttpRequestInstanceBuilder构建实例对象,设置是否为临时实例并解析请求参数final Instance instance = HttpRequestInstanceBuilder.newBuilder().setDefaultInstanceEphemeral(switchDomain.isDefaultInstanceEphemeral()).setRequest(request).build();// 调用实例操作器注册实例getInstanceOperator().registerInstance(namespaceId, serviceName, instance);// 发布实例注册事件到通知中心NotifyCenter.publishEvent(new RegisterInstanceTraceEvent(System.currentTimeMillis(),NamingRequestUtil.getSourceIpForHttpRequest(request), false, namespaceId,NamingUtils.getGroupName(serviceName), NamingUtils.getServiceName(serviceName), instance.getIp(),instance.getPort()));// 返回成功标识return "ok";}

}

public class DistroFilter implements Filter {@Overridepublic void doFilter(ServletRequest servletRequest, ServletResponse servletResponse, FilterChain filterChain)throws IOException, ServletException {// 将ServletRequest转换为可重用的HttpServletRequest,支持多次读取请求内容ReuseHttpServletRequest req = new ReuseHttpServletRequest((HttpServletRequest) servletRequest);// 获取HttpServletResponse响应对象HttpServletResponse resp = (HttpServletResponse) servletResponse;// 构建完整的请求URL字符串,包含请求路径String urlString = req.getRequestURI();// 如果查询参数不为空,则将其追加到URL字符串中if (StringUtils.isNotBlank(req.getQueryString())) {urlString += "?" + req.getQueryString();}try {// 通过ControllerMethodsCache获取当前请求对应的方法Method method = controllerMethodsCache.getMethod(req);// 获取请求路径String path = new URI(req.getRequestURI()).getPath();// 如果找不到对应的方法,抛出异常if (method == null) {throw new NoSuchMethodException(req.getMethod() + " " + path);}// 检查方法是否有CanDistro注解,如果没有则直接放行,不需要分布式处理if (!method.isAnnotationPresent(CanDistro.class)) {filterChain.doFilter(req, resp);return;}// 获取当前请求的责任标签,用于确定哪个节点负责处理此请求String distroTag = distroTagGenerator.getResponsibleTag(req);// 检查当前节点是否负责处理此标签对应的数据,如果是则直接放行if (distroMapper.responsible(distroTag)) {filterChain.doFilter(req, resp);return;}// 如果当前节点不负责处理,则需要代理转发请求到正确的节点// proxy request to other server if necessary:// 获取请求的User-Agent头部信息String userAgent = req.getHeader(HttpHeaderConsts.USER_AGENT_HEADER);// 检查请求是否来自其他Nacos服务器节点(防止循环转发)if (StringUtils.isNotBlank(userAgent) && userAgent.contains(UtilsAndCommons.NACOS_SERVER_HEADER)) {// This request is sent from peer server, should not be redirected again:// 如果是来自其他服务器的请求且还需要转发,则记录错误日志并返回400错误Loggers.SRV_LOG.error("receive invalid redirect request from peer {}", req.getRemoteAddr());resp.sendError(HttpServletResponse.SC_BAD_REQUEST,"receive invalid redirect request from peer " + req.getRemoteAddr());return;}// 根据责任标签映射到负责处理的服务器地址final String targetServer = distroMapper.mapSrv(distroTag);// 准备转发请求所需的HTTP头部信息List<String> headerList = new ArrayList<>(16);Enumeration<String> headers = req.getHeaderNames();// 遍历所有请求头并添加到列表中while (headers.hasMoreElements()) {String headerName = headers.nextElement();headerList.add(headerName);headerList.add(req.getHeader(headerName));}// 读取请求体内容final String body = IoUtils.toString(req.getInputStream(), StandardCharsets.UTF_8.name());// 转换请求参数映射final Map<String, String> paramsValue = HttpClient.translateParameterMap(req.getParameterMap());// 向目标服务器发送HTTP请求RestResult<String> result = HttpClient.request(HTTP_PREFIX + targetServer + req.getRequestURI(), headerList, paramsValue, body,PROXY_CONNECT_TIMEOUT, PROXY_READ_TIMEOUT, StandardCharsets.UTF_8.name(), req.getMethod());// 根据请求结果获取响应数据String data = result.ok() ? result.getData() : result.getMessage();try {// 将目标服务器的响应返回给原始请求方WebUtils.response(resp, data, result.getCode());} catch (Exception ignore) {// 如果响应过程中出现异常,记录警告日志Loggers.SRV_LOG.warn("[DISTRO-FILTER] request failed: " + distroMapper.mapSrv(distroTag) + urlString);}} catch (SecurityException e) {// 处理安全异常,返回403禁止访问错误resp.sendError(HttpServletResponse.SC_FORBIDDEN, "access denied: " + ExceptionUtil.getAllExceptionMsg(e));} catch (NoSuchMethodException e) {// 处理找不到方法异常,返回501未实现错误resp.sendError(HttpServletResponse.SC_NOT_IMPLEMENTED,"no such api:" + req.getMethod() + ":" + req.getRequestURI());} catch (Exception e) {// 处理其他异常,记录错误日志并返回500服务器内部错误Loggers.SRV_LOG.warn("[DISTRO-FILTER] Server failed: ", e);resp.sendError(HttpServletResponse.SC_INTERNAL_SERVER_ERROR,"Server failed, " + ExceptionUtil.getAllExceptionMsg(e));}}}

public class InstanceOperatorClientImpl implements InstanceOperator {@Override// 注册实例方法,实现InstanceOperator接口public void registerInstance(String namespaceId, String groupName, String serviceName, Instance instance)throws NacosException {// 检查实例是否合法,包括IP和端口的有效性NamingUtils.checkInstanceIsLegal(instance);// 获取实例是否为临时实例的标识boolean ephemeral = instance.isEphemeral();// 根据实例的IP端口和是否临时实例生成客户端IDString clientId = IpPortBasedClient.getClientId(instance.toInetAddr(), ephemeral);// 如果客户端不存在则创建新的IP端口客户端createIpPortClientIfAbsent(clientId);// 创建服务对象,包含命名空间、组名、服务名和是否临时实例的信息Service service = Service.newService(namespaceId, groupName, serviceName, ephemeral);// 调用客户端操作服务注册实例clientOperationService.registerInstance(service, instance, clientId);}

}

public class PersistentClientOperationServiceImpl extends RequestProcessor4CP implements ClientOperationService {@Override// 注册持久化实例方法,实现ClientOperationService接口public void registerInstance(Service service, Instance instance, String clientId) {// 通过ServiceManager获取服务单例,确保服务唯一性Service singleton = ServiceManager.getInstance().getSingleton(service);// 检查服务是否为临时服务,如果是则抛出异常,因为持久化实例不能注册到临时服务上if (singleton.isEphemeral()) {throw new NacosRuntimeException(NacosException.INVALID_PARAM,String.format("Current service %s is ephemeral service, can't register persistent instance.",singleton.getGroupedServiceName()));}// 创建实例存储请求对象,用于封装注册信息final InstanceStoreRequest request = new InstanceStoreRequest();// 设置请求中的服务信息request.setService(service);// 设置请求中的实例信息request.setInstance(instance);// 设置请求中的客户端IDrequest.setClientId(clientId);// 构建写请求,包含组名、序列化的请求数据和操作类型(ADD)final WriteRequest writeRequest = WriteRequest.newBuilder().setGroup(group()).setData(ByteString.copyFrom(serializer.serialize(request))).setOperation(DataOperation.ADD.name()).build();try {// 通过CP协议执行写操作,将实例注册信息持久化到集群protocol.write(writeRequest);// 记录实例注册成功的日志信息Loggers.RAFT.info("Client registered. service={}, clientId={}, instance={}", service, clientId, instance);} catch (Exception e) {// 如果注册过程中发生异常,抛出服务器错误异常throw new NacosRuntimeException(NacosException.SERVER_ERROR, e);}}}

public class EphemeralClientOperationServiceImpl implements ClientOperationService {@Override// 注册临时实例方法,实现ClientOperationService接口public void registerInstance(Service service, Instance instance, String clientId) throws NacosException {// 检查实例是否合法,包括IP和端口的有效性NamingUtils.checkInstanceIsLegal(instance);// 通过ServiceManager获取服务单例,确保服务唯一性Service singleton = ServiceManager.getInstance().getSingleton(service);// 检查服务是否为持久化服务,如果是则抛出异常,因为临时实例不能注册到持久化服务上if (!singleton.isEphemeral()) {throw new NacosRuntimeException(NacosException.INVALID_PARAM,String.format("Current service %s is persistent service, can't register ephemeral instance.",singleton.getGroupedServiceName()));}// 根据客户端ID获取客户端对象Client client = clientManager.getClient(clientId);// 检查客户端是否合法(是否存在且为临时客户端)checkClientIsLegal(client, clientId);// 获取实例发布信息InstancePublishInfo instanceInfo = getPublishInfo(instance);// 将服务实例添加到客户端中client.addServiceInstance(singleton, instanceInfo);// 更新客户端最后更新时间client.setLastUpdatedTime();// 重新计算客户端版本号client.recalculateRevision();// 发布客户端注册服务事件通知NotifyCenter.publishEvent(new ClientOperationEvent.ClientRegisterServiceEvent(singleton, clientId));// 发布实例元数据事件通知NotifyCenter.publishEvent(new MetadataEvent.InstanceMetadataEvent(singleton, instanceInfo.getMetadataId(), false));}}

5.1.2. AP模式特征分析

-

临时实例特性:

- EphemeralClientOperationServiceImpl实例

- 临时实例不保证数据持久化,注重可用性而非一致性

-

去中心化处理:

- 实例注册直接在内存中完成,不经过强一致性的CP协议

- 通过 clientManager 直接管理客户端状态

-

快速响应机制:

- 注册过程不涉及复杂的共识算法

- 通过 NotifyCenter 异步发布事件通知

-

高可用设计:

- 即使部分节点故障,其他节点仍可继续提供服务注册功能

- 通过Distro协议在集群间同步数据

这与 PersistentClientOperationServiceImpl 形成对比,后者使用JRaft实现CP模式,强调强一致性而牺牲部分可用性。临时实例的AP模式更适合对服务发现时效性要求高但能容忍短暂数据不一致的场景。

🔍 关键点解析:

Service是 Nacos 中 “服务” 的核心实体,封装了服务名、分组、Namespace、实例列表等信息。serviceManager.registerInstance()会根据当前集群模式(AP/CP)选择不同的同步逻辑:- AP 模式:调用

DistroProtocol.sync()异步同步实例到其他节点(保证可用性优先)。 - CP 模式:将实例信息写入 Raft 日志,通过 Raft 协议同步到所有节点(保证一致性优先)

- AP 模式:调用

5.2. 配置中心:配置监听长轮询(ConfigServletInner.java)

旧版 HTTP 长轮询的核心逻辑(3.x 中作为 gRPC 推送的 fallback),负责检测配置是否变更,若变更则立即响应客户端。

/*** 长轮询配置。*/// 执行配置长轮询的方法public String doPollingConfig(HttpServletRequest request, HttpServletResponse response,Map<String, ConfigListenState> clientMd5Map, int probeRequestSize) throws IOException {// 长轮询支持检查if (LongPollingService.isSupportLongPolling(request)) {// 添加长轮询客户端longPollingService.addLongPollingClient(request, response, clientMd5Map, probeRequestSize);// 返回HTTP 200状态码return HttpServletResponse.SC_OK + "";}// 兼容短轮询逻辑Map<String, ConfigListenState> changedGroups = MD5Util.compareMd5(request, response, clientMd5Map);// 兼容短轮询结果String oldResult = MD5Util.compareMd5OldResult(changedGroups);String newResult = MD5Util.compareMd5ResultString(changedGroups);// 获取客户端版本String version = request.getHeader(Constants.CLIENT_VERSION_HEADER);if (version == null) {version = "2.0.0";}int versionNum = Protocol.getVersionNumber(version);// 2.0.4版本之前,返回值放在header中if (versionNum < START_LONG_POLLING_VERSION_NUM) {response.addHeader(Constants.PROBE_MODIFY_RESPONSE, oldResult);response.addHeader(Constants.PROBE_MODIFY_RESPONSE_NEW, newResult);} else {request.setAttribute("content", newResult);}// 禁用缓存response.setHeader("Pragma", "no-cache");response.setDateHeader("Expires", 0);response.setHeader("Cache-Control", "no-cache,no-store");response.setStatus(HttpServletResponse.SC_OK);return HttpServletResponse.SC_OK + "";}

💡 演进说明:Nacos 3.x 中,gRPC 推送已成为默认方案,长轮询仅作为 “客户端不支持 gRPC 时的 fallback”。gRPC 基于长连接,配置变更时服务端可主动推送,延迟比长轮询低一个数量级。

5.3. 元数据中心:元数据写入

nstanceOperatorClientImpl类是Nacos实例管理功能的重要组成部分,提供了高效的批量元数据管理能力。通过调用NamingMetadataManager元数据中心的服务方法,执行元数据的写入、更新与变更通知。

@org.springframework.stereotype.Service

public class InstanceOperatorClientImpl implements InstanceOperator {private final NamingMetadataManager metadataManager;// 批量更新实例元数据的方法@Overridepublic List<String> batchUpdateMetadata(String namespaceId, InstanceOperationInfo instanceOperationInfo,Map<String, String> metadata) throws NacosException {// 判断是否为临时实例:如果一致性类型不等于PERSIST,则为临时实例boolean isEphemeral = !UtilsAndCommons.PERSIST.equals(instanceOperationInfo.getConsistencyType());// 获取服务名称String serviceName = instanceOperationInfo.getServiceName();// 根据命名空间ID、服务名称和是否临时实例创建Service对象Service service = getService(namespaceId, serviceName, isEphemeral);// 创建结果列表List<String> result = new LinkedList<>();// 查找需要更新的实例列表List<Instance> needUpdateInstance = findBatchUpdateInstance(instanceOperationInfo, service);// 遍历需要更新的实例for (Instance each : needUpdateInstance) {// 生成元数据IDString metadataId = InstancePublishInfo.genMetadataId(each.getIp(), each.getPort(), each.getClusterName());// 获取实例的元数据Optional<InstanceMetadata> instanceMetadata = metadataManager.getInstanceMetadata(service, metadataId);// 克隆现有元数据或创建新的元数据对象InstanceMetadata newMetadata = instanceMetadata.map(this::cloneMetadata).orElseGet(InstanceMetadata::new);// 将新的元数据合并到现有元数据中newMetadata.getExtendData().putAll(metadata);// 更新实例元数据metadataOperateService.updateInstanceMetadata(service, metadataId, newMetadata);// 将更新的实例信息添加到结果列表中result.add(each.toInetAddr() + ":" + UtilsAndCommons.LOCALHOST_SITE + ":" + each.getClusterName() + ":" + (each.isEphemeral() ? UtilsAndCommons.EPHEMERAL : UtilsAndCommons.PERSIST));}// 返回更新结果return result;}

}

✅ 设计亮点:可批量更新多个服务实例的配置属性;为一组实例应用通用的元数据标签;可在部署或维护期间进行批量配置变更

6. 未来趋势与社区演进

Nacos 社区在 2025 年后的核心演进方向聚焦于 “生态融合” 与 “架构轻量化”,具体包括以下 4 个方向:

6.1. Service Mesh 深度集成

Nacos 正在与 Istio、OpenSergo(开源服务治理标准)深度对接,目标是成为 Service Mesh 的 “控制面大脑”:

-

支持将 Nacos 中的服务元数据同步到 Istio Pilot,为服务网格提供服务发现能力

-

支持通过 Nacos 配置 Istio 流量规则(如熔断、限流),实现 “服务治理 + 服务网格” 统一管理

6.2. Serverless 友好架构

推出轻量级 Sidecar 模式(nacos-sidecar),适配 Serverless/FaaS 场景:

-

Sidecar 独立部署,负责与 Nacos 服务端通信,FaaS 函数无需集成 Nacos SDK

-

支持按需启动 / 销毁,降低 Serverless 场景下的资源消耗

6.3. AI 驱动的服务治理

社区已启动实验性项目 nacos-ai,探索 AI 在服务治理中的应用:

-

利用 LLM(大语言模型)分析服务依赖关系,自动生成熔断 / 限流策略

-

基于历史监控数据预测服务负载峰值,提前调整实例权重或扩容

6.4. 全球化部署支持

针对跨国企业需求,新增多 Region 部署能力:

-

支持多 Region 主备同步(基于 Binlog + Kafka 实现增量数据复制)

-

提供跨云配置复制功能(如阿里云 Region 与 AWS Region 间的配置同步)

7. 结语与学习建议

Nacos 3.x 已不再是简单的 “注册中心 + 配置中心”,而是朝着统一服务治理平台演进。其插件化架构、元数据驱动设计、控制面与数据面分离的理念,代表了下一代微服务基础设施的发展方向。

7.1. 动手实践(快速搭建本地环境)

# 1. 克隆 Nacos 源码

git clone https://github.com/alibaba/nacos.git

cd nacos# 2. 编译源码(跳过测试,加速编译)

mvn -Prelease-nacos clean install -DskipTests# 3. 启动单机模式(默认使用嵌入式 Derby 存储)

cd distribution/target/nacos-server-3.1.0-SNAPSHOT/nacos/bin

sh startup.sh -m standalone # Linux/Mac# 或

startup.cmd -m standalone # Windows

7.2. 调试技巧

-

启动 Nacos 时添加 JVM 参数

-Dnacos.plugin.enable.auth=true,开启插件日志,便于排查自定义插件问题 -

关注

nacos-core模块的RaftCore类(集群一致性核心)、nacos-naming模块的ServiceManager类(服务注册核心),通过断点调试理解核心流程

7.3. 延伸阅读

-

Nacos 3.x 官方文档(最权威的版本更新与功能说明)

-

《深入理解 Nacos 源码》(机械工业出版社,2025)(从源码角度解析 Nacos 设计思想)

🌟 核心学习原则:不要只背 “Nacos 是什么”,而要理解 “为什么这样设计”。例如:

-

为何用 Multi-Raft Group 而不是单 Raft?(避免集群级故障)

-

为何元数据要独立于配置?(解耦存储,提升性能)

-

gRPC 如何提升配置推送性能?(长连接替代短轮询,减少握手开销)

📝 版权声明

本文为原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文链接及本声明。

✅ 本文持续更新,欢迎收藏 + 关注专栏【后端高阶面经:实战篇】

✅ 下期预告:《Nacos 3.x 插件开发实战:自定义认证与存储引擎》