Datawhale25年11月组队学习:hello-agents+Task2

1.Transformer 模型架构

核心模块:注意力

整个网络完全由注意力组成

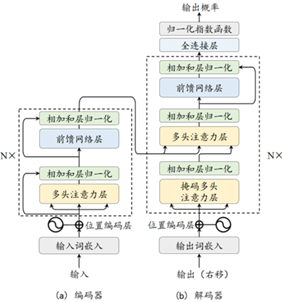

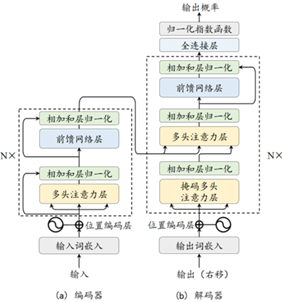

图1 编码器和解码器结构

编码器-解码器结构

编码器:将输入序列变换为隐藏层特征

解码器:将隐藏层特征变换为输出序列

在编码器-解码器中,Q、K、V均为自身前一层的输出(名称self-attention的由来)

唯一不同:

Q是前一层的输出,K、V是编码器的输出

1.Transformer 模型架构

核心模块:注意力

整个网络完全由注意力组成

图1 编码器和解码器结构

编码器-解码器结构

编码器:将输入序列变换为隐藏层特征

解码器:将隐藏层特征变换为输出序列

在编码器-解码器中,Q、K、V均为自身前一层的输出(名称self-attention的由来)

唯一不同:

Q是前一层的输出,K、V是编码器的输出