研0不会总结文献核心科学问题?

对于很多刚进入科研领域的研究生来说,文献阅读是一道绕不过去的坎。

你可能已经下载了一大堆论文,但在组会汇报时,老师总是问你一句:“这篇文献解决了什么科学问题?”——而你脑子一片空白,只能笼统地回答研究了某个现象,却无法精准地提炼出核心科学问题和创新点。

其实,这个问题不仅仅是“读得不够仔细”,更是缺乏科学性的阅读方法和信息提取能力。幸运的是,现在AI如此发达,可以从“快速检索—智能解读—知识提炼—逻辑整合”全流程帮你解决这个痛点,让你在组会和论文写作中自信满满。

一、为什么研究生容易在“科学问题总结”上卡壳?

以我的经验,研究生在汇报文献时常犯以下几类错误:

1. 只关注研究内容,不关注科学问题

很多人会机械地描述作者做了哪些实验、用了什么方法,但忽略了这篇文章到底想回答什么科学问题。

2. 无法区分背景知识与核心问题

文章里有很多引言和综述部分,新手容易把背景当成核心科学问题。

3. 缺乏问题抽象能力

科学问题往往是高度凝练的,比如“某机制是否影响某疾病发生”,但很多人总结成十几个字的复杂句,难以让人抓住重点。

要解决这些问题,需要训练结构化阅读的能力,也需要高效的文献分析工具来辅助。

二、用 MedPeer 工具解决文献总结的两步法

第一步:Deep Search——智能检索,快速锁定相关文献并初步提炼

面对海量文献,你可能花了半天时间搜集资料,却发现很多内容无关紧要,导致后续总结时思路混乱。Deep Search 正是为此而生,它结合AI和检索增强生成(RAG)技术,能从数据库、学术文献和网络资源中高效挖掘信息。

Deep Search 的核心优势:

- 全能数据源检索:支持学术文献库和网络资源的全覆盖,输入研究问题,比如“人工智能在医疗影像中的应用”,系统会自动检索相关论文和报告。

- 结果可追溯:所有总结都附带引用链接,确保信息真实可靠,避免你盲目阅读低质文献。

技巧:仔细阅读这份调研报告,帮你初步梳理问题脉络,比如从多篇文献中提炼出“AI 算法如何提升诊断准确率”的科学空白点。这样,你只需花10-15分钟,就能从零散信息中抓住重点,避免“读了半天不知所云”。

通过这一步,你不仅找到了高质量文献,还获得了初步的科学问题框架,为后续解读打下基础。

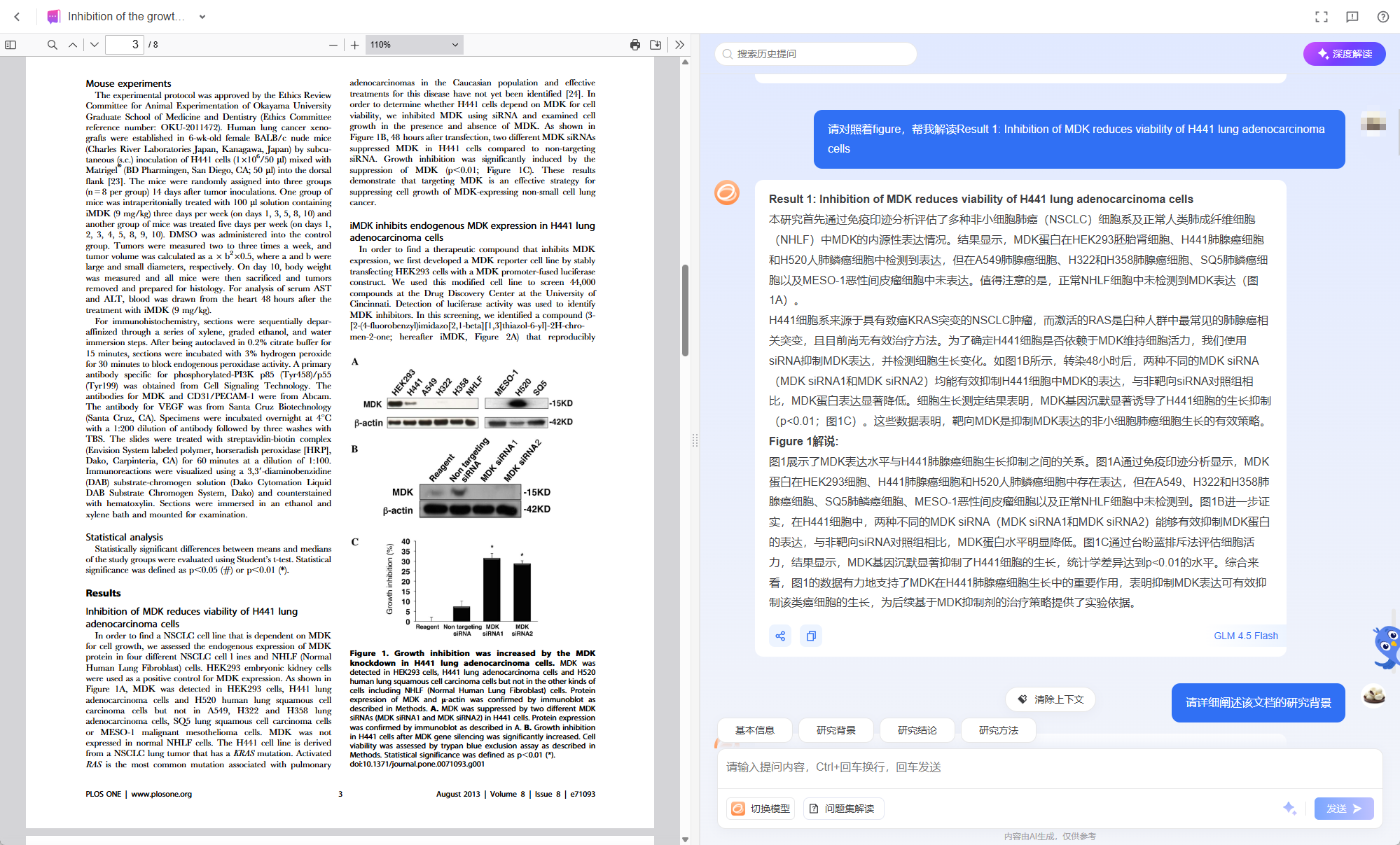

第二步:文档解读——深度分析,精准提炼单篇文献的核心科学问题

拿到具体文献后,最头疼的往往是长篇大论的阅读和提炼。Deep Search给了你概述,但要深入到单篇论文的科学问题,还需文档解读。这款工具专为科研人员设计,能AI驱动地分析文档,帮助你快速把握本质。

文档解读 的核心优势:

- 智能文献总结:上传后,AI 自动生成结构化输出,包括“文章基本信息”“核心研究内容”“研究背景与意义”“专业术语解释”和“结论与参考文献梳理”。特别针对你的痛点,它会明确标注“核心科学问题”,如“本文旨在验证 X 因素是否导致 Y 现象的发生”。

- 灵活提问模式:支持自定义提问,你也可以划选原文中的引言部分,直接问“这里的核心空白是什么?”,AI 会给出针对性解读。

技巧:导入文献后,先看“研究背景与意义”部分,对比“核心研究内容”,科学问题往往就藏在二者的交汇处——背景描述了已知知识,核心内容则针对空白发问。汇报时,你可以直接复制这些提炼点,逻辑清晰、导师满意。

结合两步,你能高效处理从检索到解读的全链条:Deep Search 拓宽视野,文档解读 深挖细节。

三、实战案例:半小时从零到科学问题总结

假设你的课题是**“人工智能在医疗影像诊断中的应用”**(跨学科通用),你可以这样操作:

- Deep Search:输入“AI medical imaging diagnosis”,选专业版,提问“文献中核心科学问题汇总”。系统检索 20 篇相关论文,生成报告:常见问题包括“AI 模型如何减少假阳性?”和“算法泛化能力在不同设备间的挑战”。

- 文档解读:上传一篇高相关论文,提问“核心科学问题是什么?创新点如何解决?”。AI 输出:“科学问题:传统 CNN 模型在低质量影像上的准确率不足 80%,本文通过迁移学习提升至 95%。”还附带背景解释和结论对比。

- 整合输出:用报告和解读结果整理汇报大纲——开头陈述领域科学问题,中间逐篇提炼,结尾总结趋势。整个过程用时 30 分钟,从文献小白变汇报高手。

这种方法不依赖特定专业,适用于任何领域的研究生。

如果你每周按这个两步法处理文献,不到一个月,你的导师就会明显感受到你在科学问题总结能力上的进步——从含糊描述变成逻辑清晰、直击本质的汇报。