分布式分片执行原理解析

背景

在分布式系统中,我们常常会遇到这样的场景:同一个服务部署在多台机器上,需要执行一些定时任务、数据同步、告警扫描等操作。如何保证 同一个任务只被一台机器执行,又能 同时提升整体执行效率,这是分布式任务调度中最关键的问题之一。本文将介绍一种基于 分片(Sharding)机制 的分布式任务调度方案,既能保证任务唯一性,又能充分利用多节点并行处理能力。

一、传统方案的局限:分布式锁的性能瓶颈

最简单的方式是使用 分布式锁(如 Redis、ZooKeeper 等):

所有节点同时抢锁;

抢到锁的节点执行任务;

任务完成后释放锁。

虽然这种方式可以保证任务不被重复执行,但存在明显的缺陷:

| 优点 | 缺点 |

|---|---|

| 简单易实现 | 性能受限:同一时刻只有一台机器工作 |

| 适合低频、轻任务 | 不适合大批量、重负载任务场景 |

如果系统中存在成千上万条需要处理的数据,那么这种“单节点串行”方式会极大浪费资源。

二、分布式任务的分片执行思路

为了同时满足:

✅ 单条任务只执行一次

✅ 整体任务能并行处理

我们引入“分片执行机制”(Sharding Execution)。

核心思想是:

将全量任务数据按照一定的规则划分成多个“片”,不同节点处理不同片上的数据。

比如总共有 3 台节点,1000 条任务数据,则可通过如下公式分片:

shard_id = task_id % total_nodes

| 节点编号 | 处理的任务 ID |

|---|---|

| Node 0 | 0, 3, 6, 9, ... |

| Node 1 | 1, 4, 7, 10, ... |

| Node 2 | 2, 5, 8, 11, ... |

这样,每个节点只负责自己那一片的数据,天然避免重复执行。

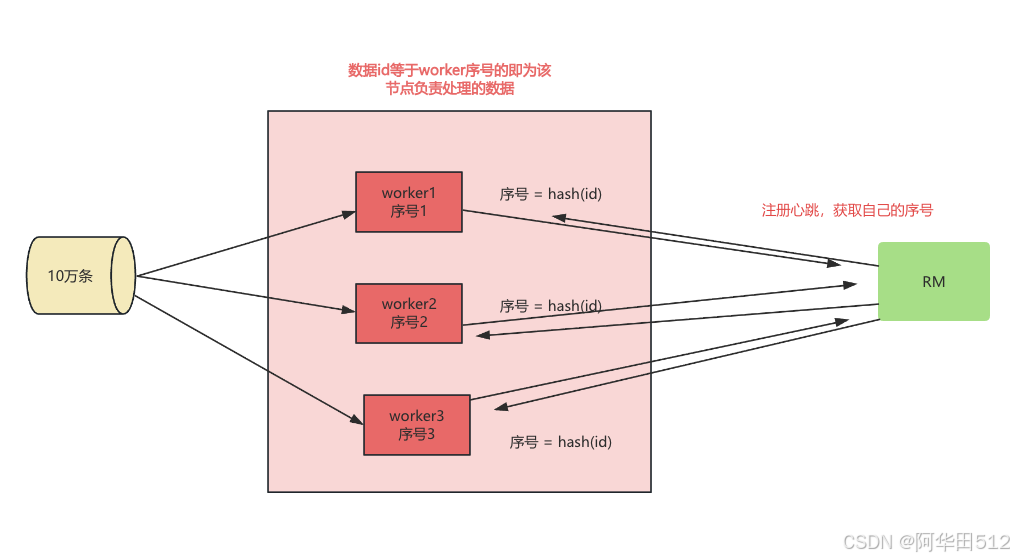

三、整体架构与角色说明

为了让分片机制有序运行,我们需要引入一个中央协调者角色:ResourceManager(RM)

架构图(可配图如下):

四、核心流程说明

Step 1. 节点注册与心跳

各节点启动时向 RM 注册;

RM 记录每个节点的 ID、IP、上报时间;

RM 每 10 秒扫描心跳,剔除僵尸节点。

// 心跳上报伪代码

rm.registerOrUpdateNode(nodeId, lastUpdateTime); rm.removeZombieNodes(timeout = 10s);

Step 2. 获取分片信息

每个节点启动任务时,向 RM 获取最新分片信息(总节点数 + 当前节点编号)。

int shardNum = rm.getShardNum(nodeId); int totalShard = rm.getTotalShards();

Step 3. 数据分片执行

任务执行时,节点根据自己的 shardNum 计算自己应处理的数据:

for (Task task : allTasks) { if (task.getId() % totalShard == shardNum) { process(task); } }

Step 4. 稳定性保障机制

由于节点上下线会导致分片变化,系统在检测到分片不稳定时,需要暂停任务执行,直到分片信息稳定再继续执行。

五、分片机制优势总结

| 对比项 | 分布式锁 | 分片执行机制 |

|---|---|---|

| 并行能力 | 单节点 | 多节点并行 |

| 性能瓶颈 | 有 | 无 |

| 容错性 | 单节点失效需重试 | 自动平衡、自动恢复 |

| 任务唯一性 | ✔ | ✔ |

| 实现复杂度 | 中 | 稍高(需RM协调) |

六、典型应用场景

✅ 大规模数据同步任务

✅ 定时统计报表任务

✅ 海量日志扫描与聚合

✅ 消息重投/补偿机制

七、总结

通过引入 ResourceManager + Sharding 分片机制,我们实现了:

任务唯一性保证

水平扩展能力

节点动态感知与自动平衡

这是分布式任务调度从“锁控制”到“智能分片”的一次升级,让系统在面对高并发、高数据量任务时更加稳定高效。