【AIGC】HPS v2:评估人类对文本到图像合成偏好的可靠基准

数据来源

HPD v2 是一个综合性的人类偏好数据集,它比较了来自不同来源的图像,包括 9 个文本到图像生成模型和 COCO Captions 数据集 [1]。该数据集包含 79.8 万张由人工标注的、基于同一提示生成的图像的成对比较,是同类数据集中规模最大的。该数据集解决了先前数据集 [32, 33, 10] 中存在的偏差问题。第一种偏差源于图像来源。先前的数据集 [32, 33, 10] 主要包含由稳定扩散 [23] 及其变体生成的图像。因此,我们无法验证仅在这些数据集上训练和评估的模型是否能够泛化到其他图像分布。HPD v2 整合了由 9 个最新模型 [2, 17, 3, 13, 39, 23, 4, 22] 生成的图像,以及来自 COCO Captions 数据集 [1] 的真实图像,从而能够更好地评估模型的泛化能力。另一个偏见来源是文本提示。用户编写的提示,例如 DiffusionDB [ 31 ] 中的提示,通常遵循特定的描述结构,并包含一些风格词。风格词中常常包含矛盾之处,这使得标注者难以理解(参见表 1 中的示例)。此外,风格词本身也存在严重的偏见,导致训练和评估过程中出现问题。为了解决这一偏见,我们采用 ChatGPT 来移除风格词,并将提示信息组织成清晰易懂的句子。

数据集搜集过程

每个实例包含两个由同一提示生成的图像,以及一个人工选择标注。

训练细节

模型

使用了 OpenClip [8] 项目在 LAION-2B [29] 数据集上预训练的 CLIP 的 ViT-H/14 变体。该模型包含一个图像 Transformer 和一个文本 Transformer,分别作为两种模态的编码器。

模型地址

laion/CLIP-ViT-H-14-laion2B-s32B-b79K

训练配置与超参

迭代4000步,使用AdamW优化器,学习率是3.3*10-6,权重衰减是0.35,批量大小是128,预热周期是500steps,并遵循余弦学习率调度。当在有限数据上微调预训练模型时,通常的做法是冻结或降低前几层的学习率 [6, 30, 35]。我们训练了 CLIP 图像编码器的最后 20 层和 CLIP 文本编码器的最后 11 层。超参数通过贝叶斯优化确定,目标是在 HPD v2 测试集上达到最佳准确率。

训练方法

训练集及优化目标

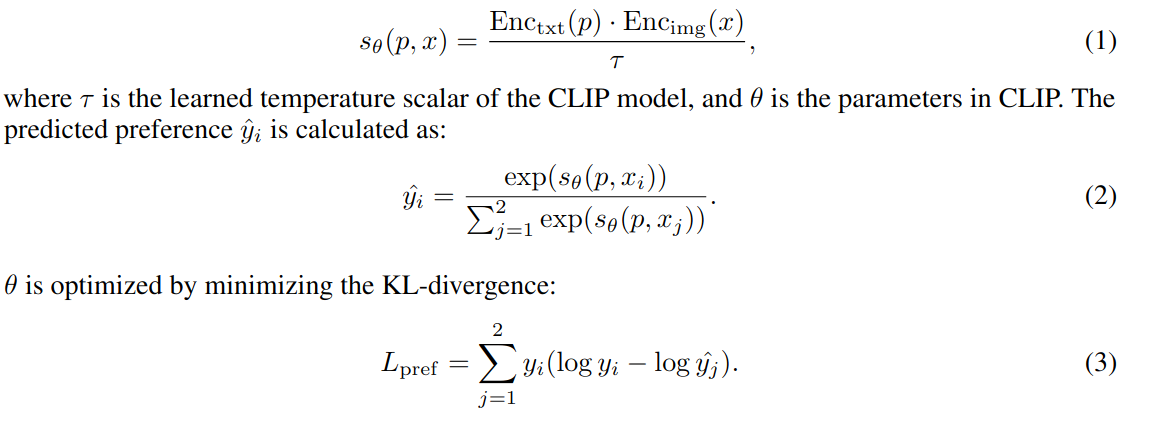

训练集中的每个实例包含一对图像 {x, x} 和一个提示 p,如果图像 x 优于 x,则提示 p 的标签为 y = [1, 0],否则为 y = [0, 1]。CLIP 模型可以看作是一个评分函数 s,用于计算提示 p 和图像 x 之间的相似度:

总结

参考论文

https://arxiv.org/pdf/2306.09341

参考工程

https://github.com/tgxs002/HPSv2.git