[人工智能-大模型-110]:用通俗易懂的语言,阐述梯度下降的本质和数学原理:就是“摸着坡度下山”——哪边最陡,就往反方向走一步,反复走,直到走到谷底。

我们用通俗易懂的语言,一步步讲清楚梯度下降的本质和数学原理,不堆公式,先理解“为什么”,再看“怎么做”。

一、梯度下降是干什么的?

想象你在一座大山的山顶,蒙着眼睛,想走到山谷最低点(比如找一条最深的沟)。你看不见路,但每走一步,你可以感觉到脚下的坡度——哪边更陡、哪边下坡。

你的策略就是:

👉 每次都往最陡的下坡方向走一步,这样大概率能慢慢接近谷底。

这个“一步步往最陡下坡方向走”的过程,就是梯度下降的核心思想!

✅ 本质一句话:

梯度下降是一种寻找函数最小值的方法——通过不断沿着函数“下降最快的方向”走一小步,最终逼近最低点。函数的参数是模型的权重参数,通过修正权重参数,确保模型对所有数据的预测结果与实际值的误差的平均值最小。

二、什么是“梯度”?

“梯度”听起来高大上,其实它就是一个指向函数上升最快方向的箭头(向量) 。

举个例子:

- 如果你在一个山坡上,梯度就是指向“最陡上坡方向”的箭头。

- 那“最陡下坡方向”呢?就是梯度的反方向。

所以,梯度下降不是顺着梯度走,而是逆着梯度走!

🔁 梯度下降 = 沿着梯度的反方向走

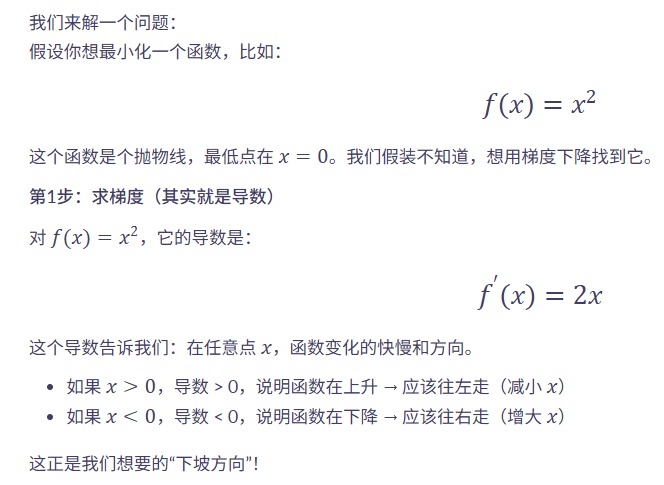

三、数学原理(简单版)

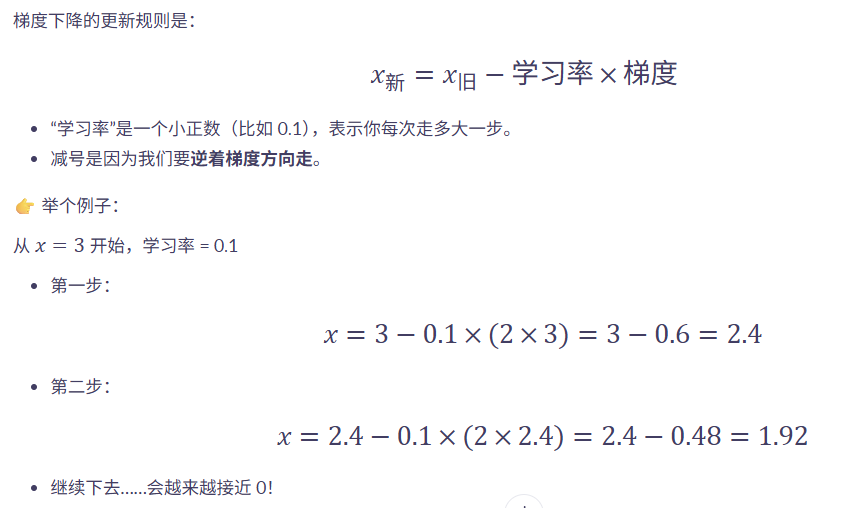

第2步:更新公式(关键!)

✅ 看到了吗?我们一步步靠近了最小值!

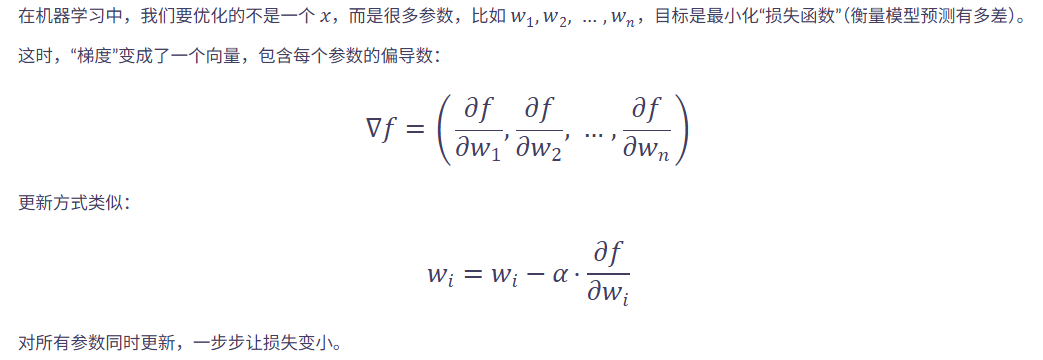

四、推广到多个可调变量(比如机器学习)

五、关键要点总结

| 概念 | 通俗解释 |

|---|---|

| 目标 | 找到函数的最小值(比如通过调整所有的模型参数W,B,让模型对所有样本的输出的误差和的平均值最小) |

| 梯度 | 当前位置上,函数上升最快的方向 |

| 下降方向 | 梯度的反方向(下坡最快) |

| 学习率 | 每次走多大步子(太大可能跳过,太小太慢) |

| 迭代 | 一步一步走,直到接近谷底 |

六、注意事项(补充)

- 🚶♂️ 学习率不能太大:可能“一步跨过谷底”,来回震荡甚至发散。

- 🐌 学习率不能太小:走得慢,训练时间长。

- ⛰ 可能卡在“局部最低点”:不是全局最优(像走到一个小坑就停了)。

现代优化算法(如 Adam)就是对梯度下降的改进,让它走得更聪明。

总结一句话:

🎯 梯度下降,就是“摸着坡度下山”——哪边最陡,就往反方向走一步,反复走,直到走到谷底。

是不是很简单?😄

进一步学习:

https://www.bilibili.com/video/BV18P4y1j7uH