k8s一站式学习

一:入门简介

1:什么是k8s

生产级别的容器编排系统。他不是容器,而是对既往的容器技术进行编排的系统。不能k8s,不能替换容器,只能管理容器。

Docker解决了容器从0到1的问题,k8s解决的是管理docker这样的容器。Docker是鲸鱼,k8s是舵手。k8s现在已经能管理很多种容器了。容器技术,现在有很多种类了。K8s现在支持了各种各样的容器。

用于自动部署,扩缩,管理容器的工作负载均衡和服务发现,可促进生声明式配置和自动化。

他就是一个生产级别的容器编排管理系统。他有一个庞大且快速生长的生态。他的服务,支持和工具的使用范围相当广泛。

Docker-Compose是单机编排。K8s是集群多节点编排。

2:为什么要用k8s

1:传统部署时代

早期各个组织运行在单个物理机上,多个应用程序部署在一台物理机上会有资源分配问题,单个应用部署单个物理机又会造成资源浪费。

2:虚拟化部署时代

虚拟操作系统隔离开了各个应用,解决了资源分配问题。这时拥有了较好的伸缩性。但是虚拟机本身也会造成计算机资源的浪费,虚拟层很笨重。拥有了很多不需要的东西, 内存寻址上也会造成浪费。

3:容器部署时代

容器类似于 V,但是更宽松的隔离特性,使容器之间可以共享操作系统(0S)。因此,容器比起 VM 被认为是更轻量级的。且与V 类似,每个容器都具有自己的文件系统、CPU、内存、进程空间等。 由于它们与基础架构分离,因此可以跨云和 0S 发行版本进行移植。 容器的出现解决了应用和基础环境异构的问题,让应用可以做到一次构建,多次部署 。不可否认容器是打包和运行应用程序的好方式,因此容器方式部署变得流行起来。但随着容器部署流行,仅仅是基于容器的部署仍有一些问题没有解决:

生产环境中, 你需要管理运行着应用程序的容器,并确保服务不会下线。 例如,如果一个容器发生故障,则你需要启动另一个容器。

高并发时,你需要启动多个应用程序容器为系统提高高可用,并保证多个容器能负载均。

在维护、升级版本时,你需要将运行应用程序容器从新部署,部署时必须对之前应用容器备份,一旦出现错误,需要手动启动之前容器保证系统运行。

容器的编排,容器的高可用,容器的负载均衡。

3:K8s能做什么

1:服务发现和负载均衡

Kubernetes 可以使用 DNS 名称或自己的IP 地址来暴露容器。如果进入容器的流量很大,Kubernetes 可以负载均衡并分配网络流量,从而使部署稳定。

2:存储编排

Kubernetes 允许你自动挂载你选择的存储系统,例如本地存储、公共云提供商等。

3:自动部署和回滚

你可以使用 Kubernetes 描述已部署容器的所需状态,它可以以受控的速率将实际状态更改为期望状态。例如,你可以自动化Kubernetes 来为你的部署创建新容器,删除现有容器并将它们的所有资源用于新容器。

4:自动完成装箱计算

你为 Kubernetes 提供许多节点组成的集群,在这个集群上运行容器化的任务。你告诉 Kubernetes 每个容器需要多少 CPU和内存(RAM)。Kubernetes 可以将这些容器按实际情况调度到你的节点上,以最佳方式利用你的资源。

5:自我修复

Kubernetes 将重新启动失败的容器、替换容器、杀死不响应用户定义的运行状况检查的容器,并且在准备好服务之前不将其通告给客户端。

6:密钥与配置管理

Kubernetes 允许你存储和管理敏感信息,例如密码、OAuth 令牌和 ssh 密钥。你可以在不重建容器镜像的情况下部署和更新密钥和应用程序配置,也无需在堆栈配置中暴露密钥。

4:k8s不是什么

Kubernetes 不是传统的、包罗万象的PaaS(平台即服务)系统。由于 Kubernetes 是在容器级别运行,而非在硬件级别,它提供了 Paas 产品共有的一些普遍适用的功能, 例如部署、扩展、负载均衡,允许用户集成他们的日志记录、监控和警报方案。 但是,Kubernetes 不是单体式(monolithic)系统,那些默认解决方案都是可选、可插拔的。 Kubernetes 为构建开发人员平台提供了基础,但是在重要的地方保留了用户选择权,能有更高的灵活性。

Kubernetes

不限制支持的应用程序类型。 Kubernetes 旨在支持极其多种多样的工作负载,包括无状态、有状态和数据处理工作负载。 如果应用程序可以在容器中运行,那么它应该可以在 Kubernetes 上很好地运行。

不部署源代码,也不构建你的应用程序。 持续集成(CI)、交付和部署(CI/CD)工作流取决于组织的文化和偏好以及技术要求。不提供应用程序级别的服务作为内置服务,例如中间件(例如消息中间件)、数据处理框架(例如 Spark)、数据库(例如 HySQL)、缓存、集群存储系统(例如 Ceph)。这样的组件可以在Kubernetes上运行,并且/或者可以由运行在Kubernetes上的应用程序通过可移植机制(例如开放服务代理)来访问。

不是日志记录、监视或警报的解决方案。 它集成了一些功能作为概念证明,并提供了收集和导出指标的机制。

不提供也不要求配置用的语言、系统(例如jsonnet),它提供了声明性API,该声明性 API 可以由任意形式的声明性规范所构成。

不提供也不采用任何全面的机器配置、维护、管理或自我修复系统。

此外,Kubernetes 不仅仅是一个编排系统,实际上它消除了编排的需要。 编排的技术定义是执行已定义的工作流程:首先执行 A、然后执行 B,再执行C。而Kubernetes 包含了一组独立可组合的控制过程,可以连续地将当前状态驱动到所提供的预期状态。 你不需要在乎如何从 A 移动到 C,也不需要集中控制,这使得系统更易于使用且功能更强大、系统更健壮,更为弹性和可扩展。

名词解释:

什么叫PASS平台:含各种软件的成熟服务系统,需要Redis直接链接就好,需要ElasticSearch直接链接就好。K8s就是一个单纯的容器运行管理平台。

二:组件&架构

1:集群组件

集群:cluster将多个节点组织到一起共同为系统组织服务的过程叫集群。Redis集群,es集群,kafka集群。

当部署完k8s之后就拥有了一个完整的集群。一组工作机器称为节点。会运行容器化应用程序,每个集群至少有一个工作节点。工作节点会托管Pod,Pod就是作为应用负载的组件,控制平面管理集群中的工作节点和Pod

k8s当中有多个节点,三个节点中有两个角色:控制节点+工作节点。k8s当中至少有一个master,至少有一个worker。控制节点负责调度和资源分配,worker节点是真正的干活的,也就是运行容器的。他的管理单元是Pod,Pod是对容器包裹了一下。一个Pod当中可以运行多个容器。

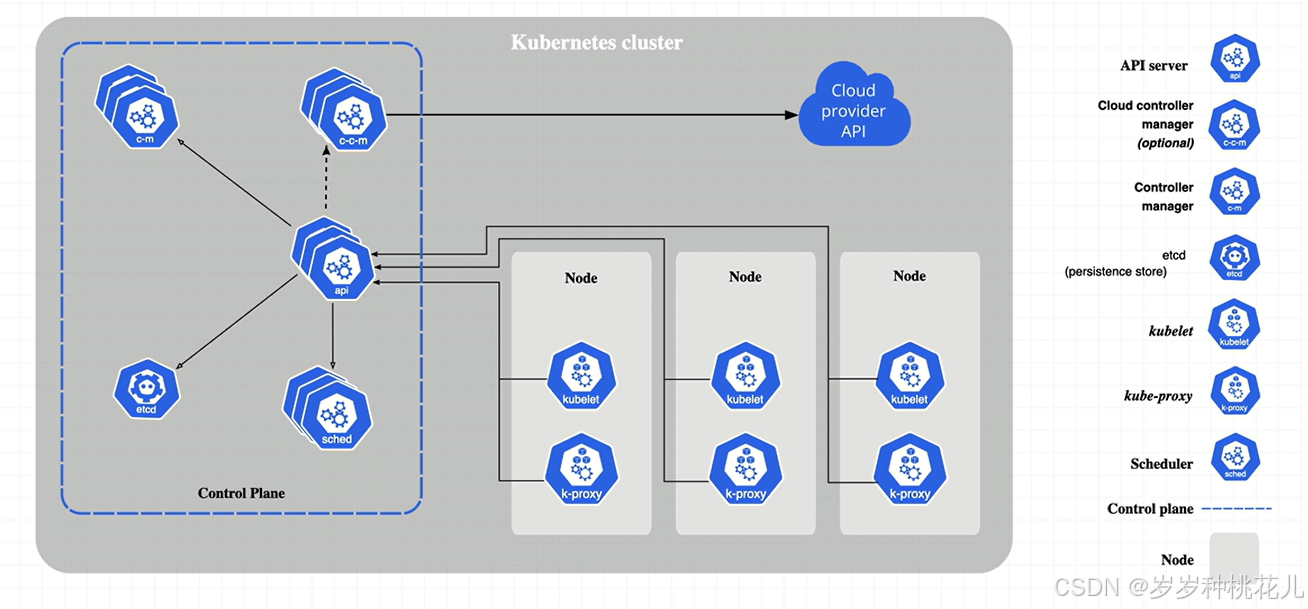

下图中左侧是控制节点,其中运行了一些k8s的组件,右侧有三个工作节点。真正用于运行应用程序的容器对应的Pod。主节点去管理多个workNode

2:核心概念

1:控制平面组件

控制平面组件会为集群做出全局决策:资源调度。以及检测和影响群时间。例如当不满足部署的replicas字段时启动新的Pod

控制平面组件可以在集群中的任何节点上运行。 然而,为了简单起见,设置脚本通常会在同一个计算机上启动所有控制平面组件, 并且不会在此计算机上运行用户容器。

1:kube-apiserver

这个是k8sAPI的总入口。他就是接收请求,处理命令的。

API server是 Kubernetes 控制平面的组件。该组件负责公开了Kubernetes API,负责处理接受请求的工作。API server是 Kubernetes控制平面的前端。Kubernetes API 服务器的主要实现是kube-apiserver。 kube-apiserver 设计上考虑了水平扩缩,也就是说,它可通过部署多个实例来进行扩缩。你可以运行 kube-apiserver 的多个实例,并在这些实例之间平衡流量。

2:etcd

一致且高可用的键值存储,用作kubernetes所有集群数据的后台数据库

记录集群信息,比如你一共有几个节点。什么时候进行了扩缩。仿佛就是k8s内置的Redis。

3:kube-scheduler

kube-scheduler 是控制平面的组件,负责监视新创建的、未指定运行节点 node的Pods, 并选择节点来让 Pod 在上面运行。

调度决策考虑的因素包括单个 Pod 及Pods 集合的资源需求、软硬件及策略约束、 亲和性及反亲和性规范、数据位置、工作负载间的干扰及最后时限。

亲和性和反亲和性或者叫黏性。我们可以指定运行在某一个节点或者不可运行到某个节点。

4:kube-controller-manager

kube-controller-manager是控制平面的组件,负责运行控制器进程。从逻辑上讲,每个控制器都是一个单独的进程,但是为了降低复杂性,它们都被编译到同一个可执行文件,并在同一个进程中运行。

这些控制器包括:

节点控制器:负责在节点出现故障时进行通知和响应

任务控制器:监测代表一次性任务的 Job 对象,然后创建 Pods 来运行这些任务直至完成

端点分片控制器:填充端点分片对象(以提供 Service和Pod 之间的链接)。

服务账号控制器:为新的命名空间创建默认的服务账号

5:cloud-controller-manager

一个 Kubernetes 控制平面组件,为了嵌入了特定于云平台的控制逻辑。云控制器管理器(Cloud Controller Manager)允许你将你的集群连接到云提供商的 API之上,并将与该云平台交互的组件同与你的集群交互的组件分离开来。

cloud-controler-manager 仅运行特定于云平台的控制器。 因此如果你在自己的环境中运行 Kubernetes,或者在本地计算机中运行学习环境, 所部署的集群不需要有云控制器管理器。与 kube-controller-manager类似,cloud-controller-manager 将若干逻辑上独立的控制回路组合到同一个可执行文件中, 供你以同一进程的方式运行。 你可以对其执行水平扩容(运行不止一个副本)以提升性能或者增强容错能力。

下面的控制器都包含对云平台驱动的依赖:

节点控制器(Node Controller):用于在节点终止响应后检查云提供商以确定节点是否已被删除

路由控制器(Route Controller):用于在底层云基础架构中设置路由

服务控制器(Service Controller):用于创建、更新和删除云提供商负载均衡器

2:Node组件

节点组件会在每个节点上运行,负责维护运行的Pod并提供kubernates运行环境

1:kubelet

kubelet 会在集群中每个节点(node)上运行。它保证容器(containers)都运行在 Pods 中。kubelet 接收一组通过各类机制提供给它的PodSpecs,确保这些 PodSpecs 中描述的容器处于运行状态且健康。 kubelet 不会管理不是由Kubernetes 创建的容器。

2:kube-proxy

他就是一个实现内外部服务网络交互的规则

kube-proxy是集群中每个节点(node)上所运行的网络代理,实现Kubernetes 服务(Service)概念的一部分。kube-proxy 维护节点上的一些网络规则, 这些网络规则会允许从集群内部或外部的网络会话与 Pod 进行网络通信。如果操作系统提供了可用的数据包过滤层,则 kube-proxy 会通过它来实现网络规则。否则,kube-proxy 仅做流量转发

3:容器运行时(Container Runtime)

容器运行环境是负责运行容器的软件。

Kubernetes 支持许多容器运行环境,例如containerd、CRI-0、Docker以及 Kubernetes CRI 的其他任何实现

3:插件

1:DNS

尽管其他插件都并非严格意义上的必需组件,但几乎所有 Kubernetes 集群都应该有集群 DNS因为很多示例都需要 DNS 服务

2:Web 界面(仪表盘)

Dashboard 是 Kubernetes 集群的通用的、基于 Web 的用户界面。 它使用户可以管理集群中运行的应用程序以及集群本身, 并进行故障排除。

3:容器资源监控

容器资源监控将关于容器的一些常见的时间序列度量值保存到一个集中的数据库中, 并提供浏览这些数据的界面。

4:集群层面日志

集群层面日志机制负责将容器的日志数据保存到一个集中的日志存储中,这种集中日志存储提供搜索和浏览接口。

三:集群安装

1:minikube

只是一个k8s集群模拟器,只有一个节点的集群。master和woker都在一起。

2:裸机安装

至少需要两台机器,一个主节点一个工作节点,需要自己安装kubernetes组件。配置会稍微麻烦点。

缺点:配置麻烦,缺少生态支持,例如负载均衡器,云存储等等。

1:环境准备

节点数量:3台虚拟机centos7

硬件配置:2.5 G或者更多的RAM,2CPU或者更多的CPU,硬盘至少30G

网络要求:多个节点之间网络互通,每个节点都能访问外网。

2:windows远程登录

## 这是没开虚拟机链接不上的状态

C:\Users\JavaC>ssh cuillei@192.168.67.128

ssh: connect to host 192.168.67.128 port 22: Connection timed out## 下面是正常链接的情况

C:\Users\JavaC>ssh cuillei@192.168.67.128

cuillei@192.168.67.128's password:

Activate the web console with: systemctl enable --now cockpit.socketLast login: Mon Sep 15 08:17:24 2025

[cuillei@localhost ~]$PS C:\Users\JavaC> ssh cuillei@192.168.67.129

cuillei@192.168.67.129's password:

Activate the web console with: systemctl enable --now cockpit.socketLast login: Mon Sep 15 09:00:35 2025 from 192.168.67.1

[cuillei@localhost ~]$PS C:\Users\JavaC> ssh cuillei@192.168.67.130

The authenticity of host '192.168.67.130 (192.168.67.130)' can't be established.

ED25519 key fingerprint is SHA256:Ja/ZNNxWk3jpd3arTEXtFad+Cw9iSgUFCIKXeEX+7s0.

This host key is known by the following other names/addresses:C:\Users\JavaC/.ssh/known_hosts:2: 192.168.67.129

Are you sure you want to continue connecting (yes/no/[fingerprint])? yes

Warning: Permanently added '192.168.67.130' (ED25519) to the list of known hosts.

cuillei@192.168.67.130's password:

Activate the web console with: systemctl enable --now cockpit.socketLast login: Mon Sep 15 08:56:03 2025

[cuillei@localhost ~]$[cuillei@localhost ~]$ ifconfig

br-bac44d1523c3: flags=4099<UP,BROADCAST,MULTICAST> mtu 1500inet 172.19.0.1 netmask 255.255.0.0 broadcast 172.19.255.255ether 66:59:8d:ad:50:96 txqueuelen 0 (Ethernet)RX packets 3 bytes 84 (84.0 B)RX errors 0 dropped 0 overruns 0 frame 0TX packets 35 bytes 4588 (4.4 KiB)TX errors 0 dropped 8 overruns 0 carrier 0 collisions 0br-ffabf460fd09: flags=4099<UP,BROADCAST,MULTICAST> mtu 1500inet 172.18.0.1 netmask 255.255.0.0 broadcast 172.18.255.255ether fe:4e:b7:46:ac:06 txqueuelen 0 (Ethernet)RX packets 3 bytes 84 (84.0 B)RX errors 0 dropped 0 overruns 0 frame 0TX packets 35 bytes 4588 (4.4 KiB)TX errors 0 dropped 8 overruns 0 carrier 0 collisions 0docker0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet 172.17.0.1 netmask 255.255.0.0 broadcast 172.17.255.255inet6 fe80::b480:bdff:fe29:5637 prefixlen 64 scopeid 0x20<link>ether b6:80:bd:29:56:37 txqueuelen 0 (Ethernet)RX packets 3 bytes 84 (84.0 B)RX errors 0 dropped 0 overruns 0 frame 0TX packets 35 bytes 4588 (4.4 KiB)TX errors 0 dropped 8 overruns 0 carrier 0 collisions 0ens33: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet 192.168.67.130 netmask 255.255.255.0 broadcast 192.168.67.255inet6 fe80::20c:29ff:fecd:4b4e prefixlen 64 scopeid 0x20<link>ether 00:0c:29:cd:4b:4e txqueuelen 1000 (Ethernet)RX packets 258 bytes 38150 (37.2 KiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 171 bytes 19059 (18.6 KiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0lo: flags=73<UP,LOOPBACK,RUNNING> mtu 65536inet 127.0.0.1 netmask 255.0.0.0inet6 ::1 prefixlen 128 scopeid 0x10<host>loop txqueuelen 1000 (Local Loopback)RX packets 18 bytes 2112 (2.0 KiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 18 bytes 2112 (2.0 KiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0veth4ad8f6c: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet6 fe80::38e6:2dff:fead:51f6 prefixlen 64 scopeid 0x20<link>ether 3a:e6:2d:ad:51:f6 txqueuelen 0 (Ethernet)RX packets 3 bytes 126 (126.0 B)RX errors 0 dropped 0 overruns 0 frame 0TX packets 62 bytes 7653 (7.4 KiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0[cuillei@localhost ~]$3:集群ip记录

节点1:192.148.67.128 将来作为控制节点节点2:192.148.67.129 将来作为worknode节点3:192.148.67.130 将来作为worknode4:设置主机名

hostnamectl set-hostname k8s-node1hostnamectl set-hostname k8s-node2hostnamectl set-hostname k8s-node35:同步hosts文件

如果DNS不支持主机名解析,还需要在每台机器行的/etc/hosts文件中添加主机名和IP的对应关系。

cat >> /etc/hosts <<EOF

192.168.67.128 k8s-node1

192.168.67.129 k8s-node2

192.168.67.130 k8s-node3

EOF6:关闭防火墙

systemctl stop firewalld && systemctl disable firewalld7:关闭swap分区

swapoff -a && sed -ri 's/.*swap.*/#$/' /etc/fstab8:同步所有节点的时间

yum install ntpdate -y

ntpdate time.windows.com9:安装containerd和cri-tools

安装k8s的容器运行环境,容器运行环境所有节点都需要安装包含主节点和工作节点。早起版本用的是docker容器环境,最新版本就不用docker了。新版本我们containerd,docker的底层也是containerd,只不过docker对containerd做了进一步的实现。

## 安装yum-config-manager相关依赖

yum install -y yum-utils device-mapper-persistent-data lvm2## 添加containerd yum源

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo## 安装containerd

yum install -y containerd.io cri-tools10:安装cri-tools

## 安装编译依赖:

sudo dnf install -y golang git make##克隆源码并 checkout 兼容版本:

git clone https://github.com/kubernetes-sigs/cri-tools.git

cd cri-tools## 选择一个稳定版本(如v1.26.0,与K8s版本匹配)

git checkout v1.26.0##编译并安装:

make

sudo make install##验证安装:

crictl --version##检查环境变量 PATH

echo $PATH

如果看不到/usr/local/bin,需要将其添加到环境变量:## 临时生效

export PATH=$PATH:/usr/local/bin## 永久生效(对所有用户)

echo 'export PATH=$PATH:/usr/local/bin' | sudo tee -a /etc/profile

source /etc/profile11:配置containerd

cat > /etc/containerd/config.toml << EOF

disabled_plugins=["restart"]

[plugins.linux]

shim_debug = true

[plugins.cri.registry.mirrors."docker.io"]

endpoint=["https://91weqgtbxwneyz.xuanyuan.run"]

[plugins.cri]

sandbox_image="registry.aliyuncs.com/google_containers/pause:3.2"

EOF