第二章、Docker+Ollama封神!2步装Qwen+Deepseek小型模型

宝子们!上篇 Ubuntu Docker 教程火了~ 好多宝子问怎么用 Docker 装 Ollama 跑大模型,今天安排上!不用复杂配置,2 步就能装完 Qwen 和 Deepseek 的小型库,本地就能聊,还不占太多内存👏

📌 前提:已装 Docker(没装的看上篇教程!)

先确认 Docker 在运行:终端输docker ps,能看到表头就没问题~ 没运行的话输sudo systemctl start docker启动

🔧 第一步:Docker 拉取 Ollama 镜像(超简单!)

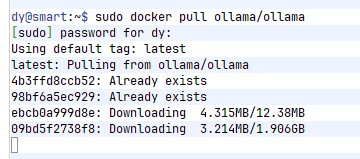

打开终端(Ctrl+Alt+T),直接复制这条命令,回车:

sudo docker pull ollama/ollama等待下载完成,期间可以喝口水~ 下载速度看网速,一般几分钟就好

📸

🚀 第二步:启动 Ollama 容器 + 装 Qwen+Deepseek 小型模型

1. 先启动 Ollama 容器

输这条命令,创建并启动容器(映射端口 + 挂载模型目录,避免下次重装丢模型):

sudo docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama✅ 解释下关键参数(新手不用记,照输就行):

d:后台运行容器v ollama:/root/.ollama:把模型存在本地,删容器也不会丢p 11434:11434:映射端口,本地能通过这个端口访问

📸

2. 安装 Qwen 小型模型(阿里的!超流畅)

容器启动后,输这条命令拉取 Qwen 小型库(选的是 7B 以下的小型版,占内存小):

sudo docker exec -it ollama ollama run qwen:0.5b等待模型下载 + 加载,第一次会慢一点,出现 “>>>” 提示符就说明能聊了!

可以试着重输入:“介绍下自己”,模型会马上回复~

📸

3. 安装 Deepseek 小型模型(代码能力强!)

不用停 Ollama,新开一个终端,输这条命令:

sudo docker exec -it ollama ollama run deepseek-coder:1.3b同样等加载完成,出现 “>>>” 就可以提问啦~ 小型模型适合写简单代码、答疑,日常够用!

📸 配图建议:终端加载 Deepseek 成功的截图,加个 “代码神器 get” 的文字贴纸,附一句示例提问 “写一个 Python Hello World”

❌ 常见问题解决(踩坑总结)

拉取模型提示 “connection refused”?

👉 先检查容器是否在运行:

sudo docker ps,没看到 ollama 容器就重新执行启动命令模型下载慢 / 中断?

👉 可以换国内镜像源,或者重新输拉取命令,Ollama 会断点续传

终端关了模型就停了?

👉 因为用了

-d后台运行容器,只要容器没删,重新输sudo docker exec -it ollama ollama run 模型名就能重新启动对话

💡 新手实用小技巧

- 查看已装模型:终端输

sudo docker exec -it ollama ollama list - 停止模型对话:按 Ctrl+C

- 关闭 Ollama 容器:

sudo docker stop ollama(想重新开就输sudo docker start ollama) - 推荐小型模型(占内存<8G):

- qwen:0.5b(通用型,聊天流畅)

- deepseek-coder:1.3b(写代码超棒,适合新手)

不用复杂配置,本地就能拥有两个 AI 助手!后续会出 Ollama 模型调优、Web 界面搭建教程,关注不迷路~

#Docker 教程 #Ollama #大模型 #Qwen #Deepseek #Ubuntu 技巧 #编程工具 #AI 入门