RTSP低延迟播放重构:SmartMediaKit如何让系统“看见即行动”

延迟,不只是数字,更是体验的生死线。

在安防监控、无人机回传、工业远程控制、教育互动课堂等实时场景中,

RTSP的延迟决定了系统是否“实时可用”。

一、RTSP延迟的极限:理论与现实的落差

从协议层面来看,RTSP 本身只是“控制层”,真正决定延迟的,是其承载的数据通道——RTP/RTCP 传输 + 网络链路 + 解码 + 渲染。

在理想网络环境下,UDP 模式端到端延迟可降至 100~200ms,而 TCP 模式因重传机制,一般在 200~400ms。然而现实中,跨网段传输、软解开销、缓冲滞后、渲染阻塞等因素叠加,让延迟轻松突破 500ms 至 2s。

传统开源播放器(VLC、FFmpeg、Live555)的问题并不在算法,而在架构:

-

静态缓冲策略:默认缓存 1~3 秒;

-

多次数据拷贝(CPU→系统内存→GPU);

-

缺乏动态 JitterBuffer 调节;

-

软解与时钟同步滞后。

结果是,理论上 200ms 的延迟,在现实中往往成为“一整秒的等待”。延迟的根源,从不是协议,而是体系。

Windows平台 RTSP vs RTMP播放器延迟大比拼

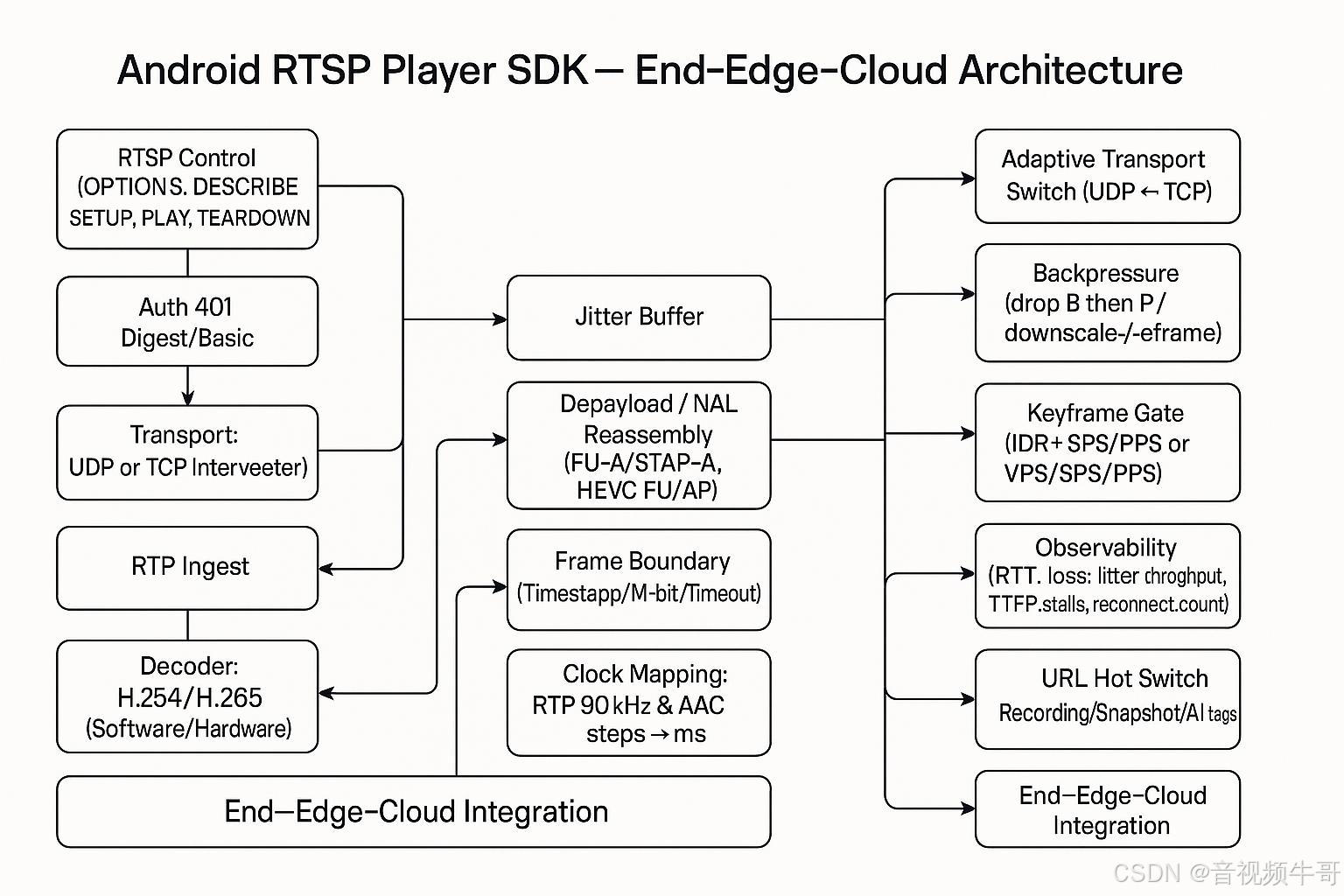

二、大牛直播SDK的核心突破:让“低延迟”成为系统的本能

在 RTSP 生态中,真正的低延迟,靠的不是“配置技巧”,而是“系统设计”。大牛直播SDK从底层架构重构播放链路,使延迟成为一种系统能力。

1️⃣ 架构层的重构

传统播放器采用串行管线,天然引入等待。

大牛直播SDK以多线程解码 + 异步渲染 + 时序驱动为核心,

让数据流在进入系统的瞬间即被分发执行,实现并行处理与时序同步。

2️⃣ 智能自适应缓冲引擎

固定缓冲意味着“延迟不可控”。

SDK 的自适应 Buffer Engine 能实时监测 RTP 间隔、抖动与丢包率,

在稳定网络下主动压缩缓冲窗口,在不稳定网络中则动态平衡流畅性。

因此,在多数场景下,端到端延迟稳定保持在 100~200ms 区间。

3️⃣ 零拷贝渲染管线

开源播放器往往存在多次 CPU↔GPU 内存拷贝。

SDK 通过低拷贝渲染架构,首帧“秒开”、资源占用更低、多实例播放依旧流畅。

4️⃣ 面向稳定的设计哲学

低延迟如果不稳定,就毫无意义。

SDK 支持 TCP/UDP 自动切换、RTSP 401 鉴权自动处理、断网重连与时序补偿,

确保在复杂网络环境下依旧连续可控。

在大牛直播SDK的体系中,延迟不是结果,而是一种被“工程化”的性能。

它不是被动减少,而是主动设计的产物。

安卓RTSP播放器多实例播放时延测试

三、实测对比:真延迟才是硬指标

参数可以修饰性能,但“延迟”揭示本质。在相同网络与码流条件下,开源播放器普遍需要 500ms~2s 才能完成渲染,而大牛直播SDK凭借体系化优化,端到端延迟稳定控制在 100~200ms。

在使用体验中,这种差距几乎触手可感:

大牛直播SDK画面几乎“即刻出现”,镜头移动、声音反馈与现场完全同步;而开源播放器常常“慢半拍”。对于安防调度、远程控制、无人机等实时业务而言,这一拍的延迟,就是从“可视”到“可控”的分界线。

更难得的是,这种性能并未以稳定性为代价。无论是断流、丢包还是弱网,SDK 都能通过自适应机制快速重连、自动补偿,在系统层面维持连续与流畅。

大牛直播SDK的价值,不仅是“更快”,而是“更可控”。

它用工程化的方式,让毫秒成为可预测、可管理的单位。

安卓轻量级RTSP服务采集摄像头,PC端到安卓拉取RTSP流

四、为何这很重要:从“可看”到“可控”

RTSP播放器的使命,正在从“让画面能看见”,转向“让系统能反应”。

这是从人类视觉体验到机器感知能力的一次跃迁。

延迟,不只是体验指标,而是控制权的分界线。

超过 500ms,画面已不再属于现实,而成为一种“回放”;

而当延迟被压缩至 200ms 以内,视频与现实几乎同速,系统得以“看到即行动”。

这标志着一个时代的临界点:视频从“显示信息”变为“触发行为”。

这种变化,在不同领域中呈现出不同的价值维度:

-

在安防系统中,它意味着指令与现场画面的实时对齐,警情识别、云台联动、AI布控都能在毫秒级完成。安防不再是“事后取证”,而是真正实现“实时防控”。

-

在无人机与低空经济领域,它意味着“操控即响应”。飞行控制、云台转动、避障算法与画面回传保持同步,让远程操作像“身临其境”一样自然。

-

在工业远程控制中,它意味着机械臂、生产线、检测设备的动作,基于“当下画面”作出判断,而非滞后的数据。低延迟成为精密控制的前提条件。

-

在AI视觉系统中,它意味着算法分析与现实时序的完美重合。目标检测、识别、追踪、分割等模型不再处理“历史帧”,而是实时输入,使“感知-决策-执行”真正成为闭环。

Android平台RTSP播放器时延测试

延迟的降低,不仅提升了画面的“及时性”,更重塑了系统的“决策逻辑”。当反应时间被压缩到人类感知阈值之下,系统获得了一种新的“同步能力”——它能与现实世界在同一时间尺度上运行。

大牛直播SDK,正是这种能力的工程化体现。通过自研内核与自适应架构,它让“实时视频”从被动的视觉流,升级为具备反应速度、稳定节奏与信息自治能力的“感知神经元”。系统不再只是“播放”,而是能够“感知、理解、响应”。

低延迟的尽头,是控制力。

它让智能不再只是算得快,而是反应得准;

不只是能看世界,而是能与世界实时互动。

五、功能矩阵:从播放能力到系统基石

除了延迟优化,大牛直播SDK在功能层面也展现出全面的工程实力:

✅ 协议与编解码

-

支持 RTSP (TCP/UDP 自动切换),全自研协议栈,稳定性业内领先;

-

支持 H.264 / H.265 / MJPEG 视频格式,AAC / PCMA / PCMU 音频格式;

-

支持软解与硬解(Windows / Linux / Android / iOS 全平台),

Android 支持 Surface 模式硬解与普通硬解自由切换; -

支持 RTSP 超时设置、401 鉴权处理与自动重连机制。

✅ 播放与控制能力

-

支持多实例播放、首屏秒开、实时静音、实时音量调节;

-

支持快速切换 URL,播放流无缝切换;

-

支持实时快照、关键帧播放、镜像翻转、旋转角度设置、等比例缩放等多样渲染控制;

-

提供解码前后视频数据回调(H.264/H.265 YUV/RGB)、音频数据回调(AAC/PCMA/PCMU);

-

支持实时下载速率回调与网络状态事件上报。

✅ 系统扩展性

-

与录像SDK无缝对接,支持 RTSP H.265 流录制、PCMA/PCMU→AAC 转码录制;

-

支持设置只录制音频或视频;

-

支持复杂网络环境自动恢复与缓冲自适应策略。

✅ 全平台覆盖

-

Windows / Linux(x86_64 | aarch64) / Android / iOS 全平台一致支持;

-

支持多种渲染机制:SurfaceView、OpenGL ES、DirectX、AudioTrack、OpenSL ES;

-

在嵌入式与边缘端设备中依旧保持极低资源占用。

这些功能共同构成了一套完善的、跨平台的 实时视频播放体系。

它不仅能播放流,更能让视频在系统间流动、协作与计算。

六、开放生态与未来演进:从感知到协同,从系统到生态

低延迟是起点,协同是未来。

当视频流不再只是影像,而成为系统间的实时数据通道,RTSP播放器的角色也随之进化——

它从一个独立模块,成为视频神经系统的前端感知节点。

大牛直播SDK以模块化架构连接采集、传输、播放、录制、转推、AI识别等环节,通过统一的事件机制与数据接口,实现横向扩展、纵向融合。

例如:

-

在安防集群中,RTSP播放器可作为边缘节点,将多路视频流分发至监控中心与AI算法模块,实现“前端感知 + 后端决策”的闭环。

-

在无人机与低空经济体系中,它成为空中视觉神经元,为地面控制系统提供毫秒级画面输入,支持编队协同、远程调度。

-

在工业与医疗领域,它构建安全可控的远程视觉链路,使专家与设备在同一时刻“共视共感”。

-

在AI感知系统中,它与算法模块形成内在耦合,让视频成为算法的原始输入,实现从“可见”到“可懂”。

这种开放生态的意义在于:

视频流不再是“媒体”,而是“数据”;播放器不再是“终端”,而是“节点”。未来的视频系统将像神经网络一样,每一个节点都能感知、传递、协作、学习。

而大牛直播SDK,正是这张网络的“感知前线”——它让视频流以最低延迟进入系统决策链,让AI在实时世界中运算、反馈、控制。

技术的终点,不是画面更清晰,而是系统更敏捷;

真正的创新,不是播放更快,而是协同更深。

大牛直播SDK,正在让视频从信息,变为行动;从系统智能,走向生态智能。

📎 CSDN官方博客:音视频牛哥-CSDN博客