When NOMA Meets AIGC: Enhanced WirelessFederated Learning

摘要

1. 研究背景

论文关注的是无线联邦学习(Wireless Federated Learning, WFL),这是一种让多个设备在不共享原始数据的情况下,通过本地训练和模型上传来协同训练全局模型的技术。

但在实际中,WFL 面临数据稀缺与异质性问题:各设备上的数据量有限且分布不均,这会导致整体模型性能下降。

2. 引入 AIGC 解决数据问题

作者提出利用人工智能生成内容(AIGC)技术来生成合成数据,以弥补各设备本地数据不足,从而提升模型训练效果。

不过,这带来了新的挑战——下载合成数据和上传本地模型都非常耗时,尤其当设备数量很多时。

3. 使用 NOMA 提高通信效率

为解决通信效率低的问题,论文提出采用非正交多址接入(NOMA)技术,使得多个设备可以同时进行数据和模型传输,从而加快整个训练与数据交换过程。

4. 提出的创新点

论文首次将 AIGC + NOMA + WFL 三者结合起来,以最大化提升学习性能。

研究目标是联合优化合成数据分配、双向通信资源和计算资源分配,以最小化全局学习误差。

5. 方法与算法

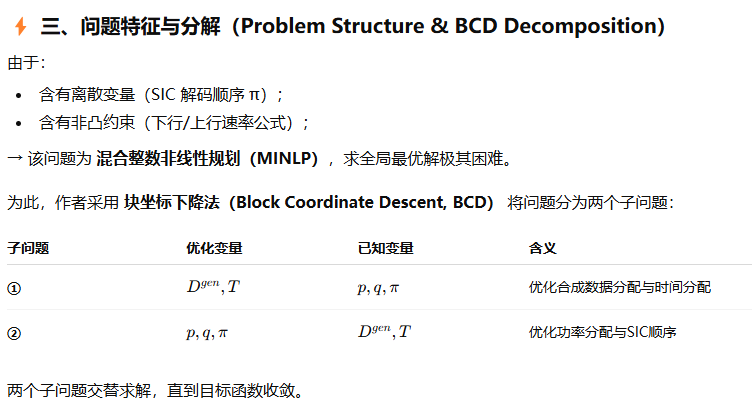

该优化问题属于混合整数非线性规划(MINLP),求最优解非常困难。

作者采用:

块坐标下降(BCD)法来分解变量;

解析近似法得到低复杂度的局部最优解(部分为闭式解)。

6. 实验与结果

通过大量仿真验证,所提方案在学习性能上优于传统方案,包括基于频分/时分多址(FDMA/TDMA)的 AIGC 增强型 WFL 方法。

引言

1. 研究背景:IoT 与分布式机器学习的需求

随着 物联网(IoT)设备数量爆炸式增长,产生了海量数据,需要通过机器学习来进行分析,用于支持增强现实(AR)、虚拟现实(VR)等应用。

但由于无线通信资源有限,将所有数据上传到数据中心进行集中式训练是不现实的。

幸运的是,设备的计算能力不断提升(芯片技术进步),因此可以采用分布式机器学习的方式,让设备在本地训练模型。

⚙️ 2. 联邦学习(FL)与无线联邦学习(WFL)

联邦学习(Federated Learning, FL)允许多个设备在不上传原始数据的情况下协同训练全局模型,从而保护隐私。

无线联邦学习(WFL)是 FL 的无线扩展,设备通过带宽受限、能量有限的无线信道与中央服务器通信。

在 WFL 中,流程是:

服务器下发全局模型;

各设备用本地数据独立训练;

上传本地模型;

服务器聚合成新的全局模型;

重复迭代直到模型收敛。

因此,**无线传输性能(带宽、能耗等)**对 WFL 效果有关键影响,需要进行特别设计与优化。

⚠️ 3. WFL 面临的问题:数据稀缺与异质性

各设备的数据 数量有限且分布不均(data scarcity & heterogeneity);

某些设备可能缺少特定类型的数据;

这会导致全局模型的收敛精度下降。

已有解决思路:

设备选择(device selection):只选择部分设备参与聚合;

缺点:引入公平性问题,弱设备可能被长期忽略;

数据补充(data collection):让设备去采集缺失数据;

缺点:高延迟、耗能大,对资源受限设备不适用。

🧠 4. 解决思路:引入 AIGC 生成合成数据

AIGC(Artificial Intelligence Generated Content) 是一种自动生成数据的技术,可以帮助设备补充缺失的数据类型;

AIGC 能生成多种形式的数据(文本、图像、视频等),使用的模型包括:

生成对抗网络(GAN)

变分自编码器(VAE)

扩散模型(Diffusion Models);

由于 AIGC 计算量大,可部署在云端 AIGC 服务器;

各设备可以请求云端生成特定类型的合成数据并下载,用于本地训练;

这样既能节省数据采集时间与能耗,又能缓解数据稀缺与分布不均的问题。

相关工作

1. 现有 WFL 研究:聚焦于资源优化与设备调度

论文首先回顾了大量关于 WFL 的研究工作 [11]–[16],这些工作主要探讨了 如何优化 WFL 的通信、计算和调度资源 以提升训练效率或降低能耗。具体包括:

[11]:提出一种基于 匈牙利算法(Hungarian method) 的联合优化方案,同时优化学习、无线资源分配与设备选择,以最小化 WFL 损失函数。

[12]:研究了 学习与通信资源联合优化 问题,目标是最小化总能耗,并通过迭代算法求得局部最优解。

[13]:联合优化 计算与通信资源 及模型量化比特数,以最小化收敛时间。

[14]:提出一种基于 TDMA(时分多址) 的方案,协调本地训练与模型上传以减少每轮训练时延。

[15]:基于 指针网络(pointer network) 和 深度强化学习(DRL) 提出联合调度算法,优化设备调度与无线资源分配。

[16]:基于 Stackelberg 博弈 设计激励机制,鼓励设备参与模型训练。

这些研究使用的无线传输方式有:

[11], [12], [15], [16] → FDMA(频分多址)

[13], [14] → TDMA(时分多址)

而两者都属于 OMA(正交多址),其缺点是:

传输效率低,因为每个设备独占一个时频资源,无法并行通信。

⚙️ 2. NOMA 增强型 WFL:提高通信效率

为克服 OMA 的低效,研究者引入了 NOMA(非正交多址接入) 技术 [17], [18]:

多个设备可同时在同一频谱上传输;

服务器利用 叠加编码(superposition coding) 和 串行干扰抵消(SIC) 技术解码不同设备信号;

从而实现更高的传输效率。

在此基础上,一些 NOMA + WFL 的工作出现了 [19]–[22]:

[19]:设备通过基站无线供能,联合优化 NOMA 通信与计算资源以最小化系统成本,采用**单调优化(monotonic optimization)**算法;

[20]:在中继辅助 NOMA-WFL 网络中,联合优化设备调度、功率与计算频率以最小化能耗;

[21]:将设备分组为不同的 NOMA 群组,联合优化功率与带宽以最大化收敛性能;

[22]:通过单调性分析与对偶分解优化设备选择和资源分配,最小化总训练时延。

➡️ 这些工作证明了 NOMA 技术能显著提升 WFL 网络的通信与训练效率。

🧠 3. AIGC 在无线网络与 WFL 中的应用

接下来,作者讨论了 AIGC(人工智能生成内容) 在无线网络中的新兴研究方向:

无线网络中的 AIGC 应用包括:

语义通信增强(AIGC-enhanced semantic communication) [23]–[25];

区块链赋能的 AIGC [26];

分布式 AIGC [27];

AIGC 服务提供商选择 [28];

内容缓存优化 [29], [30]。

AIGC 也开始与 FL/WFL 结合:

[31]、[32]:关注 如何用联邦学习(FL)来赋能 AIGC;

[31] 用 WFL 实现高效的 AIGC 生成,提升个性化内容;

[32] 提出安全、可持续的 WFL-AIGC 训练架构,对抗触发式攻击。

[33]–[36]:关注 如何用 AIGC 来增强 FL/WFL;

[33]:用 AIGC 生成额外训练数据,在保证性能的前提下降低能耗;

[34]:提出基于特征匹配与增强的 AIGC 方法,缓解非 IID 数据问题;

[35]:提出基于数据质量的激励机制;

[36]:提出基于反向拍卖的激励机制促进设备参与。

🚀 4. 小结与本文创新点的铺垫

总结来看:

以往工作要么专注于 WFL 的通信与资源优化;

要么研究 NOMA 提高传输效率;

或者探讨 AIGC 与 FL 的结合。

然而,还没有工作将 AIGC 与 NOMA 同时结合到 WFL 框架中。这正是本文的研究空白与创新点所在。

动机和贡献

🧩 一、研究动机(Motivation)

作者首先指出:

在 无线联邦学习(WFL) 中,由于设备异构、数据有限且分布不均,可以利用 AIGC(人工智能生成内容) 来生成缺失的数据,从而提升本地训练效果和全局模型的收敛性能。

但现有研究仍存在三个关键问题:

1️⃣ 现有工作主要聚焦于有线 FL,而非无线 WFL

多数 AIGC+FL 研究(如 [34]–[36])只考虑有线通信环境;

未考虑无线环境下的关键挑战,如:

带宽受限;

信道衰落与干扰;

因此,现有方法不适用于无线 IoT 场景,而 IoT 环境正是 WFL 的典型应用。

2️⃣ 忽略了合成数据传输的时间开销

唯一涉及 AIGC 增强 WFL 的工作 [33] 忽略了从 AIGC 服务器下载合成数据的延迟;

实际中,数据下载需要时间,会形成数据量与效率的权衡:

更多合成数据 → 模型精度更高;

但传输延迟变长 → 系统效率下降;

因此需要优化合成数据生成与分配策略以平衡精度与效率。

3️⃣ 使用低效的多址接入方式(FDMA)

[33] 使用 FDMA(频分多址) 上传本地模型;

在设备数量多的 IoT 场景中,FDMA扩展性差、效率低;

因此需要采用更高效的传输机制来提升系统性能。

⚙️ 二、本文提出的解决方案

基于上述问题,作者提出了:

一种结合 NOMA 与 AIGC 的增强型 WFL 框架(NOMA+AIGC-enhanced WFL)

主要思想:

采用 NOMA(非正交多址接入) 技术实现:

合成数据下载(下行);

本地模型上传(上行);

同时联合优化以下要素以提升学习性能:

合成数据分配;

双向通信资源;

计算资源(包括设备与基站功率分配、SIC解码顺序等)。

与以往 NOMA-WFL 研究的不同:

传统 NOMA-WFL [19]–[22] 仅考虑模型上传;

本文同时在数据下载与模型上传中使用 NOMA;

解码顺序不仅受信道增益影响,还需考虑数据量与能耗异构性;

优化问题更复杂,涉及多层耦合变量(合成数据分配、功率控制、SIC顺序等)。

与 AIGC-WFL(如 [33])的区别:

本文使用 NOMA(并行通信),而 [33] 使用 FDMA(正交通信);

本文显式考虑 AIGC 数据分配与下载过程;

考虑 AIGC 服务器的合成能力有限 与 设备能量约束,对能耗、训练轮数与收敛都有综合影响;

问题更复杂,但也更贴近真实 IoT 场景。

🚀 三、主要贡献(Contributions)

作者总结了三项核心贡献:

① 首次提出 NOMA+AIGC 增强型 WFL 系统模型

设备可通过 NOMA 从 AIGC 服务器下载合成数据;

本地训练后,再通过 NOMA 向 WFL 服务器上传模型;

建立联合优化问题,目标是最小化全局学习误差;

优化变量包括:

合成数据分配;

时间分配;

BS 与设备的功率分配;

SIC 解码顺序;

计算频率分配。

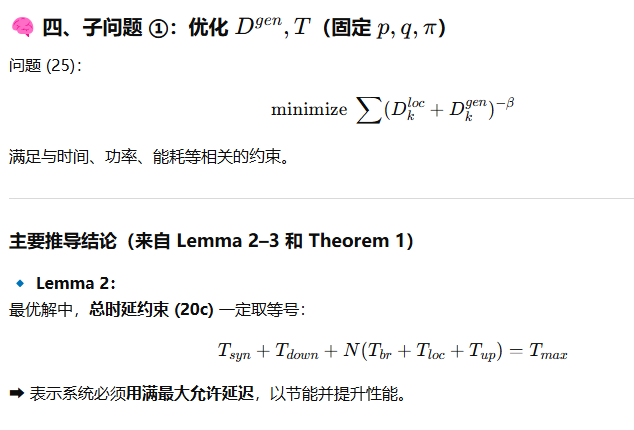

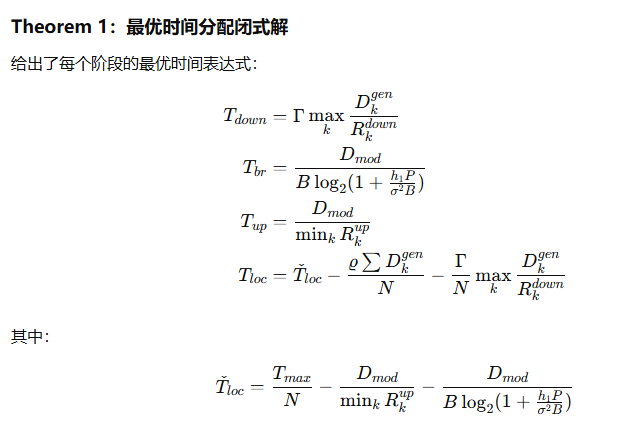

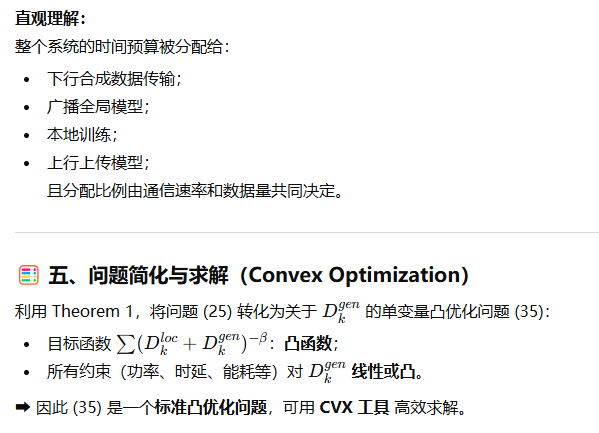

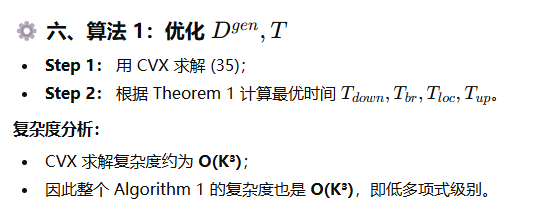

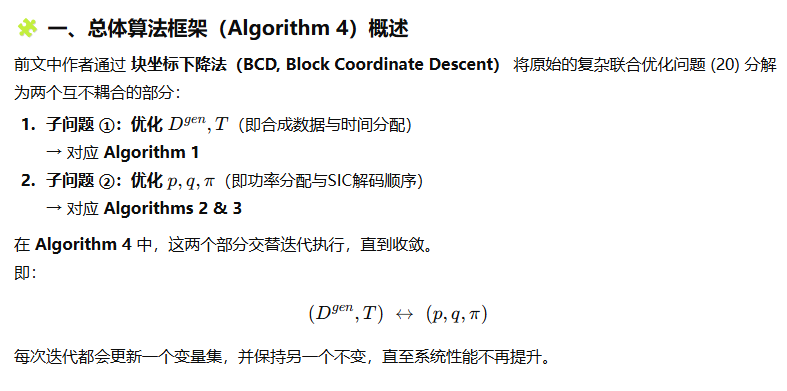

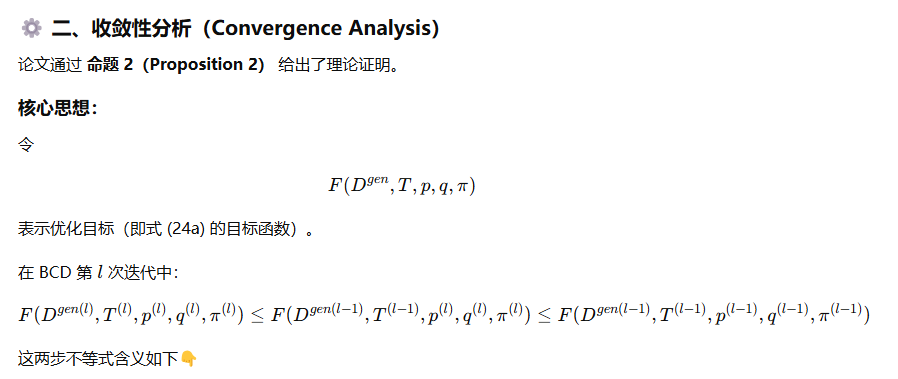

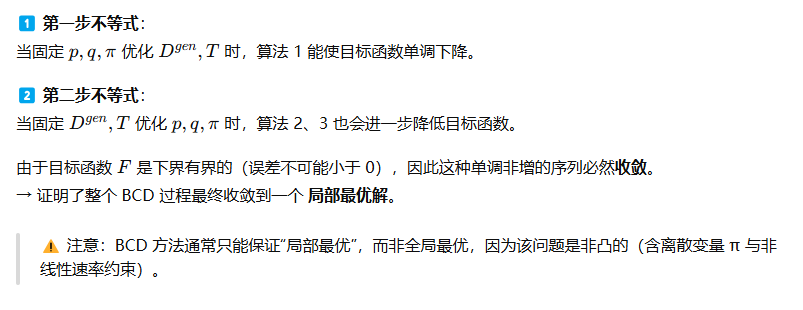

② 提出低复杂度算法框架

解析推导部分变量的闭式解(如计算频率、部分功率分配等);

采用 块坐标下降法(BCD) 分解为两个子问题:

子问题1: 优化合成数据与时间分配(部分可解析求解);

子问题2: 优化功率分配与 SIC 顺序(递归与闭式解相结合);

实现了 局部最优解的低复杂度算法。

③ 仿真验证性能优势

仿真结果表明:

提出的 NOMA+AIGC 方案显著优于:

传统 FDMA/TDMA+AIGC;

无 AIGC 的 NOMA/FDMA;

在以下条件下优势更明显:

基站最大功率更高;

设备能量预算更低;

设备数量更多;

总体上显著提升了全局学习精度与系统效率。

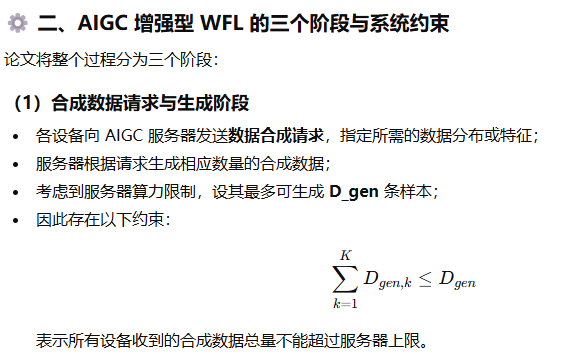

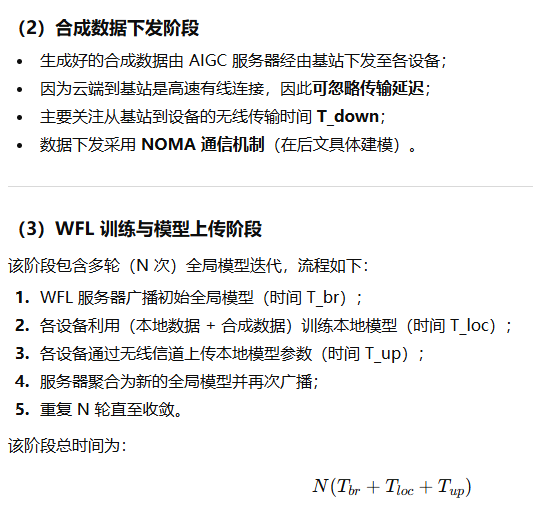

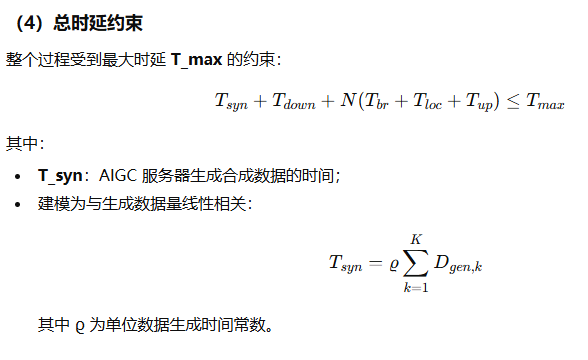

模型架构

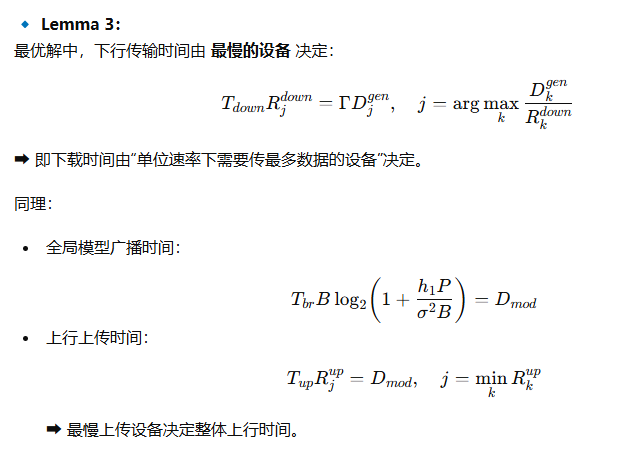

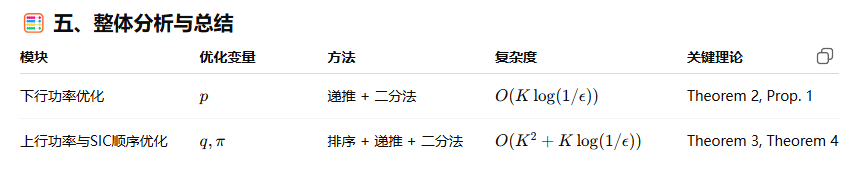

三、核心思想总结

这部分系统模型奠定了后续优化问题的基础,描述了:

系统结构: 云端 AIGC → 基站 → 多设备的三层体系;

三阶段流程: 数据生成 → 数据下发 → 本地训练与上传;

资源约束: 合成数据生成上限与总时延限制;

变量定义: 各阶段时间、数据量、模型大小、迭代次数等。

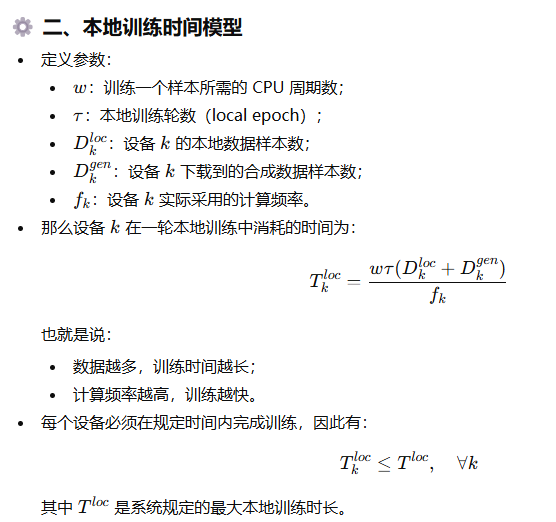

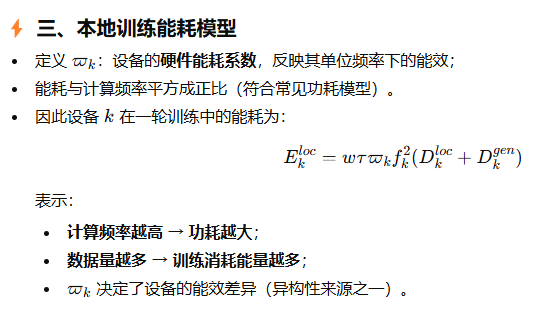

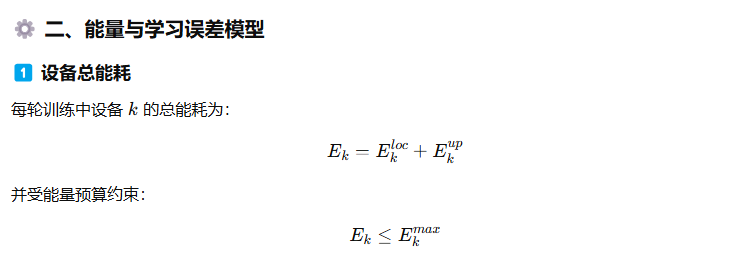

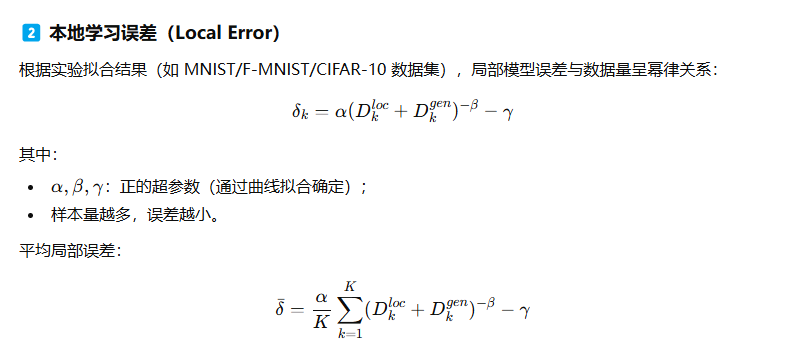

计算模型

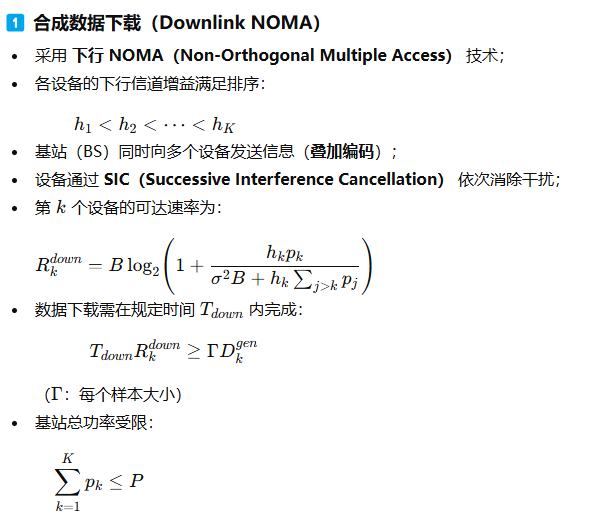

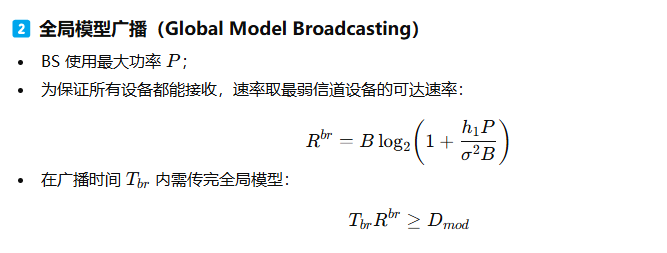

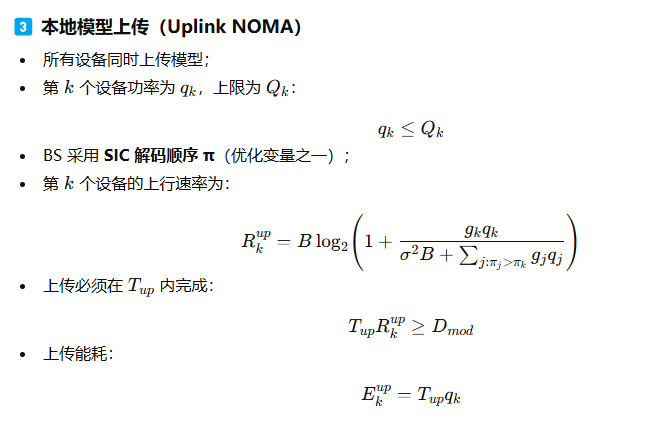

NOMA增强型通信模型

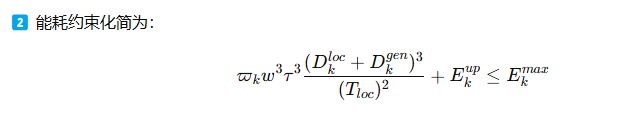

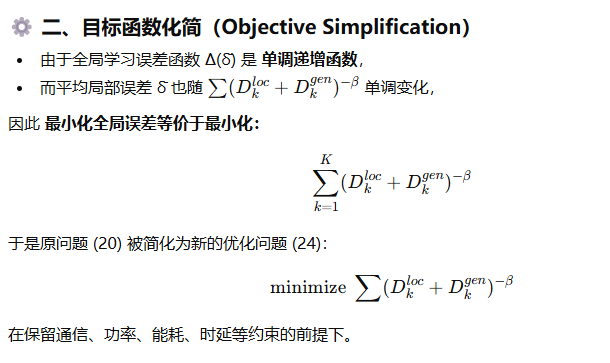

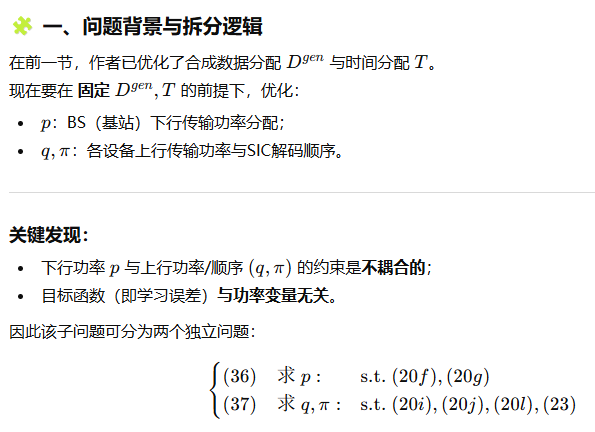

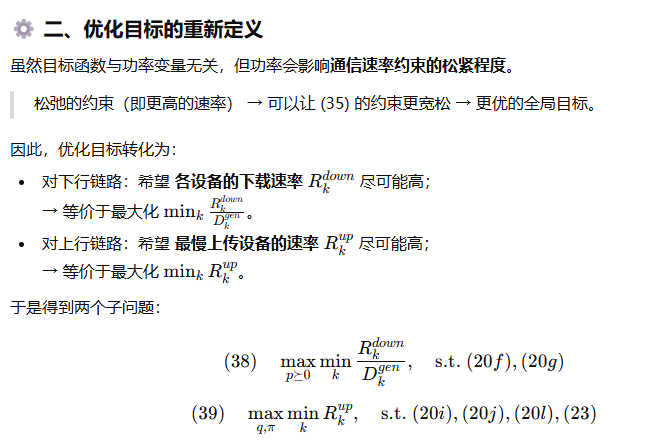

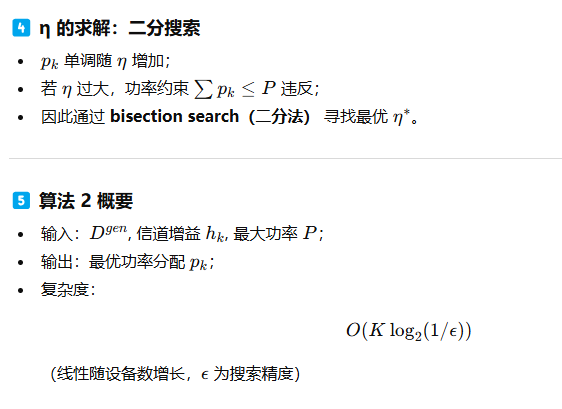

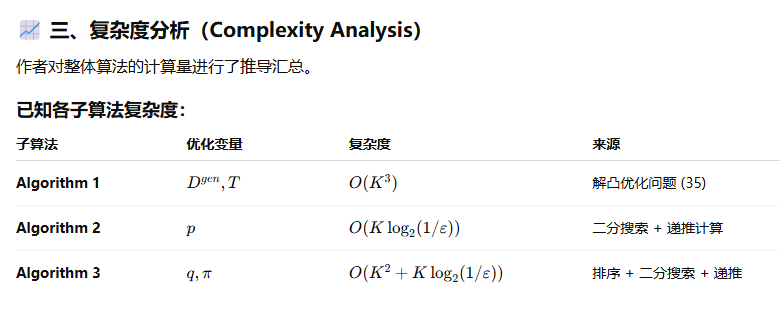

解决方案框架

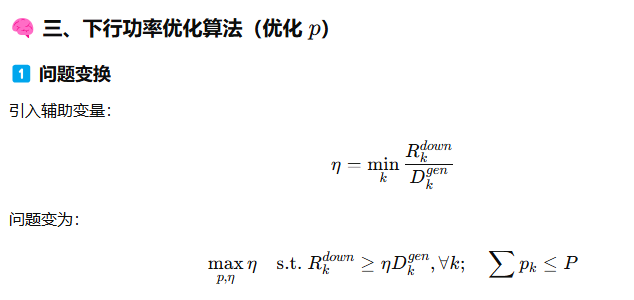

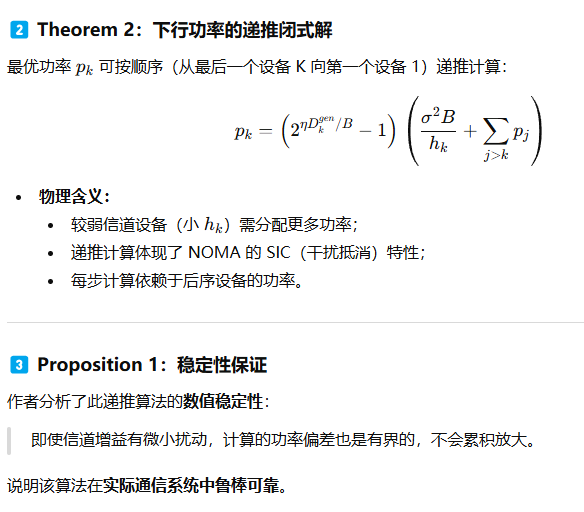

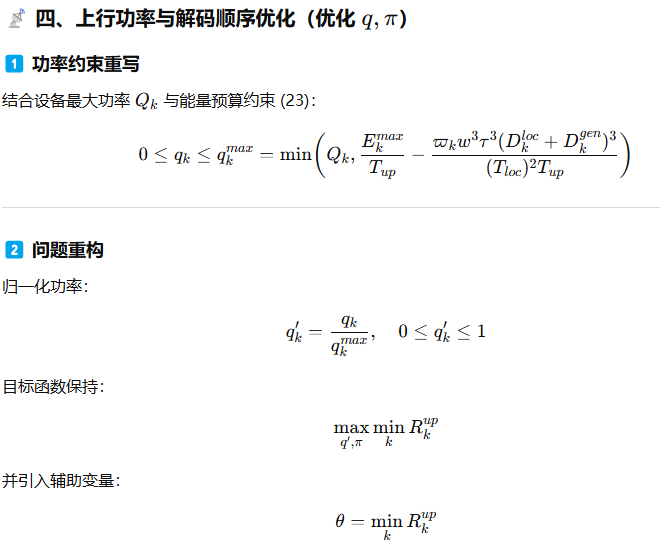

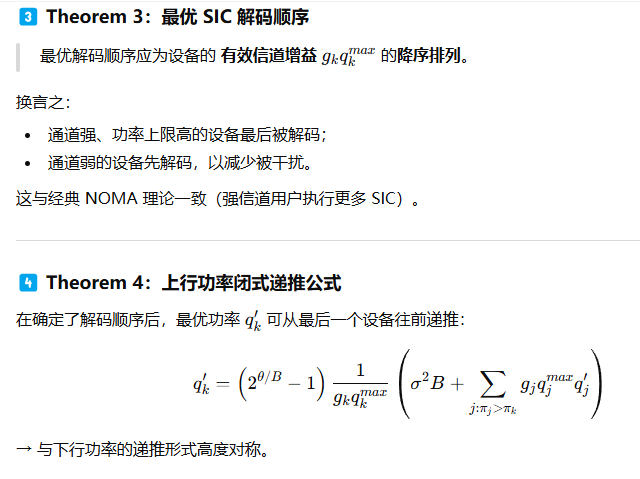

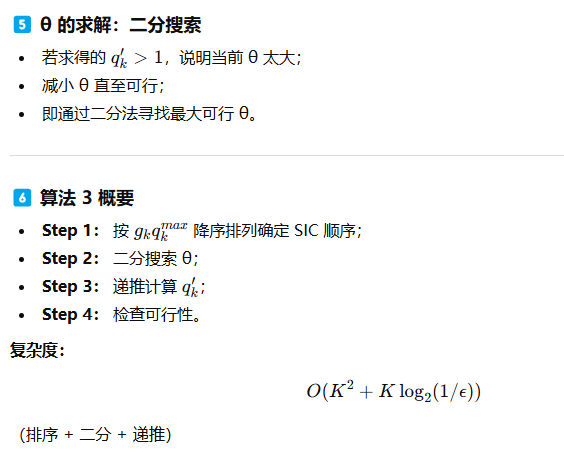

功率与SIC解码顺序优化

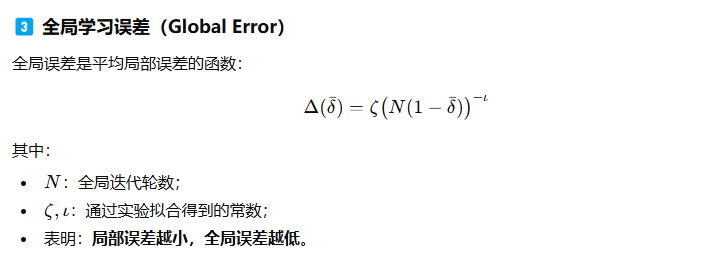

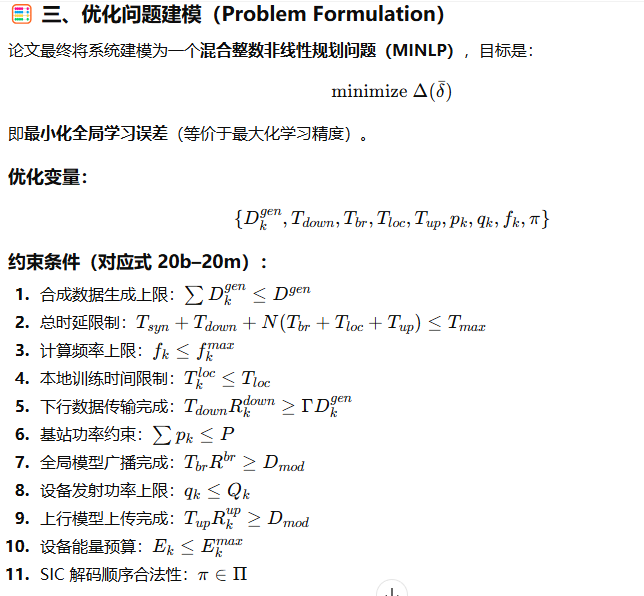

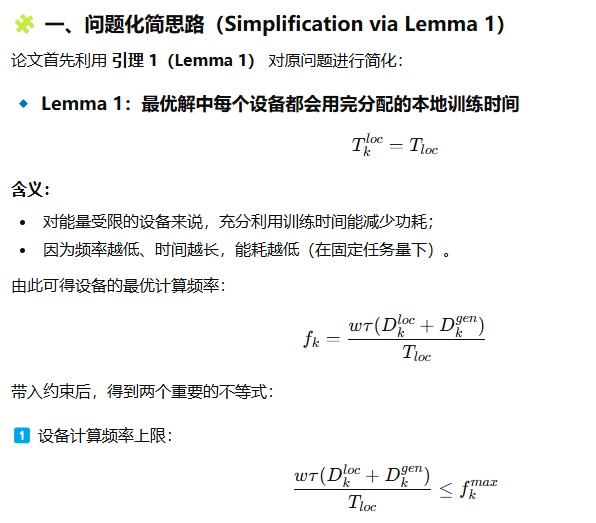

最终优化框架

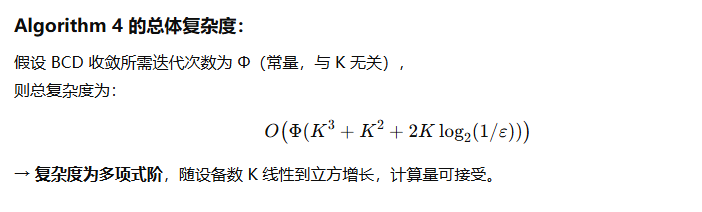

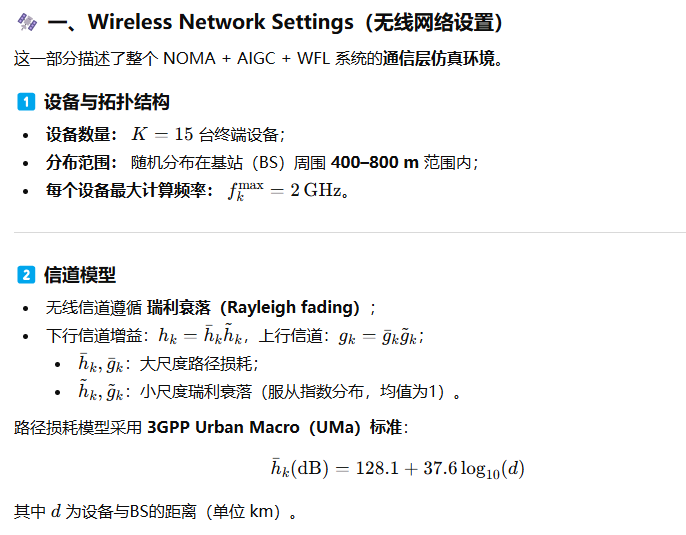

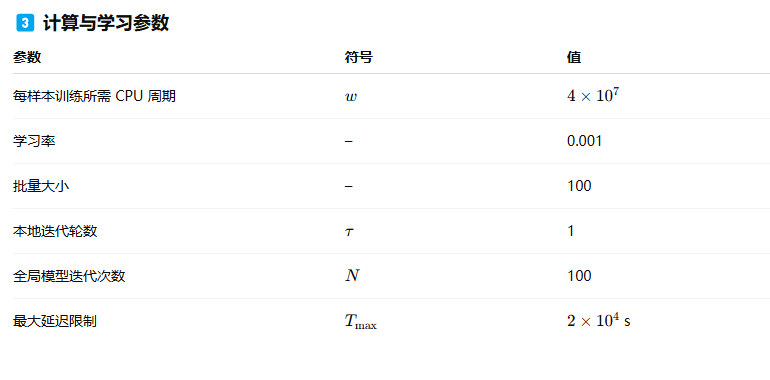

仿真实验设置

其他学习策略对比

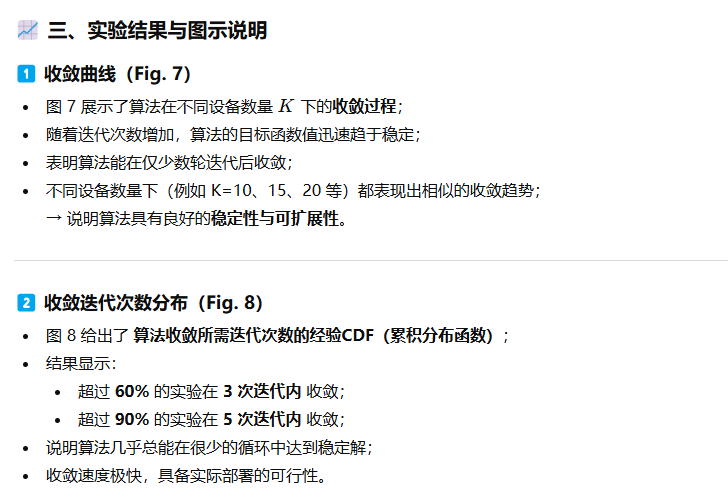

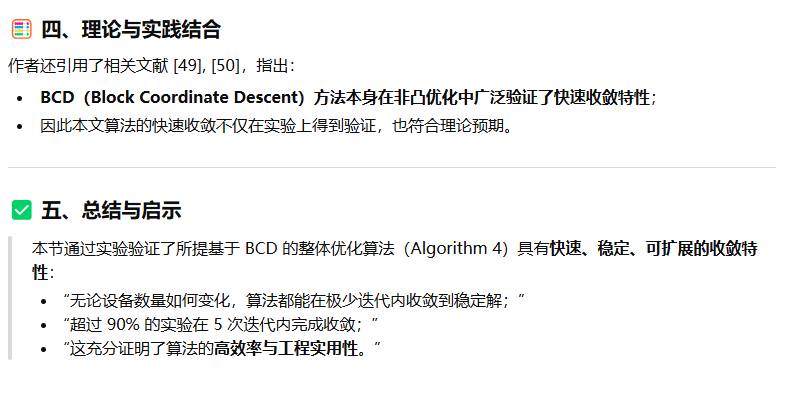

算法收敛性分析

不同参数对性能影响