【项目与八股】复习整理笔记

【项目与八股】复习整理笔记

- 智能安防监控系统

- 工厂模式与观察者模式

- RKMPI库的视频处理RTSP、LCD、OSD、PTZ、Onvif

- V4L2

- LCD

- 线程安全队列

- 环形缓冲区

- CAS原子操作

- SPSC队列

- MPMC无锁队列

- OSD叠加

- 云台追踪

- onvif协议总结

- RTSP协议总结

- RTP包结构

- 视频封装(以H.264为例)

- 视频编码器 Video Encoder

- 视频卡顿花屏 GOP

- QT客户端

- MVVM

- 线程池的设计

- 线程池整体工作流程

- 设计细节与常考问题

- 概念问题

- 同步与互斥

- FFmpeg

- 智能家居项目

- C语言的面向对象编程

- 单例模式

- hash_map

- 自定义堆区动态内存配置机制

- epoll并发服务器

- 环形缓冲区与粘包问题

- xv6操作系统内核

- 系统调用

- 页表

- 惰性分配与缺页

- 大文件与软链接

- 线程切换实现用户态协程

- C语言

- 指针 数组 函数 常量

- 大端序、小端序

- 内存对齐

- C语言关键字 staic const extern volatile预处理

- sizeof 与 strlen

- malloc与calloc的区别

- 数组与链表的区别

- 栈与队列的区别

- 使用指针需要注意什么?

- 野指针、段错误

- 内存泄漏

- 内存管理

- 内存分布模型

- C语言堆栈分区理解与区别

- 内存碎片

- 分段、分页、段页式、请求式分页

- 内存池

- 虚拟内存与页表

- 虚拟内存的好处

- 页表的作用是什么?

- 地址映射

- 缺页异常与置换

- 缺页中断

- 中断和异常的区别

- 页面置换算法

- LRU算法

- 文件访问方式

- C++

- new/delete/delete[]与malloc/free的区别,allocator

- 指针与引用的区别

- const关键字的使用

- static关键字的用处

- 面对对象的三大特性

- 菱形继承

- 多态

- vector动态数组

- 迭代器失效问题

- 深拷贝与浅拷贝

- inline

- 类的大小

- C++内存泄漏有哪些

- STL

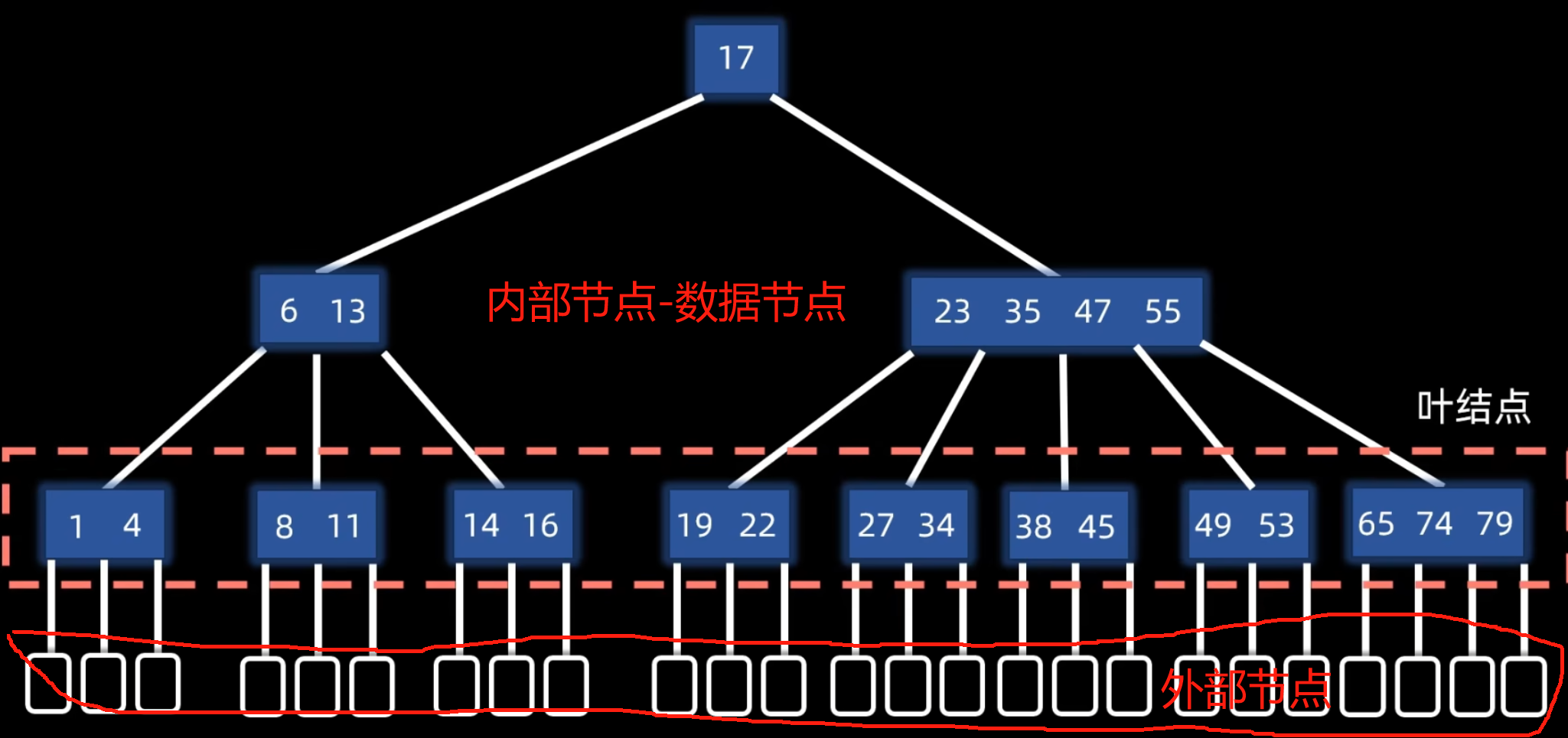

- 红黑树/B树与B+树

- C++11新特性

- 左值与右值及右值引用

- C++类型转换

- 函数模板与模板函数

- function/lambda/bind

- 类型推导

- 智能指针

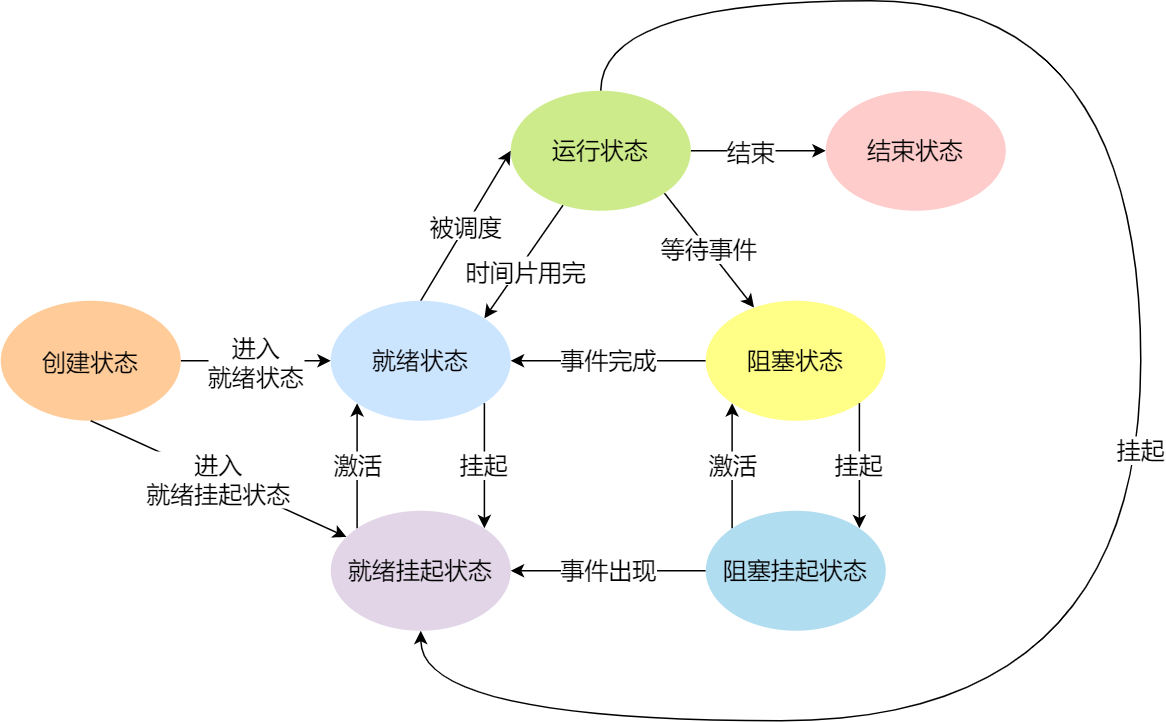

- 进程

- 进程与线程的区别

- 进程的控制

- 进程和线程的创建与结束

- 进程的创建

- 进程的结束

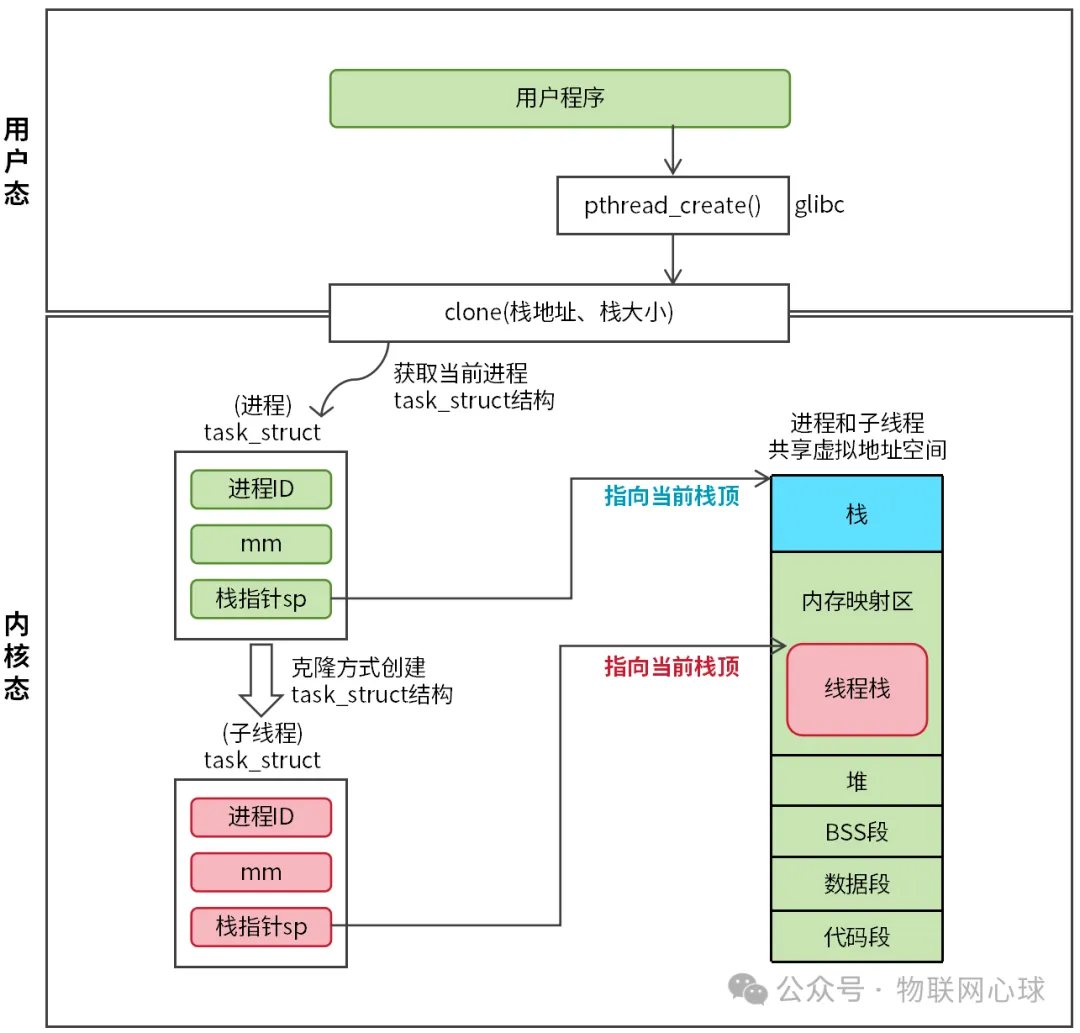

- 线程的创建

- 线程的结束

- 线程栈

- 默认栈

- 进行线程切换的区别

- 僵死守护孤儿

- fork的作用

- fork与vfork的区别

- 父进程创建子进程,有哪些资源共享

- 进程间通信

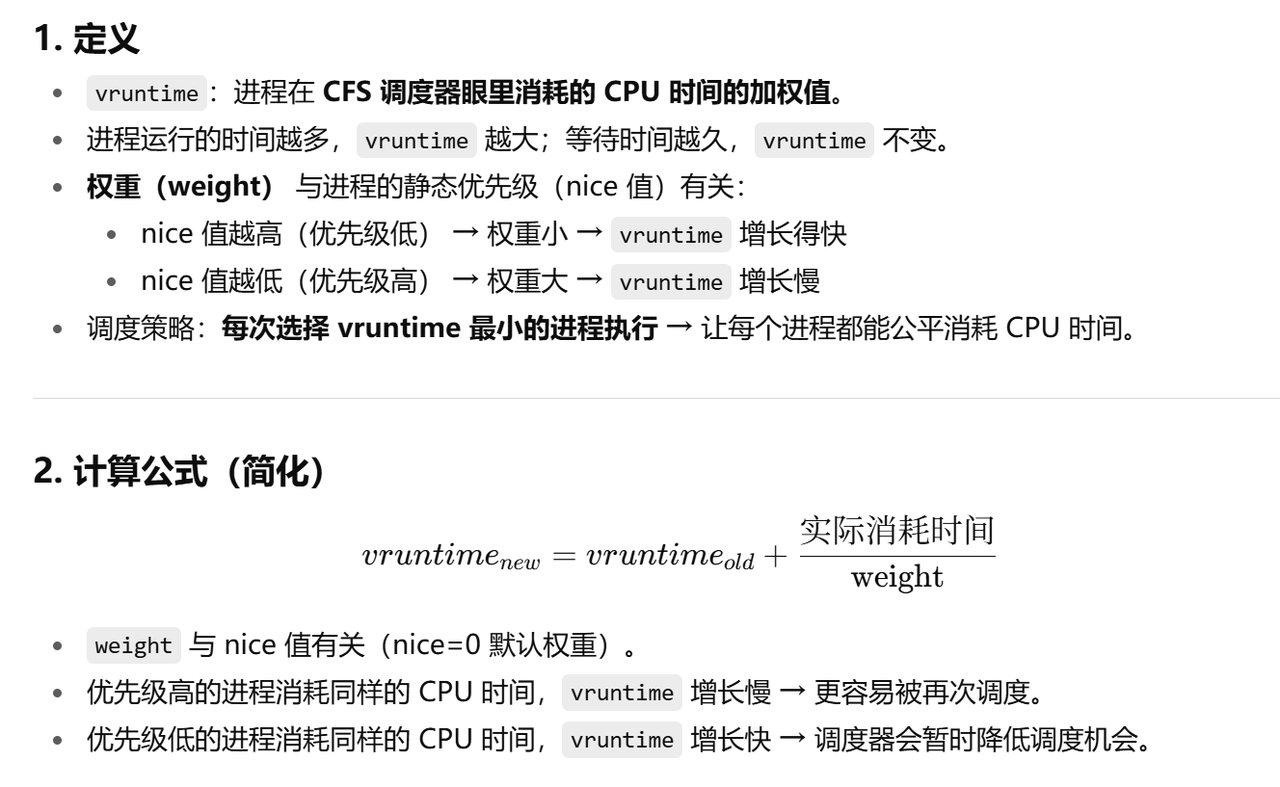

- 进程的调度机制

- Linux内核中的调度

- 线程

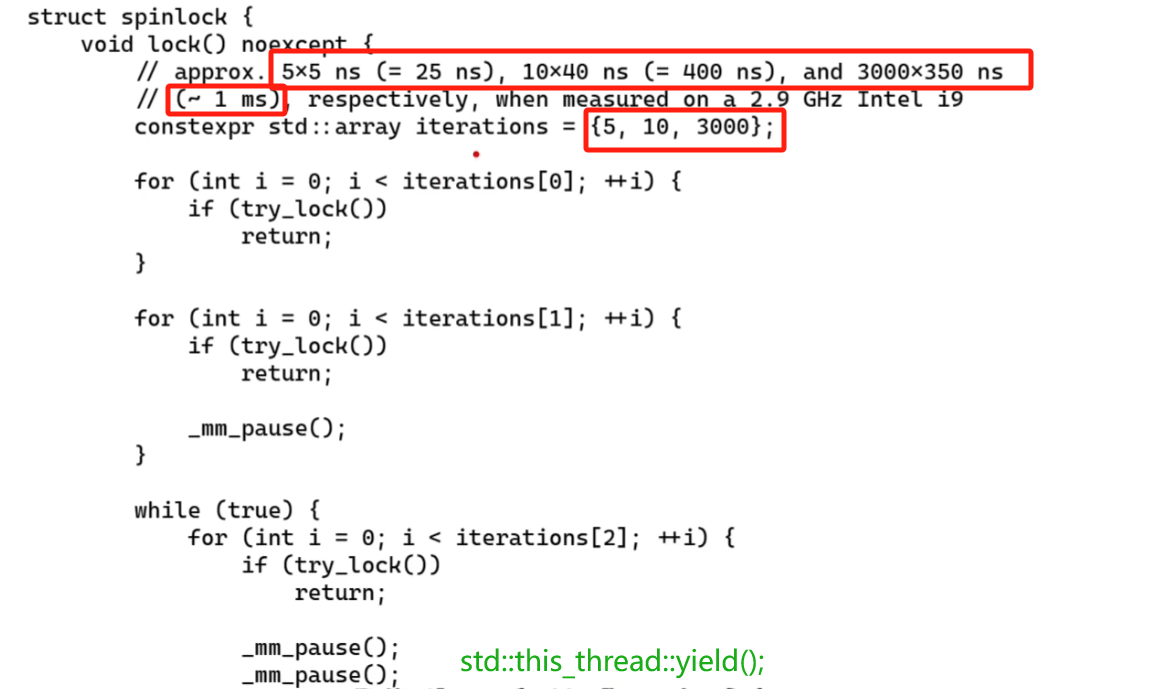

- 互斥锁、信号量、自旋锁

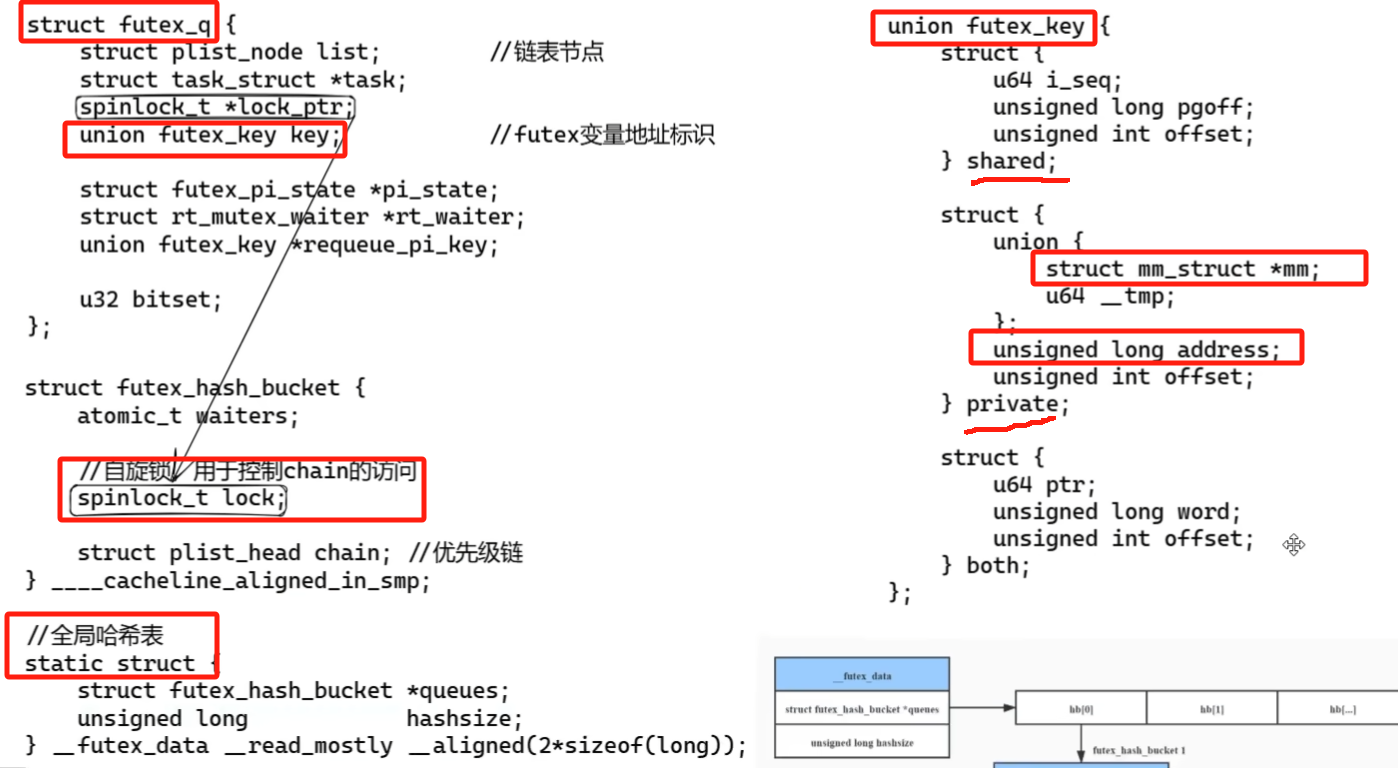

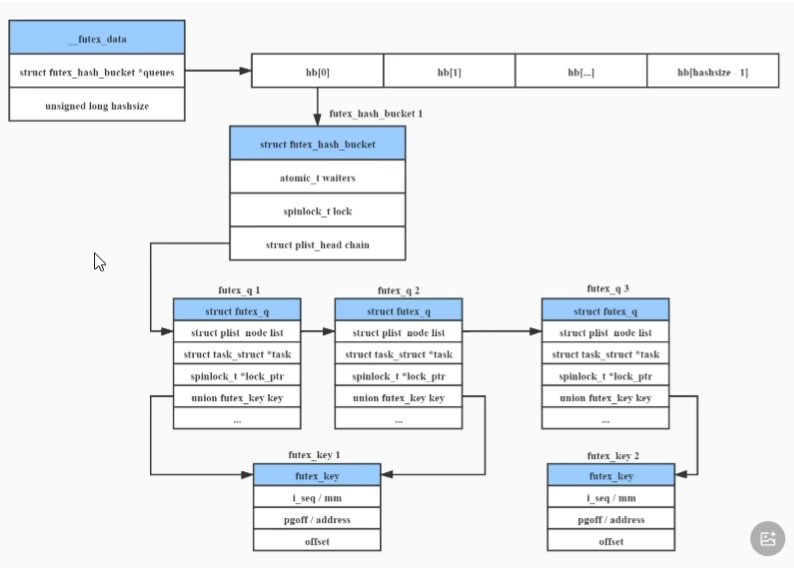

- Futex机制

- 读写、条件变量

- 死锁

- 用户线程和内核线程

- 操作系统

- 用户态和内核态

- 上下文

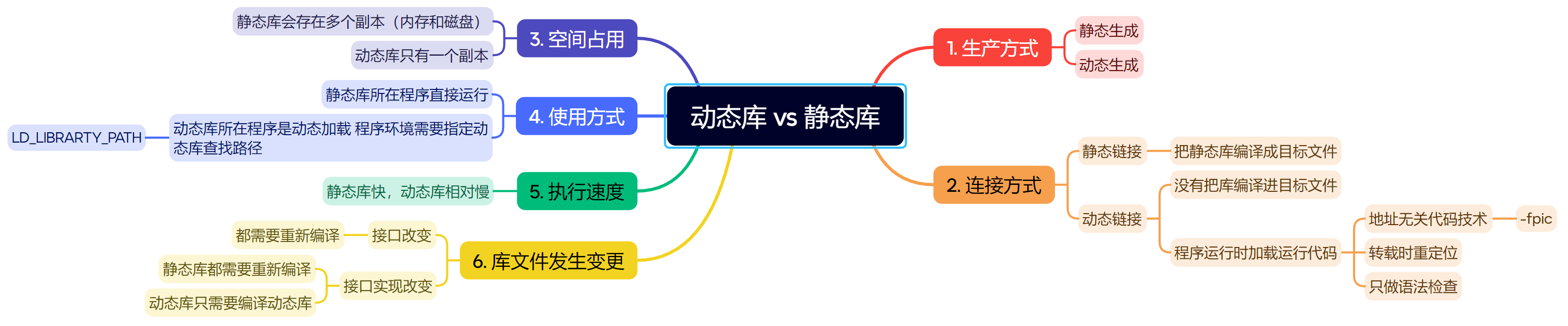

- 动态库与静态库的区别

- 软链接与硬链接

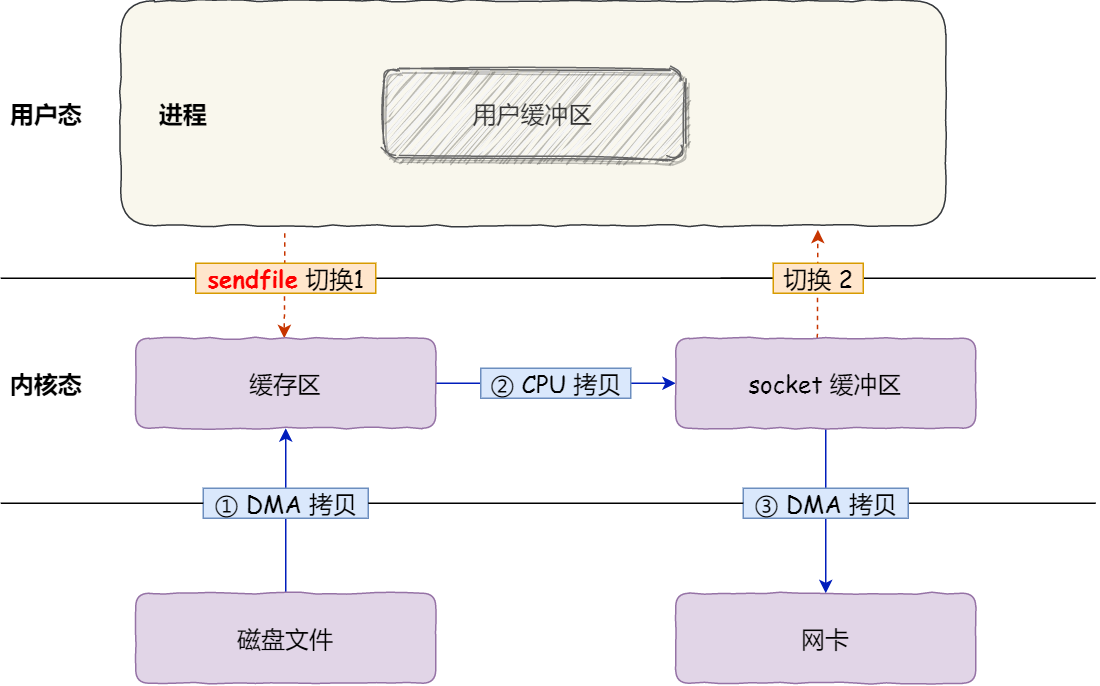

- DMA技术

- 计算机网络

- TCP与UDP的区别

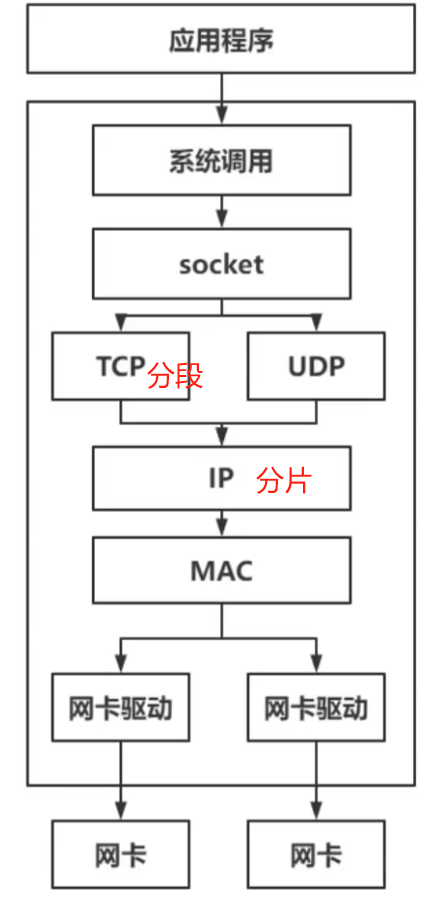

- 接收数据包流程

- 宕机是否丢失

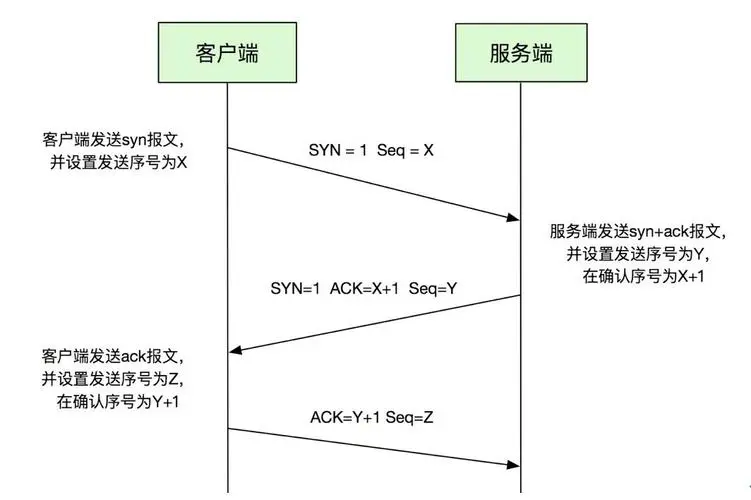

- 三次握手 四次挥手相关

- 判断断开

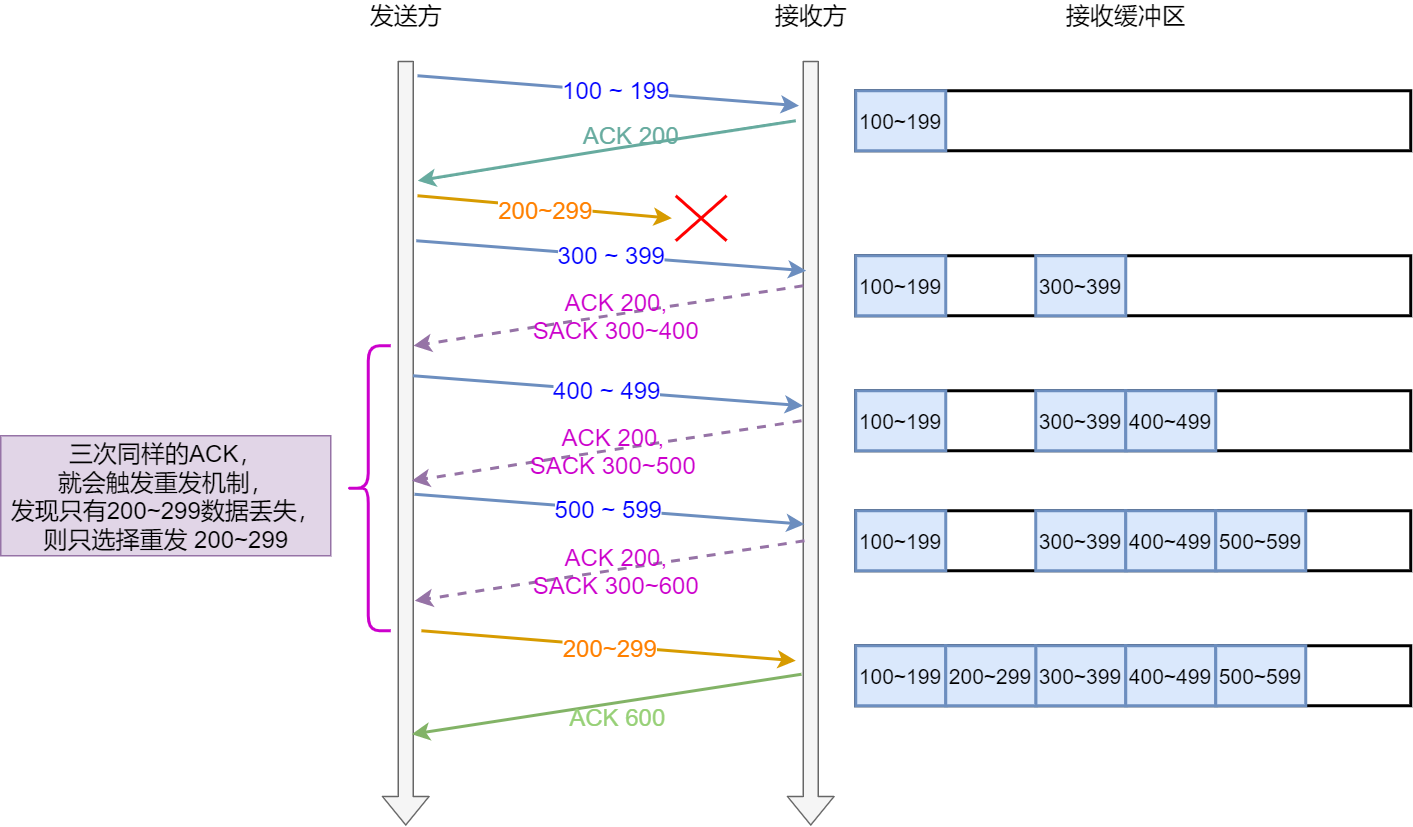

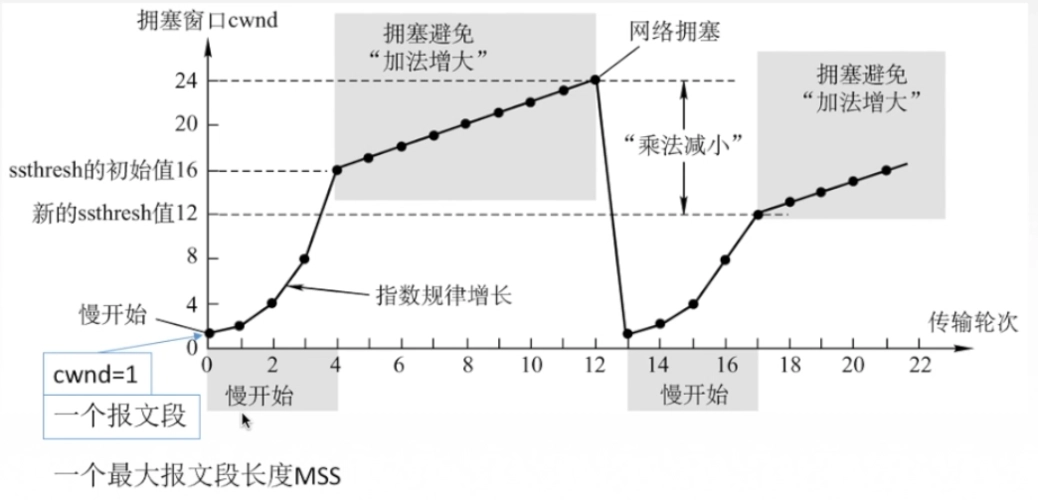

- TCP可靠机制

- TCP粘包/半包现象

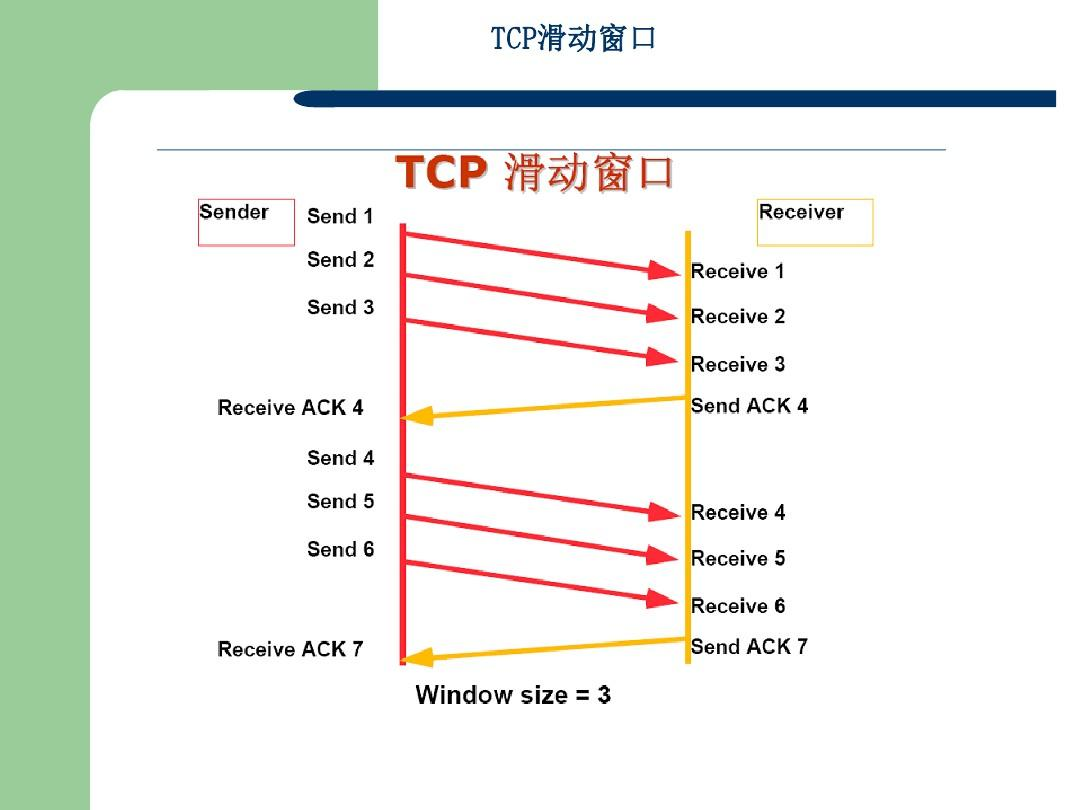

- TCP的ACK机制,有什么好处?

- TIME_WAIT

- 长短连接、全连接、半连接

- socket编程

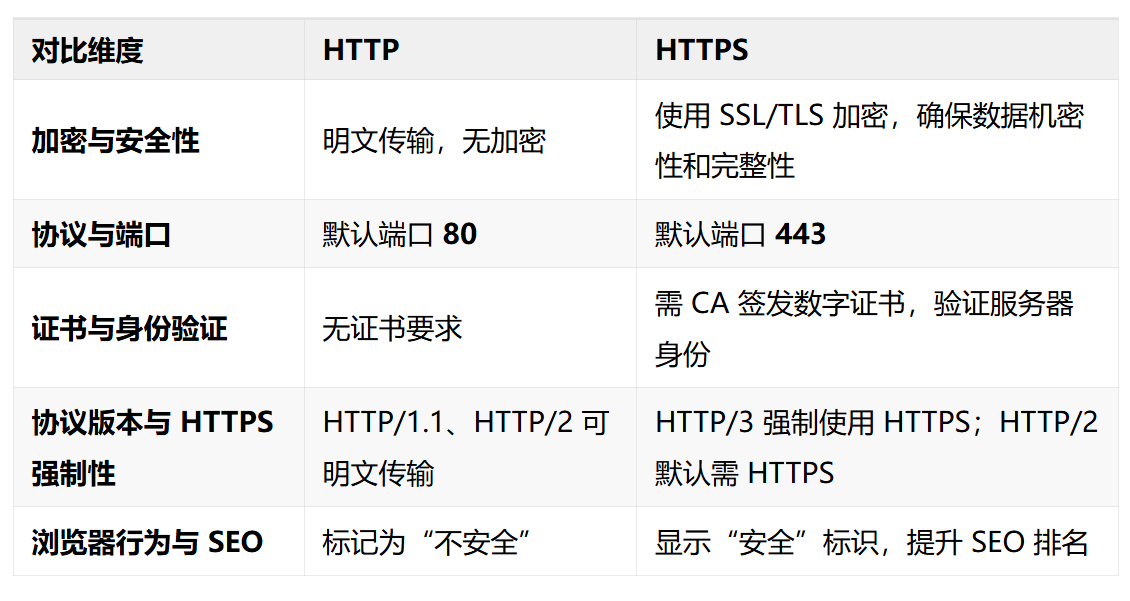

- HTTP与HTTPS

- 常用的指令

- Linux常用指令

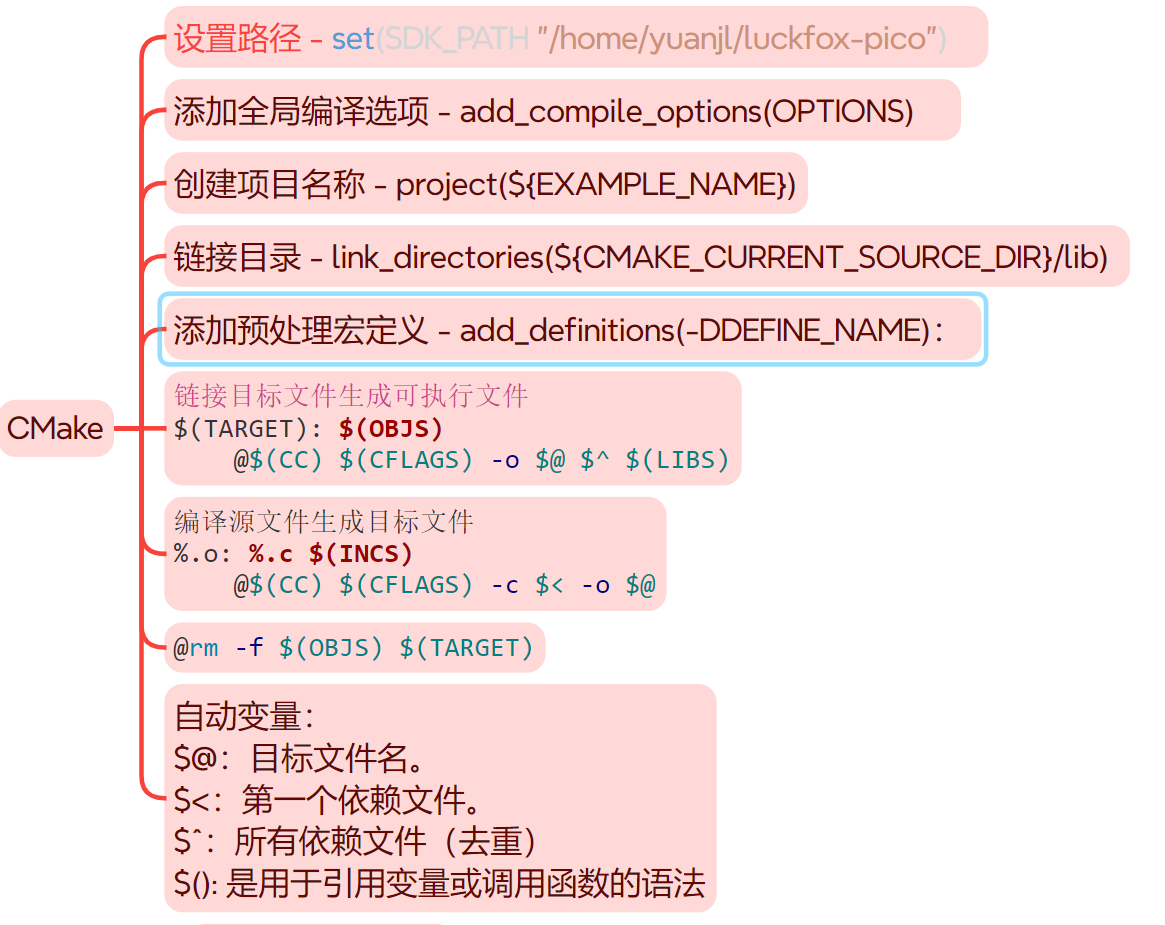

- git、cmake、makefile

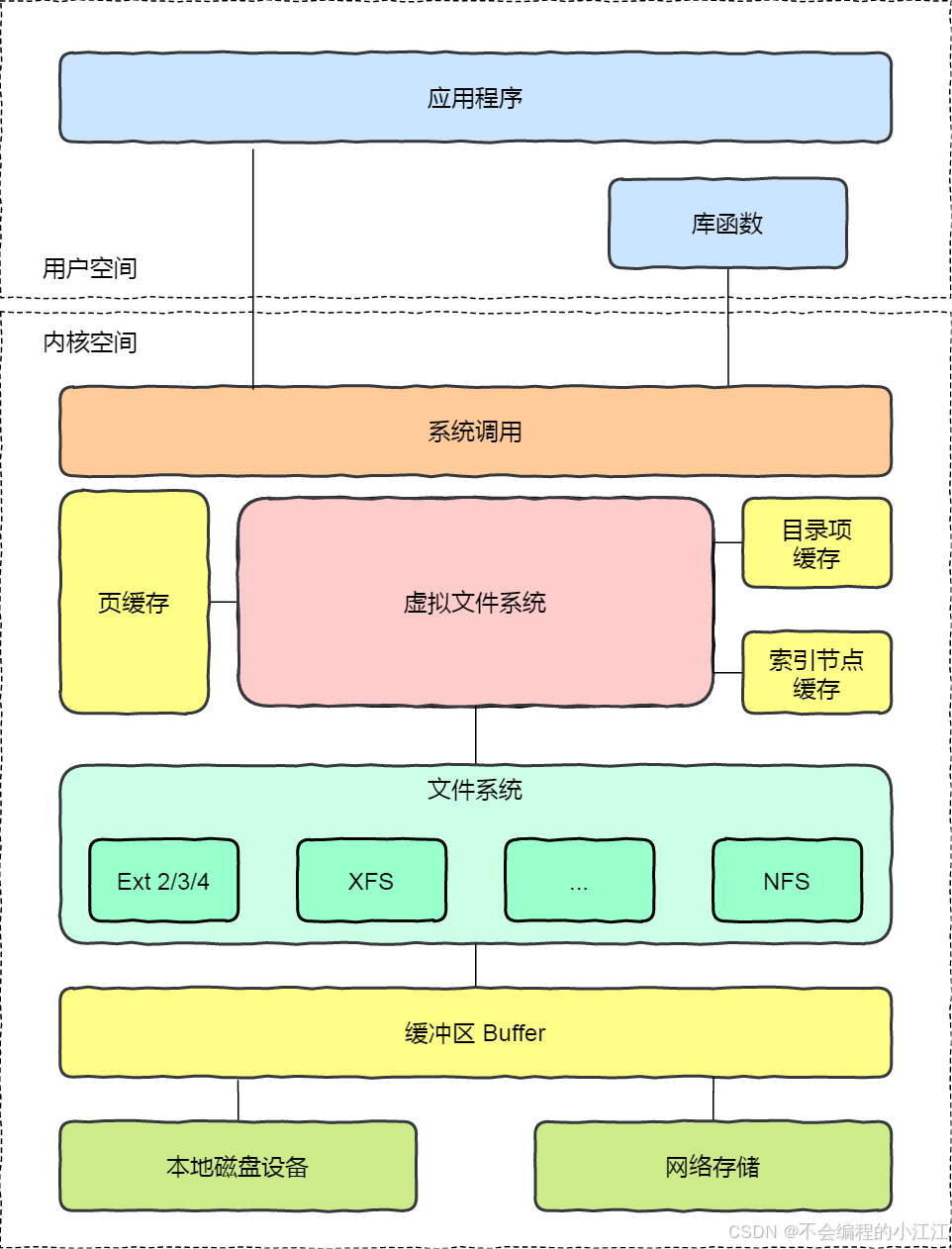

- 文件系统

- 文件系统的组成

- 文件系统的结构

- 虚拟文件系统

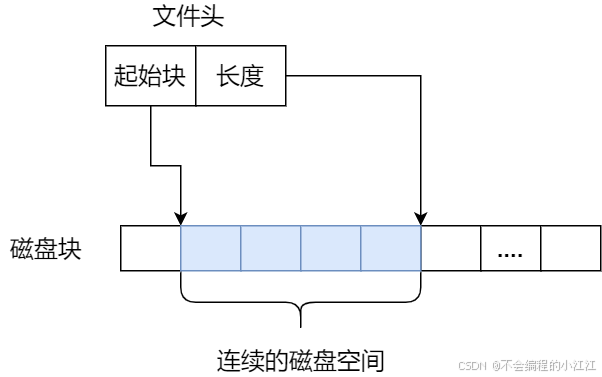

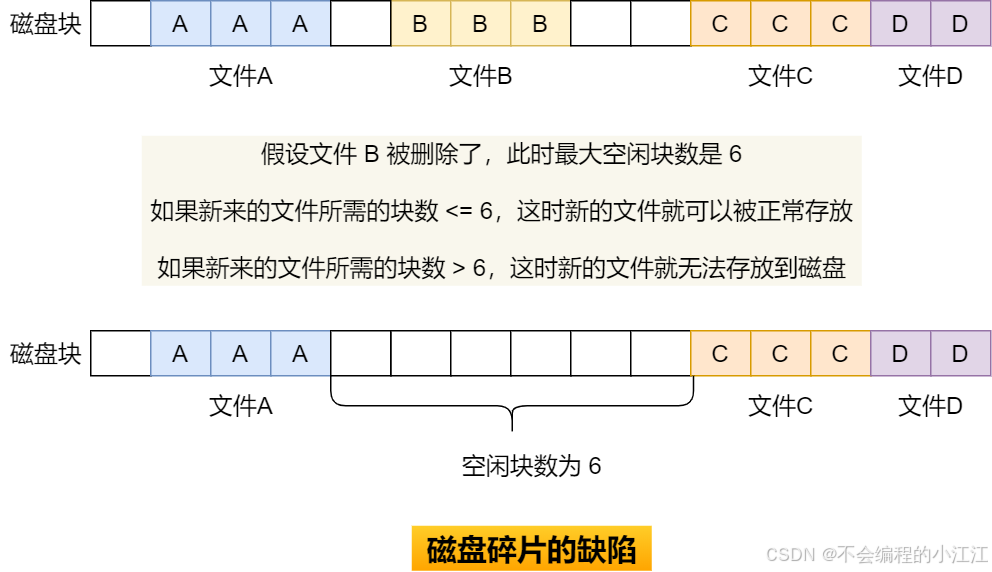

- 连续空间存储

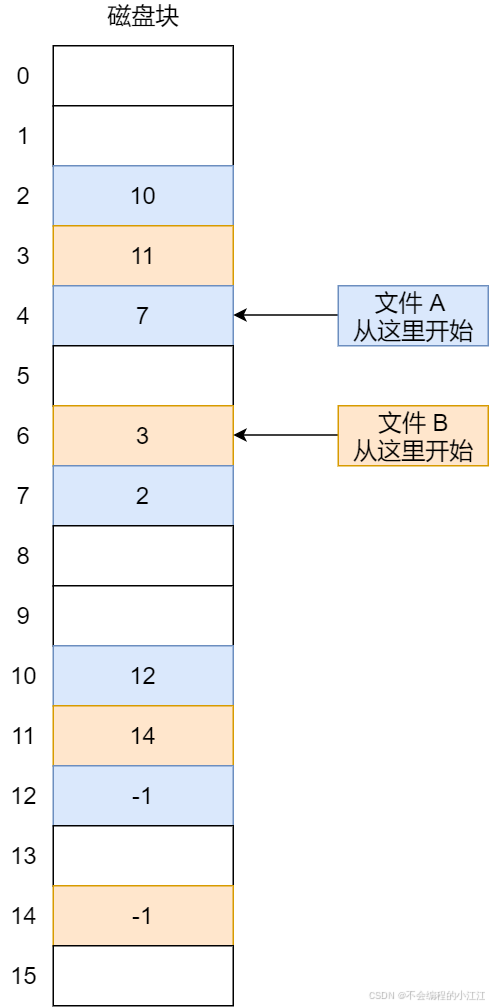

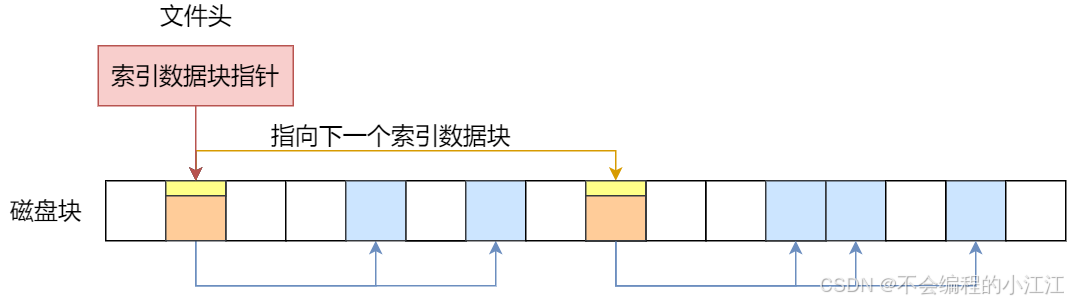

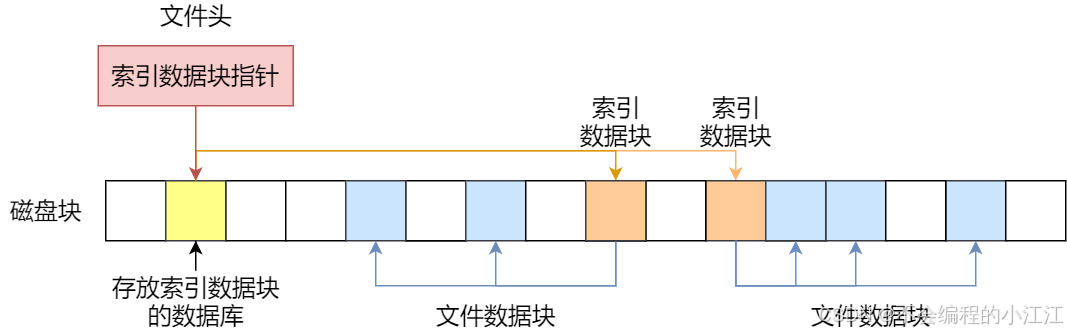

- 非连续空间存储

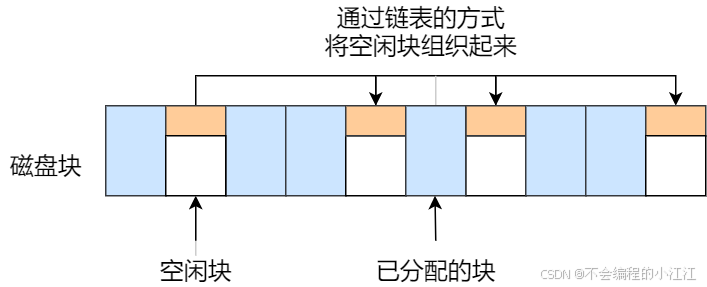

- 空闲空间管理

- 空闲表法

- 空闲链表法

- 位图法

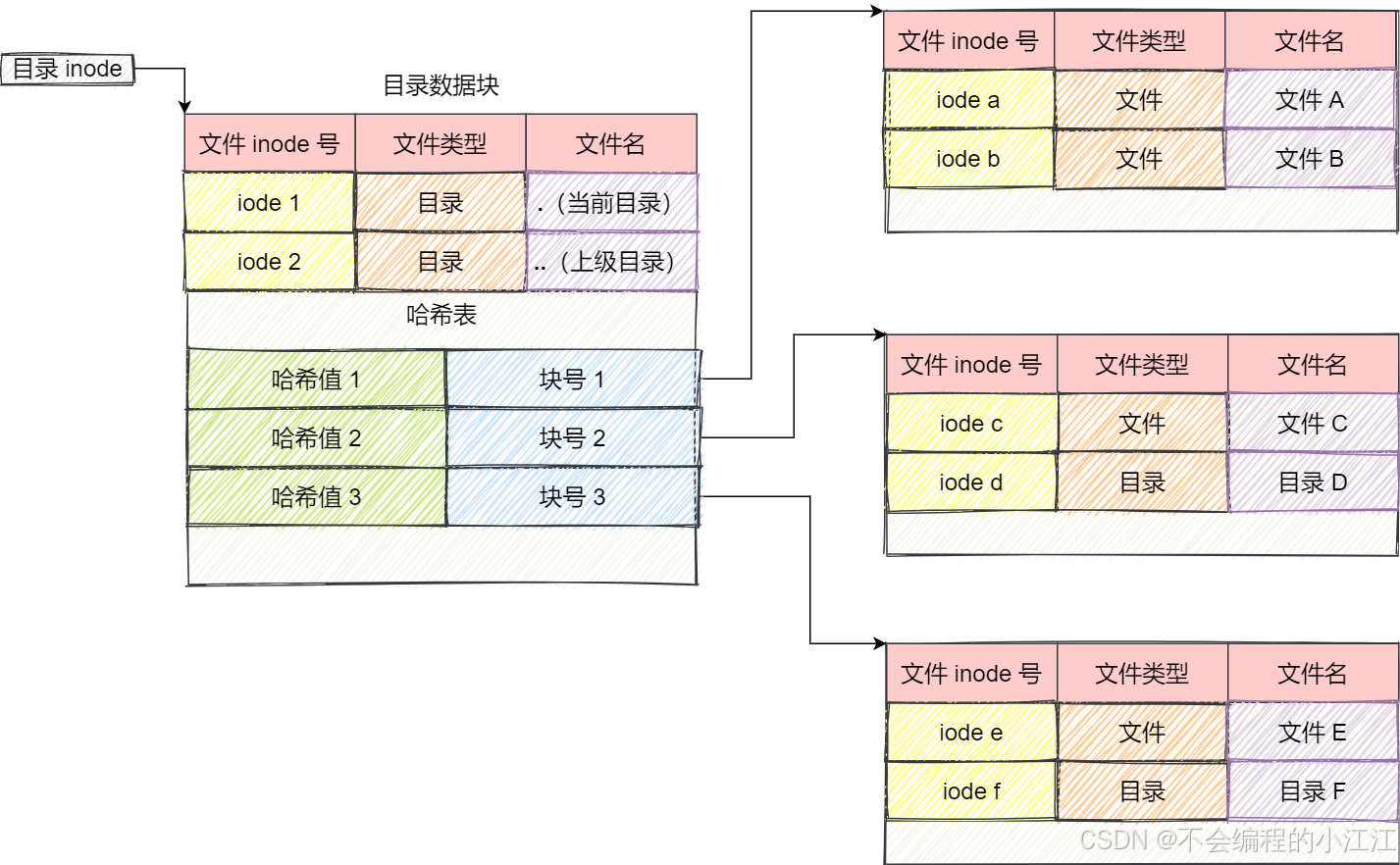

- 目录的存储

- 软链接和硬链接

- Linux内核与驱动

- Linux操作系统在开发板的启动流程

- Linux内核结构框图

- Bootloader的两个阶段的启动过程。

- linux的内核是由bootloader装载到内存中的?

- 为什么需要BootLoader

- bootloader内核和根文件的关系

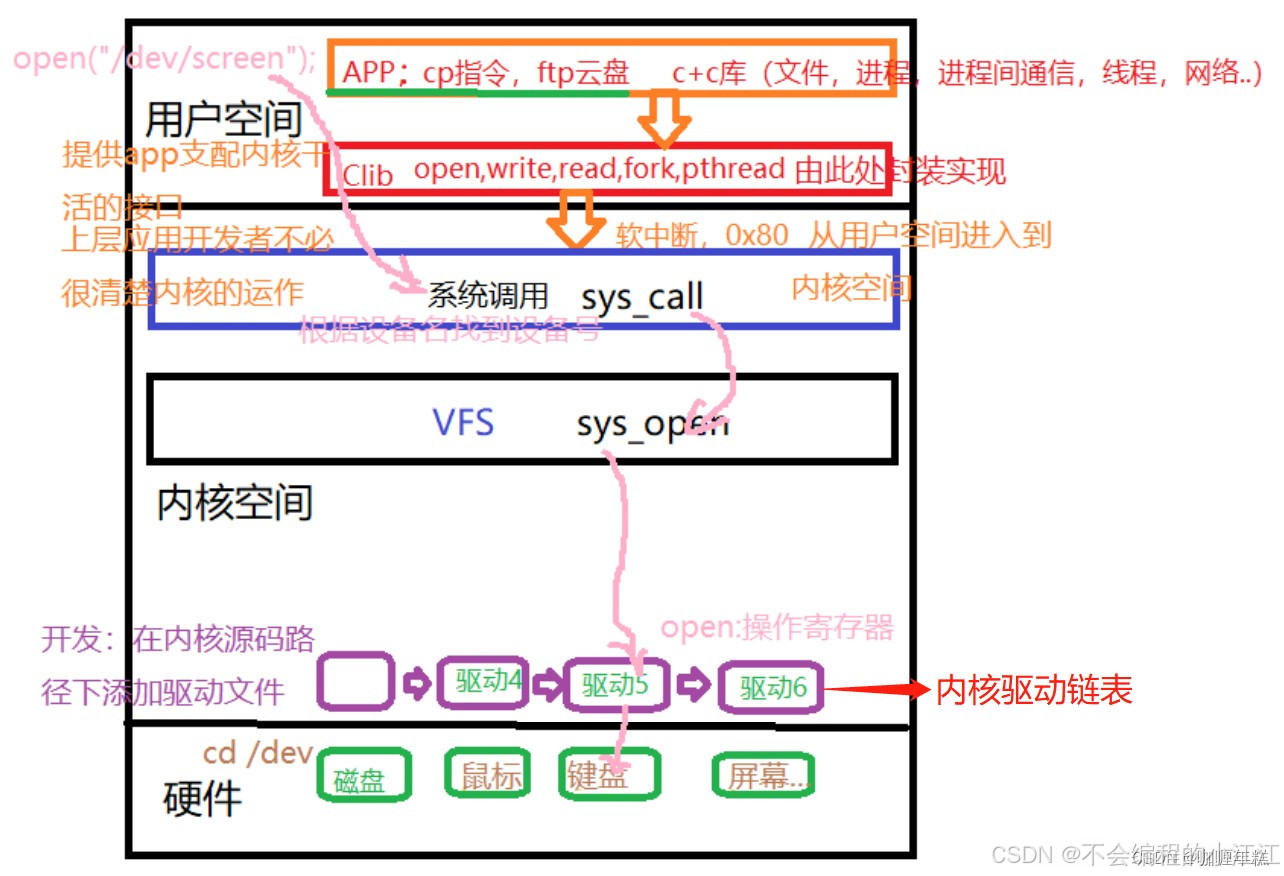

- 系统调用read()/write(),内核具体做了哪些事情?

- 内核态,用户态的区别

- 树莓派Linux源码配置

- 移植内核至树莓派

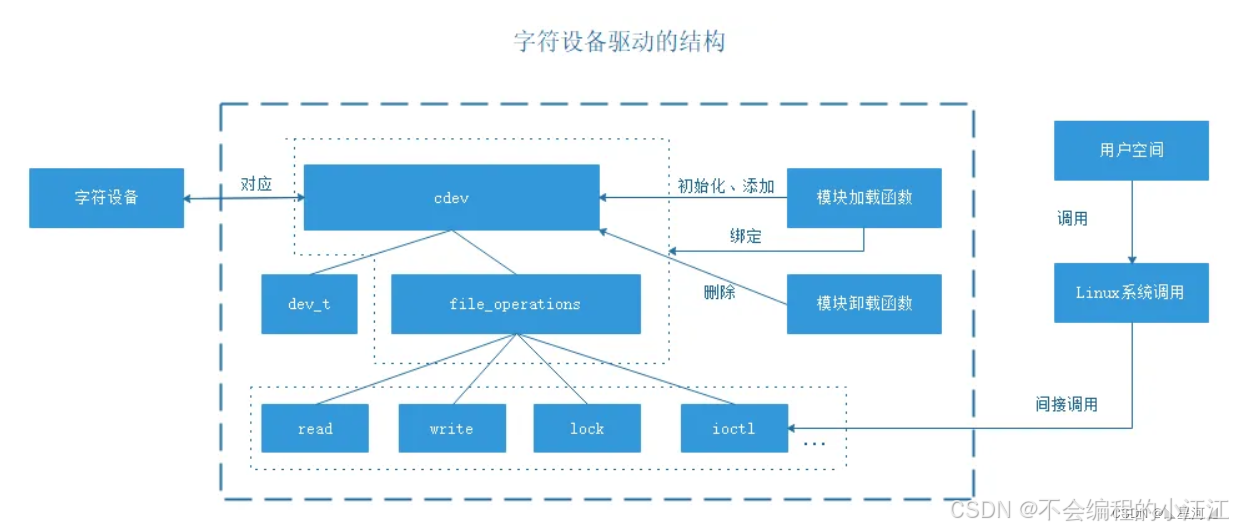

- 字符设备驱动

- 单片机

- IIC SPI UART的区别

- 键盘敲入字母A时,发生了什么

- 一帧数据的传递

- 输入URL到页面展示发生了什么

- 有了IP地址如何找到对端

- 动态路由协议有哪些

- 外部网关协议 - BGP

- 内部网关协议OSPF,ISIS,RIP

- BGP

- 基础概念

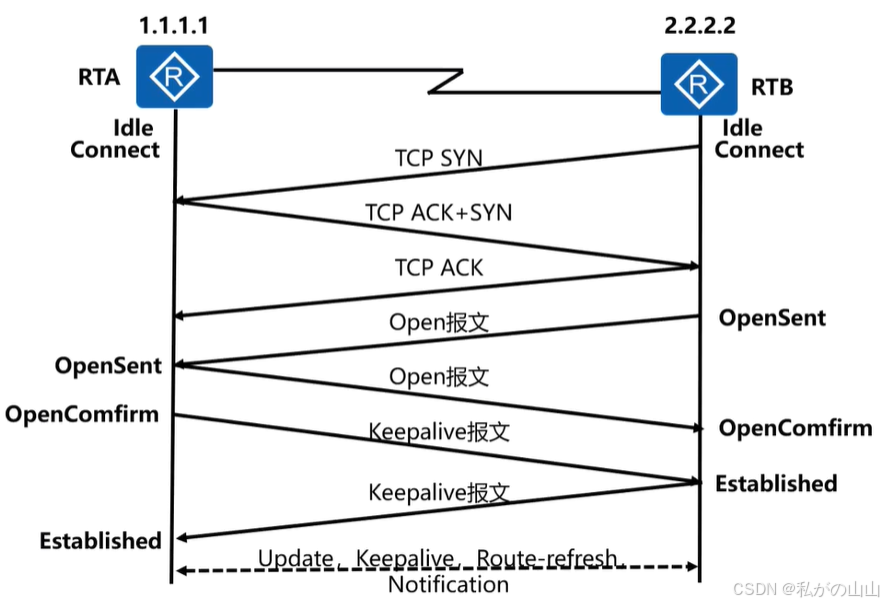

- BGP建邻

- 路由属性与策略

智能安防监控系统

-

难点1: 项目的框架搭建,各模块的解耦合,各模块间的数据传输,使得具备高扩展性,添加模块功能方便,同时模块机的数据传输耦合度降低

-

QT界面: 代码设计与业务逻辑的分离,降低耦合度,信号传输深度过深

-

难点2: 摄像头的视频采集、编码、传输功能的实现以及视频出现的花屏卡顿,LCD显示屏的驱动与显示,

-

QT界面的视频编解码: 通过ffmpeg库对视频进行编解码,对视频的接收,环形缓冲区,16路视频解码,窗口的不断创建与释放,对象池

-

难点3: Onvif协议的应用与接口的封装

-

移植到RK3588,交叉编译QT库,ffmpeg库,以及后面利用硬件GPU加速进行对图像进行解码操作

-

摄像头视频采集与传输,利用RKMPI库,API文档,官方app例程,移植一些功能函数模块与流程

-

添加功能模块,舵机PT控制,LCD显示,onvif协议,降低系统的耦合度的集成与扩展,无参考,网络框架学习与参考源码

-

RV1106 是一款专门用于人工智能相关应用的高度集成 IPC 视觉处理器 SoC。它基于单核 ARM Cortex-A7 32 位内核,集成了 NEON 和 FPU,并内置 NPU 支持 INT4 / INT8 / INT16 混合运算,RV1106G2 计算能力高达 0.5TOPS,RV1106G3计算能力高达 1TOPS

工厂模式与观察者模式

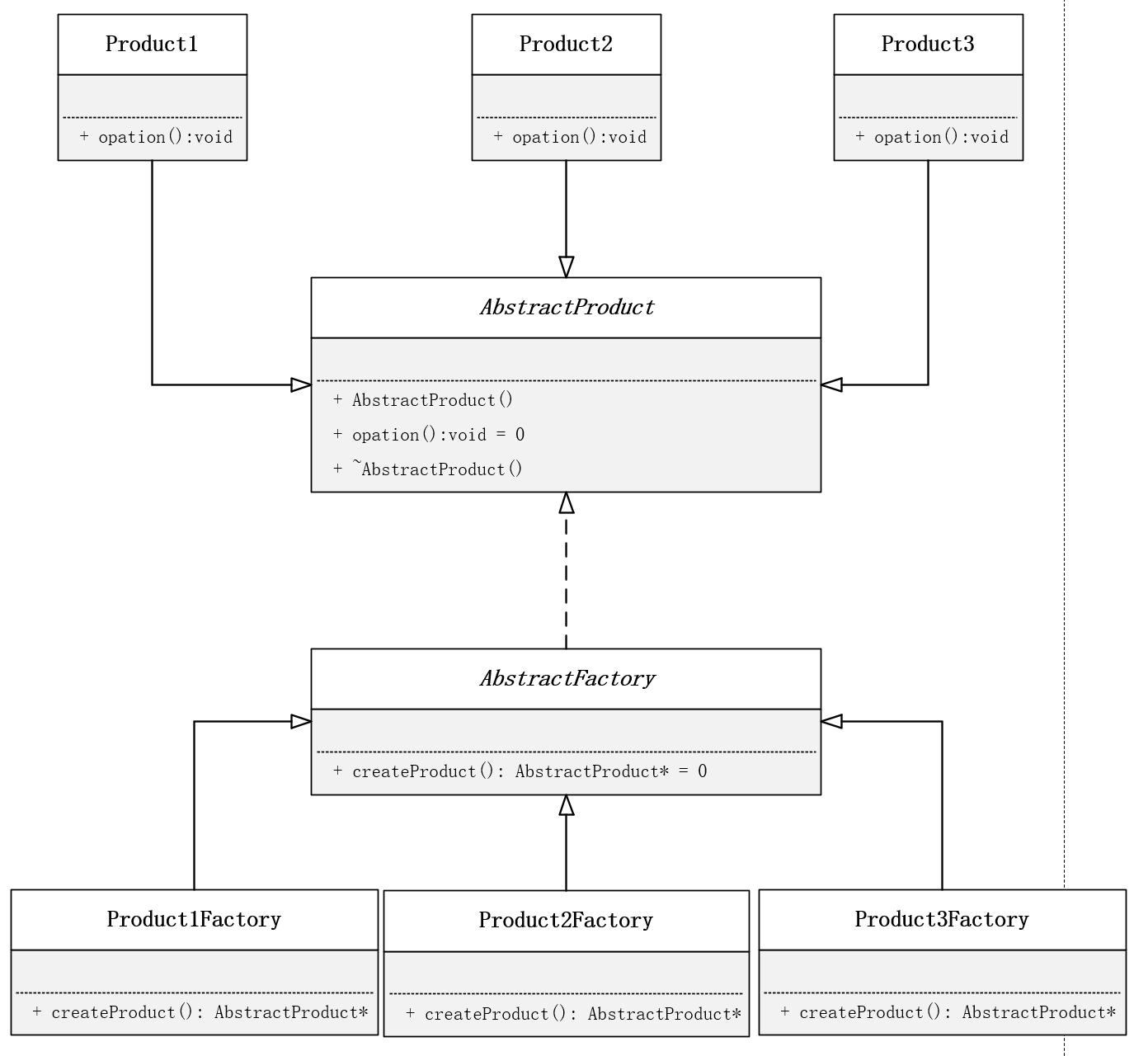

工厂模式: 设计基类工厂,各个模块的具体工厂创建对应的每一个类,最后通过基类指针访问每个具体工厂创建的对象

简单工厂模式与工厂模式的区别:

简单工厂模式是只有一个工厂类,而工厂模式是有很多的工厂类:

- 工厂模式:

- 一个基类,包含一个虚工厂函数,用于实现多态。

- 多个子类,重写父类的工厂函数。每个子工厂类负责生产一种产品的实例对象,这相当于再次解耦,将工厂类的职责再次拆分

通过基类指针实现运行时多态,统一管理不同视频流处理方式

采用抽象工厂模式(VideoStreamFactory)来创建具体的视频流对象,提高系统的可扩展性,这种设计实现了:

- 接口统一化:通过基类规范所有视频流处理的操作

- 功能模块化:各子类专注实现特定功能

- 扩展灵活性:新增处理方式只需添加新子类

- 创建解耦:工厂模式隔离对象创建和使用

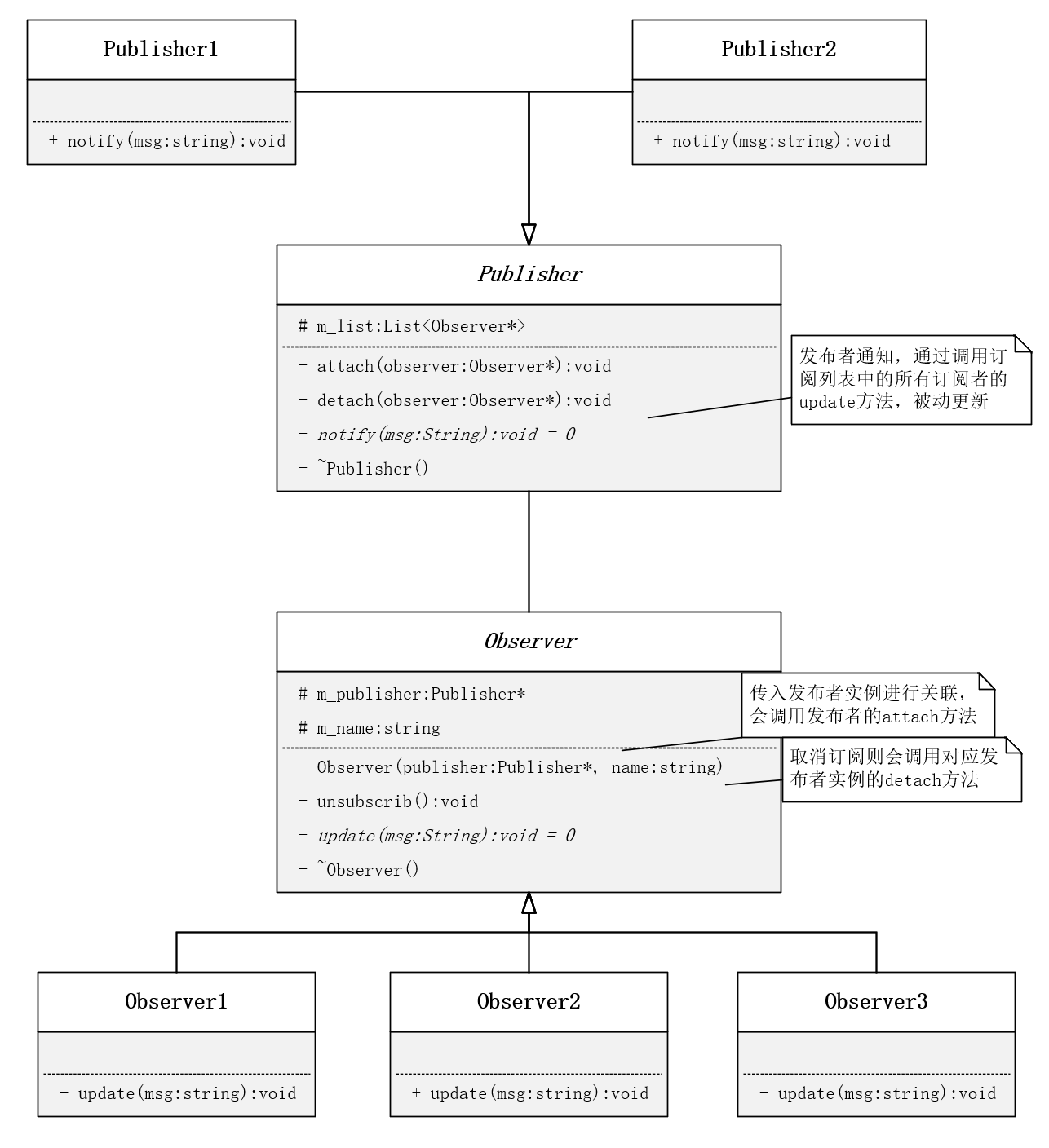

观察者模式:

class Publisher

{

public:Publisher();virtual ~Publisher() {} // 基类,虚析构,多态时能通过基类指针析构各个子类的析构函数// 1. 添加订阅者void attach(Observer* observer) {m_observers.push_back(observer);}// 2. 删除订阅者void detach(Observer* observer) {m_observers.remove(observer);}// 3. 通知订阅者 不同子类发送消息不一样,定义为存虚,要求必须重写notify函数virtual void notify(string msg) = 0; {for(const auto &observer : m_observers) {// 观察者更新数据 这句话是关键,理解是如何更新观察者的数据的,观察者的方法在下面定义,可先跳过// observer->update(msg);}}

protected:// 订阅者列表 添加删除效率高list<Observer*> m_observers;

};// 抽象观察者类

class Observer {

public:// 和发布者进行关联 - 通过构造函数实现 - 初始化列表Observer(Publisher* publisher, string name) : m_publisher(publisher), m_name(name) {m_publisher->attach(this); // 发布者添加该观察者}// 和发布者进行解除关联 - 取消订阅void unsubscribe() {m_publisher->detach(this); // 发布者取消该观察者}// 更新消息virtual void update(string msg) = 0; {cout << "Observer " << m_name << " received msg: " << msg << endl;}virtual ~Observer() {cout << "Observer " << m_name << " is destroyed" << endl;}protected:Publisher* m_publisher; // 订阅的的发布者string m_name; // 当前观察者的名字

};

优点:

- 降低了类与类之间的耦合度,把耦合关系在基类中处理

- 观察者模式实现了稳定的消息更新和传递的机制,通过引入抽象层可以扩展不同的具体观察者角色;

- 支持广播通信 ,所有已注册的观察者(添加到目标列表中的对象)都会得到消息更新的通知, 简化了一对多设计的难度;

- 符合开闭原则 ,增加新的观察者无需修改已有代码,在具体观察者与观察目标之间不存在关联关系的情况下增加新的观察目标也很方便。

缺点:

- 代码中观察者和发布者相互引用 ,存在循环依赖,观察目标会触发二者循环调用,有引起系统崩溃的风险

- 如果一个发布者有很多直接和间接观察者,将所有的观察者都通知到会耗费大量时间。

适用环境:

- 一个对象的改变会引起其他对象的联动改变,但并不知道是哪些对象会产生改变以及产生什么样的改变;

- 如果需要设计一个链式触发的系统,可是使用观察者模式;

- 广播通信、消息更新通知等场景。

虚函数与纯虚函数

使用纯虚函数

- 当你希望所有派生类都必须实现某个功能时

- 当你希望基类成为抽象类,不能直接实例化时

- 确保所有子类都实现特定接口,避免遗漏

使用虚函数的情况

- 当你希望提供一个默认实现,子类可以选择是否重写时,使用虚函数

- 当你希望子类可以选择是否重写某个函数时,使用虚函数

- 允许子类选择是否实现某个功能

RKMPI库的视频处理RTSP、LCD、OSD、PTZ、Onvif

面试简答版: 视频采集的原理是:摄像头传感器把光信号转成电信号,经 ISP 处理后通过接口传给主机。软件侧通过 V4L2 驱动访问 /dev/videoX 设备节点,使用环形缓冲区管理采集到的帧,应用程序再进行显示、编码或传输。整个过程核心是“驱动采集—缓冲区交互—应用处理”的循环

V4L2

V4L2:

用户空间:┌──────────────────────────────────────┐│ while(1): ││ DQBUF → 取帧 ││ 处理数据(显示/编码/发送) ││ QBUF → 重新入队 │└──────────────────────────────────────┘↑ ↓

内核驱动:┌──────────────────────────────────────┐│ 驱动 DMA 写入缓冲帧 ││ 中断通知帧完成 ││ 管理缓冲队列状态 │└──────────────────────────────────────┘

V4L2 常用控制接口

| 步骤 | 调用接口 | 说明 |

|---|---|---|

| 1. 打开设备 | open() | /dev/videoX |

| 2. 查询能力 | VIDIOC_QUERYCAP | 检查是否支持视频采集 |

| 3. 设置格式 | VIDIOC_S_FMT | 分辨率、像素格式 |

| 4. 申请缓冲 | VIDIOC_REQBUFS | 分配队列缓冲 |

| 5. 映射缓冲 | VIDIOC_QUERYBUF + mmap | 映射到用户空间 |

| 6. 启动采集 | VIDIOC_STREAMON | 开始视频流 |

| 7. 获取帧 | VIDIOC_DQBUF / VIDIOC_QBUF | 不断采集帧 |

| 8. 停止采集 | VIDIOC_STREAMOFF | 释放资源 |

在 V4L2 中,重新入队(VIDIOC_QBUF)是为了:

✅ 让驱动重新使用这块缓冲区采集下一帧数据。

如果不重新入队会怎样?

如果用户只出队 (DQBUF),不再入队 (QBUF),那么:

- 驱动缓冲区会越用越少;

- 最后没有空闲缓冲区;

- 驱动无法继续采集新帧;

VIDIOC_DQBUF调用将阻塞(等待新帧但永远不会来)。

结果就是:

📉 画面卡死、帧率掉为 0。

| 问题 | 答案 |

|---|---|

| V4L2 怎么知道哪些缓冲可用? | 每个缓冲区有状态机(IDLE、QUEUED、ACTIVE、DONE),驱动自动管理 |

| 谁是生产者?谁是消费者? | 驱动(生产者)采集帧,用户(消费者)处理帧 |

| 多线程怎么保护? | 内核用自旋锁/mutex保护 vb2 队列,用户用 mutex + 条件变量同步 |

| 为什么环形? | 使用索引循环复用缓冲,提高采集效率并实现零拷贝 |

视频采集-编码-传输:

采集:

-

RKMPI_SYS_INIT()

-

SAMPLE_COMM_ISP_INIT():启动ISP 算法实现自动校正与增强,坏点修复(修复死点)、白平衡、曝光控制、自动增益控制、色彩校正等操作,保证捕获图像的质量

-

vi_dev_init:启动VI设备,配置设备属性,绑定管道,

- 帧率:每秒采集多少帧图像

- 码分辨率:图像的大小

-

编码器初始化:获取编码器属性,通道,编码类型,VPSS 通道,格式

- 空间冗余,时间冗余,信息熵冗余

-

RTSP实例,创建接口,设置RTSP属性,同步时间戳

调用瑞芯微的RKMPI库,实现视频的采集、编码与RTSP传输,我的任务是设计了三路视频码流,分别实现RTSP推流,本地LCD显示,以及一路低帧率码流用于AI识别,三路线程的视频处理,同时搭建onvif服务端与QT客户端进行数据传输。

LCD

-

修改设备树,添加TFT节点

dts文件

- LCD相关配置关: 1. 包括背光控制(LCD_BL)、数据/命令选择(LCD_DC)、复位信号(LCD_RES)。 2. 使用GPIO引脚实现对LCD显示屏的控制

- 引脚控制器(Pinctrl)配置: 配置了具体的GPIO引脚功能,包括背光、数据/命令选择、复位信号以及SPI控制器的引脚。

- SPI控制器配置: 启用SPI0控制器,并定义了相关的引脚组和设备节点。

dtsi文件

- 模块功能概述:主要定义了SPI控制器(spi0)及其相关的设备节点配置,包括一个通用SPI设备(spidev@0)和一个LCD显示屏驱动(fbtft@0)

-

SPI控制器配置:引脚组配置、地址单元和大小单元、通用spi节点配置

- LCD显示屏驱动配置:屏幕兼容性、基本配置、高级配置,GPIO配置

线程安全队列

1. 什么是线程安全队列

线程安全队列是一种能够在多线程环境下安全使用的队列数据结构。在多线程环境中,多个线程可能会同时对队列进行插入和删除操作,如果不进行适当的同步控制,可能会导致数据不一致、竞争条件或死锁等问题。它通过同步机制(如互斥锁、条件变量、原子操作等)来防止多个线程同时修改队列的状态,从而避免数据竞争和不一致的问题。

2. 线程安全队列的实现方式

- 使用互斥锁: 使用互斥锁保护队列的插入和删除操作,确保同一时间只有一个线程可以修改队列

- 使用读写锁: 使用读写锁允许多个线程同时读取队列,但写操作是独占的

- 使用无锁算法: 使用原子操作(如CAS操作)实现无锁队列,避免使用互斥锁,提高并发性能。

3. 线程安全队列的应用场景

- 生产者-消费者问题:多个生产者线程将数据放入队列,多个消费者线程从队列中取出数据进行处理。示例:任务调度、消息队列系统。

- 并发任务处理: 在多线程环境中,多个线程可以安全地将任务放入队列,其他线程从队列中取出任务执行。示例:线程池中的任务队列。

- 异步编程: 在异步编程模型中,线程安全队列用于存储待处理的事件或请求。

示例:事件循环中的任务队列。 - 缓存系统: 线程安全队列用于管理缓存中的数据,确保多线程环境下的数据一致性。示例:LRU 缓存。

4. 线程安全队列的注意事项

- 性能开销: 同步机制(如互斥锁)会引入一定的性能开销,特别是在高并发环境下。

- 死锁风险: 不正确的锁使用可能导致死锁,需要谨慎设计锁的获取和释放顺序。

- 公平性: 一些同步机制(如互斥锁)可能不保证公平性,导致某些线程长时间无法获取锁。

- 内存管理: 在实现线程安全队列时,需要注意内存的分配和释放,避免内存泄漏。

5. 常见的线程安全队列实现

- C++ STL 中的 std::queue:std::queue 本身不是线程安全的,但可以通过组合使用 std::mutex 和 std::condition_variable 来实现线程安全队列。

- C++11 中的 std::atomic:使用原子操作实现无锁队列,提高并发性能

环形缓冲区

RingBuffer,中文名是环形缓冲区,也被叫做循环缓冲区 ,从名字就能看出它的独特之处。简单来说,它是一种固定大小、头尾相连的缓冲区,通过头尾指针实现 “环形” 复用空间,避免内存碎片。

优势: 固定大小、内存连续、无需频繁扩容、读写效率高,适合生产者 - 消费者模型

环形缓冲区如何判断 “满” 和 “空”?有哪些实现方式?

- 预留一个空元素(牺牲 1 个位置),

(head + 1) % size == tail表示满,head ==tail 表示空; - 用计数器记录元素数量,

count == size为满,count == 0为空; - 用两个独立的读写指针 + 标志位区分满 / 空(if_full), 若写入后,读写索引相等说明队列已满,读取后一定不满

常见问题:

-

线程安全的环形缓冲区: 单生产者单消费者可通过原子操作实现无锁;多生产者 / 消费者需加锁或使用 CAS 等同步机制

-

读写的流程: 写操作先判断是否满,再写入并移动 tail;读操作先判断是否空,再读取并移动 head;需处理指针越界(模运算)

-

为什么大小是1024,是2的幂:

% size 运算可转化为 & (size-1),提升计算效率,尤其在嵌入式 / 高性能场景

应用场景: 传感器数据采集、音视频数据处理、多线程网络数据传输、日志缓存

缺点: 固定大小易溢出,不适合数据量动态变化大的场景;扩容困难,需重新分配内存并拷贝数据

线程安全:

- 互斥锁: 避免了竞争条件,但锁机制也有缺点,它会带来额外的开销,而且如果锁使用不当,还可能会导致死锁。

- 原子操作则是利用硬件提供的原子指令,保证对数据的操作是不可分割的,不会被其他线程打断

- 无锁数据结构则是一种更高级的解决方案,它通过巧妙的设计,避免了使用锁,从而提高了并发性能。像一些基于 CAS 算法实现的无锁 RingBuffer,在高并发场景下表现出色。但无锁数据结构的实现难度较大,需要对底层原理有深入的理解 。

解决方案:

- 单生产者单消费者场景下:头尾指针分别由生产者和消费者独立修改,通过原子变量保证可见性,无需加锁

- 多生产者多消费者场景下: 多个线程竞争读写指针,需用锁或无锁算法(如 CAS)保证操作原子性,可能引入性能开销

当多个线程同时进行读写操作时,需要通过同步机制来保证数据操作的正确性。但存在一种特殊场景:当只有一个读线程和一个写线程时,可以实现无锁的线程安全环形缓冲区。这种情况下,通过特定的指针操作设计,无需额外的锁机制就能避免数据竞争,确保读写操作的安全性。其核心思路是利用单生产者 - 单消费者模型的特性,通过指针间的逻辑关系来控制读写边界,从而在无锁情况下保证线程安全,代码如下:

#include <vector>template<typename T>

class RingBuffer

{

private:std::vector<T> elements;int head; // 写指针:指向 next 要写入的位置int tail; // 读指针:指向 next 要读取的位置bool is_full; // 用于区分满和空的状态public:RingBuffer(size_t cap) : elements(cap), head(0), tail(0), is_full(false) {}bool isEmpty() const {return !is_full && (head == tail);}bool isFull() const {return is_full;}// 总是接受新数据,必要时覆盖旧数据void push(const T& element) {// 如果缓冲区满了,移动读指针(相当于覆盖最旧的数据)if (isFull()) {tail = (tail + 1) % elements.size();}// 写入新数据elements[head] = element;head = (head + 1) % elements.size();// 更新满状态is_full = (head == tail);}bool pop(T &element) {if (isEmpty())return false; // 没有数据可读// 读取数据element = elements[tail];tail = (tail + 1) % elements.size();is_full = false; // 读取后一定不满return true;}size_t size() const {if (isFull())return elements.size();if (head >= tail)return head - tail;elsereturn elements.size() - tail + head;}size_t capacity() const {return elements.size();}

};

- tail 指针仅由读线程修改,head 指针仅由写线程修改,且始终维持单一的读写线程,不存在多个线程同时写入或同时读取的情况,因此不会产生并发写冲突。

- 不过需要注意,读写操作本身并非原子性的,读操作可能穿插在写操作过程中,反之亦然。这理论上可能引发两个问题:读线程在缓冲区为空时,可能读取到尚未写入完成的数据;写线程在缓冲区已满时,可能覆盖尚未读取的数据。

- 设计了特定的操作顺序 —— 写操作时先更新数据元素再移动 head指针,读操作时先读取数据元素再移动 tail指针 —— 这就从根本上避免了上述问题。因此,这种 RingBuffer 不仅是线程安全的,还实现了无锁设计,能获得更高的性能表现

要实现 RingBuffer 的读写操作,需要以下 4 个关键信息:

- 内存中的实际开始位置:它可以是一片内存的头指针,也可以是数组的第一个元素指针,用于确定缓冲区在内存中的起始地址。

- 内存中的实际结束位置:或者通过缓冲区实际空间大小,结合开始位置来计算出结束位置,以此定义缓冲区的边界。

- 写索引值: 在缓冲区中进行写操作时的索引值,标记下一个要写入数据的位置。

- 读索引值: 在缓冲区中进行读操作时的索引值,标记下一个要读取数据的位置。

CAS原子操作

比较并交换,通过硬件级别的原子指令,在无锁的情况下保证操作的安全性。CAS 是一个原子操作(不可被中断的操作),其目标是判断内存中的某个值是否与预期值一致,若一致则更新为新值,否则不做任何操作。

- 内存地址 V:需要操作的内存位置,读取内存地址 V 中的当前值;

- 比较currentValue与预期值 A 是否相等:

- 若相等:将内存地址 V 的值更新为新值 B,操作成功;

- 若不相等:不做任何修改,操作失败;

- 返回操作结果(成功或失败,部分实现会返回更新前的旧值)。

依赖CPU 的底层原子指令, CPU 会通过总线锁定或缓存锁定机制保证指令执行的原子性

CAS 操作失败本身不会导致程序错误或数据不一致,它仅仅是一个 “操作未成功执行” 的信号。实际行为完全由上层逻辑控制:

- 多数场景下(如原子类、无锁数据结构)会选择自旋重试,直到成功;

- 特殊场景下可能放弃操作或执行替代逻辑。

局限性:需注意的问题

ABA 问题:

- 若内存值从 A 被其他线程修改为 B,再改回 A,CAS 会误认为值未变(因为预期值 A 与当前值 A 一致),导致错误更新。

- 解决方式:引入版本号(如AtomicStampedReference),每次更新时版本号 + 1,CAS 同时比较值和版本号。

自旋开销

- 若并发冲突频繁,CAS 会陷入长时间自旋(循环重试),持续占用 CPU 资源,反而降低性能。

- 优化方式:限制自旋次数(如自适应自旋),或冲突严重时升级为锁。

只能保证单个变量的原子性

只能保证单个变量的原子性

- CAS 仅支持单个内存地址的原子操作,若需对多个变量进行原子操作,需通过其他方式(如合并变量为对象,或使用锁)实现。

SPSC队列

在 SPSC 场景中,原子操作的应用非常广泛,尤其是在实现高效的 SPSC 队列时。SPSC 队列是一种数据结构,它允许一个生产者线程将数据放入队列,同时允许一个消费者线程从队列中取出数据。由于只有一个生产者和一个消费者,因此可以使用一些特殊的技巧来实现高效的线程安全。

一种常见的实现方式是使用环形缓冲区(Circular Buffer)。环形缓冲区是一个固定大小的数组,它被视为一个环形结构。生产者和消费者通过移动指针来访问缓冲区中的数据。当生产者向缓冲区中写入数据时,它会将数据写入当前写指针指向的位置,然后将写指针向后移动一位。如果写指针到达了缓冲区的末尾,它会回到缓冲区的开头。

#include <atomic>

#include <iostream>

#include <type_traits>

#include <thread>template<typename T, size_t Capacity>

class SPSCQueue {

private:// 使用 Capacity + 1 来区分满和空状态static constexpr size_t kActualCapacity = Capacity + 1;T buffer[kActualCapacity];std::atomic<size_t> m_read_idx{0};std::atomic<size_t> m_write_idx{0};public:SPSCQueue() = default;~SPSCQueue() = default;// 禁止拷贝和赋值SPSCQueue(const SPSCQueue&) = delete;SPSCQueue& operator=(const SPSCQueue&) = delete;// 生产者线程调用:向队列中添加元素bool enqueue(const T& item) {size_t write_idx = m_write_idx.load(std::memory_order_relaxed);size_t next_idx = (write_idx + 1) % kActualCapacity;// 检查队列是否已满if (next_idx == m_read_idx.load(std::memory_order_acquire)) {return false; // 队列已满}buffer[write_idx] = item;m_write_idx.store(next_idx, std::memory_order_release);return true;}// 生产者线程调用:移动版本的入队操作bool enqueue(T&& item) {size_t write_idx = m_write_idx.load(std::memory_order_relaxed);size_t next_idx = (write_idx + 1) % kActualCapacity;// 检查队列是否已满if (next_idx == m_read_idx.load(std::memory_order_acquire)) {return false; // 队列已满}buffer[write_idx] = std::move(item);m_write_idx.store(next_idx, std::memory_order_release);return true;}// 消费者线程调用:从队列中取出元素bool dequeue(T& item) {size_t read_idx = m_read_idx.load(std::memory_order_relaxed);// 检查队列是否为空if (read_idx == m_write_idx.load(std::memory_order_acquire)) {return false; // 队列为空}item = std::move(buffer[read_idx]);size_t next_idx = (read_idx + 1) % kActualCapacity;m_read_idx.store(next_idx, std::memory_order_release);return true;}// 检查队列是否为空(仅由消费者线程调用)bool empty() const {return m_read_idx.load(std::memory_order_acquire) == m_write_idx.load(std::memory_order_acquire);}// 获取队列中元素的数量(仅由消费者线程调用)size_t size() const {size_t read_idx = m_read_idx.load(std::memory_order_acquire);size_t write_idx = m_write_idx.load(std::memory_order_acquire);if (write_idx >= read_idx) {return write_idx - read_idx;} else {return kActualCapacity - read_idx + write_idx;}}// 获取队列最大容量size_t capacity() const {return Capacity;}

};// 示例使用

int main() {SPSCQueue<int, 10> queue;// 生产者线程逻辑auto producer = [&queue]() {for (int i = 0; i < 20; ++i) {while (!queue.enqueue(i)) {// 队列满了,可以短暂等待或执行其他操作std::this_thread::sleep_for(std::chrono::microseconds(1));}std::cout << "Enqueued: " << i << std::endl;}};// 消费者线程逻辑auto consumer = [&queue]() {for (int i = 0; i < 20; ++i) {int item;while (!queue.dequeue(item)) {// 队列空了,可以短暂等待或执行其他操作std::this_thread::sleep_for(std::chrono::microseconds(1));}std::cout << "Dequeued: " << item << std::endl;}};// 创建并启动线程std::thread producer_thread(producer);std::thread consumer_thread(consumer);// 等待线程完成producer_thread.join();consumer_thread.join();return 0;

}

MPMC无锁队列

在上述SPSC队列中,当入队缓存已满或出队缓存为空时,采用简单的索引比较来判断队列状态,这种实现方式可能出现以下问题:

- 在多生产者或多消费者环境下会发生竞态条件(Race Condition):多个生产者可能同时读取 m_write_idx,然后都判断队列未满,导致多个线程尝试写入同一个位置。

- 此外也没有解决ABA问题,索引是循环使用的,可能出现不同状态但索引值相同的情况

LockFreeQueue的MPMC支持机制

- 使用compare_exchange_weak 进行原子操作,这确保了只有成功更新写索引的线程才能继续执行写入操作,避免了多个生产者写入同一位置的问题。

- 使用额外的标志位(flag)标记元素状态

两阶段检查机制: LockFreeQueue在写入前进行了两次检查:

- 检查队列是否已满(通过索引比较)

- 检查目标位置是否已被占用(通过flag)

这种双重检查机制确保了在并发环境下的数据一致性。

template<typename T, size_t N = 1024>

class LockFreeQueue{

public:// 定义队列的元素struct Element{// 定义元素是否存在,存在才可以读写std::atomic_bool flag;T data;};LockFreeQueue() : m_data(N), m_write_idx(0), m_read_idx(0) {}~LockFreeQueue() = default;// 入队// 满的条件 write_idx = read_idx + data.size()bool Enqueue(T value) {int write_idx = 0;Element *e = nullptr;do{// 获取当前读位置write_idx = m_write_idx.load(std::memory_order_acquire);// 检查队列是否已满(写位置 >= 读位置 + 队列容量)if(write_idx >= m_read_idx.load(std::memory_order_acquire) + m_data.size())return false;// 计算在循环数组中的实际索引size_t index = write_idx % m_data.size();e = &m_data[index]; // 取出队头元素// 检查该位置是否已被占用(flag为true表示已被写入但未读取)if(e->flag.load(std::memory_order_acquire))return false;}while (!m_write_idx.compare_exchange_weak(write_idx, // 输入:预期值;输出:实际值(比较失败时)write_idx + 1, // 当预期值与原子变量当前值相等时,要设置的新值std::memory_order_release, // 比较并交换成功时的内存序std::memory_order_relaxed)); // 比较并交换失败时的内存序// CAS成功,执行实际写入操作e->data = std::move(value); // 转移所以权e->flag.store(true, std::memory_order_release); // 标记已占用return true;}bool Dequeue(T& val){int read_idx = 0;Element *e = nullptr;do{// 只是取出数据,不考虑内存序,这里条件宽松read_idx = m_read_idx.load(std::memory_order_acquire);// 队列已经满了if(read_idx >= m_write_idx.load(std::memory_order_acquire))return false;// 获取当前可以使用的下标size_t index = read_idx % m_data.size();// 取出队头元素e = &m_data[index];// 考虑位置是否能被读出来if(!e->flag.load(std::memory_order_acquire))return false;}while (!m_read_idx.compare_exchange_weak(read_idx, read_idx + 1,std::memory_order_release,std::memory_order_relaxed));// 弱交换, 性能更好val = std::move(e->data); // 转移所以权e->flag.store(false, std::memory_order_release); // 标记该位置目前被使用了return true;}private:std::vector<Element> m_data;std::atomic_int m_read_idx;std::atomic_int m_write_idx;

};

-

compare_exchange_weak:可能会出现伪失败,即在比较成功的情况下仍然返回 false -

compare_exchange_strong:不会出现伪失败,比较成功就一定返回 true -

锁队列实现中使用

compare_exchange_weak是非常合适的选择,因为代码已经包含了重试循环 do-while,可以很好地处理伪失败的情况,同时还能获得更好的性能表现。 -

伪失败是指

compare_exchange_weak函数在比较实际上是成功的情况下,仍然返回 false 的现象。

OSD叠加

将yolo模型转RKNN模式并部署至摄像头平台,完成识别后采用OSD异步的形式一批一批的绘制识别结果在主码流上,同时控制云台的自动追踪功能

- 直接调用例程比较卡,重新开一路低分辨率的码流供AI识别,由于识别非串行,通过批量化处理,一批一批的显示,异步显示,将OSD结果叠加到主码流,推流不卡顿,OSD自动叠加。

OSD步骤:

- 步骤1: 调用RK_MPI_RGN_Create 填充区域属性并创建区域。

- 步骤2:调用RK_MPI_RGN_AttachToChn 将画布绑定到通道特定区域上。

- 步骤3:调用RK_MPI_RGN_GetCanvasInfo 获取画布信息。

- 步骤4:将位图数据写入画布信息中。

- 步骤5:调用RK_MPI_RGN_UpdateCanvas 更新画布。

- 更新画布信息时重复步骤3 ~ 步骤5。

- 步骤6:不用时调用 RK_MPI_RGN_DetachFromChn 将画布从绑定通道中解绑。

- 步骤7:调用 RK_MPI_RGN_Destroy 销毁区域。

YUV420 是一种广泛应用于视频存储、传输和处理的色彩编码格式,它通过分离**亮度(Y)和色度(UV)**信息

-

亮度(Y,Luminance):代表图像的明暗信息,对应黑白图像的灰度值,人眼对其变化更敏感。

-

色度(UV,Chrominance):包含色彩的色调(U,蓝色分量与亮度的差值)和饱和度(V,红色分量与亮度的差值)信息,人眼对其细节敏感度较低。

-

比例定义:在每 4 个连续的 Y 像素(通常构成 2×2 的像素块)对应的区域中,只保留 1 个 U 像素和 1 个 V 像素。

-

直观理解:

- Y 分量:每个像素都保留完整信息(数据量最大)。

- U 和 V 分量:水平和垂直方向上的分辨率均为 Y 的 1/2(即每 2×2 的 Y 块共享一组 UV 值)。

-

数据量优势:相比 RGB 格式(每个像素 3 个分量均完整存储),YUV420 的数据量仅为其 3/8(RGB:3 字节 / 像素;YUV420:1 + 0.25 + 0.25 = 1.5 字节 / 像素),大幅节省存储和带宽。

2bpp(Bits Per Pixel,每像素位数)图像具有以下特征:

- 颜色深度: 2bpp 图像每个像素使用 2 位来表示颜色,因此,每个像素可以表示 (2^2 = 4) 种不同的颜色。

- 颜色调色板: 由于每个像素只能表示 4 种颜色,通常会使用一个颜色调色板(Color Palette)来定义这 4 种颜色, 调色板中的每个颜色通常用 RGB 值表示。

- 存储效率: 2bpp 图像的存储效率较高,因为每个像素只需要 2 位。

- 内存访问: 由于每个字节可以存储 4 个像素(2 位/像素),在处理 2bpp 图像时,通常需要按字节访问内存,并在字节内进行位操作来提取或设置单个像素的值,例如,一个字节

0b10100101可以表示 4 个像素,分别为10、10、01和01。

云台追踪

- 计算当前目标与上一个目标与视频中心的偏移

- 计算当前目标与上个目标的面积

- 计算两次得分 = 置信度 + 面积 * 权重

- 更新目标的坐标和置信度

- 计算目标中心位置与图像中心的偏移量

- 是否在感兴趣区域内、偏移吃否超过容忍值

- 将像素偏移量转换为云台角度调整量,左右 90°,俯仰 45°

onvif协议总结

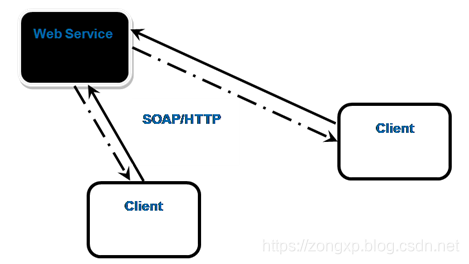

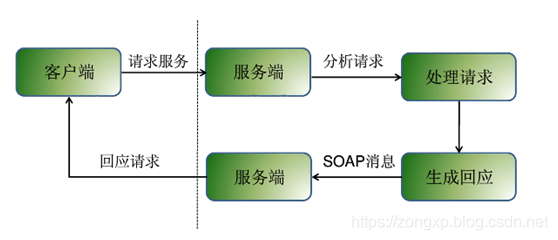

基于ONVIF协议的摄像头开发总结

什么是onvif

ONVIF规范中设备管理和控制部分所定义的接口均以Web Services的形式提供,设备作为服务提供者为服务端。ONVIF规范涵盖了完全的基于XML及WSDL的定义。每一个支持ONVIF规范的终端设备均须提供与功能相应的Web Service。服务端与客户端的数据交互采用SOAP协议。ONVIF中的其他部分比如音视频流则通过RTP/RTSP进行

客户端根据 WSDL 描述文档,会生成一个 SOAP 请求消息,该请求会被嵌入在一个HTTP POST请求中,发送到Web Services 所在的Web 服务器。Web Services 请求处理器解析收到的 SOAP 请求,调用相应的 Web Services。然后再生成相应的SOAP 应答。Web 服务器得到 SOAP 应答后,会再通过 HTTP应答的方式把信息送回到客户端。

Web Service能为视频监控什么

- 设备的无关性,任何一个设备接入系统,不会对其他系统造成影响。

- 设备的独立性,每一个设备只负责对接收到的请求做出反馈,甚至不需要知晓控制端的存在。

- 管理的集中性,所有的控制由客户端来发起。

ONVIF规范能为视频监控带来什么

- 抽象了功能的接口。统一了对设备的配置以及操作的方式。

- 控制端关心的不是设备的型号,而是设备所提供的Web Service。

- 规范了视频系统中Web Service范围之外的行为。

- ONVIF提供了各个模块的WSDL,拥有效率非常高的开发方式。

ONVIF规范的内容

- 设备发现,设备管理,实时流媒体,事件处理,PTZ,接收端配置,显示服务,设备输入输出服务

WSDL: WSDL是Web services 描述语言的缩写。是一种基于xml的网络服务描述语言,用来描述Web服务和说明如何与Web服务通信的XML语言,为用户提供详细的接口说明书。

SOAP:

SOAP是Simple Object Access Protocol的缩写。是基于XML的一种协议。一条SOAP 消息就是一个普通的XML 文档,包含下列元素:

- 必需的 Envelope 元素,可把此 XML 文档标识为一条 SOAP 消息

- 可选的 Header 元素,包含头部信息

- 必需的 Body 元素,包含所有的调用和响应信息

- 可选的 Fault 元素,提供有关在处理此消息所发生错误的信息

RTSP协议总结

RTSP关键信令交互流程

- 建立连接:客户端通过 TCP(默认端口554) 或 UDP 与服务器建立连接。

- 选择协商: 客户端->服务器、服务器->客户端:返回支持的RTSP方法

- 获取媒体描述: 客户端请求媒体资源的SDP描述,服务器返回SDP描述

- 建立传输通道: 客户端协商传输方式(RTP over UDP/TCP)和端口,服务器传输参数并返回会话ID

- 开始播放: 客户端请求开始传输流、服务器确认播放

- 终止会话: 客户端终止会话、服务器确认终止

RTSP概述

- rtsp协议是国际标准,里面使用了sdp协议, rtp协议,rtcp协议, sdp协议叫做会话描述协议, rtp协议叫做实时传输协议,rtcp为实时传输控制协议。

RTSP:应用层,控制媒体流的播放、暂停、终止

SDP:会话描述层:

- 声明媒体流的格式(如H.264)、传输方式(TCP/UDP)、端口号等

- sdp是一个文本描述协议,用于声明会话参数

RTP over UDP:

- 延时低、不可靠(容忍丢包)、协议开销小,实时音视频、直播、视频会议

- 在网络弱、需穿透防火墙时需要over TCP

- 5004 是 RTP 的常见默认端口

RTCP:

- RTCP 强制使用TCP: RTSP协议本身的控制命令必须通过TCP传输(默认端口554),确保信令的可靠性和有序性。

- 主流选择: 大多数实时流媒体(如摄像头监控)使用RTP over UDP传输音视频数据,搭配RTCP进行质量控制

- 追求低延迟选UDP,追求可靠性选TCP

RTCP控制信号的具体功能

- 网络质量反馈(RR/SR) 丢包率 接收端RR报文告知发送端SR,

- 延迟与抖动:计算网络延迟(DLSR字段)和抖动(包到达时间波动)

- RTCP的“控制信号”是针对媒体流传输的实时反馈机制,核心目标是动态优化QoS(服务质量)

- RTCP:通过SR(Sender Report)和RR(Receiver Report)报告传输质量(丢包率、延迟等)

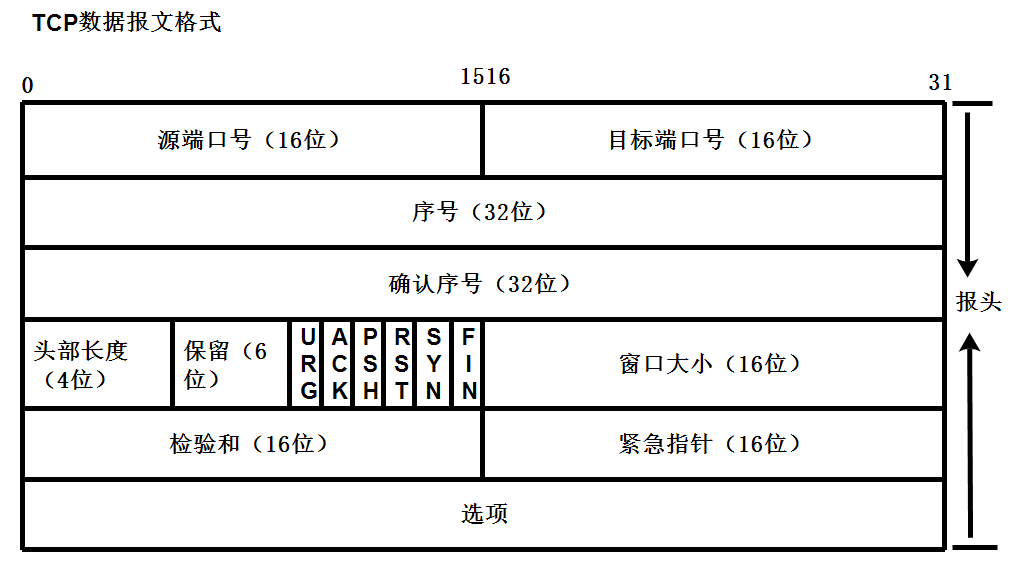

RTP包结构

RTP Header字段:

- V 版本 固定为2

- 是否有填充字节

- 扩展头

- CSRC计数 CC

- 标记关键帧

- 负载类型

- 序列号

- 时间戳

- SSRC:同步标识符

视频封装(以H.264为例)

- NAL单元(Network Abstraction Layer Unit):H.264的基本数据单元

NAL头(1字节):F|NRI|Type,其中:

- F(Forbidden):错误位,通常为0。

- NRI(重要性):0~3,值越大表示越重要。

- Type:NAL单元类型(如7=SPS,8=PPS,5=IDR帧)

(1)单NAL单元模式:一个RTP包包含一个完整的NAL单元。

±--------±---------------+

| RTP头 | NAL单元(如IDR)|

±--------±---------------+

(2)分片模式(FU-A):大NAL单元分片传输

±--------±------±--------------±--------------+

| RTP头 | FU头 | FU负载起始部分 | …后续分片…|

±--------±------±--------------±--------------+

FU头(1字节):S|E|R|Type,其中:

- S(Start):是否为分片起始。

- E(End):是否为分片结束。

- R(Reserved):保留位.

- Type:原NAL单元类型。

(3)组合模式(STAP-A):多个小NAL单元合并到一个RTP包。

视频编码器 Video Encoder

H.264/AVC 帧间预测、CAVLC/CABAC熵编码 直播、视频监控、蓝光光盘

H.265/HEVC: 4K/8K超高清、VR、医疗影像

AV1 2018 流媒体(YouTube、Netflix)

帧类型(Frame Types)

-

I帧:独立编码帧,关键帧,解码不依赖其他帧(压缩率低,质量高,保真度)。

-

P帧:预测帧,参考前一帧(I或P帧)进行运动补偿预测。

-

B帧:双向预测帧,参考前后双向帧,压缩率更高,但增加延迟。

| 帧类型 | 参考帧 | 编码方式 | 核心作用 | 优点 | 缺点 |

|---|---|---|---|---|---|

| I 帧 | 无(自参考) | 帧内编码 | 作为后续帧的参考基准,随机访问点 | 画质最高,可独立解码 | 压缩率最低,数据量大 |

| P 帧 | 1 个前向参考(I/P 帧) | 帧间预测 + 残差 | 利用前帧冗余,降低数据量 | 压缩率高于 I 帧 | 依赖前帧,出错会扩散 |

| B 帧 | 2 个参考(前 + 后 I/P 帧) | 双向预测 + 残差 | 最大化利用帧间冗余 | 压缩率最高(比 P 帧低 30%+) | 依赖前后帧,解码延迟高,不可作为参考帧 |

参数优化:

CRF: 动态码率控制(x264/x265常用,值越小质量越高)。 CRF=23(默认平衡点)

- CRF通过动态调整量化参数控制压缩强度:

- RF↓ → QP↓:减少量化步长,系数舍入误差越小 → 重建图像更接近原始帧,保留更多细节 质量与体积的平衡

GOP结构: I帧间隔(如GOP=30)、B帧数量(如–bframes 4)。

- GOP大小与丢包恢复能力: GOP小→I帧多→恢复快,因此可能减少花屏;但若导致码率波动引起丢包增加,反而增加花屏

- GOP调小能缩短丢包恢复时间 GOP=1~2秒 禁用B帧

视频卡顿花屏 GOP

-

定义: GOP是一组连续的图像帧序列,以I帧(关键帧)开始,后面跟若干P帧(预测帧)或B帧(双向预测帧)

-

I帧:完整编码的帧,解码时不依赖其他帧。

-

P/B帧:基于参考帧(如I帧或前序帧)压缩,解码依赖前文。

-

调小GOP: 即缩短I帧间隔,例如从300帧(10秒)调整为30帧(1秒),增加关键帧密度

-

花屏常见的原因之一是丢包导致参考帧缺失。如果GOP太大,关键帧帧间隔时间长,那么在网络差的时候,丢失的P/B帧可能无法正确参考之前的I帧,导致后续画面出错,直到下一个关键帧帧出现才恢复。

-

调小GOP可能导致码率波动更大,因为I帧的压缩率较低,体积较大

GOP大小与丢包恢复能力: GOP小→I帧多→恢复快,因此可能减少花屏;但若导致码率波动引起丢包增加,反而增加花屏

GOP调小能缩短丢包恢复时间

QT客户端

MVVM

在MVVM架构中,ViewModel作为Model和View之间的桥梁,主要承担以下职责:

- 数据转换与格式化:将Model层的数据转换为View层可直接使用的格式

- 业务逻辑处理:包含与UI相关的业务逻辑,但不包含视图操作

- 状态管理:维护视图状态(如加载中、错误状态等)

- 命令处理:处理来自View的用户交互命令

- 数据验证:对输入数据进行验证

响应式编程是实现实时更新的核心:

- 当数据变化时自动通知所有观察者

线程池的设计

线程池整体工作流程

- 用户通过

submitTask提交一个任务,抢锁,condNotFull.wait_for,如果任务队列未满,任务入队,如果任务队列满了,等待1秒(wait_for),return Result(task, false);notEmpty.notify,唤醒阻塞的线程来消费了- 设置设置了

cached模式,且 任务队列长度 > 当前可用线程的数量,并且当前线程数量又小于最大线程数,扩容 - 返回Result类型,并支持类型参数类型,

return Result(task);

- 线程函数:抢锁,

condNotEmpty.wait,如果线程池有线程(tasiSize > 0),唤醒一个线程,从任务队列中取一个任务来执行notFull.notify,通知用户可以提交任务了if taskSize > 0,notEmpty.notify,任务队列还有任务,通知其他线程可是继续来消费cached模式下,如果任务队列为空,获取当前时间与上一次运行这个线程的时间:auto now = std::chrono::high_resolution_clock().now();,如果,则回收当前这个线程- 任务队列为空了

- 两个时间的差值大于60s

- 当前线程数量 > 核心线程数量

- 资源回收,如果

quit_flag,- 析构函数,

condNotEmpty.notify,唤醒等待任务中的线程, - 线程函数释放线程池函数后,

condExit.notify_all();,唤醒析构函数中的Exit条件变量(pool.size())

- 析构函数,

设计细节与常考问题

- 线程池中没有线程处理用户提交的任务了怎么办,用户不是阻塞了吗

- 加入用户加入的任务的生命周期比较短怎么办呢

- 怎么设计返回值表示任意类型Any,如何设计Result机制,如果线程还没有处理完获取结果会怎么样(如果提交成功则阻塞,如果提交失败)

submitTask返回结果是task->getResult()还是Result(task)比较好- 随着task被执行完,task对象没了,线程池中会 pop(),然后析构了,所以需要在Result中保存 task

- 对于get方法,如果任务提交失败,是否还需要阻塞

- setVal,如何获取任务run的返回值,exec()封装run(),在run完保存run结果,setVal(Any),但原来是Result中包含task,用裸指针,1. 避免循环引用 2. Result的生命周期是大于task的,然后在Result里面执行 task->setResult(this);

- get,用户调用这个方法,获任务执行的返回值

step1

-

对于每个任务

run()函数执行完毕,自动释放资源,希望自动释放资源,并且还要考虑用户传入的对象的生命周期std::queue<std::shared_ptr<Task>> taskQue; // 任务队列 -

线程函数设计,从任务队列(非空)中取一个任务给线程消费,结果如果queSzie > 0,notEmp通知,notFull一定会通知

-

用户提交函数用智能指针管理,极端情况,如果任务队列满了,会提交失败,等待1秒wait_for返回false

-

线程函数thread_function定义在ThreadPool中,但需要绑定到Thead中

step2 资源回收与后处理

- 线程池的资源回收

- 析构函数等待正在执行的线程,执行完再通知析构函数的条件变量

- 析构函数函数唤醒阻塞线程,

- 线程池结束后,如何处理任务队列中的任务,队列为空exitCond.notify

step3 线程池支持cached模式

-

用户自定义设置工作模式,默认Fixed

-

提交任务函数中,任务数 > 空闲线程数,需要创建空闲线程

-

线程函数中,如果有过多的空闲线程,并且空闲时间超过了60s,回收空闲线程

- 时间相关与判断(high_resolution_clock)

- 如何找到这个线程函数对应的是哪个线程,thread_id > 线程对象 > 删除

step4

如何获取线程任务返回值,并接收任意参数类型

Result res = pool.submitTask(std::make_shared<MyTask>());

int data = res.get().cast_<int>();

接收任意参数类型,定义Any类

- 定义一个抽象基类

Base,作为所有类型的共同接口。 - 定义模板派生类

Derived<T>,用于存储具体类型T的数据,并继承自Base。 Any类通过持有Base的智能指针,间接存储任意类型的Derived<T>对象,从而实现 “存储任意类型” 的能力。- 通过

dynamic_cast实现类型的安全转换,确保提取数据时的类型正确性。

类层次结构:

Base:纯接口基类,仅定义默认构造函数和虚析构函数(虚析构函数确保Derived对象能被正确销毁)。Derived<T>:模板类,继承自Base,内部用data_存储具体类型T的数据。

Any类的关键成员:

std::unique_ptr<Base> basePtr:智能指针,指向Derived<T>对象,实现对任意类型数据的存储。- 禁用拷贝构造和拷贝赋值(

= delete),允许移动构造和移动赋值(= default),确保资源管理的安全性(unique_ptr不可拷贝)。

核心功能:

- 构造函数模板:接收任意类型

T的数据,通过std::make_unique创建Derived<T>对象,并用basePtr持有。 cast_<T>()方法模板:通过dynamic_cast将basePtr转换为Derived<T>*,若成功则返回存储的数据,否则抛出异常。

#include<memory>

class Base{

public:Base() = default;virtual ~Base() = default;

};template<typename T>

class Derived : public Base{

public:Derived(T data) : data_( data) {}~Derived() = default;T data_;

};class Any

{

public:Any() = default;~Any() = default;Any(const Any& ) = delete;Any& operator=(const Any&) = delete;Any( Any&& ) = default;Any& operator=( Any&&) = default;//构造函数接收任意其他类型的数据template<typename T>Any(T data) : basePtr(std::make_unique<Derived<T>>(data)) {}// cast_提取任意其他类型的数据template<typename T>T cast_() {auto ptr = dynamic_cast<Derived<T>*>(basePtr.get());if(ptr != nullptr)return ptr->data_;elsethrow "type error";}

private:std::unique_ptr<Base> basePtr;

};

封装Any类与Task,run的结果,定义一个Resul类

-

是task.getResult()还是Result(task)。随着task被执行完,task对象没了,线程池中会 pop(),然后析构了,所以需要在Result中保存 task。

- 对于get方法,如果任务提交失败,是否还需要阻塞

- setVal,如何获取任务run的返回值,exec()封装run(),在run完保存run结果,setVal(Any),但原来是Result中包含task,用裸指针,1. 避免循环引用 2. Result的生命周期是大于task的,然后在Result里面执行 task->setResult(this);

- get,用户调用这个方法,获任务执行的返回值

- Result如何获取task的结果的,Task中封装run(),在exec中

设计一个Resul类,有成员变量:

- taskPtr:保存用户用户提交的任务指针

- isValid:保存用户提交任务成功与否

- 信号量sem:等待任务执行完毕

- 数据类型 Any

Result类设计

class Result {

public:Result() : taskPtr(nullptr) {}~Result() = default;Result(std::shared_ptr<Task> task, bool flag = true) : taskPtr(task), isValid(flag){if (taskPtr) {taskPtr->setResult(this);}}// 设置结果void setVal(Any any) {this->any = std::move(any);sema.post();} // 获取结果Any get() {if(!isValid) return ""; // 用户提交任务失败sema.wait(); // 等待用户任务完成return std::move(any);}private:Any any;std::shared_ptr<Task> taskPtr;std::atomic_bool isValid;Semaphore sema;

};

Task类设计

// 前向声明 Result 类

class Result;

class Task

{

private:Result* result;

public:virtual Any run() = 0;void exec() {if(result)result->setVal(run());}void setResult(Result* res){this->result = res;}

};

Semaphore类设计

#include <mutex>

#include <condition_variable>

#include <atomic>class Semaphore

{

private:std::atomic_bool isExit;int cnt;std::mutex mtx;std::condition_variable cond;public:Semaphore(int szie = 0) : cnt(szie), isExit(false) { }~Semaphore() {isExit = true;}void post() {if(isExit)return;std::unique_lock<std::mutex> lock(mtx);cnt++;// linux下condition析构什么也没做,没有释放任何东西// 导致cond无效cond.notify_all();}void wait() {if(isExit)return;std::unique_lock<std::mutex> lock(mtx);cond.wait(lock, [=]()->bool{return cnt > 0;});cnt--;}

};

step5 项目优化

- 现需要定义派生类,继承于Task对象,然后重写run()方法,并通过构造函数传入参数,提交任务应该更简单,直接传递函数名称

- 为了获得返回值,任务比较大Any类,Semaphore类,Result类

- 解决方案:

- 可编程模板编程

- packaged_task(函数对象)和future(相当于Result)机制来节省线程池代码

概念问题

核心作用:

- 降低资源消耗: 减少线程创建 / 销毁的性能开销(线程是稀缺资源,创建需分配内存、上下文切换等)。

- 提高响应速度: 任务到达时无需等待线程创建,直接复用空闲线程。

- 便于管理控制: 统一管理线程生命周期,可控制并发数、监控线程状态等。

线程池的优势

线程池的优势就是,在服务进程启动之初,就事先创建好线程池里面的线程,当业务流量到来时需要分配线程,直接从线程池中获取一个空闲线程执行task任务即可,task执行完成后,也不用释放线程,而是把线程归还到线程池中继续给后续的task提供服务。

频繁创建线程存在明显缺陷:

- 性能开销大: 线程创建需向 OS 申请资源(如栈空间,默认 1MB),销毁需回收资源,频繁操作会导致 CPU 资源浪费。

- 资源耗尽风险: 无限制创建线程可能导致内存溢出(OOM)或系统资源耗尽(如句柄不足)。

- 难以管理: 无法统一控制并发数,可能因线程过多导致上下文切换频繁,反而降低效率。

线程池的核心参数与作用

| 核心参数 | 作用 |

|---|---|

| 核心线程数 | 线程池长期保留的最小线程数(初始化线程数),即使空闲也不会销毁 |

| 最大线程数 | 程池允许创建的最大线程数(核心线程 + 非核心线程(动态创建)的上限) |

| 非核心线程空闲存活时间 | 当非核心线程空闲超过该时间(60s),会被销毁释放资源 |

| 任务阻塞队列 | 当核心线程都在忙时,新任务会进入该队列等待,每次提交也先都提交到队列中 |

| 拒绝策略 | 当线程池、队列都满时,对新任务的处理策略 |

线程池的两种模式:

- fixed模式:线程池里面的线程个数是固定不变的,一般是ThreadPool创建时根据当前机器的CPU核心数量进行指定。

- cached模式: 线程池里面的线程个数是可动态增长的,根据任务的数量动态的增加线程的数量,但是会设置一个线程数量的阈值,任务处理完成,如果动态增长的线程空闲了60s还没有处理其它任务,那么关闭线程,保持池中最初数量的线程即可。

并发与并行:

- 并发: 在单核CPU,一个流水线上,运行多个任务,每个任务占用一定的时间片,相当于一个时间片轮转,每一个时刻还是只有一个任务在执行

-

并行: 对于多CPU,每个CPU上有一条流水线,每条流水线上又有不同的任务在并发执行,比如task1在第一条流水线上执行,task2在第二天流水线上执行,同一时刻是有多个任务在同时执行的。

IO密集与CPU密集:

- CPU密集型: 程序内部主要是做计算用的,如深度学习、1+2+…+到10亿

- IO密集型: 程序的指令涉及IO操作,文件操作、设备、网络操作(等待客户端接入,IO操作可以把进程阻塞住的),再分配给他CPU的时间片,CPU相当于是空闲下来了

多线程编程是否一定好

- 对于多核CPU都是适合的

- 单核的CPU密集型不适合多线程: 因为多个线程的调度会频繁的上下文切换,线程栈保存相关上下文寄存器,保存到内核栈,调度时候还要访问另一个线程的内核栈,花销高

- 单核的IO密集型还是适合的,IO会有阻塞队列,不在就绪队列中,不会被调度,阻塞的时候会让出CPU的时间片

线程的消耗

- 线程的创建和销毁都是非常"复杂"的操作(空间切换,PCB,内核栈,页表,页目录,地址空间数据结构vm_struct,又要回到用户空间,还要销毁)

- 线程栈(保存函数信息)本身占用大量内存,用户空间3G,一个线程栈8M,380个左右的线程

- 线程的调度,线程的上下文切换要占用大量时间

- 大量线程同时唤醒(同一时间很多IO操作准备好了)会使系统经常出现锯齿状负载或者瞬间负载量很大导致宕机

上下文切换: 线程的调度,保存上下文,保存CPU寄存器信息保存到线程栈上

线程数的确定

1. CPU 密集型任务

- 特点: 任务主要消耗 CPU 资源(如复杂计算、数据处理等),线程运行时很少阻塞,CPU 利用率接近 100%。

- 核心问题: 线程数过多会导致 CPU 频繁进行上下文切换(保存 / 恢复线程状态),反而增加额外开销,降低整体效率。

设置原则:

- 核心线程数 ≈ CPU 核心数 或 CPU 核心数 + 1。

- 最大线程数 = 核心线程数(无需额外创建非核心线程,避免上下文切换损耗)。

示例: 若服务器为 4 核 CPU,核心线程数可设为 4 或 5(+1 是为了应对偶尔的线程阻塞,如极短的 IO 操作);最大线程数同样设为 4 或 5。

2. IO 密集型任务(IO-bound)

- 特点: 任务大部分时间处于阻塞状态(如数据库查询、网络请求、文件 IO 等),CPU 利用率较低(线程等待 IO 时 CPU 空闲)。

- 核心问题: 线程阻塞时 CPU 空闲,需要更多线程 “填充” 空闲时间,提高 CPU 利用率。

设置原则:

- 核心线程数 ≈ CPU 核心数 × 2 (基础参考)。-

- 最大线程数:根据 IO 阻塞时间调整,阻塞时间越长,可设置越大(但需避免无限制增大)。

进阶公式:

理想线程数 = CPU核心数 × (1 + IO等待时间 / CPU执行时间)- 例如: 若任务的 IO 等待时间是 CPU 执行时间的 3 倍,4 核 CPU 的理想线程数为 4 × (1 + 3) = 16。

同步与互斥

互斥锁mutex

- 看这段代码是否存在竞态条件,称作临界区代码段,代码不可重入的,需要保证它的原子操作,通过互斥锁来保证他的原子操作

lock_guard:自动加锁与加锁,通过构造函数加锁,析构函数解锁,不支持手动的加锁与解锁。unique_lock: 提供手动的lock与unlock,可以手动加锁与解锁,可以配合条件变量使用

atomic原子类型

-

使用的是CAS操作(比较与交换),效率性能会比较高,但也会有一定的问题,比如ABA问题

-

生产者/消费者操作容器,都要先获取一把锁,因为容器不是线程安全的

-

生产者先检测容器是否已满,如果满

wait,发生以下事情- 改变线程的状态,改变等待状态

- 释放互斥锁,让消费者去获取锁

-

生产者生产完后把数据存入容器,然后

notify,唤醒等待在这个条件上的线程,等待在这个条件变量的线程从等待状态转化为阻塞状态。 -

消费者消费之前检查容器是否为空,如果为空则

wait,同理发生以上两件事情 -

消费者如果收到很生产者的

notify,从等待到阻塞,获取到锁互就就绪,等待调度

信号量 semaphore

- 可以看成资源记数没有限制的互斥锁,互斥锁可以看成资源记数只有0,1的信号量

互斥锁与信号量的区别:

- 互斥锁是独占的,信号量是共享的

- mutex由哪个线程获取,必须由哪个线程来解锁,信号量的post/wait可以由不同的线程操作

- 互斥锁不能直接unlock(无意义),信号量可以直接post或wait

FFmpeg

设计一个基于 FFmpeg 和 Qt 的视频解码器类VideoDecoder,主要功能是打开视频流、解码视频帧,并将解码后的帧转换为 Qt 的QImage格式用于显示。核心流程包括:初始化 FFmpeg、打开视频源、查找视频流、初始化解码器、读取并解码帧、格式转换为 RGB(适配 QImage)

FFmpeg 的核心库及其作用:

libavformat:处理媒体格式(封装 / 解封装),支持 RTSP、MP4、MKV 等格式。libavcodec:提供编解码器(如 H.264、H.265、AAC),负责编码和解码。libswscale:处理像素格式转换和尺寸缩放(如 YUV→RGB、1080P→720P)。libavutil:提供工具函数(如内存管理、数学运算),是其他库的基础。

核心结构体及其作用

AVFormatContext:格式上下文,用于管理媒体文件 / 流的整体信息(如流数量、格式类型等),是 FFmpeg 处理媒体的 “总入口”。AVStream:媒体流结构体,每个AVFormatContext包含多个AVStream(如视频流、音频流),存储流的具体信息(如解码器参数、时长等)。AVCodecContext:解码器上下文,存储解码器的详细参数(如宽高、像素格式、比特率等),是解码器的 “控制中心”。AVCodec:解码器 / 编码器结构体,封装了具体的编解码算法(如 H.264、H.265 解码器)。AVPacket:编码数据包,存储从流中读取的编码数据(如 H.264 的 NALU 单元),是解码的输入。AVFrame:原始帧结构体,存储解码后的原始数据(如 YUV/RGB 像素数据),是解码的输出。SwsContext:像素格式转换上下文,用于不同像素格式(如 YUV420P 转 RGB24)或尺寸的转换。

解码流程:

-

1. 初始化 FFmpeg 网络模块:

avformat_network_init()启用网络功能 -

2. 打开 RTSP 流

- 分配

AVFormatContext(avformat_alloc_context())。 - 调用

avformat_open_input()

- 分配

-

3. 查找流信息

调用avformat_find_stream_info(pFormatCtx, NULL)获取流的详细信息(如帧率、编码格式)。 -

4. 初始化解码器

- 从视频流

AVStream中获取解码器上下文AVCodecContext(stream->codec)。 - 查找对应解码器(

avcodec_find_decoder(pCodecCtx->codec_id))。 - 打开解码器(

avcodec_open2(pCodecCtx, pCodec, NULL))。

- 从视频流

-

5. 准备帧存储与格式转换

-

分配

AVFrame(pFrame)存储解码后的原始帧(如 YUV 格式)。 -

分配

AVFrame(pFrameRGB)存储转换后的 RGB 帧,并用av_image_alloc()分配像素缓冲区。 -

创建格式转换上下文(

sws_getContext()),指定源格式(如 YUV420P)、目标格式(RGB24)、宽高和缩放算法(如SWS_BILINEAR)。

-

-

6. 循环读取并解码帧

- 调用

av_read_frame()读取AVPacket(编码数据)。 - 过滤视频流的包(

packet.stream_index == videoStream)。 - 发送数据包到解码器(

avcodec_send_packet())。 - 接收解码后的帧(

avcodec_receive_frame())。 - 调用

sws_scale()将原始帧(YUV)转换为 RGB 帧。

- 调用

-

7. 转换为 QImage 显示

将pFrameRGB的像素数据(data[0])转换为QImage(格式QImage::Format_RGB888),用于 Qt 界面显示。 -

8. 资源释放 解码结束后,释放所有 FFmpeg 资源:

- 释放格式转换上下文(

sws_freeContext())。 - 释放帧缓冲区(

av_frame_free())。 - 关闭解码器(

avcodec_free_context())。 - 关闭流并释放格式上下文(

avformat_close_input())

- 释放格式转换上下文(

编码流程:

-

1. 初始化 FFmpeg 库

- 网络模块初始化:调用

avformat_network_init(),启用 FFmpeg 的网络功能(必需,否则无法解析 RTSP 流)。 - 注册组件:通过

avcodec_register_all()和av_register_all()注册编解码器和格式(旧版本 FFmpeg 必需,新版本可省略)。

- 网络模块初始化:调用

-

2. 打开 RTSP 输入流并解析信息

- 打开输入:调用

avformat_open_input()打开 RTSP URL(如rtsp://172.32.0.93/live/0),创建并填充输入格式上下文i_fmt_ctx。 - 解析流信息:调用

avformat_find_stream_info()读取流的详细数据(如编码格式、码率),完善i_fmt_ctx中的流信息。 - 查找视频流:遍历输入流

i_fmt_ctx->nb_streams,筛选出类型为AVMEDIA_TYPE_VIDEO的视频流,保存到i_video_stream。

- 打开输入:调用

-

3. 初始化输出上下文与输出流-

- 创建输出上下文:调用

avformat_alloc_output_context2(),根据输出文件路径(../output/1.mp4)自动推断输出格式(MP4),创建输出格式上下文o_fmt_ctx。 - 创建输出流:调用

avformat_new_stream()为输出上下文创建新的视频流o_video_stream。 - 复制流参数:通过

avcodec_parameters_copy()将输入视频流的编码参数(如宽高、像素格式、 codec_id)复制到输出流(确保输入输出编码格式一致,避免重新编码,仅做封装转换)。 - 补充输出参数:手动设置输出流的比特率(

out_codecpar->bit_rate = 400000),适配 MP4 封装要求。

- 创建输出上下文:调用

-

4. 打开输出文件并写入文件头

- 打开输出文件:调用

avio_open()打开输出文件(../output/1.mp4),绑定输出上下文的 IO 缓冲区(o_fmt_ctx->pb)。 - 写入文件头:调用

avformat_write_header(),向输出文件写入 MP4 的文件头(包含封装格式信息、流参数等,是 MP4 文件的 “元数据”)。

- 打开输出文件:调用

-

5. 循环读取 RTSP 帧并写入输出文件

- 读取编码帧:通过

av_read_frame()从 RTSP 流中读取编码数据包(AVPacket,包含 H.264/H.265 等编码数据)。 - 时间戳转换:调用

av_packet_rescale_ts()将输入流的时间戳(基于输入流的time_base)转换为输出流的时间戳(基于输出流的time_base),确保时间戳在输出流中有效。 - 时间戳修正:手动调整 PTS(显示时间戳)和 DTS(解码时间戳)

- 写入帧数据:调用

av_interleaved_write_frame()将处理后的AVPacket写入输出文件(自动处理流的交织,确保 MP4 封装顺序正确)。

- 读取编码帧:通过

-

6. 收尾与资源释放

- 写入文件尾:调用

av_write_trailer(),向输出文件写入 MP4 的文件尾(包含索引信息,确保文件可正常播放)。 - 释放资源:依次关闭输入流(

avformat_close_input())、输出文件 IO(avio_close())、释放输出上下文(av_free(o_fmt_ctx))及流资源,避免内存泄漏。

- 写入文件尾:调用

智能家居项目

C语言的面向对象编程

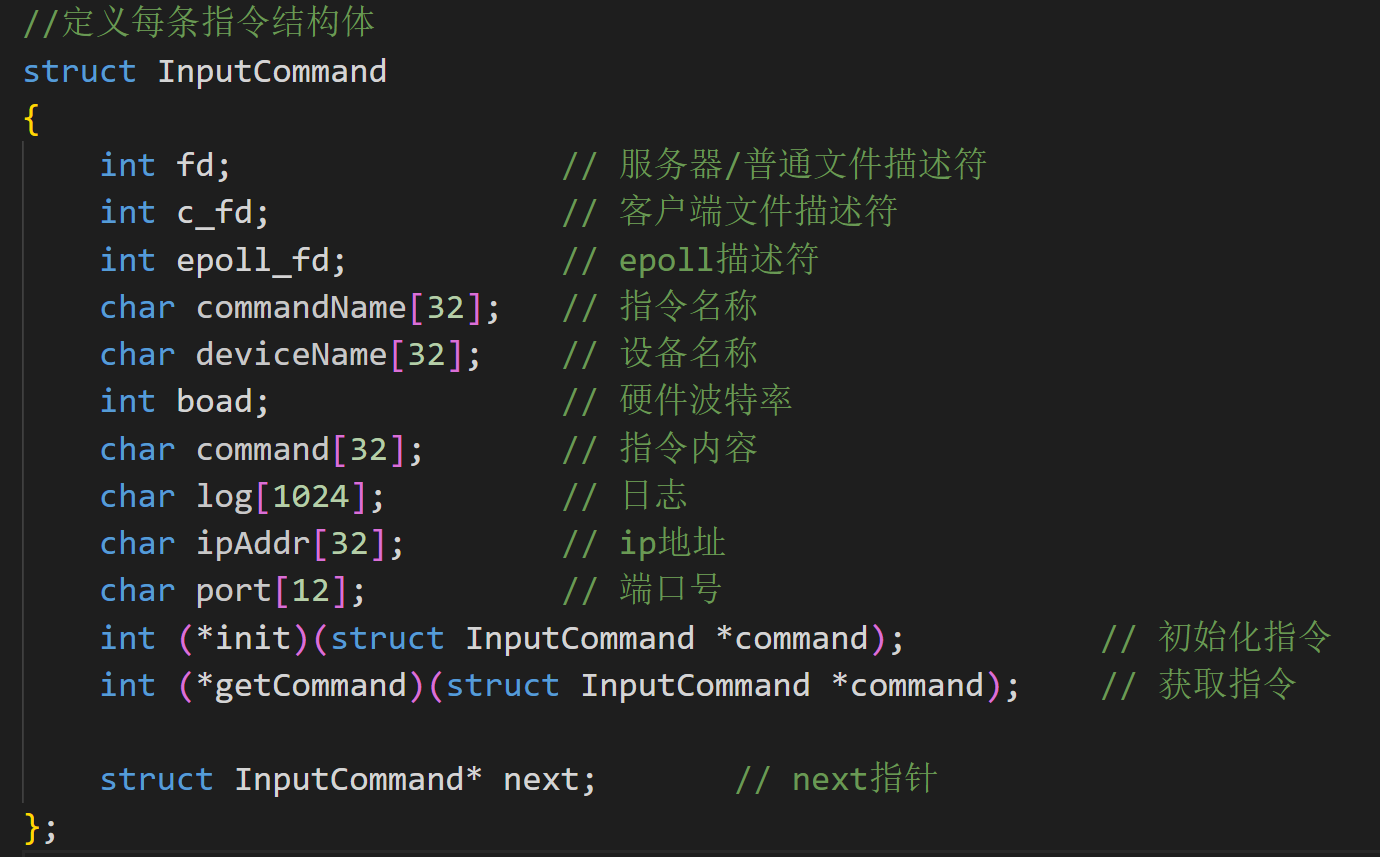

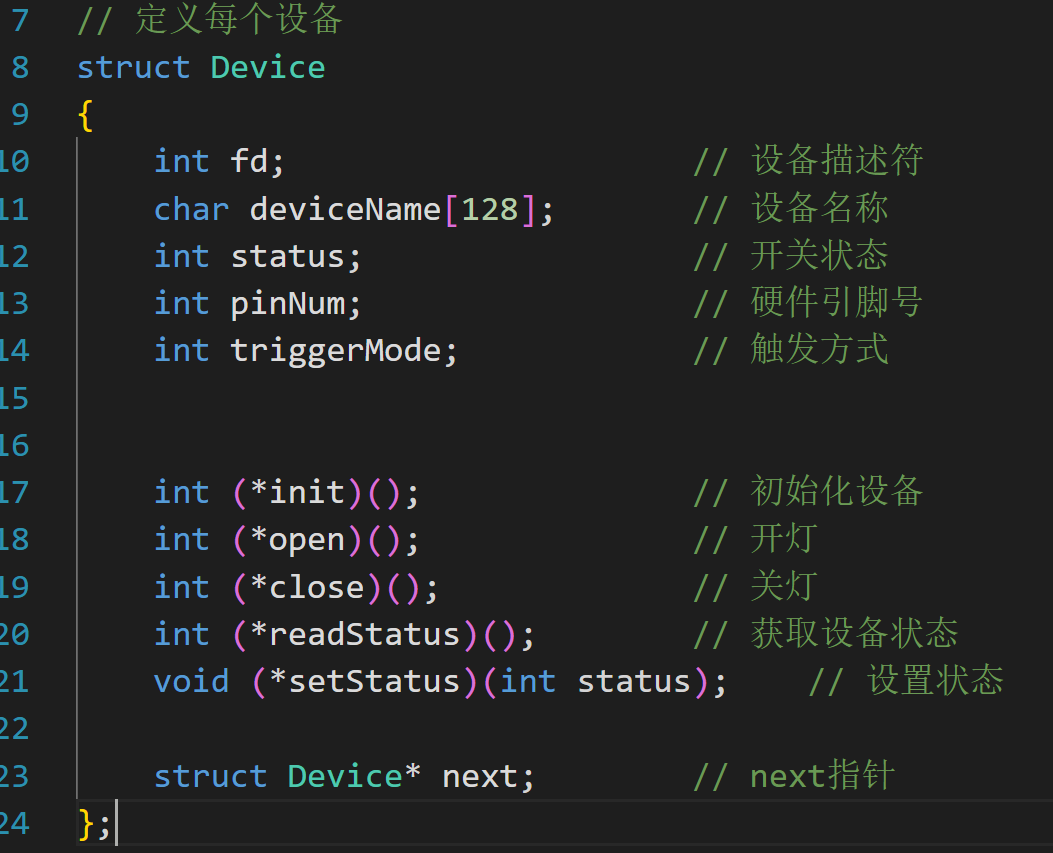

- 存在设备工厂与指令工厂,通过将每个设备的一些参数和功能进程封装成类似的类对象,通过创建实体设备,同时通过保存函数指针调用不同设备的方法

- 每个工厂中的实力通过hash_map的方式存储

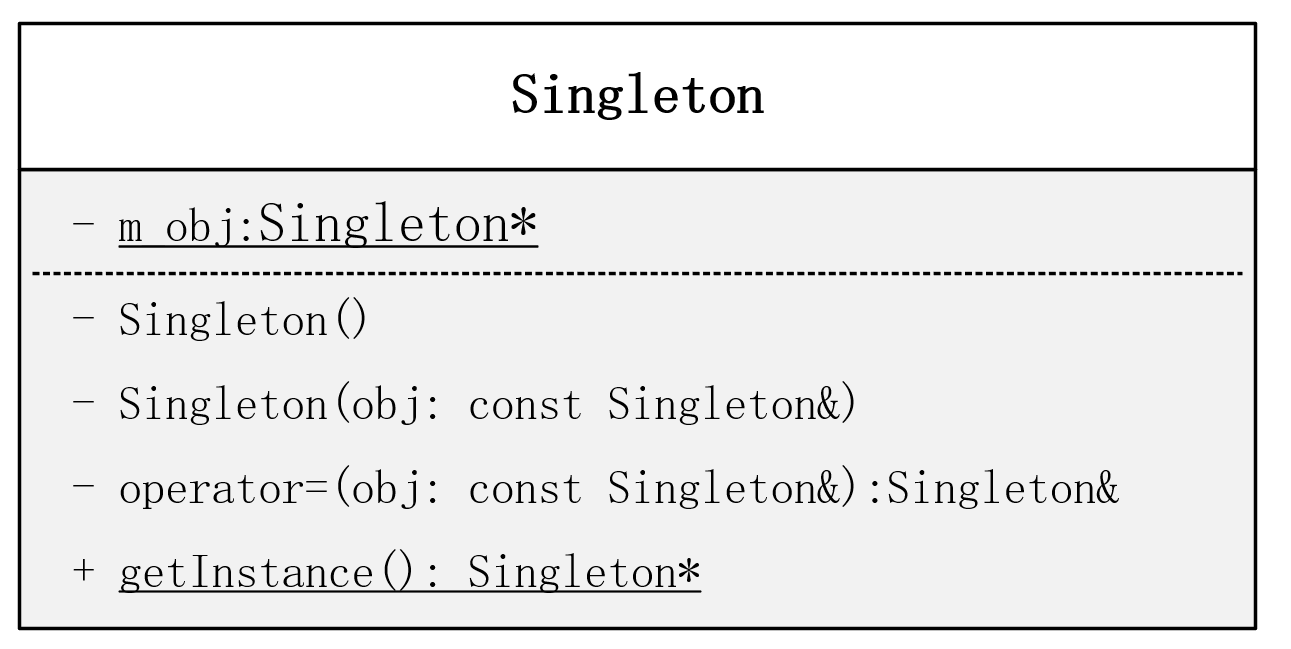

单例模式

单例模式的型号控制器,确保一个类仅有一个实例,并提供全局访问点。适用于需要全局唯一对象的场景,层次深,开销大。

-

饿汉模式就是在类加载的时候立刻进行实例化,这样就得到了一个唯一的可用对象

-

懒汉模式在类加载的时候不去创建这个唯一的实例,而是在需要使用的时候再进行实例化,相比饿汉式,节省内存空间

// 定义类的时候创建单例对象

class Singleton

{

public:// = delete 代表函数禁用, 也可以将其访问权限设置为私有Singleton(const Singleton& obj) = delete;Singleton& operator=(const Singleton& obj) = delete;// 饿汉式static Singleton* getInstance(){return m_obj;}// 懒汉式static Singleton* getInstance(){if(m_obj == nullptr)m_obj = new Singleton();return m_obj;}private:Singleton() = default; // 构造函数私有化,饿汉式构造函数不能删除,必须私有并默认static Singleton* m_obj; // 单例对象

};

// 初始化静态成员变量 懒汉式就为nullptr

Singleton* Singleton::m_obj = new Singleton;// 简化的宏定义

#define SINGLETON(Class) \private: \Class(); \~Class(); \friend class Singleton<Class>;

单例模式: 确保一个类只有一个实例,并提供一个全局访问点来访问这个唯一实例。

(1)构造函数的设计(为什么私有?除了私有还可以怎么实现(进阶)?)

- 防止外部实例化, 私有构造函数确保只有类自身能够创建实例,外部代码无法通过new关键字创建新对象,防止无意中创建多个实例,破坏单例约束。

- 采用奇异递归模板模式

-

创建基类模板,并将基类构造函数设置为保护类型,防止直接实例化

-

派生类的构造函数可以是公共或保护

-

声明基类为友元,允许基类访问派生类的构造函数

-

(2)对外接口的设计(为什么这么设计?)

- 提供一个全局访问点来访问这个实例,使用static确保这个访问是类级别的访问

(3)单例对象的设计(为什么是static?如何初始化?如何销毁?(进阶))

-

全访问点,利用static保证该访问数据类级别,由于静态成员属性只能访问静态成员变量,因此需要将成员变量的实例也设置为static

-

私有化构造函数,删除拷贝构造函数与拷贝赋值操作符重载函数,并且在类外对类的静态成员变量进行初始化

-

设置实例对象为静态局部变量,自动销毁,或者手动delete删除,或者利用智能指针管理

(4)懒汉模式和恶汉模式的实现(判空!!!加锁!!!),并且要能说明原因(为什么判空两次?)

- 恶汉模式无线程安全问题,因为一开始就创建了实例对象,多线程获取对象的时候只做返回静态成员变量

- 懒汉模式在使用的时候才创建实例对象,在多线程中存在线程安全问题,多个线程第一个进入创建实例,存在创建了多个实例的隐患,因此需要加互斥锁,保证当前只有一个线程在创建实例对象。

- 这把锁又影响了效率,这样一来只有一个线程运行,其他线程阻塞,因此需要2次判空

- 第一次判空,在大多数情况下,实例已经存在,直接返回,避免了不必要的互斥开销

- 同步互斥块:确保只有一个线程能进入创建实例的代码段

- 第二次判空:防止多个线程同时通过第一次判空后,在互斥块内重复创建实例

(5)对于C++编码者,需尤其注意C++11以后的单例模式的实现(为什么这么简化?怎么保证的(进阶))

-

静态局部变量方式

-

在C++11标准中有如下规定,并且这个操作是在编译时由编译器保证的:如果指令逻辑进入一个未被初始化的声明变量,所有并发执行应当等待该变量完成初始化。

-

双重检查锁的问题所在: 一条语句的机器指令分为3步

- 第一步:分配内存用于保存类对象。

- 第二步:在分配的内存中构造一个 类对象(初始化内存)

- 第三步:使用 对象指针指向分配的内存

该顺序可能被重排变成1,3,2,可以使用原子操作来解决,或者使用C++11以上的静态局部变量解决

hash_map

// 哈希节点(键为fd,值为结构体指针)

typedef struct HashNode {int fd; // 键:文件描述符Device* value; // 值:结构体指针struct HashNode* next; // 处理哈希冲突的链表

} HashNode;// 哈希表结构

typedef struct HashMap {HashNode** buckets; // 桶数组size_t capacity; // 容量(桶数量)size_t size; // 实际存储的键值对数量float load_factor; // 负载因子(触发扩容阈值)pthread_rwlock_t rwlock; // 读写锁

} HashMap;// 哈希函数(针对整数fd优化)

static uint64_t hash_func(int fd, size_t capacity) {// 整数哈希:简单映射避免负fd(fd通常非负,此处兼容特殊情况)uint64_t key = (uint64_t)(fd < 0 ? -fd : fd);// 乘以一个大质数减少哈希冲突key = key * 1099511628211ULL;return key % capacity;

}

| 方法 | 主要特点 | 查询效率 | 插入效率 | 空间效率 | 备注 |

|---|---|---|---|---|---|

| 线性探测 | 简单,易聚集 | 一般 | 一般 | 高 | 容易产生主聚集 |

| 平方探测 | 减少聚集 | 一般 | 一般 | 高 | 可能失败(循环) |

| 双重哈希 | 分布更好 | 较好 | 较好 | 高 | 函数设计复杂 |

| 开链法 | 插入灵活,支持扩容 | 稳定 | 稳定 | 较低 | 缓存不友好 |

| 溢出区 | 存储独立,结构分离 | 不稳定 | 不稳定 | 较低 | 很少使用 |

关于哈希

- 为什么选择哈希表而不是其他数据结构来存储设备节点?

- 通过 fd 查找设备需要 O(1) 平均时间复杂度,比红黑树的 O(log n) 更快

- 备节点主要通过 fd 访问,哈希表最适合基于键的快速查找

- 如何解决哈希冲突? 这里采用了什么策略?

- 使用链地址法(拉链法),每个桶是一个链表(hashMap中保存二级指针)

- 冲突元素通过 next 指针链接在同一桶中

- 负载因子的作用是什么?为什么设置为0.75?

- 负载因子控制扩容时机,避免过多冲突

- 0.75 是空间和时间的平衡点,冲突概率较低且内存利用率高

- 扩容时为什么要重新哈希所有元素?

- 容量变化后,哈希函数结果会改变

- 必须重新计算每个元素在新桶数组中的位置

关于性能与复杂度

- 什么情况下哈希表的性能会退化?

- 哈希函数质量差导致大量冲突

- 极端情况下退化为链表,查找复杂度变为 O(n)

- 当前实现的时间复杂度是多少?

- 查找、插入、删除:平均 O(1),最坏 O(n)

- 如果有大量设备同时连接,这个实现能应对吗?

- 能,通过动态扩容和负载因子控制,可适应大规模数据

- 扩容过程中如果内存分配失败会怎样?

- 新桶分配失败时保留原表,但可能处于不一致状态

- 为什么使用头插法插入链表?

- 实现简单,插入操作为 O(1)

关于线程安全

- 采用查找和操作分离的策略,hasp只用于查找,并且更多的用于查找,因为设置的是一个全局读写锁,适用于读多写少的场景,而且性能开销比互斥锁、分段锁小

- 内存分配失败时锁未释放,确保所有退出路径都释放锁

- 多线程同时触发扩容,添加扩容标志和双重检查(扩容标志与大小)

- 死锁解决:put调用resize_internal(不加锁函数)

- resize调用resize_internal(不加锁函数)

- 当前实现的局限性

- 所有操作都使用全局锁,可能成为性能瓶颈

- 扩容期间所有操作都会被阻塞

- 没有实现迭代器的安全遍历机制

关于实际应用

- 如果需要遍历所有设备,这个实现的效率如何?

- 效率较低,需要遍历所有桶和链表节点

- 如何处理设备断开连接的情况?

- 调用 hash_map_remove 删除对应 fd 的节点

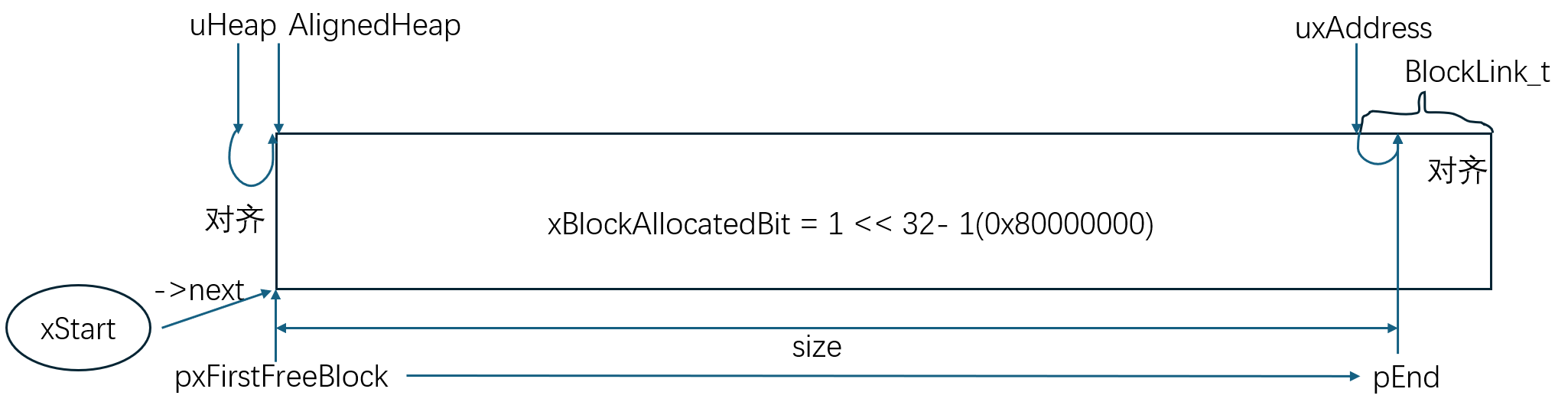

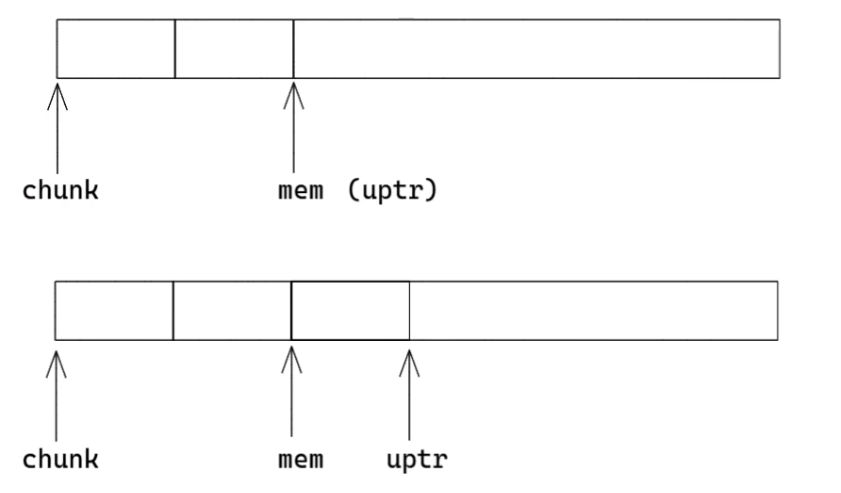

自定义堆区动态内存配置机制

设计一套基于静态内存池的自定义堆内存管理机制,主要用于嵌入式系统或实时系统场景,标准库的malloc/free存在明显缺陷:

- 依赖操作系统动态内存管理,分配 / 释放时间不确定(不符合实时系统 “确定性” 要求);

- 容易产生内存碎片(小空闲块无法合并,导致大内存请求失败);

- 可能因误操作导致堆溢出(无边界检查),且内存使用状态不可控。

1. 堆区结构体与函数指针(对象方法)

typedef struct _MY_HEAP

{void * (*malloc)(uint32_t xWantedSize); // 分配堆区内存void (*free)(void *pv); // 释放堆区内存 uint32_t(*get_free_heapsize)(void); // 获取当前可用堆大小uint32_t(*get_min_ever_free_heapsize)(void); // 获取历史最小可用堆大小

}c_my_heap;

2. 创建实体对象,并为函数指针确定指向的具体实现函数

const c_my_heap my_heap = {.malloc = my_heap_malloc,.free = my_heap_free,.get_free_heapsize = my_heap_get_free_heapsize, .get_min_ever_free_heapsize = my_heap_get_min_ever_free_heapsize

};

// 获取单例实例的函数

const c_my_heap* get_my_heap_instance(void) {return &my_heap;

}

3. 内存对齐核心变量

// 对齐字节数

#define portBYTE_ALIGNMENT 8

// 对齐字节掩码 用于内存对齐

#define portBYTE_ALIGNMENT_MASK (portBYTE_ALIGNMENT - 1)

// 对一个字节或者内存进行对齐 ******核心操作******

uint32_t address = (address + portBYTE_ALIGNMENT_MASK) & ~portBYTE_ALIGNMENT_MASK

4. 空闲内存块设计

// 定义块链接结构体

typedef struct A_BLOCK_LINK {struct A_BLOCK_LINK *pxNextFreeBlock; // 指向下一个空闲块 size_t xBlockSize; // 空闲块的大小

} BlockLink_t;// 空闲块也必须做内存对齐

static const uint32_t xHeapStructSize = (sizeof(BlockLink_t) + portBYTE_ALIGNMENT_MASK) & (~portBYTE_ALIGNMENT_MASK);// 定义一个最小块,因为后期获取的空闲内存块可能可以分成两块,即可以分割的最小块大小

#define heapMINIMUM_BLOCK_SIZE (size_t)((xHeapStructSize << 1)) // 最小块大小

5. 其他核心变量

// 内存池区域 从数组的起点地址开始维护一段 4096 字节的内存

static uint8_t ucHeap[ configTOTAL_HEAP_SIZE ];

// 空闲内存块头尾指针,都是哨兵节点

static BlockLink_t xStart, *pxEnd = NULL;// 获取 uint32_t 类型的最高位。

// 当该位在 BlockLink_t 的 xBlockSize 成员中被设置时,块属于应用程序。

// 当该位未设置时,该块仍然是自由堆空间的一部分。

static uint32_t xBlockAllocatedBit = 0; // 初始化函数中初始化为0x80000000 (1 << 31)// 记录剩余可用字节数,但不能显示内存碎片

static uint32_t xFreeBytesRemaining = 0U;

static uint32_t xMinimumEverFreeBytesRemaining = 0U;

私有函数实现

-

堆区内存初始化:

- 起始内存对齐 -> 确定头尾哨兵节点(尾指针内存对齐) -> 初始化唯一空闲内存块 -> 统计内存剩余信息 -> 初始化内存分配标记位

static void my_heap_init( void ) {BlockLink_t *pxFirstFreeBlock; // 指向第一个空闲内存块的指针uint8_t *pucAlignedHeap; // 对齐后的堆起始地址uint32_t uxAddress;uint32_t xTotalHeapSize = configTOTAL_HEAP_SIZE; // 调整后的实际可用堆大小// 1. 地址对齐开始处理uxAddress = (uint32_t)ucHeap;if ((uxAddress & portBYTE_ALIGNMENT_MASK) != 0){// (1) 先加上对齐边界减1的值, 确保跨越下一个对齐边界uxAddress += (portBYTE_ALIGNMENT - 1);// (2) 通过与操作清除低位,实现向下对齐uxAddress &= ~( (uint32_t) portBYTE_ALIGNMENT_MASK );// (3) 调整总堆大小xTotalHeapSize -= uxAddress - (uint32_t)ucHeap;}pucAlignedHeap = (uint8_t *)uxAddress;// 2. 初始化链表头尾节点:// xStart 用于持有空闲块链表的第一个元素的指针xStart.pxNextFreeBlock = (void *)pucAlignedHeap;xStart.xBlockSize = (uint32_t)0;// pxEnd 用于标记空闲块链表的结束,并插入在堆空间的末尾。uxAddress = ((uint32_t)pucAlignedHeap) + xTotalHeapSize;uxAddress -= sizeof(BlockLink_t); // 留出一块做内存对齐,并防止越界访问uxAddress &= ~( (uint32_t) portBYTE_ALIGNMENT_MASK );pxEnd = (void *)uxAddress; // 设置 pxEnd 为堆的末尾pxEnd->xBlockSize = 0; // 结束块的大小设置为0pxEnd->pxNextFreeBlock = NULL; // 下一个指针设为NULL// 3. 初始化唯一空闲块 开始时只有一个空闲块,该块的大小为整个堆空间pxFirstFreeBlock = (void *)pucAlignedHeap;pxFirstFreeBlock->xBlockSize = uxAddress - (uint32_t)pxFirstFreeBlock; // 计算空闲块大小pxFirstFreeBlock->pxNextFreeBlock = pxEnd; // 链接到结束块// 4. 初始化统计信息:仅有一个块,覆盖整个可用堆空间。xMinimumEverFreeBytesRemaining = pxFirstFreeBlock->xBlockSize; // 初始化最小可用xFreeBytesRemaining = pxFirstFreeBlock->xBlockSize; // 初始化可用字节// 5. 分配标志位初始化 uint32_t 变量中顶位的位置。xBlockAllocatedBit = ((uint32_t) 1) << ((sizeof(uint32_t) * heapBITS_PER_BYTE) - 1 ); } -

内存分配 my_heap_malloc

初始化检查 -> 参数检查 -> 调整大小(+xHeapStructSize)并对齐 -> 空闲块检查, 遍历空闲链表寻找合适块 -> 标记返回指向的内存空间,跳过 BlockLink_t 的结构体 -> 块分割处理 -> 创建新块(更新两个块的大小) -> 把新块插入到空闲块链表void *my_heap_malloc( uint32_t xWantedSize ) {BlockLink_t *pxBlock, *pxPreviousBlock, *pxNewBlockLink;void *pvReturn = NULL;// 1. 初始化检查if( pxEnd == NULL ) my_heap_init();// 2. 参数校验// 检查请求的块大小是否过大,最高位应设置为 0if( ( xWantedSize & xBlockAllocatedBit ) == 0 ) {if( xWantedSize > 0 ){// 3. 大小调整xWantedSize += xHeapStructSize; // (1) 增加块头大小// (2) 进行内存对齐处理if((xWantedSize & portBYTE_ALIGNMENT_MASK ) != 0)xWantedSize = (xWantedSize + portBYTE_ALIGNMENT_MASK) & (~portBYTE_ALIGNMENT_MASK);}// 4. 空闲内存检查: 确认有足够剩余内存if((xWantedSize > 0 ) && (xWantedSize <= xFreeBytesRemaining)){// 5. 空闲块查找:遍历空闲链表寻找合适块 // 从低地址块开始遍历链表,直到找到合适大小的块。pxPreviousBlock = &xStart;pxBlock = xStart.pxNextFreeBlock;while((pxBlock->xBlockSize < xWantedSize ) && (pxBlock->pxNextFreeBlock != NULL)){pxPreviousBlock = pxBlock;pxBlock = pxBlock->pxNextFreeBlock;}// 如果到达了结束标志,则未找到合适大小的块。if( pxBlock != pxEnd ){// 6. 标记返回指向的内存空间,跳过 BlockLink_t 的结构体pvReturn = (void *)((( uint8_t *) pxPreviousBlock->pxNextFreeBlock) + xHeapStructSize);// 此块正在被返回使用,因此必须将其从空闲块列表中移除。pxPreviousBlock->pxNextFreeBlock = pxBlock->pxNextFreeBlock;// 7. 块分割处理:如果找到的块过大,进行分割if( ( pxBlock->xBlockSize - xWantedSize ) > heapMINIMUM_BLOCK_SIZE ){// 该块要拆分为两个块。创建在请求的字节之后的新块。pxNewBlockLink = ( void * ) (((uint8_t *)pxBlock) + xWantedSize );// 更新后面一块与前面分配内存的一个块的大小pxNewBlockLink->xBlockSize = pxBlock->xBlockSize - xWantedSize;pxBlock->xBlockSize = xWantedSize;// 将新块插入空闲块列表中。 my_heap_insert_block_into_freelist( pxNewBlockLink );}// 更新剩余字节数xFreeBytesRemaining -= pxBlock->xBlockSize;if( xFreeBytesRemaining < xMinimumEverFreeBytesRemaining ){xMinimumEverFreeBytesRemaining = xFreeBytesRemaining;}// 此块正在被返回 - 它已分配并归应用程序所有,并且没有“下一个”块。 */pxBlock->xBlockSize |= xBlockAllocatedBit;pxBlock->pxNextFreeBlock = NULL; // 设置下一个块指针为 NULL}}}return pvReturn; } -

往空闲块链表中插入一个空闲块

- 找合适的位置,从头开始,找到第一个pxIterator->next > Insert的地址,Interator是Insert前面一个块的地址,这里数字当然是为了便于理解,实际的是内存对齐的

-

找到合适的空闲块插入的前一个块起始地址Interator

// 遍历链表,找到适合插入的新块位置 BlockLink_t *pxIterator = &xStart; while(pxIterator->pxNextFreeBlock < pxBlockToInsert){pxIterator = pxIterator->pxNextFreeBlock } -

前序合并

// 可能与前一个块合并 puc = (uint8_t *)pxIterator; if ((puc + pxIterator->xBlockSize) == (uint8_t *)pxBlockToInsert) {pxIterator->xBlockSize += pxBlockToInsert->xBlockSize; // 合并块pxBlockToInsert = pxIterator; // 更新插入块 } // 这里可能先与前面的块合并后继续与后续的块合并,走下面的逻辑 -

后续合并

// 可能与后一个块合并 puc = (uint8_t *)pxBlockToInsert; if ((puc + pxBlockToInsert->xBlockSize) == (uint8_t *)pxIterator->pxNextFreeBlock) {if (pxIterator->pxNextFreeBlock != pxEnd) {/* 合并两个块 */pxBlockToInsert->xBlockSize += pxIterator->pxNextFreeBlock->xBlockSize;pxBlockToInsert->pxNextFreeBlock = pxIterator->pxNextFreeBlock->pxNextFreeBlock; // 更新链表} else {pxBlockToInsert->pxNextFreeBlock = pxEnd; // 更新结束块} } // 插入新块 insert->next else {pxBlockToInsert->pxNextFreeBlock = pxIterator->pxNextFreeBlock; }

-

完整插入空闲块代码

static void my_heap_insert_block_into_freelist(BlockLink_t *pxBlockToInsert){BlockLink_t *pxIterator;uint8_t *puc;// 遍历链表,找到适合插入的新块位置pxIterator = &xStart;while(pxIterator->pxNextFreeBlock < pxBlockToInsert){pxIterator = pxIterator->pxNextFreeBlock;}// 可能与前一个块合并puc = (uint8_t *)pxIterator;if ((puc + pxIterator->xBlockSize) == (uint8_t *)pxBlockToInsert) {pxIterator->xBlockSize += pxBlockToInsert->xBlockSize; // 合并块pxBlockToInsert = pxIterator; // 更新插入块}/* 可能与后一个块合并 */puc = (uint8_t *)pxBlockToInsert;if ((puc + pxBlockToInsert->xBlockSize) == (uint8_t *)pxIterator->pxNextFreeBlock) {/* 合并两个块 */if (pxIterator->pxNextFreeBlock != pxEnd) {// 更新块大小pxBlockToInsert->xBlockSize += pxIterator->pxNextFreeBlock->xBlockSize;// 更新链表pxBlockToInsert->pxNextFreeBlock = pxIterator->pxNextFreeBlock->pxNextFreeBlock; } else {pxBlockToInsert->pxNextFreeBlock = pxEnd; // 更新结束块}} // 插入新块 insert->nextelse {pxBlockToInsert->pxNextFreeBlock = pxIterator->pxNextFreeBlock;}// 如果未发生合并,插入块 前面连接 insertif (pxIterator != pxBlockToInsert) {pxIterator->pxNextFreeBlock = pxBlockToInsert;}} -

内存释放

void my_heap_free( void *pv ) {uint8_t *puc = ( uint8_t * ) pv;BlockLink_t *pxLink;if( pv != NULL ){/* 被释放的内存会在它前面有一个 BlockLink_t 结构。 */puc -= xHeapStructSize;if( ( pxLink->xBlockSize & xBlockAllocatedBit ) != 0 ){/* 该块正在返回给堆 - 它不再属于已分配块。 */pxLink->xBlockSize &= ~xBlockAllocatedBit;/* 将该块添加到空闲块列表。 */xFreeBytesRemaining += pxLink->xBlockSize;my_heap_insert_block_into_freelist( ( ( BlockLink_t * ) pxLink ) );}} }

结合代码细节,该实现的核心优势如下:

- 内存使用可控

- 堆大小由

configTOTAL_HEAP_SIZE固定(基于静态数组ucHeap),避免堆无限制增长导致的内存溢出; - 通过

xFreeBytesRemaining和xMinimumEverFreeBytesRemaining跟踪内存使用,便于调试和资源监控。

- 堆大小由

- 分配效率与确定性

- 基于链表管理空闲块,遍历和插入操作逻辑简单,避免标准库复杂的系统调用开销;

- 分配 / 释放时间可预测(无复杂算法),符合实时系统对 “操作耗时固定” 的要求。

- 减少内存碎片

- 释放内存时通过

my_heap_insert_block_into_freelist实现双向合并(与前 / 后空闲块合并),减少外部碎片; - 分配时若空闲块过大,会拆分出多余部分重新加入空闲链表(

pxNewBlockLink逻辑),提高内存利用率。

- 释放内存时通过

- 适配硬件要求

- 强制内存对齐(

portBYTE_ALIGNMENT处理),确保分配的内存地址符合硬件访问要求(如某些 CPU 需 4 字节 / 8 字节对齐); - 无动态内存依赖(基于静态数组),适合无操作系统或资源受限的嵌入式芯片(如 MCU)。

- 强制内存对齐(

- 可维护性与安全性

- 封装为单例模式(

c_my_heap结构体),避免多实例冲突,便于全局管理; - 通过

xBlockAllocatedBit标记块是否分配,防止重复释放或非法访问。

- 封装为单例模式(

常见问题与解答

1. 为什么不使用标准库的malloc/free,而要自定义堆管理?

- 标准库

malloc/free分配时间不确定(依赖系统内存管理策略),不适合实时系统; - 容易产生内存碎片,且无法控制堆大小(可能溢出到其他内存区域);

- 嵌入式系统资源有限(如小容量 RAM),自定义堆可基于静态数组固定大小,避免内存滥用。

2. 内存对齐是如何实现的?为什么需要内存对齐?

- 通过

(xWantedSize + portBYTE_ALIGNMENT_MASK) & (~portBYTE_ALIGNMENT_MASK)调整大小,通过uxAddress &= ~portBYTE_ALIGNMENT_MASK调整地址,确保满足portBYTE_ALIGNMENT对齐要求; - 原因:硬件限制(如 CPU 访问非对齐地址可能报错或性能下降),同时保证

BlockLink_t结构体成员(如指针)的正确访问。

3. 如何处理内存碎片?代码中具体做了哪些操作?

- 主要通过空闲块合并解决外部碎片:

- 释放内存时,

my_heap_insert_block_into_freelist先检查前序块(pxIterator)是否相邻,若相邻则合并; - 再检查后序块(

pxIterator->pxNextFreeBlock)是否相邻,若相邻则合并;

- 释放内存时,

- 分配时若空闲块过大(剩余空间 > 最小块大小

heapMINIMUM_BLOCK_SIZE),会拆分出多余部分重新加入空闲链表,避免大空闲块被浪费。

4. 代码中用链表管理空闲块,为什么选择链表而不是其他数据结构(如树)

- 嵌入式系统对内存和计算资源敏感,链表实现简单(仅需指针和大小字段),内存开销小;

- 代码中空闲块按地址有序排列(遍历插入时保证

pxIterator->pxNextFreeBlock < pxBlockToInsert),线性遍历即可满足需求,无需更复杂的树结构(如二叉树); - 实时系统更关注 “确定性” 而非极致性能,链表的固定操作耗时更符合要求。

5. 堆初始化(my_heap_init)主要做了哪些工作?

- 地址对齐:调整

ucHeap的起始地址,确保满足对齐要求; - 初始化链表:创建哨兵节点

xStart和pxEnd,将整个ucHeap初始化为一个大空闲块,加入链表; - 初始化统计信息:设置

xFreeBytesRemaining(初始为总大小)和xMinimumEverFreeBytesRemaining(跟踪最小剩余内存); - 初始化分配标志位:计算

xBlockAllocatedBit(uint32_t的最高位)。

6.xBlockAllocatedBit的作用是什么?如何避免重复释放?

- 作用:

xBlockAllocatedBit是xBlockSize的最高位,用于标记块是否被分配(置位表示已分配,清零表示空闲); - 避免重复释放:

my_heap_free中先检查(pxLink->xBlockSize & xBlockAllocatedBit) != 0,仅当块处于 “已分配” 状态时才执行释放,防止重复释放导致的链表错乱。

7. 代码是否支持多线程?若不支持,如何改进?

- 不支持。当前代码无互斥机制,多线程同时调用

my_heap_malloc或my_heap_free可能导致链表指针错乱(如同时修改pxNextFreeBlock); - 改进:添加互斥锁(如嵌入式中的

vTaskSuspendAll/xTaskResumeAll,或 POSIX 的pthread_mutex),确保内存操作的原子性。

8. xStart是BlockLink_t变量而非指针,为什么这样设计?

- xStart是哨兵节点(dummy node),作为空闲链表的固定头部,简化链表操作:

- 遍历从

&xStart开始,无需判断 “头指针是否为 NULL”(避免空指针检查); - 插入新块时,

pxIterator从xStart开始遍历,确保总能找到前序节点,统一处理边界情况(如链表为空时)。

epoll并发服务器

为什么在 “多连接少活跃” 场景下选择 epoll 而不是 select/poll?

- select/poll 采用 “轮询” 机制,每次需遍历所有注册的文件描述符(fd),时间复杂度为 O (n),连接数增多时效率急剧下降;

- epoll 基于 “事件通知” 机制,通过红黑树管理注册的 fd(O (1) 增删),就绪事件通过就绪链表返回(仅遍历活跃 fd),时间复杂度为 O (1),适合多连接但活跃少的场景;

- 此外,select 有 fd 数量上限(受限于 FD_SETSIZE),而 epoll 无此限制(仅受系统内存限制)。

触发方式,你用了什么,为什么

-

水平触发 模式:只要 fd 缓冲区有数据未读,就会持续触发 EPOLLIN 事件;

-

边缘触发 模式:仅在 fd 状态由 “无数据” 变为 “有数据” 时触发一次 EPOLLIN 事件(需一次性读完所有数据,否则可能丢失事件);

-

多连接少活跃场景使用水平触发 模式:因为活跃连接少,LT 的 “重复通知” 不会带来明显性能损耗,且编程更简单(无需处理 “一次性读完” 的逻辑,减少漏读风险);边缘触发 适合高活跃场景,但需更复杂的读写逻辑(如循环读直到 EAGAIN)。

epoll如何管理多连接,接入流程是什么

-

流程:创建监听 socket(socket ())→ 绑定端口(bind ())→ 监听(listen ())→ 创建 epoll 实例(epoll_create ())→ 将监听 socket 注册到 epoll(epoll_ctl (EPOLL_CTL_ADD, EPOLLIN))→ 进入事件循环(epoll_wait ());

-

新连接处理:当监听 socket 触发 EPOLLIN 事件时,调用 accept () 获取新连接的 fd,设置新 fd 为非阻塞(避免 IO 阻塞),将其注册到 epoll(关注 EPOLLIN 事件),并为该连接分配环形缓冲区等资源。

如何避免 epoll 的 “惊群效应”?

-

惊群效应指多个线程阻塞在 epoll_wait () 时**,一个事件触发会唤醒所有线程**,但最终只有一个线程处理,导致资源浪费;

-

单线程处理 epoll 事件(适合多连接少活跃场景,避免线程切换开销);

-

若用多线程,可通过 “EPOLLONESHOT” 标记:事件触发后自动禁用该 fd 的事件通知,处理完后重新启用,确保一个事件仅被一个线程处理。

如何管理每个连接的状态?连接超时如何检测和处理?

- 连接状态管理:为每个连接维护结构体(包含 fd、环形缓冲区、最后活跃时间、状态(连接中 / 关闭中)等),用哈希表(fd→连接结构体)快速索引;

- 超时检测:

- 定期轮询(如每隔 10 秒遍历所有连接,检查最后活跃时间与当前时间差,超过阈值则关闭);

- 结合 epoll 的 EPOLLRDHUP 事件检测对方主动关闭,避免僵尸连接;

- **处理流程:**超时连接→从 epoll 中移除(epoll_ctl (EPOLL_CTL_DEL))→关闭 fd→释放环形缓冲区和连接结构体资源。

区分 “新连接事件” 和 “已连接的 IO 事件”?如何处理读写事件?

- 区分事件:监听 socket 的 fd 是固定的,事件循环中通过 fd 是否为监听 fd 判断:是则处理新连接(accept ()),否则处理已连接的 IO 事件;

- 读事件(EPOLLIN):从 fd 读取数据到环形缓冲区,调用粘包解析逻辑提取完整数据包,交给业务层处理;

- 写事件(EPOLLOUT):仅在有数据待发送时注册(避免空轮询),从发送缓冲区写数据到 fd,写完后取消 EPOLLOUT 注册。

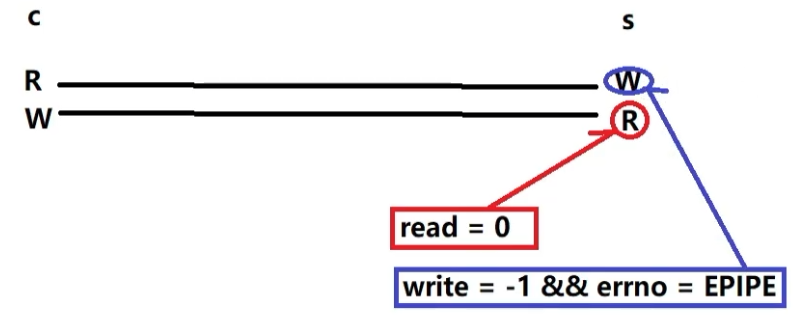

如何处理 “连接断开” 的情况?如何避免资源泄漏?

- 断开检测:通过 read () 返回 0(正常断开)或 - 1 且 errno 为 ECONNRESET(异常断开)判断;

- 处理流程:

- 从 epoll 中删除该 fd(epoll_ctl (EPOLL_CTL_DEL));

- 关闭 fd(close ());

- 释放环形缓冲区、连接结构体等资源;

- 从哈希表中移除该连接的索引,避免后续操作访问无效指针。

如何优化 epoll 的性能?(如减少系统调用、降低开销)

- 减少 epoll_ctl 调用:连接建立后尽量不频繁修改事件(如用 EPOLLONESHOT 时仅在处理完事件后重新启用);

- 合理设置 epoll_wait 超时时间:避免无限阻塞(便于处理定时任务,如超时检测);

- 使用非阻塞 IO:所有 socket(监听和连接)设为非阻塞(fcntl (F_SETFL, O_NONBLOCK)),避免 IO 操作阻塞事件循环;

- 批量处理事件:epoll_wait 返回的事件列表一次性处理,减少循环次数。

如果场景变为 “多连接高活跃”,你的框架需要做哪些调整?

- 触发模式:从 LT 改为 ET(减少重复通知,降低 CPU 开销),需实现 “循环读直到 EAGAIN” 的逻辑;

- 多线程:引入线程池,将数据包处理任务分发到业务线程(IO 线程仅负责读写,避免阻塞);

- 缓冲区:增大环形缓冲区大小,或引入动态扩容机制;

- 负载均衡:若单机压力过大,可引入多机分布式架构(如用 Nginx 代理 TCP 连接)。

环形缓冲区与粘包问题

TCP 粘包 / 半包的原因是什么?如何通过环形缓冲区解决?

-

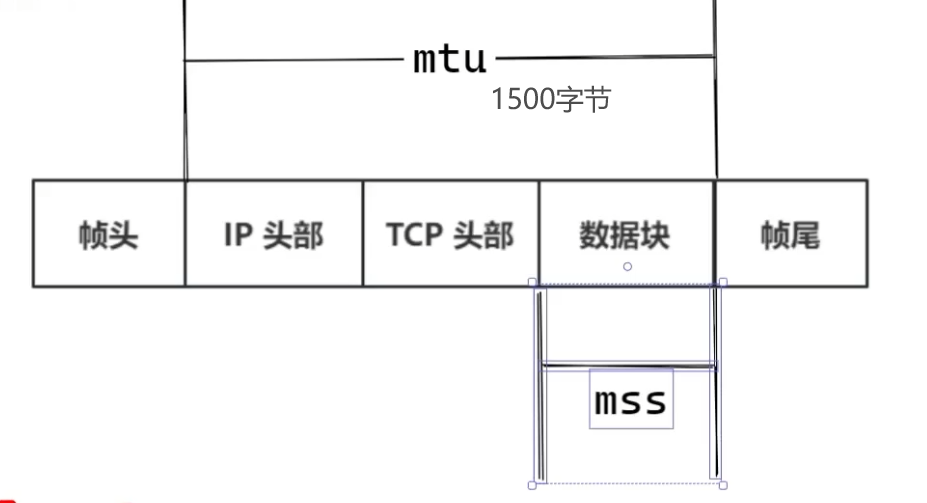

粘包原因:TCP 是 “流协议”,无消息边界,数据会按 MTU(数据链路层规定的帧大小) / 滑动窗口拆分或合并发送(如连续小数据包合并,或大数据包拆分);

-

环形缓冲区作用:暂存读取的字节流,通过 “数据包解析逻辑” 从缓冲区中提取完整消息;

-

解决流程:

- 读取数据到环形缓冲区(保证数据不丢失);

- 按协议格式(如 “头部 + 长度”)解析缓冲区:先读头部获取包长度,判断缓冲区数据是否足够;

- 若数据足够,提取完整数据包并处理;若不足,等待下一次数据到来后继续解析。

环形缓冲区的核心结构是什么?如何实现 “环形”(避免内存碎片)?

-

核心结构:固定大小的数组(或内存块)+ 读指针(read_idx)+ 写指针(write_idx)+ 缓冲区大小(size);

-

环形实现:通过 “取模运算” 让指针在到达末尾后回到起点(如

write_idx = (write_idx + 1) % size); -

空 / 满判断:

- 空:

read_idx == write_idx; - 满:

(write_idx + 1) % size == read_idx(预留一个空位置区分空和满)。

- 空:

环形缓冲区满了怎么办?如何设置缓冲区大小?

- 缓冲区满时策略:

- 丢弃新数据(适合非核心场景,需记录丢弃计数用于监控);

- 阻塞等待(不适合非阻塞 IO 框架,会导致线程挂起);

- 动态扩容 括1次,设置最大容器大小(环形缓冲区通常固定大小,扩容需拷贝数据,适合低频扩容场景);

- 大小设置:根据业务平均包大小和最大并发连接数估算,例如:若单连接最大包为 16KB,并发 1000 连接,单个缓冲区可设为 32KB(留冗余),总内存可控。

环形缓冲区如何保证线程安全

- 若单线程处理 epoll 事件(读写同一连接的缓冲区),无需加锁(线程内串行);

- 若多线程(如 IO 线程读缓冲区,业务线程写缓冲区),需轻量级同步:

- 用互斥锁(mutex)保护读写指针;

- 或用原子操作(atomic)标记指针状态(如 CAS 操作更新读写位置);

- 避免用重量级锁,否则可能抵消 epoll 的性能优势。

环形缓冲区在高并发下可能出现什么问题?如何优化?

- 可能问题:读写指针竞争(多线程下锁开销)、缓冲区过小导致频繁丢弃数据、内存拷贝过多;

- 优化:

- 单线程读写(IO 线程内处理,避免锁);

- 预分配足够大的缓冲区(根据业务峰值估算);

- 减少拷贝:用分散读(readv)直接将数据读入缓冲区,避免中间缓冲区;

- 对齐内存:缓冲区大小设为 2 的幂次,用位运算替代取模(

idx % size→idx & (size-1)),提高运算效率。

除了环形缓冲区,还有哪些解决粘包的方案?它们的优缺点是什么?

- 固定长度:每个数据包大小固定,不足补空。优点:解析简单;缺点:灵活性差(不适合动态长度数据),空间浪费。

- 分隔符:用特殊字符(如 ‘\r\n’)标记包结束。优点:实现简单;缺点:需避免数据中包含分隔符(需转义,增加复杂度)。

- 头部 + 长度:数据包前加固定长度的头部(含数据长度)。优点:灵活支持任意长度数据;缺点:需先读头部再读数据(两次解析),环形缓冲区可优化此流程(一次读入后解析)。

xv6操作系统内核

系统调用

alarm 系统调用

- 添加新的系统调用

- 保存 sigalarm 的报警间隔与 handler 指针,保存在 struct proc 中新的字段,并在proc.c中allocproc初始化字段

sys_sigalarm:

获取用户参数

argint(0, &ticks);

argaddr(1, &handler);

// 保存参数

p->ticks = ticks;

p->handler = handler;

p->ticks_count = 0;sys_sigreturn:

p->is_handling = 0; 清空中断标记位

memmove(p->trapframe, p->save_trap_frame, PGSIZE); 中断返回 保存现场的地址

页表

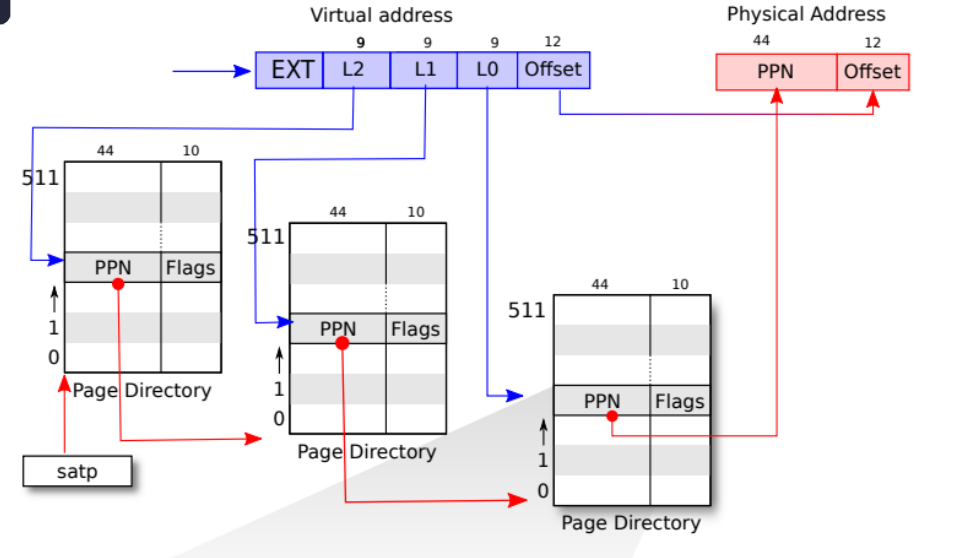

页表(Page Table)是操作系统中用于实现虚拟内存管理的核心数据结构,它负责将进程的虚拟地址(Virtual Address)转换为实际的物理地址(Physical Address)。通过分页机制,操作系统能够更高效、安全地管理内存资源。

1. 页表的核心作用

- 地址映射: 每个进程“看到”的是一个连续的虚拟地址空间(如0x0000 ~ 0xFFFF)。实际上,物理内存可能分散且不连续。页表记录了 虚拟页号 → 物理页框号 的映射关系,由CPU的 内存管理单元(MMU) 自动完成地址转换。

- 内存保护: 页表中的每个条目(页表项)包含权限标志位,如:

- 简化内存管理: 以分页的方式管理内存,支持动态内存分配和释放。当某个虚拟页未在物理内存中时,触发触发缺页中断(Page Fault),操作系统会从磁盘(如Swap分区)加载所需页面到内存,并更新页表。这使得物理内存成为磁盘的缓存,突破了内存容量限制。

- 实现虚拟内存: 页表是虚拟内存管理的基础支持。借助页表,操作系统能够将程序需要的内存部分保存在磁盘上(例如交换空间),并在需要时动态加载到内存中,从而使得程序可以使用更大的内存空间,提升系统的扩展能力和性能。

虚拟内存和物理内存通常被划分为固定大小的块,称为“页”(Page)和 “页框号”(Frame)。每个页面由相同数量的连续字节组成,常见的页面大小有4KB、8KB等。

页表的结构: 页表主要包含每个 虚拟页号(VPN) 对应的 物理页框号(PPN)

地址转换过程: 在访问内存时 ,CPU会将虚拟地址划分为页号和页内偏移(offset),具体步骤如下:

- 获取虚拟页号: 从虚拟地址中提取页号部分。

- 查找页表: 使用虚拟页号查询相应的页表项,获取物理页框号。

- 构建物理地址: 将物理页框号与原虚拟地址中的页内偏移结合,生成物理地址,访问实际的内存。

- 页表page table: 记录从VPN→PPN的映射关系表

- 页表项 PTE: 页表中的每一项,具体内容如上述中的解释

- 虚拟页号VPN: virtual page number

- 物理页号PPN/PFN: physical page number

- 页内偏移量offset: 偏移量的位数决定了一页的大小,一般是12位,即4KB

- 虚拟地址va: virtual address相当于VPN与offset的组合

- 物理地址pa: physical address相当于PFN/PPN与offset的组合

- 物理页帧: page frame

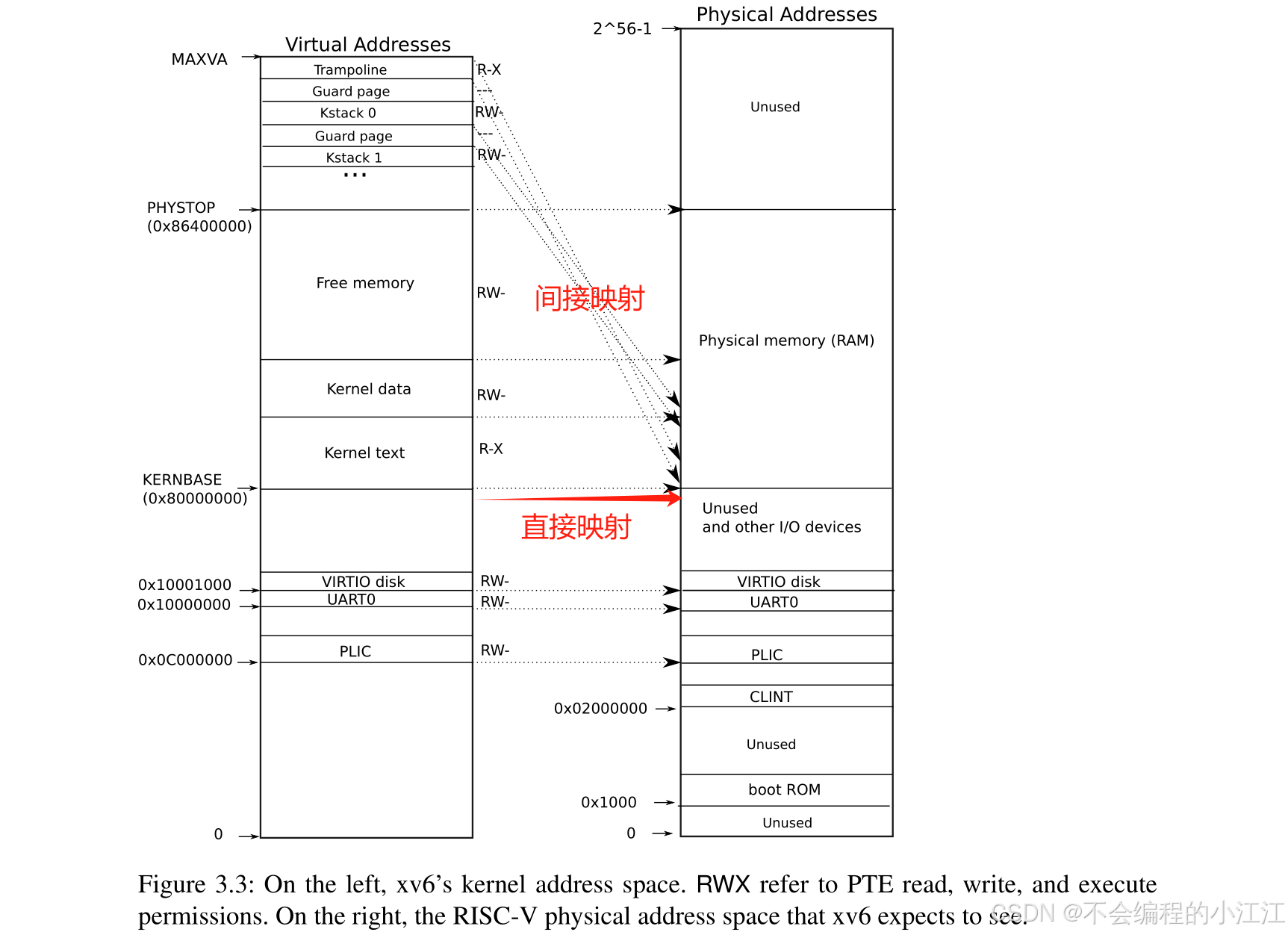

一、为每个进程分配一个页表

当前xv6操作系统中,在用户态下的每个用户进程都使用各自的用户态页表。一旦进入了内核态(例如系统调用)就会切换到内核态页表。然而这个内核态页表是全局共享的。如果一个进程因为 bug 或恶意操作访问了内核中的敏感数据,它可能会影响其他进程或系统的整体稳定性。

- 创建内核页表: 普通进程也可以通过调用 kvm_map_pagetble 函数来创建自己的内核页表了,此时在内核态中就有两种页表:一种是内核进程独享的页表,另一种是其他进程各自独享的页表

- 重映射内核栈: 原本的 xv6 设计中,所有处于内核态的进程都共享同一个页表,即意味着共享同一个地址空间。由于 xv6 支持多核/多进程调度,同一时间可能会有多个进程处于内核态,所以需要对所有处于内核态的进程创建其独立的内核态内的栈,也就是内核栈,供给其内核态代码执行过程。

- 在已经添加的新修改中,每一个进程都会有自己独立的内核页表。而现在需要每个进程只访问自己的内核栈,所以可以把每个进程的内核栈映射到各自内核页表的固定位置(不同页表内的同一逻辑地址,指向不同物理内存)

- 资源释放: 先释放进程的内核栈,再释放进程的内核页表。这里不能使用 proc_freepagetable 函数直接释放页表,因为该函数会释放掉内核进程必要的映射,导致内核崩溃。这里释放的只是内核页表中的所有映射,不释放其指向的物理页。 因为物理页的资源不是这一个进程独享的

二、简化copyin / copyinstr:将用户页表中的映射同步到每个进程的内核页表中。这样,内核可以直接使用硬件页表机制来访问用户空间的内存,而不需要手动解析页表。

- 页表复制和缩减内存函数: 首先在 kernel/vm.c 实现一个复制页表函数,将 src 页表的一部分页映射关系拷贝到 dst 页表中。只拷贝页表项, 不拷贝实际的物理页内存

- 处理内存映射捏的冲突

- 用户态页表修改,同步数据到内核页表

惰性分配与缺页

- 缺页异常:应该是指操作系统在分配内存时不会立即分配物理内存,仅分配虚拟地址空间,不分配物理页。

惰性机制优点: 应用程序往往请求比实际需要更多的内存,通过性分配,系统仅在真正使用内存时才进行分配,避免了大量内存浪费

当出现缺页异常,需调入新页面内存已满时,选择被置换的物理页面,也就是说选择⼀个物理页面换出到磁盘,然后把需要访问的页面换入到物理页。

- 引起page fault的内存地址 STVAL寄存器

- 引起page fault的原因类型 SCAUSE寄存器

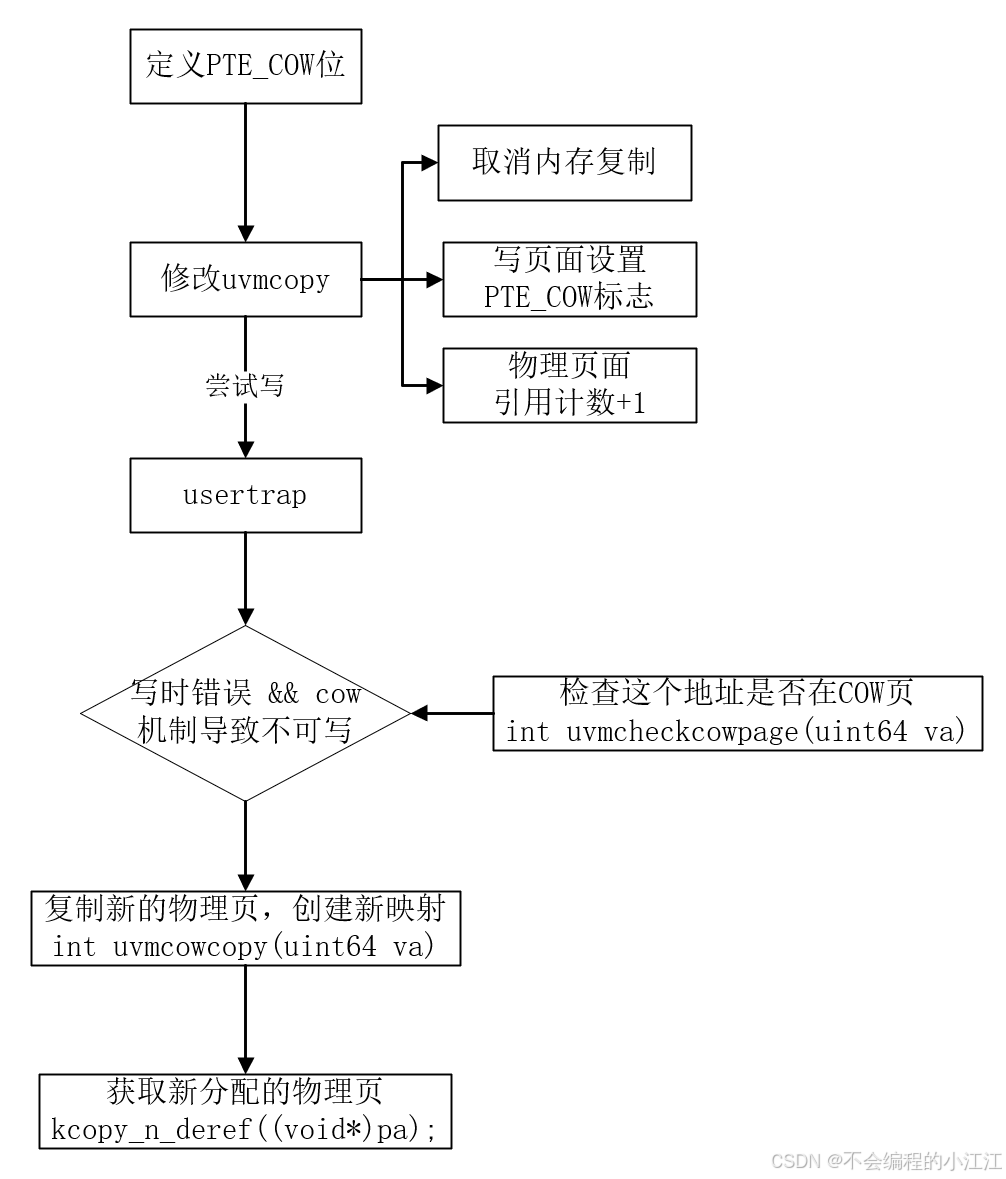

写时拷贝

在原始的XV6中,fork函数是通过直接对进程的地址空间完整地复制一份来实现的。但是,拷贝整个地址空间是十分耗时的,并且在很多情况下,程序立即调用 exec 函数来替换掉地址空间,导致 fork 做了很多无用功。

该实验的改进:

- COW fork() 为子进程创建一个页表,让子进程和父进程都一起映射到父进程的物理页

- 禁止写权限,因为一旦子进程想要修改这些内存的内容,相应的更新应该对父进程不可见,因此需要将这里的父进程和子进程的PTE的标志位都设置成只读的

- 当任一进程试图写入其中一个COW页时,CPU将强制产生页面错误。内核页面错误处理程序检测到这种情况,将为出错进程分配一页物理内存,将原始页复制到新页中,并修改出错进程中的相关PTE指向新的页面,将PTE标记为可写。

大文件与软链接

xv6文件系统层次: 从上至下分别为 文件描述符、路径名、目标、索引节点、日志、缓冲区高速缓存、磁盘

索引节点 inode:

-

type字段: 文件类型,表明inode是文件还是目录

-

nlink字段:,也就是link计数器,用来跟踪究竟有多少文件名指向了当前的inode

-

size字段: 文件大小。表明了文件数据有多少个字节

-

12个直接块编号,这些直接块编号直接指向文件的前 12 个磁盘块。当文件较小时,直接块可以满足文件存储的需求,每个块的大小在 xv6 中是 1KB,因此使用 12 个直接块意味着最多可以存储 12*1KB=12KB 的数据

-

1个间接块编号,指向一个间接块,间接块本身是一个磁盘块,其中包含了 256 个条目,每个条目存储一个数据块编号,这些编号依次指向文件的数据块

添加二级链接块,实现超大文件存储

-

修改 inode 的结构:,修改成11个直接块,1个一级间接块,1个二级间接块。

-

修改逻辑块号与物理块号的映射: 原xv6文件系统中逻辑块号与物理块号的映射关系: 先判断逻辑块号与直接映射的物理块号来确定是否为直接映射,若否则建立间接映射

-

释放节点映射的所有数据块

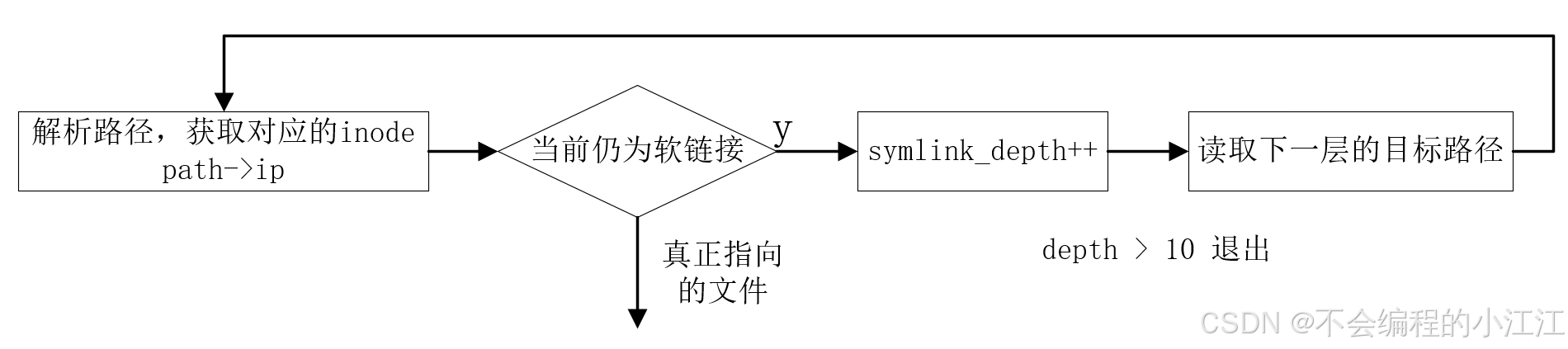

软链接设计 设计一个软链接系统调用

- 实现具体的 sys_symlink: 使用 create 创建一个加了锁的指向源文件的inode,再将链接目标文件地址通过 writei 写入inode,操作完之后使用 iunlockput 解锁创建的inode并使其引用计数-1,表示创建软链接的操作结束,释放锁。

- 修改

sys_open函数,通过循环调用 namei 获取对应的inode,如果指向的仍是软链接,就继续循环读取,直到找到真正指向的文件,或者超过了一定的链接深度

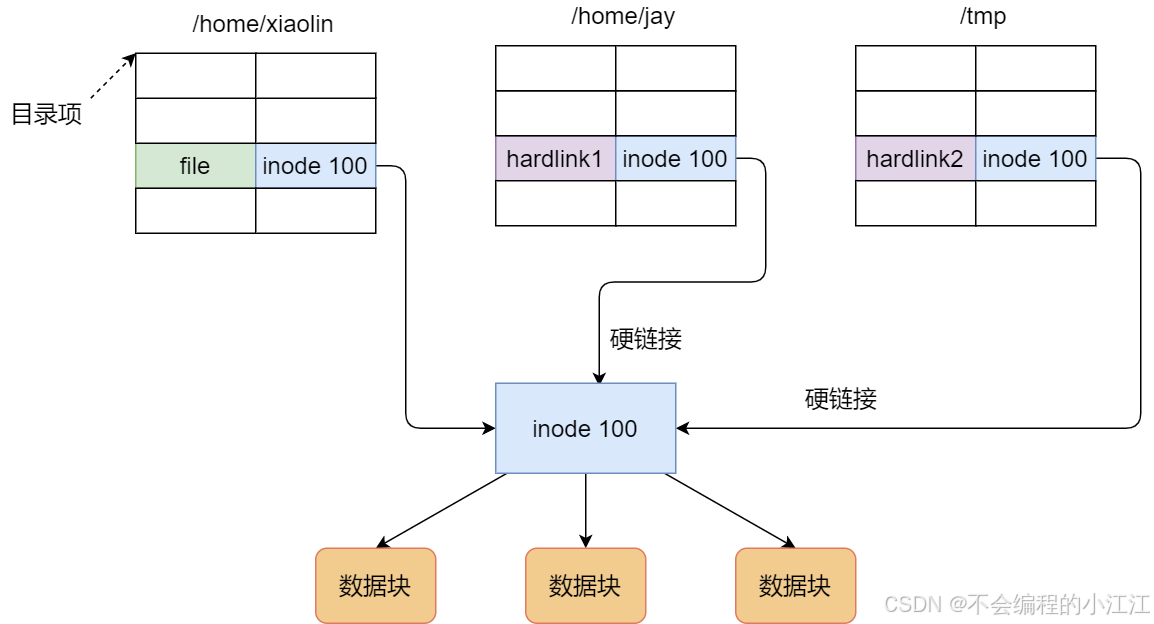

硬链接 多个目录项中的**「索引节点」指向一个文件,也就是指向同一个 inode**,但是 inode 是不可能跨越文件系统的,每个文件系统都有各自的 inode 数据结构和列表,所以硬链接是不可用于跨文件系统的。由于多个目录项都是指向一个 inode,那么只有删除文件的所有硬链接以及源文件时,系统才会彻底删除该文件。

软链接 相当于重新创建一个文件,这个文件有独立的inode,但是这个文件的内容是另外一个文件的路径,所以访问软链接的时候,实际上相当于访问到了另外一个文件,所以软链接是可以跨文件系统的,其目标文件被删除了,链接文件还是在的,只不过指向的文件找不到了而已

线程切换实现用户态协程

- 设计用户级线程系统的上下文切换机制,设计一个方法来创建线程,并保存/恢复寄存器以在线程之间切换,

- 添加线程切换上下文数据类型: 上下文结构体寄存器,成员变量-上下文,定义用户线程切换uthread_switch.S中进行保存上下文,恢复上下文

- 汇编thread_switch函数实现保存上下文寄存器

- 在线程切换时候,通过uthread_switch函数切换到汇编,进行上下文切换

1. 添加线程换上下文数据类型(这里的操作模仿进程的context结构体)

-

定义线程上下文结构体寄存器

-

定义线程结构体成员变量-上下文,

-

定义用户线程切换uthread_switch.S中进行保存上下文,恢复上下文

-

定义上下文数据结构

// 用户线程的上下文结构体 struct context {uint64 ra; // return addressuint64 sp; // 栈指针// callee-saveduint64 s0;uint64 s1; }; -

添加上下文至线程成员变量

struct thread {struct context context; // 添加成员变量char stack[STACK_SIZE]; /* the thread's stack */int state; /* FREE, RUNNING, RUNNABLE */ }; -

汇编

thread_switch函数实现保存上下文寄存器thread_switch:/* YOUR CODE HERE */sd ra, 0(a0)sd sp, 8(a0)sd s0, 16(a0)sd s1, 24(a0)ret /* return to ra */

2. 在线程切换时候,通过uthread_switch函数切换到汇编,进行上下文切换: uthread.c / thread_schedule函数

thread_switch(&t->context, &next_thread->context);

if (current_thread != next_thread) { /* switch threads? */next_thread->state = RUNNING;t = current_thread;current_thread = next_thread;// 上下文切换thread_switch(&t->context, &next_thread->context);} elsenext_thread = 0;

3. 创建线程时,初始化线程

// 返回地址, thread_switch线程切换执行完后返回到ra,

// 设置成线程函数func, 就可以切换后执行func

t->context.ra = (uint64)func;

// 栈指针,将线程的栈指针指向其独立的栈,

// 栈的生长是从高地址到低地址,所以要将 sp 设置为指向 stack 的最高地址

t->context.sp = (uint64)t->stack + STACK_SIZE;

C语言

指针 数组 函数 常量

- 数组指针: 数组指针是指向数组的指针变量

int (*p)[5] - 指针数组: 指针数组是一个数组,数组的元素都是指针

int *p[5] - 指针函数: 指针函数是一种返回指针类型的函数,记得malloc

- 函数指针: 函数指针是指向函数的指针变量

void (*p)(Devide *) - 指针与数组名的区别:

- 本质不同: 变量,地址常量

- sizeof大小不同

- 运算不同

- 作为函数参数时的行为

- 取地址(&)行为不同

- 指针常量: 指针常量其实就是一个常量,他的地址是不可的,即指向的对象是不变的,但指向的对象的内容是可变的,因为在指针名前面加上了一个const,地址是个常量

int* const ptr; - **常量指针: ** 指常量指针就是一个指针,常量指的是指针的所指内容。

const int* ptr,但指针可以指向其他不同的常量对象

大端序、小端序

- 大端序: 数据的高位字节存在内存的低地址,数据的低位字节存在内存的高地址

- 小端序: 数据的低位字节存在内存的低地址,数据的高位字节存在内存的高地址

如何判断字节序:

int main()

{int num = 1; // 0x00000001char* ptr = (char*)#if(*ptr == 1)cout << "小端序";else cout << "大端序";

}

为什么要字节序:

- 跨平台兼容性: 不同架构的计算机可能使用不同的字节序方式。

- 网络通信:通过网络传输数据时,不同计算机可能采用不同的字节序,使用网络字节序可以确保数据正确传输

- 硬件差异: 一些硬件平台(如x86、ARM)采用小端序,而一些平台(如某些 RISC系统)采用大端序,标准化字节序能够提高

网络字节序: 网络字节序是为了确保在网络中不同计算机间传输数据时,能够统一数据的存储顺序。它采用的是大端序。

在编程中,为了保证数据的正确性,可以使用一些库函数来进行字节序转换。例如,htonl() 和 ntohl() 用于将数据从主机字节序转换为网络字节序,反之亦然。

htonl():主机到网络字节序(32位)ntohl():网络到主机字节序(32位)

内存对齐

内存对齐是计算机系统中一种重要的内存访问优化机制,它要求数据在内存中的存储地址必须满足特定对齐要求。

元素的起始地址放在其类型大小整数倍的位置上,不满足则需要填充字节

提高性能,高效的读取/写入内存

基本数据:

char 1字节 short 2字节 int 4字节 float 4字节 double 8字节 指针 4/8字节

结构体(struct)对齐

- 规则 1:成员按自身大小对齐。

- 规则 2:结构体成员按其内部最大成员对齐。

- 规则 3:整个结构体大小补齐为最大成员大小的整数倍。

- 编译器可以设置最大对齐值,类型的实际对齐值是该类型的对齐值与默认对齐值取最小值

- GCC 64位 最大对齐值为 8

#pragma pack(show)来显示

应用场景: 嵌入式系统中硬件寄存器访问,网络协议解析, 高性能计算

为什么要这样:

- 硬件优化: 现代CPU(如x86、ARM)通常以对齐的字长(如4字节、8字节)为单位读写内存,未对齐访问可能导致性能下降或硬件异常。

- 缓存效率: 对齐数据能更好利用CPU缓存行(通常64字节),增大缓存命中率

- 减少内存碎片

C++额外注意点:

- 虚基表指针(菱形继承)

- 虚函数表指针(多态)

C语言关键字 staic const extern volatile预处理

static: 声明静态变量(当前文件),声明静态函数(当前文件),声明静态成员变量与成员函数(属于类,多个对象共享)

const: 一旦常量被赋值后,其值将保持不变,不能再对其进行修改,编译时确定,运行时不变,作用域限制

- 应用:声明常量变量,使用 const 参数声明函数,使用 const 修饰函数返回值

const与deifine的区别:

- const是一种编译器关键字,而#define是预处理器指令。const在编译阶段进行处理,而#define在预处理阶段进行处理

- const定义的常量具有类型,而define没有。const在声明时需要指定常量的类型,编译器会进行类型检查。而#define只是简单的文本替换,没有类型检查

- define定义的常量没有作用域限制,整个程序中都有效。

extern: 声明一个在其他文件中定义的外部变量或函数,允许在当前文件中使用这些外部变量或函数而不需要重新定义

volatile: volatile声明的变量是指可能会被意想不到地改变的变量,这样编译器就不会轻易优化该变量

- 多线程中的共享变量

- 中断程序中修改的供其他程序检测的变量

- 并行设备的硬件寄存器

预处理:

- 宏定义

- 文件包含

- 条件编译

它的主要作用是对源代码进行文本级别的处理,为后续的编译阶段做好准备

sizeof 与 strlen

| 对比项 | sizeof | strlen |

|---|---|---|

| 类型 | 编辑期运算符 | 运行时函数(#include) |

| 返回类型 | size_t(表示字节序) | size_t (表示字符串长度) |

| 参数要求 | 变量 / 类型 | const char* |

| 是否包含 \0 | 包含(数组大小) | 不包含(仅字符个数) |

| 计算时间点 | 编辑阶段完成 | 运行阶段,从到遍历直到 \0 |

malloc与calloc的区别

- malloc 分配的内存是未初始化的,calloc 分配的内存会被初始化为全0

- 如果内存分配失败,malloc 返回一个空指针 NULL,通过返回判断是否分配成功,calloc 在分配失败时会自动抛出错误(异常),可以使用异常处理机制来捕获和处理错误。

数组与链表的区别

用链表的目的是什么?省空间还是省时间?

线性表与数组

数组与链表

- 存储方式: 数组是连续的,而链表是非连续的

- 内存使用情况: 数组的大小通常是固定的,内存会预先分配好,而链表的大小是动态的,并且除数据外,还需要额外的内存存储next指针,内存相对较大。

- 访问效率: 数组支持随机访问,通过索引可以直接定位到任意元素,时间复杂度为 O(1)。链表只能顺序访问,需要从头节点开始逐个遍历才能找到目标节点,时间复杂度为 O(n)。

- 操作复杂度:数组的插入删除操作位O(n),链表的插入删除操作时间复杂度为O(1)

适用场景

- 数组:适合需要频繁随机访问元素的场景,例如查找某个特定位置的值,数组是更好的选择,例如矩阵运算、图像处理、排序算法等。

- 链表:适合需要频繁插入和删除元素的场景,或内存大小未知、需动态分配、内存不连续等环境更适合用链表,或更复杂的数据结果,例如双向链表、二叉树、图的邻接表, LRU 缓存等等。

有哪些链表:

- 单向链表: 需要从头到尾顺序遍历数据,不需要反向遍历,插入删除频繁

- 双向链表: 需要双向遍历数据,

- 循环链表: 实现循环队列或约瑟夫环问题,需要从任意节点开始遍历整个链表

- 带头节点的链表: 在链表的头部添加一个特殊的节点(哨兵节点),该节点不存储实际数据,简化边界条件的处理,例如插入或删除头节点时的操作

- 静态链表: 使用数组模拟链表,每个数组元素包含数据部分和指向下一个节点的索引,资源受限(嵌入式系统),需要利用数组的连续性优势场景。内存连续,灵活性差

- 跳表: 是一种多层链表结构,每一层包含部分节点,高层节点用于快速跳过中间节点,类似于平衡树,通过概率实现, 需要高效的查找、插入和删除操作。

栈与队列的区别

存取方式、操作位置

栈的应用场景:

- 函数调用(递归)

- 撤销与恢复操作

- 深度优先搜索

- 线程管理:上下文切换

队列的应用场景:

- 任务调度和资源分配,先来先服务算法

- 消息传递 - 消息队列

- 缓存淘汰策略:淘汰最早进入的缓存数据

- 广度优先搜索

- LRU缓存

使用指针需要注意什么?

- 定义指针时,最好将其初始化为 NULL,这样可以避免使用未初始化的指针。

- 在使用 malloc 或 new 分配内存之后,应该立即检查指针的值是否为 NULL,以防止在使用指针值为 NULL 的内存时出现问题。在 C++11 及更高版本中,使用 new 分配内存的时候,如果发生错误,会抛出异常,因此不需要显示判空。

- 当使用指针指向数组或者动态分配的内存时,一定要记得为其赋初值,避免使用未被初始化的内存作为右值。

- 小心避免数字或指针的下标越界,特别是一些常见的“多1”或者“少1”错误。

- 在释放动态分配的内存时,务必确保申请和释放是配对的,以防止内存泄漏。

- 使用 free 或 delete 释放内存后,立即将指针设置为 NULL,以避免出现悬空指针(野指针)。

- 避免指针的多重间接性:多重间接性指的是通过多个指针进行连续的解引用操作。尽量避免过多的间接性,以提高代码的可读性和维护性。

- 注意浅拷贝和深拷贝:如果指针指向的是动态分配的内存,涉及到对象的拷贝或赋值时,需要注意浅拷贝和深拷贝的区别。深拷贝会复制整个对象及其指向的内存,而浅拷贝只是复制指针本身,可能导致多个指针指向同一块内存。

野指针、段错误

野指针

-

野指针是指向不可用内存的指针,当指针被创建时,指针不可能自动指向NULL,这时,默认值是随机的,此时的指针成为野指针。

-

当指针被free或delete释放掉时,如果没有把指针设置为NULL,则会产生野指针,因为释放掉的仅仅是指针指向的内存,并没有把指针本身释放掉。

-

第三个造成野指针的原因是指针操作超越了变量的作用范围

段错误

段错误是 C/C++ 程序中最常见的运行时错误之一,通常是由于非法内存访问导致的。

段错误的原因:

| 段错误的原因 | 避免 |

|---|---|

| 访问未初始化的指针 | 初始化指针 |

| 解引用野指针或空指针, 访问已释放的内存 | 检查指针有效性,避免野指针,释放后置空 |

| 数组越界 | 避免数组越界 |

| 修改只读内存 | 使用 const 保护只读数据 |

| 栈溢出 | 注意递归返回 |

调试段错误的工具 gdb

- run:运行程序

- backtrace(bt):查看调用栈

- print(p):打印变量值

- break(b):设置断点

- next(n):单步执行(不进入函数)

- step(s):单步执行(进入函数)

- continue(c): 跳到下个断点

- info threads

- thread

内存泄漏

内存泄漏: 内存泄漏指程序在动态分配内存(如 malloc、new)后,未能正确释放已不再使用的内存,程序失去对该内存的控制。导致系统可用内存逐渐减少,最终可能引发程序崩溃或系统性能下降

内存泄漏了怎么办:

- 审查代码,malloc与free,new delete是否成对出现

- 点击 VSCode 调试 > 窗口 > 显示诊断工具,运行程序,查看 内存使用量 图表和泄漏报告

- valgrind --tool = memerycheck --leak_check = full

如何预防内存泄漏?

- 检查malloc与free,new delete成对出现

- 使用容器(如 std::vector、std::string)替代原生数组

- 将资源(内存、文件句柄)封装在对象中,析构时自动释放。

- 使用C++的智能指针,unique_ptr独占所有权,自动释放,shared_ptr + weak_ptr:避免循环引用

三者的联系

- 野指针 → 段错误

野指针解引用是段错误的常见原因之一(如访问已释放的内存)。 - 内存泄漏 → 间接问题

内存泄漏虽不直接导致段错误,但可能耗尽内存,导致后续new或malloc失败(抛出异常或返回空指针),若未检查空指针则可能引发段错误。 - 共同根源:手动内存管理

内存管理

内存分布模型

- 代码段: 存放程序的机器指令(即二进制代码)。通常是只读的,因为程序的指令在执行过程中不应该被修改。

- 常量区: 字符串、数字等常量存放在常量区,const修饰的全局变量存放在常量区

- 全局区

- 数据段: 存放已初始化的全局变量和静态变量。这些变量在程序开始运行时已经赋予了初始值。

- BSS 段: 存放未初始化的全局变量和静态变量。它们在程序开始运行时会自动初始化为0或者空指针。

- 堆区: 动态分配的内存空间,用于存放程序运行时动态申请的内存。(程序员可以通过函数(如malloc、calloc等)或者操作系统提供的接口来申请和释放堆内存,堆从低地址向高地址增长)

- 栈区: 存放函数的局部变量、函数参数值以及函数调用和返回时的相关信息。栈区是按照“先进后出”的原则进行管理,内存的分配和释放是自动进行的,栈从高地址向低地址增长。是一块连续的空间。

- 文件映射:也称为共享内存,用于实现不同进程之间的内存共享

C语言堆栈分区理解与区别

- 分配与释放: 栈区由编译器自动管理,自动释放,堆区变量需要手动的创建与释放

- 生命周期: 栈区的变量的生命周期与函数调用绑定,堆区变量内存由程序员控制,可跨函数使用

- 大小: 默认栈大小较小,通常最多为2MB,超过则会报溢出错误.堆区内存比较大,由虚拟内存决定,理论上可以接近3GB(对于32位程序来说)

- 连续性: 栈区内存分配遵循内存分配遵循后进先出(LIFO)原则,地址连续的,堆区的内存块通过链表管理,地址不连续

- 内存碎片: 栈操作遵循"后进先出"的原则,不会有内存块从栈中弹出,因此不会产生碎片。堆是通过动态分配内存的方式进行分配和释放,频繁的申请和释放内存可能会引发内存碎片问题。

- 生长方向: 堆:从低地址向高地址生长

- 缓存方式: 栈使用的是一级缓存,调用完成立即释放,速度比较快,堆使用的是二级缓存与主存,速度相对慢

栈区的使用场景: 函数内部局部变量、函数调用信息、递归调用,注意栈溢出。每个线程独享独立栈空间(与线程同生命周期(线程创建时分配,退出时释放))

堆:整个进程共享同一堆空间

- 存储全局或共享数据

- 动态数据结构(链表、树等)

- 跨线程共享的数据(需同步机制保护)。

为什么堆的空间是不连续的? 堆包含一个链表来维护已用和空闲的内存块。申请和释放许多小的块可能会产生如下状态:在已用块之间存在很多小的空闲块。进而申请大块内存失败,虽然空闲块的总和足够,但是空闲的小块是零散的,不连续的,不能满足申请的大小,这叫做**“堆碎片”**

堆分配的空间在逻辑地址(虚拟地址)上是连续的,但在物理地址上是不连续的

用户栈和内核栈

内核栈: 内存中属于操作系统空间的一块区域。1. 保存中断现场,对于嵌套中断 2. 保存操作系统程序相互调用的参数

用户栈: 用户进程空间的一块区域,用于保存用户空间子程序间调用的参数,返回值以及局部变量

为什么不能共用:

- 大小问题: 如果只用系统栈,系统栈一般大小有限,用户程序调用次数可能很多

- 安全性问题: 如果只用用户栈,系统程序需要在某种保护下运行

内存碎片

内存碎片是指在内存管理过程中产生的未被有效利用的零散、不连续的内存空间。主要分为两种类型:内部碎片和外部碎片。

-

内部碎片: 是由于固定大小的内存分配方式或对齐要求等原因导致的未被利用的小空间。当分配给进程的内存块大于所需的大小时,其中的剩余空间就成为了内部碎片。需要举例子说明,比如malloc分配了20字节,但实际只用15字节,剩下的5字节就是内部碎片。

-

外部碎片: 是由于存在未分配的连续内存空间太小而不能满足分配请求,从而导致这些内存无法被有效利用。比如系统有100字节空闲,但分散成多个30字节的小块,这时申请40字节就会失败。 解决外部内存碎⽚的问题就是内存交换

消除外部碎片:

- 紧凑技术: 操作系统会不时将进程在内存中的位置移动,移动和整理过程开销大,效率较低

- 内存交换: 256MB→临时写到硬盘→读回时不放在原来的位置,而是紧跟已有的 512MB 内存块之后

- 空闲块合并: 内存释放时,尽可能将相邻的空闲空间合并成更大的连续内存块,减少碎片。

消除内部碎片:

- 分页机制(Paging):把内存划分为固定大小的页框,进程按页分配,每一页为4K,避免因连续空间不足而产生外部碎片,但最后仍可能有页内的 内部碎片

- 使用内存池: 内存池是一种动态内存分配与管理技术。存池则是在真正使用内存之前,先申请分配一大块内存(内存池)留作备用**,**当我们申请内存时,从池中取出一块动态分配的内存,释放内存时,再将我们使用的内存释放到我们申请的内存池内,再次申请内存池也可以再取出来使用。并且,尽量与周边的内存块合并。若内存池不够时,则自动扩大内存池,从操作系统中申请更大的内存池

- 伙伴系统(Buddy System):通过二叉分割和合并空闲块,快速找到合适的空闲内存,减少内外部碎片。

分段、分页、段页式、请求式分页

-

分区式内存管理: 将整个程序一次性加载到内存的一个连续区域中,会产生 外部碎片,导致内存利用率低

-

分页式内存管理: 将内存划分为固定大小的页框(4KB),程序被切分成同样大小的页(Page),逻辑上连续,物理上可以离散。提高内存利用率,不产生外部碎片,只会产生少量 内部碎片(最后一页用不完的部分)

-

分段式内存管理: 根据逻辑模块(如代码段、数据段、堆、栈等)划分为多个段,每个段连续分配物理内存。更符合程序的逻辑结构,方便实现信息共享与保护。但段长不固定,容易产生 外部碎片,且为大段分配连续空间较困难。

-

段页式内存管理: 先按照逻辑模块划分为段,再对每个段进行分页,逻辑地址 = 段号 + 页号 + 页内偏移量。既支持逻辑模块化,也避免外部碎片,但地址转换过程更复杂(段表 + 页表)

-

请求式分页与虚拟内存: 程序并不一次性加载,而是 按需加载页面。依赖 局部性原理(程序运行时只会频繁访问少量数据)。若访问的页面不在内存,会触发 缺页异常,操作系统从磁盘调入相应页面。

| 管理方式 | 特点 | 碎片情况 | 优缺点 |

|---|---|---|---|

| 分区式 | 整个程序一次性装入内存 | 外部碎片严重 | 简单,但浪费空间 |

| 分页式 | 固定大小页,物理地址离散 | 少量内部碎片 | 内存利用率高,不利共享 |

| 分段式 | 按逻辑模块划分 | 外部碎片 | 方便共享与保护,难以分配大段 |

| 段页式 | 分段后再分页 | 减少外部碎片 | 结合两者优点,开销较大 |

| 请求分页 | 按需调入页面 | 几乎无碎片 | 支持虚拟内存,提高利用率 |

内存池

内存池(Memory Pool)是一种动态内存分配与管理技术。当程序长时间运行时,由于所申请的内存块大小不定,频繁使用时会造成大量的内存碎片从而降低程序和操作系统的性能。内存池则是在真正使用内存之前,先申请分配一大块内存(内存池)留作备用,当我们申请内存时,从池中取出一块动态分配的内存,释放内存时,再将我们使用的内存释放到我们申请的内存池内,再次申请内存池也可以再取出来使用。并且,尽量与周边的内存块合并。若内存池不够时,则自动扩大内存池,从操作系统中申请更大的内存池

为什么要做内存池?

- 性能优化:

- 减少动态内存分配的开销:系统调用 malloc/new和free/delete 涉及复杂的内存管理操作(如内存查找、碎片整理),导致性能较低,而内存池通过预分配和简单的逻辑管理提高分配和释放的效率。

- 避免内存碎片: 动态分配内存会产生内存碎片,尤其在大量小对象频繁分配和释放的场景中,导致的后果就是: 当程序长时间运行时,由于所申请的内存块的大小不定,频繁使用时会造成大量的内存碎片从而降低程序和操作系统的性能。内存池通过管理固定大小的内存块,可以有效避免碎片化。

- 降低系统调用频率: 系统级内存分配(如malloc)需要进入内核态,频繁调用会有较高的性能开销。内存池通过减少系统调用频率提高程序效率。

- 确定性: 稳定的分配时间,使用内存池可以使分配和释放操作的耗时更加可控和稳定,适合实时性有严格要求的系统。

应用场景?

- 高频小对象分配: 游戏中大量小对象的动态分配与释放、网络编程中大量的请求和响应

- 实时系统: 嵌入式设备或实时控制系统中,动态分配内存延时可能影响实时性,内存池提供了确定的性能

- 服务器开发: 数据库服务器、web服务器等需要管理大量连接和请求,这些连接涉及大量内存分配,内存池能有效提升服务器性能。

内存池在代码中的应用

- 对 new/malloc/delete/free 等动态开辟内存的系统调用进行替换

- 对STL众多容器中的空间配置器 std::allocator 进行替换

#include <iostream>

#include <cstdlib>class SimpleMemoryPool {

private:char* pool; // 内存池起始地址size_t blockSize; // 内存块大小size_t numBlocks; // 内存块数量char* freeList; // 空闲节点链表头节点

public:SimpleMemoryPool(size_t blockSize, size_t numBlocks) : blockSize(blockSize), numBlocks(numBlocks) ;~SimpleMemoryPool();void* allocate();void deallocate(void* block);

};

内存池的缺点

- 初始内存占用: 内存池需要预先分配较大的内存区域,可能浪费一些内存。

- 复杂性: 实现和调试内存池代码比直接使用malloc/new更复杂。

- 不适合大型对象: 对于大对象的分配可能并不划算。

虚拟内存与页表

直接访问物理内存的缺点: 碎片化导致利用率低,缺乏访问控制,无法隔离进程,安全性差,内存不足时效率低下。

虚拟内存的好处

虚拟内存是一种抽象的内存概念,它为每个进程提供了一个独立的地址空间,这个地址空间被称为虚拟地址空间。虚拟内存的大小可以超过物理内存的容量。

物理内存是计算机系统中实际存在的内存硬件,由RAM(Random Access Memory)组成。物理内存存储着正在运行的程序和数据。

为什么要使用虚拟内存?以下是虚拟内存的几个好处:

- 扩展内存容量: 虚拟内存允许进程访问超过物理内存容量的虚拟地址空间。当物理内存不足以容纳所有进程的数据时,操作系统可以将不常用的页面置换到磁盘上,从而释放物理内存空间给其他进程使用。

- 内存隔离: 每个进程都有独立的虚拟地址空间,使得不同进程之间的内存彼此隔离,互不干扰。这提高了系统的安全性和稳定性,一个进程的错误不会影响其他进程。

- 简化程序设计: 虚拟内存使得程序设计人员可以将内存视为连续的地址空间,而不需要关注物理内存的限制和分配。程序可以使用大量的虚拟内存,而不必担心物理内存的实际大小。

- 提高性能: 虚拟内存通过提供更大的地址空间和内存管理机制,可以提高系统的性能。它允许操作系统将常用的页面保留在物理内存中,减少了磁盘访问次数,提高了访问速度。

- 按需调页,提升内存利用率:程序的虚拟地址空间被划分为 页(Page),这些页并不需要全部映射到物理内存,而是 按需加载,当程序访问到不在物理内存的页时,会触发 缺页异常。

页表的作用是什么?

页表 简化 user/kernel 间数据传递流程

页表(Page Table)是操作系统中的一种数据结构,用于管理虚拟内存和物理内存之间的映射关系。它记录了进程的页(Page)与物理页框(Page Frame)之间的对应关系。

页表的作用是实现虚拟内存与物理内存之间的映射关系,并提供对内存访问的控制和管理。具体作用包括:

- 映射关系:通过页表,操作系统可以根据进程的虚拟地址将其转换为实际的物理地址。这样,进程就可以使用连续的虚拟地址空间而不需要关心物理内存的布局。

- 内存管理: 页表可以帮助操作系统有效地管理内存。它可以将进程的虚拟地址空间分割成小的固定大小的页,同时将物理内存分割成与页大小相同的块。这样,操作系统可以根据需要进行页面调度,将进程所需的虚拟页加载到物理内存中,并保持合理的内存利用率。

- 内存保护: 页表中可以记录访问权限和保护位等信息,用于控制进程对内存的访问权限。通过页表,操作系统可以实现内存的保护,确保进程只能访问到其所拥有的内存空间,防止越界访问和非法操作。

- 虚拟化技术支持: 在虚拟化环境下,页表可以实现虚拟机对物理内存的访问和管理。虚拟机监控程序(Hypervisor)会维护独立的页表,将虚拟机的虚拟地址转换为物理地址,隔离不同虚拟机之间的内存空间。

地址映射

-

内存被划分为固定大小的 页(Page),通常 4KB。

-

物理内存也划分为同样大小的 页帧(Page Frame)。

-

页表记录 虚拟页号 → 物理页帧号 的映射。

-

虚拟地址到物理地址的映射是通过页表(Page Table)来实现的。页表是一种数据结构,记录了虚拟页和物理页之间的映射关系。

-

在分页机制下,虚拟地址分为两部分,页号和页内偏移。页号作为页表的索引,页表包含物理页每页所在物理内存的基地址,这个基地址与页内偏移的组合就形成了物理内存地址

虚拟地址 到物理地址 三个步骤:

- 把虚拟内存地址,切分成页号和偏移量;

- 根据页号,从页表里面,查询对应的物理页号;

- 直接拿物理页号,加上前面的偏移量,就得到了物理内存地址。

缺页异常与置换

-

虚拟页的数量 > 物理页帧数量 → 有些虚拟页不在物理内存,而是存放在磁盘中。

-

当 CPU 访问一个虚拟地址时:

- 调用内核的缺页处理程序。

- 选择一个物理页帧(可能采用 LRU 等页面置换算法)换出到磁盘。

- 从磁盘调入所需页面,更新页表项(有效位 = 1,并写入新的物理页号)。

- 返回原指令重新执行,此时命中物理内存。

-

查询页表:如果页表有效位 = 1 → 命中 → 直接访问物理内存。

若有效位 = 0 → 缺页异常:

缺页中断

缺页异常: malloc和mmap函数在分配内存时只是建立了进程虚拟地址空间,并没有分配虚拟内存对应的物理内存。当进程访问这些没有建立映射关系的虚拟内存时,处理器自动触发一个缺页异常,引发缺页中断。

缺页中断: 缺页异常后将产生一个缺页中断,此时操作系统会根据页表中的外存地址在外存中找到所缺的一页,将其调入内存。

操作系统中的缺页中断(Page Fault)是指当程序访问的页不在物理内存中时发生的一种中断机制。当程序需要访问一个虚拟页,但该页当前不在物理内存中时,CPU会触发一个缺页中断,将控制权交给操作系统。

惰性分配与缺页

缺页中断的处理过程大致如下:(大致了解)

- 当程序访问一个缺页时,CPU会暂停当前的指令执行,并产生一个异常或中断,即缺页中断。

- 操作系统的内核捕获到缺页中断,并开始处理中断。

- 操作系统首先会检查发生缺页中断的原因。如果该页是无效的或不可访问的,操作系统会终止该进程,因为这可能是非法访问。否则,如果该页是合法的但不在物理内存中,操作系统需要将该页加载到内存中。

- 操作系统根据页表信息确定要替换的物理页框,并根据需要从磁盘中获取相应的页。

- 如果物理内存中有空闲的页面,操作系统将被替换的页面清除并将新的页面加载到物理内存中。如果物理内存没有空间,则必须选择一个页面进行替换,通常会使用一些页面置换算法,如最近最少使用(LRU)或先进先出(FIFO)。

- 操作系统更新页表,将新加载的页与对应的虚拟页建立映射关系,并标记该页为已加载到物理内存中。

- 最后,操作系统恢复中断点,并将控制权返回给触发缺页中断的程序,让它继续执行。

缺页中断的目的是实现了虚拟内存的概念,允许程序使用比实际物理内存更大的地址空间,并将常用的页存放在物理内存中,而将不常用的页放在磁盘上。通过缺页中断处理,操作系统能够根据需求将所需的虚拟页从磁盘加载到内存中,实现了透明的内存管理和动态的页面调度。

中断和异常的区别

| 中断 | 异常 | |

|---|---|---|

| 触发方式 | 由外部设备或其他特殊事件触发,如时钟、IO | 由当前执行的指令引发,表示当前指令无法正常执行或发生了错误,如除零错误、越界访问、非法指令等 |

| 异步性 | 异步事件,与当前程序的执行无关,可在任何时刻发生 | 同步事件,由当前执行的指令引发,与当前执行步骤相关 |

| 处理机制 | 发生中断时,处理器立即中断当前正在执行的程序,保存当前程序的上下文,并跳转到中断处理程序来处理中断事件。处理完中断后,处理器恢复之前被中断的程序的上下文,并继续执行。 | 发生异常时,处理器立即中断当前指令的执行,保存当前程序的上下文,并跳转到异常处理程序来处理异常情况。处理完异常后,处理器根据异常处理程序的指示继续执行。 |

| 类型 | 没有明确的类型,可根据中断源进行分类,如外部设备中断、时钟中断 | 异常可以分为故障(Fault)、陷阱(Trap)和终止(Abort)三种类型。Fault表示可以被修复的异常,Trap用于实现系统调用和调试功能,Abort表示无法恢复的异常。 |

| 优先级 | 中断可以具有不同的优先级,处理器按照优先级处理中断事件,高优先级的中断会打断低优先级的中断处理 | 异常没有明确的优先级概念,处理器通常按照异常的严重程度来处理 |

页面置换算法

- 缺页异常:应该是指操作系统在分配内存时不会立即分配物理内存,仅分配虚拟地址空间,不分配物理页。

当出现缺页异常,需调入新页面内存已满时,选择被置换的物理页面,也就是说选择⼀个物理页面换出到磁盘,然后把需要访问的页面换入到物理页。

目的:尽量减少页面换入换出的次数

- 最佳页面置换算法(OPT) 置换未来最长时间不会被访问的页面(理论最优,但无法实际实现)

- 先进先出置换算法(FIFO) 队列维护

- 最近最久未使用的置换算法(LRU) 通过时间戳或计数器记录页面访问时间

- 时钟页面置换算法(Lock) LRU的近似实现,使用引用位标记页面是否被访问过,页面组织成环形链表

- 最不常用置换算法(LFU) 置换访问频率最低的页面,维护页面访问计数器

LRU算法

LRU(Least Recently Used)算法是一种用于页面置换的算法,用于决定哪些页面应该被置换出内存。这个算法的基本思想是,当需要置换页面时,选择最近最少被使用的页面进行替换。

LRU 算法: 实现 LRU 算法的方式可以利用一个数据结构来记录页面的访问历史,可以使用链表或者队列来实现。下面是一种基于双向链表的 LRU 算法实现方式:

- 维护一个双向链表。链表的头部表示最近使用的页面,尾部表示最久未使用的页面。

- 当访问一个页面时,如果页面在链表中存在,将其从原位置删除,并插入到链表头部。

- 当访问一个页面时,如果页面不在链表中,且缓存未满,则直接将该页面插入到链表头部。

- 当访问一个页面时,如果页面不在链表中,且缓存已满,则删除链表尾部的页面,并将新页面插入到链表头部。

- 缓存的数据通过哈希表 cache 来进行快速查找,键为键值,值为节点指针

总结: 使用了一个结构体 ListNode 表示双向链表的节点,通过指针 prev 和 next 连接节点。缓存的数据通过哈希表 cache 来进行快速查找,键为键值,值为节点指针。LRU 缓存的容量由变量 capacity 控制。每次访问或插入新数据时,通过操作链表的头部指针和节点的连接关系来更新缓存的访问顺序,同时使用哈希表来查询快速访问指定键值的节点。

class LRUCache{

private:struct ListNode{int key;int val;ListNode* prev;ListNode* next;ListNode(int k, int v):key(k), val(v), prev(nullptr),next(nullptr){}};ListNode* head;ListNode* tail;unordered_map<int, ListNode*> cache;int capacity;public:LRUCache(int capacity) ; // 构造函数void addToHead(ListNode* node); // 往头节点添加一个节点void deleteNode(ListNode* node); // 删除一个节点int get(int key); // 根据键获取值void put(int key, int val); // 添加一个页面

};