【知识图谱】图神经网络(GNN)核心概念详解:从消息传递到实战应用

本文将深入浅出地解析图神经网络的核心概念、经典模型、主要任务与关键挑战,并附上一个完整的静态图数据处理流程,助你快速入门GNN。

1. 引言:为什么需要图神经网络?

在现实世界中,大量数据天然就是图结构的:

- 社交网络:用户(节点)与关注关系(边)。

- 分子结构:原子(节点)与化学键(边)。

- 引文网络:论文(节点)与引用关系(边)。

传统神经网络(如CNN、RNN)在处理这种非欧几里得数据时显得力不从心。CNN依赖于规则的网格结构,RNN依赖于序列顺序,而图的节点连接是任意、无序的。

图神经网络(GNN) 应运而生,它赋予深度学习模型直接处理图结构数据的能力,从而从复杂的关联关系中学习。

2. GNN的核心思想:消息传递机制

消息传递是GNN的基石,其过程类似于社交网络中的信息交流。

核心三步曲:

- 消息创建:每个邻居节点基于自身特征生成一个“消息”。

- 消息聚合:中心节点将所有邻居的消息通过聚合函数(如

求和、均值、最大值)合并。 - 节点更新:中心节点结合自身特征和聚合的邻居信息,生成新的、更丰富的特征表示。

这个过程会迭代进行多次(K层)。经过K层后,一个节点的表示就包含了其K-hop邻域内所有节点的信息。

3. 经典模型剖析

3.1 图卷积网络(GCN)

GCN是GCN中最基础的模型之一,它将卷积操作巧妙地推广到图数据上。

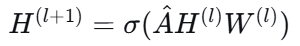

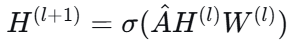

核心公式:

-

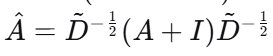

Â:归一化后的带自环的邻接矩阵。

A + I:添加自环,确保节点聚合时不遗忘自身。D:度矩阵,用于归一化,防止邻居数量多的节点主导整个网络。

-

W^{(l)}:第

l层的可学习权重参数。 -

σ:非线性激活函数(如ReLU)。

直观理解:GCN对每个节点及其所有邻居的特征进行归一化的加权求和,再通过一个可学习的权重矩阵进行变换。

3.2 图注意力网络(GAT)

GAT为GCN引入了注意力机制,认为邻居的重要性各不相同。

核心思想:为每个邻居节点计算一个注意力系数,在聚合时进行加权求和。

- 优点:

- 模型能关注更重要的邻居,表达能力更强。

- 不依赖于预先计算的图结构系数。

注意力系数计算步骤:

- 对节点特征进行线性变换。

- 使用一个单层前馈神经网络

a计算中心节点与邻居节点之间的未归一化注意力分数。 - 通过

softmax函数对分数进行归一化,得到标准注意力系数。 - 用注意力系数对邻居特征进行加权求和并更新。

4. GNN的主要任务

GNN可以处理不同级别的预测任务:

| 任务级别 | 目标 | 示例 | 方法 |

|---|---|---|---|

| 节点级别 | 预测节点属性 | 用户分类,论文主题分类 | 直接使用学习到的节点嵌入 |

| 边级别 | 预测边存在性或属性 | 链接预测,推荐系统 | 基于两节点嵌入计算(如内积+MLP) |

| 图级别 | 预测整个图的属性 | 分子性质预测,恶意代码检测 | 先聚合所有节点嵌入为图嵌入,再分类 |

注:

- 恶意代码检测:指将程序的控制流图(CFG) 作为输入,GNN判断其是否为病毒或木马。

- 拓扑信息:指图的连接结构信息(如社区结构、路径长度),与节点特征无关,是GNN的关键学习对象。

5. 实战流程:处理静态图数据

- 数据预处理:构建节点特征矩阵

X(即H⁽⁰⁾) 和邻接矩阵A。 - 前向传播:数据与图结构通过GNN模型。例如,在GCN中,计算

模型学习的是参数W,而非静态权重。 - 任务输出:

- 节点分类:将

H⁽ᴸ⁾输入MLP进行分类。 - 图分类:先将

H⁽ᴸ⁾全局池化为图嵌入,再输入MLP。 - 链接预测:用节点嵌入的内积+sigmoid预测边概率。

- 节点分类:将

- 训练:计算预测值与真实标签的损失,通过反向传播更新所有

W参数。 - 推理:使用训练好的模型对测试集进行预测。

6. 关键挑战与前沿探讨

- 过平滑:GNN层数过深时,所有节点表示会趋于相同。解决方案包括跳跃连接、残差连接等。

- 计算效率:大规模图的邻接矩阵大且稀疏。常用子图采样(如GraphSAGE, Cluster-GCN)等方法,类似于“分治”策略,将大图切分成子图进行训练。

- 动态图:处理随时间变化的图。解决方案包括持续训练、专门的动态GNN模型(引入时间维度建模)。

- 可解释性:理解模型为何做出特定决策。方法包括基于注意力、基于扰动和生成解释子图。这在医疗、金融等高风险领域至关重要,用于验证模型、发现偏差和调试。

7. 总结

GNN通过消息传递机制,巧妙地融合了图的结构信息与节点特征,是处理关系数据的强大工具。理解其核心思想、经典模型以及从数据准备到训练推理的完整流程,是入门和掌握GNN的关键。随着技术在可解释性、动态图处理等方面的不断突破,GNN的应用前景将更加广阔。