一、核心概念拆解

1. 强化学习(Reinforcement Learning, RL)

- 定义:智能体(Agent)通过与环境(Environment)交互,基于奖励信号(Reward)学习最优决策策略(Policy)的机器学习分支。

- 核心逻辑:试错学习(Trial and Error),强调序列决策的长期收益最大化(而非单步奖励)。

- 核心组件:状态(State)、动作(Action)、奖励(Reward)、策略(Policy)、价值函数(Value Function)、Q 函数(Action-Value Function)。

- 典型算法:Q-Learning、Sarsa、蒙特卡洛树搜索(MCTS)、策略梯度(Policy Gradient)。

- 适用场景:机器人控制、游戏 AI、自动驾驶决策、资源调度。

2. 深度学习(Deep Learning, DL)

- 定义:基于深度神经网络(多层感知器、CNN、Transformer 等)的机器学习方法,核心是自动提取数据的深层特征。

- 核心逻辑:通过反向传播(Backpropagation)优化网络参数,拟合数据的输入 - 输出映射关系。

- 核心组件:神经网络层(卷积层、全连接层、注意力层)、激活函数、损失函数、优化器(SGD、Adam)。

- 典型算法:CNN(图像识别)、RNN/LSTM(序列数据)、Transformer(NLP、大模型)、GAN(生成式模型)。

- 适用场景:图像 / 语音识别、自然语言处理、大模型训练、计算机视觉生成任务。

3. 深度强化学习(Deep Reinforcement Learning, DRL)

- 定义:融合强化学习的决策框架与深度学习的特征提取能力,用神经网络替代 RL 中传统的价值函数 / 策略函数表示方法。

- 核心逻辑:解决传统 RL 在高维状态空间(如图像、复杂环境)中的维度灾难问题,通过神经网络拟合 Q 函数或策略。

- 核心组件:RL 的决策流程 + DL 的神经网络(如 CNN 处理图像状态、Transformer 处理序列状态)。

- 典型算法:DQN(深度 Q 网络)、PPO(近端策略优化)、A2C/A3C(优势演员 - 评论家)、SAC(软 actor-critic)。

- 适用场景:AlphaGo(围棋 AI)、机器人复杂动作控制、大模型 RLHF(基于人类反馈的强化学习)、元宇宙虚拟人决策。

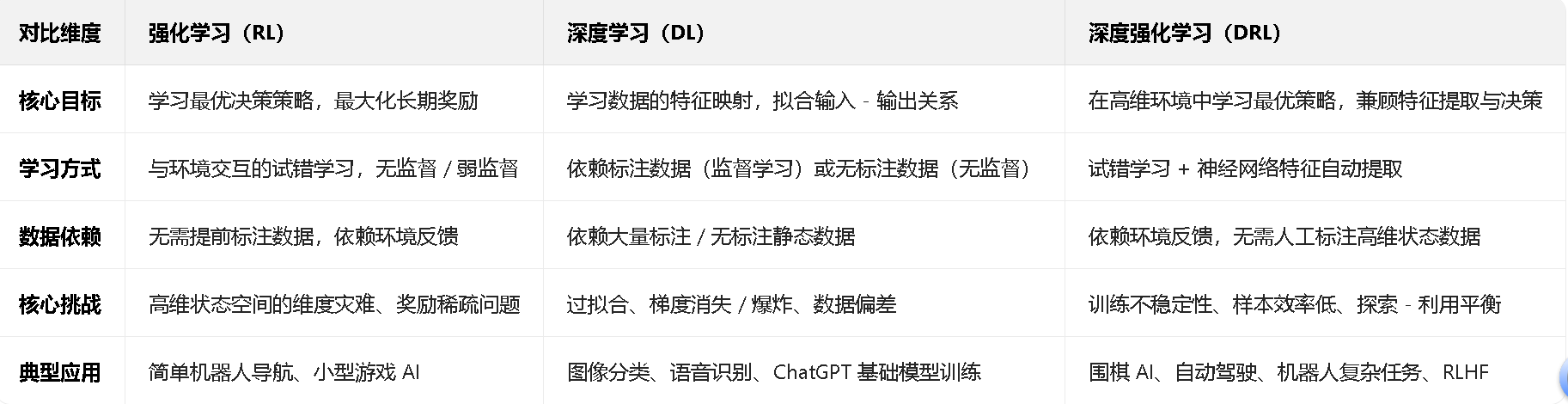

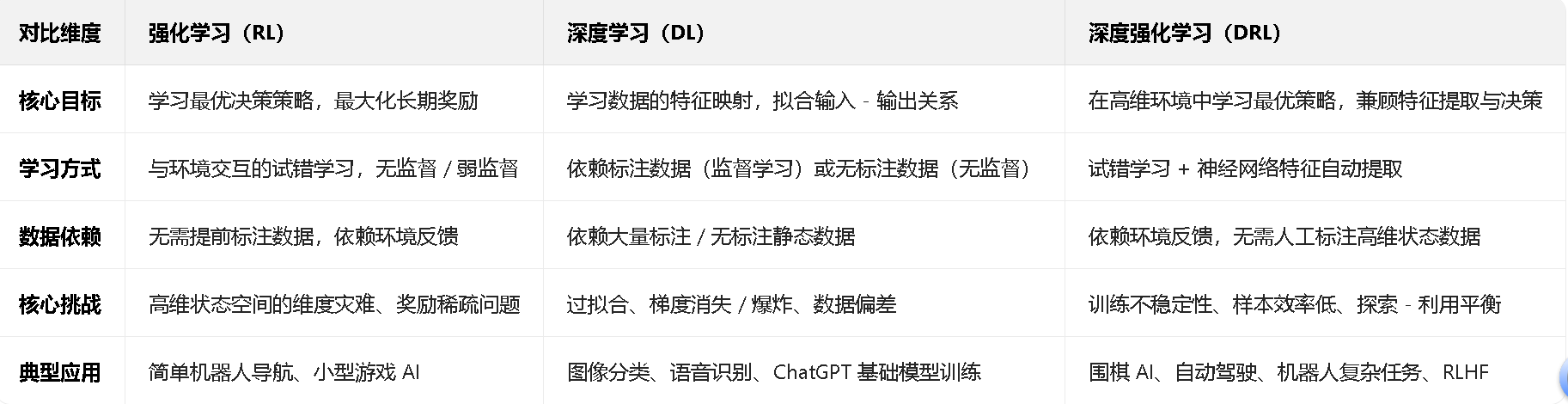

二、关键维度对比表

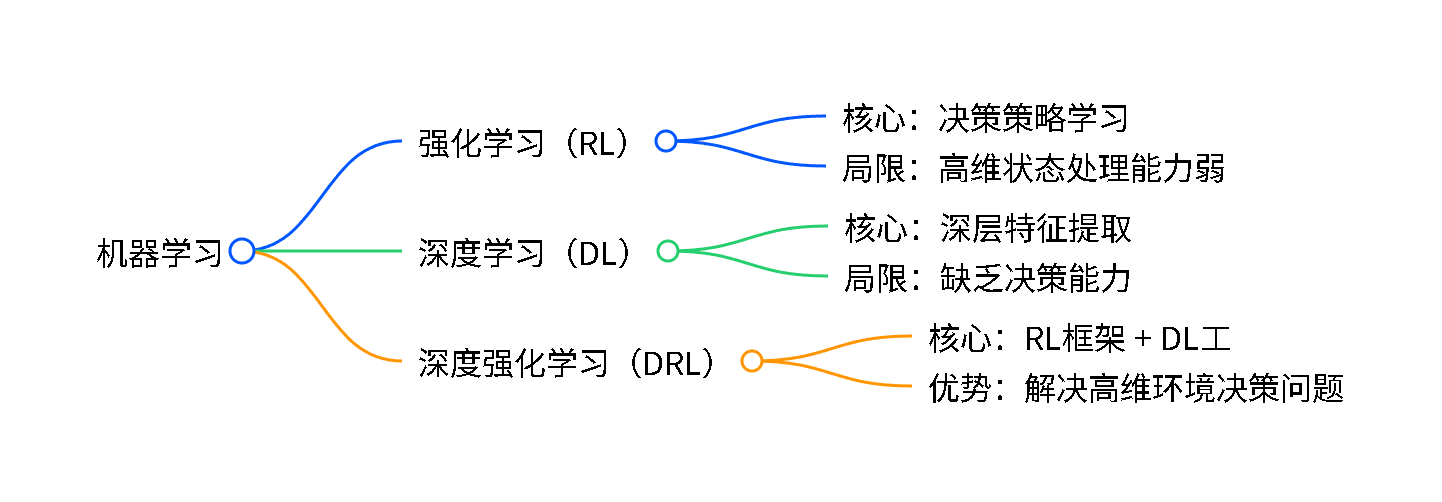

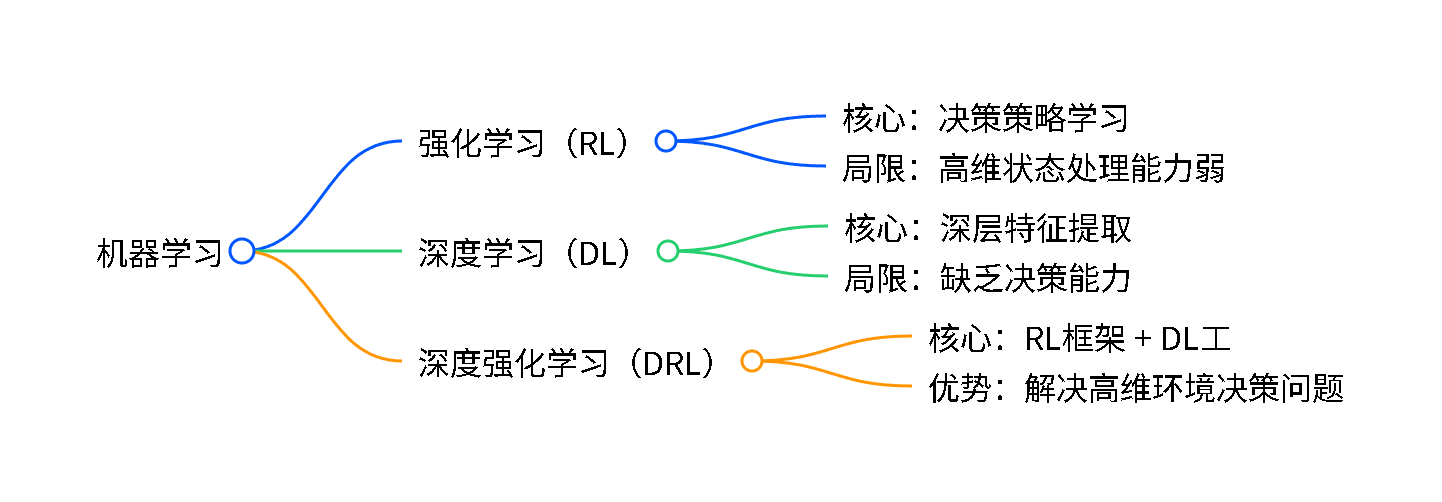

三、三者关系可视化(思维导图)

四、学术应用场景关联(结合你的研究方向)

1. 强化学习在你的研究中的应用

- 机器人领域:传统 RL 可用于简单机器人的路径规划(如基于 Q-Learning 的避障),但无法处理视觉传感器的高维图像输入。

- 大模型领域:RL 是 RLHF(基于人类反馈的强化学习)的核心框架,用于优化大模型的对话策略(对齐人类偏好)。

2. 深度学习在你的研究中的应用

- 机器人领域:用 CNN 处理摄像头图像、用 Transformer 处理激光雷达点云,提取环境特征(如识别障碍物、目标物体)。

- 强化学习领域:用神经网络拟合价值函数 / 策略函数,是 DRL 的基础(如 DQN 用 CNN 处理 Atari 游戏图像)。

3. 深度强化学习在你的研究中的核心价值

- 机器人领域:DRL 可实现端到端的机器人控制(如基于 PPO 的机械臂抓取、基于 SAC 的无人机轨迹跟踪),直接从高维传感器数据输出动作。

- 大模型领域:RLHF 的核心是 DRL(用 PPO 算法优化模型参数),结合 Transformer 架构的大模型,实现对话质量的迭代提升。

五、关键区别总结

- 本质差异:RL 是 “决策框架”,DL 是 “特征提取工具”,DRL 是 “用 DL 工具解决 RL 的高维问题”。

- 数据处理:RL 依赖环境交互数据,DL 依赖静态标注 / 无标注数据,DRL 依赖高维环境的交互数据。

- 核心挑战:RL 的瓶颈是高维状态处理,DL 的瓶颈是决策能力缺失,DRL 的瓶颈是训练稳定性和样本效率。

六、进阶追问方向(按需深入)

- 具体算法细节:如 DQN 如何用经验回放(Replay Buffer)解决相关性问题?PPO 的 clip 机制如何保证训练稳定?

- 研究方向深度应用:如 DRL 在机器人操作中的视觉 - 动作映射实现?RLHF 的具体流程(SFT→RM→RL)?

- 代码复现需求:如基于 PyTorch 的 DQN 实现 Atari 游戏、PPO 用于机器人控制的开源项目解析?