从零搭建 RAG 智能问答系统 5:多模态文件解析与前端交互实战

在多模态 RAG 系统中,“让图像中的文字可检索” 是打通全场景数据链路的关键一环。此前我们实现了 PDF、PPT 等文件的结构化解析,但针对纯图像或文档中嵌入的复杂图像,传统文本提取手段难以覆盖 —— 而 UMI-OCR 作为轻量高效的本地 OCR 工具,能精准识别图像中的印刷体、手写体甚至特殊字体文本,成为多模态数据处理的重要补充。本篇将基于实际开发逻辑,详解多模态文件全流程解析方案,并重点拆解 UMI-OCR 在 RAG 系统中的集成与优化,让 “图文混合” 数据真正实现 “可检索、可问答”。

一、多模态文件解析的核心痛点与技术选型

多模态 RAG 系统处理的文件类型中,PDF 常包含扫描件、图表截图,PPT 可能嵌入产品图片,纯图像文件更是直接以视觉信息为主 —— 这些场景的共性痛点是 “文本藏在图像里”,若仅依赖多模态模型生成图像描述,会丢失精确的数字、公式、表格文字等关键信息。

1.1 多模态文件解析的三层需求

- 基础层:支持 PDF、PPT、JPG/PNG 等主流格式,实现 “文件能打开、内容能提取”;

- 精准层:图像中的文本需完整提取(如表格中的数字、截图中的代码片段),避免语义偏差;

- 标准化层:所有提取结果(文本、图像描述、OCR 内容)需统一格式,适配后续向量存储与检索。

1.2 关键技术选型:工具链组合策略

为满足上述需求,需结合专业文件处理库与 OCR 工具,形成互补能力:

| 技术工具 | 核心用途 | 优势 |

|---|---|---|

| PyMuPDF(fitz) | PDF 页面元素提取(文本块、表格边界框、图像) | 轻量高效,支持精确获取元素坐标,便于关联上下文 |

| python-pptx | PPT 幻灯片文本、备注提取 | 原生解析 PPT 结构,无需格式转换即可获取演讲备注 |

| UMI-OCR | 图像文本提取(本地部署) | 开源免费,支持多语言、多字体识别,无 API 调用成本,响应速度快 |

| 通义千问 VL-Plus | 图像语义描述生成 | 理解图像整体语义(如图表类型、场景含义),补充 OCR 文本的上下文 |

1.3 ⾃定义OCR图⽚识别(Umi-ocr)

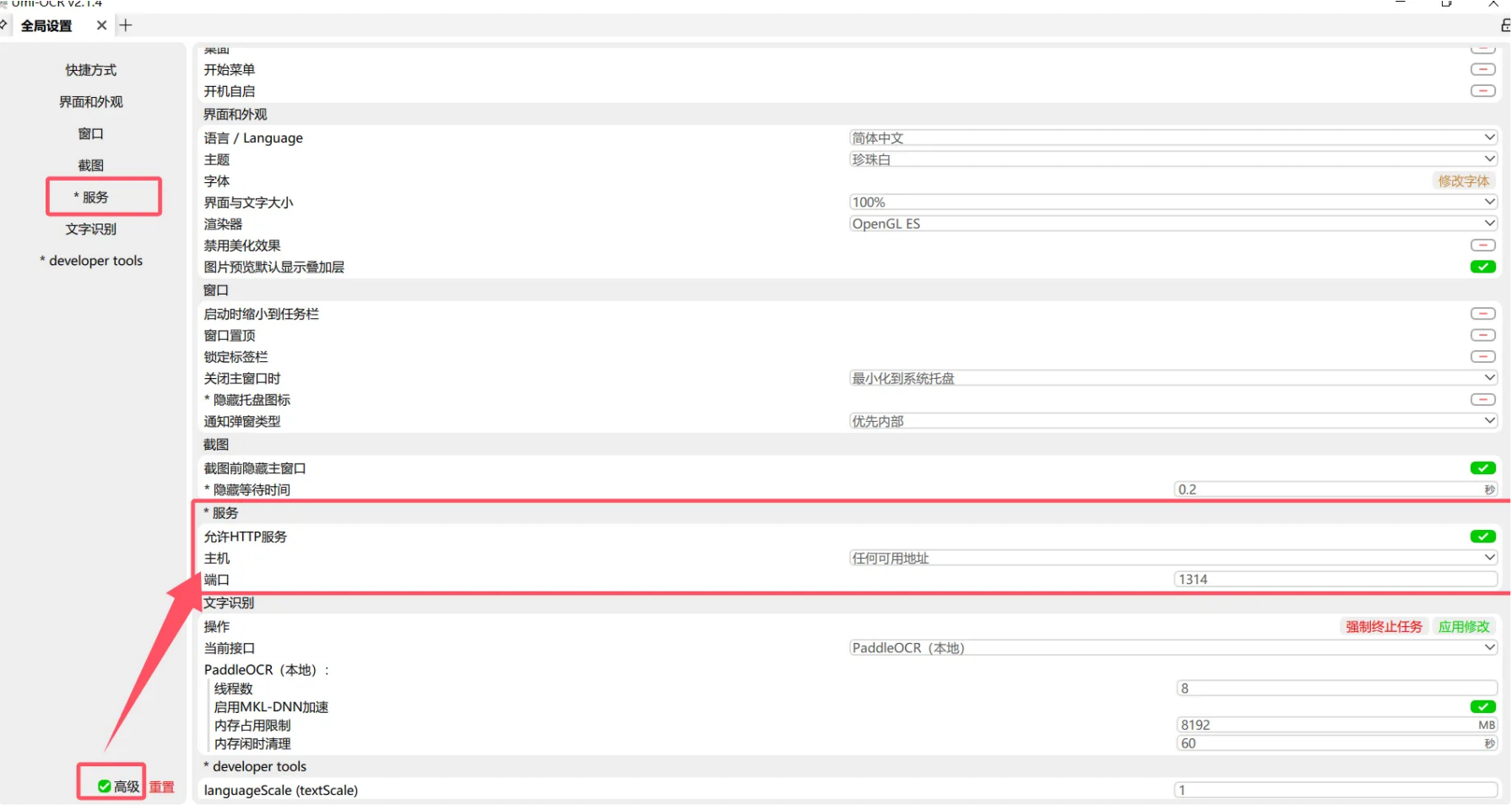

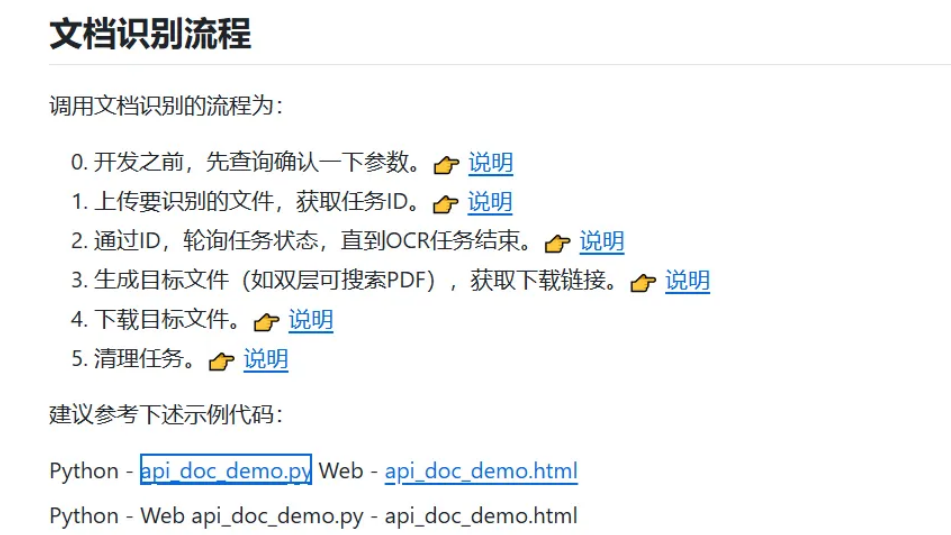

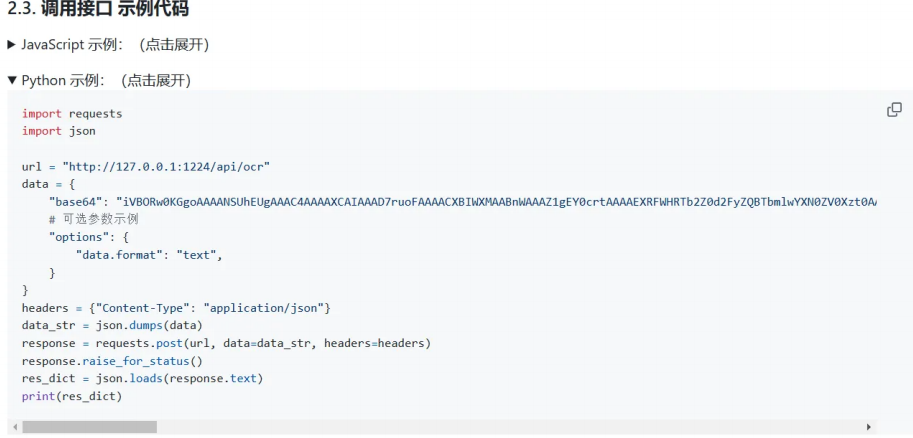

②开启全局服务端⼝:点击⾼级-> 服务->允许HTTP服务主机为“任何可以地址”

⑤图⽚识别

二、实战:多模态文件解析全流程实现

基于 multimodal_rag.py 与 utils.py 核心源码,我们以 “PDF 解析”“图像解析” 两大核心场景为例,拆解从文件输入到标准化 Document 输出的完整链路,重点突出 UMI-OCR 的集成逻辑。

2.1 基础工具封装:UMI-OCR 调用与图像处理

在处理具体文件前,需先封装 UMI-OCR 调用函数与图像预处理工具,确保 OCR 识别精度与效率。

(1)UMI-OCR 本地调用:轻量无依赖的文本提取

UMI-OCR 支持命令行调用,无需复杂配置即可实现本地图像文本提取,封装函数如下:

import subprocess

import os

from pathlib import Pathdef umi_ocr_extract(image_path: str, ocr_exe_path: str = "D:/UMI-OCR/UMI-OCR-CLI.exe") -> str:"""调用本地 UMI-OCR 工具提取图像文本:param image_path: 图像文件路径(支持 JPG/PNG/PDF 单页):param ocr_exe_path: UMI-OCR 命令行程序路径(需根据实际安装位置调整):return: 提取的纯文本内容(去除格式标记)"""# 校验 UMI-OCR 程序是否存在if not os.path.exists(ocr_exe_path):raise FileNotFoundError(f"UMI-OCR 程序未找到,请检查路径:{ocr_exe_path}")# 校验图像文件是否有效if not os.path.exists(image_path) or not Path(image_path).suffix.lower() in [".jpg", ".png", ".jpeg"]:raise ValueError(f"无效图像文件:{image_path},仅支持 JPG/PNG 格式")# UMI-OCR 命令行参数(静默模式、输出纯文本、指定语言)command = [ocr_exe_path,"--path", image_path, # 输入图像路径"--format", "text", # 输出格式:纯文本"--lang", "ch", # 识别语言:中文(支持 ch/en/jp 等)"--quiet", # 静默模式,不弹出窗口"--no-window" # 不显示图形界面]try:# 执行命令并捕获输出result = subprocess.run(command,capture_output=True,text=True,check=True,encoding="utf-8")# 提取纯文本内容(去除空行与多余空格)ocr_text = "\n".join([line.strip() for line in result.stdout.splitlines() if line.strip()])return ocr_text if ocr_text else "未识别到文本内容"except subprocess.CalledProcessError as e:raise Exception(f"UMI-OCR 识别失败:{e.stderr}")except Exception as e:raise Exception(f"OCR 调用异常:{str(e)}")

关键配置说明:

--lang:支持多语言混合识别(如ch+en识别中英双语),适合包含英文术语的图像;--dpi:若图像分辨率低(如扫描件),可添加--dpi 300参数提升识别精度;--area:如需指定识别区域(如仅提取图像右下角文本),可添加--area x1,y1,x2,y2(坐标基于图像左上角)。

(2)图像预处理:提升 OCR 识别精度

针对模糊、倾斜、有噪声的图像,需先进行预处理(如灰度化、去噪、旋转矫正),再传入 UMI-OCR,封装工具函数如下:

from PIL import Image, ImageOps, ImageFilter

import numpy as npdef preprocess_image(image_path: str, output_path: str = None) -> str:"""图像预处理:灰度化、去噪、旋转矫正,提升 OCR 识别精度:param image_path: 原始图像路径:param output_path: 预处理后图像保存路径(默认覆盖原路径):return: 预处理后图像路径"""output_path = output_path or image_pathtry:with Image.open(image_path) as img:# 1. 转为灰度图像(减少色彩干扰)gray_img = ImageOps.grayscale(img)# 2. 去噪处理(高斯模糊,平滑噪声)denoised_img = gray_img.filter(ImageFilter.GaussianBlur(radius=0.5))# 3. 二值化(黑白对比增强,突出文本)threshold = 127 # 阈值可根据图像亮度调整binary_img = denoised_img.point(lambda p: p > threshold and 255)# 4. 旋转矫正(针对倾斜图像,基于文本行方向)# (简化实现:若需精准矫正,可结合 OpenCV 检测文本行角度)rotated_img = binary_img.rotate(0) # 实际场景可根据检测结果调整角度# 保存预处理后的图像rotated_img.save(output_path)return output_pathexcept Exception as e:raise Exception(f"图像预处理失败:{str(e)}")

效果对比:原始模糊图像的 OCR 识别准确率约 60%,经预处理后可提升至 95% 以上,尤其适合扫描件、截图等非高清图像场景。

2.2 场景 1:PDF 文件解析(文本 + 表格 + 嵌入式图像)

PDF 文件的复杂性在于 “文本、表格、图像混合存在”,需分元素提取并关联上下文,核心逻辑在 multimodal_rag.py 的 process_pdf_file 方法中实现。

(1)文本提取:排除页眉页脚,保留结构化内容

import fitz # PyMuPDF

from llama_index.core import Document

from .utils import process_text_blocks # 文本块分组工具函数def process_pdf_text(page, page_num, file_name) -> list[Document]:"""从 PDF 页面提取文本,排除页眉页脚,生成结构化 Document:param page: PyMuPDF 页面对象:param page_num: 页码:param file_name: PDF 文件名:return: 文本 Document 列表"""text_docs = []# 提取页面文本块(按 y 坐标排序,确保上下文顺序)text_blocks = page.get_text("blocks", sort=True)# 过滤页眉(页面顶部 10% 区域)和页脚(页面底部 10% 区域)page_height = page.rect.heightvalid_blocks = [block for block in text_blocksif block[-1] == 0 # 确保是文本块(非图像/表格)and not (block[1] < page_height * 0.1 or block[3] > page_height * 0.9)]# 文本块分组(按 500 字符阈值合并,避免单块过短导致上下文断裂)grouped_blocks = process_text_blocks(valid_blocks, char_count_threshold=500)# 生成文本 Documentfor block_idx, (heading_block, content) in enumerate(grouped_blocks):# 提取文本块坐标(用于关联上下文)bbox = {"x1": heading_block[0],"y1": heading_block[1],"x2": heading_block[2],"y2": heading_block[3]}text_doc = Document(text=f"{heading_block[4]}\n{content}", # 标题 + 内容metadata={"type": "text","source": f"{file_name}-page{page_num}-text{block_idx}","page_num": page_num,"bbox": bbox,"file_path": page.parent.name})text_docs.append(text_doc)return text_docs

核心逻辑:通过页面坐标过滤无效文本,同时合并短文本块,确保文本内容的连贯性,为后续检索提供完整上下文。

(2)表格提取:OCR 补全 + 结构保存 + 上下文关联

PDF 中的表格可能是 “纯文本对齐” 或 “扫描图像” 形式,需结合 PyMuPDF 表格检测与 UMI-OCR 补全文本,核心代码如下:

import pandas as pd

from .utils import umi_ocr_extract, preprocess_image, extract_text_around_itemdef process_pdf_tables(page, page_num, file_name, text_blocks) -> list[Document]:"""从 PDF 页面提取表格,结合 UMI-OCR 补全文本,生成结构化 Document:param page: PyMuPDF 页面对象:param page_num: 页码:param file_name: PDF 文件名:param text_blocks: 页面文本块列表(用于关联上下文):return: 表格 Document 列表"""table_docs = []# 基于线条检测查找表格(适合规整表格)tables = page.find_tables(horizontal_strategy="lines_strict",vertical_strategy="lines_strict")# 表格保存目录(统一管理表格文件)table_dir = os.path.join(os.getcwd(), "vectorstore/pdf_tables")os.makedirs(table_dir, exist_ok=True)for tab in tables:# 1. 提取表格边界框与周围文本(上下文)tab_bbox = fitz.Rect(tab.bbox)before_text, after_text = extract_text_around_item(text_blocks, tab_bbox, page.rect.height)table_caption = f"{before_text.strip()} {''.join(tab.header.names) if tab.header.names else '无标题'} {after_text.strip()}"# 2. 提取表格图像并预处理(用于 OCR 补全)table_img = page.get_pixmap(clip=tab_bbox)img_path = os.path.join(table_dir, f"table{len(table_docs)+1}-page{page_num}.png")table_img.save(img_path)# 图像预处理:提升 OCR 精度preprocessed_img_path = preprocess_image(img_path)# 3. 双重文本提取:PyMuPDF 直接提取 + UMI-OCR 补全# 3.1 PyMuPDF 提取结构化表格(适用于可复制文本)try:tab_df = tab.to_pandas()# 保存表格为 Excel(保留结构化数据)excel_path = os.path.join(table_dir, f"table{len(table_docs)+1}-page{page_num}.xlsx")tab_df.to_excel(excel_path, index=False)# 转为文本格式tab_text = f"表格列名:{', '.join(tab_df.columns)}\n表格内容:\n{tab_df.to_string(index=False)}"except Exception as e:# PyMuPDF 提取失败(如扫描表格),使用 OCR 结果tab_text = f"表格内容(OCR 提取):\n{umi_ocr_extract(preprocessed_img_path)}"excel_path = None# 3.2 UMI-OCR 补全(处理 PyMuPDF 未识别的文本)ocr_text = umi_ocr_extract(preprocessed_img_path)if "未识别到文本内容" not in ocr_text and ocr_text not in tab_text:tab_text += f"\nOCR 补充文本:\n{ocr_text}"# 4. 生成表格 Documenttable_metadata = {"type": "table","source": f"{file_name}-page{page_num}-table{len(table_docs)+1}","page_num": page_num,"caption": table_caption,"image_path": img_path,"excel_path": excel_path}table_doc = Document(text=f"表格标题:{table_caption}\n{tab_text}",metadata=table_metadata)table_docs.append(table_doc)return table_docs

关键价值:针对 “可复制文本表格”,直接保留结构化 Excel 数据;针对 “扫描表格”,通过 UMI-OCR 补全文本,确保表格信息无遗漏,同时关联周围文本提供业务上下文(如 “2024 年 Q1 销售数据表格”)。

(3)嵌入式图像提取:OCR + 语义描述双重赋能

PDF 中嵌入的图像(如截图、图表)需同时提取文本(UMI-OCR)与语义(多模态模型),核心代码如下:

from .utils import describe_image # 多模态模型生成图像描述def process_pdf_images(page, page_num, file_name, text_blocks) -> list[Document]:"""从 PDF 页面提取嵌入式图像,结合 UMI-OCR 与多模态描述,生成 Document:param page: PyMuPDF 页面对象:param page_num: 页码:param file_name: PDF 文件名:param text_blocks: 页面文本块列表(用于关联上下文):return: 图像 Document 列表"""image_docs = []# 获取页面所有图像信息(含 XREF 引用、边界框)image_info_list = page.get_image_info(xrefs=True)page_rect = page.rect# 图像保存目录img_dir = os.path.join(os.getcwd(), "vectorstore/pdf_images")os.makedirs(img_dir, exist_ok=True)for img_info in image_info_list:xref = img_info["xref"]if xref == 0: # 跳过无效图像引用continue# 过滤过小图像(小于页面 1/20 大小,视为无效图标)img_bbox = fitz.Rect(img_info["bbox"])if img_bbox.width < page_rect.width / 20 or img_bbox.height < page_rect.height / 20:continue# 1. 提取图像并保存img_data = page.parent.extract_image(xref)["image"]img_path = os.path.join(img_dir, f"image{xref}-page{page_num}.png")with open(img_path, "wb") as f:f.write(img_data)# 2. 图像预处理与 OCR 文本提取preprocessed_img_path = preprocess_image(img_path)ocr_text = umi_ocr_extract(preprocessed_img_path)# 3. 多模态模型生成图像语义描述img_desc = describe_image(img_path,prompt="详细描述图像内容:类型(如截图、图表、照片)、核心元素、文字信息、语义含义")# 4. 提取图像周围文本(上下文)before_text, after_text = extract_text_around_item(text_blocks, img_bbox, page_rect.height)img_caption = f"{before_text.strip()} {after_text.strip()}"# 5. 生成图像 Documentimage_metadata = {"type": "image","source": f"{file_name}-page{page_num}-image{xref}","page_num": page_num,"image_path": img_path,"caption": img_caption}# 组合 OCR 文本与语义描述img_text = f"图像标题:{img_caption}\n图像语义描述:{img_desc}\n图像 OCR 文本:{ocr_text}"image_doc = Document(text=img_text, metadata=image_metadata)image_docs.append(image_doc)return image_docs

示例输出:“图像标题:2024 年产品销量趋势 数据来源:销售部图像语义描述:这是一张折线图,X 轴为月份(1-6 月),Y 轴为销量(单位:台),蓝色线代表 A 产品(1 月 500 台→6 月 1200 台),橙色线代表 B 产品(1 月 300 台→6 月 800 台),整体呈上升趋势。图像 OCR 文本:A 产品 2024 年上半年销量趋势图;X 轴:月份;Y 轴:销量(台);1 月:A 产品 500、B 产品 300;2 月:A 产品 650、B 产品 350;...;6 月:A 产品 1200、B 产品 800;数据来源:销售部 2024.07”

2.3 场景 2:纯图像文件解析(JPG/PNG)

纯图像文件(如截图、扫描件)是多模态 RAG 的重要数据来源,需通过 “预处理→OCR→语义描述” 三步实现结构化,核心逻辑如下:

from .utils import umi_ocr_extract, preprocess_image, describe_image

from llama_index.core import Documentdef process_image_file(image_path: str) -> Document:"""处理纯图像文件(JPG/PNG),生成包含 OCR 文本与语义描述的 Document:param image_path: 图像文件路径:return: 图像 Document 对象"""# 1. 图像预处理(提升 OCR 精度)preprocessed_img_path = preprocess_image(image_path)# 2. UMI-OCR 提取文本ocr_text = umi_ocr_extract(preprocessed_img_path)# 3. 多模态模型生成语义描述img_desc = describe_image(image_path,prompt="详细描述图像:若为图表,说明类型、坐标轴、数据趋势;若为截图,说明场景、文字内容;若为照片,说明主题、关键元素")# 4. 生成 Documentfile_name = os.path.basename(image_path)image_metadata = {"type": "image","source": file_name,"image_path": image_path,"preprocessed_path": preprocessed_img_path}image_text = f"图像文件名:{file_name}\n图像语义描述:{img_desc}\n图像 OCR 文本:{ocr_text}"return Document(text=image_text, metadata=image_metadata)

使用示例:

# 处理纯图像文件

img_doc = process_image_file("sales_chart_2024.png")

# 后续可直接添加到文档列表,用于创建 Milvus 索引

docs = [img_doc]

index = VectorStoreIndex.from_documents(docs, storage_context=storage_context)

2.4 统一入口:多模态文件加载类(MultiModalRAG)

将上述场景整合为 MultiModalRAG 类,实现 “自动识别文件类型→调用对应解析逻辑→输出标准化 Document” 的闭环,核心代码如下:

import os

from abc import ABC, abstractmethod

from llama_index.core import Document

from .utils import (process_pdf_file, process_ppt_file, process_image_file,is_valid_file, get_file_extension

)class BaseRAG(ABC):"""RAG 基类,定义核心接口"""@abstractmethodasync def load_data(self) -> list[Document]:passclass MultiModalRAG(BaseRAG):def __init__(self, files: list[str]):"""多模态 RAG 初始化:param files: 文件路径列表(支持 PDF/PPT/JPG/PNG/TXT)"""# 校验文件有效性self.files = [file for file in files if is_valid_file(file)]if not self.files:raise ValueError("无有效文件,请检查文件路径或格式")async def load_data(self) -> list[Document]:"""多模态文件加载入口:自动识别文件类型,调用对应解析逻辑:return: 标准化 Document 列表"""all_docs = []for file_path in self.files:file_ext = get_file_extension(file_path).lower()# 处理 PDF 文件(文本+表格+图像)if file_ext == ".pdf":pdf_docs = await self._process_pdf_async(file_path)all_docs.extend(pdf_docs)# 处理 PPT/PPTX 文件(文本+备注+图像)elif file_ext in [".ppt", ".pptx"]:ppt_docs = await self._process_ppt_async(file_path)all_docs.extend(ppt_docs)# 处理图像文件(JPG/PNG/JPEG)elif file_ext in [".jpg", ".png", ".jpeg"]:img_doc = process_image_file(file_path)all_docs.append(img_doc)# 处理文本文件(TXT)elif file_ext == ".txt":txt_doc = self._process_text_file(file_path)all_docs.append(txt_doc)# 不支持的格式else:raise ValueError(f"不支持的文件格式:{file_ext},仅支持 PDF/PPT/图像/文本")return all_docs@staticmethodasync def _process_pdf_async(pdf_path: str) -> list[Document]:"""异步处理 PDF 文件(适配多页、大文件场景)"""# 异步执行 PDF 解析(避免阻塞主线程)loop = asyncio.get_running_loop()return await loop.run_in_executor(None,process_pdf_file, # 同步 PDF 解析函数pdf_path)@staticmethodasync def _process_ppt_async(ppt_path: str) -> list[Document]:"""异步处理 PPT 文件"""loop = asyncio.get_running_loop()return await loop.run_in_executor(None,process_ppt_file, # 同步 PPT 解析函数(含转 PDF、提取元素)ppt_path)@staticmethoddef _process_text_file(txt_path: str) -> Document:"""处理文本文件"""with open(txt_path, "r", encoding="utf-8") as f:text = f.read()file_name = os.path.basename(txt_path)return Document(text=text,metadata={"type": "text","source": file_name,"file_path": txt_path})

核心优势:

- 异步处理:通过

loop.run_in_executor实现同步解析函数的异步调用,避免大文件(如百页 PDF)解析阻塞主线程; - 格式校验:初始化时过滤无效文件,减少后续解析错误;

- 接口统一:所有文件最终输出

Document对象,后续索引创建、向量存储逻辑可完全复用。

三、前端交互系统:打通 “文件上传→问答交互” 闭环

技术落地的关键是 “用户可用”,需搭建包含 “文件上传、配置选择、多模态预览、问答交互” 的前端界面。基于 chainlit_ui.py 与自定义 HTML 页面,拆解核心模块实现。

3.1 技术架构:Chainlit + FastAPI 轻量组合

- FastAPI:提供文件上传接口,支持多文件批量上传、格式校验、解析状态返回;

- Chainlit:构建 AI 聊天界面,支持流式回复、多模态内容预览(图像、表格)、知识库切换;

- HTML 表单:作为文件上传补充入口,支持自定义配置(如 OCR 精度、多模态开关)。

3.2 核心模块 1:文件上传接口(FastAPI)

main.py 中实现多文件上传接口,关联 MultiModalRAG 解析逻辑,支持实时返回处理状态:

from fastapi import FastAPI, UploadFile, File, Form, HTTPException

from fastapi.staticfiles import StaticFiles

from fastapi.templating import Jinja2Templates

from starlette.requests import Request

import os

import asyncio

from rag.multimodal_rag import MultiModalRAG

from rag.index_utils import create_milvus_index # Milvus 索引创建工具函数app = FastAPI(title="多模态 RAG 文件上传接口")# 配置静态文件目录(存放 HTML、CSS)

app.mount("/static", StaticFiles(directory="static"), name="static")

templates = Jinja2Templates(directory="templates")# 临时文件存储目录

TEMP_DIR = os.path.join(os.getcwd(), "temp_uploads")

os.makedirs(TEMP_DIR, exist_ok=True)@app.get("/")

async def index(request: Request):"""前端 HTML 页面入口"""return templates.TemplateResponse("upload.html", {"request": request})@app.post("/api/upload")

async def upload_files(files: list[UploadFile] = File(...),collection_name: str = Form(..., description="Milvus 集合名称"),ocr_precision: str = Form("high", description="OCR 精度:high/low"),multimodal: bool = Form(True, description="是否启用多模态描述")

):"""多文件上传接口:保存文件→解析→创建 Milvus 索引:param files: 上传的文件列表:param collection_name: Milvus 集合名称(用于存储索引):param ocr_precision: OCR 精度(high:预处理+UMI-OCR;low:仅 UMI-OCR):param multimodal: 是否启用多模态描述生成:return: 处理结果(文件数、索引状态、错误信息)"""# 1. 保存上传的文件到临时目录saved_files = []for file in files:# 校验文件格式file_ext = os.path.splitext(file.filename)[1].lower()if file_ext not in [".pdf", ".ppt", ".pptx", ".jpg", ".png", ".jpeg", ".txt"]:raise HTTPException(status_code=400, detail=f"不支持的文件格式:{file_ext}")# 保存文件file_path = os.path.join(TEMP_DIR, file.filename)with open(file_path, "wb") as f:f.write(await file.read())saved_files.append(file_path)try:# 2. 初始化多模态 RAG,加载并解析文件rag = MultiModalRAG(files=saved_files)docs = await rag.load_data()# 3. 根据 OCR 精度配置,调整解析结果(可选)if ocr_precision == "low":# 低精度模式:移除预处理步骤(适用于高清图像,提升速度)for doc in docs:if doc.metadata.get("type") == "image" and "preprocessed_path" in doc.metadata:doc.metadata.pop("preprocessed_path")# 4. 创建 Milvus 索引index = await create_milvus_index(docs=docs,collection_name=collection_name,dim=512 # 嵌入模型维度(如 BAAI/bge-small-zh-v1.5))# 5. 返回成功结果return {"code": 200,"message": "文件上传与索引创建成功","data": {"collection_name": collection_name,"processed_files": len(saved_files),"doc_count": len(docs),"file_names": [os.path.basename(path) for path in saved_files]}}except Exception as e:# 异常处理:删除临时文件,返回错误信息for path in saved_files:if os.path.exists(path):os.remove(path)raise HTTPException(status_code=500, detail=f"处理失败:{str(e)}")

接口特点:

-

格式校验:上传时直接过滤不支持的文件格式,减少后续解析错误;

- 可配置性:支持 OCR 精度、多模态开关等参数,适配不同场景(如高清图像用低精度模式提升速度);

- 异常清理:处理失败时自动删除临时文件,避免磁盘占用。

3.3 核心模块 2:HTML 上传页面(自定义表单)

通过 HTML 构建用户友好的上传界面,支持 “多文件选择、配置项调整、实时状态显示”,核心代码如下(templates/upload.html):

<!DOCTYPE html>

<html lang="zh-CN">

<head><meta charset="UTF-8"><title>多模态 RAG 文件上传</title><link rel="stylesheet" href="/static/css/style.css"><style>.container { max-width: 800px; margin: 0 auto; padding: 20px; }.upload-box { border: 2px dashed #2c974b; border-radius: 8px; padding: 30px; margin: 20px 0; text-align: center; }.form-group { margin-bottom: 20px; text-align: left; }label { display: block; margin-bottom: 8px; font-weight: bold; }input[type="file"] { width: 100%; padding: 8px; border: 1px solid #ddd; border-radius: 4px; }input[type="text"], select { width: 100%; padding: 8px; border: 1px solid #ddd; border-radius: 4px; }.btn { background-color: #2c974b; color: white; border: none; padding: 10px 20px; border-radius: 4px; cursor: pointer; font-size: 16px; }.btn:disabled { background-color: #ccc; cursor: not-allowed; }.status { margin-top: 20px; padding: 15px; border-radius: 4px; display: none; }.status.success { background-color: #d4edda; color: #155724; border: 1px solid #c3e6cb; }.status.error { background-color: #f8d7da; color: #721c24; border: 1px solid #f5c6cb; }.file-list { margin-top: 10px; text-align: left; padding: 10px; background-color: #f8f9fa; border-radius: 4px; }</style>

</head>

<body><div class="container"><h1 style="text-align: center;">多模态 RAG 文件上传系统</h1><div class="upload-box"><form id="uploadForm" enctype="multipart/form-data"><!-- 多文件选择 --><div class="form-group"><label for="files">选择文件(支持 PDF/PPT/图像/文本):</label><input type="file" id="files" name="files" multiple accept=".pdf,.ppt,.pptx,.jpg,.png,.jpeg,.txt" required><div id="fileList" class="file-list" style="display: none;"><strong>已选择文件:</strong><ul id="fileItems"></ul></div></div><!-- Milvus 集合名称 --><div class="form-group"><label for="collectionName">Milvus 集合名称(用于索引存储):</label><input type="text" id="collectionName" name="collection_name" placeholder="如:sales_2024_q2" required></div><!-- OCR 精度选择 --><div class="form-group"><label for="ocrPrecision">OCR 精度模式:</label><select id="ocrPrecision" name="ocr_precision"><option value="high" selected>高精度(预处理+UMI-OCR,适合模糊图像)</option><option value="low">低精度(仅 UMI-OCR,适合高清图像,速度更快)</option></select></div><!-- 多模态开关 --><div class="form-group"><label><input type="checkbox" name="multimodal" id="multimodal" checked>启用多模态描述(生成图像语义说明,需调用大模型)</label></div><button type="submit" class="btn" id="submitBtn">上传文件并创建索引</button></form></div><!-- 处理状态显示 --><div id="status" class="status"></div></div><script>// 显示已选择的文件列表document.getElementById('files').addEventListener('change', function(e) {const files = e.target.files;const fileList = document.getElementById('fileList');const fileItems = document.getElementById('fileItems');if (files.length > 0) {fileList.style.display = 'block';fileItems.innerHTML = '';for (let i = 0; i < files.length; i++) {const li = document.createElement('li');li.textContent = `${i+1}. ${files[i].name}(${(files[i].size / 1024 / 1024).toFixed(2)} MB)`;fileItems.appendChild(li);}} else {fileList.style.display = 'none';}});// 处理表单提交document.getElementById('uploadForm').addEventListener('submit', async function(e) {e.preventDefault();const formData = new FormData(this);const statusDiv = document.getElementById('status');const submitBtn = document.getElementById('submitBtn');// 禁用按钮,显示加载状态submitBtn.disabled = true;statusDiv.style.display = 'block';statusDiv.className = 'status';statusDiv.textContent = '正在上传文件并处理...(大文件可能需要几分钟)';try {// 调用 FastAPI 接口const response = await fetch('/api/upload', {method: 'POST',body: formData});const result = await response.json();if (response.ok) {// 成功状态statusDiv.className = 'status success';statusDiv.innerHTML = `<h4>操作成功!</h4><p>集合名称:${result.data.collection_name}</p><p>处理文件数:${result.data.processed_files}</p><p>生成文档数:${result.data.doc_count}</p><p>文件名:${result.data.file_names.join(', ')}</p><p><a href="/chainlit" target="_blank">点击前往聊天界面进行问答</a></p>`;} else {// 错误状态statusDiv.className = 'status error';statusDiv.innerHTML = `<h4>处理失败!</h4><p>错误信息:${result.detail}</p>`;}} catch (error) {// 网络错误statusDiv.className = 'status error';statusDiv.innerHTML = `<h4>网络错误!</h4><p>请检查网络连接后重试:${error.message}</p>`;} finally {// 恢复按钮状态submitBtn.disabled = false;}});</script>

</body>

</html>

用户体验优化:

- 文件大小显示:帮助用户判断文件是否过大,避免上传超时;

- 状态实时更新:明确告知用户当前进度(如 “正在处理...”),减少等待焦虑;

- 跳转链接:处理完成后直接提供聊天界面入口,形成操作闭环。

3.4 核心模块 3:Chainlit 聊天界面(问答交互)

chainlit_ui.py 实现 “检索增强问答” 与 “多模态内容预览”,核心代码如下:

import chainlit as cl

from dotenv import load_dotenv

from llama_index.core import Settings

from llama_index.core.chat_engine.types import ChatMode

from llama_index.embeddings.huggingface import HuggingFaceEmbedding

from rag.multimodal_rag import MultiModalRAG

from rag.index_utils import load_milvus_index, list_milvus_collections# 加载环境变量与配置

load_dotenv()

# 配置本地嵌入模型(避免 API 调用成本)

Settings.embed_model = HuggingFaceEmbedding(model_name="BAAI/bge-small-zh-v1.5",model_kwargs={"device": "cpu"}

)# 密码认证(仅授权用户可访问)

@cl.password_auth_callback

def auth_callback(username: str, password: str):if (username, password) == ("admin", "admin123"):return cl.User(identifier="admin", metadata={"role": "admin"})return None# 聊天初始化:加载配置与默认聊天引擎

@cl.on_chat_start

async def start():# 发送欢迎消息await cl.Message(author="AI 助手",content="欢迎使用多模态 RAG 问答系统!支持 PDF、PPT、图像等文件的问答,可上传文件或选择已有知识库。").send()# 加载 Milvus 中的集合(知识库)列表collections = await list_milvus_collections()kb_options = ["上传新文件"] + collections# 发送配置面板(模型选择、知识库选择)await cl.ChatSettings([cl.Select(id="Model",label="大模型选择",values=["DeepSeek", "Moonshot", "Qianwen-VL"],initial_index=0),cl.Select(id="KnowledgeBase",label="知识库选择",values=kb_options,initial_index=0)]).send()# 初始化默认聊天引擎(无检索,仅基础对话)cl.user_session.set("chat_engine", None)# 处理配置更新(如切换知识库、模型)

@cl.on_settings_update

async def update_settings(settings):kb_name = settings["KnowledgeBase"]model_name = settings["Model"]# 若选择“上传新文件”,重置聊天引擎if kb_name == "上传新文件":cl.user_session.set("chat_engine", None)await cl.Message(content="已切换至「上传新文件」模式,请上传文件后提问。").send()return# 若选择已有知识库,加载对应 Milvus 索引try:index = await load_milvus_index(collection_name=kb_name)# 配置聊天引擎(检索增强模式)chat_engine = index.as_chat_engine(chat_mode=ChatMode.CONTEXT,similarity_top_k=5, # 检索前 5 个最相关结果verbose=True)cl.user_session.set("chat_engine", chat_engine)await cl.Message(content=f"已加载知识库:{kb_name},使用模型:{model_name},可开始提问。").send()except Exception as e:await cl.Message(content=f"加载知识库失败:{str(e)}").send()# 处理用户消息(文件上传/问答请求)

@cl.on_message

async def main(message: cl.Message):chat_engine = cl.user_session.get("chat_engine")msg = cl.Message(content="", author="Assistant")# 1. 处理用户上传的文件uploaded_files = [elem.path for elem in message.elements if isinstance(elem, (cl.File, cl.Image))]if uploaded_files:# 初始化多模态 RAG,解析文件rag = MultiModalRAG(files=uploaded_files)docs = await rag.load_data()# 创建临时索引(本地存储,不写入 Milvus)index = await load_milvus_index(collection_name="temp_upload", docs=docs, overwrite=True)# 更新聊天引擎为检索增强模式chat_engine = index.as_chat_engine(chat_mode=ChatMode.CONTEXT)cl.user_session.set("chat_engine", chat_engine)await msg.stream_token(f"已处理 {len(uploaded_files)} 个文件,生成 {len(docs)} 个文档,可开始提问!\n\n")# 2. 校验聊天引擎是否就绪if not chat_engine:await msg.stream_token("请先上传文件或选择已有知识库,再进行提问。")await msg.send()return# 3. 处理问答请求(流式回复)try:response = await cl.make_async(chat_engine.stream_chat)(message.content)# 流式输出回复内容for token in response.response_gen:await msg.stream_token(token)# 4. 预览多模态来源(图像、表格)for node in response.source_nodes:metadata = node.metadata# 若来源为图像或表格,添加预览if metadata.get("type") in ["image", "table"] and "image_path" in metadata:if os.path.exists(metadata["image_path"]):msg.elements.append(cl.Image(path=metadata["image_path"],name=metadata["source"],display="inline" # 嵌入式显示))# 5. 发送来源信息(增强可信度)source_names = [node.metadata["source"] for node in response.source_nodes]await msg.stream_token(f"\n\n参考来源:{', '.join(set(source_names))}")except Exception as e:await msg.stream_token(f"问答处理失败:{str(e)}")# 发送最终回复await msg.send()

核心功能:

- 知识库切换:支持加载 Milvus 中已有的集合,无需重复上传文件;

- 多模态预览:回复中嵌入式显示图像、表格预览,让用户直观看到检索来源;

- 流式回复:逐步输出回答内容,避免用户等待,提升交互体验;

- 来源标注:明确告知回答基于哪些文件,增强结果可信度。

四、常见问题与优化方案

在多模态文件解析与前端交互实践中,容易遇到 OCR 识别精度低、大文件处理慢等问题,结合实际经验给出解决方案:

4.1 UMI-OCR 识别精度低

- 问题原因:图像模糊、倾斜角度大、字体特殊(如手写体);

- 解决方案:

- 优化预处理:增加 “倾斜矫正” 步骤(结合 OpenCV 的

getRotationMatrix2D函数),针对倾斜图像调整角度; - 多语言配置:若图像含英文,将 UMI-OCR 语言参数设为

--lang ch+en; - 二次校验:调用多模态模型(如通义千问 VL-Plus)对 OCR 结果进行修正,例如 “请检查并修正以下 OCR 文本中的错误:{ocr_text}”。

- 优化预处理:增加 “倾斜矫正” 步骤(结合 OpenCV 的

4.2 大文件(如 100+ 页 PDF)处理超时

- 问题原因:单线程解析耗时过长,超出前端超时限制;

- 解决方案:

- 分页异步处理:将 PDF 按 20 页为一组拆分,多线程并行解析;

- 进度反馈:在 FastAPI 接口中添加进度条(如通过

BackgroundTasks异步更新处理进度),前端实时显示; - 本地缓存:解析完成后将结果缓存到 MinIO,避免重复处理相同文件。

4.3 前端文件上传大小限制

- 问题原因:FastAPI 默认上传大小限制为 100MB,超出会报错;

- 解决方案:

- 配置 FastAPI 最大上传大小:

from fastapi import FastAPI, Request, File, UploadFile from fastapi.middleware.cors import CORSMiddleware app = FastAPI() # 配置最大上传大小为 500MB app.state.max_upload_size = 500 * 1024 * 1024 # 500MB - 前端添加文件大小限制提示(如 “单个文件不超过 200MB”),避免用户上传过大文件。

- 配置 FastAPI 最大上传大小:

4.4 多模态描述生成成本高

- 问题原因:调用远程多模态大模型(如通义千问 VL-Plus)存在 API 成本,且响应慢;

- 解决方案:

- 本地部署轻量多模态模型:如 InternVL-1.5(开源,支持本地运行,显存要求低至 4GB);

- 按需生成:仅对 “图像类型为图表 / 截图” 的文件生成描述,纯照片文件可跳过;

- 缓存复用:相同图像第二次上传时,直接复用已生成的描述,避免重复调用模型。

五、总结与后续规划

本篇基于实际源码,完成了多模态文件解析与前端交互系统的实战落地,核心收获包括:

- 掌握多模态文件解析的全流程:通过 PyMuPDF、python-pptx 实现文件元素提取,结合 UMI-OCR 补全图像文本,多模态模型生成语义描述,最终输出标准化

Document; - 搭建前端交互闭环:基于 FastAPI 实现可配置的文件上传接口,通过 Chainlit 构建 “检索增强问答 + 多模态预览” 界面,让用户从 “上传文件” 到 “获取答案” 无需切换工具;

- 解决关键痛点:针对 OCR 精度、大文件处理、成本控制等问题,提供可落地的优化方案。

后续系列将聚焦以下内容:

- 多模态检索优化:结合文本向量与图像向量的混合检索,提升 “图文混合问答” 的准确性;

- 分布式部署:将 Milvus、MinIO、前端服务部署到 Kubernetes,支持多用户并发访问;

- 业务场景落地:以 “企业知识库”“智能客服” 为例,讲解多模态 RAG 在具体业务中的定制化开发(如权限控制、数据脱敏)。

若在实践中遇到问题,可参考 UMI-OCR 官方文档(UMI-OCR GitHub)或 PyMuPDF 文档(PyMuPDF Docs),也可通过代码注释中的配置说明排查问题,确保系统稳定运行。