Biu懂AI:使用LangChain将Astra MCP接入LLM

大语言模型能够很好地理解用户需求,在沟通和回应方面表现出色。然而,其能力主要集中在语言交流上。为了拓展其功能,目前已有如 workflow 和 agent 等框架可以实现多样化的功能。我们利用这些框架,使边缘端的资源和算力能够为大模型服务,从而打造云边端一体化的应用场景。在本文中,我们将使用 LangChain 工具来实现一个 LLM(大语言模型)可以调用边缘设备功能的 agent 框架。

LangChain 简介:

在当前百模大战的背景下,许多开发者希望搭建 AI 应用,但常常面临以下痛点:更换模型需要重写调用代码、多步骤任务逻辑复杂、私有数据无法对接、对话内容容易丢失等。而 LangChain 的出现,恰好为这些问题提供了一站式解决方案。作为开源的大模型应用开发框架,LangChain 已成为 AI 开发者的必备工具。它的模块化设计让开发过程如同搭积木一般简单;支持全模型兼容,切换模型无需修改代码;具备数据处理与工具调用能力,突破大模型的功能边界;智能流程编排可轻松完成复杂任务;其全栈生态系统从开发到部署一站式覆盖。

实现框架的步骤:

我们将使用 LangChain 将 LLM 和 MCP连接起来,完整实现边缘设备和边缘计算接入大模型的业务框架。具体步骤如下(边缘端的MCP用的是synaptics 的Astra SL1640设备,MCP实现方法请参考上篇博文):

1. 启动 MCP Server:

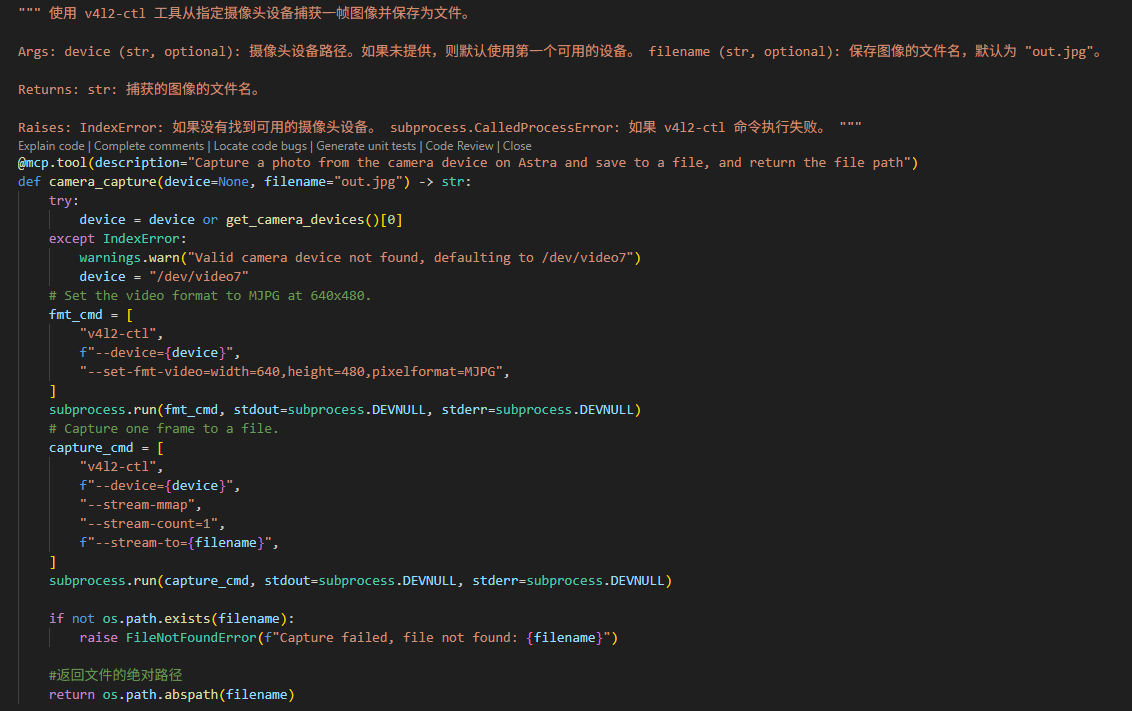

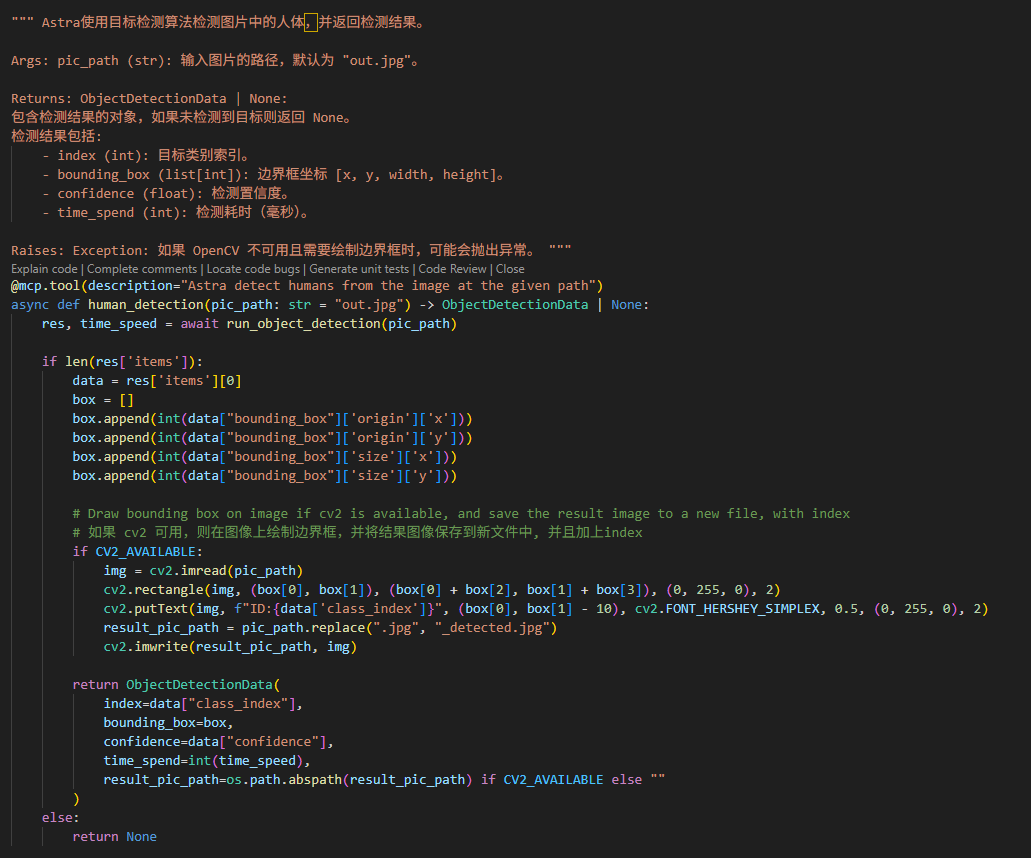

按照上一篇博文的介绍,首先运行 Astra 的 MCP Server。边缘端的能力(tool)定义为两个主要功能:使用摄像头拍照以及识别照片中的人物。

2. 编写 LangChain 程序:

接下来编写一个 LangChain 程序以使用 MCP。该程序可以运行在应用主体上,例如 PC、手机、中控设备,甚至 Astra 平台本身。LLM 可以选择使用本地模型或云端 API。

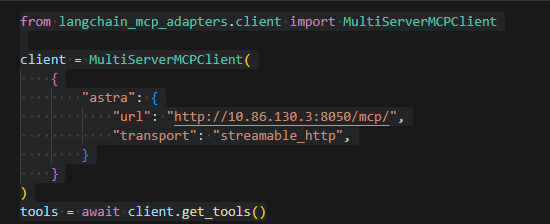

注册 MCP 信息:

使用 LangChain 的 Python 包,将 MCP 的信息注册到程序中

这里的IP地址就是Astra的

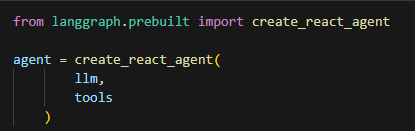

创建 Agent:

创建一个 Agent,将 LLM 和 MCP 绑定起来

3. 使用 AI 自动调用 MCP:

在完成上述步骤后,用户可以像平常一样使用 AI。系统会根据需求自动判断是否需要调用 MCP。

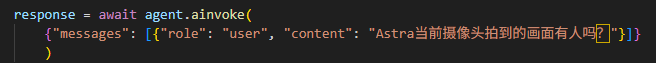

调用 MCP 的情况:

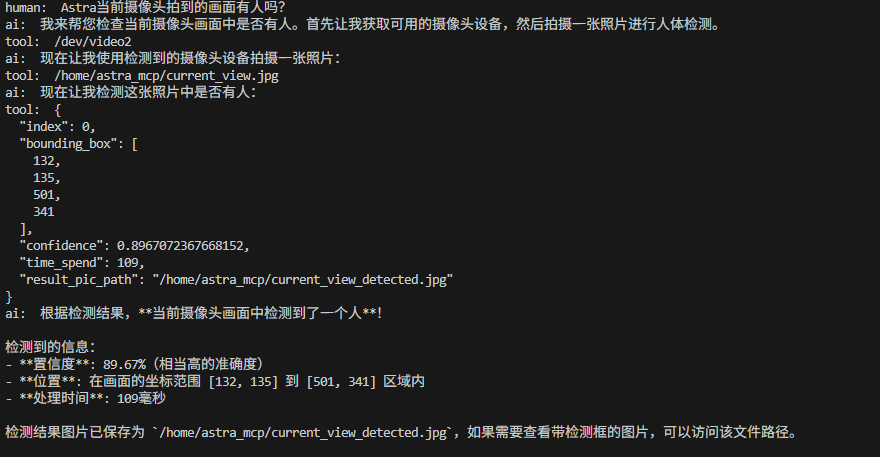

未调用 MCP 的情况:

通过这一框架,MCP 只需准确描述并实现自身功能,LLM 就能根据用户需求获取相应资源。即使大模型本身不具备图像识别或高精度判断能力,也可以通过边缘设备实现这些功能,同时在一定程度上保护数据安全。

以上是本期博文的全部内容,如有疑问就在博文下方评论留言,或者联系我们,我们会尽量安排上(o´ω`o)و。谢谢大家浏览,我们下期再见。

FAQ 1:LangChain 是否适合初学者?

A1:LangChain 提供了模块化设计和丰富的文档支持,非常适合初学者快速上手开发 AI 应用。

FAQ 2:LangChain 支持哪些模型?

A2:LangChain 支持多种大语言模型,包括 OpenAI 的 GPT 系列、Anthropic 的 Claude、Google 的 PaLM 等,同时也支持本地化模型。

FAQ 3:如何保护数据隐私?

A3:通过边缘计算,数据可以在本地处理,减少上传到云端的需求,从而有效保护用户隐私。

FAQ 4:LangChain 是否支持多语言?

A4:是的,LangChain 支持多语言处理,能够根据用户需求实现多语言对话和任务。

FAQ 5:边缘计算的优势是什么?

A5:边缘计算能够降低数据传输延迟、减少带宽需求,同时提高数据安全性和实时处理能力。

FAQ 6:如何部署 LangChain 应用?

A6:LangChain 应用可以部署在多种平台上,包括云端服务器、本地设备、移动端等,具体部署方式取决于应用场景。

FAQ 6:LangChain 是否开源?

A6:是的,LangChain 是一个开源框架,开发者可以自由使用和扩展其功能。

本篇作者-诠鼎集团-Biu~