蚂蚁集团开源的万亿参数模型Ling-1T和Ring-1T-preview

目录

引言:当AI开始解奥数题

一、认识“双子星”:一个“能说会道”,一个“善于思考”

1.1 Ling-1T:全能的“语言学家”

1.2 Ring-1T:专注的“思想家”

二、技术肌肉秀:这些成就到底意味着什么?

2.1 解开IMO奥数题,为什么这么难?

2.2 “逼近GPT-5”,需要加上限定词

三、解密“黑科技”:万亿模型如何做到“又大又省”?

四、真正的价值:开源,以及对“唯参数论”的反思

4.1 开源的战略价值

4.2 蚂蚁的场景化野心

4.3 超越参数竞赛

结语:一个里程碑,而非终点

🎬 攻城狮7号:个人主页

🔥 个人专栏:《AI前沿技术要闻》

⛺️ 君子慎独!

🌈 大家好,欢迎来访我的博客!

⛳️ 此篇文章主要介绍 蚂蚁集团开源的万亿参数模型

📚 本期文章收录在《AI前沿技术要闻》,大家有兴趣可以自行查看!

⛺️ 欢迎各位 ✔️ 点赞 👍 收藏 ⭐留言 📝!

引言:当AI开始解奥数题

最近,AI圈被两则重磅消息刷屏,都来自蚂蚁集团。他们接连开源了两款万亿参数级别的“巨兽”模型:一个是能言善辩的通用语言模型Ling-1T,另一个是擅长深度推理的思考模型Ring-1T。

最引人注目的,莫过于Ring-1T的惊人战绩:它挑战了号称人类智慧巅峰之一的国际数学奥林匹克(IMO)竞赛题,并一举拿下“银牌水平”的成绩。同时,在衡量模型综合能力的权威榜单上,它的表现已经十分逼近GPT-5的深度思考模式。

“万亿参数”、“开源”、“比肩GPT-5”、“解奥数题”——这些标签组合在一起,无疑极具冲击力。但这背后,一连串更实际的问题也随之而来:这是否意味着我们普通人也能用上堪比GPT-5的免费AI了?蚂蚁斥巨资研发这样的顶尖模型,究竟意欲何为?当AI的参数竞赛日益白热化,我们究竟应该关注什么?

一、认识“双子星”:一个“能说会道”,一个“善于思考”

要理解蚂蚁的布局,首先要分清Ling-1T和Ring-1T这两个模型。它们虽然同为万亿参数,但定位和分工截然不同。

1.1 Ling-1T:全能的“语言学家”

这是蚂蚁的通用语言大模型,你可以把它理解成一个知识渊博、表达流畅的全能助手。它的核心任务是理解和生成高质量的文本,适用于智能客服、内容创作、知识问答、代码编写等绝大多数日常场景。它的目标是“说得对”和“说得好”。

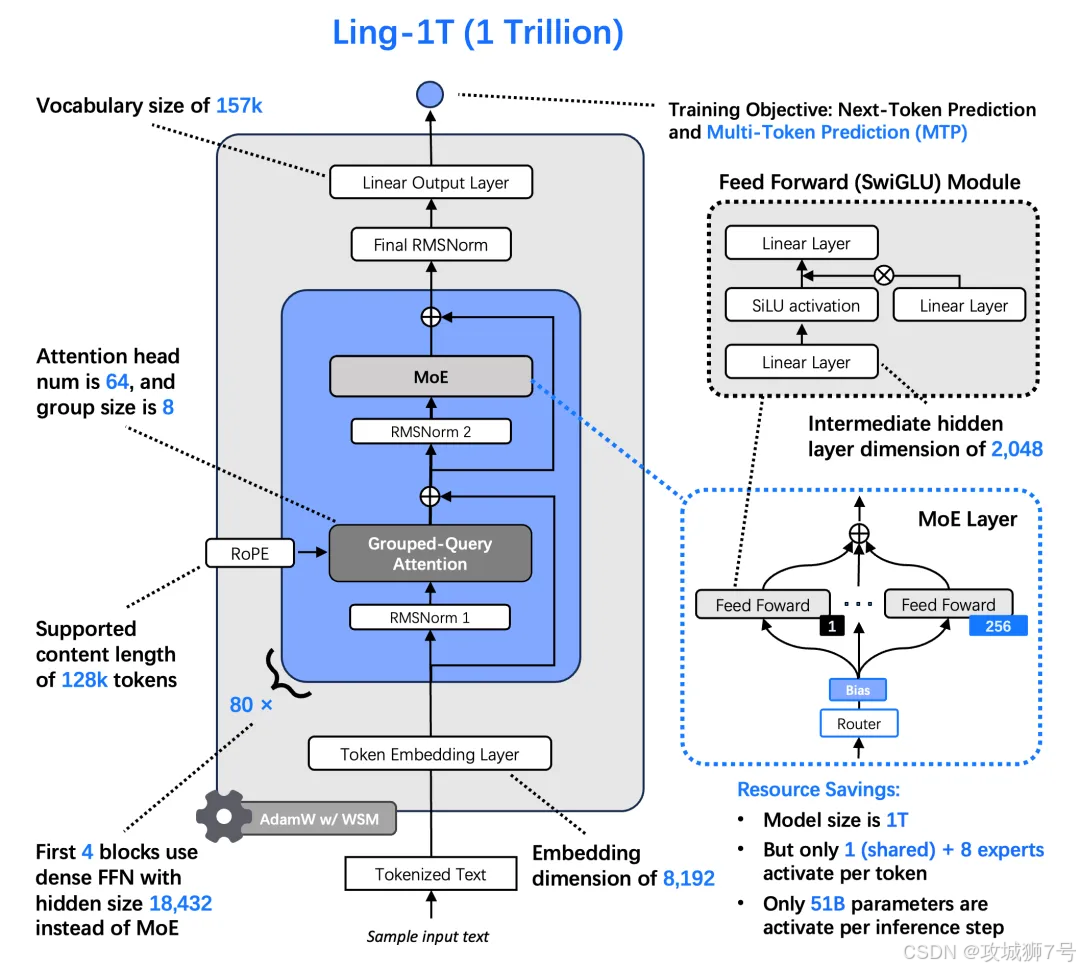

Ling-1T 模型架构图

1.2 Ring-1T:专注的“思想家”

这是在Ling-1T的基础上,通过大量复杂的推理任务进行“特训”后诞生的思考模型。如果说Ling-1T追求的是广度,那么Ring-1T追求的就是深度。它的设计初衷,就是为了攻克那些需要严密逻辑、多步推理和抽象思维的难题,比如数学竞赛、复杂的代码生成和科学研究。它的目标是“想得深”和“想得通”。

简单来说,Ling-1T是基础,Ring-1T是进阶。我们日常聊天、写文案,用的是Ling-1T的能力;而当需要AI解决一个复杂的数学证明或设计一个精密的算法时,就需要Ring-1T这样的“思想家”出马了。

二、技术肌肉秀:这些成就到底意味着什么?

Ring-1T的“IMO银牌”和“逼近GPT-5”的成绩单,无疑是其技术实力的最佳证明。但我们需要冷静地解读这些成就背后的真正含义。

2.1 解开IMO奥数题,为什么这么难?

IMO赛题和我们平时遇到的数学题完全不同,它几乎没有固定的解题套路,需要极强的洞察力、逻辑推理能力甚至“灵感”。AI解IMO题,挑战的不是计算能力,而是机器是否能像人一样进行创造性思考。

Ring-1T能一次性解出多道难题,证明它在数学推理的深度上达到了世界顶尖水平。但同时,在最难的那道题上,它和Gemini 2.5 Pro一样给出了相同的错误答案。这说明,对于人类智慧最顶尖的难题,现有AI模型仍然存在共同的“天花板”。

2.2 “逼近GPT-5”,需要加上限定词

在“人类偏好对齐”测试Arena-Hard V2中,Ring-1T的成绩非常接近GPT-5的“思考模式”(Thinking Mode)。这个成绩含金量很高,说明其生成内容的质量、逻辑性和安全性等综合表现,已经得到了高度认可。

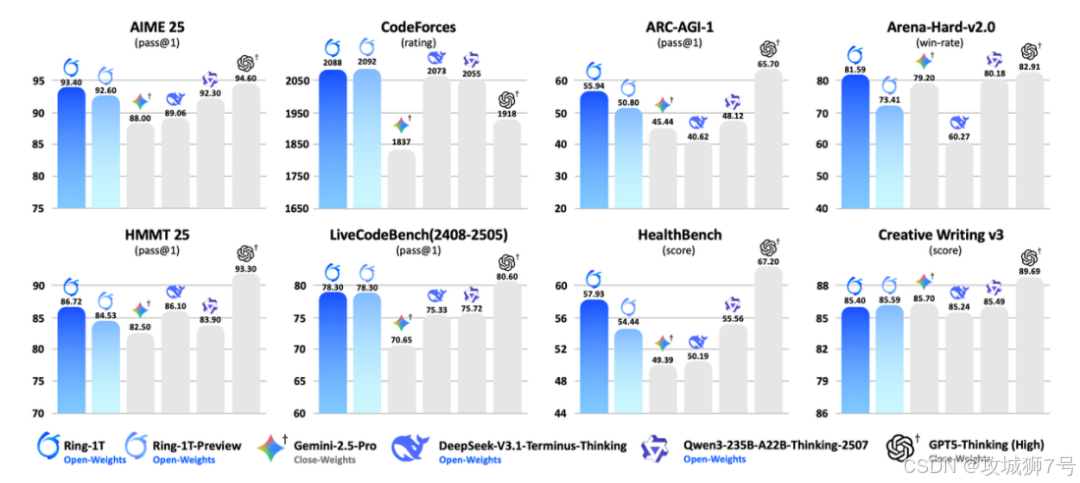

Ring-1T 与业界代表性思考模型的性能横评

但我们也需要客观看待这个“逼近”。首先,与之对标的是GPT-5的特定模式,该模式以更长的推理时间和更高的成本为代价,换取更优的回答质量。其次,测试榜单上的微小差距,在解决某些关键问题时,可能就是“能”与“不能”的区别。因此,“逼近”是一个恰当的描述,它代表了追赶的姿态,而非全面的超越。

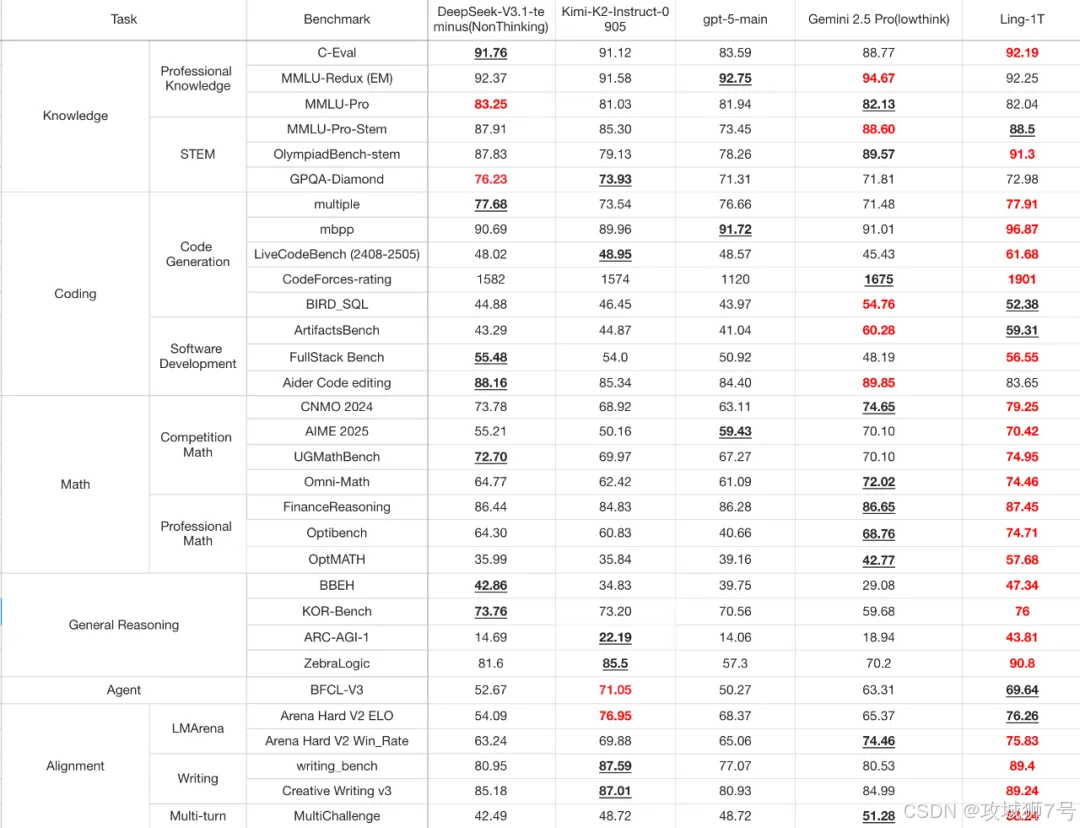

Ling-1T(最右列)与几款具有代表性的旗舰模型的比较

三、解密“黑科技”:万亿模型如何做到“又大又省”?

“万亿参数”听起来就是一个吞噬算力的无底洞,蚂蚁是如何驾驭这个巨兽,并让它高效运转的?这背后有几项关键的技术创新。

(1)MoE架构:养了一支“专家团队”,而非一个“臃肿大脑”

Ling-1T和Ring-1T都采用了目前最前沿的MoE(专家混合)架构。你可以把它想象成一个拥有一万亿知识储备的“智库”,但这个智库并非一个单一的大脑,而是由许多各有所长的“专家小组”构成。

当一个任务进来时,系统并不会调动全部一万亿参数,而是像一位聪明的项目经理,只激活与任务最相关的几十个专家(约500亿参数)来协同工作。这样做的好处显而易见:既拥有了万亿模型的知识广度和深度,又保持了百亿级模型的运行效率和成本。这就是“万亿储备,百亿开销”的由来。

(2)自研算法与系统:为“巨兽”保驾护航

训练如此规模的模型,会遇到各种世界级难题。比如“训推精度差异”——模型在训练时的表现和实际使用时的表现不一致,容易导致训练过程“翻车”。为此,蚂蚁自研了“棒冰(icepop)”算法,确保训练过程的稳定。

同时,为了让模型“想得更明白”,蚂蚁还创新地提出了LPO(语言单元策略优化)方法,在强化学习阶段,让AI以“句子”为单位进行思考和优化,而不是传统的、零碎的“单词”。这更符合人类的逻辑思维习惯,让模型的回答更加连贯和有条理。

这些底层技术的突破,才是蚂TA能够成功训练并开源万亿模型的基石。

四、真正的价值:开源,以及对“唯参数论”的反思

对于绝大多数普通用户来说,即便上手体验Ring-1T,可能也感受不到它和GPT-4在日常任务上的天壤之别。甚至因为它是“思考模型”,响应速度可能还会更慢。

那么,蚂蚁耗费巨大资源做这件事的意义何在?

4.1 开源的战略价值

这或许是Ring-1T和Ling-1T发布最核心的意义。在过去,万亿参数模型是少数几家科技巨头的“传家宝”,外界只能通过API接口调用,无法窥其内部构造。

蚂蚁这次将模型权重、训练方法等核心资产全部开放给社区,相当于把“武功秘籍”公之于众。这极大地推动了全球AI研究的进程。全世界的开发者和研究者,都可以在此基础上进行二次开发、寻找模型缺陷、探索新的应用,从而加速整个AI技术的迭代。这是一种对技术生态的长期投资。

4.2 蚂蚁的场景化野心

与OpenAI打造通用AI助手的路线不同,蚂蚁的大模型战略更聚焦于和自身业务的深度融合。这些强大的AI能力,正被逐步应用到支付宝的各个角落:更聪明的AI理财管家“蚂小财”、更贴心的AI生活助手、服务企业客户的“数字蚂力”平台等。

蚂蚁的逻辑是,与其去卷一个大而全的聊天工具,不如利用自身庞大的用户基础和丰富的应用场景,将AI能力“润物细无声”地嵌入到金融、生活服务中去,解决更具体、更垂直的问题。

4.3 超越参数竞赛

Ring-1T的发布,也引发了我们对“唯参数论”的思考。AI的竞争,一定要不断地堆积参数吗?从百亿到千亿,再到万亿,性能的提升似乎正在边际递减,而成本和能耗却在指数级增长。

蚂蚁通过MoE架构和一系列效率优化,给出了一个可能的答案:未来的竞争,可能不再是谁的模型更大,而是谁能用更低的成本、更高的效率,将AI能力稳定、可靠地应用到实际场景中。

结语:一个里程碑,而非终点

蚂蚁的万亿参数双子星,无疑是中国AI发展史上的一个重要里程碑。它证明了中国企业在超大规模模型的设计、训练和工程实现上,已经具备了世界顶尖的实力。

然而,它更像是一个新阶段的开端。对于蚂蚁而言,如何将这些强大的技术能力,转化为用户真正喜爱并高频使用的产品,是比技术本身更严峻的考验。对于整个AI行业而言,如何摆脱对参数规模的盲目崇拜,转向效率、应用和生态的良性竞争,将是下一阶段的核心命题。

Ring-1T解开的奥数题固然精彩,但AI如何解开赋能千行百业、融入大众生活的“应用题”,或许才是更值得我们期待的答案。

Ring-1T-preview的开源地址:

Hugging Face:https://huggingface.co/inclusionai/ring-1t

ModelScope:https://modelscope.cn/models/inclusionai/ring-1t

Ling-1T相关体验地址和开源地址:

HuggingFace:https://huggingface.co/inclusionAI/Ling-1T

ModelScope:https://modelscope.cn/models/inclusionAI/Ling-1T

GitHub:https://github.com/inclusionAI/Ling-V2

Ling chat(国内用户):https://ling.tbox.cn/chat

ZenMux(海外开发者,提供 Chat 测试与 API 等能力):https://zenmux.ai/inclusionai/ling-1t

看到这里了还不给博主点一个:

⛳️ 点赞☀️收藏 ⭐️ 关注!

💛 💙 💜 ❤️ 💚💓 💗 💕 💞 💘 💖

再次感谢大家的支持!

你们的点赞就是博主更新最大的动力!