DeepSeek-AI团队开源的DeepSeek-OCR模型

2025年10月20日,DeepSeek-AI团队开源的DeepSeek-OCR模型凭借"上下文光学压缩"技术惊艳业界。这款参数量仅3B的模型,通过将文本转化为视觉模态进行压缩,用少量视觉token即可承载海量文本信息,不仅刷新了OCR任务的性能基准,更为大语言模型(LLM)长上下文处理难题提供了全新解法。本文将从技术原理、架构设计、性能表现到实际应用进行全方位解析。

一、技术背景:为什么需要"视觉压缩"?

当前LLM在处理长文档时面临致命瓶颈:文本token数量随内容长度线性增长,当输入达到数万字时,算力与内存需求呈指数级上升,严重限制了金融分析、法律文书处理等场景的落地。传统OCR工具虽能实现图文转换,但存在两大缺陷:要么token消耗过高(如MinerU2.0平均每页需6000+token),要么精度不足,无法兼顾效率与性能。

DeepSeek团队从人类视觉认知机制中获得灵感:人类阅读时能通过视觉系统高效捕捉页面布局与段落结构,实现信息的天然压缩。基于此,他们提出"上下文光学压缩"(Contexts Optical Compression)理念——将文本渲染为图像,通过视觉模型压缩为少量token,再由语言模型解码还原,形成"压缩-解压"的完整链路。

二、核心架构:DeepEncoder与MoE解码器的协同设计

DeepSeek-OCR采用端到端VLM架构,由DeepEncoder深度编码器与DeepSeek-3B-MoE解码器两大核心组件构成,二者分工明确又协同联动。

1. 编码器:DeepEncoder的"局部-全局"压缩艺术

DeepEncoder是实现高压缩比的关键,参数量约3.8亿,专为"高分辨率输入+低token输出"设计,融合了SAM与CLIP的优势架构:

- 双特征提取模块:前半部分采用8000万参数的SAM-base,通过窗口注意力机制高效处理局部视觉细节;后半部分采用3亿参数的CLIP-large,以密集全局注意力捕获整体知识信息。

- 16倍下采样压缩:在双模块之间加入2层卷积模块,将SAM输出的4096个patch token压缩至256个,大幅降低全局注意力计算的内存开销。

- 动态分辨率支持:设计原生分辨率(Tiny/Small/Base/Large四种子模式)与动态分辨率(多原生模式组合)两类输入模式,其中Gundam模式可通过瓦片化处理超高分辨率图像,输出token数为"n×100+256"(n为瓦片数量)。

这种"局部感知→压缩降维→全局理解"的设计,既保证了细节识别精度,又将视觉token数量控制在极低水平。

2. 解码器:3B MoE的高效"解压"能力

解码器采用DeepSeek-3B-MoE混合专家模型,推理时仅激活6个路由专家与2个共享专家,实际运行参数量约5.7亿。这种架构实现了"大模型能力+小模型效率"的平衡——既能精准解析压缩后的视觉特征,又保持了轻量化推理性能,完美匹配编码器的输出处理需求。

三、性能评测:压缩比与精度的最优平衡

DeepSeek-OCR在Fox与OmniDocBench两大基准测试中表现突出,充分验证了"上下文光学压缩"的可行性与优越性。

1. 核心指标:压缩比与精度的强相关性

在文本密集型的Fox基准测试中,模型展现了惊人的压缩效率:

- 压缩比≤10×时(如1000个文本token对应100个视觉token),OCR解码精度达97%以上;

- 压缩比提升至20×时,精度仍维持在60%左右,远超同类技术的性能下限。

研究发现,压缩比超过10×后性能下降主要源于两点:一是长文档布局复杂度增加,二是低分辨率导致文本模糊,前者可通过优化页面布局渲染缓解,后者则为构建"自然遗忘机制"提供了启发。

2. 对比测试:碾压同类模型的效率优势

在OmniDocBench基准的实际场景测试中,DeepSeek-OCR实现了"用更少token做更好效果":

- 仅用100个视觉token即超越GOT-OCR2.0(每页需256个token);

- 用不到800个视觉token的表现优于MinerU2.0(平均每页6000+token)。

在算力效率方面,单张A100-40G显卡可支持每日20万页以上的VLM训练数据生成,完全满足工业化场景需求。

四、功能扩展:不止于OCR的多模态解析能力

DeepSeek-OCR突破了传统OCR的文本识别局限,通过多样化训练数据(含图表、化学方程式、几何图形等),具备了复杂视觉元素的结构化处理能力:

- 科研场景:可将化学分子式转换为SMILES格式,直接用于学术分析;

- 金融场景:能解析报告中的图表并生成结构化表格数据;

- 教育场景:可识别几何图形中的线段关系与标注信息。

这种跨类型解析能力,使其从单纯的OCR工具升级为多模态文档理解引擎。

五、上手实践:基于Hugging Face的快速部署

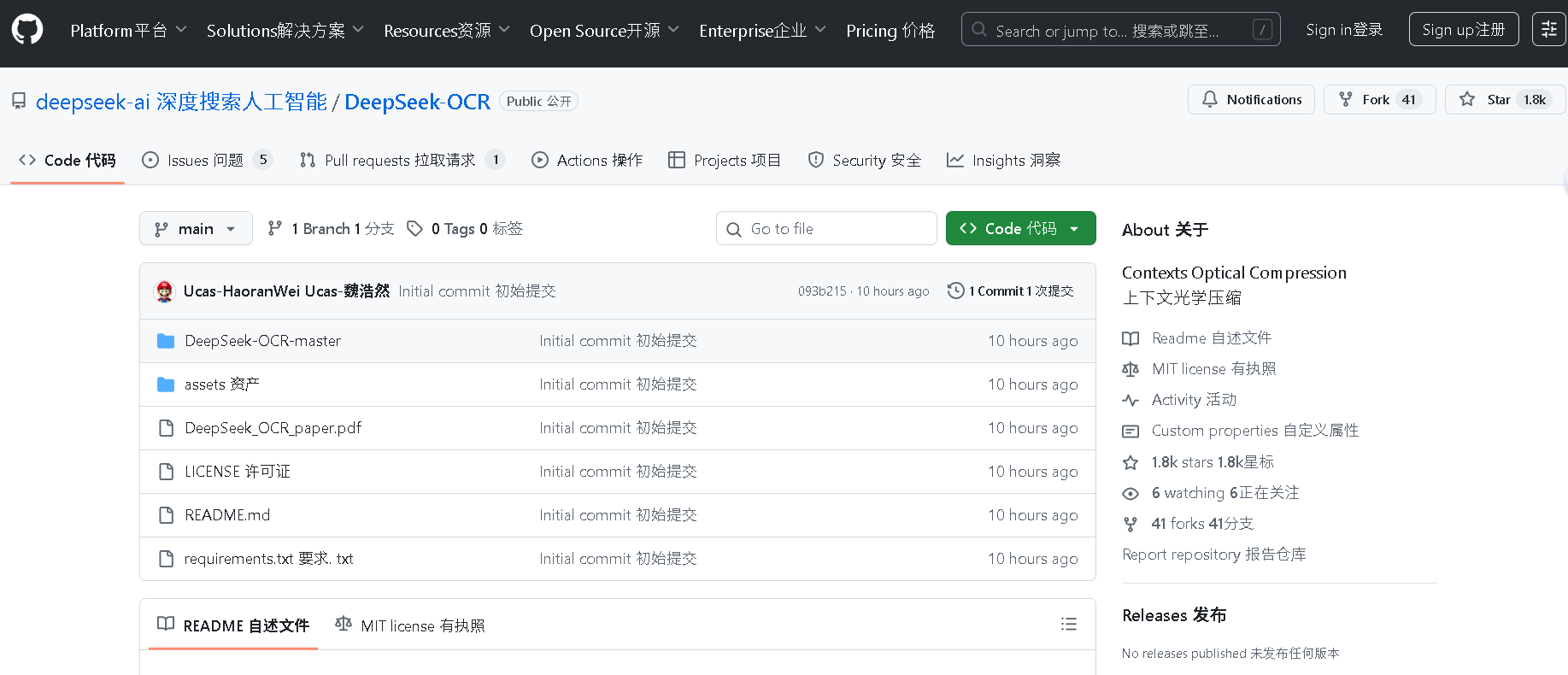

DeepSeek-OCR已开源至Github与Hugging Face,开发者可通过简单步骤实现本地部署与推理。

1. 环境准备

需安装Python 3.8+及相关依赖:

pip install transformers torch pillow accelerate

2. 基础推理示例

加载模型并处理文档图像:

from transformers import AutoProcessor, AutoModelForVision2Seq

from PIL import Image# 加载预训练模型与处理器

processor = AutoProcessor.from_pretrained("deepseek-ai/deepseek-ocr")

model = AutoModelForVision2Seq.from_pretrained("deepseek-ai/deepseek-ocr")# 读取图像(支持多分辨率输入)

image = Image.open("document.png").convert("RGB")# 模型推理

inputs = processor(images=image, return_tensors="pt")

outputs = model.generate(**inputs, max_new_tokens=1024)

result = processor.decode(outputs[0], skip_special_tokens=True)print("识别结果:", result)

3. 关键参数说明

- 分辨率设置:根据文档复杂度选择原生模式(如Base模式对应1024×1024);

- 压缩比控制:通过调整

num_visual_tokens参数在精度与效率间平衡; - 复杂元素解析:需启用

structure_output参数获取结构化结果。

六、局限与展望

当前DeepSeek-OCR仍存在待优化空间:压缩比超过10×时性能明显下降,极端复杂版面的处理能力不足,且尚未完全解决多轮对话场景中的上下文依赖问题。对此,团队计划开展三项重点研究:

- 优化数字文本与光学文本交错的预训练策略;

- 构建长上下文检索准确性的"大海捞针"测试基准;

- 探索多轮对话历史的光学化压缩方案。

结语

DeepSeek-OCR的价值远超一款OCR工具:其"视觉压缩"范式重新定义了视觉与语言模态的协同关系,证明了视觉token可作为高效的信息载体解决长文本处理瓶颈。对于开发者而言,3B参数量的轻量化设计降低了应用门槛;对于行业而言,这种创新为智能文档处理、LLM内存优化等领域开辟了新路径。随着开源生态的完善,DeepSeek-OCR有望在金融、科研、教育等场景实现规模化落地。

可通过以下链接获取完整资源:

- Github仓库:https://github.com/deepseek-ai/DeepSeek-OCR

- Hugging Face模型页:https://huggingface.co/deepseek-ai/deepseek-ocr