Linux系统--信号(4--信号捕捉、信号递达)--重点--重点!!!

Linux系统–信号(4–信号捕捉、信号递达)–重点–重点!!!

前文:

正文中提到的,信号1对应第一个链接,信号2对应第二个链接,信号3对应第三个链接

-

Linux系统–信号(1–准备)-CSDN博客

-

Linux系统–信号(2–信号的产生)-CSDN博客

-

Linux系统–信号(3–信号的保存、阻塞)-CSDN博客

本文会提到部分的陌生概念,大家可以通过下面两个链接来查看:(大家点进去,根据文章前言判断是否有需要的信息)

- Linux系统–信号(2–信号的产生)–陌生概念篇-CSDN博客

- Linux系统–信号(4–信号捕捉、信号递达)陌生概念篇-CSDN博客

前言:

-

信号是什么时候被处理的?详细讲解一下信号从产生到递达处理的全过程。细节到需要过程中有判断pending位图和blocked位图的操作,以及内核怎么找到处理函数的(sighand)。

-

在信号处理过程中,如果是信号捕捉,会有几次内核态和用户态之间的切换?如果没有信号捕捉,又会有几次内核态和用户态之间的切换?

-

前一个例子是一个信号已经产生并被记录在进程的

pending位图中。现在我的疑问就是如果进程的pending位图中并没有未决信号,也没有对任何信号设置阻塞,进程在执行过程中突然收到一条信号,信号从产生到递达的一个完整流程会有什么变化吗?如果是别的情况,又会有变化吗? -

也就是说进程每次从内核态返回到用户态的时候,都会去检查是否有信号需要处理。假设现在进程中的task_struct中的pending位图已经有一个未决信号来,而且没有被阻塞,要是进程没有陷入内核态,进程就不会有从内核态返回用户态的时刻,那信号岂不是不会被处理?怎么确保进程在接收到信号的时候,CPU一定会陷入内核呢?

-

在Linux系统中,所有信号的产生都必然伴随着CPU陷入内核态的操作。这是由操作系统作为资源管理者和硬件仲裁者的角色决定的。无论信号源于硬件异常、系统调用、终端控制还是软件条件,其产生路径都需经过内核的审核与中转。

-

为什么系统检测到有信号捕捉的时候,要从内核态转变为用户态去执行处理函数?而没有信号捕捉的时候,则可以在内核状态下直接执行默认动作。

-

为什么有的操作要陷入内核态处理?是谁陷入内核态?是CPU还是操作系统本身亦或者说是进程?如何理解陷入内核态这个动作?内核究竟是什么东西?

-

计算机内部是如何区分用户态和内核态的,有什么权限标志吗?从底层硬件,到软件层面是如何表现的。

-

操作系统是怎么随时控制任意进程的?为什么进程无论如何切换,都能找到操作系统?怎么做到的?这和虚拟内存空间中内核内存那段区域有什么关系吗?是将操作系统(内核)的代码都映射给了每一个进程吗?

-

操作系统是如何正常运行起来的?是谁让操作系统一直运行着的?让我们用一个具体的例子——x86架构的Linux系统启动过程,来详细讲解操作系统是如何从"死寂的硬件"变成"活着的系统管理者"的。

信号是什么时候被处理的?

详细讲解一下信号从产生到递达处理的全过程。细节到需要过程中有判断pending位图和blocked位图的操作,以及内核怎么找到处理函数的(sighand)。主要重点在处理部分。

// 这是5.6.1版本的Linux系统中的task_struct部分代码

// 对这部分代码的讲解在 信号3。

struct task_struct {// .../* Signal handlers: */struct signal_struct *signal; // (1) 进程组共享的信号信息struct sighand_struct __rcu *sighand; // (2) 指向信号处理程序描述符sigset_t blocked; // (3) 当前线程的信号屏蔽字(阻塞掩码)sigset_t real_blocked; // (4) 临时信号屏蔽字(用于TIF_SIGPENDING)/* Restored if set_restore_sigmask() was used: */sigset_t saved_sigmask; // (5) 保存的信号屏蔽字(用于系统调用重启等)struct sigpending pending; // (6) 挂起(未决)信号队列// ...

};

核心概念回顾

- 信号产生 (Signal Generation): 事件发生(如按下

Ctrl+C、子进程退出、程序错误、kill系统调用等),内核或进程为目标进程设置一个信号标记。此时信号是未决的。 - 信号未决 (Pending): 信号已经产生,但尚未被目标进程处理的状态。内核为每个进程维护一个数据结构(通常是位图),称为

pending掩码。每一位对应一个信号编号(如 SIGINT 是 2)。当信号产生时,内核设置对应信号的位。 - 信号阻塞 (Blocking / Masking): 进程可以主动告诉内核暂时不要递送某些信号。内核为每个进程维护另一个位图,称为

blocked掩码(或信号掩码)。如果某个信号的位在blocked掩码中被设置,那么即使该信号被设置在了pending掩码中(即已产生),内核也不会立即递送它。它保持未决状态,直到被解除阻塞。 - 信号递达 (Signal Delivery): 内核在合适的时机,将未决且未被阻塞的信号传递给目标进程,进程执行该信号对应的处理动作(处理函数、忽略或默认动作)的过程。

- 信号处理函数 (Signal Handler): 用户自定义的函数,用于响应特定信号。进程通过

signal()或sigaction()系统调用注册这些函数。内核通过一个结构(通常是sigaction结构数组)记录每个信号的处理方式。

信号是什么时候被处理的?

这是理解信号机制的关键。信号的处理(递达)发生在目标进程从内核态返回到用户态执行的瞬间。

更具体地说:

- 触发点: 当进程因为以下原因陷入内核态:

- 执行了系统调用 (如

read,write,open,kill等)。 - 发生了硬件中断 (如 时钟中断、网络包到达)。

- 发生了异常 (如 除零错误、页错误 - 虽然页错误最终可能产生 SIGSEGV,但处理信号本身是另一个时机)。

- 执行了系统调用 (如

- 返回时机: 当内核处理完导致陷入的原因(例如,系统调用执行完毕、中断服务程序完成、异常处理完毕),准备将控制权交还给进程的用户空间代码时,内核会执行一个关键的检查点。

- 检查信号: 就在这个返回用户态之前的检查点,内核会检查当前进程的

pending信号集合。它查看是否有任何信号是未决的 (pending位被置位) 并且没有被阻塞 (blocked位未被置位)。 - 处理决策:

- 如果没有未决且未阻塞的信号,内核简单地恢复进程的用户态上下文(寄存器、栈指针、程序计数器等),进程继续执行被中断的用户代码。

- 如果有未决且未阻塞的信号,内核会选择一个信号(通常是数值最小的那个)进行递达处理。

信号从产生到递达处理的全过程(重点在递达处理)

假设一个信号已经产生并被记录在进程的pending位图中。现在,进程执行了一个系统调用(例如 read),进入内核态。

- 系统调用执行/中断/异常处理: 内核执行系统调用的代码或处理中断/异常。

- 准备返回用户态: 系统调用完成或中断/异常处理完毕。内核开始准备恢复进程的用户态执行。

- 关键检查点 (

exit_to_user_mode_loop或类似逻辑): 在内核的调度/返回路径上(例如 Linux 内核中的exit_to_user_mode_loop函数),内核执行以下操作:- 检查

pending & ~blocked: 内核计算pending位图与blocked位图的反码 (~blocked) 的按位与 (&)。这个操作的结果是一个位图,其中每一位为 1 表示对应的信号是未决且未被阻塞的,即可以立即递达。 - 判断是否有信号待处理: 检查

pending & ~blocked的结果是否非零(即是否有任何位被置位)。- 如果没有 (

pending & ~blocked == 0): 跳转到第 8 步。 - 如果有 (

pending & ~blocked != 0): 进入信号处理流程。

- 如果没有 (

- 检查

- 选择待处理信号: 内核需要从

pending & ~blocked集合中选择一个信号进行处理。选择策略通常是选择数值最小的信号(例如,ffs()- Find First Set bit 或类似函数)。假设选中的信号是signum。 - 清除未决状态: 内核将

pending位图中对应signum的位清除(置为 0)。表示这个信号正在被处理,不再处于未决状态。(注意:对于标准信号,即使同一信号在清除pending位之后、处理函数结束之前再次产生,pending位只会被重新置位一次,表示“至少又来了一次”,不会排队。实时信号会排队,pending位可多次置位)。 - 查找处理函数 (

sighand):- 内核访问当前进程的进程描述符(如 Linux 的

task_struct)。 - 在

task_struct中,有一个指向signal_struct的指针,它包含进程级别的信号信息。 - 更重要的是,

task_struct中有一个指向sighand_struct结构的指针 (sighand)。// 这个结构体在信号3中就有讲解 sighand_struct结构包含一个action数组 (struct sigaction action[_NSIG])。这个数组的索引就是信号编号 (signum)。- 内核通过

signum索引sighand->action[]数组,找到该信号对应的struct sigaction结构。 struct sigaction包含三个关键信息:sa_handler或sa_sigaction: 指向用户空间注册的信号处理函数的指针。sa_mask: 一个信号集,指定在执行这个处理函数期间需要临时阻塞哪些额外信号。sa_flags: 标志位,控制处理行为(如是否使用sa_sigaction、是否自动重启被中断的系统调用 SA_RESTART、是否提供额外信息 SA_SIGINFO 等)。

- 内核访问当前进程的进程描述符(如 Linux 的

- 执行处理动作: 内核根据

struct sigaction中的信息决定如何处理信号signum:SIG_DFL(默认动作): 执行该信号的系统默认行为。常见的默认行为有:Term: 终止进程 (可能产生 core dump)。Ign: 忽略信号 (什么都不做)。Core: 终止进程并产生 core dump 文件。Stop: 停止进程 (挂起)。Cont: 如果进程被停止,则继续运行。- 内核直接在内核态执行默认动作(如设置进程退出状态、发送 SIGCONT 等),然后继续检查是否还有其他待处理信号(回到第 3 步)。

SIG_IGN(忽略): 内核什么也不做(信号已被清除)。然后继续检查是否还有其他待处理信号(回到第 3 步)。- 用户自定义处理函数 (

sa_handler/sa_sigaction): 这是最复杂的部分。 内核需要安排进程在返回到用户态时,不是回到被系统调用/中断打断的地方,而是跳转到用户注册的信号处理函数去执行。这个过程称为“捕获”信号。具体步骤:- 构建用户态栈帧: 内核在进程的用户态栈上精心构造一个新的栈帧。这个栈帧包含了:

- 足够的信息,使得将来从信号处理函数返回时 (

return或调用sigreturn),内核能知道如何恢复进程之前被打断的上下文。 - 传递给信号处理函数的参数(如果使用了

SA_SIGINFO标志,则包括siginfo_t和ucontext_t)。

- 足够的信息,使得将来从信号处理函数返回时 (

- 设置用户态寄存器:

- 栈指针 (

%rsp / %esp): 指向内核在用户栈上新构建的栈帧的顶部。 - 指令指针 (

%rip / %eip): 指向信号处理函数的入口地址 (sa_handler或sa_sigaction)。 - 其他寄存器可能根据 ABI (Application Binary Interface) 和

sa_flags被设置(例如,%rdi可能被设置为信号编号signum,%rsi可能被设置为指向siginfo_t的指针,%rdx可能被设置为指向ucontext_t的指针)。

- 栈指针 (

- 设置临时阻塞掩码: 内核将进程当前的

blocked信号掩码保存起来。然后,它将blocked掩码设置为(current_blocked | sa_mask | signum)。这意味着:- 在执行这个信号处理函数期间,自动阻塞当前正在处理的这个信号 (

signum) (防止递归调用)。 - 自动阻塞用户在

sa_mask中指定的其他信号。 - 原有的阻塞信号 (

current_blocked) 仍然保持阻塞。

- 在执行这个信号处理函数期间,自动阻塞当前正在处理的这个信号 (

- 返回用户态: 内核完成上述设置后,执行正常的“从内核态返回用户态”的操作。但是,由于寄存器(特别是

%rip和%rsp)已经被修改,控制权被传递给了用户空间的信号处理函数。此时,信号处理函数开始执行。

- 构建用户态栈帧: 内核在进程的用户态栈上精心构造一个新的栈帧。这个栈帧包含了:

- 无信号或处理完毕后的返回: 如果第 3 步判断没有待处理信号,或者第 7 步执行了默认动作或忽略动作后没有其他待处理信号了:

- 内核恢复进程原本的用户态上下文(即进入内核态之前保存的寄存器状态,包括

%rip指向被中断的指令)。 - 内核将控制权交还给进程,进程从被中断的地方(系统调用后、中断后、异常处理后)继续执行用户空间代码。

- 内核恢复进程原本的用户态上下文(即进入内核态之前保存的寄存器状态,包括

信号处理函数执行完毕后的返回

当用户注册的信号处理函数执行完毕(通过 return语句结束)时:

return触发sigreturn: 编译器通常会在信号处理函数的return语句处插入对sigreturn或rt_sigreturn系统调用的代码。这是由内核在构建栈帧时安排好的。sigreturn系统调用: 进程再次进入内核态。- 内核恢复现场:

- 内核从之前构建在用户栈上的栈帧中恢复进程在进入信号处理函数之前保存的原始上下文(寄存器状态,包括被中断点的

%rip和%rsp)。 - 内核恢复之前保存的

blocked信号掩码(即去掉临时阻塞的sa_mask和signum)。 - 内核清理用户栈上用于信号处理的栈帧。

- 内核从之前构建在用户栈上的栈帧中恢复进程在进入信号处理函数之前保存的原始上下文(寄存器状态,包括被中断点的

- 再次检查信号: 内核在从

sigreturn系统调用返回用户态之前,再次执行第 3 步的检查!它重新计算pending & ~blocked。- 如果在执行信号处理函数期间,同一个信号 (

signum) 又产生了(并且没有被阻塞),由于处理期间内核自动阻塞了signum,这个新产生的信号会被记录在pending中,但此时blocked掩码即将恢复(不再自动阻塞signum),所以pending & ~blocked中可能又包含了signum(或其他信号)。内核会再次尝试递达这个信号(可能再次调用同一个处理函数!这就是递归信号处理,需要小心设计)。 - 如果有其他未决且未阻塞的信号,内核也会尝试递达它们。

- 如果没有待处理信号,内核恢复原始上下文,进程最终回到最初被中断的指令处继续执行。

- 如果在执行信号处理函数期间,同一个信号 (

总结关键点

- 时机: 信号递达发生在进程从内核态返回用户态的时刻。

- 位图操作核心:

pending & ~blocked决定了哪些信号可以立即递达。 - 处理函数查找: 通过进程的

task_struct -> sighand -> action[signum]找到对应的struct sigaction,进而获取sa_handler/sa_sigaction。 - 用户处理函数执行: 内核通过精心构造用户栈和修改寄存器,将控制流劫持到用户处理函数。

- 临时阻塞: 执行处理函数期间,内核自动阻塞该信号本身 (

signum) 和sa_mask中指定的信号。 - 递归可能性: 处理函数返回时 (

sigreturn),内核会再次检查未决信号。如果在处理期间同一个信号又来了,它会被再次递达,可能导致处理函数递归调用。使用sa_mask阻塞相关信号是避免递归的关键手段之一。 - 嵌套处理: 如果在处理一个信号期间,发生了另一个未阻塞信号的递达条件,内核会在第一个信号的处理函数返回后(或嵌套地,如果架构/内核支持,但通常避免)处理第二个信号。

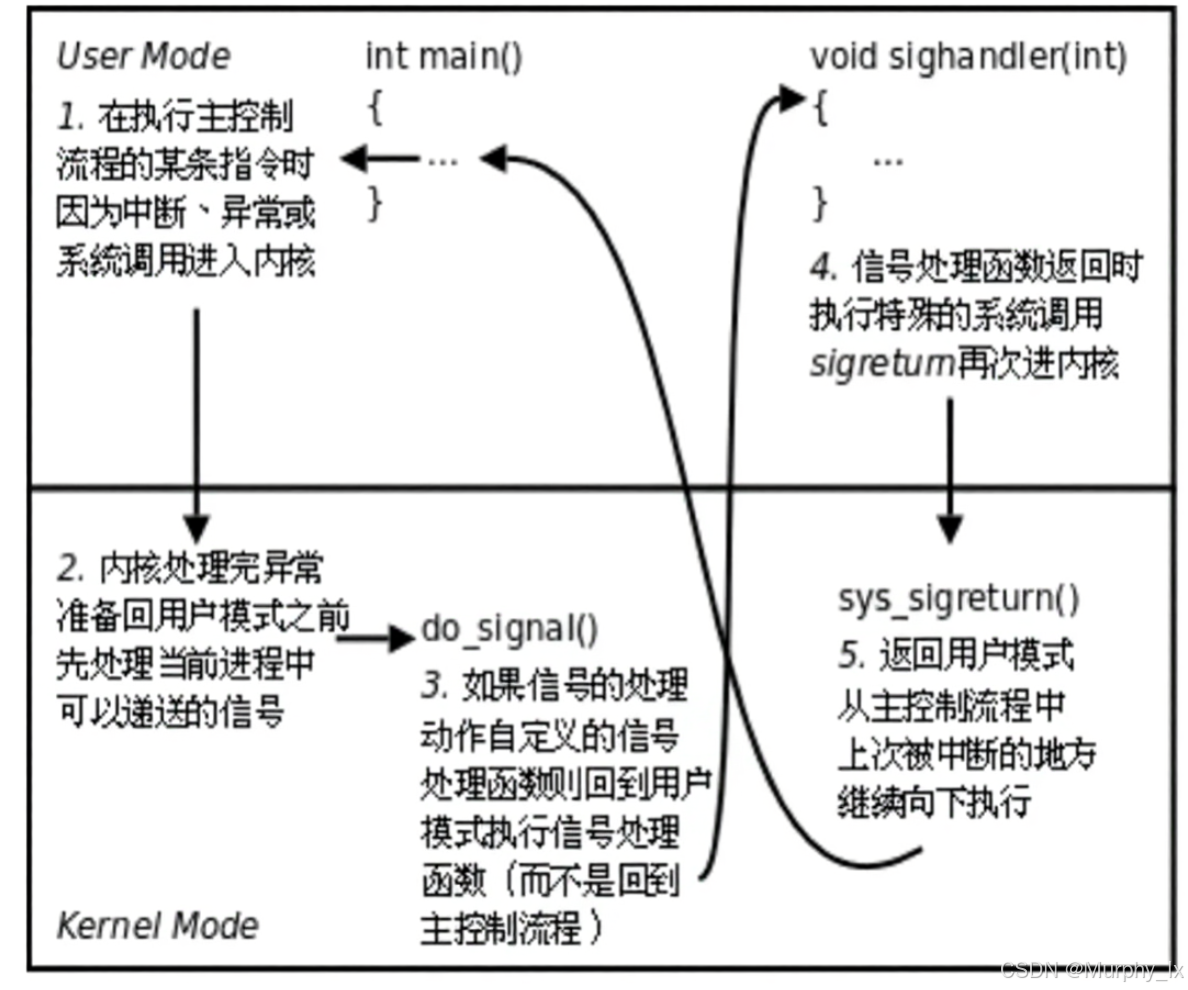

内核态-用户态之间切换次数

在信号处理过程中,如果是信号捕捉,会有几次内核态和用户态之间的切换?如果没有信号捕捉,又会有几次内核态和用户态之间的切换?

这是一个非常关键的问题,涉及到信号处理机制的性能开销和底层原理。信号处理过程中内核态与用户态之间的切换次数,直接影响了程序的响应速度和系统开销。让我们分情况详细分析:

情况一:无信号捕捉(默认处理或忽略)

流程与切换次数

- 用户态 -> 内核态 (第一次切换):

- 触发原因:信号产生(如其他进程调用

kill(),或内核检测到软件条件)。 - 动作:内核在目标进程的

task_struct中设置信号pending标志。 - 切换点:这通常发生在内核处理发送信号的系统调用 (

kill) 或检测到条件的内核路径中。对目标进程本身而言,这次切换是异步发生的,目标进程可能完全不知道。

- 触发原因:信号产生(如其他进程调用

- 内核态 -> 用户态 (第二次切换):

- 触发原因:目标进程在下次从内核态返回用户态时(例如系统调用返回、中断/异常处理完毕),内核检查到有待处理的信号。

- 动作:

- 默认终止/忽略 (SIG_DFL):内核直接执行默认动作(如终止进程)或清除忽略信号的

pending标志。 - 显式忽略 (SIG_IGN):内核直接清除

pending标志。

- 默认终止/忽略 (SIG_DFL):内核直接执行默认动作(如终止进程)或清除忽略信号的

- 切换点:内核完成信号处理后,恢复用户态上下文,

iret/sysret等指令返回用户态。 - 结果:进程继续执行用户态代码(忽略时),或被终止(默认终止时)。

总结 (无捕捉):共 2 次特权级切换。

- 第一次切换 (U->K):信号产生/记录(对目标进程是异步的)。

- 第二次切换 (K->U):信号递达处理(在目标进程的上下文切换路径中)。

情况二:有信号捕捉(自定义信号处理函数)

流程与切换次数 (核心流程)

- 用户态 -> 内核态 (第一次切换):

- 触发原因:同“无捕捉”情况。信号产生,内核设置

pending。 - 切换点:对目标进程异步发生。

- 触发原因:同“无捕捉”情况。信号产生,内核设置

- 内核态 -> 用户态 (第二次切换):

- 触发原因:目标进程在下次从内核态返回用户态时,内核检查到待处理信号。

- 动作:

- 内核发现该信号设置了自定义处理函数 (

sa_handler或sa_sigaction)。 - 内核精心构造用户态栈帧:将返回地址、寄存器状态等信息压入用户栈,使得

handler函数看起来像是被正常调用的。 - 将进程的指令指针 (EIP/RIP) 修改为

handler函数的入口地址。 - 设置栈指针指向新构造的栈帧。

- 内核发现该信号设置了自定义处理函数 (

- 切换点:内核通过

iret/sysret等指令“返回”用户态,但实际是跳转到handler函数。

- 用户态执行

handler函数:- 进程在用户态执行用户编写的信号处理代码。

- 注意:此时进程处于用户态。

- 用户态 -> 内核态 (第三次切换):

- 触发原因:

handler函数执行完毕,通过return语句返回。 - 底层动作:

return指令会跳转到栈上保存的返回地址。这个返回地址是内核预先设置的一个特殊入口(通常是__restore_rt或类似函数,属于glibc的一部分)。 - 切换点:

__restore_rt函数内部会执行一个特殊的系统调用rt_sigreturn。

- 触发原因:

- 内核态执行

rt_sigreturn:- 动作:内核的

sys_rt_sigreturn处理程序:- 从用户栈上恢复之前保存的原始上下文(包括寄存器、栈指针、指令指针等)。

- 清除与信号处理相关的临时状态。

- 动作:内核的

- 内核态 -> 用户态 (第四次切换):

- 触发原因:

rt_sigreturn系统调用执行完毕。 - 动作:内核使用恢复的原始上下文,通过

iret/sysret真正返回到被信号中断的原始用户态代码位置继续执行。 - 结果:进程仿佛从未被信号中断过一样,继续执行原来的代码。

- 触发原因:

总结 (有捕捉):共 4 次特权级切换。

- 第一次切换 (U->K):信号产生/记录(异步)。

- 第二次切换 (K->U):内核“返回”到用户态的自定义处理函数 (

handler)。 - 第三次切换 (U->K):处理函数返回,触发

rt_sigreturn系统调用。 - 第四次切换 (K->U):内核恢复原始上下文,真正返回到被中断点。

关键图解:有信号捕捉时的切换流程

重要说明与边界情况

- 切换的定义:这里的“切换”特指特权级 (CPL) 的变更,即通过

syscall/sysenter/int进入内核或通过iret/sysexit返回用户。在用户态或内核态内部执行代码不算一次切换。 - 信号产生的切换不计入目标进程? 严格来说,信号产生时(如

kill系统调用)的 U->K 切换发生在发送信号的进程上下文中。对于接收信号的进程,第一次有意义的切换是它自己因系统调用/中断进入内核时发现 pending 信号。但在计算目标进程因该信号而产生的总开销时,信号产生导致的内核操作(设置 pending)也是该信号处理的一部分。 - 嵌套信号处理:如果在执行一个信号处理函数 (

handler1) 时,进程又收到了另一个信号,并且该信号没有被阻塞,那么内核可能会中断handler1,切换到第二个信号的处理函数 (handler2)。这将导致额外的切换:handler1(用户态) -> 内核 (发现新信号) ->handler2(用户态) -> 内核 (rt_sigreturnfor handler2) -> 恢复handler1-> 内核 (rt_sigreturnfor handler1) -> 原始代码。- 这会显著增加切换次数(可能达到 6 次或更多)。

SA_RESTART与自动重启:如果使用sigaction设置了SA_RESTART标志,并且信号中断了一个可重启的系统调用(如read,write,accept),那么在信号处理完毕并返回后,内核会自动重启该系统调用。这发生在第 4 次切换 (K->U) 之后的内核逻辑中,不增加额外的特权级切换次数,但增加了内核的处理逻辑。

结论

- 无信号捕捉 (默认/忽略):信号处理导致目标进程发生 2 次 内核态/用户态切换。

- 有信号捕捉 (自定义处理函数):信号处理导致目标进程发生 4 次 内核态/用户态切换。

理解这些切换次数对于分析程序性能(尤其是高频信号场景)和调试复杂信号交互问题至关重要。额外的两次切换(进入和退出处理函数)是自定义信号处理的主要开销来源之一。

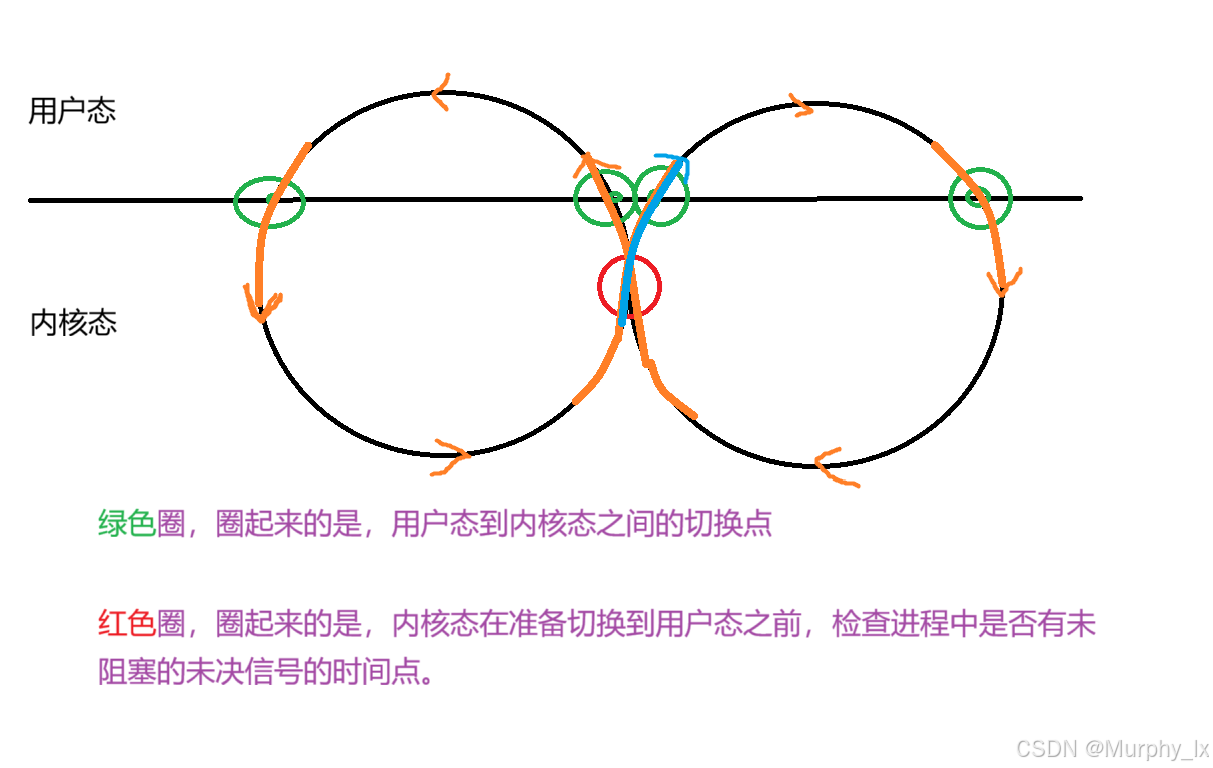

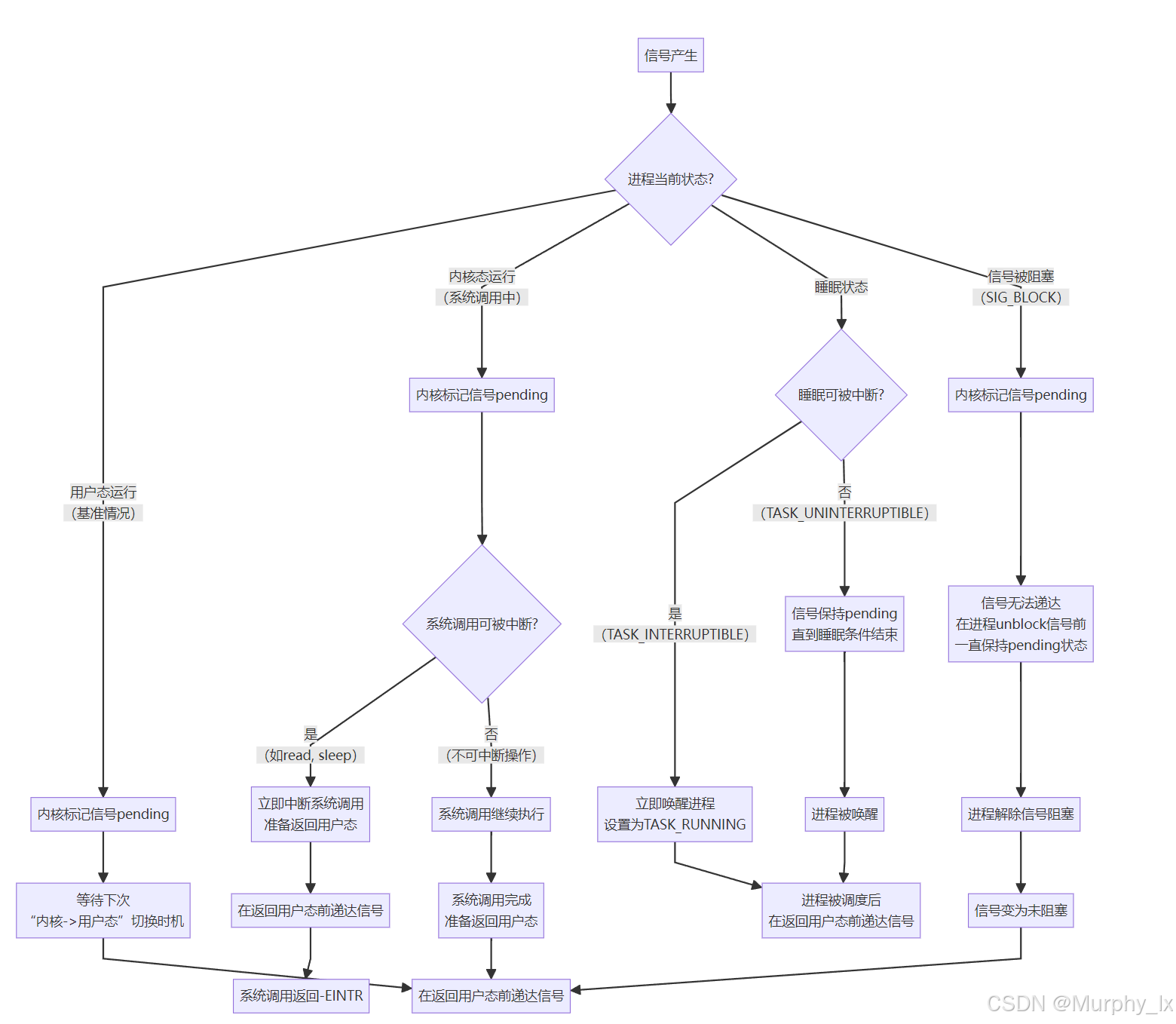

更多的场景

前一个例子是一个信号已经产生并被记录在进程的pending位图中。现在我的疑问就是如果进程的pending位图中并没有未决信号,也没有对任何信号设置阻塞,进程在执行过程中突然收到一条信号,信号从产生到递达的一个完整流程会有什么变化吗?如果是别的情况,又会有变化吗?

信号从产生到递达的流程,其核心框架是固定的,但具体的执行路径和时机确实会根据进程的当前状态和信号设置发生显著变化。

前面描述的情况——进程pending位图为空,无阻塞信号,突然收到信号——这恰恰是信号处理最标准、最典型的场景。我们以这个为基础,来详细分析各种情况下的流程变化。

基准情况:标准流程(你描述的情况)

这是最经典的场景。假设进程正在用户态执行 main函数中的代码。

- 信号产生:另一个进程调用

kill(pid, SIGUSR1)。 - 内核记录:内核在目标进程的

task_struct中将SIGUSR1对应的位设置为1(标记为待处理)。 - 寻找递达时机:由于进程正在运行,内核无法立即打断它(除非是硬件中断)。内核会等待一个“安全”的时机,即从内核态返回用户态的时刻。

- 递达信号:

- 不久后,发生了一次时钟中断。CPU陷入内核,执行调度器等代码。

- 在中断处理完毕,即将返回用户空间的前一刻,内核检查当前进程的待处理信号。

- 发现了

SIGUSR1,且该信号未被阻塞。 - 内核调用

do_signal()函数,开始递达流程(执行默认动作/忽略/调用处理函数)。

- 返回用户态:信号处理完毕后,进程返回到被中断的用户代码继续执行。

核心:信号递达的时机是“内核态 -> 用户态”的切换点。

情况变化分析:四种关键场景

下面的流程图清晰地展示了不同情况下信号处理路径的差异:

flowchart TDA[信号产生] --> B{进程当前状态?}B -- 用户态运行<br>(基准情况) --> C[内核标记信号pending]C --> D[等待下次<br>“内核->用户态”切换时机]D --> E[在返回用户态前递达信号]B -- 内核态运行<br>(系统调用中) --> F[内核标记信号pending]F --> G{系统调用可被中断?}G -- 是<br>(如read, sleep) --> H[立即中断系统调用<br>准备返回用户态]H --> I[在返回用户态前递达信号]I --> J[系统调用返回-EINTR]G -- 否<br>(不可中断操作) --> K[系统调用继续执行]K --> L[系统调用完成<br>准备返回用户态]L --> EB -- 睡眠状态 --> M{睡眠可被中断?}M -- 是<br>(TASK_INTERRUPTIBLE) --> N[立即唤醒进程<br>设置为TASK_RUNNING]N --> O[进程被调度后<br>在返回用户态前递达信号]M -- 否<br>(TASK_UNINTERRUPTIBLE) --> P[信号保持pending<br>直到睡眠条件结束]P --> Q[进程被唤醒]Q --> OB -- 信号被阻塞<br>(SIG_BLOCK) --> R[内核标记信号pending]R --> S[信号无法递达<br>在进程unblock信号前<br>一直保持pending状态]S --> T[进程解除信号阻塞]T --> U[信号变为未阻塞]U --> E

现在,我们根据这幅流程图,对每种情况进行详细解读。

场景一:进程正在执行一个系统调用(如在 read中等待终端输入)

这是最常见的变化之一。

- 流程变化:

- 信号产生,内核标记为pending。

- 内核发现进程正处于可中断的睡眠状态(TASK_INTERRUPTIBLE),并且该系统调用是可被信号中断的(如

read,write,sleep等)。 - 内核立即将进程状态设置为 TASK_RUNNING,并中断(取消)当前的系统调用。

- 系统调用返回一个错误

-1,并设置errno为 EINTR (Interrupted function call)。 - 随后,在返回用户态的路上,内核递达信号。

- 关键点:信号递达的时机早于基准情况。它没有等待下一次时钟中断,而是主动唤醒并中断了阻塞中的系统调用。这是编写健壮网络服务/驱动程序时必须处理的经典问题(需要检查

errno == EINTR并重试系统调用)。

场景二:进程处于不可中断的睡眠(TASK_UNINTERRUPTIBLE)

这种状态通常发生在进程等待底层硬件操作时(如磁盘I/O)。

- 流程变化:

- 信号产生,内核标记为pending。

- 内核发现进程处于 TASK_UNINTERRUPTIBLE 状态。信号无法中断这种睡眠。

- 信号会一直保持pending状态,直到磁盘I/O完成,进程被驱动程序唤醒。

- 进程被唤醒后,变为TASK_RUNNING。当它被调度执行并从内核态返回用户态时,信号才会被递达。

- 关键点:信号递达被严重延迟,直到引起睡眠的底层条件满足。这就是为什么你用

ps命令有时会看到状态为D(不可中断睡眠)的进程,即使用kill -9也杀不掉的原因。

场景三:信号被进程阻塞(在 sigprocmask中设置了 SIG_BLOCK)

这是对信号递达流程的主动控制。

- 流程变化:

- 信号产生,内核标记为pending。

- 内核检查信号掩码(blocked位图),发现该信号被阻塞。

- 内核不会递达该信号。信号将无限期地保持在pending状态。

- 只有当进程后续调用

sigprocmask解除了对该信号的阻塞,内核才会在下一个“内核态->用户态”的时机递达这个(现在已未阻塞的)信号。

- 关键点:阻塞(Block) 和 忽略(Ignore) 是不同的。

- 忽略(SIG_IGN):信号递达了,但处理动是“什么都不做”。

- 阻塞(SIG_BLOCK):信号根本不会被递达,它被卡在了pending阶段。这常用于保护代码的临界区,防止被信号打断。

总结

- 你的基准情况是标准流程:信号产生 -> 记录pending -> 在下次返用户态时递达。

- 进程状态和信号设置会改变递达的时机和行为:

- 系统调用中:可能导致系统调用被中断(返回EINTR)。

- 不可中断睡眠:导致信号递达被延迟,直到睡眠结束。

- 信号被阻塞:导致信号根本无法递达,直到解除阻塞。

如何确保一定会陷入内核?

也就是说进程每次从内核态返回到用户态的时候,都会去检查是否有信号需要处理。假设现在进程中的task_struct中的pending位图已经有一个未决信号来,而且没有被阻塞,要是进程没有陷入内核态,进程就不会有从内核态返回用户态的时刻,那信号岂不是不会被处理?怎么确保进程在接收到信号的时候,CPU一定会陷入内核呢?

推理完全正确:如果进程长时间运行在用户态,从不陷入内核态(比如执行一个非常耗时的纯计算循环),那么即使有未决且未阻塞的信号,内核也确实没有机会去检查和处理它,因为进程没有经历“从内核态返回用户态”这个关键时机。

那么,内核是如何确保信号最终能被及时处理,避免进程完全“屏蔽”信号的呢?答案在于中断(Interrupts),特别是时钟中断(Timer Interrupt)。

内核确保信号能被处理的机制

以下是内核确保信号能被处理的机制:

-

硬件中断的强制介入:

-

现代操作系统是多任务系统,CPU 时间被划分成很短的时间片(通常是几毫秒到几十毫秒),分配给不同的进程轮流执行。

-

这个时间片的划分和进程切换的触发,主要依靠硬件定时器产生的时钟中断(Timer Interrupt)。

-

无论进程当前是在用户态执行代码,还是在内核态执行系统调用,硬件中断(包括时钟中断)拥有最高的优先级。当硬件中断发生时:

- CPU 会立即暂停当前执行的指令流(无论是用户态还是内核态)。

- CPU 保存当前上下文(寄存器等)。

- CPU 跳转到内核预定义好的中断处理程序(Interrupt Service Routine, ISR) 执行。这个过程本身就是一种“陷入内核态”。

-

时钟中断(Timer Interrupt):

- CPU内置了一个硬件定时器(如x86的Local APIC定时器)。

- 操作系统内核在启动时会配置这个定时器,让它周期性地(例如每1ms、4ms或10ms,可配置)产生一个硬件中断(通常是IRQ 0)。

- 无论进程当前在用户态执行什么代码(即使是

while(1);),时钟中断都会强制打断它。CPU必须立即暂停当前指令流,保存现场,陷入内核态处理这个中断。

-

其他硬件中断(External Interrupts):

- 键盘按键、鼠标移动、网络数据包到达、磁盘I/O完成等外部事件都会由硬件(中断控制器)产生中断信号。

- 这些中断同样会强制打断用户进程的执行,陷入内核态。

-

-

中断处理与返回用户态:

- 内核的中断处理程序(比如时钟中断处理程序

tick_handle_periodic或类似函数)负责处理中断事件。对于时钟中断,其核心任务之一就是触发进程调度。 - 在中断处理程序的末尾,内核会进行调度决策:

- 如果当前进程的时间片用完,或者有更高优先级的进程就绪,内核会标记需要切换进程。

- 无论是否切换进程,最终内核都需要将控制权返还给某个进程(可能是当前进程,也可能是新选中的进程)。

- 关键点来了: 在将控制权返还给用户态进程之前(无论是返还给原进程还是切换到的新进程),内核执行路径都会走到那个关键的“返回用户态”的检查点。在这个检查点上,内核会执行我们之前讨论过的操作:

- 检查

pending & ~blocked。 - 如果有未决且未阻塞的信号,则进行信号递达处理(执行默认动作、忽略或调用用户注册的处理函数)。

- 然后才恢复用户态上下文,让进程继续执行。

- 检查

- 内核的中断处理程序(比如时钟中断处理程序

-

总结保证机制:

- 时钟中断是周期性的: 它每隔一个很短的时间间隔(由

HZ配置决定,通常是 100, 250, 1000 等,表示每秒中断次数)就会发生一次。 - 中断强制陷入内核: 时钟中断(以及其他可能的中断,如网络包到达、磁盘I/O完成)会强制打断用户态代码的执行,将CPU控制权交给内核的中断处理程序。

- 中断处理最终会触发返回用户态检查: 在处理完中断事件后,内核在准备将控制权交还给用户态进程时,必定会执行信号检查和处理流程。

- 时间片限制: 即使进程执行一个无限循环,时钟中断也会周期性地剥夺其CPU使用权。在剥夺后准备将CPU交给下一个进程(或交还给原进程)之前,都会进行信号检查。

- 时钟中断是周期性的: 它每隔一个很短的时间间隔(由

因此,时钟中断(以及所有其他硬件中断)是内核能够“闯入”用户态执行流,并在必要时进行信号处理(以及进程调度等关键任务)的基石。 它确保了:

- 没有进程能永久霸占CPU(公平调度)。

- 信号最终会被递达(通常在毫秒级延迟内)。

- 内核能维持对系统的整体控制。

信号递达的完整保障流程:

结合前面描述的场景(pending信号存在,未阻塞,进程在用户态运行),信号的递达如何被确保:

- 信号产生并标记Pending:进程B调用

kill(pid_A, SIGUSR1)。内核在进程A的task_struct->pending位图中设置SIGUSR1位。 - 进程A在用户态运行:进程A此时可能正在执行一个无限循环

while(1);,看起来“永不进入内核”。 - 时钟中断发生(必然发生):

- 硬件定时器到期,触发IRQ 0中断。

- CPU强制中断进程A的执行:

- 保存现场:CPU自动将进程A的用户态上下文(EIP/RIP, EFLAGS/RFLAGS, 通用寄存器等)压入进程A的内核栈。

- 切换特权级:CPU从用户态(Ring 3)切换到内核态(Ring 0)。

- 查找IDT:CPU根据中断向量号(IRQ 0对应某个向量号,如0x20)查找IDT,跳转到内核的时钟中断处理程序(如

timer_interrupt)。

- 内核处理时钟中断:

- 内核更新系统时间、进程A的CPU时间统计等。

- 检查时间片:内核检查进程A的时间片(time slice)是否用完。

- 时间片未用完:内核准备返回进程A继续执行。

- 时间片用完:内核将进程A的状态从

TASK_RUNNING改为TASK_RUNNABLE,放入运行队列尾部,并触发调度,选择另一个就绪进程运行。

- 关键点:信号检查! 无论是否触发调度,在离开时钟中断处理程序,准备返回用户空间之前,内核都会执行一个必经的检查点:

exit_to_user_mode_loop()(或类似函数)。在这里,内核会:- 检查当前进程(进程A)是否有待处理的信号(

pending位图)。 - 检查这些信号是否未被阻塞(

blocked位图)。 - 如果发现符合条件的信号(如SIGUSR1),则调用

do_signal()开始信号递达流程!

- 检查当前进程(进程A)是否有待处理的信号(

- 信号递达:

- 如果SIGUSR1是默认动作,内核可能直接终止进程A。

- 如果设置了忽略,内核清除pending位。

- 如果设置了自定义处理函数,内核构造用户态栈帧,修改返回地址指向

handler。

- 返回用户态:

- 内核通过

iret/sysret等指令恢复之前保存的上下文(或跳转到处理函数),返回到用户态。 - 进程A要么被终止,要么执行信号处理函数,要么继续原来的循环(如果信号被忽略)。

- 内核通过

总结:为什么信号永远不会“漏掉”

- 硬件中断的强制性:时钟中断(及其他硬件中断)是物理层面的事件,由CPU硬件触发。用户程序无法屏蔽或阻止它的发生(除非在极端的内核态禁用中断,但用户进程无此权限)。这确保了进程不可能永远停留在用户态。

- 中断返回路径的统一检查点:内核在每一次从内核态返回用户态之前(无论是系统调用返回、中断处理完毕、还是异常处理结束),都会执行信号检查逻辑。时钟中断处理完毕后的返回路径,就是这个检查点的完美载体。

- 时间片耗尽的调度:即使时钟中断没有直接导致信号递达(比如时间片未用完),当进程的时间片耗尽时,调度器也会剥夺其CPU。当该进程再次被调度回来时,它必然是从内核的调度器代码返回到用户态,此时同样会经过信号检查点。

结论

- 进程不可能永远“不陷入内核态”。硬件中断(尤其是时钟中断)会周期性地、强制性地打断用户态执行,将其拉入内核。

- 每一次从内核态返回用户态的机会,都是信号递达的窗口。内核利用这个统一的出口路径检查并处理信号。

- 因此,只要信号被设置为pending且未被阻塞,它最终一定会被递达。操作系统通过硬件和内核的协同设计,完美保障了信号机制的可靠性和实时性。

这个设计体现了操作系统内核作为系统资源管理者和仲裁者的核心角色:即使是最“顽固”的用户进程,也无法逃脱内核的监管和调度。信号作为进程间通信和事件通知的基石,其可靠性正是建立在这个精妙的设计之上。

信号产生的本质:内核态作为必经之路

具体内容(也就是关于信号的产生),都在信号2这节内容中。

在Linux系统中,所有信号的产生都必然伴随着CPU陷入内核态的操作。这是由操作系统作为资源管理者和硬件仲裁者的角色决定的。无论信号源于硬件异常、系统调用、终端控制还是软件条件,其产生路径都需经过内核的审核与中转。

一、硬件异常:CPU与内核的协同检测

-

指令执行与硬件检测

CPU执行单元(ALU算数逻辑单元 / MMU内存管理单元)在执行指令时会同步进行合法性检测:

- 算术单元检测除零操作(触发

SIGFPE) - 内存管理单元检测非法地址访问(触发

SIGSEGV) - 执行非法指令(触发

SIGILL)

- 算术单元检测除零操作(触发

-

异常触发与陷入内核

检测到异常后:

- CPU自动保存上下文(EIP/RIP, EFLAGS等)到内核栈

- 根据预定义的中断向量号(如x86中除零异常为0)陷入内核态

- 通过IDT(中断描述符表)定位异常处理程序

-

内核转换异常为信号

在异常处理程序中:

// 伪代码示意内核行为 void divide_error_handler() {struct task_struct *tsk = current; // 获取当前进程send_sig(SIGFPE, tsk, 0); // 发送信号tsk->thread.trap_nr = X86_TRAP_DE; // 记录异常类型 }关键转换:硬件异常被抽象为软件信号(如

SIGFPE),挂载到进程的pending位图

二、系统调用:主动陷入内核的通道

-

系统调用入口

进程通过

syscall/int 0x80等指令主动陷入内核:mov eax, 1 ; sys_exit 调用号 int 0x80 ; 陷入内核 -

信号产生的两种场景:

- 直接产生:调用

kill(),tkill()等系统调用 - 间接产生:执行其他系统调用时触发条件(如

write()发现管道破裂)

- 直接产生:调用

三、终端控制:硬件中断驱动信号

-

终端输入触发中断

用户按下

Ctrl+C(SIGINT)或Ctrl+Z(SIGTSTP):- 键盘控制器产生IRQ 1中断

- CPU陷入内核执行终端驱动处理程序

-

信号生成逻辑

在终端驱动中:

// drivers/tty/tty_io.c if (c == INTR_CHAR(tty)) { // 检测Ctrl+Csignal_pending(current); // 向前台进程组发送SIGINT }

四、软件条件:内核的主动监控

以管道破裂(SIGPIPE)为例:

-

系统调用中的条件检测

当进程执行

write()系统调用时:CPU根据系统调用号,在系统调用表中找到对应的内核函数,例如

sys_write。内核的

sys_write函数开始执行。它根据文件描述符pipe_fd,找到对应的内核数据结构(struct file)。这个结构体包含一个指向文件操作函数表的指针(file_operations)。- 关键细节:对于普通文件、套接字、管道,这个函数表是不同的。对于管道,其写操作函数指向一个特定的函数,比如

pipe_write。

内核调用

pipe_write函数。这个函数的核心工作是:将用户空间的数据拷贝到内核的管道缓冲区(一个环形缓冲区)中。但在执行拷贝之前和之中,它必须进行一系列状态检查。正是在这里,软件条件被检测到。

// fs/pipe.c static ssize_t pipe_write(...) {if (pipe->readers == 0) { // 检测读端关闭send_sig(SIGPIPE, current, 0); // 发送信号return -EPIPE; // 返回错误}// ...正常写入逻辑... } - 关键细节:对于普通文件、套接字、管道,这个函数表是不同的。对于管道,其写操作函数指向一个特定的函数,比如

-

内核的主动管理角色

内核持续监控资源状态(管道读端计数、定时器超时、子进程退出等),在条件满足时主动决策发送信号,体现其资源管理职责。

信号处理的时效性保障

在未阻塞信号的情况下,信号的快速处理依赖于两个机制:

-

中断驱动的强制陷入

即使进程执行纯用户态计算(如

while(1);),时钟中断会周期性(通常1-10ms)强制CPU陷入内核:timelinetitle 时钟中断保障信号处理用户态执行 --> 时钟中断触发 --> 陷入内核态 --> 检查信号 --> 递达信号 -

统一的返回路径检查

内核在所有返回用户态的路径上(系统调用返回/中断处理结束)都会执行信号检查:

// arch/x86/kernel/signal.c void exit_to_user_mode_prepare(...) {if (test_thread_flag(TIF_SIGPENDING)) // 检查信号挂起do_signal(regs); // 处理信号 }

结论:信号与内核态的不可分割性

- 产生必然性:四种信号产生方式均需通过内核态实现,这是因信号本质是内核管理的进程间事件通知机制

- 处理保障性:通过硬件中断(时钟/外设)和系统调用返回路径,确保未阻塞信号总能被及时递达

- 设计哲学:体现了Linux的异步事件处理模型——硬件事件→内核抽象→用户态通知

关键洞察:信号机制是操作系统"受控陷入"理念的典范——用户程序通过有限的内核入口获得系统服务,内核则通过统一出口(返回用户态前)实现事件分发。这种设计平衡了效率与安全性,使信号成为Unix哲学中"一切皆事件"的核心载体。

所以在一般情况下,进程没有对信号设置阻塞的情况下,当进程接收到信号的时候,一般都是可以很快速的处理掉这个信号的。

信号捕捉时为何要从内核态转变为用户态

为什么系统检测到有信号捕捉的时候,要从内核态转变为用户态去执行处理函数?而没有信号捕捉的时候,则可以在内核状态下直接执行默认动作。

这个问题,触及了操作系统设计中特权级隔离和用户空间自主性的核心原则。让我们从多个层面剖析这个设计决策背后的逻辑:

一、安全边界:用户态与内核态的严格隔离(根本原因)

-

Ring 0 与 Ring 3 的鸿沟

CPU通过特权级(Ring 0-3)实现硬件级隔离:

- 内核态 (Ring 0):可执行任何指令,访问所有内存

- 用户态 (Ring 3):受限指令集,只能访问用户空间内存

-

信号处理函数的本质

用户注册的信号处理函数(如

handler())是:- 位于用户空间的代码

- 可能调用任意用户态函数(如

printf(),malloc()) - 可能包含漏洞甚至恶意代码

-

内核的保护职责

若在内核态直接执行用户代码:

// 伪代码:危险的内核行为(实际不存在) void do_signal() {if (signal == SIGUSR1) {current->handler(); // 在内核态执行用户代码!} }灾难性后果:

- 用户代码可能执行特权指令(如

cli禁用中断) - 可能覆盖内核数据结构导致系统崩溃

- 绕过安全检查实施攻击(如提权漏洞)

- 用户代码可能执行特权指令(如

二、设计哲学:最小特权原则的贯彻

-

内核的自我约束

内核遵循"只做必要之事"的原则:

- 默认动作(终止/忽略/暂停)是可预测的有限操作

- 执行这些动作不需要离开内核态

信号处理类型 所需特权 执行位置 终止进程 内核资源回收权限 内核态 忽略信号 清除pending位 内核态 暂停进程 修改进程状态 内核态 自定义处理 执行任意用户代码 必须用户态 -

用户空间的自主权

自定义信号处理是进程的私有行为:

- 处理逻辑可能涉及进程特有的数据结构

- 可能需要调用进程自定义的库函数

- 内核不应(也无法)理解这些用户级语义

三、技术实现:用户态执行的必要性

-

栈空间的隔离

- 内核栈:固定大小(通常8-16KB),用于中断处理等

- 用户栈:动态扩展(可能GB级),适合处理函数递归调用

若在内核态执行处理函数:

// 危险示例:用户处理函数导致内核栈溢出 void deep_recursion() {char buf[1024];deep_recursion(); // 无限递归 }内核栈溢出将导致不可恢复的系统崩溃。

-

内存访问的合法性

用户处理函数可能访问:

- 进程的全局变量(位于用户空间)

- 动态链接库的代码段

- 通过

dlopen()加载的插件

这些地址在内核态是不可见的(CPU在Ring 0时,用户空间地址未映射)。

-

系统调用的支持

常见信号处理中需要:

void handler(int sig) {write(log_fd, "Signal received!", 16); // 需要系统调用kill(other_pid, SIGCONT); // 需要系统调用 }这些操作必须通过合法的syscall入口进入内核,而非直接在内核态调用。

四、对比分析:为什么默认动作可在内核完成

-

终止进程 (SIGKILL/SIGTERM)

// 内核实现代码(简化) do_exit(exit_code) {release_resources(); // 释放内存/文件等notify_parent(); // 发送SIGCHLD给父进程schedule(); // 切换新进程 }- 完全依赖内核管理的资源

- 无需接触用户空间数据

-

忽略信号 (SIGIGN)

只需清除pending位:

sigdelset(¤t->pending, SIGUSR1);- 纯内核数据结构操作

- 不涉及任何用户空间

-

暂停进程 (SIGSTOP)

修改进程状态即可:

current->state = TASK_STOPPED; schedule();

五、架构设计:信号递达的精确流程

结论:安全与自由的平衡艺术

-

安全边界不可逾越

用户代码永远不能在内核态执行——这是CPU硬件和操作系统设计的铁律。

-

内核的自我克制

内核仅处理与资源管理相关的原子操作(终止/暂停),将业务逻辑交还用户空间。

-

用户空间的完整性

信号处理函数作为进程的一部分,必须在进程自己的执行环境(用户态)中运行,才能:

- 正确访问进程内存

- 安全调用库函数

- 通过合法途径使用系统调用

这种设计完美体现了Unix哲学的"机制与策略分离":

- 内核提供机制:信号传递框架

- 用户决定策略:自定义处理逻辑

内核究竟是什么东西?

为什么有的操作要陷入内核态处理?是谁陷入内核态?是CPU还是操作系统本身亦或者说是进程?如何理解陷入内核态这个动作?内核究竟是什么东西?

一、为什么需要陷入内核态?——特权级的必要性

-

硬件层面的保护需求

CPU设计者通过特权级(Privilege Levels)实现硬件级隔离:

- Ring 0(内核态):可执行所有指令(如

HLT停机、IN/OUT端口访问) - Ring 3(用户态):受限指令集,禁止直接操作硬件

操作类型 用户态 内核态 典型场景 访问物理内存 ❌ ✅ 内存分配 修改页表 ❌ ✅ 进程切换 执行I/O指令 ❌ ✅ 读写磁盘 禁用中断 ❌ ✅ 临界区保护 调用系统函数 ✅ ✅ 用户程序逻辑 - Ring 0(内核态):可执行所有指令(如

-

软件层面的安全需求

若允许用户程序直接操作硬件:

// 灾难性伪代码:用户程序直接操作硬盘 void user_program() {disk_write(0, "格式化整个磁盘"); // 若允许将导致系统毁灭 }内核作为受信任的中介,确保:

- 文件操作只能访问授权区域

- 网络数据需经协议栈过滤

- 内存访问不越界

二、谁陷入内核态?——执行主体的转变

-

执行体的切换

- CPU硬件:执行特权级切换的物理动作

- 进程上下文:当前运行的进程触发切换

- 内核代码:最终执行内核空间的指令

-

关键理解

- 进程是载体:进程通过

syscall发起请求,但不执行内核代码 - CPU是执行者:CPU实际读取并执行内核内存中的指令

- 内核是服务提供方:内核空间存放操作系统核心代码

- 进程是载体:进程通过

三、如何理解"陷入"(Trap)?——特权切换的微观过程

以x86架构的syscall指令为例:

; 用户态发起系统调用

mov rax, 1 ; 系统调用号(sys_exit)

syscall ; 触发陷入; CPU硬件自动完成:

; 1. 将RIP保存到RCX

; 2. 从MSR寄存器加载内核入口地址到RIP

; 3. 将特权级切换到Ring 0

; 4. 将栈指针切换到内核栈

完整切换流程:

- 保存现场:CPU自动保存

RIP、RSP、RFLAGS到内核栈 - 切换环境:

- 加载

CS段寄存器为内核代码段 - 加载

SS为内核数据段

- 加载

- 权限升级:CPL(当前特权级)从3变为0

- 执行跳转:开始执行

entry_SYSCALL_64等内核入口代码

关键洞察:陷入是受控的硬件行为,如同电梯从公共区域(用户层)进入受限区域(设备层),需要专用钥匙(特权指令)和安保检查(权限验证)。

四、内核究竟是什么?——多维度的本质解读

1. 物理视角:常驻内存的二进制代码

- 位置:加载到物理内存的

0x100000以上区域(x86) - 大小:现代内核约10-50MB(如Linux vmlinuz)

- 特征:启动后始终驻留,不被换出

2. 逻辑视角:资源管理的服务集合

// 内核服务的抽象接口

struct kernel_services {memory_manager_t *mm; // 内存管理scheduler_t *sched; // 进程调度vfs_t *filesystem; // 文件系统net_stack_t *network; // 网络协议栈driver_interface_t *drv; // 设备驱动

};

3. 运行时视角:事件驱动的状态机

内核本质是中断驱动的有限状态机:

4. 代码视角:C语言与汇编的混合体

-

核心组件:

/arch # CPU架构相关代码(汇编/C) /mm # 内存管理(页分配器、SLAB) /kernel # 进程调度、信号处理 /drivers # 设备驱动(占内核代码70%) /fs # 文件系统(ext4, procfs等) /net # 网络协议栈(TCP/IP)

五、信号处理全流程示例:SIGCHLD的旅程

终极答案:内核的本质是资源仲裁者

- 物理存在:内存中的二进制代码 + 数据结构

- 逻辑角色:硬件与应用程序之间的可信中介

- 运行方式:通过中断/异常触发的事件处理器

- 设计哲学:实现受控共享(Controlled Sharing)

- 时间共享:CPU分时复用(调度器)

- 空间共享:内存虚拟化(MMU)

- 设备共享:统一驱动接口

正如有些人所言:

“All problems in computer science can be solved by another level of indirection.”:“计算机科学中的所有问题都可以通过增加一个间接层来解决。”

内核正是通过"陷入"这个间接层,在用户程序与硬件之间构建了安全、高效的抽象屏障。

个人理解

粗略的看,我们可以简单的把陷入内核态,或者用户态切换为内核态理解为:CPU执行权限从3级权限切换到0级权限,CPU在切换为0级权限的时候,可以执行内核的代码,其实也就是操作系统的代码嘛。

内核态切换为用户态,其实可以理解为:CPU的执行权限由0变3。这个时候CPU只能执行用户层面的代码(指令),不能执行内核区域的代码。

用户态 → 内核态切换的本质

- 权限升级:CPU 的当前特权级 (CPL) 从 Ring 3(用户态)→ Ring 0(内核态)

- Ring 3:受限权限,禁止执行特权指令(如修改页表、停机指令

HLT) - Ring 0:最高权限,可执行所有指令,访问全部内存空间

- Ring 3:受限权限,禁止执行特权指令(如修改页表、停机指令

- 代码执行范围变化:

- ✅ 内核态下:CPU 可执行内核代码段中的指令(位于高地址空间,如

0xffffffff80000000) - ❌ 用户态下:CPU 无法访问内核代码段(硬件强制隔离)

- ✅ 内核态下:CPU 可执行内核代码段中的指令(位于高地址空间,如

// 用户态尝试执行内核代码将触发异常

void user_program() {void (*kernel_func)() = (void*)0xffffffff81000000;kernel_func(); // 触发 #GP 异常(General Protection Fault)!

}

内核态 → 用户态切换的本质

- 权限降级:CPL 从 Ring 0 → Ring 3

- 内存访问限制:

- ✅ 用户态下:CPU 只能访问用户空间地址(如

0x400000) - ❌ 内核态下:CPU 可访问全部地址空间(用户空间+内核空间)

- ✅ 用户态下:CPU 只能访问用户空间地址(如

关键验证:从硬件视角看隔离机制

-

代码段权限检查:

-

CPU 通过 CS 寄存器中的 RPL(请求特权级) 与代码段描述符中的 DPL(描述符特权级) 比对:

if (RPL > DPL) { // 例如用户态(RPL=3)访问内核段(DPL=0)trigger #GP_fault(); // 拒绝访问! }

-

-

页表权限控制:

- 内核空间的页表项标记为

Supervisor Only(如 x86 的U/S=0) - 用户态访问时触发 #PF(Page Fault)异常

- 内核空间的页表项标记为

为什么必须切换?—— 一个类比解释

想象一座安全大楼:

- 用户态 (Ring 3):普通办公区(员工可自由活动,但禁止进入机房)

- 内核态 (Ring 0):核心机房(需刷卡进入,内含服务器和电闸)

- 系统调用:如同按下"紧急服务按钮" → 保安(CPU)带你进入机房处理请求

- 返回用户态:处理完成后保安送你回办公区,并锁上机房大门

信号处理中的特权切换实战

当进程收到信号且需执行自定义处理函数时:

📌 注意:一次信号处理可能引发多次特权切换(如图中的 🔁)

总结:

- 内核态 (Ring 0) = 特权全开模式 → 可执行内核代码

- 用户态 (Ring 3) = 监狱模式 → 仅能执行用户空间代码

- 切换动作 = 硬件控制的权限升降级(通过

syscall/iret等指令)

这种设计是操作系统安全的基石—— 即使用户程序崩溃或恶意操作,也无法直接破坏内核(这也是为什么 Windows 蓝屏/Linux kernel panic 远比程序崩溃严重的原因)。

如何区分用户态和内核态?

计算机内部是如何区分用户态和内核态的,有什么权限标志吗?从底层硬件,到软件层面是如何表现的。

一、硬件基石:CPU特权级(Privilege Levels)

1. 核心机制:特权环(Ring Architecture)

- x86架构:定义了4个特权级(Ring 0 ~ Ring 3)

- Ring 0:最高权限 → 内核态

- Ring 1-2:历史遗留(现代OS通常不用)

- Ring 3:最低权限 → 用户态

- ARM架构:类似概念(EL0=用户态, EL1=内核态, EL2/3=虚拟化/安全监控)

2. 硬件标志寄存器

- 关键寄存器:

CS(Code Segment Register,代码段寄存器) - 权限标识位:

CS寄存器的低2位称为 CPL(Current Privilege Level)CPL=0→ 当前运行在内核态(Ring 0)CPL=3→ 当前运行在用户态(Ring 3)

示例:当CPU执行用户程序时,

CS=0x1B(二进制0001111,末两位=3),执行内核代码时CS=0x08(二进制0000100,末两位=0)。

二、内存访问控制:分段与分页机制

1. 段描述符特权级(DPL)

-

全局描述符表(GDT):存储所有内存段的描述符

-

段描述符结构:

struct segment_descriptor {uint16_t limit_low; // 段界限低16位uint16_t base_low; // 段基址低16位uint8_t base_mid; // 段基址中8位uint8_t type : 4; // 段类型(代码/数据)uint8_t s : 1; // 系统段标志uint8_t dpl : 2; // **描述符特权级(DPL)** ← 核心!uint8_t p : 1; // 段存在标志uint8_t limit_high : 4;uint8_t avl : 1;uint8_t l : 1; // 64位代码段标志uint8_t d : 1; // 默认操作大小uint8_t g : 1; // 粒度标志uint8_t base_high; // 段基址高8位 }; -

访问规则:

if (CPL <= DPL)才允许访问该内存段(用户态CPL=3 > 内核段DPL → 禁止访问)

2. 页表权限位(分页机制)

- 页表项(PTE)控制位:

U/S(User/Supervisor)位:0= 仅内核态可访问(Supervisor)1= 用户态可访问(User)

R/W(Read/Write)位:0= 只读1= 可读写

- 访问规则:

- 用户态访问

U/S=0的页面 → 触发 #PF(Page Fault)异常 - 用户态写

R/W=0的页面 → 触发 #PF异常

- 用户态访问

示例:内核代码段所在页面的PTE中

U/S=0,用户程序访问时触发异常。

三、指令执行控制:特权指令拦截

1. 特权指令白名单

-

Ring 0专属指令(用户态执行会触发 #GP 异常):

cli ; 禁用中断(影响系统调度) sti ; 启用中断 lgdt ; 加载GDT寄存器(篡改内存映射) wrmsr ; 写模型专用寄存器(修改CPU行为) in/out ; 直接访问I/O端口(操作硬件)

2. 指令执行时的硬件检查

CPU在执行每条指令前自动验证:

if (is_privileged_instruction(opcode) && (CPL != 0)) {trigger_GPFault(); // 触发#GP异常

}

四、软件协同:操作系统的桥梁作用

1. 系统调用门(Syscall Gate)

-

陷入内核的合法入口:

; Linux x86-64系统调用示例 mov rax, 1 ; 系统调用号(sys_exit) syscall ; 硬件自动切换至Ring 0 -

幕后动作:

- CPU将

CS替换为预设的内核代码段(CPL=0) - 将

RIP指向内核入口(如entry_SYSCALL_64) - 栈指针切换到内核栈

- CPU将

2. 中断描述符表(IDT)

-

硬件中断路由表:

struct idt_entry {uint16_t offset_low; // 处理程序地址低16位uint16_t selector; // 目标代码段选择子(含CPL)uint8_t ist : 3; // 中断栈表索引uint8_t zero : 5;uint8_t type : 4; // 门类型(中断/陷阱)uint8_t s : 1; // 存储段标志uint8_t dpl : 2; // **访问此中断门所需最低特权级**uint8_t p : 1; // 存在标志uint16_t offset_mid; // 地址中16位uint32_t offset_high; // 地址高32位uint32_t reserved; }; -

关键字段:

dpl决定哪些特权级可触发此中断(如键盘中断DPL=3,允许用户态触发)

五、状态切换的完整流程(以系统调用为例)

六、用户态与内核态的直观对比

| 特性 | 用户态 (Ring 3) | 内核态 (Ring 0) |

|---|---|---|

| CPL值 | 3 | 0 |

| 内存访问 | 仅用户空间 (U/S=1的页面) | 全部空间 (包括内核页) |

| 指令权限 | 禁止执行特权指令 | 可执行所有指令 |

| 中断控制 | 不可屏蔽中断 | 可禁用中断 (cli/sti) |

| I/O操作 | 禁止直接访问 | 可直接操作硬件端口 |

| 页表修改 | 禁止 | 可修改CR3寄存器切换页表 |

| 耗时 | 纳秒级切换 | 微秒级上下文保存 |

总结:权限控制的本质

- 硬件标记:

CPL(当前特权级)是CPU的实时状态标志 - 访问控制:

- 分段机制 → 通过

DPL限制段访问 - 分页机制 → 通过

U/S位隔离内存空间

- 分段机制 → 通过

- 指令防火墙:CPU硬件拦截非法特权指令

- 安全通道:系统调用/中断提供受控陷入入口

最终效果:

当你在Linux中运行 ./a.out时,CPU的 CPL在用户代码执行期间始终为3。一旦调用 write(),syscall指令将 CPL瞬间切换为0,CPU开始执行内核中 fs/read_write.c的代码。返回用户态时,sysret又将 CPL改回3——如同穿过一道只有内核持有钥匙的安全门。

操作系统是怎么随时控制任意进程的?

操作系统是怎么随时控制任意进程的?为什么进程无论如何切换,都能找到操作系统?怎么做到的?这和虚拟内存空间中内核内存那段区域有什么关系吗?是将操作系统(内核)的代码都映射给了每一个进程吗?

一、硬件基石:CPU的忠诚守卫

1. 中断向量表(IDT)的永恒存在

- 物理地址绑定:CPU的

IDTR寄存器永远指向内核的中断描述符表(IDT)物理地址 - 不可篡改性:用户进程无法修改

IDTR(特权指令LIDT只能在Ring 0执行) - 中断响应:无论运行哪个进程,硬件中断(时钟/键盘)都会强制跳转到IDT指定的内核代码

如同每个公民都知道110报警电话,CPU永远知道如何呼叫内核

2. 系统调用门的统一入口

-

MSR寄存器:x86的

MSR_LSTAR寄存器存储syscall入口地址(内核启动时设置) -

执行不可逆:

; 用户进程执行 mov rax, 60 ; sys_exit syscall ; 硬件自动跳转到MSR_LSTAR指向的内核代码

二、内存魔法:内核空间的全局映射

1. 虚拟内存的精妙设计

每个进程的虚拟地址空间布局:

0x0000000000000000 - 0x00007FFFFFFFFFFF : 用户空间(进程独享)

0xFFFF800000000000 - 0xFFFFFFFFFFFFFFFF : 内核空间(所有进程共享)

关键:高地址的内核区域在所有进程的页表中映射到相同的物理内存

2. 内核镜像的物理唯一性

-

启动时加载:内核镜像(

vmlinuz)在启动时加载到物理内存固定区域(如0x100000) -

全局页表项:

// 所有进程的页表共享项 for (each process) {map_virtual(0xFFFF800000000000, PHYS_KERNEL_BASE); } -

效果:当进程A访问

0xFFFF800012345678时,与进程B访问相同地址,实际访问的都是同一块物理内存中的内核代码

三、进程控制块(PCB):操作系统的提线木偶

1. 内核的上帝视角

-

task_struct链:内核维护全局链表记录所有进程struct task_struct {pid_t pid;struct mm_struct *mm; // 内存管理结构struct files_struct *fs; // 文件系统信息// ... 其他300+字段 ...struct list_head tasks; // 全局链表指针 }; -

物理存储:所有

task_struct都存放在内核空间(用户进程无法直接访问)

2. 调度器的绝对控制

调度流程:

关键:进程切换的本质是用新进程的task_struct覆盖CPU寄存器

我想澄清一下,原流程图中的表述“保存ProcA寄存器到task_struct”实际上是正确的,只是可能不够精确。让我详细解释一下进程切换的完整流程,以避免误解。

进程切换的正确流程

在操作系统中,进程切换(上下文切换)涉及以下步骤:

- 保存当前进程的上下文:当从进程A切换到进程B时,内核首先将进程A的CPU寄存器状态(如EAX、EBX、EIP、ESP等)保存到进程A的进程控制块(即

task_struct)中。这是因为task_struct包含一个字段(如thread_struct)专门用于存储寄存器快照。 - 加载下一个进程的上下文:然后,内核从进程B的

task_struct中恢复之前保存的寄存器值到CPU寄存器中,使进程B从上次中断点继续执行。

所以,原话“保存ProcA寄存器到task_struct”是一种简化的表述,意思是“保存ProcA的寄存器状态到ProcA的task_struct中”。

为什么原流程图的表述可以接受?

- 在操作系统术语中,“保存寄存器到task_struct”是常见说法,强调将CPU状态备份到进程描述符中。流程图通常简化语言以突出关键动作。

- 完整的流程应该是:“保存ProcA的寄存器到ProcA的task_struct” → “加载ProcB的task_struct中的寄存器到CPU”。

如何改进理解?

如果大家觉得原话模糊,可以更精确地理解为:

- “保存ProcA的寄存器状态到其task_struct”

- 或“将ProcA的上下文保存到task_struct”

这样能避免歧义。

四、系统调用:受控的入口闸门

1. 陷入内核的标准化路径

// 用户空间封装

int write(int fd, const void *buf, size_t count) {long ret;asm volatile ("mov $1, %%rax\n" // 系统调用号"syscall": "=a"(ret): "D"(fd), "S"(buf), "d"(count));return ret;

}

2. 内核的统一分发

// 内核系统调用表

static const sys_call_ptr_t sys_call_table[] = {[0] = sys_read,[1] = sys_write, // 指向真正的写处理函数[2] = sys_open,// ...

};// 系统调用入口(arch/x86/entry/entry_64.S)

entry_SYSCALL_64:swapgs // 切换到内核GS寄存器mov %rsp, PER_CPU_VAR(kernel_stack) // 切换到内核栈call do_syscall_64 // 跳转到C语言处理

五、为什么进程永远无法逃脱?

1. 三重保险机制

| 控制层 | 实现方式 | 逃逸后果 |

|---|---|---|

| 硬件中断 | 时钟中断强制剥夺CPU | 系统失去实时性 |

| 内存隔离 | 用户/内核空间硬件隔离 | 进程篡改内核导致崩溃 |

| 调度器权威 | task_struct控制执行流 | 进程永久占用CPU |

2. 虚拟内存的致命约束

用户进程尝试直接访问内核地址:

mov rax, [0xffffffff81000000] ; 尝试读取内核代码

将触发:

- MMU检查页表 → 用户态访问

U/S=0页面 → #PF 缺页异常 - CPU陷入内核执行

do_page_fault() - 内核发送

SIGSEGV杀死进程

六、全景架构图

结论:操作系统的三位一体控制

- 硬件囚笼

- 特权级隔离(Ring 0/3)

- 内存管理单元(MMU)强制分域

- 中断控制器接管CPU

- 内存镜像

- 内核代码物理单例 + 全局虚拟映射

- 进程控制块存储在内核空间

- 调度权威

- 通过保存/恢复

task_struct控制执行流 - 系统调用提供唯一合法入口

- 通过保存/恢复

最终效果:

当你在Linux中运行 ./hello时,进程以为自己独占CPU,实则每一步都在内核监控下——如同《楚门的世界》中的演员,看似自由却活在导演(内核)精心构建的牢笼中。这种"受控的幻觉",正是现代操作系统的伟大设计精髓。

操作系统是如何正常运行起来的?

操作系统是如何正常运行起来的?是谁让操作系统一直运行着的?

让我们用一个具体的例子——x86架构的Linux系统启动过程,来详细讲解操作系统是如何从"死寂的硬件"变成"活着的系统管理者"的。

第一阶段:BIOS/UEFI - 唤醒沉睡的巨人

场景:按下电源按钮

具体过程:

- CPU硬复位:电源接通后,CPU的

RESET引脚被触发,所有寄存器设为默认值 - 第一条指令:x86 CPU从地址

0xFFFFFFF0(ROM BIOS区域)取出第一条指令JMP F000:E05B - BIOS执行:CPU开始在ROM中执行BIOS代码,进行:

- POST(电源自检):检查内存、硬盘等硬件

- 硬件初始化:设置显卡、键盘控制器等

- 启动设备选择:按配置顺序尝试读取设备的第一个扇区(MBR)

第二阶段:Bootloader - 找到操作系统入口

GRUB Bootloader的工作

GRUB Bootloader 是大多数 Linux 发行版默认的启动引导程序

// 简化版GRUB启动流程

void grub_main() {// 1. 从磁盘加载内核映像vmlinuz到内存load_kernel_image(0x100000); // 加载到1MB地址// 2. 解析initrd(初始内存文件系统)load_initrd(0x2000000);// 3. 设置内核启动参数setup_boot_params();// 4. 跳转到内核入口点jump_to_kernel_entry();

}

关键步骤:

- 保护模式切换:GRUB将CPU从16位实模式切换到32位保护模式

- 内核加载:将压缩的内核映像

vmlinuz从磁盘读到内存0x100000地址 - 移交控制权:执行

jmp 0x100000跳转到内核代码

第三阶段:内核初始化 - 构建操作系统大厦

Linux内核启动流程(arch/x86/boot/header.S)

_start:.byte 0xeb, 0x48 ; 跳转到实际入口.ascii "HdrS" ; 魔数签名.word 0x0206 ; 协议版本entry:cli ; 禁用中断movw $0x2000, %ax ; 设置栈段movw %ax, %ssmovl $0x8000, %esp ; 设置栈指针; 解压内核到高位内存call decompress_kernel; 跳转到解压后的内核jmp protected_mode_entry

内核C语言入口:start_kernel()

// init/main.c - 操作系统"主函数"

asmlinkage __visible void __init start_kernel(void)

{// 1. 早期初始化setup_arch(&command_line); // 架构相关初始化trap_init(); // 设置中断描述符表IDTmm_init(); // 内存管理初始化// 2. 核心子系统sched_init(); // 调度器初始化time_init(); // 时钟系统初始化proc_root_init(); // proc文件系统// 3. 驱动初始化console_init(); // 控制台显示rest_init(); // 创建init进程

}

关键初始化:

| 子系统 | 初始化函数 | 作用 |

|---|---|---|

| 中断系统 | trap_init() | 设置#DE、#PF等异常处理 |

| 内存管理 | mm_init() | 建立页表、初始化buddy分配器 |

| 进程调度 | sched_init() | 初始化运行队列、创建idle进程 |

| 文件系统 | vfs_caches_init() | 初始化虚拟文件系统 |

第四阶段:创建第一个用户进程 - init的诞生

rest_init() - 系统的临门一脚

// init/main.c

void __init rest_init(void)

{// 创建内核线程kernel_initpid = kernel_thread(kernel_init, NULL, CLONE_FS);// 创建内核线程kthreadd(内核守护进程)pid = kernel_thread(kthreadd, NULL, CLONE_FS);// CPU0执行idle循环cpu_startup_entry(CPUHP_ONLINE);

}static int __ref kernel_init(void *unused)

{// 尝试执行用户空间init程序if (ramdisk_execute_command) {ret = run_init_process(ramdisk_execute_command);}// 尝试/sbin/init, /etc/init, /bin/init等if (!try_to_run_init_process("/sbin/init") ||!try_to_run_init_process("/etc/init") ||!try_to_run_init_process("/bin/init"))return 0;// 最后尝试/bin/sh(应急shell)panic("No working init found. Try passing init= option to kernel.");

}

进程树诞生:

进程ID 进程名 描述

0 swapper idle进程,CPU空闲时运行

1 init 所有用户进程的祖先

2 kthreadd 内核守护进程的管理者

第五阶段:init进程 - 用户空间的起点

systemd初始化流程

# systemd启动序列

/sbin/init (PID 1)

├── systemd-journald # 日志服务

├── systemd-udevd # 设备管理

├── network.service # 网络初始化

├── sshd.service # SSH服务

└── getty.target # 登录终端

关键作用:

- 生成登录终端:在tty1-6启动

getty进程 - 显示登录提示:

login: - 启动shell:用户登录后执行

/bin/bash

第六阶段:调度器接管 - 操作系统的永动机

谁让操作系统"一直运行"?

答案是:调度器 + 中断机制的共同作用!

1. 时钟中断 - 系统的心跳

// 时钟中断处理程序(每10ms触发一次)

void timer_interrupt(struct pt_regs *regs)

{// 更新系统时间jiffies_64++;// 触发调度检查scheduler_tick();// 处理定时器run_timer_list();

}

2. 调度器 - 进程的交通警察

// 核心调度函数

void schedule(void)

{struct task_struct *prev, *next;prev = current; // 当前运行进程next = pick_next_task(rq); // 选择下一个进程if (prev != next) {context_switch(rq, prev, next); // 上下文切换}

}// 上下文切换(arch/x86/kernel/process_64.c)

__visible __switch_to(struct task_struct *prev, struct task_struct *next)

{// 切换页表(CR3寄存器)load_new_mm_cr3(next->mm);// 切换栈指针load_sp0(next);// 切换浮点寄存器状态switch_fpu_finish(next);

}

3. idle进程 - CPU的休息站

当没有其他进程可运行时,CPU执行swapper进程(PID 0):

// arch/x86/kernel/process.c

void cpu_idle_loop(void)

{while (1) {// 检查是否需要调度while (!need_resched()) {// 执行节能指令(如HLT)native_safe_halt();}schedule(); // 有任务时立即调度}

}

完整循环:操作系统如何保持"永生"

总结:操作系统的永生之谜

- 启动靠BIOS:硬件固件加载引导程序

- 初始化靠内核:

start_kernel()构建所有子系统 - 用户空间靠init:PID 1进程创建所有用户进程

- 永生靠调度器:

- 时钟中断提供恒定"心跳"

- 调度算法在进程间公平切换

- idle进程保证CPU永不"空转"

最终答案:让操作系统一直运行的不是某个神秘实体,而是精心设计的中断机制 + 调度算法,它们共同构成了一个永不停歇的"进程轮盘",使得操作系统能够像一位不知疲倦的交通警察,永远协调着系统资源的流动。