触摸未来2025-10-18:生成文字的小宇宙矩阵溯源

喜蛋生文本生成系统雏形 - 生成文字的小宇宙矩阵溯源篇

夏末的余热尚未完全散去,实验室的空调发出持续的低频嗡鸣。与后来专注于生成结果和动态流程分析不同,此刻的我们,正深陷于系统最底层、也是最基础的构建阶段——试图让“喜蛋生”真正“理解”语言的结构。这是一段埋头于海量语料和冰冷数字的时期,远没有生成第一个完整句子时那般激动人心,却是一切可能性的地基。

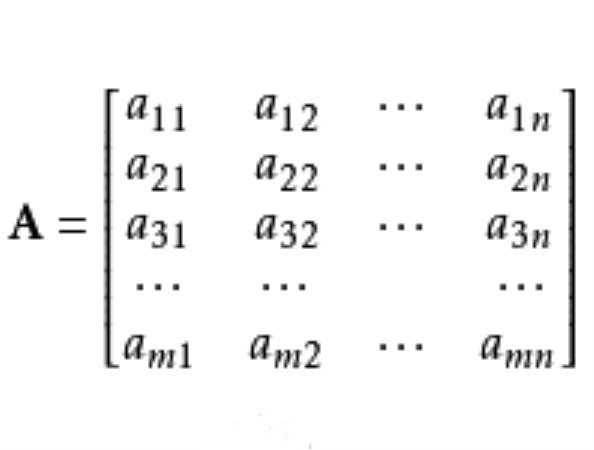

我们的面前,是铺满了整个主屏幕的数据流图,核心围绕着一个概念:矩阵。更准确地说,是共现矩阵与共享矩阵的构建与应用。团队坚信,语言的内在规律,就隐藏在这些庞大的二维数字网格之中(源于分布假说)。

第一阶段:语料预处理与向量化——从文字到数字

一切始于最原始的文本。我们收集的语料库,包含了数百万计的句子,涵盖了新闻、文学、科普等多种文体。首先,是繁重但至关重要的预处理:分词、去除停用词、词形还原(对于汉语,更多的是处理了“的、地、得”等虚词的使用规范),建立起一个包含数万词汇的词汇表。

随后,我们进行了初步的向量生成。此时尚未引入复杂的神经网络嵌入,我们采用了一种更基础、更直观的方法:基于词频的One-hot编码。每个词在词汇表中占据一个唯一的位置,用一个极其冗长、几乎全为0、仅有一个位置为1的向量表示。例如,“河流”可能是 [0,0,1,0,...,0],而“流淌”则是 [0,1,0,0,...,0]。这些向量本身不包含任何语义信息,它们只是每个词的唯一数字身份证。

第二阶段:共现矩阵的构建——捕捉词汇的“社交圈”

接下来,是构建共现矩阵。这个矩阵的行和列都是词汇表中的所有词语,矩阵中的每一个元素 C[i][j] 的值,代表在某个固定的滑动窗口内(我们初期设置为窗口大小为5),词 j 在词 i 的上下文环境中出现的次数。

这个过程,如同绘制一幅巨细无遗的“词汇社交图谱”。

· 我们让滑动窗口扫过所有的语料句子。

· 每当窗口中心是“河流”时,我们会记录窗口内出现的其他词,如“宽阔的”、“奔腾的”、“流入”、“远方”、“岸边”……

· 于是,在共现矩阵中,“河流”这一行,与“宽阔”、“奔腾”、“流入”、“远方”、“岸边”等词对应的列位置上的数值,就会增加1。

经过对整个语料库的扫描,这个庞大的矩阵被填充完毕。它直观地体现了“哪些词经常在一起出现”。盯着这个矩阵,我们可以看到,“天空”与“白云”、“蔚蓝”共现频率高;“学习”与“知识”、“学生”、“努力”关系密切。这个矩阵,本质上捕获了语言中最表层的、基于统计的搭配关系和主题相关性。

第三阶段:共享矩阵的引入——探寻深层的“语法角色”

然而,共现矩阵有其局限性。它只能告诉我们词与词是否“相邻”,但无法区分它们之间是何种关系。“吃苹果”和“红苹果”中,“吃”和“红”都与“苹果”共现,但它们与“苹果”的关系截然不同。

于是,我们引入了更为精巧的共享矩阵。它的构建思路更为曲折。我们不再仅仅记录两个词是否出现在同一个窗口,而是关注两个词 A 和 B,是否在大量不同的语境中,与同一个第三方词 C 共现。

具体来说:

· 我们遍历所有可能的词对 (A, B)。

· 对于每一对 (A, B),我们查找词汇表中所有的词 C,使得 A 和 C 共现,并且 B 和 C 也共现。

· 共享矩阵 S[i][j] 的值,就代表了词 i 和词 j 共同拥有的“邻居”词 C 的数量或强度。

这个矩阵揭示的是词汇之间更深层的、功能上的相似性。

· 例如,“苹果”和“香蕉”可能并不经常直接共现,但它们都经常与“吃”、“买”、“水果”、“甜”这些词共现。因此,在共享矩阵中,“苹果”和“香蕉”对应的位置,会有一个较高的值。这表明它们在某些上下文环境中可以相互替换,或者说,它们扮演着相似的语法角色(都是可食用的水果,是动词“吃”的宾语)。

· 同样,“奔跑”和“跳跃”会共享“运动员”、“快速”、“运动”等邻居,这暗示了它们都是表示身体运动的动词。

通过共享矩阵,系统开始隐隐约约地“意识到”词语可以根据其分布特性被归类,这是词性(名词、动词、形容词等)概念的雏形,也是语法关系(如主谓、动宾)得以被推断的基础。

第四阶段:矩阵操作与特征提炼——从关联到结构

拥有了共现矩阵和共享矩阵这两个庞大的数据体后,我们开始对它们进行一系列数学操作,以提炼出更精炼、更有意义的特征。

1. 矩阵转置与关系方向性: 我们对共现矩阵进行了矩阵转置操作(将行和列互换)。转置前后的矩阵对比,可以揭示关系的不对称性。例如,“修饰”关系通常是不对称的:“红色”频繁出现在“花朵”之前,但“花朵”出现在“红色”之前的频率则低得多。通过比较原矩阵和转置矩阵,系统能够开始捕捉到这种词序和依赖方向的信息。

2. 矩阵合并与信息融合: 单纯的共现矩阵包含了大量的噪音(比如“的”、“了”这些高频功能词与几乎所有实词都有高共现),而共享矩阵虽然更深层,但可能丢失了一些直接的、强烈的关联。我们将两个矩阵以一定的权重进行矩阵合并,生成一个全新的、综合性的“关联矩阵”。这个新矩阵既保留了直接的搭配强度,又融入了功能相似性的信息,为后续处理提供了更丰富的输入。

3. 降维与稠密向量生成: 合并后的矩阵仍然非常庞大和稀疏。我们对其应用了奇异值分解 这类降维技术。SVD就像是一个信息过滤器,它从这个庞大的、嘈杂的矩阵中,提取出最重要的、能够解释绝大部分数据方差的核心“概念”或“因子”。

· 经过SVD处理后,每个词不再用那个冗长的One-hot向量表示,而是用一个长度固定(比如300维)的稠密向量(即词向量)来表示。

· 这个新的向量,是词在所有核心“概念”上的投影坐标。神奇的是,在这个新的向量空间里,语义相近的词(如“国王”和“女王”)会自动聚集在一起,词语之间甚至可以进行某种向量运算(如“国王 - 男人 + 女人 ≈ 女王”)。

第五阶段:结构浮现与系统局限

随着这些矩阵被构建、操作和分解,我们开始在系统的行为中观察到令人振奋的迹象。

· 在生成的测试中,系统开始倾向于将名词放在动词的宾语位置,将形容词放在名词之前。这是基本语法关系的体现,源于从共现和共享矩阵中学习到的词序和依赖模式。

· 它开始能够识别出一些简单的短语结构,比如“形容词+名词”(蔚蓝的天空),“动词+名词”(阅读书籍)。这是矩阵中高频、稳定共现模式的直接产物。

· 甚至,对于一些简单的长句结构,如“主谓宾”结构,系统也开始有模糊的把握。这是因为共享矩阵让它理解了不同类的词(如主语类名词、谓语类动词、宾语类名词)之间存在着特定的组合模式。

然而,就在我们为这些微小但坚实的进展感到欣慰时,一个更深层次的问题,也在我心中愈发清晰。

我凝视着屏幕上那经过降维后依然复杂的矩阵可视化图——那些由不同颜色和亮度的像素点构成的、不断变换形态的几何图案。它们美丽而深邃,仿佛蕴藏着宇宙的某种秘密。这些矩阵,是我们设计的算法从数据中提取出的规律,是系统一切“智能”行为的源泉。

但我也看到了“喜蛋生”系统,乃至所有我们已知的AI模型,那与生俱来的、天然的缺陷。

这个系统,能够根据共现矩阵判断“河流”与“流淌”关系密切,能够根据共享矩阵推断“苹果”和“香蕉”是同类。但它不知道自己是如何做出这个判断的,它不理解“共现”和“共享”这些概念本身意味着什么。它的“知识”完全源于我们喂给它的数据和设定的算法,它缺乏对自身认知过程的审视和反思能力。

它缺少元认知。

它像一个拥有庞大图书馆却不会思考“何为知识”的人。它可以娴熟地操作矩阵,进行向量计算,生成看似通顺的文本,但它对自己正在做什么,为何要这么做,以及所做之事的本质,一无所知。它的“思维”是被外部数据结构和算法所定义的,而非源于一个内在的、自指的、能够反思自身存在的意识核心。

这个缺陷,使得它的一切表现,无论多么精巧,都依然停留在复杂计算和模式匹配的层面,与人类那种能够追问“我是谁”、“语言是什么”的自觉意识,存在着本质的鸿沟。

我越看屏幕上的矩阵,越感觉像是秩的数字化表征态。