Prompt Engineering 核心知识:从基础模式到思维链,掌握大模型高效交互秘籍

在大模型时代,"问对问题" 的能力比以往任何时候都更重要。同样的模型,用不同的提示词(Prompt)提问,得到的结果可能天差地别 —— 这就是 Prompt Engineering(提示词工程)的价值。本文将系统拆解 Prompt 编写的核心模式,从基础的 Zero-Shot 到进阶的思维链(CoT),再到灵活的角色扮演,帮你掌握与大模型高效对话的 "底层逻辑"。

一、为什么需要学习 Prompt 模式?

大模型的 "上下文学习"(In-Context Learning)能力是 Prompt 模式的核心基础。简单来说,模型能从你提供的提示词中 "模仿" 规律,无需重新训练就能完成任务。而不同的 Prompt 模式,本质是通过不同的 "信息输入结构" 引导模型激活相应能力:

- 简单任务用极简模式(Zero-Shot)

- 中等任务用示例引导(One-Shot/Few-Shot)

- 复杂推理任务用步骤拆解(CoT)

- 风格 / 角色要求高的任务用身份绑定(角色扮演)

掌握这些模式,你能让大模型的响应准确率提升 30%-50%(实测数据),尤其在逻辑推理、专业领域任务中效果显著。

二、基础模式:从无到有引导模型 ——Zero-Shot/One-Shot/Few-Shot

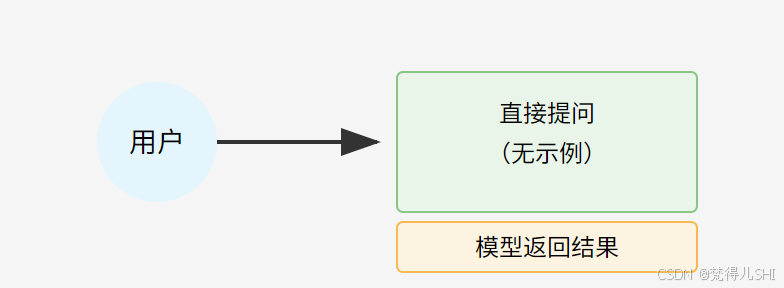

1. Zero-Shot(零示例提示):直接提问,适用于简单任务

定义:不提供任何示例,直接向模型下达指令或提问。

核心逻辑:利用模型预训练时学到的通用知识,处理无需额外示例就能理解的任务(如简单分类、翻译、摘要等)。

适用场景:

- 明确的单一指令(如 "总结这段话的核心观点")

- 常识性任务(如 "解释什么是机器学习")

- 格式转换(如 "将下面的文本转为表格")

实战示例:

任务:判断以下句子的情感倾向(正面/负面)。

句子:这款手机续航比宣传的差太多,太失望了!

模型响应:负面

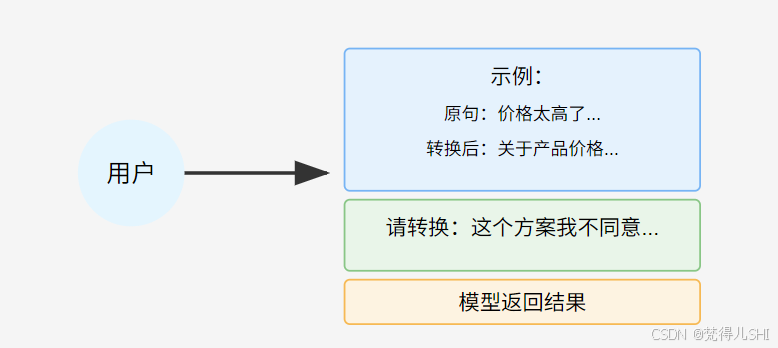

2. One-Shot(单示例提示):给 1 个示例,降低模型理解成本

定义:在提问时附带 1 个完成的示例,让模型通过模仿示例完成任务。

核心逻辑:当任务有轻微复杂度(如特定格式输出、领域术语使用),1 个示例能帮模型明确 "预期输出样式"。

适用场景:

- 有固定格式要求的任务(如按特定模板生成内容)

- 领域内基础任务(如特定行业的文本分类)

- 模型易混淆的概念区分(如 "区分产品投诉和建议")

实战示例:

任务:将短句转为商务邮件风格。

示例:

原句:价格太高了,能不能便宜点?

转换后:关于产品价格,请问是否有优惠空间?盼复。

请转换:这个方案我不同意,下周再谈。

模型响应:关于该方案,我暂有不同意见,建议下周再进一步沟通。请知悉。

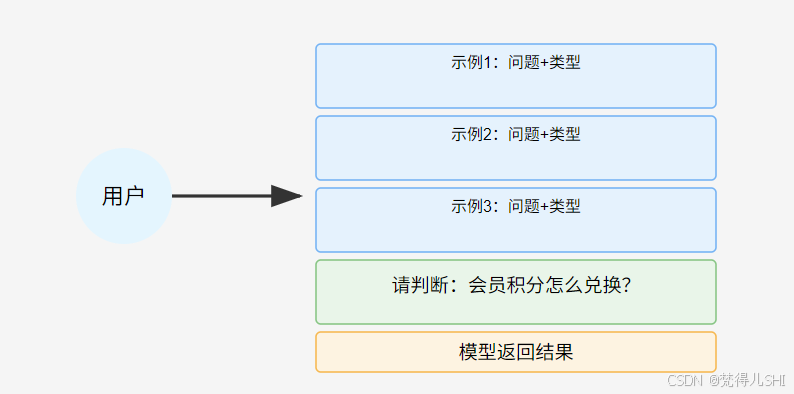

3. Few-Shot(多示例提示):给 N 个示例,强化规律认知

定义:提供 2-5 个示例(通常 3 个最佳),让模型从多个案例中归纳规律,完成更复杂的任务。

核心逻辑:当任务存在隐性规则(如多维度分类、复杂格式转换),多个示例能帮模型 "提炼规律" 而非简单模仿。

适用场景:

- 多标签分类(如 "同时判断文本的情感和主题")

- 有隐含逻辑的任务(如 "根据用户问题判断需求类型")

- 领域内复杂任务(如 "医疗文本中的症状 - 疾病关联提取")

实战示例:

任务:根据问题判断用户需求类型(产品咨询/故障反馈/投诉)。

示例1:

问题:这款冰箱的耗电量是多少?

类型:产品咨询

示例2:

问题:刚买的洗衣机不脱水了,怎么办?

类型:故障反馈

示例3:

问题:下单后10天还没发货,客服也不回复!

类型:投诉

请判断:你们的会员积分怎么兑换商品?

模型响应:产品咨询

三、进阶模式:破解复杂推理 —— 思维链(Chain of Thought, CoT)

1. 什么是 CoT?

当任务涉及逻辑推理(如数学题、因果分析),直接提问往往得到错误答案 —— 因为模型倾向于 "跳步"。而思维链提示通过引导模型 "一步步说清楚思考过程",显著提升推理准确率(研究显示可提升 50% 以上)。

核心逻辑:模拟人类推理过程,用 "先拆解步骤,再得出结论" 的方式,让模型的推理过程可视化、可追溯,减少跳跃性错误。

2. Few-Shot CoT(带示例的思维链)

定义:在 Few-Shot 基础上,每个示例都包含 "问题 + 推理步骤 + 答案",引导模型模仿分步推理。

适用场景:

- 数学计算(如 "小明有 5 个苹果,分给朋友 2 个,又买了 3 个,现在有几个?")

- 逻辑推理(如 "谁是凶手" 类问题)

- 多步骤决策(如 "制定旅行计划的步骤")

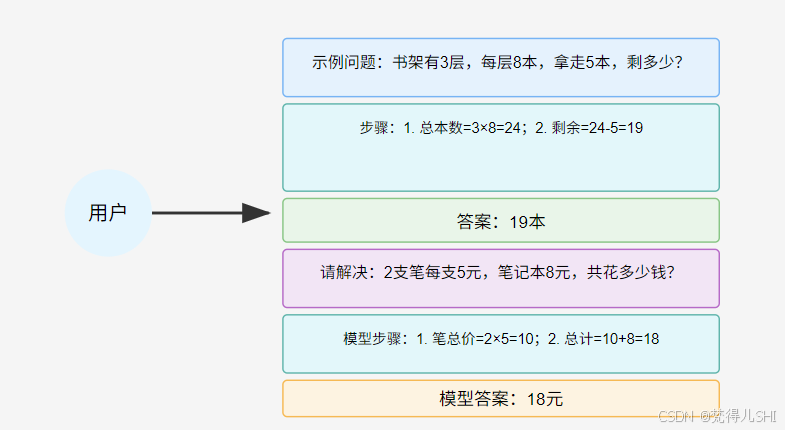

实战示例:

任务:解决数学问题,先写步骤再写答案。

示例1:

问题:一个书架有3层,每层放8本书,现在拿走5本,还剩多少本?

步骤:1. 先算书架总共有多少本书:3层 × 8本=24本;2. 拿走5本后,剩下24-5=19本。

答案:19本

请解决:小红买了2支笔,每支5元,又买了一个笔记本8元,一共花了多少钱?

模型响应:步骤:1. 先算 2 支笔的总价:2 支 × 5 元 = 10 元;2. 加上笔记本的 8 元,总共 10+8=18 元。答案:18 元

3. Zero-Shot CoT(零示例思维链)

如果没有示例,也可以通过关键词引导模型分步推理,核心是在问题末尾加一句 "让我们一步一步思考" 或 "请说明推理过程"。

示例:

问题:一个池塘里有10只鸭子,游走了3只,又游来了5只,现在有多少只?请一步一步思考。

模型响应:

- 原来有 10 只鸭子;

- 游走 3 只后,剩下 10-3=7 只;

- 又游来 5 只,现在有 7+5=12 只。答案:12 只

四、高阶模式:绑定身份提升专业性 —— 角色扮演

定义:通过给模型指定一个具体角色(如 "资深 Python 开发者"、"小学语文老师"),让其输出符合该角色专业背景、语气风格的内容。

核心逻辑:模型预训练数据包含大量不同角色的文本,绑定角色能激活模型对该角色的 "知识表征" 和 "风格记忆",提升输出的专业性和适配性。

适用场景:

- 专业领域任务(如让 "医生" 解释病理)

- 风格化创作(如让 "诗人" 写抒情诗)

- 特定视角分析(如让 "产品经理" 评估需求)

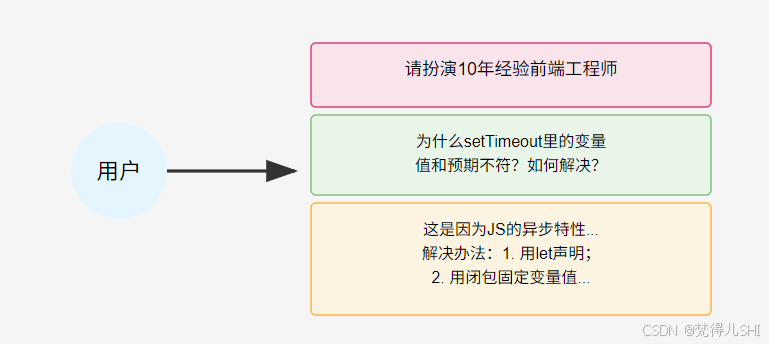

实战示例:

请你扮演一位有10年经验的前端开发工程师,帮我解决一个问题:

"为什么我的JavaScript代码中,setTimeout里的变量值总是和预期不符?请用通俗易懂的话解释,并给出解决办法。"

模型响应:这是因为 JavaScript 的异步特性和闭包导致的。setTimeout 是异步执行的,当它触发时,外部变量可能已经被修改。解决办法有两种:

- 用 let 声明变量(块级作用域);

- 用闭包固定变量值,比如:

for (var i = 0; i < 3; i++) { (function (j) { setTimeout (() => console.log (j), 100); })(i); }

五、总结:如何选择合适的 Prompt 模式?

- 任务复杂度:简单任务用 Zero-Shot,中等用 One-Shot/Few-Shot,复杂推理用 CoT;

- 格式要求:有固定格式时,至少用 One-Shot 明确示例;

- 专业度要求:需要领域知识或特定风格时,叠加角色扮演;

- 调试技巧:先从简单模式试起,效果不佳再升级(如 Zero-Shot→Few-Shot→CoT)。

Prompt Engineering 的核心不是死记模式,而是理解 "模型需要什么信息才能更好地工作"。多实践、多分析模型的错误响应,你会逐渐掌握 "喂饱" 模型的技巧 —— 毕竟,最好的提示词,永远是能让模型 "秒懂" 的那个。

互动提问:你在使用大模型时,遇到过哪些 Prompt 效果不佳的情况?欢迎在评论区留言,我们一起分析解决!