Google提示词白皮书总结(1)

Google提示词白皮书总结(1)

- 一、LLM输出配置

- (一).输出长度(Output length)

- (二).采样控制 (Sampling controls)

- 二、提示技巧

- (一).样本示例类

- (二).系统、上下文和角色提示(System, contextual and role prompting)

注:PE==Prompt Engineering

一、LLM输出配置

选定模型后需要确定模型配置。大多数LLM都带有各种配置选项,用于控制输出,有效的PE需要为了特定的任务优化设置这些配置。

(一).输出长度(Output length)

- 重要配置,生成更多令牌需要llm做出更多计算,导致更高能耗,更慢的响应时间以及更高的成本。

- 减少llm的输出程度不会让回答更简洁,只是在maxtokens后强制截断,需要简介需要在PE中设置。

- 对部分LLM提示技术(如react)输出长度很重要,因为获得所需响应以后,llm可能继续发出无用token。

(二).采样控制 (Sampling controls)

LLM实质上是预测下一个令牌,而根据对令牌概率的采样,可以确定需要生成的令牌。而配置采样可以通过温度(temperature ),TOP-K,TOP-P是最常见的配置设置,决定了如何采样。

- 温度——控制令牌选择的随机程度

较低的温度适用于更确定性的要求,0代表结果确定,始终选择概率最高的令牌,temp越高,结果越随机,事实问答适合于低温,故事生成适合于高温。 - TOP-K和TOP-P是llm中使用的采样设置,用于将预测的下一个token限制为来自具有最高的token。

TOP-K指的是最高概率的K个令牌,越高代表输出越具有创造性和多样性,TOP-P代表采样选择累积概率不超过P的最高概率令牌。

二、提示技巧

(一).样本示例类

- 通用模版/零样本:此类是最简单的提示类型,仅仅提供任务描述和一些巩LLM开始使用的文本。ex:

- 单样本&少样本:为AI创建提示时,提供一定示例,尤其希望引导模型遵循特定的输出结构或者模式。少样本提示的数量取决于就几个因素,包括任务的复杂性、示例的质量以及AI的能力,一般会有三到五个,对于复杂任务应当多一点,如果模型输入长度有限制,应该使用更少的示例。

(二).系统、上下文和角色提示(System, contextual and role prompting)

- 系统提示设置llm的总体背景和目的,它定义了模型应该做什么大局,例如翻译语言,分类评论。

- 上下文提示提供与当前对话或者任务的特定细节与背景信息,帮助模型理解所提的细微差别,并相应地调整影响。

- 角色提示为语言模型分配一个特定的角色或者身份提供采用,有助于模型生成与所分配角色以及相关知识和行为一致的选择。

这三者可能会有相当大的重叠,例如,一个系统分配角色的prompt也可以包含上下文。

三种提示代表三种指导llm的维度,系统提示设定舞台,上下文提示提供即时的场景细节,而角色提示定义了演员的形象。它们可以单独使用,也可以组合分层使用。

区分系统,上下文和角色提供了一个框架,用于设计更好的prompt,灵活组合,并且更容易分析每种提示类型如何影响语言模型的输出。

- 系统提示 (System prompting)

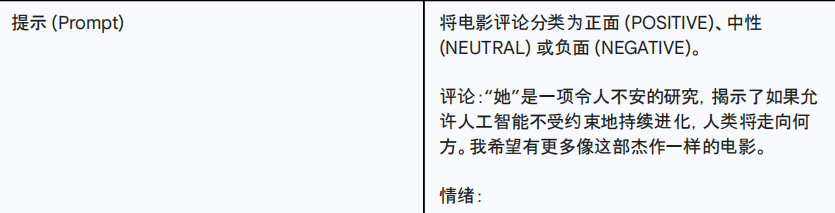

ex:

指定了有关如何返回输出的附加信息。

系统提示对于生成满足特定要求的输出非常有用。“系统提示”这个名称实际上代表“向系统提供附加任务”。例如,可以使用系统提示生成与特定编程语言兼容的代码片段,或者使用系统提示返回某种结构。 - 上下文提示

通过上下文提示,可以确保AI交互尽可能无缝和高效,模型将能够更宽理解请求, 生成更准确,相关的响应,上下文提示将LLM的响应防御特定的环境或者背景信息,防止产生通用或者不相关的输出,并确保针对当前情况量身定制。

3.回退提示

采用引导的方式,类似上上篇文章的LTM。

回退(Step-back) 提示是一种提高性能的技术,它提示 LLM 首先考虑与手头特定任务相关的一个更普遍的问题,然后将该普遍问题的答案输入到后续针对特定任务的提示中。这种“回退”允许 LLM 在尝试解决具体问题之前激活相关的背景知识和推理过程 。

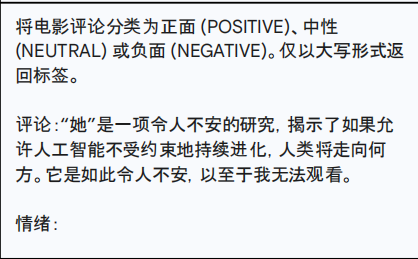

prompt1:

prompt2: