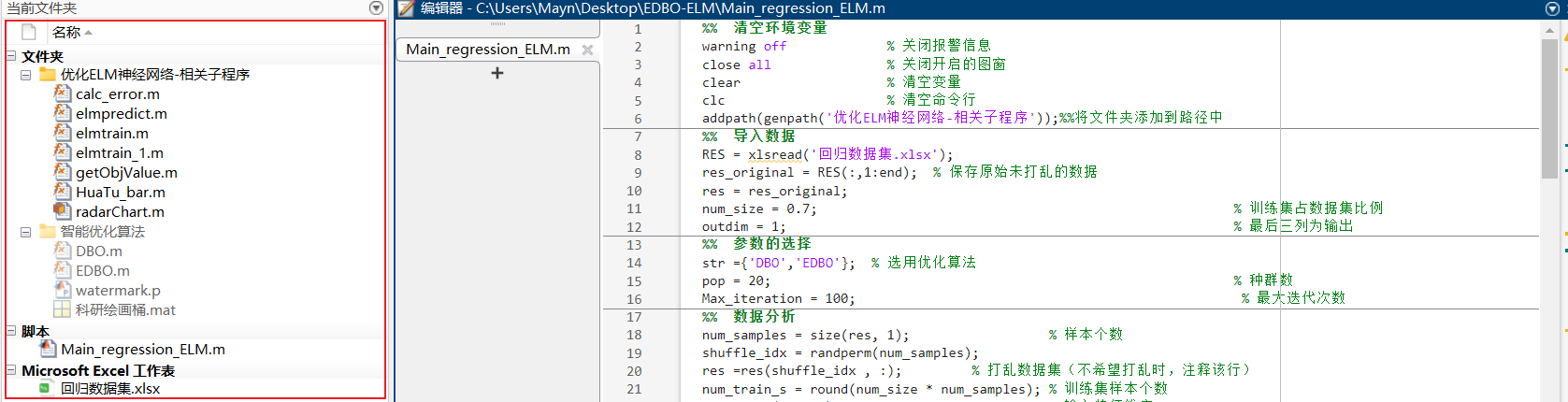

基于EDBO-ELM(改进蜣螂算法优化极限学习机)数据回归预测

代码主要包括以下部分

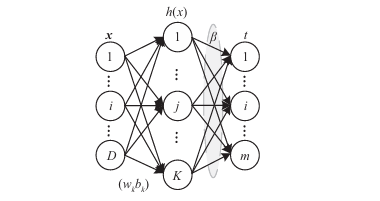

极限学习机(ELM)是一种简单有效的单隐层正向神经网络学习方法。由南洋理工大学黄广斌副教授于2004年提出。相较于以BPNN为代表的传统神经网络学习方法需人工设定较多的参数,且易陷入局部极值,该方法仅需设定网络隐含层结点数目,无需对网络输入权重和隐元偏置进行调节,因而学习速度快、推广能力强。

01 深入理解ELM:优势与挑战并存

ELM的核心机制

极限学习机是一种创新的单隐藏层前馈神经网络,其核心思想在于:

- 随机初始化隐藏层参数

- 解析求解输出层权重

- 极速训练过程

% 传统ELM训练过程[IW, B, LW, TF, TYPE] = elmtrain_1(p_train, t_train, hiddennum, activate_model, 0);面临的严峻挑战

尽管ELM具有显著优势,但其固有缺陷同样明显:

- 性能不稳定:随机初始化导致结果波动大

- 泛化能力差:参数选择不当影响预测精度

- 局部最优陷阱:难以获得全局最优解

02 智能优化算法:ELM的"性能加速器"

一、采用智能优化算法来找到最佳ELM参数,有效提升模型性能

2025年优化算法:多策略增强蜣螂优化算法(EDBO)

1.优化ELM的过程

(1) 参数表示与编码:将ELM的隐藏层参数(如权重和偏置)表示为优化算法中的个体。

(2) 适应度函数定义:使用ELM模型在验证集上的误差(如均方误差)作为优化算法的适应度函数,指导参数的优化。

(3) 优化过程:

① 使用智能优化算法对个体进行迭代优化,更新模型的隐藏层参数。

② 通过评估适应度函数,选择最优参数。

(4)模型重建与验证:利用优化后的参数重建ELM模型,并在测试集上验证性能。

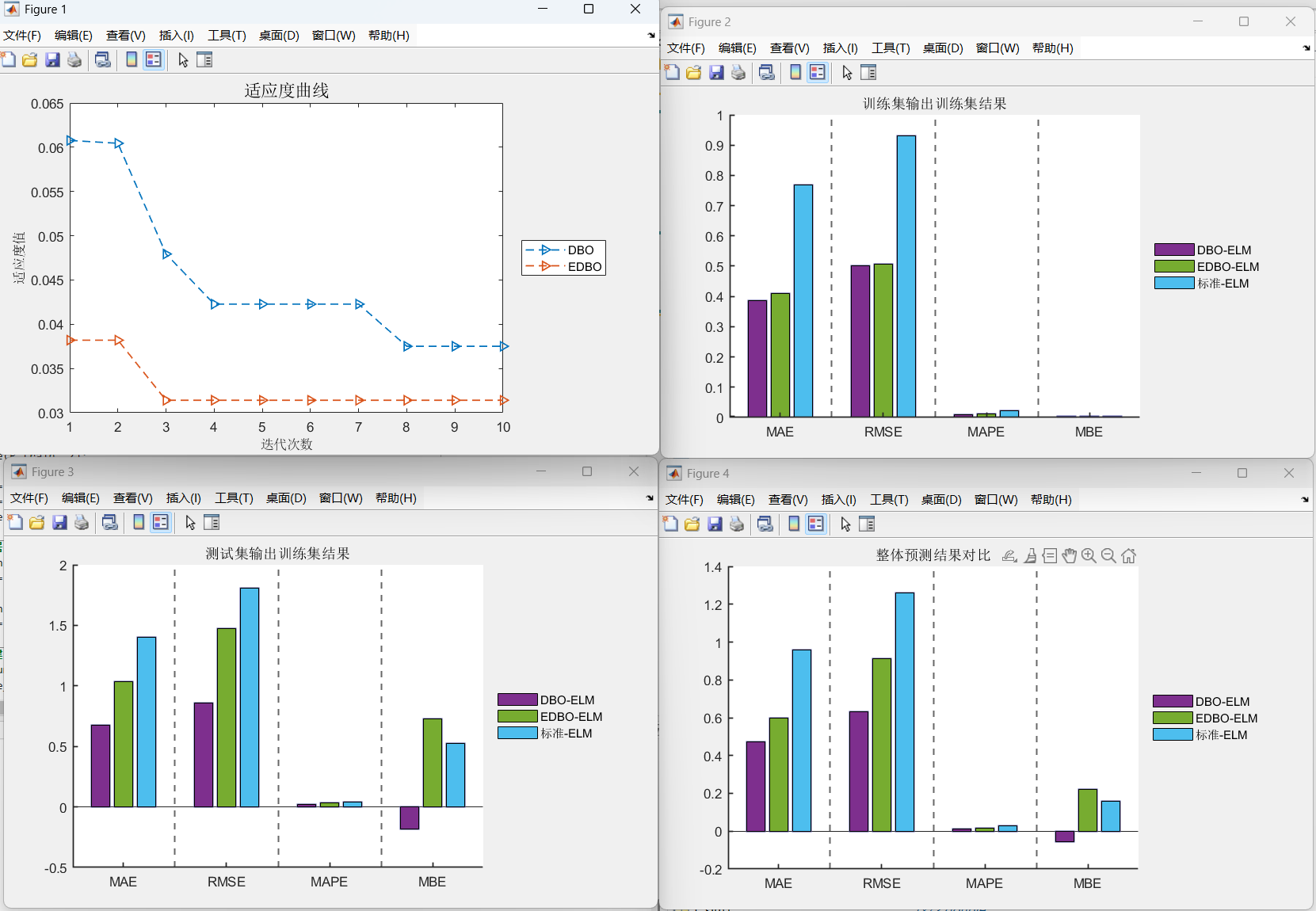

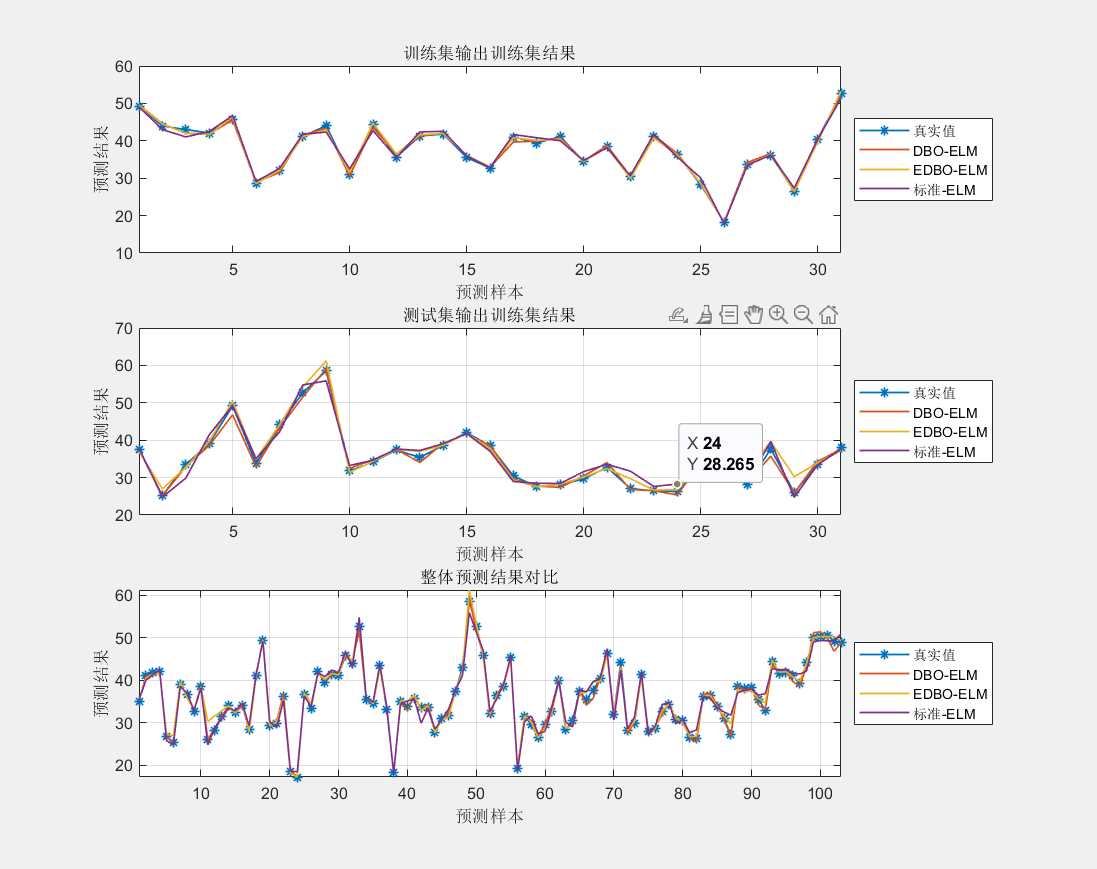

2.应用效果

提升预测精度:智能优化算法可以显著提高ELM的预测精度。

提高模型稳定性:优化算法能够减少由于随机初始化引起的不稳定性。

增强泛化能力:优化后的模型对未知数据有更好的泛化效果。

3.总结

通过结合智能优化算法,ELM神经网络可以更好地进行参数选择,提高其回归预测能力。这些算法不仅加速了参数收敛,还提升了模型的精确度和在不同数据集上的泛化能力。利用多种优化技术提供的全局搜索能力,能有效地改善ELM的整体性能。

03.近年来相关论文发表

基于该机ELM数据回归预测依旧活跃

04.本文代码效果图

✅作者简介:信号处理方向在校博士研究生,目前专研于MATLAB算法及科学绘图等,熟知各种信号分解算法、神经网络时序、回归和分类预测算法、数据拟合算法以及滤波算法。提供一个可以相互学习相互进步的平台

🚩技术信仰:知行合一,让每一行代码都成为解决问题的利器

🔍后台私信备注个人需求(比如EDBO-ELM)