大型语言模型实战入门:从 API 到开源模型,掌握文本生成与对话核心技能

大型语言模型(LLM)已成为开发者的重要工具,无论是构建智能对话机器人、自动生成文案,还是辅助代码开发,都离不开对 LLM 接口的灵活运用。本文将系统讲解三大类 LLM 工具的实战技巧 ——OpenAI API、国产模型 API(以文心一言为例)和开源模型 Ollama,通过具体代码示例和直观图示,帮你快速掌握文本生成与对话的核心技能,让 LLM 真正为你所用。

一、为什么要学 LLM API?—— 从工具到生产力的跨越

在 LLM 普及的今天,直接调用 API 或部署开源模型是最高效的应用方式,无需关注模型训练的复杂细节(千亿参数、万亿 tokens 训练数据),只需掌握接口调用逻辑,就能快速实现:

- 文本生成:自动写文案、生成报告、创作代码片段;

- 对话交互:构建客服机器人、智能助手、教学问答系统;

- 内容处理:文本摘要、翻译、情感分析等。

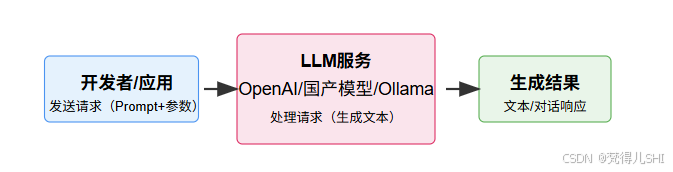

LLM API 的核心逻辑可简化为 “输入 - 处理 - 输出” 的闭环:开发者发送包含 “提示词(Prompt)” 和参数的请求,模型处理后返回生成结果。无论哪种模型,这个核心逻辑都是相通的。

接下来,我们分别实战三大类工具,从 API 调用到本地部署,覆盖不同场景需求。

二、实战一:OpenAI API—— 国际主流 LLM 接口的使用

OpenAI 的 GPT 系列(如 GPT-3.5、GPT-4)是目前应用最广泛的 LLM 之一,其 API 设计简洁,文档完善,适合快速开发。

2.1 准备工作:注册账号与获取 API 密钥

- 注册 OpenAI 账号:访问OpenAI 平台,用邮箱注册(需科学上网);

- 创建 API 密钥:登录后进入 “Personal → View API keys”,点击 “Create new secret key”,保存密钥(仅显示一次)。

注意:API 调用需要计费(新账号有免费额度),需绑定支付方式;密钥是访问凭证,切勿泄露(泄露后立即吊销)。

2.2 核心能力 1:文本生成(Completion)

使用gpt-3.5-turbo-instruct模型生成指定风格的文本(如产品文案、代码片段)。

代码示例(Python):

import openai# 配置API密钥(建议通过环境变量加载,避免硬编码)

openai.api_key = "你的API密钥"def generate_text(prompt, model="gpt-3.5-turbo-instruct", max_tokens=100, temperature=0.7):"""生成文本:param prompt: 提示词(核心输入):param model: 模型名称:param max_tokens: 生成文本的最大长度:param temperature: 随机性(0-1,值越高越随机):return: 生成的文本"""response = openai.Completion.create(model=model,prompt=prompt,max_tokens=max_tokens,temperature=temperature)return response.choices[0].text.strip()# 示例:生成一段Java变量命名规范的说明

prompt = "请用简洁的语言说明Java变量命名的3个核心规范:"

result = generate_text(prompt, max_tokens=150)

print("生成结果:\n", result)

输出示例:

生成结果:1. 采用小驼峰命名法:首字母小写,后续单词首字母大写(如userName、orderTotal)。2. 见名知意:变量名需清晰表达其用途(避免使用a、b等无意义名称)。3. 避免关键字:不能使用Java保留字(如class、int)作为变量名。

2.3 核心能力 2:对话交互(Chat Completion)

gpt-3.5-turbo和gpt-4模型支持多轮对话,通过 “消息列表” 维护上下文。