CoRL2025口头报告:基于最优传输对齐人类视角和机器人视角的多模态数据,真正解决跨模态数据融合的问题

目前机器人模仿学习的数据集还是依赖大量机器人遥操作来完成采集的,通过物理机器人在多样化环境中采集数据成本还是太高了,而且也难以规模化。本文的目标则瞄向了人类穿戴设备(比如XR设备、智能眼镜)来采集第一视角数据的方案,毕竟这样的话就不需要机器人来参与采集了,极大的降低了成本而且还可以规模化。然而,这种方案存在一个大问题,那就是人类与机器人之间的差距。尽管现在很多方法都在致力于解决这个问题,但效果都很有限,所以如何有效跨越这些域差距,充分利用人类数据提升机器人模仿学习能力,是当前亟待解决的核心问题。

EgoBridge是一个统一的协同训练框架,它通过最优传输技术来对齐人类与机器人数据的策略潜在空间,并结合动态时间规整(DTW)构建行为相似的伪样本对,在对齐跨域分布的同时保留关键动作信息,既解决了传统域适应方法忽略动作关联性的缺陷,又缓解了人类数据与机器人数据在视觉外观、传感器模态、运动学上的域差距,为跨域模仿学习提供了高效且通用的新方案。

EgoBridge效果展示1:机器人拿起一个玩具,将其放入打开的抽屉中,然后将其关闭

EgoBridge效果展示2:机器人折叠一件随机放在桌子上的Polo衫

EgoBridge效果展示3:机器人拿起一勺装满咖啡豆的勺子,将其倒入随机放置的目标容器中

项目地址:https://ego-bridge.github.io/

1、跨具身的训练到底怎么做的?

目前主流的方案是将多源数据进行融合,然后利用标准行为克隆损失对策略进行端到端的训练;然而,要从两种数据源头进行有效学习,需满足一个关键假设:即将人类观测和机器人观测投影到共享潜在空间,得到的潜在特征应该和动作的映射应该相同

2、目前这些联合训练方法存在什么样的问题?

这些潜空间上的边缘分布会出现显著的协变量偏移,这种偏移源于两类数据源固有的域差距:

① 观测差距:人类与机器人的视觉外观、视角不同,比如:机器人有腕部相机,但人类数据中通常缺失

② 运动学差距:人类与机器人的运动学特性差异也会导致行为分布偏移

3、本文到底要研究什么?目的又是什么?

构建了一个统一的协同训练框架EgoBridge,利用“机器人演示数据”与“第一视角人类演示数据”融合训练一个特征编码器,将"人类观测数据"与"机器人观测数据"均投影到共享潜在空间,然后再联合训练一个策略,将学习到的潜在表征映射成动作,从而实现两个关键层级的泛化:

观测泛化:去有效弥合视觉与传感器差距

行为泛化:学习到的编码器具备超越“人类-机器人配对数据场景”的泛化能力,能够有效迁移运动信息

4、 EgoBridge的设计理念基础是最优传输,那么什么是最优传输呢?

简单来说最优传输就是比较几个样本空间概率分布的一套数学理论框架,比方说给定2个样本空间,源空间分布S和目标空间分布T,以及一个成本函数C(S,T),成本函数C是衡量从样本S空间传输到T空间下所需要的代价,最优传输的目标是找到一个耦合关系,使得这种传输成本最小化

5、 关键创新点:基于最优传输的联合域自适应

为了融合机器人和人类这两类数据,解决两类数据固有的差距问题,需要摒弃传统的域自适应技术(这种技术通常仅对齐数据边缘的分布,因此可能丢失动作相关信息)。EgoBridge 则以最优传输为基础,直接优化它们共享的编码器,实现对齐“编码器输出潜在特征”与“对应动作”的联合分布,具体来说就是:输入人类演示数据和机器人演示数据

,

:观测数据,

:演示动作,

:人类,

:机器人,用基于最优传输的损失函数

去指导编码器

学习,损失函数公式如下:

,其中是耦合“第 i 个人类(潜在特征-动作)”与“第 j 个机器人(潜在特征-动作)”的最优传输计划,成本函数

用于衡量这些联合实体之间的差异,最小化

,促使编码器生成对齐人类和机器人潜在空间所需传输的最小成本,即两个特征对应的动作在行为上相似时,成本

最小。正是通过这种迭代过程,潜在特征空间被塑造成“对联合观测-动作跨域不变性”的空间。

▲说明|利用人类与机器人之间固有的运动相似性,为潜在空间对齐提供监督。将此问题形式化为一个最优传输问题,对人类数据与机器人数据进行概率性映射。

6、 EgoBridge创新点的最优传输的成本函数的设计思路是怎样的?

人类数据和机器人数据存在2个极大的差异,OT成本函数设计要解决2个最大的问题:

① 、时间错位:人类与机器人执行同一任务的速度通常不同

② 、运动学差异:即使在“共享SE (3)末端执行器动作空间”且“通过第一视角坐标系实现手眼对齐”的情况下,二者仍存在细微的运动学差异

解题的思路是什么呢?答案是:DTW和软监督

DTW: 给定两条长度相同的动作序列和

,DTW会寻找一个对齐路径,使累积距离最小化,公式如下, 通过允许小幅偏移来对齐两个空间中最接近的动作,以完成时间对齐的功效

▲说明|为将动作信息融入最优传输过程,引入DTW,在一个数据批次中,DTW 会为每个机器人样本找到行为最相似的人类样本,这些的“伪配对样本”被用于降低最优传输中潜在特征的匹配成本,最终实现潜在特征-动作联合分布的对齐。

软监督:利用DTW识别人类与机器人中行为相似的样本对,接着基于这些相似性构建伪配对关系,然后在最优传输的成本函数中,对经过DTW判定的行为匹配样本对设置更低成本,以此引导模型在学习过程中更关注这类具有潜在关联的样本,从而实现跨域知识的有效迁移与模型泛化能力的提升。

7、 EgoBridge完整的框架结构

联合训练:

EgoBridge将特征编码器与策略解码器进行联合优化:对特征编码器应用联合最优传输损失,对编码器与解码器整体应用BC联合训练损失,总损失公式如下:

数据集采集过程:

● 人类数据集

○ 采集:采集者带上Meta Project Aria智能眼镜进行作业任务,同时采集第一视角RGB 图像、人体双臂笛卡尔位姿

○ 处理:将手部位姿投影到第一视角相机坐标系下,生成“轨迹块”形式的动作序列,同时对本体感受数据做归一化

● 机器人数据集

○ 采集:以Eve机器人为平台,用Aria眼镜模拟人类手眼配置采集第一视角图像,搭配腕部相机获近景RGB,通过遥操作记录机器人末端执行器位姿、关节状态

○ 处理:将末端执行器位姿序列整理为“轨迹块”动作,对关节数据、动作做归一化,统一与人类数据的动作空间

策略解码器架构:

EgoBridge带联合自适应的策略联合训练, 编码器 包含“模态特异性输入分支”与“编码器主干”,策略

包含“共享多块 Transformer 的解码器”,

用于优化编码器,

用于优化整个网络。

1、 实验内容及结果

论文中围绕EgoBridge框架的有效性验证开展了1项仿真实验和3项真实世界实验,具体内容如下:

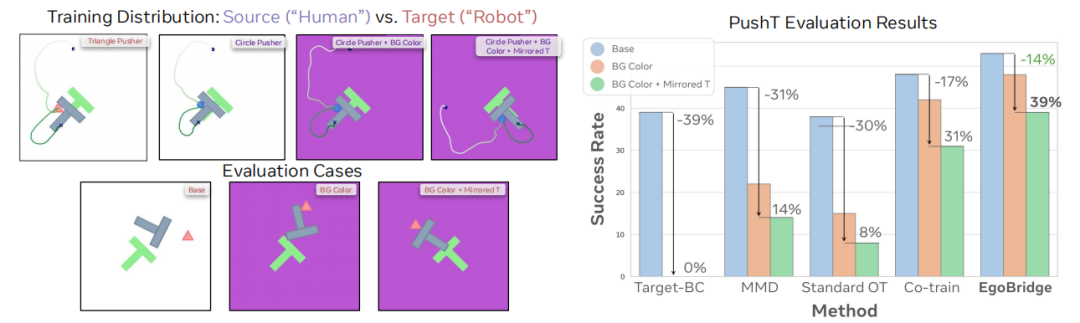

(1)仿真实验:平面推T形物体任务(PushT)

● 实验过程:

构建“人类-机器人”跨域场景:用蓝色圆形推杆模拟“人类源域数据”,粉色三角形推杆模拟“机器人目标域数据”,并通过改变背景颜色(白色→紫色)、T形物体初始构型(正常→镜像),模拟视觉外观与运动模式差异。

■ 数据设置:机器人数据仅覆盖“白色背景+正常T形”场景,人类数据额外覆盖“紫色背景+镜像T形”等未被机器人观测的场景。

■ 基线对比:将EgoBridge与目标域仅训练(Target-only BC)、普通共训练(Co-train)、最大均值差异(MMD)、标准最优传输(Standard OT)等基线对比,评估任务成功率(reward≥0.9)与平均奖励(目标IoU)。

● 结果:

■ 跨场景泛化优势显著:在“紫色背景+镜像T形”的未观测场景中,EgoBridge成功率达39%,而其他基线(如Standard OT、MMD)成功率仅8%-14%,Target-only BC完全失败(0%)。

■ 性能下降最小:相比“白色背景+正常T形”的域内场景,EgoBridge在未观测场景中的性能下降仅14%,远低于其他基线(如Co-train下降17%、MMD下降31%)。

(2)真实世界实验1:抽屉操作任务

实验过程:

任务目标:机器人用机械臂抓取玩具,放入预打开的抽屉并关闭,共涉及6×4抽屉阵列(分4个象限)。

■ 数据设置:机器人数据仅覆盖3个象限(共144条演示),人类数据覆盖全部4个象限(1小时时长),重点测试对“仅人类观测的第4象限抽屉”的行为泛化能力。

■ 基线对比:对比EgoBridge与机器人仅训练(Robot-only BC)、普通共训练(Co-train)、EgoMimic、MimicPlay、ATM等基线,评估任务成功率(全流程完成)与阶段得分(抓取、放玩具、关抽屉)。

● 结果:

■ 行为泛化突破:EgoBridge在“仅人类观测的第4象限”成功率达33%,而所有基线(如EgoMimic、ATM)均完全失败。

■ 域内性能领先:在机器人已观测的3个象限中,EgoBridge成功率47%,较Robot-only BC(9%)、Co-train(22%)分别提升38、25个百分点。

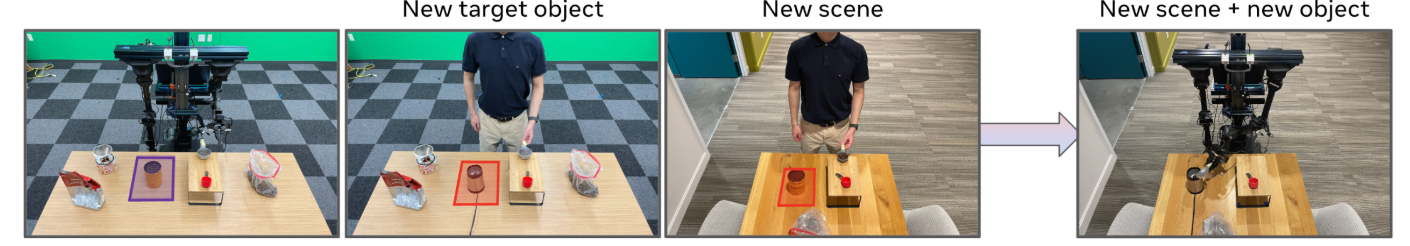

(3)真实世界实验2:咖啡勺取任务

● 实验过程:

机器人用左臂勺取咖啡豆,倒入目标容器(罐/研磨机),涉及场景与物体变化(原场景+罐→新场景+研磨机)。

■ 数据设置:机器人数据仅覆盖“原场景+罐”(50条演示),人类数据覆盖“原场景+罐”“新场景+研磨机”(2小时时长),测试对“新物体+新场景”的观测泛化能力。

■ 基线对比:同抽屉任务,评估不同场景下的勺取成功率。

● 结果:

■ 新物体泛化:对“新容器(研磨机)”,EgoBridge成功率60%,较EgoMimic(53%)、Co-train(46%)提升7-14个百分点。

■ 新场景+新物体泛化:在“新场景+研磨机”的未观测场景中,EgoBridge仍保持27%成功率,而所有基线完全失败。

(4)真实世界实验3:衣物折叠任务

实验过程:

任务目标:机器人用双臂完成衬衫折叠(右袖→左袖→整体对折),涉及衬衫初始位置(50×22cm范围)、颜色变化,测试双模态协调与视觉泛化能力。

■ 数据设置:机器人数据覆盖3种衬衫(300条演示,2小时),人类数据覆盖更多衬衫类型(700条演示,2小时),评估全流程成功率与阶段得分。

● 结果:

■ 域内性能领先:EgoBridge全流程成功率72%,较Robot-only BC(28%)、Co-train(33%)提升44、39个百分点,是所有基线中唯一突破70%的方法。

■ 鲁棒性强:在衬衫位置偏移(±30°旋转)、颜色变化场景中,EgoBridge阶段成功率(如右袖折叠)较EgoMimic提升19个百分点,无明显性能波动。

2、 实验假设及依据

文章提出3个核心假设(H1-H3),均通过实验数据与分析验证,依据如下:

(1)假设H1:EgoBridge提升“人类-机器人共现场景”的共训练性能

● 依据:

仿真实验:在“白色背景+正常T形”的共现场景中,EgoBridge平均奖励0.76,成功率53%,较Co-train(奖励0.71、成功率48%)、MMD(奖励0.64、成功率45%)显著提升。

真实世界实验: 抽屉任务共现场景(3个象限):EgoBridge成功率47%,较Robot-only BC(9%)提升38个百分点;

○ 咖啡勺取共现场景(原场景+罐):EgoBridge成功率67%,较EgoMimic(60%)提升7个百分点;

○ 衣物折叠共现场景:EgoBridge成功率72%,较所有基线提升至少39个百分点。

● 结论:EgoBridge通过最优传输(OT)对齐潜空间,解决了普通共训练的“潜变量分布偏移”问题,提升跨域知识迁移效率。

(2)假设H2:EgoBridge实现“仅人类观测场景”的泛化(物体、场景、行为)

● 依据:

物体泛化(咖啡任务):对“仅人类观测的研磨机”,EgoBridge成功率60%,其他基线(如ATM、MimicPlay)仅27%-33%。

○ 场景+物体泛化(咖啡任务):“新场景+研磨机”场景中,EgoBridge成功率27%,所有基线完全失败。

○ 行为泛化(抽屉任务):“仅人类观测的第4象限抽屉”中,EgoBridge成功率33%,其他基线均为0%。

○ 仿真泛化验证:“紫色背景+镜像T形”未观测场景中,EgoBridge成功率39%,Target-only BC、Standard OT等均低于15%。

● 结论:EgoBridge通过动态时间规整(DTW)构建行为相似伪对,使潜空间保留“动作相关信息”,实现对未观测场景的泛化。

(3)假设H3:EgoBridge学习到“人类-机器人任务相关对齐”的共享潜空间

● 依据:

潜空间可视化(TSNE分析):EgoBridge的人类-机器人潜变量Wasserstein-2距离接近0,显著低于Co-train(7.642)、MimicPlay(10.55),表明全局分布对齐更优。

○ 语义相似性验证(K近邻分析):在抽屉、咖啡任务中,EgoBridge的潜空间K近邻对均对应“相同任务阶段”(如“抓取玩具”“勺取咖啡豆”),而Co-train、MimicPlay的近邻对常出现语义错位(如“抓取玩具”匹配“关闭抽屉”)。

○ 消融实验佐证:移除DTW伪对(改用MSE)或仅对齐边缘分布(Standard OT)后,潜空间对齐效果下降,抽屉任务域内成功率从47%降至14%-33%,泛化成功率从33%降至17%,证明“任务相关对齐”对潜空间有效性的关键作用。

● 结论:EgoBridge的“OT+DTW”联合对齐机制,使潜空间同时满足“跨域分布一致”与“动作语义保留”,为知识迁移提供基础。

EgoBridge,旨在利用第一视角人类数据高效提升机器人操作能力。该框架的核心创新在于,通过最优传输技术对齐人类与机器人数据的策略潜在空间,并结合动态时间规整构建行为相似的伪样本对,在对齐跨域分布的同时保留关键动作信息——既解决了传统域适应方法忽略动作关联性的缺陷,又缓解了人类与机器人在视觉外观、传感器模态、运动学上的域差距,从而实现人类与机器人数据的任务相关对齐,为跨域模仿学习提供了高效且通用的新方案。