【完整源码+数据集+部署教程】 盲道砖块缺陷检测系统源码和数据集:改进yolo11-unireplknet

背景意义

研究背景与意义

随着城市化进程的加快,公共设施的建设和维护显得尤为重要,尤其是针对视障人士的无障碍设施。在众多无障碍设施中,盲道砖块作为重要的导向工具,能够有效帮助视障人士在城市环境中安全行走。然而,盲道砖块在长期使用过程中,容易出现磨损、破损和缺陷,这不仅影响了其功能性,还可能对视障人士的安全造成威胁。因此,及时、准确地检测盲道砖块的缺陷,对于提升城市无障碍环境的安全性和可用性具有重要意义。

传统的盲道砖块缺陷检测方法多依赖人工巡查,效率低下且容易受到主观因素的影响。随着计算机视觉技术的迅猛发展,基于深度学习的自动化检测方法逐渐成为研究热点。YOLO(You Only Look Once)系列算法因其高效的实时检测能力,已被广泛应用于各类目标检测任务中。特别是YOLOv11的改进版本,结合了更先进的特征提取和处理机制,能够在复杂环境中实现更高的检测精度和速度。

本研究旨在基于改进的YOLOv11算法,构建一个盲道砖块缺陷检测系统。该系统将利用包含4198张标注图像的数据集,专注于盲道砖块的缺陷识别。通过对数据集的深入分析和模型的优化训练,期望能够实现对盲道砖块缺陷的自动化检测,提升检测的准确性和效率。这不仅能够为城市无障碍设施的维护提供技术支持,还能为视障人士的安全出行提供保障,推动社会对无障碍环境建设的重视和投入。

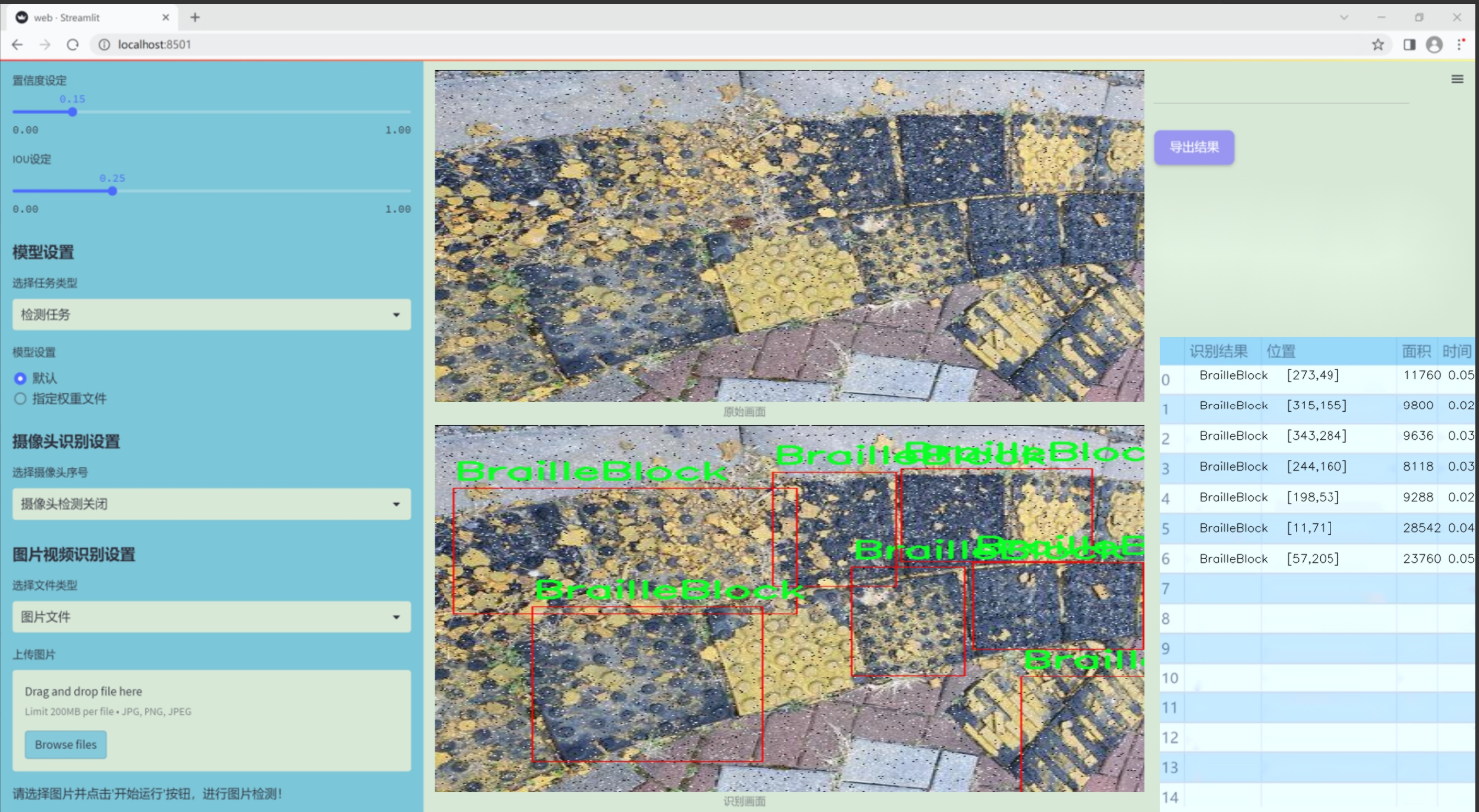

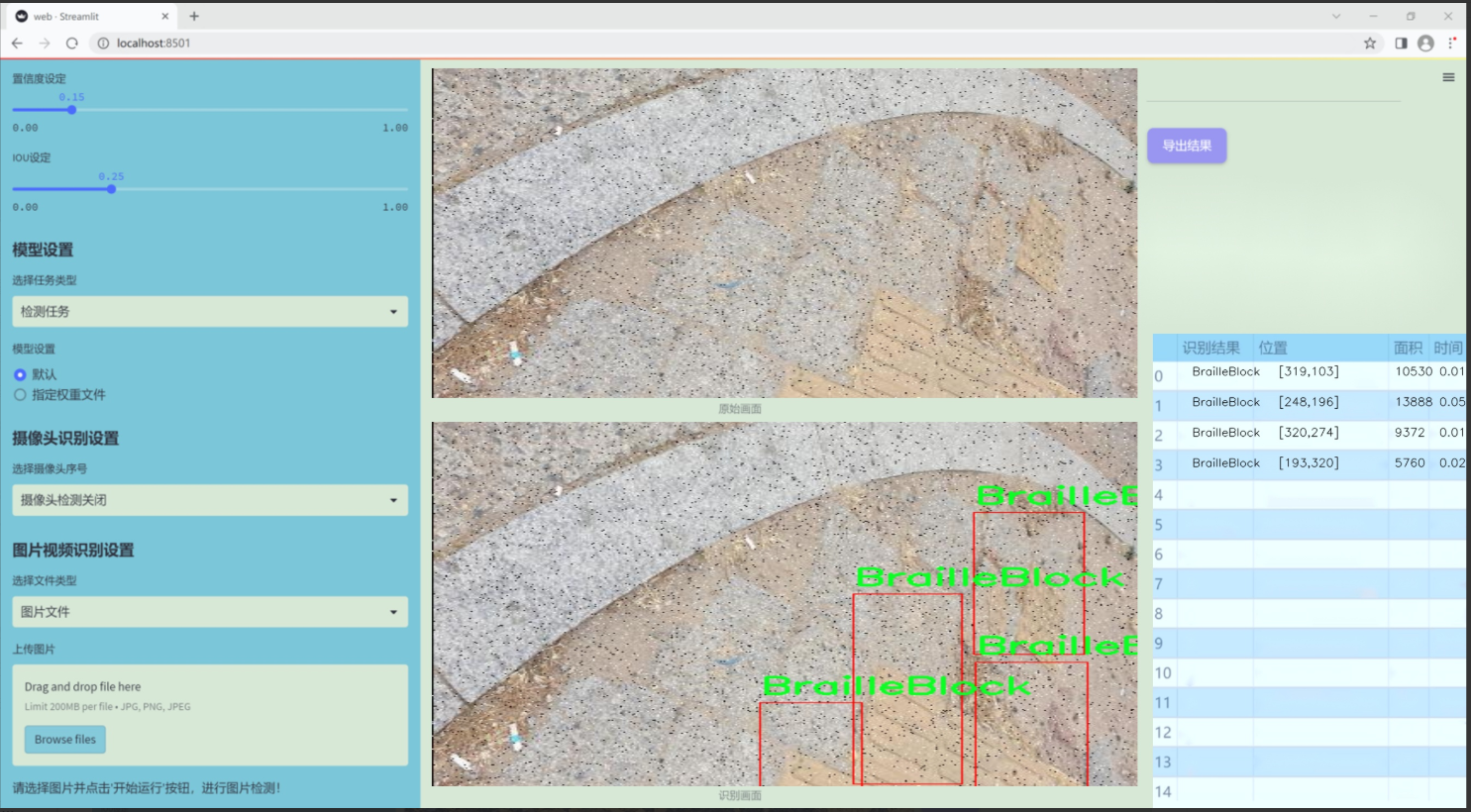

图片效果

数据集信息

本项目数据集信息介绍

本项目所使用的数据集专注于盲道砖块的缺陷检测,旨在为改进YOLOv11模型提供高质量的训练数据。数据集的主题为“BrailleBlock”,主要涵盖了盲道砖块的各种形态和状态,特别是针对其在实际应用中可能出现的缺陷。该数据集的类别数量为1,具体类别为“BrailleBlock”,这意味着所有的数据样本均围绕这一特定类别展开,确保了数据集的专一性和针对性。

在数据收集过程中,我们通过实地拍摄和图像采集的方式,涵盖了不同环境和光照条件下的盲道砖块图像。这些图像不仅包括完好无损的盲道砖块,还包括因磨损、破损、错位等原因导致的各种缺陷样本。这种多样化的样本选择,旨在提高模型对不同缺陷的识别能力,从而增强其在实际应用中的有效性和可靠性。

数据集中的图像经过精心标注,确保每一张图像都能够准确反映盲道砖块的状态。这一过程不仅涉及到对缺陷的标识,还包括对砖块整体结构的分析,力求为模型提供全面的信息支持。此外,为了提高模型的泛化能力,数据集中还包含了不同角度、不同距离拍摄的图像,使得模型在面对实际场景时能够更好地适应变化。

总之,本项目的数据集为盲道砖块缺陷检测系统的训练提供了坚实的基础,旨在通过改进YOLOv11模型,提升其在实际应用中的表现,最终实现对盲道砖块状态的高效、准确检测。这不仅有助于提升公共设施的安全性,也为盲人出行提供了更为可靠的保障。

核心代码

以下是经过简化和注释的核心代码部分,保留了 EfficientFormerV2 模型的主要结构和功能:

import torch

import torch.nn as nn

import math

import itertools

class Attention4D(nn.Module):

def init(self, dim=384, key_dim=32, num_heads=8, attn_ratio=4, resolution=7, act_layer=nn.ReLU, stride=None):

super().init()

self.num_heads = num_heads # 注意力头的数量

self.scale = key_dim ** -0.5 # 缩放因子

self.key_dim = key_dim # 键的维度

self.d = int(attn_ratio * key_dim) # 注意力的维度

self.dh = self.d * num_heads # 总的注意力维度

# 处理输入的分辨率和步幅if stride is not None:self.resolution = math.ceil(resolution / stride)self.stride_conv = nn.Conv2d(dim, dim, kernel_size=3, stride=stride, padding=1, groups=dim)self.upsample = nn.Upsample(scale_factor=stride, mode='bilinear')else:self.resolution = resolutionself.stride_conv = Noneself.upsample = None# 定义查询、键、值的卷积层self.q = nn.Conv2d(dim, num_heads * key_dim, 1)self.k = nn.Conv2d(dim, num_heads * key_dim, 1)self.v = nn.Conv2d(dim, num_heads * self.d, 1)# 注意力偏置points = list(itertools.product(range(self.resolution), repeat=2))attention_offsets = {}idxs = []for p1 in points:for p2 in points:offset = (abs(p1[0] - p2[0]), abs(p1[1] - p2[1]))if offset not in attention_offsets:attention_offsets[offset] = len(attention_offsets)idxs.append(attention_offsets[offset])self.attention_biases = nn.Parameter(torch.zeros(num_heads, len(attention_offsets)))self.register_buffer('attention_bias_idxs', torch.LongTensor(idxs).view(len(points), len(points)))def forward(self, x):B, C, H, W = x.shape # 获取输入的形状if self.stride_conv is not None:x = self.stride_conv(x) # 进行步幅卷积# 计算查询、键、值q = self.q(x).flatten(2).reshape(B, self.num_heads, -1, self.resolution).permute(0, 1, 3, 2)k = self.k(x).flatten(2).reshape(B, self.num_heads, -1, self.resolution).permute(0, 1, 2, 3)v = self.v(x).flatten(2).reshape(B, self.num_heads, -1, self.resolution).permute(0, 1, 3, 2)# 计算注意力权重attn = (q @ k) * self.scale + self.attention_biases[:, self.attention_bias_idxs]attn = attn.softmax(dim=-1) # 归一化# 计算输出x = (attn @ v).transpose(2, 3).reshape(B, self.dh, self.resolution, self.resolution)if self.upsample is not None:x = self.upsample(x) # 上采样return x

class EfficientFormerV2(nn.Module):

def init(self, layers, embed_dims, num_classes=1000):

super().init()

self.patch_embed = nn.Conv2d(3, embed_dims[0], kernel_size=3, stride=2, padding=1) # 初始嵌入层

self.network = nn.ModuleList() # 存储网络的各个层

# 构建网络的各个阶段for i in range(len(layers)):stage = []for _ in range(layers[i]):stage.append(Attention4D(dim=embed_dims[i])) # 添加注意力层self.network.append(nn.Sequential(*stage)) # 将阶段添加到网络中self.classifier = nn.Linear(embed_dims[-1], num_classes) # 分类器def forward(self, x):x = self.patch_embed(x) # 嵌入输入for block in self.network:x = block(x) # 通过网络的每个阶段x = x.mean(dim=[2, 3]) # 全局平均池化x = self.classifier(x) # 分类return x

定义模型的实例

def efficientformerv2_s0(num_classes=1000):

model = EfficientFormerV2(

layers=[2, 2, 4, 2], # 各层的深度

embed_dims=[32, 64, 128, 256], # 各层的嵌入维度

num_classes=num_classes

)

return model

测试模型

if name == ‘main’:

inputs = torch.randn((1, 3, 640, 640)) # 输入示例

model = efficientformerv2_s0() # 创建模型

res = model(inputs) # 前向传播

print(res.size()) # 输出结果的形状

代码说明:

Attention4D 类:实现了一个四维注意力机制,包括查询、键、值的计算,以及注意力权重的归一化和输出的计算。

EfficientFormerV2 类:构建了整个 EfficientFormerV2 模型,包含了嵌入层和多个注意力层,最后通过全局平均池化和线性层进行分类。

efficientformerv2_s0 函数:用于创建一个特定配置的 EfficientFormerV2 模型实例。

主程序:测试模型的前向传播,输出结果的形状。

这个程序文件实现了一个名为 EfficientFormerV2 的深度学习模型,主要用于图像处理任务。模型的设计灵感来源于视觉变换器(Vision Transformer),并在此基础上进行了优化,以提高计算效率和性能。

首先,文件中定义了一些模型的超参数,包括不同规模(S0, S1, S2, L)的宽度和深度。这些参数以字典的形式存储,方便后续模型的构建。每种规模对应不同的网络层数和通道数,以适应不同的应用场景和计算资源。

接下来,文件中定义了多个类,分别实现了模型的不同组件。其中 Attention4D 类实现了一个四维注意力机制,支持多头注意力和可选的下采样功能。这个类通过卷积层来生成查询(Q)、键(K)和值(V),并计算注意力权重。它还实现了局部注意力机制,以增强模型对局部特征的捕捉能力。

Embedding 类负责将输入图像转换为嵌入特征,使用卷积层进行特征提取。根据是否使用轻量级或自适应下采样的策略,Embedding 类的实现有所不同。

Mlp 类实现了多层感知机(MLP),使用1x1卷积进行特征转换,并包含激活函数和归一化层。AttnFFN 和 FFN 类则分别实现了结合注意力机制和MLP的前馈网络。

eformer_block 函数用于构建模型的各个块,根据给定的层数和参数配置生成相应的网络结构。EfficientFormerV2 类是整个模型的核心,负责整合各个组件并定义前向传播逻辑。该类的构造函数中根据输入的层数和通道数构建网络,并在需要时添加归一化层。

文件的最后部分定义了几个函数,用于创建不同规模的 EfficientFormerV2 模型,并支持加载预训练权重。update_weight 函数用于更新模型的权重,确保加载的权重与模型结构匹配。

在 main 部分,程序通过随机生成的输入张量测试了不同规模的模型,并打印出每个模型输出的特征图尺寸。这部分代码可以用于验证模型的构建是否正确。

总体来说,这个程序文件展示了如何构建一个高效的视觉变换器模型,涵盖了从基本组件到整体架构的设计思路,并提供了灵活的接口以适应不同的应用需求。

10.4 RFAConv.py

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

import torch.nn as nn

from einops import rearrange

class RFAConv(nn.Module):

def init(self, in_channel, out_channel, kernel_size, stride=1):

super().init()

self.kernel_size = kernel_size

# 用于生成权重的网络self.get_weight = nn.Sequential(nn.AvgPool2d(kernel_size=kernel_size, padding=kernel_size // 2, stride=stride),nn.Conv2d(in_channel, in_channel * (kernel_size ** 2), kernel_size=1, groups=in_channel, bias=False))# 用于生成特征的网络self.generate_feature = nn.Sequential(nn.Conv2d(in_channel, in_channel * (kernel_size ** 2), kernel_size=kernel_size, padding=kernel_size // 2, stride=stride, groups=in_channel, bias=False),nn.BatchNorm2d(in_channel * (kernel_size ** 2)),nn.ReLU())# 最终的卷积层self.conv = nn.Conv2d(in_channel, out_channel, kernel_size=kernel_size, stride=kernel_size)def forward(self, x):b, c = x.shape[0:2] # 获取输入的批量大小和通道数weight = self.get_weight(x) # 计算权重h, w = weight.shape[2:] # 获取特征图的高度和宽度# 计算权重的softmaxweighted = weight.view(b, c, self.kernel_size ** 2, h, w).softmax(2) # b c*k**2, h, wfeature = self.generate_feature(x).view(b, c, self.kernel_size ** 2, h, w) # b c*k**2, h, w# 加权特征weighted_data = feature * weighted# 重排数据以适应卷积层的输入格式conv_data = rearrange(weighted_data, 'b c (n1 n2) h w -> b c (h n1) (w n2)', n1=self.kernel_size, n2=self.kernel_size)return self.conv(conv_data) # 返回卷积结果

class SE(nn.Module):

def init(self, in_channel, ratio=16):

super(SE, self).init()

self.gap = nn.AdaptiveAvgPool2d((1, 1)) # 全局平均池化

self.fc = nn.Sequential(

nn.Linear(in_channel, ratio, bias=False), # 从 c -> c/r

nn.ReLU(),

nn.Linear(ratio, in_channel, bias=False), # 从 c/r -> c

nn.Sigmoid()

)

def forward(self, x):b, c = x.shape[0:2] # 获取输入的批量大小和通道数y = self.gap(x).view(b, c) # 进行全局平均池化并调整形状y = self.fc(y).view(b, c, 1, 1) # 通过全连接层并调整形状return y # 返回通道注意力权重

class RFCBAMConv(nn.Module):

def init(self, in_channel, out_channel, kernel_size=3, stride=1):

super().init()

self.kernel_size = kernel_size

# 特征生成网络self.generate = nn.Sequential(nn.Conv2d(in_channel, in_channel * (kernel_size ** 2), kernel_size, padding=kernel_size // 2, stride=stride, groups=in_channel, bias=False),nn.BatchNorm2d(in_channel * (kernel_size ** 2)),nn.ReLU())# 权重生成网络self.get_weight = nn.Sequential(nn.Conv2d(2, 1, kernel_size=3, padding=1, bias=False), nn.Sigmoid())self.se = SE(in_channel) # 通道注意力模块# 最终的卷积层self.conv = nn.Conv2d(in_channel, out_channel, kernel_size=kernel_size, stride=kernel_size)def forward(self, x):b, c = x.shape[0:2] # 获取输入的批量大小和通道数channel_attention = self.se(x) # 计算通道注意力generate_feature = self.generate(x) # 生成特征h, w = generate_feature.shape[2:] # 获取特征图的高度和宽度generate_feature = generate_feature.view(b, c, self.kernel_size ** 2, h, w) # 调整形状# 重排数据以适应卷积层的输入格式generate_feature = rearrange(generate_feature, 'b c (n1 n2) h w -> b c (h n1) (w n2)', n1=self.kernel_size, n2=self.kernel_size)# 计算加权特征unfold_feature = generate_feature * channel_attention# 计算最大值和均值特征max_feature, _ = torch.max(generate_feature, dim=1, keepdim=True)mean_feature = torch.mean(generate_feature, dim=1, keepdim=True)# 计算感受野注意力receptive_field_attention = self.get_weight(torch.cat((max_feature, mean_feature), dim=1))# 返回卷积结果conv_data = unfold_feature * receptive_field_attentionreturn self.conv(conv_data)

代码说明:

RFAConv:实现了一种加权特征生成的卷积层,首先通过平均池化和卷积生成权重,然后生成特征,最后将加权特征输入到卷积层中。

SE:实现了通道注意力机制,通过全局平均池化和全连接层生成通道权重,用于增强重要特征的表达。

RFCBAMConv:结合了特征生成、通道注意力和感受野注意力的卷积层,旨在提升特征提取的能力。

以上是核心代码的精简与注释,主要集中在特征生成、权重计算和注意力机制的实现上。

这个程序文件 RFAConv.py 定义了一些用于卷积神经网络的模块,主要包括自定义的激活函数、卷积层以及结合注意力机制的卷积层。文件中包含多个类,每个类都实现了特定的功能。

首先,文件导入了必要的库,包括 PyTorch 和 einops。接着定义了两个自定义的激活函数类:h_sigmoid 和 h_swish。h_sigmoid 是一种激活函数,使用了 ReLU6 作为基础,输入加上 3 后进行归一化处理。h_swish 则是将输入与 h_sigmoid 的输出相乘,形成一种新的激活方式。

接下来是 RFAConv 类,它实现了一种特殊的卷积操作。该类的构造函数中定义了几个层,包括一个用于获取权重的平均池化层和卷积层,以及一个用于生成特征的卷积层。forward 方法中,输入数据经过权重计算和特征生成后,进行加权处理,并最终通过卷积层输出结果。

SE 类实现了 Squeeze-and-Excitation(SE)模块,通过全局平均池化和全连接层来生成通道注意力权重。该模块可以增强网络对重要特征的关注。

RFCBAMConv 类是一个结合了通道注意力和特征生成的卷积模块。它在构造函数中定义了特征生成层、权重获取层和 SE 模块。在 forward 方法中,首先计算通道注意力,然后生成特征并进行加权,最后通过卷积层输出结果。

最后,RFCAConv 类是一个结合了空间注意力机制的卷积模块。它的构造函数中同样定义了特征生成层和卷积层,并且通过自适应平均池化计算空间注意力。在 forward 方法中,生成特征后进行空间注意力的计算,最后将加权后的特征通过卷积层输出。

整体来看,这个文件实现了一些现代卷积神经网络中常用的结构,结合了注意力机制以提高特征提取的能力,适用于各种计算机视觉任务。

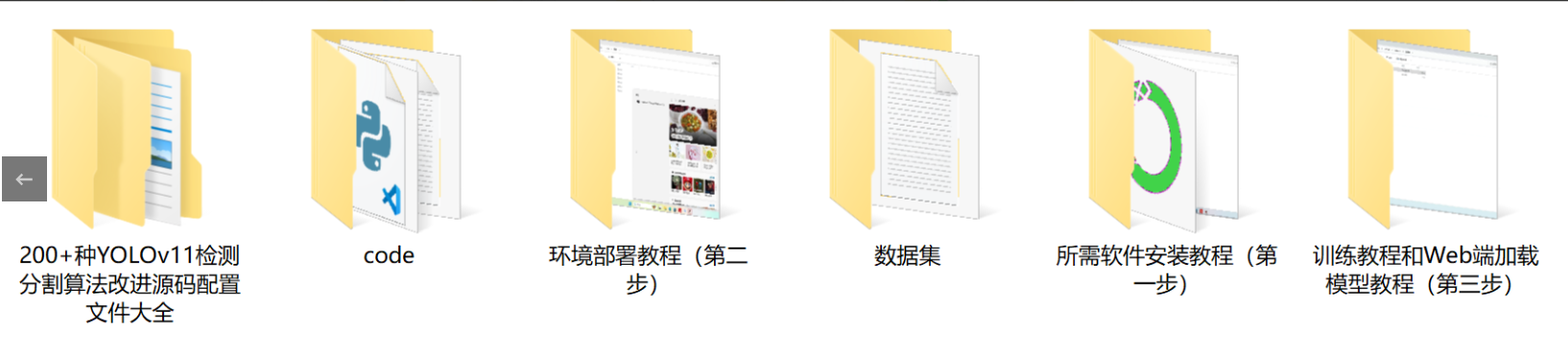

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式