AI-调查研究-100-具身智能 现代AI方法全解析:强化学习、模仿学习与Transformer在机器人控制中的应用

点一下关注吧!!!非常感谢!!持续更新!!!

🚀 AI篇持续更新中!(长期更新)

AI炼丹日志-31- 千呼万唤始出来 GPT-5 发布!“快的模型 + 深度思考模型 + 实时路由”,持续打造实用AI工具指南!📐🤖

💻 Java篇正式开启!(300篇)

目前2025年10月07日更新到:

Java-141 深入浅出 MySQL Spring事务失效的常见场景与解决方案详解(3)

MyBatis 已完结,Spring 已完结,Nginx已完结,Tomcat已完结,分布式服务正在更新!深入浅出助你打牢基础!

📊 大数据板块已完成多项干货更新(300篇):

包括 Hadoop、Hive、Kafka、Flink、ClickHouse、Elasticsearch 等二十余项核心组件,覆盖离线+实时数仓全栈!

大数据-278 Spark MLib - 基础介绍 机器学习算法 梯度提升树 GBDT案例 详解

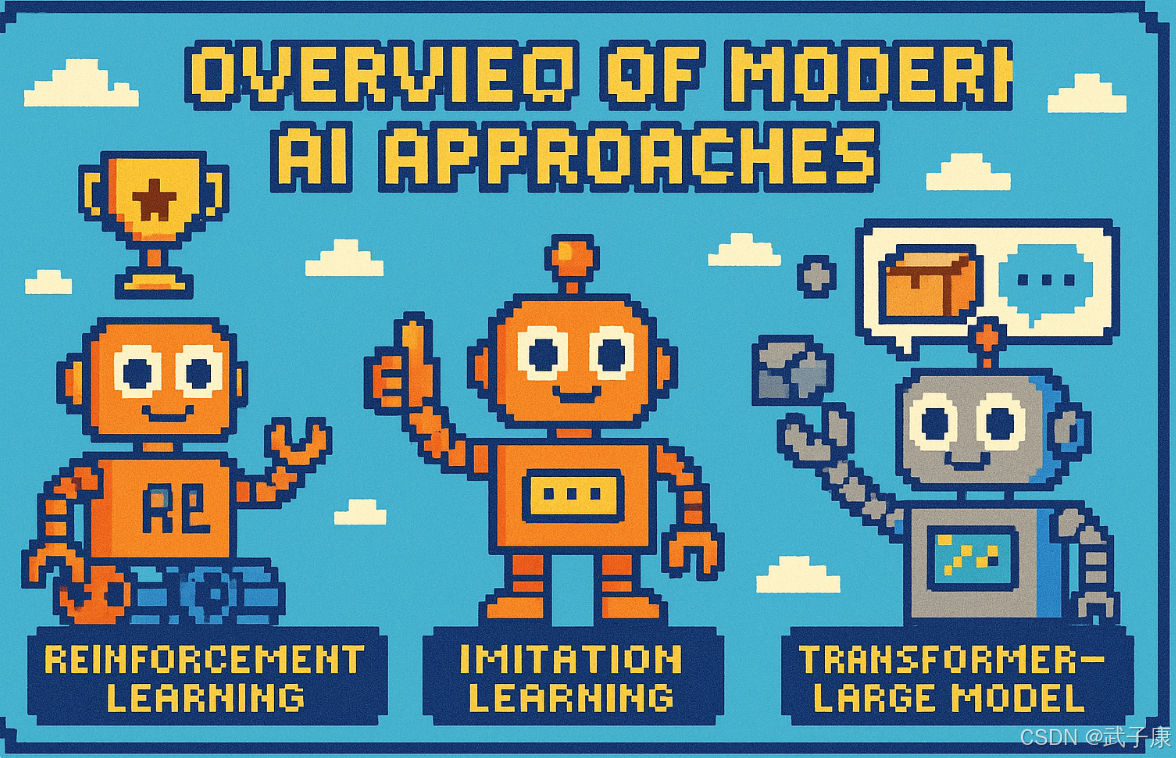

现代AI方法概览

面向机器人控制的现代智能体算法主要包括强化学习(RL)、模仿学习(含行为克隆 BC 等)、以及基于Transformer的大模型方法(如动作分块Transformer ACT、视觉-语言-动作模型 VLA 等),往往结合多模态感知。

强化学习在机器人领域的应用

核心概念

强化学习(Reinforcement Learning, RL)是一种通过环境奖励信号来驱动机器人自主学习策略的机器学习方法。其核心思想是让智能体(Agent)在与环境(Environment)的持续交互中,通过试错学习来优化决策策略,最终实现最大化累积奖励的目标。

典型算法与应用

当前主流的强化学习算法可分为三类:

- 值函数方法:如DQN(Deep Q-Network)及其变种(Double DQN、Dueling DQN等),适用于离散动作空间任务

- 策略梯度方法:如PPO(Proximal Policy Optimization)、TRPO(Trust Region Policy Optimization),适合连续动作控制

- 混合方法:如SAC(Soft Actor-Critic)、DDPG(Deep Deterministic Policy Gradient),结合了值函数和策略梯度的优势

这些算法已成功应用于以下机器人控制任务:

- 机械臂操作:抓取、装配、分拣等精细操作任务

- 移动机器人:室内外导航、避障、路径规划

- 仿生机器人:四足机器人行走/奔跑、人形机器人平衡控制

- 无人机:自主飞行、编队控制

训练流程与关键技术

- 环境建模:构建包含机器人动力学和任务目标的仿真环境(如PyBullet、MuJoCo、Isaac Gym)

- 奖励设计:精心设计奖励函数(如机械臂抓取任务可能包含:抓取成功奖励、动作平滑惩罚等)

- 并行采样:在仿真环境中同时运行数百个机器人实例,加速数据收集

- 策略优化:通过RL算法迭代更新策略网络参数

- Sim2Real迁移:采用域随机化等技术提升策略在真实环境中的泛化能力

优势与挑战

优势:

- 能够通过探索发现超出人类示范性能的策略

- 适用于复杂、高维度的连续控制任务

- 在仿真环境中可大规模并行训练,降低硬件成本

挑战:

- 样本效率低:通常需要数百万次交互才能学到有效策略

- 奖励设计困难:不合理的奖励函数可能导致策略出现意外行为

- 现实风险:直接在真实机器人上训练可能导致设备损坏

- 实现复杂度高:需要搭建完整的仿真-训练-验证pipeline

- 超参数敏感:学习率、折扣因子等参数需要精心调试

典型应用案例

- OpenAI的机械手解魔方:使用PPO算法,通过强化学习训练机械手灵巧操作能力

- Boston Atlas机器人:采用强化学习实现复杂地形下的稳定行走

- 无人机竞速:通过RL训练出超越人类飞行员的控制策略

未来发展方向

- 样本效率提升:结合模仿学习、元学习等方法

- 安全强化学习:确保训练过程的安全性

- 多任务学习:开发可迁移的通用策略

- 仿真-现实鸿沟:改进Sim2Real技术

模仿学习

模仿学习(Imitation Learning, IL)是一种让机器人通过观察专家演示来学习行为的范式。它通过降低自主探索的难度,显著提高了学习效率。其中最简单直接的方法是行为克隆(Behavior Cloning, BC),其核心思想是将机器人控制问题转化为一个监督学习任务:将环境状态或观测作为输入,专家演示的动作作为输出,直接学习从状态到动作的映射关系 。

BC的优势在于实现简洁且不需要设计复杂的奖励函数。这种方法在工业机器人快速学习人类操作任务(如抓取、装配、焊接等)方面表现突出。例如,在汽车装配线上,通过记录熟练工人的操作轨迹,可以让新部署的机械臂在几小时内掌握装配技能。

然而,BC存在一个关键问题——分布漂移(Distribution Shift)。这是由于在执行过程中,微小的误差会不断累积,导致机器人逐渐偏离训练时见过的状态分布,进入未知状态空间  。这种误差累积效应使得纯BC方法在需要长时间精确控制的任务(如微创手术机器人操作)上表现欠佳 。

针对这一问题,研究者提出了多种改进方案:

- 策略在线修正(DAgger算法):通过迭代地收集机器人执行时的状态数据,并让专家标注正确动作

- 示范扰动注入:在训练数据中人为添加噪声,并记录专家如何从错误中恢复

- 混合学习框架:结合BC与其他强化学习方法

值得注意的是,在精密操作任务(如芯片贴装)中,这些干预方法往往难以实施:一方面专家纠正动作的采集成本高昂,另一方面注入的噪声可能破坏关键的运动精度 。

相比之下,IL的高级形式提供了更鲁棒的解决方案:

- 逆向强化学习(IRL):通过专家演示反推潜在奖励函数

- 生成对抗模仿学习(GAIL):使用判别器来区分专家和智能体的行为分布

这些方法虽然能更好地处理分布漂移问题,但实现复杂度显著提高,需要更复杂的训练过程和计算资源。例如,GAIL通常需要数百万次的策略迭代才能收敛,这在实时控制场景中可能不适用。

基于Transformer的序列决策模型

近年来,Transformer模型凭借其强大的序列建模能力,在自然语言处理和计算机视觉领域取得突破性进展后,被成功引入机器人控制领域。与传统循环神经网络相比,Transformer具有以下显著优势:

- 并行处理能力:Transformer可以同时处理整个输入序列,避免了RNN的时序依赖性

- 长程依赖建模:通过自注意力机制,能够有效捕捉序列中任意位置之间的依赖关系

- 可扩展性:模型规模可以灵活调整以适应不同复杂度的任务

在具体应用方面,Decision Transformer提出了一种创新的序列建模方法。它将机器人的历史状态-动作序列与未来期望回报(如目标回报或任务奖励)共同编码为一个单一的序列。通过对这个序列进行自回归建模,Transformer可以生成后续的动作序列。这种架构特别适合离线强化学习场景,因为它能够直接从历史数据中学习策略,而不需要与环境进行在线交互。

典型的Decision Transformer工作流程包括:

- 序列构建:将历史观测、动作和奖励拼接成输入序列

- 位置编码:为序列中的每个元素添加时序信息

- 注意力计算:通过多头注意力机制建立跨时间步的依赖关系

- 动作预测:基于上下文信息生成下一步动作

更先进的模型如GATO和PaLM-E则进一步扩展了这一范式。这些通用大模型实现了多模态统一编码,能够同时处理:

- 视觉输入(如摄像头图像)

- 文本指令(如任务描述)

- 机器人控制序列(如关节角度)

例如,PaLM-E模型将语言模型PaLM与视觉编码器结合,可以直接根据"请把红色积木放到蓝色盒子旁边"这样的自然语言指令生成相应的机器人动作序列。

Transformer在机器人控制中的核心优势体现在:

- 预训练知识迁移:可以利用在大量数据上预训练的表示,加速新任务的学习

- 长序列建模:能够处理长达数百步的决策序列,保持长期一致性

- 跨任务泛化:同一模型可以适应多种不同的机器人任务

- 多模态融合:有效整合视觉、语言和控制信号

这些特性使得Transformer架构成为当前最前沿的机器人决策模型的核心组件,为实现更智能、更通用的机器人控制系统提供了新的可能性。

动作分块 Transformer(ACT)

动作分块 Transformer(ACT)是由斯坦福大学等机构提出的Action Chunking with Transformers算法,它是一种创新的模仿学习框架,专门用于解决机器人连续动作控制问题。

核心算法原理

ACT的核心创新点在于将连续动作序列离散化为固定长度的动作块(chunk)。具体来说:

- 动作分块机制:算法将连续的关节空间动作划分为固定长度的动作块(通常k=10−20k=10-20k=10−20步)

- Transformer架构:采用Transformer解码器结构,一次性预测未来kkk步动作

- 决策频次降低:相比传统方法每步都需要决策,ACT只需每kkk步决策一次

技术细节

-

条件变分自编码器(CVAE):

- 通过CVAE训练策略捕获人类演示的多样性

- 编码器部分学习动作块的潜在表示

- 解码器部分基于当前观测和潜在变量生成动作序列

-

误差累积缓解:

- 传统模仿学习方法的误差会随着时间累积

- ACT将任务时域缩短了kkk倍,显著减轻了行为克隆(BC)的误差累积问题

性能表现

-

任务成功率:

- 在精细操作任务上(如撬开罐盖、插入电池)达到80-90%成功率

- 明显优于传统单步模仿学习方法(通常只有30-50%成功率)

-

动作精度:

- 直接预测连续关节空间动作(不进行离散化)

- 满足高精度操作需求(精度可达0.1mm级别)

-

计算效率:

- 预测时延降低为原来的1/kkk

- 在实时控制系统中表现优异

应用场景

-

硬件适配性:

- 特别适合低成本硬件系统(如Stanford ALOHA双臂机器人)

- 使精度不高的机器人也能完成精细操作任务

-

典型任务:

- 双手协调操作(如开瓶盖、组装零件)

- 需要高精度定位的任务(如插入USB接口)

- 长时间序列操作(如连续折叠衣物)

-

扩展应用:

- 工业装配线精密操作

- 医疗机器人手术辅助

- 家庭服务机器人日常任务

实现优势

-

训练数据效率:

- 相比强化学习,所需演示数据量显著减少

- 通常50-100次人类演示即可达到良好效果

-

迁移能力:

- 学习到的动作块具有一定泛化性

- 可适应相似但不完全相同的任务场景

-

实时性能:

- 在NVIDIA Jetson等边缘设备上可实现实时推理

- 典型推理时间<10ms/块