Windows本地Docker+Open-WebUI部署DeepSeek

最近想在自己的电脑本地部署一下DeepSeek试试,由于不希望污染电脑的Windows环境,所以在wsl中安装了ollama,使用ollama拉取DeepSeek模型。然后在Windows中安装了Docker Desktop,在Docker中部署了Open-WebUI,最后再在Open-WebUI中连接到wsl的ollama,大功告成!这里记录一下部署的过程。

显卡:NVIDIA GeForce RTX 3060 Laptop

Docker Desktop 版本:v4.38.0

ollama 版本:0.5.11

DeepSeek模型:DeepSeek R1 8b 4bit量化

目录

安装ollama

1.下载安装ollama

2.执行命令查看状态

3.查看ollama端口

4.查看本地模型执行命令

5.拉取DeepSeek模型

6.编辑ollama.service文件

安装Docker Desktop

1.下载 Docker Desktop

2.查看Docker是否正常工作

安装Open-WebUI

1.安装

2.Open-WebUI 接入 Ollama

安装ollama

首先Windows上需要安装了WSL2,网上很多教程,这里就不写详细过程了。

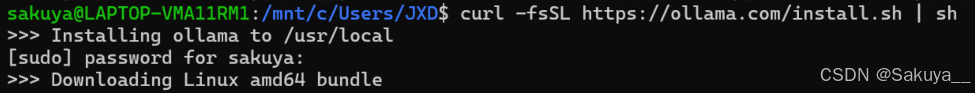

1.下载安装ollama

在终端里切换到WSL里,执行下面的命令下载安装ollama:

curl -fsSL https://ollama.com/install.sh | sh如果不挂梯子的话,会安装的非常慢,建议开梯子再下载。

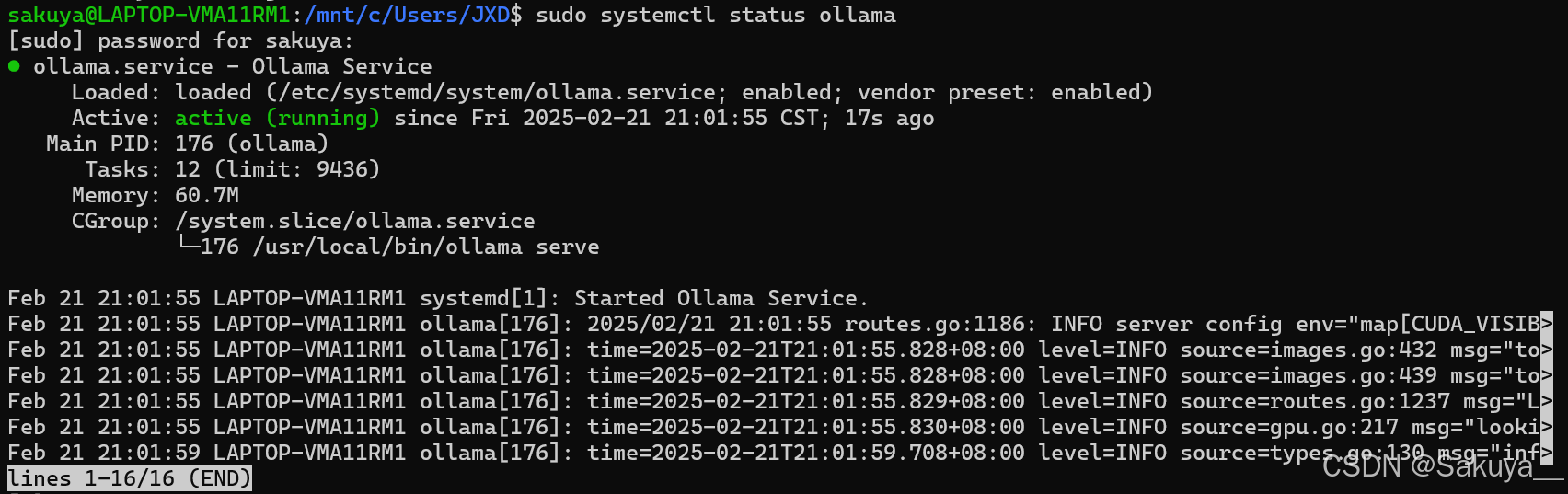

2.执行命令查看状态

sudo systemctl status ollama

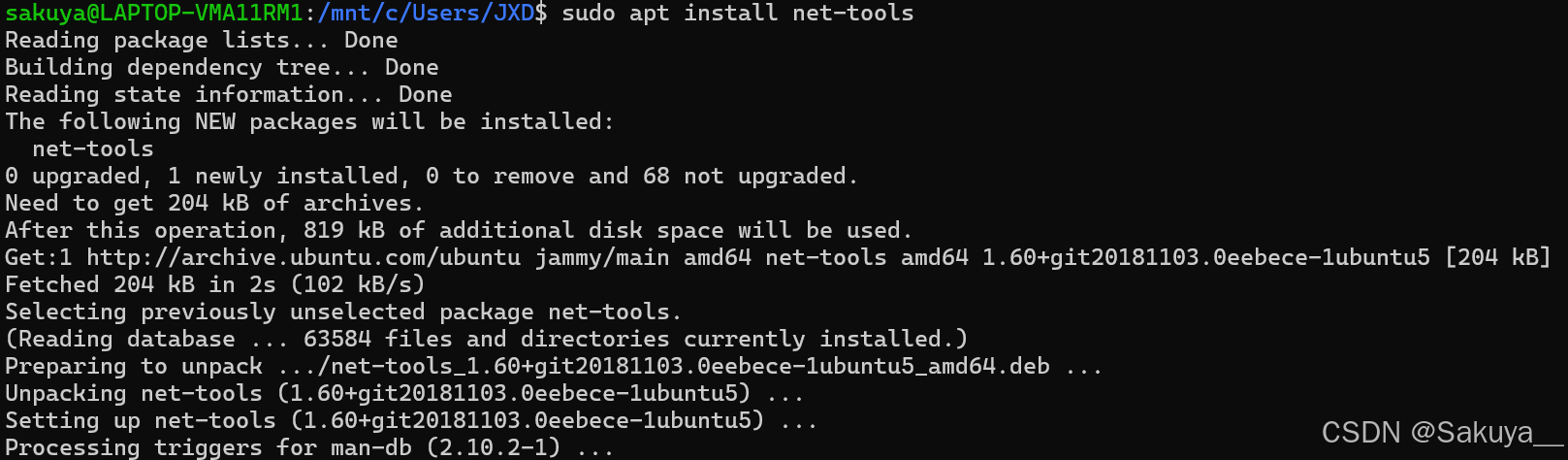

3.查看ollama端口

执行命令安装net-tools:

sudo apt install net-tools

执行命令:

sudo netstat -anp | grep 11434![]()

4.查看本地模型执行命令

ollama list![]()

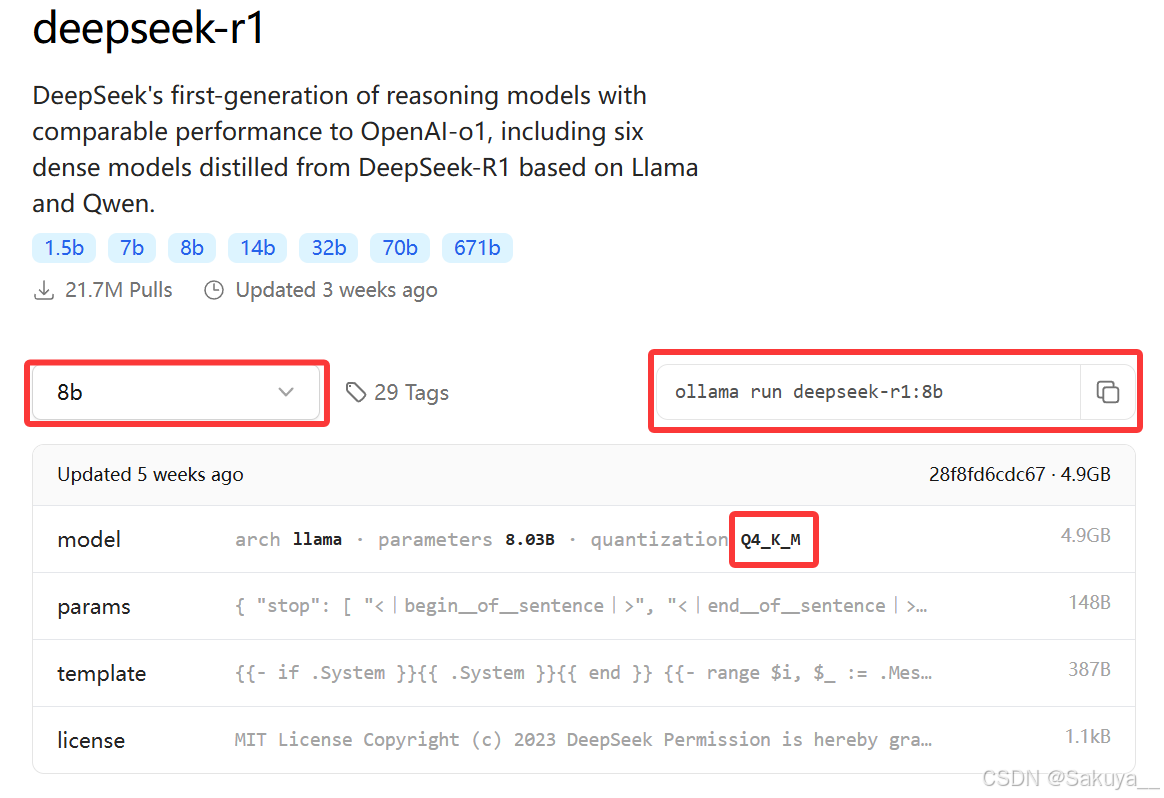

5.拉取DeepSeek模型

在 ollama 官网上可以查看可以拉取的模型以及对应的命令:https://ollama.com/search,我这里拉取的是DeepSeek R1 8b 的 4bit 量化版本,Q4_K_M表示量化的 4bit 版本:

执行命令,会先给你下载,再自动启动的:

ollama run deepseek-r1:8b 下载完后,可以看到本地已经有DeepSeek-R1:8b模型了。

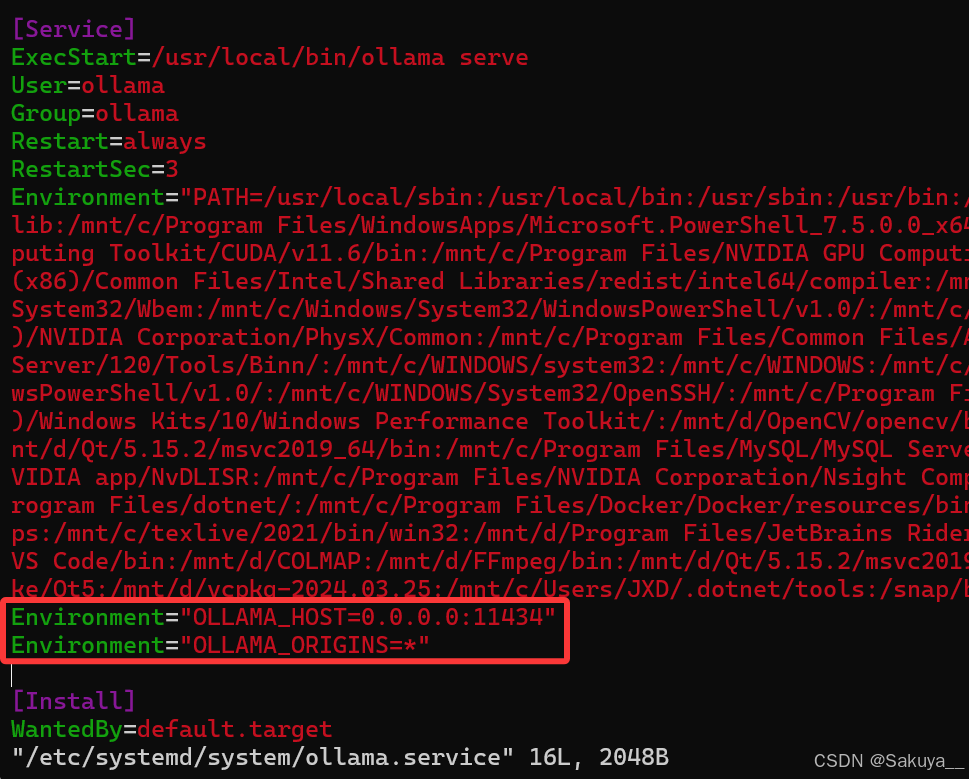

6.编辑ollama.service文件

执行下面的命令使用vim编辑ollama.service文件,并在其中添加如下两行:

sudo vim /etc/systemd/system/ollama.serviceEnvironment="OLLAMA_HOST=0.0.0.0:11434"

Environment="OLLAMA_ORIGINS=*"

改好以后记得使用下面的命令,重启ollama服务,然后可以关闭WSL:

sudo systemctl restart ollama安装Docker Desktop

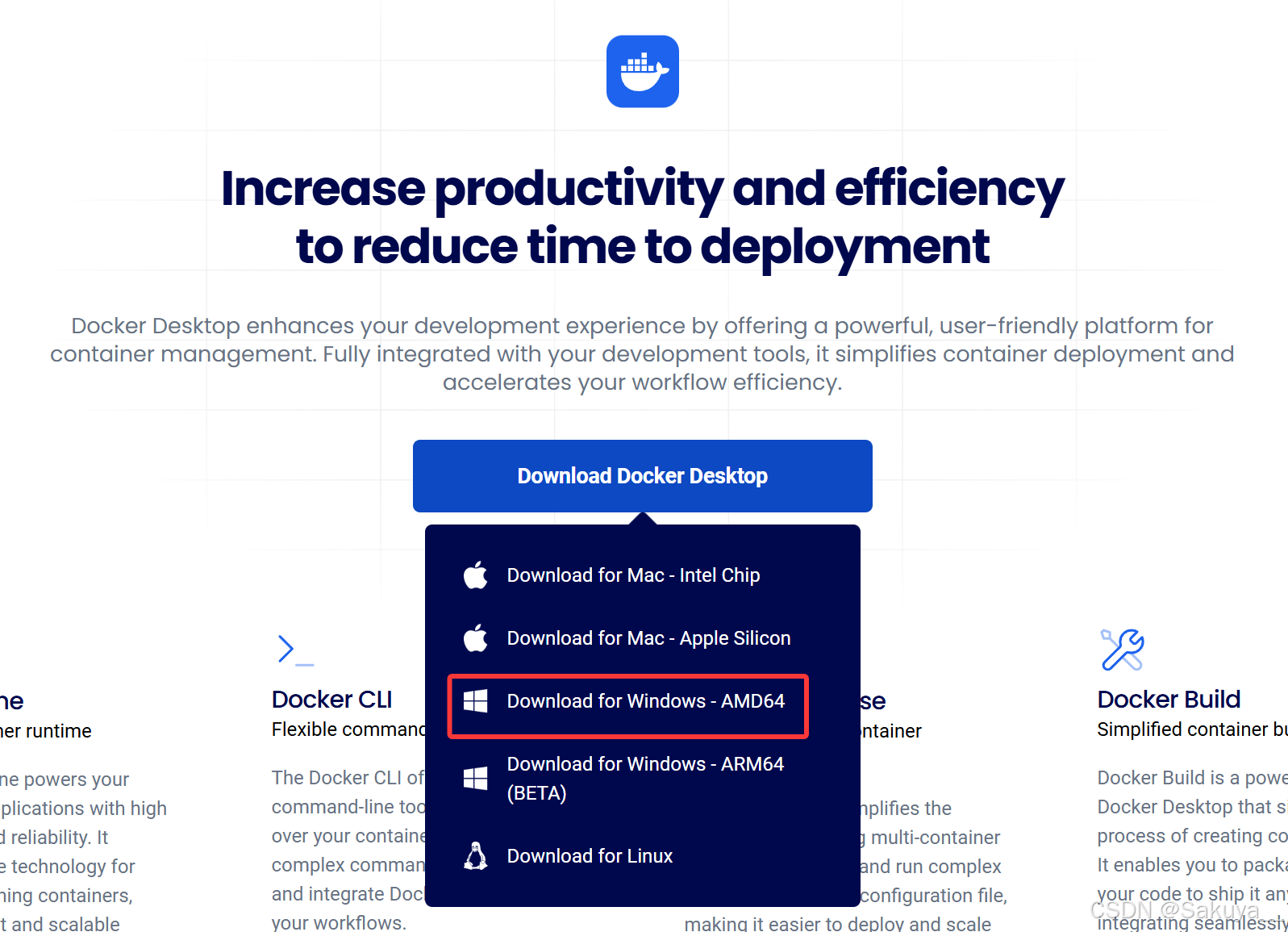

1.下载 Docker Desktop

访问 Docker 官网 下载 Docker Desktop。下载适用于 Windows 的 Docker Desktop 安装程序。

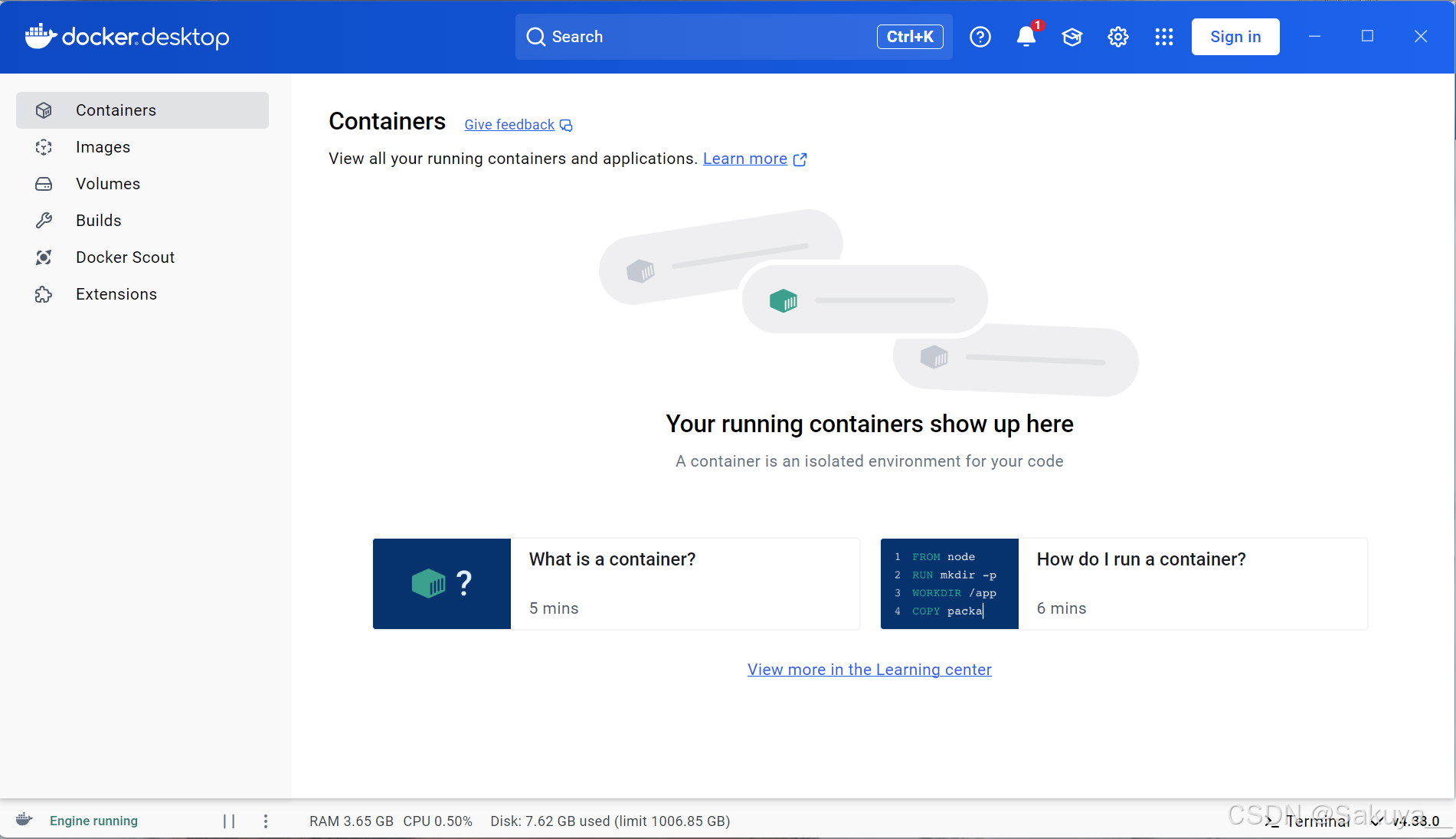

下载完成后双击安装,Docker Desktop 默认安装在:C:\Program Files\Docker\Docker。Docker会自动为你配置WSL 2和虚拟化支持。安装完成后打开:

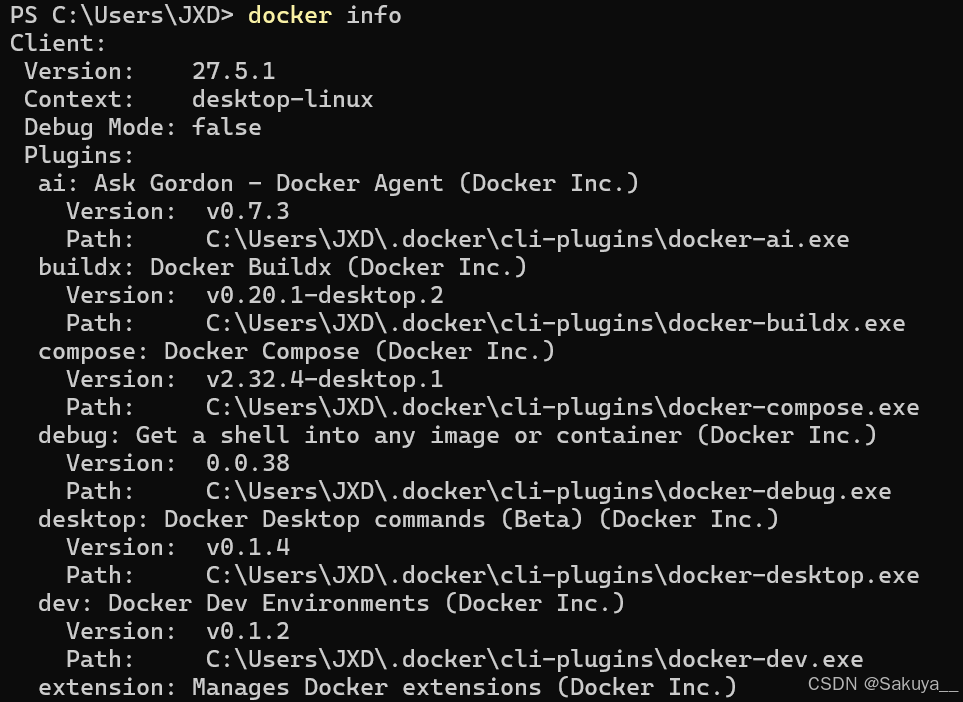

2.查看Docker是否正常工作

输入命令,查看 Docker 版本:

docker --version

输入命令,查看 Docker 的配置信息,包括容器和镜像的详细信息:

docker info

安装Open-WebUI

1.安装

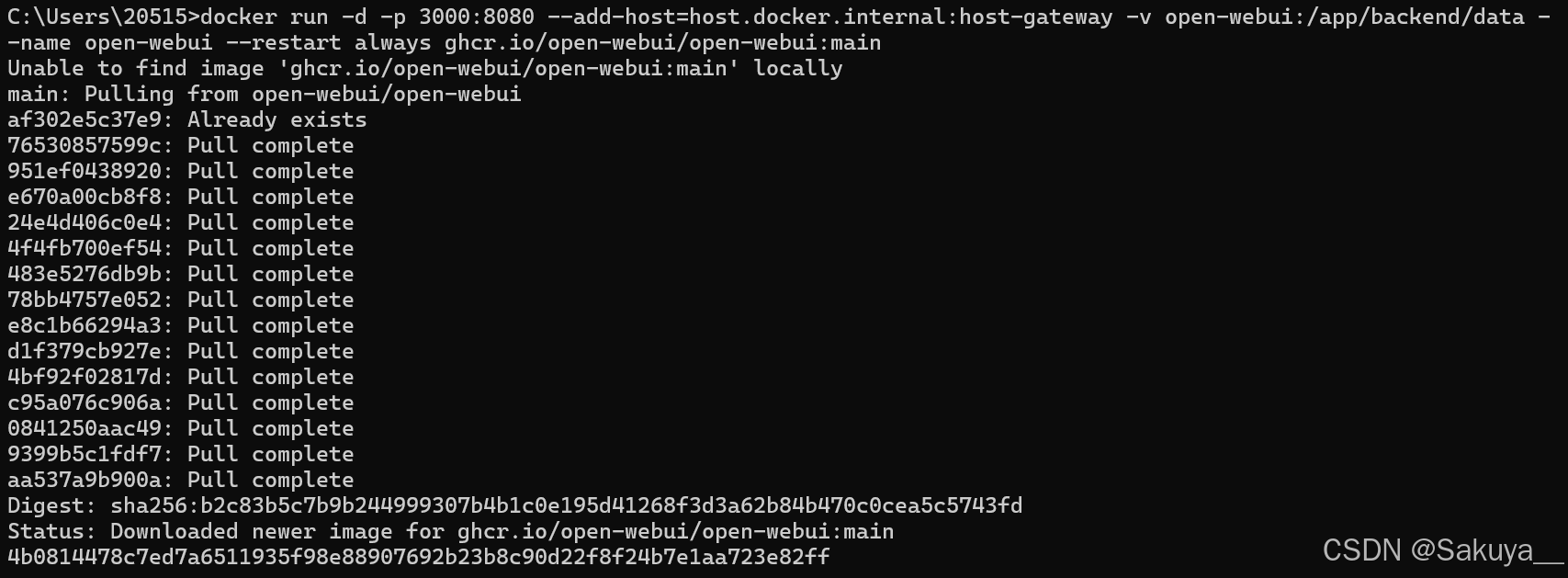

运行如下命令,安装 Open-WebUI:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

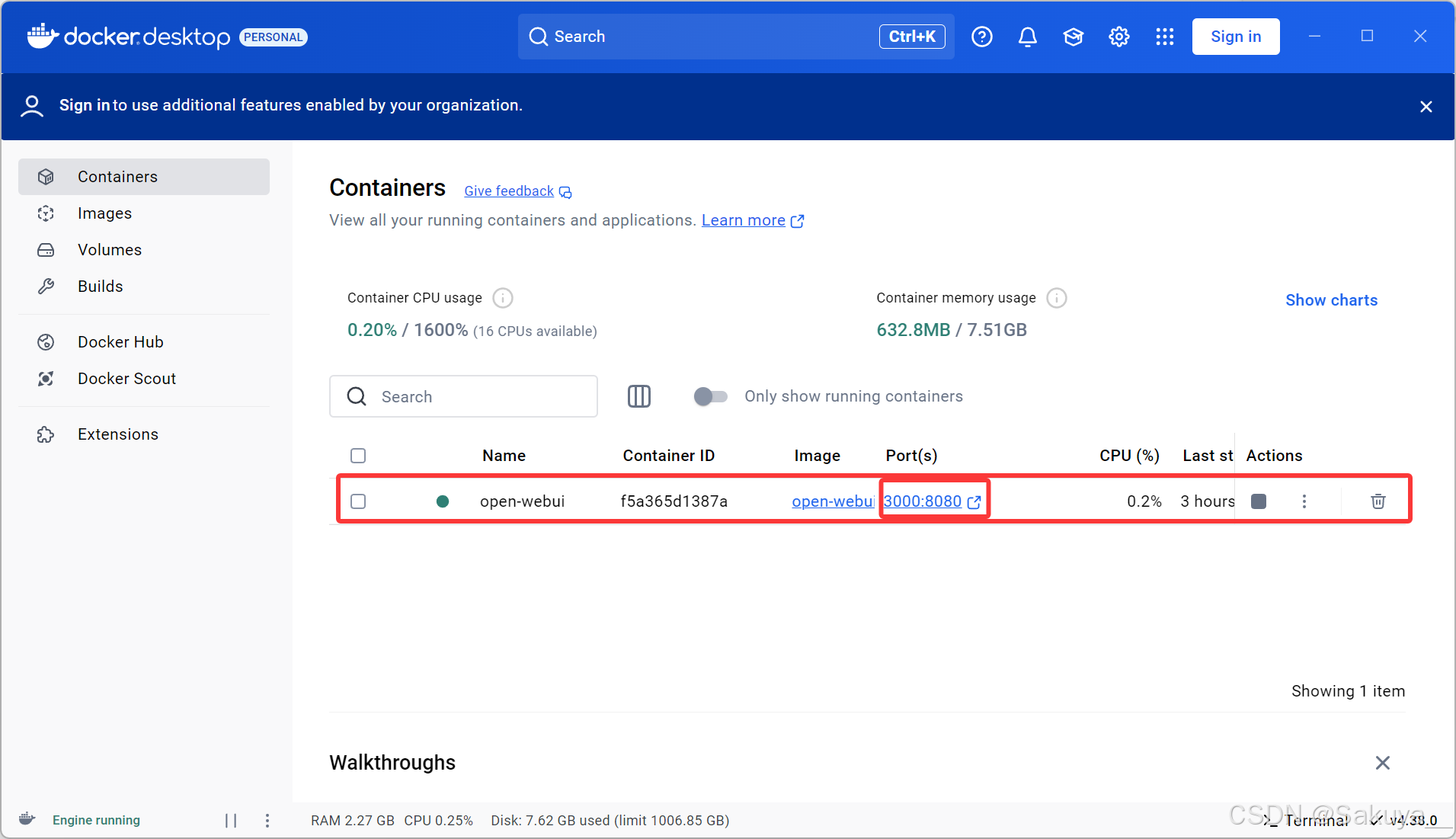

安装完后,重启 Docker Desktop ,可以查看到容器信息:

2.Open-WebUI 接入 Ollama

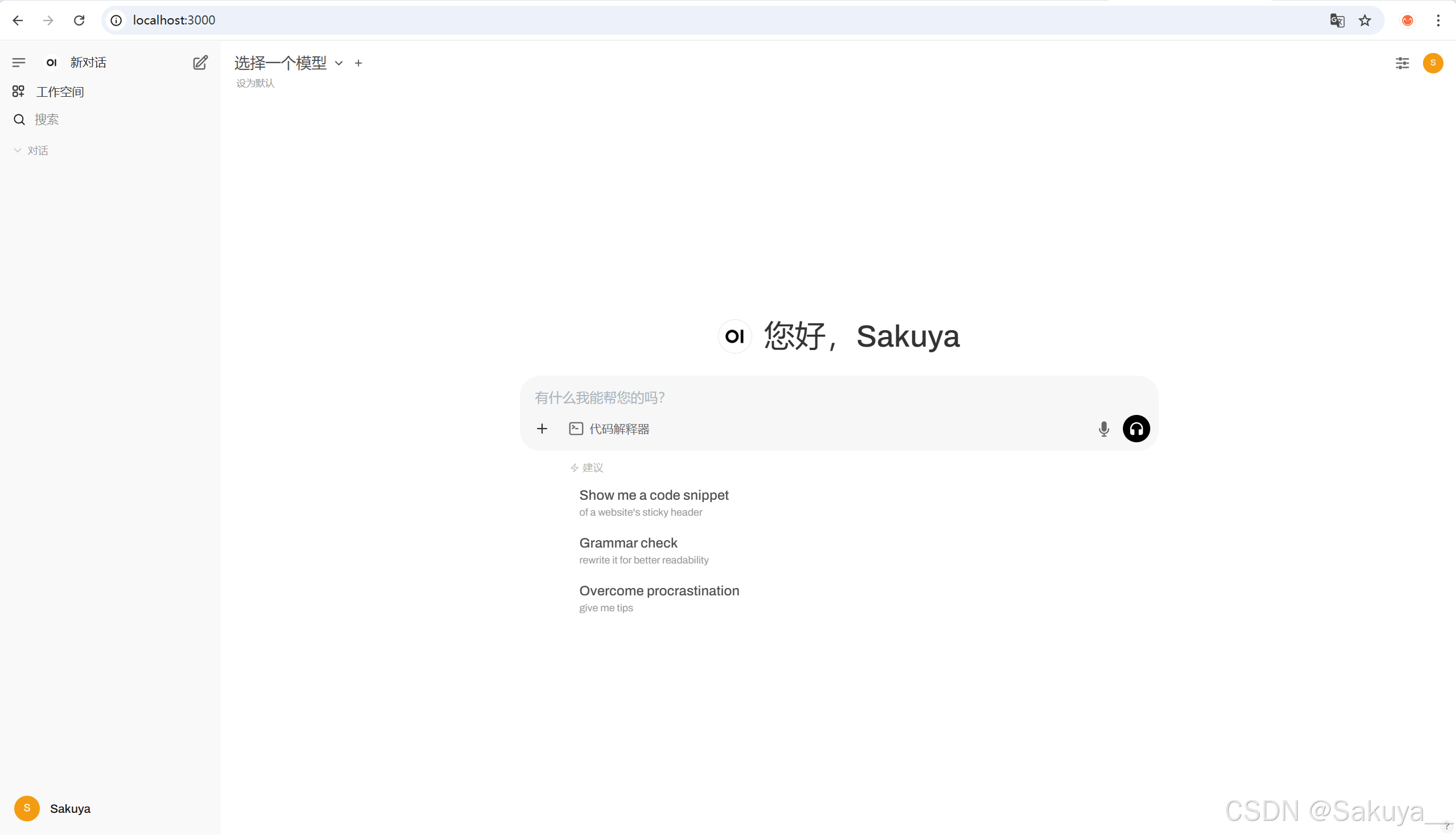

点击端口,进入 Open-WebUI ,注册管理员账号后进入主页面,这时候可以选择的模型列表还是空的:

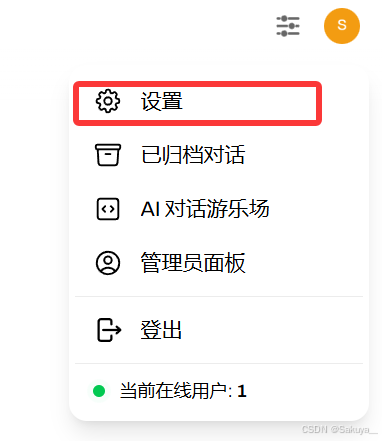

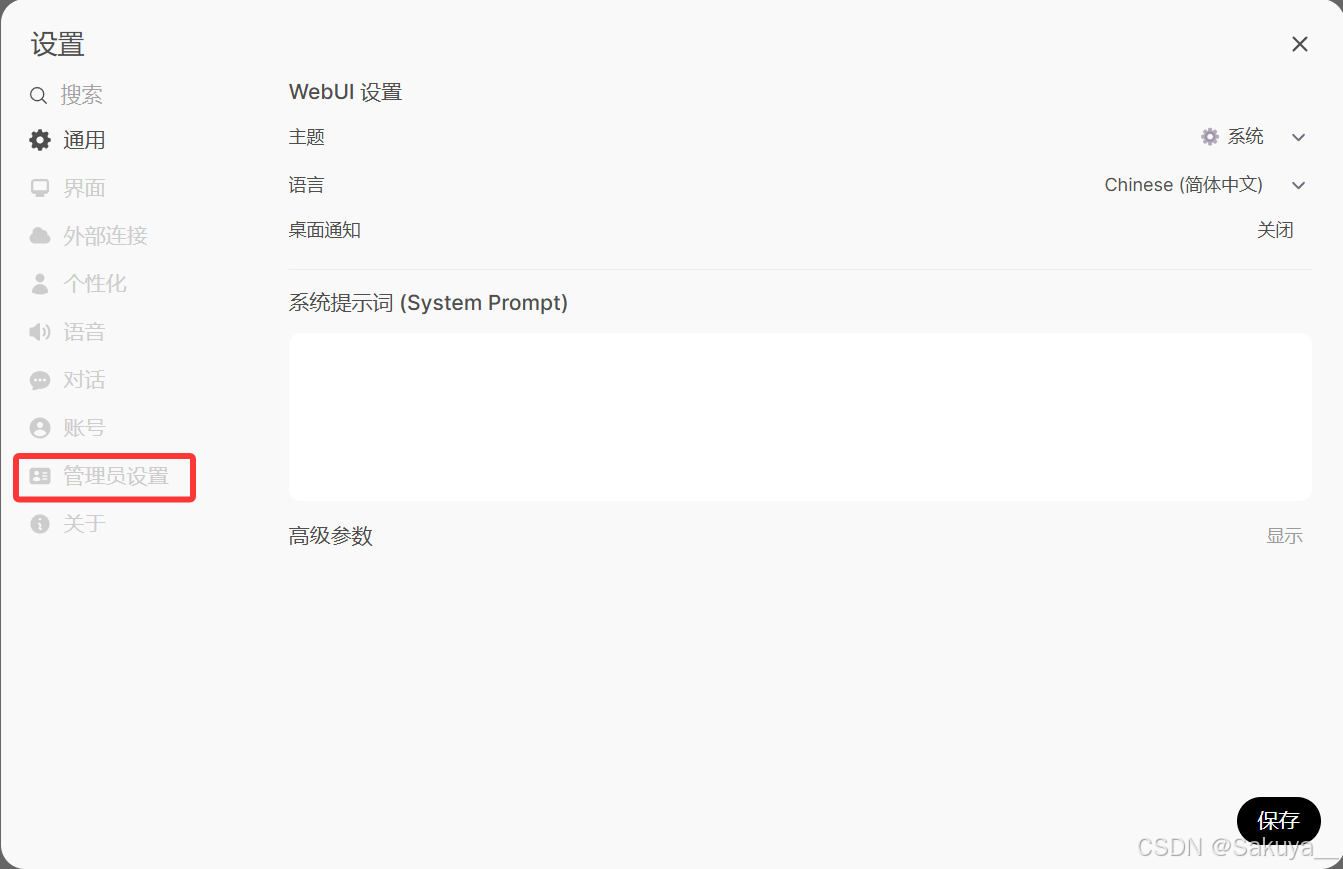

点击右上角头像—>设置—>管理员设置

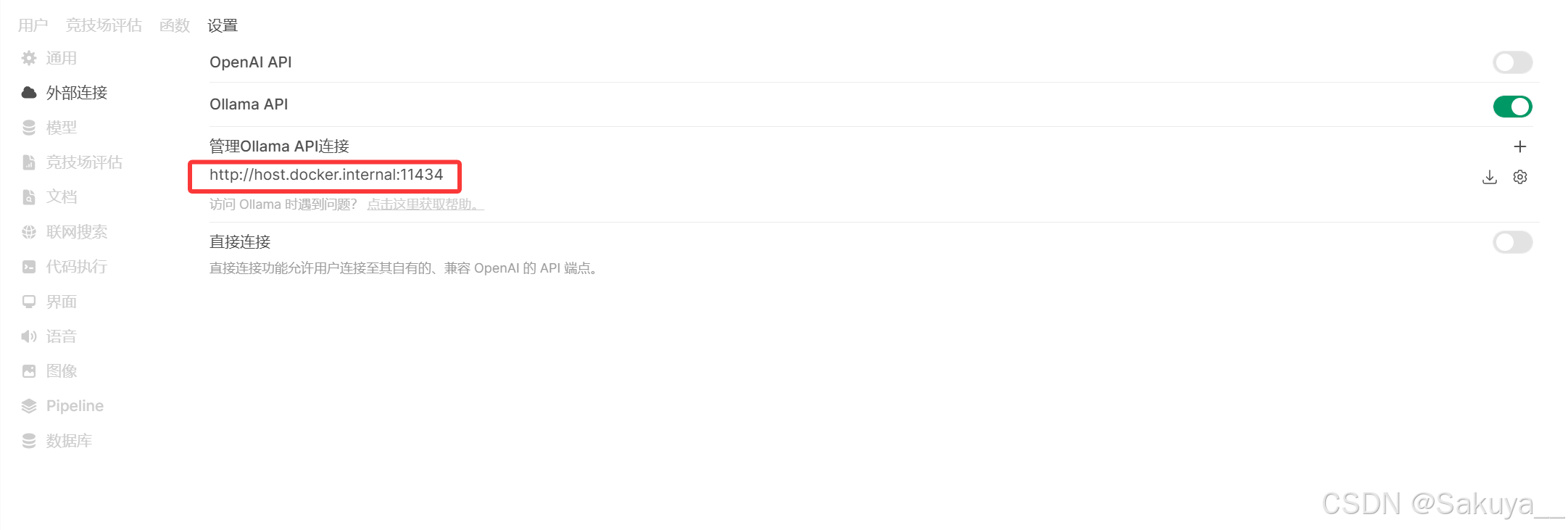

点击外部连接,选择Ollama API,设置连接地址:

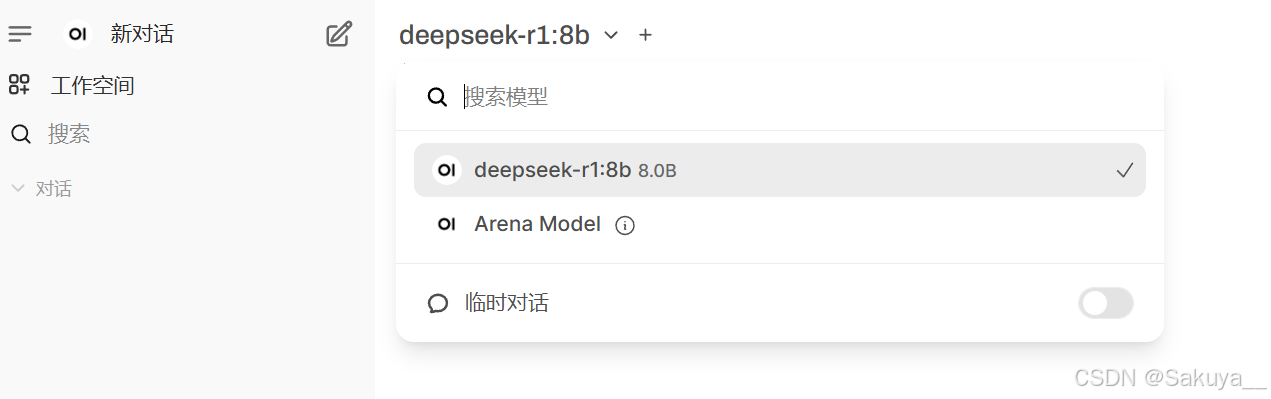

然后回到主页面,再点击选择一个模型,就可以看到我们再Ollama中拉取的DeepSeek-R1:8b模型了,大功告成!

参考博客:Windows 中使用 Docker Desktop 部署 Open WebUI 做大模型可视化_openwebui docker部署-CSDN博客