RynnVLA-001-7B: 使用人类演示增强机器人Manipulation--达摩院--2025.9.18--开源

0. 前言

他们官方是在SO100/SO101机械臂系列上做的实验,实机演示的效果不错,而且前段时间代码权重都开源了,而且我也做了源码剖析:RynnVLA-001–达摩院–开源–2025.8.11–介绍与源码剖析

整体代码的逻辑是顺畅易懂的,现在看到他们发布了技术报告,可以来学习学习。

github

1. 简要介绍

1.1 背景

过去几年里,大规模语言模型(……)、大规模多模态模型(……)、基于视觉的识别模型(……)以及生成模型(……)都取得了快速进展。这些领域的成功主要归功于大规模数据集的可用性。

例如,大型语言模型受益于来自网络来源的充足训练数据,这些数据相对容易获取。相比之下,Vision-Language-Action(VLA)模型的发展受制于大规模机器人操作数据的稀缺。收集这类数据通常依赖人工遥操物理机器人来记录操作轨迹,因此构建大规模数据集既费时又昂贵。为应对数据稀缺问题,已有一些早期尝试。

一方面,有些方法提出构建大规模机器人操作数据集(……),这些数据集在多样环境下甚至使用不同的机器人身体(embodiments)采集操作数据。然而,这些数据集的规模仍然远小于用于 LLM、VLM 和生成模型的数据集。

另一类研究尝试利用来自预训练生成模型或 VLM 的海量先验知识来缓解数据稀缺问题。

1.2 解决问题

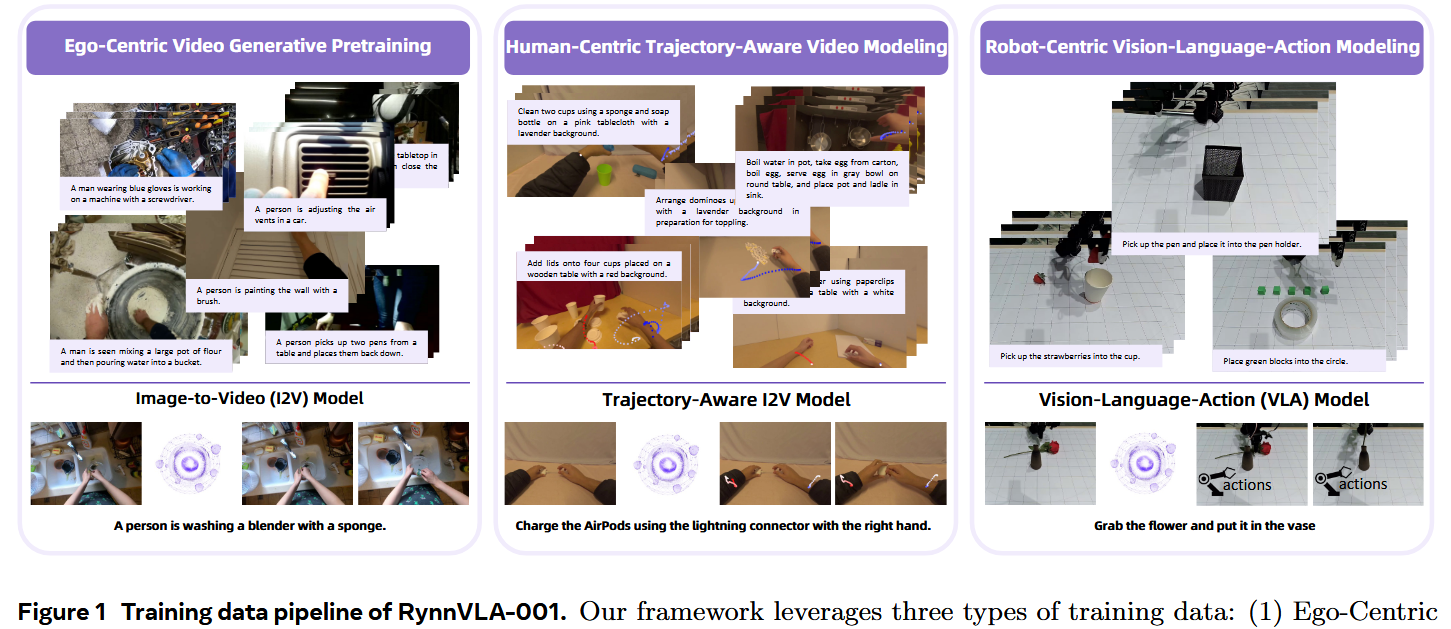

本文提出了 RynnVLA-001,一种基于大规模来自人类示范的视频生成预训练(video generative pretraining)的 VLA 模型。作者提出了一种新颖的两阶段预训练方法。

第一阶段称为 Ego-Centric Video Generative Pretraining(第一人称视角视频生成预训练),在 1,200 万条第一人称视角(ego-centric)操作视频上训练一个 Image-to-Video 模型,目标是在给定初始帧和语言指令的条件下预测未来帧。为了捕获通用的操作动力学,该阶段依赖第一人称的人类操作视频,这类视频强调第一视角下的手部操作。作者设计了专门的数据筛选流水线,从现有网络来源中筛选出 1200 万条自我视角操作视频。在这些视频上训练后,模型能够在视觉层面预测操作过程。

然而,高层视觉观测与控制真实机器人所需的低层动作空间之间仍存在差距,为弥合这一差距引入了第二阶段。

第二阶段为 Human-Centric Trajectory-Aware Modeling(以人为中心的轨迹感知建模),在该阶段,除了预测未来帧之外,模型还被训练去预测在当前观测和语言指令条件下未来帧中的关键点轨迹。这些基于关键点的模式与机器人动作具有相似性,从而促进了从视觉动力学到低层机器人动作的迁移。

在前述预训练阶段之后,作者进一步使用自采集的机器人数据对模型进行适配(adapt)。在这一阶段,模型被训练去预测 action chunks(动作块)而不是单步动作,输入为 RGB 观测和语言指令。

为保证预测动作的平滑性与时间一致性,作者提出了 ActionVAE——一种变分自编码器(variational autoencoder),它将动作序列压缩为紧凑的潜在嵌入(latent embeddings),从而降低 VLA 输出空间的复杂度。ActionVAE 训练完成后被冻结(frozen),用于提取未来动作的潜在表示。随后,模型被优化以同时预测这些动作嵌入(action embeddings)和未来的视觉观测。

在推理阶段,给定观测与语言指令,模型输出一个动作嵌入,该嵌入随后由 ActionVAE 解码为一段可执行的机器人动作序列。

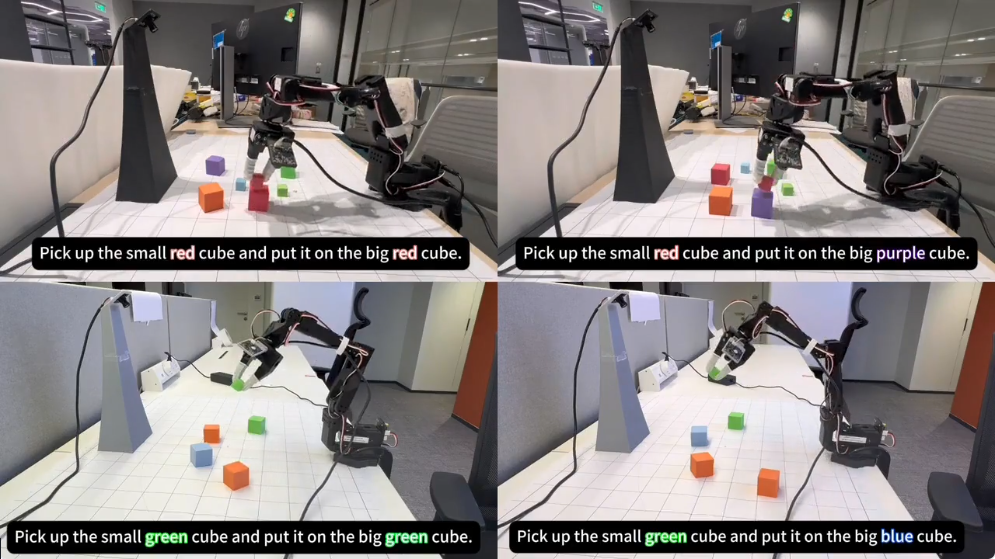

作者提出的 RynnVLA-001 能够使机械臂通过准确执行高层语言指令来完成复杂的抓取-放置与长时序任务。当在相同的下游机器人数据集上进行微调(finetune)时,与包括 GR00T N1.5 和 Pi0 在内的最先进模型进行比较,RynnVLA-001 在性能上超越了最先进的基线方法,这表明所提出的预训练策略能为 VLA 模型提供更有效的初始化。

整体训练流程如图 1 所示。

1.3 相关工作

VLA模型

近年来机器人智能体的发展依赖于利用预训练 Vision-Language Models(VLMs)的强大能力,从而使具身系统能够在复杂环境中更有效地感知、推理和执行动作。

RT-2(Zitkovich 等,2023)率先提出了 vision-language-action(VLA)模型的概念:将 VLM 与机器人轨迹数据和大规模互联网视觉-语言任务一起联合微调。这类工作的一项关键策略是把连续动作离散化为类别化的桶(categorical bins),以便与标准的 LLM backbone 兼容。

这一思路被后续模型推进,例如 OpenVLA(Kim 等,2024)通过大规模预训练提升了泛化能力,FAST(Pertsch 等,2025)则探索了更高效的 tokenization 方案。然而,动作离散化常常导致动作表示的精度损失。

VQ-VLA(Wang 等,2025)提出训练一个 VQVAE 来对 action chunks 进行离散化,从而提升了动作表示的精确性。另一类方法则提出集成专门为连续动作生成设计的 policy heads(策略头)。LCB(Shentu 等,2024)在此类双系统架构上先行一步:借助一个预训练的 VLM(Liu 等,2023)负责高层推理与场景理解,同时使用一个独立且专门化的 policy head 来生成连续的低层动作(Ke 等,2024)。

随后大量研究在该双系统范式上展开各种改进,比如优化交互频率、采用不同的 policy head 模型(例如 diffusion transformers),以及在多种 embodiment 上引入多样的训练策略。值得注意的是,最近的工作已将该概念发展为更通用的框架。例如,Pi0(Black 等,2024)将 PaliGemma(Beyer 等,2024)与 conditional flow matching(Lipman 等,2023)相结合,用于连续控制。

类似地,GR00T 项目(Bjorck 等,2025)在复杂硬件(例如类人机器人)上交付了端到端训练且开源的双系统实现。这些框架代表了朝着基于 VLM 的高级 VLA 模型迈出的重要一步。

机器人学习预测未来

现有基于 VLM 的策略常受制于对视觉动力学建模不足,因为它们通常只依赖当前观测的 1—2 帧静态图像。为了解决这一问题,一大批研究致力于引入未来预测以显式建模物理动力学,从而改善策略学习。这些工作大体可以分为三类范式。

- 第一类范式是把策略条件化在显式生成的未来状态上。也就是先生成一个“未来图像/关键帧”作为视觉目标,然后让动作策略去实现这个视觉目标。

早期工作如 SuSIE(Black 等,2023)和 UniPi(Du 等,2023)利用图像编辑或生成模型生成单个未来关键帧,随后将其作为动作策略的视觉目标。后来该思想被如 GEVRM(Zhang 等,2025)等方法推进,它们利用像 Open-Sora(Zheng 等,2024)这样的强大视频基础模型来生成更具表现力的未来目标序列。DREAMGEN(Jang 等,2025)利用视频世界模型生成大规模合成机器人数据,用于离线策略训练。

- 另一种更为一体化的范式是在单一架构中统一未来预测与动作生成。即不分离预测和控制,而是在一个模型中共同学习两者的互惠关系,期望二者互相促进。

有些方法(Wu 等,2024;Tian 等,2025;Zhao 等,2025)在架构中强制顺序依赖:先生成一个未来子目标图像,再预测动作序列。PAD(Guo 等,2024)采用扩散模型(diffusion model)来联合预测未来图像与动作;而 WorldVLA(Cen 等,2025)则开发了一个自回归框架,在该框架中多步未来状态预测与动作生成相互告知、相互促进。

- 第三类范式把未来视频预测主要作为一种强有力的预训练目标来学习表征,而不是在推理时直接使用生成结果。

例如,GR-2(Cheang 等,2024)在大规模互联网视频数据上预训练模型,然后再微调用于动作预测;VPP(Hu 等,2024)成功利用已有的视频基础模型的表示来进行机器人控制。尽管这些方法验证了视频预训练的潜力,作者的工作通过引入一个多阶段的课程式训练流程来推进该范式,逐步把视觉生成与机器人控制关联起来。

首先在大规模第一人称视角视频上预训练视频生成模型。接着,引入一个中间阶段,加入对人类轨迹的预测,以弥合纯视觉预测与动作生成之间的鸿沟。最后,将这个具有轨迹感知能力的模型在机器人特定数据上进行微调。

2. 具体方法

在本工作中,作者提出 RynnVLA-001,一种基于大规模视频生成预训练的 Vision-Language-Action(VLA)模型。

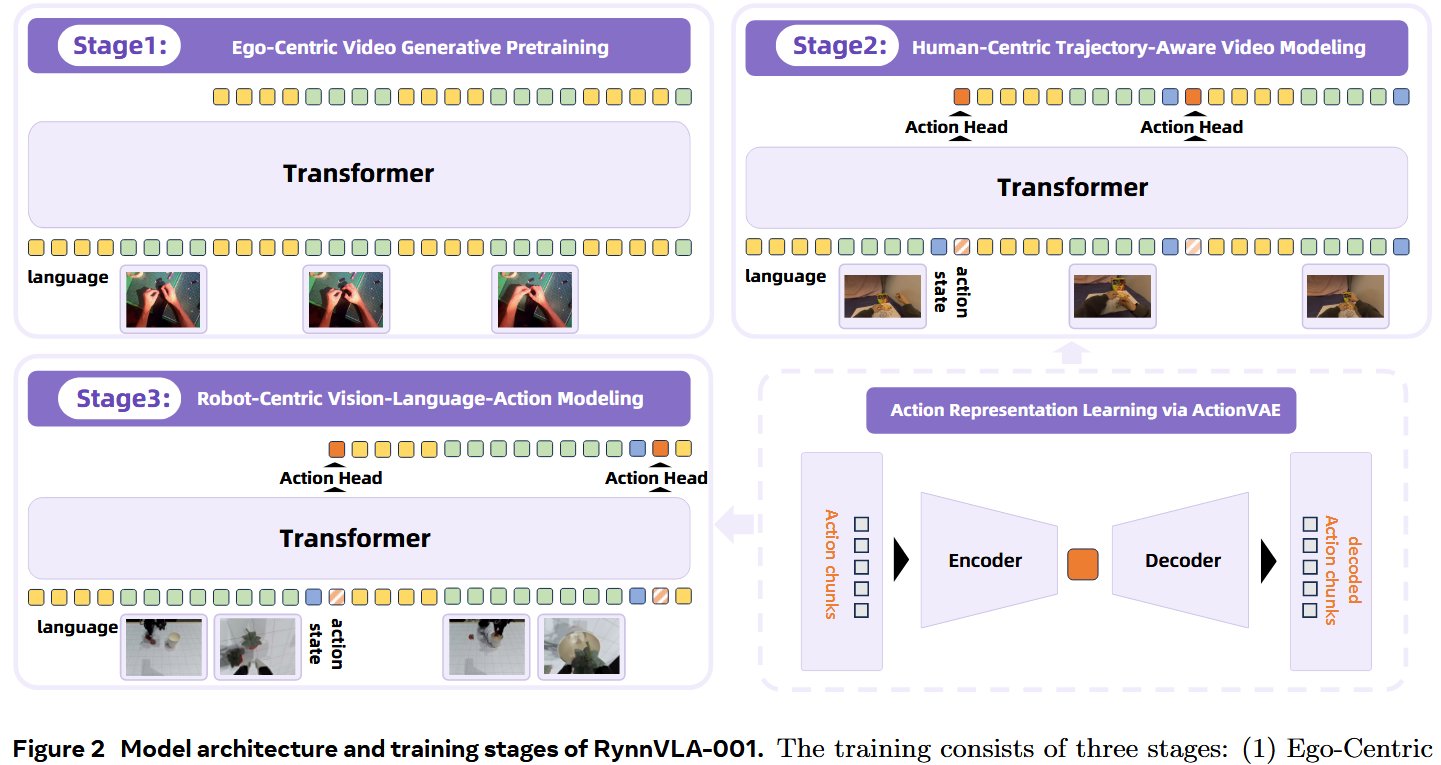

先训练一个第一人称视角(ego-centric)的 Image-to-Video(I2V)模型,然后将其微调为具有轨迹感知能力的第一人称视角视频生成模型。最后,通过继承这些预训练权重将模型适配为 VLA 模型。该模型通过三阶段逐步训练(如图 2 所示):

- Ego-Centric Video Generative Pretraining:在自我视角的人类操作视频上训练自我视角的 Image-to-Video(I2V)模型。该阶段使模型具备预测未来帧的能力。

- Human-Centric Trajectory-Aware Video Modeling:将预训练的 I2V 模型进一步微调,使其能够联合预测未来帧与人类关键点轨迹(human keypoint trajectories)。该阶段在纯视觉帧预测和面向动作的建模之间搭起桥梁。

- Robot-Centric Vision-Language-Action Modeling:VLA 模型继承前几阶段的权重,并在机器人数据上训练;输入为语言指令和当前观测(包括双视角观测 two-view observations 与关节状态 joint states)。该模型被优化以同时预测未来帧和动作嵌入(action embeddings),其中动作嵌入由预训练的 ActionVAE 解码为可执行的机器人动作。

2.1 预训练第一人称视频生成模型

扩展 VLA 模型的一个关键挑战是大规模成对训练数据的稀缺。为了解决这个问题,作者通过大规模视频预训练将来自人类示范的先验迁移过来,首先采用 Ego-Centric Video Generative Pretraining。该阶段的目标是训练一个 I2V(Image-to-Video)模型,其推理过程尽可能模拟 VLA 模型的推理。

在典型的 VLA 场景中,动作是在给定当前观测(例如视觉输入和机器人状态)以及语言指令的条件下被预测的。因此, I2V 模型被训练以基于初始视觉观测和对应的语言描述来预测未来视频帧。这一预训练任务促使模型从第一人称视角学习物体操作的物理动力学。

在网络架构上,采用了自回归(autoregressive, AR)Transformer。由于基于 AR 的视频生成框架较少,作者扩展了一个强大的 AR 图像生成模型 Chameleon(Team, 2024;Liu 等,2024a)来执行 I2V 任务。为确保学到的先验与机器人操控直接相关,作者筛选并整理了 1200 万条第一人称视角人类操作视频用于训练。

这些视频包含第一视角的人类操作,重点是与机器人夹爪运动和操作相类似的手部操作。(数据筛选流水线的细节将会在第 4 节给出。)此外,还从开源数据集中筛选了 244K 条机器人操控视频(Brohan 等,2022;Walke 等,2023;O’Neill 等,2024;Khazatsky 等,2024)。

如图 2 所示,为了更好对齐 VLA 的推理(每次动作预测都受到两种模态的条件影响),**语言 tokens 并非只出现一次,而是与 visual tokens 交错出现。**输入序列结构为

[language tokens, visual token_t, language tokens, visual token_{t+1}, …]

训练以对离散化的 visual tokens 和 language tokens 计算的交叉熵损失作为监督。

2.2 微调成具有轨迹感知能力的模型

虽然第一阶段的 I2V 模型学会在视觉层面预测动力学,但它缺乏对动作的显式理解,而这对最终的 VLA 建模是必需的。为弥合纯视觉预测与动作生成之间的鸿沟,第二阶段将预训练模型微调为一个具有轨迹感知能力的框架。

该阶段的关键思想是用一个多任务目标来微调预训练模型:并行预测未来视觉帧和对应的人类关键点轨迹。人类轨迹可以被视为另一种形式的动作。通过学习把视觉变化与其底层运动轨迹关联起来,模型能够对操作动力学形成更完整的理解。

为此采用 EgoDex 数据集(Hoque 等,2025),该数据集通过 Apple Vision Pro 设备提供了所有上半身关节的轨迹。在这些关节中,有选择地只使用手腕(wrist)关键点,因为它们近似末端执行器的位置。关键在于,模型不是直接预测原始坐标,而是被训练去预测由预训练 ActionVAE 生成的轨迹块(trajectory chunks)的紧凑且连续的嵌入(embeddings)。有关细节见第 3.3 节。

这种设计在降低预测复杂度的同时产生了对运动的密集表征。为了向模型提供本体感觉(proprioceptive)信息,引入了 state embeddings(图 2 中的蓝色方块)。这些 embeddings 表示当前人类手腕的关键点位置,并在每个时间步输入给模型。

这些 embeddings 通过一个线性层投影到 Transformer 的输入维度,并与其他 tokens 交错输入。输入序列现在构成如下:

[language, visual token_t, state embedding_t, <ACTION_PLACEHOLDER>, …]

其中 <ACTION_PLACEHOLDER> 是用于触发生成连续动作嵌入(action embeddings)的占位信号。该序列显式地向模型提供三项关键信息:高层目标(语言)、当前视觉场景(visual tokens)以及手腕的当前物理构型(state embeddings)。

第一阶段的架构被扩展以处理新的连续预测目标。引入了一个轻量级的 action head(单层线性层)。Transformer 的主输出仍为离散化的 visual tokens,而 action head 则把最后一层的 hidden state 映射到动作嵌入的连续潜在空间。

action head 的训练采用 L1 损失监督,并且该损失仅在 <ACTION_PLACEHOLDER> 对应的 token 位置上计算。视觉 token 的预测与第一阶段保持一致。

2.3 ActionVAE: Action Representation via VAE

在 VLA 模型中,预测 action chunks(即短序列动作)比逐步预测单步动作更为有效。该设计选择基于两个关键因素:1)避免重复预测:单步动作执行常常带来微小的视觉变化,可能使模型反复输出相同动作而陷入僵局;预测动作块则鼓励更显著的视觉变化。2)效率:在单次前向传递中生成多步动作可以减少计算开销和推理延迟。

为支持这种块级预测并保证生成动作的平滑与连贯性,在第 2 与第 3 阶段引入了 Action Variational Autoencoder(ActionVAE)。如图 2 所示,ActionVAE 包含一个编码器,将“动作块”压缩为紧凑且连续的潜在嵌入;以及一个解码器,从该嵌入重构原始动作序列。

由于训练流程既包含人类示范也包含机器人执行,且它们的运动学空间存在差异,所以训练了两个领域特定的 ActionVAE:一个用于压缩人类轨迹(用于第 2 阶段),另一个用于压缩机器人动作(用于第 3 阶段)。这确保了每个域都有专门且准确的动作表示。

重要的是,ActionVAE 与 embodiment(机器身体形态)相关。由于它编码的是常对应于原子运动原语的块级动作,训练良好的模型可以在相同 embodiment 的新数据上直接用来提取动作嵌入,而无需重新训练。

2.4 模型化以机器人为中心的VLA

在最后阶段,将预训练的、具备轨迹感知能力的模型适配为用于机器人控制的 VLA 模型。实现方式是整合面向机器人的 ActionVAE 表示,并在机器人数据上对模型进行微调。

模型的主要目标是预测下一段机器人 action chunk 的 embedding,随后由 ActionVAE 解码成可执行的动作序列。架构在大体上沿用了第 2 阶段的框架,但已针对机器人域进行了适配。一个关键修改体现在 action head 上。

鉴于人手轨迹与机械臂的运动学存在显著差异,第 2 阶段预训练得到的 action head 被舍弃。取而代之的是初始化一个新的轻量级 action head(单层线性层),用于预测机器人 action embeddings。

VLA 模型的输入序列被构造成与真实机器人部署情形相一致,仍采用第 2 阶段的占位符设计:

language,visual token_t,state embedding_t,<ACTION_PLACEHOLDER >,…

不过此处的 visual tokens 现在由两个相机视角组成(front view 与 wrist view),而第 2 阶段是单视角输入。该序列显式地提供了四个组成部分:(1)高层目标(language),(2)以机器人为中心的视觉观测(front view 与 wrist view),(3)当前机器人状态,以及(4)用于生成下一动作的信号(<ACTION_PLACEHOLDER>)。

训练期间,模型以两个并行目标进行优化:

- 机器人动作预测:与 <ACTION_PLACEHOLDER> token 输出对应的 hidden state 被送入新初始化的 action head。该 head 将 hidden state 回归为表示下一段机器人 action chunk 的连续 embedding。该 head 的训练由 L1 损失监督,即预测 embedding 与来自机器人专用 ActionVAE 的真实 embedding 之间的 L1 距离。

- 未来视觉预测:模型继续对下一帧的 visual tokens 进行自回归预测,使用交叉熵损失监督。该辅助任务对训练起到正则化作用,并保持模型对世界动力学的理解。

2.5 推理

在推理阶段,VLA 模型在一个闭环控制周期内运行以完成任务。在循环的每一步,模型以语言指令、来自机器人相机的当前 RGB 观测以及当前机器人状态作为输入。关键的是,为了优化效率,作者在推理时做了一处修改。

模型在推理时仅预测 action embedding,而不再生成未来的 visual tokens。尽管在训练中预测未来帧作为辅助任务有很好的正则化价值,但它在计算上代价高且对实际控制并非必需。舍弃该过程能显著提升推理速度,从而使模型在实时应用中更实用。

随后,预测到的 action embedding 会被立即传递给 ActionVAE 的解码器。解码器从该单一的 embedding 重构出一段连贯的低层机器人动作序列(即 action chunk)。机器人执行整段解码出的 action chunk。完成该动作块后,会采集新观测并与语言指令一起反馈给模型,触发下一轮循环。该过程重复进行,直到任务成功完成为止。

3. Ego-Centric Video Data Curation Pipeline

为了用相关的人类示范进行预训练,从网络资源构建了一个大规模的自我视角(ego-centric)操作视频数据集(Wang et al., 2024b; Grauman et al., 2022; Miech et al., 2019; Damen et al., 2022, 2018, 2021; Goyal et al., 2017; Mahdisoltani et al., 2018)。

鉴于原始视频数据噪声大且高度多样,作者设计了一个多阶段数据整理流水线来筛选并注释适合预训练的影片。该流水线包含以下步骤:

- 关键点检测(Keypoint Detection):对视频中的每一帧,运用姿态估计模型(Yang 等,2023)提取人体关键点,包括面部标志、躯干关节和与手相关的关键点(例如手腕、肘部、手指)。

- 第一人称视角筛选:采用两个关键筛选标准以仅保留高质量的自我视角操作视频:1)无面部关键点:出现人脸关键点的视频会被丢弃。人脸的出现强烈表明是第三人称视角,不适合自我视角建模。2)手部关键点存在:仅保留那些手腕和手的关键点可见的帧。靠近相机的手的存在是自我视角人类操作的重要指标,对建模可迁移的机器人行为至关重要。

- 文本描述注释:对每个筛选后的视频,使用 Qwen2-VL-7B(Wang 等,2024a)生成简明的文本描述。这些描述刻意保持简短,以模拟机器人学习中常用的自然语言指令(例如“把瓶子放进箱子里”、“打开抽屉”)。生成的文本-视频对作为有效的监督信号,用于视觉—动作对齐训练。

4. 实验

4.1 实验设置

数据集

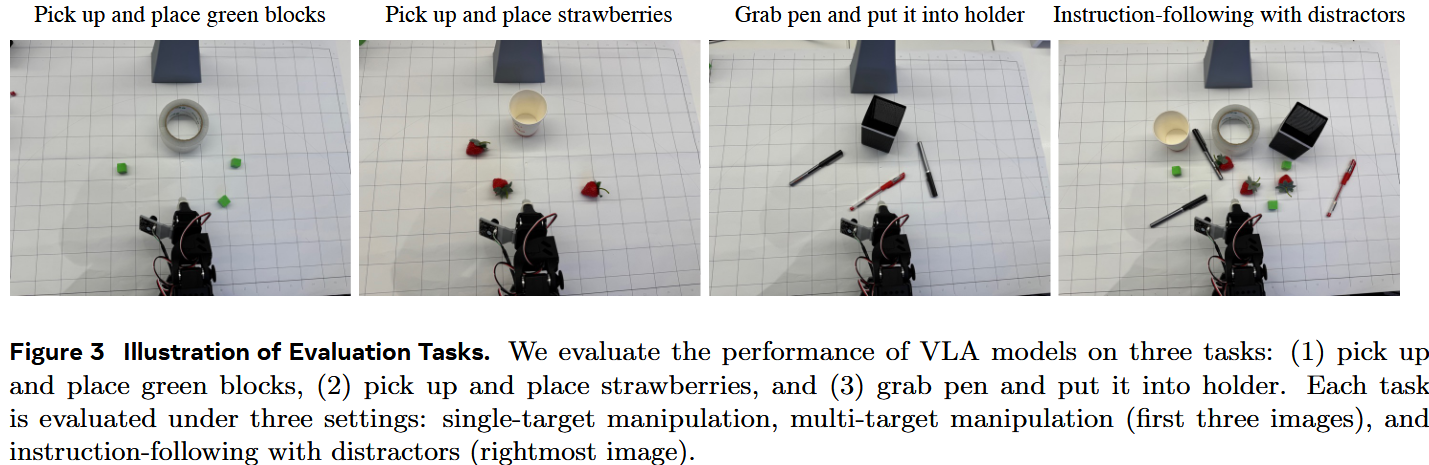

为训练与评估作者提出的 RynnVLA-001 模型,使用 LeRobot SO100 机械臂(Cadene 等,2024)采集了一个新的真实世界操控数据集。该数据集由通过人工遥控(teleoperation)收集的专家示范组成。为了确保数据集覆盖基本操控技能,作者设计并采集了三项代表性任务的数据(如图 3 所示):

- 拾取并放置绿色方块:此任务侧重基础的物体识别与抓取能力。采集了 248 次示范。

- 拾取并放置草莓:该任务要求精确定位与抓取点估计,侧重模型的细粒度感知能力。我们采集了 249 次示范。

- 抓取笔并插入笔架:该任务要求高级 3D 空间推理,特别是推断物体朝向与高度以完成精确插入动作。采集了 301 次示范。

为了增加数据的丰富性与复杂度,操作场景从仅包含目标对象到包含其他无关干扰物的更复杂布置均有覆盖。在遥控演示过程中,操作者的目标是将所有目标对象移动到它们的指定位置。此外,数据使用三台不同的 SO100 机械臂在不同环境与不同光照条件下采集。

基线

将模型与两个强大的开源基线进行比较,分别为 GR00T N1.5(Bjorck 等,2025a)和 Pi0(Black 等,2024)。以相应的预训练权重初始化这些模型,然后使用相同的 SO100 数据对它们进行微调。使用 GR00T N1.5 和 Pi0 的官方代码,并严格按照其说明进行微调。

评估

评估协议考虑三种不同场景:1)单目标操控(桌面上仅有单个目标对象);2)多目标操控(桌面上有多个目标对象);3)带干扰物的指令执行(桌面上同时出现目标对象与干扰物)。

对于所有场景,若模型在预定时间限制内将至少一个目标对象正确放置到指定位置,则该次试验被视为成功。在以下任一情况下,试验被标记为失败:1)超出时间限制;2)模型连续超过五次抓取目标失败;3)对于带干扰物的指令执行场景,若模型尝试操作任何干扰物则视为失败。

作者报告了 Success Rate@1(SR@1)指标,其定义为单次试验中成功完成任务的百分比。为评估泛化能力,每个任务在多台机械臂上进行评测,每台机械臂在独特的物理环境中运行。

4.2 和SOTA方法比较

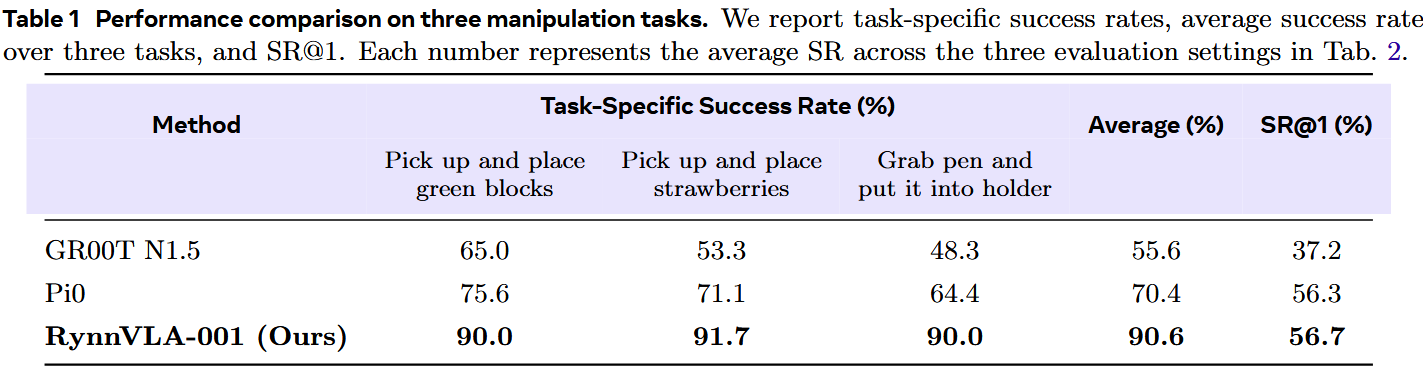

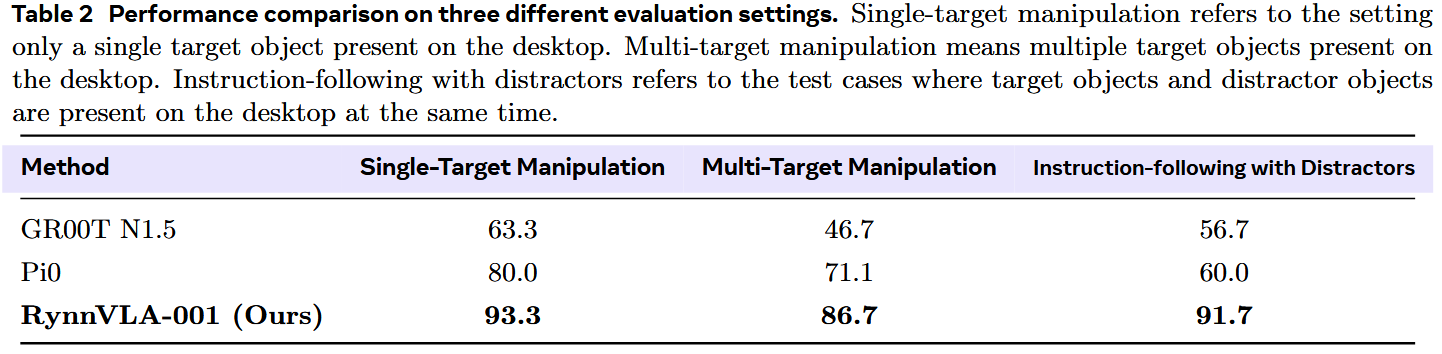

表 1 给出了按任务划分的以及平均成功率的详细比较。

模型 RynnVLA-001 在总体性能上明显更优,在所有三项任务上均优于 GR00T N1.5 与 Pi0。就 SR@1 指标而言,作者提出的 RynnVLA-001 与 Pi0 表现相当。所有三种模型的 SR@1 值相对较低,这表明在提高目标定位精度以实现可靠的单次成功上仍有很大的改进空间。

在表 2 中,我们报告了三种不同评估设置下的成功率。

当场景中出现更多物体时,任务变得更具挑战性。对于 GR00T N1.5,多目标操控以及有干扰物的指令执行场景的成功率均低于单目标操控场景。对于 Pi0,当桌面出现干扰物时,成功率显著下降,这表明其指令跟随能力有限。相比之下,提出的 RynnVLA-001 性能保持稳定。

4.3 预训练的提升

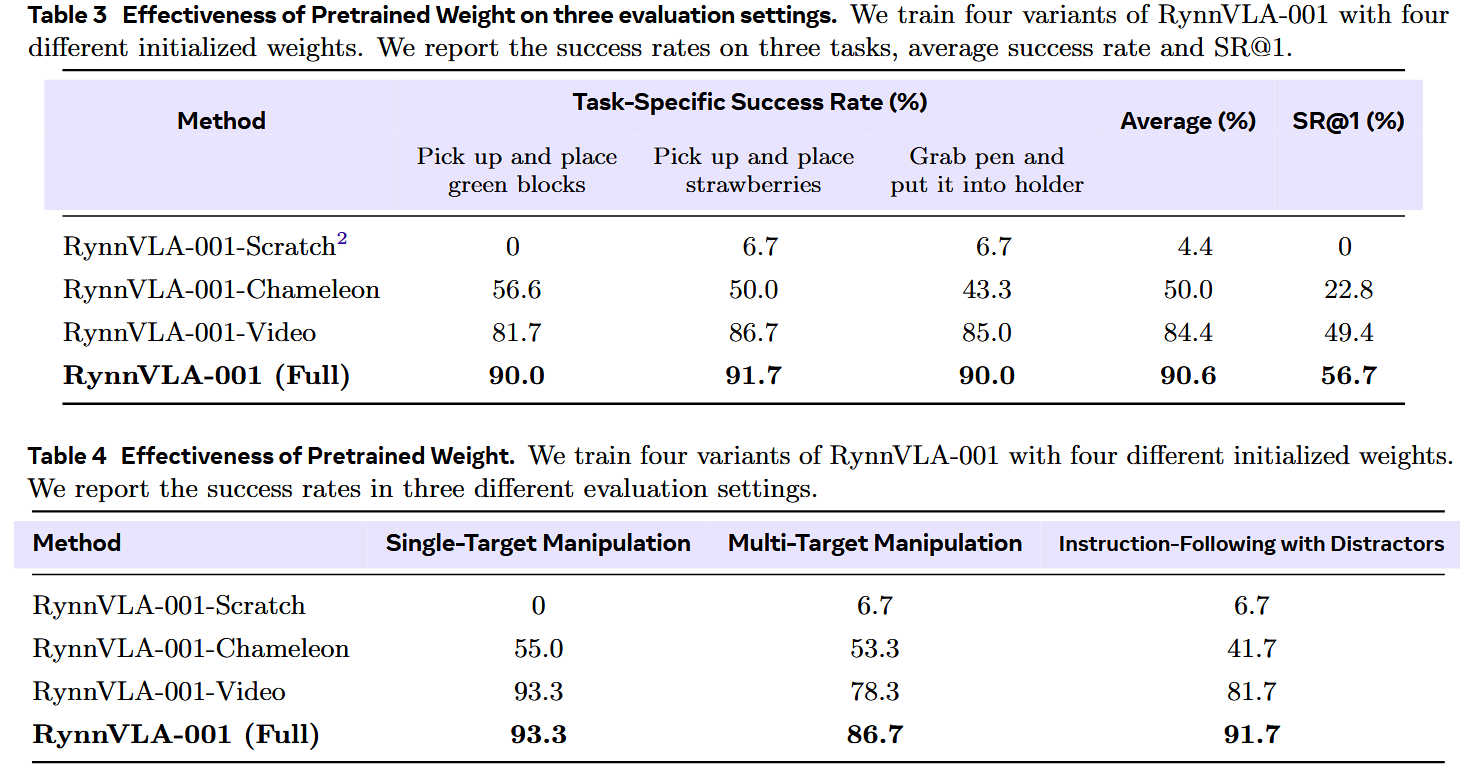

在 RynnVLA-001 中,作者提出了两阶段预训练:1)第一人称视角(ego-centric)视频生成预训练;2)以人为中心的轨迹感知视频建模。为探究提出的两阶段预训练流水线的有效性,作者进行了全面的消融研究,结果分别列在表 3 与表 4 中。

首先,评估第 1 阶段(Ego-centric Video Generative Pretraining)的影响。比较了用于最终 VLA 模型的三种初始化策略:1)RynnVLA-001-Scratch:从随机权重初始化的基线,跳过所有预训练。

2)RynnVLA-001-Chameleon:较强的基线,直接用 Chameleon Text-to-Image(T2I)模型的预训练权重初始化,跳过视频预训练阶段。

3)RynnVLA-001-Video:经过第 1 阶段训练后的模型,该模型从 Chameleon 权重出发并在自我视角视频上进一步预训练。

结果清楚地表明了以视频为中心的预训练的重要性。

RynnVLA-001-Scratch 模型无法将语言指令与有意义的动作相关联,导致极低的成功率。受益于预训练的 T2I 检查点,RynnVLA-001-Chameleon 在简单抓取任务上取得了较为合理的结果。然而,它的定位能力受限,使其性能被限制在约 50.0% 的成功率。

相反,RynnVLA-001-Video 获得了显著的性能提升,表明从第一人称视角视频学到的先验对于 VLA 适配是有效的。接着,在该视频预训练模型基础上评估第 2 阶段(Human-centric Trajectory-Aware Video Modeling)的贡献。

通过加入第二阶段预训练(让模型学习预测人类轨迹),完整模型 RynnVLA-001 在所有变体中达到了最佳性能。这一最终提升展示了通过预训练模型以预测人类轨迹来显式弥合视觉预测与动作生成之间差距的益处。

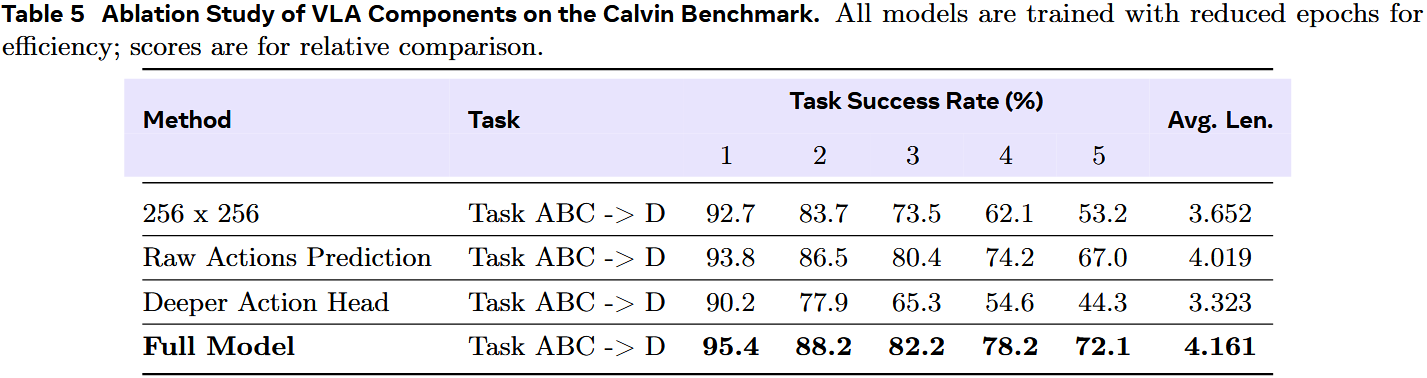

4.4 模型设计方面的消融实验

为了系统地评估所设计关键组件的影响,在 Calvin 基准(Mees 等,2022)上做了一系列消融实验。为提高实验效率,完整模型与消融变体均从 RynnVLA-001-Video 的预训练权重出发进行训练,但训练轮数有所减少。因此,本节中呈现的结果主要用于比较性分析,以展示各组件的相对重要性。

图像分辨率

在本研究中,考察图像分辨率对 RynnVLA-001-Video 的影响。如表 5 所示,当分辨率从我们建议的 384×384 降到 256×256 时,观察到显著的性能下降。这种退化归因于与 VQGAN 组件的分辨率不匹配;该 VQGAN 是在 512×512 图像上预训练的。

在较低的 256×256 分辨率下,VQGAN 的重构质量下降,无法生成高保真重构,从而产生不精确的 visual tokens,无法忠实表示源内容。因此,在这些不精确 token 上训练得到的 VLA 模型性能下降。

此外,选择 384×384 达到了一种折衷:1)因更接近 VQGAN 的原生分辨率,它保持了较高的重构保真度;2)与 512×512 相比,它显著降低了计算开销,使其在部署时更实用。

动作表示

在本工作中,作者提出使用 Variational Autoencoder(VAE)将 action chunks 压缩为紧凑的潜在嵌入。这种方法与先前直接预测原始动作序列的方法形成对比(openvla,pi0,gr00t)。

为评估该组件的有效性,在 Calvin 的 ABC->D 基准上进行了消融比较:预测 VAE embeddings 与直接预测原始动作序列的性能对比。如表 5 所示,在 VAE 的潜在空间中预测动作优于直接预测原始动作。

性能提升来自 VAE 的两个关键优势:1)它为复杂动作序列提供了高效的压缩表示;2)其潜在空间的内在结构提升了时间一致性,从而产生更平滑的预测动作。

动作head的大小

动作预测模块采用了一个简单的 action head,即单层线性层,将 transformer 的最终 hidden state 投影到动作嵌入空间。为评估 head 复杂度的影响,在 Calvin 的 ABC->D 任务上比较了该设计与一个更深的五层 MLP head 的表现。

如表 5 所示,增加 action head 的深度反而出乎意料地损害了性能,使评估分数显著从 4.019 降至 3.323。该结果表明 transformer 的输出表示对于该任务已非常有效。直接的线性映射足以解码,而更深层次的 head 所带来的额外复杂性似乎引入了噪声或过拟合,最终削弱了性能。这强调了在模型解码阶段保持架构简洁的价值。

4.5 进一步分析

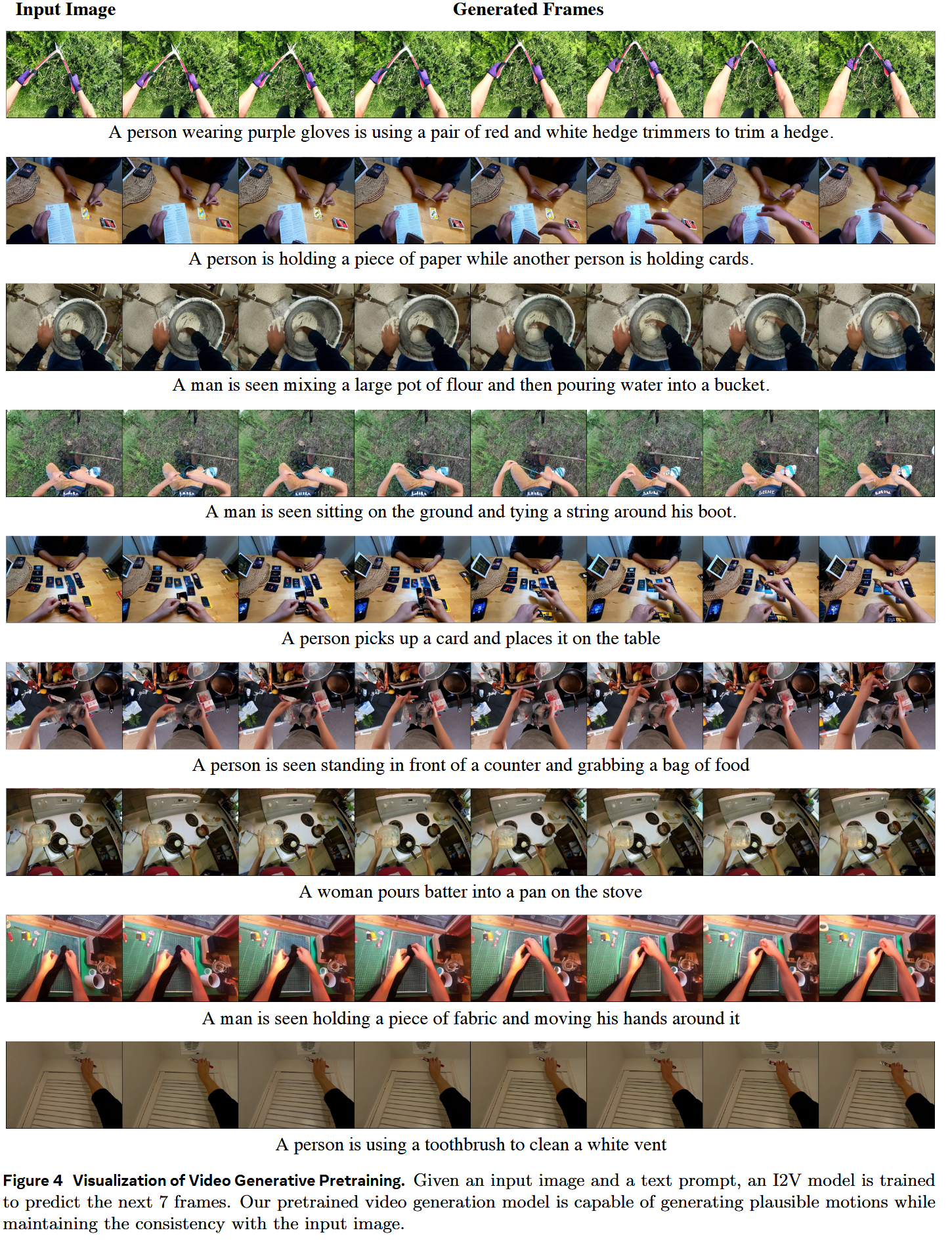

视频预训练模型的可视化

提出的 RynnVLA-001 的第一阶段包括对一个 ego-centric 的 Image-to-Video(I2V)模型进行预训练。之所以采用 I2V 范式,是为了与 VLA 模型的典型输入保持一致:初始图像观测与基于文本的指令。

如图 4 所示,预训练模型能够基于给定图像与文本提示生成具有合理运动和一致内容的视频帧。尽管模型在帧间往往只产生细微的视觉变化,但作者认为其作为后续 VLA 训练的预训练 backbone 已足够。

通过在训练数据中增加场景复杂度来提升指令跟随能力

用于评估指令跟随能力的协议是在桌面放置干扰物,以测试模型面对视觉歧义时的鲁棒性。假设仅在仅含孤立目标物的数据上训练会导致一种简化且以视觉为主导的策略:模型会学会抓取任何物体,而不会执行与所给语言指令相一致的动作。

为验证该假设,作者做了消融实验:训练一个仅使用不含干扰物数据的 RynnVLA-001 变体。

当在一个被笔和绿色方块杂乱占据的场景中评测**“拾取草莓”**任务时,该消融模型在 10 次试验中表现出 0% 的成功率。在 10 次失败中,有 5 次是持续选择干扰物体。

相比之下,完整的 RynnVLA-001(在包含干扰物的综合数据集上训练)在该任务上达到了 90% 的成功率(9/10)。这些结果定量强调了在数据采集中包含干扰物以增加多样性的关键重要性,对于开发可靠的语言条件 VLA 模型至关重要。

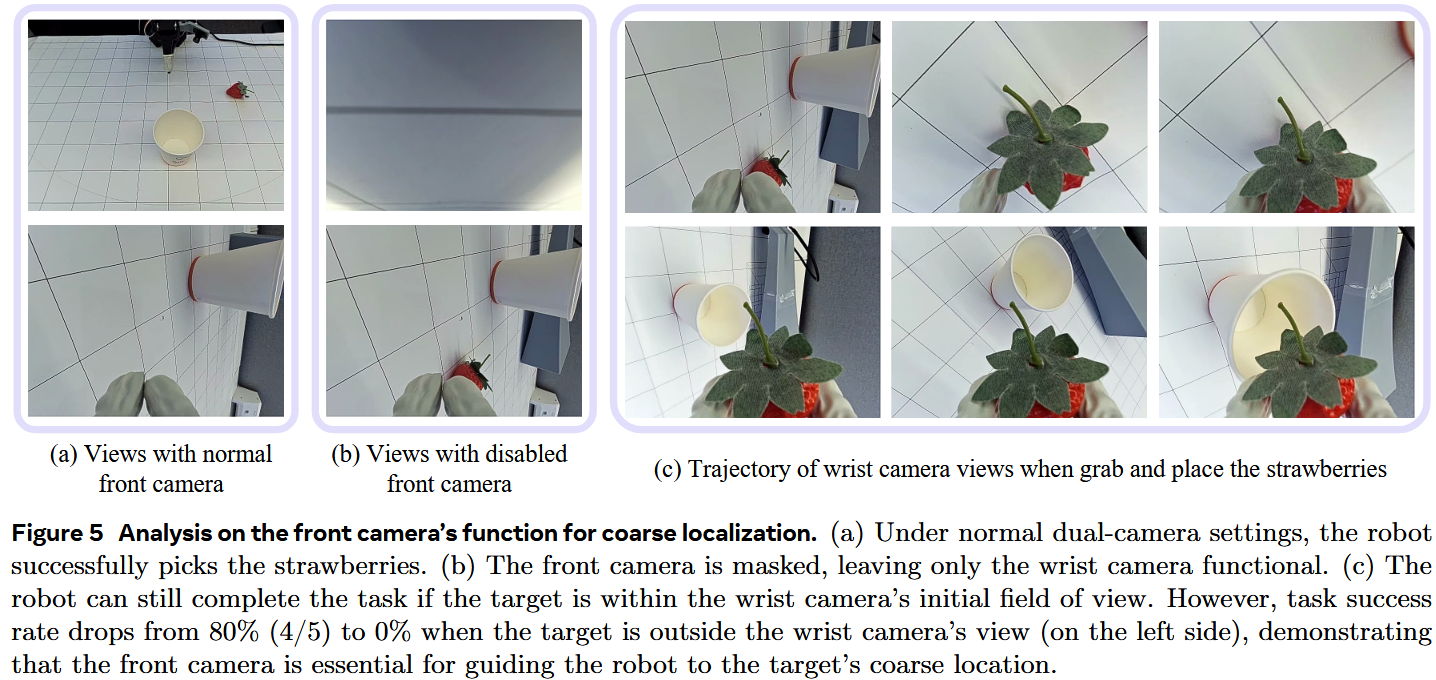

前视与腕视相机的功能性分析

作者还研究了 LeRobot SO100 臂上前视相机与腕视相机的不同功能。假设前视相机负责粗略的物体定位和 3D 投影上下文,而腕视相机负责精确的局部调整。

1)为验证前视相机在粗定位中的作用,作者进行了一项实验:在实验中禁用前视相机。在正常条件下(图 5(a)),机器人能成功完成任务。当前视相机被屏蔽(图 5(b))时,我们观察到只要目标位于腕视相机的初始视野内(图 5©),模型仍然可以成功。

然而,如果目标(例如位于左侧的草莓)不在腕视相机的视野内,机器人将无法发起任何动作。定量结果证实了这一点:对右侧目标,在屏蔽后成功率从 100%(5/5)略降至 80%(4/5);而对左侧目标,成功率则从 80%(4/5)降为 0%。

这些发现强烈表明前视相机的主要功能是引导末端执行器粗略靠近目标。

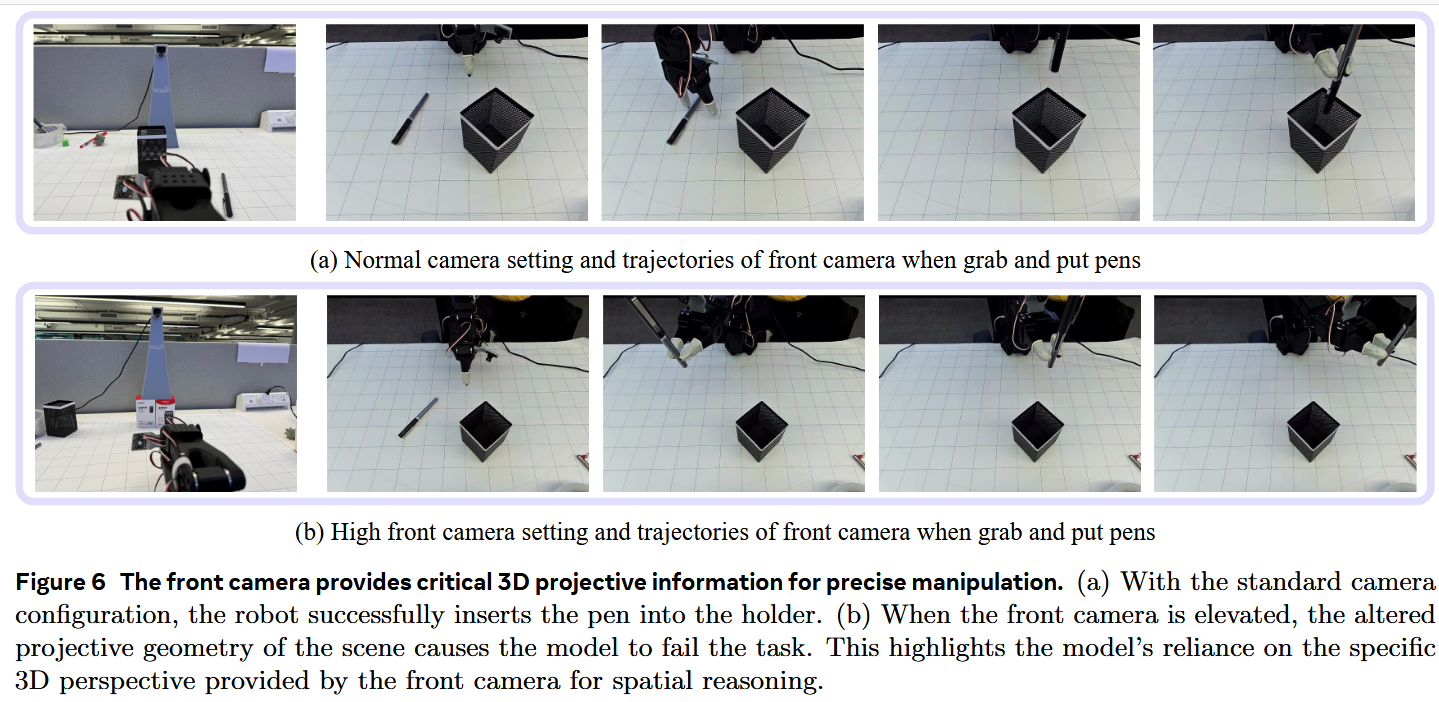

2)此外,还探讨了前视相机在提供 3D 信息方面的作用,这对诸如将笔插入笔架等需要深度感知的任务尤为重要。

如图 6(a) 所示,在正常相机配置下机器人成功完成任务。然而,当我们抬高前视相机,改变了场景的投影几何(图 6(b)),模型就无法将笔插入笔架。这表明前视相机提供了模型在空间推理与操控中所依赖的关键 3D 投影信息。

本文仅在 LeRobot SO100 机械臂上验证了 RynnVLA-001 的性能。然而,当前评估的范围存在若干限制,我们计划在未来工作中予以解决。实验仅限于单一机器人形态(embodiment)和一个与训练配置高度相似的评估环境。此外,前置相机在实验中是以固定位置安装的。为严格评估并增强模型的泛化能力,未来工作将聚焦于:(1)将评估扩展到更多样化的机械臂;(2)在更复杂、非结构化的环境中测试模型;以及(3)多样化相机视角配置。