【AI论文】DeepSearch:借助蒙特卡洛树搜索,以可验证奖励突破强化学习的瓶颈

摘要:尽管基于强化学习的值函数推理(RLVR)已成为提升大语言模型(LLMs)高级推理能力的关键组件,但现有研究表明,在经历数千次优化步骤后,训练过程会出现性能提升停滞现象——即使增加计算资源投入,性能增益仍显著下降。这一局限源于当前RLVR实践中固有的稀疏探索模式:模型依赖有限的模拟推演(rollouts),往往遗漏关键推理路径,且无法对解空间进行系统性覆盖。

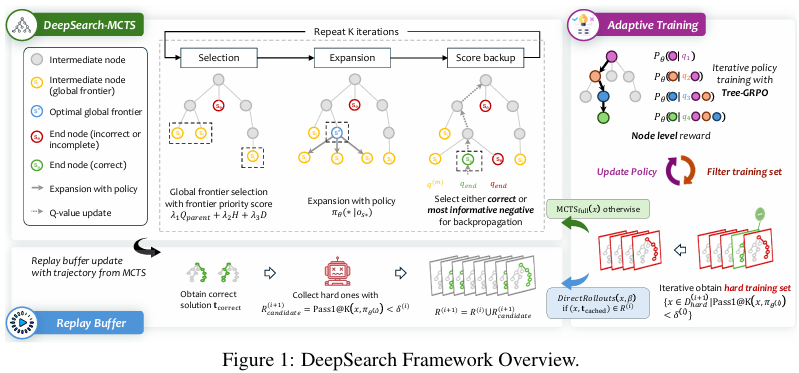

我们提出DeepSearch框架,将蒙特卡洛树搜索(MCTS)直接集成至RLVR训练流程。与现有仅在推理阶段使用树搜索的方法不同,DeepSearch将结构化搜索嵌入训练循环,实现了对推理步骤的系统性探索与细粒度信用分配。通过训练阶段的主动探索,DeepSearch解决了因探索不足导致的性能提升瓶颈问题,避免了长时间训练下性能增益衰减的现象。

我们的贡献包括:(1)全局前沿节点选择策略,可跨搜索树优先选择高潜力节点;(2)基于熵的路径选择指导,能识别高置信度路径以进行监督;(3)采用带解缓存的自适应回放缓冲区训练机制以提升效率。在数学推理基准测试中的实验表明,DeepSearch的平均准确率达62.95%,为15亿参数推理模型树立了新的最优水平,且所需GPU小时数仅为扩展训练方法的5.7分之一。

这些结果凸显了策略性探索相较于暴力计算扩展的重要性,证明了算法创新对推进RLVR方法论的潜力。DeepSearch开创了通过系统性搜索而非延长计算时间来扩展推理能力的新方向。Huggingface链接:Paper page,论文链接:2509.25454

研究背景和目的

研究背景:

随着大型语言模型(LLMs)在自然语言处理领域的快速发展,如何提升其推理能力成为了一个重要的研究方向。特别是对于需要复杂逻辑推理和数学计算的任务,传统的强化学习方法往往受限于训练过程中的探索不足,导致模型在优化数千步后性能提升逐渐趋于平缓。这种现象在强化学习与可验证奖励(RLVR)结合的场景中尤为明显,模型在训练后期往往无法发现关键的推理路径,从而限制了其性能的进一步提升。

蒙特卡洛树搜索(MCTS)作为一种系统性的搜索方法,已经在游戏、机器人路径规划等多个领域展现出强大的探索能力。然而,传统的RLVR方法通常仅在推理阶段使用MCTS,而忽略了将搜索机制嵌入训练过程的重要性。

这种分离导致模型无法充分利用搜索过程中产生的丰富监督信号,限制了其推理能力的进一步提升。

研究目的:

本研究旨在通过引入MCTS到RLVR的训练过程中,提出一个名为DeepSearch的框架,以解决现有方法中的探索不足问题。具体目标包括:

- 提升模型推理能力:通过在训练过程中嵌入MCTS,实现系统性的探索和细粒度的信用分配,从而提高模型在复杂推理任务上的表现。

- 减少计算成本:通过优化搜索策略和重放缓冲区管理,确保在提升模型性能的同时,保持计算效率。

- 建立新的性能基准:在数学推理基准测试上,DeepSearch需要达到或超越当前最先进的模型性能,展示其有效性和优越性。

研究方法

1. 框架设计:

DeepSearch框架通过将MCTS直接嵌入RLVR的训练循环中,实现了系统性的探索和细粒度的信用分配。

具体设计包括:

- 全局前沿选择策略:通过优先选择搜索树中具有潜力的节点,扩大推理的覆盖范围。

- 基于熵的路径选择:利用策略的熵来识别需要更多监督的路径,增强探索的针对性。

- 自适应重放缓冲区训练:通过缓存已验证的解决方案,提高训练效率,避免冗余计算。

2. 搜索策略:

DeepSearch采用了一种混合选择策略,结合了传统的UCT(Upper Confidence Bounds for Trees)局部选择和全局前沿选择。

具体实现包括:

- 局部选择:使用UCT算法在子树内部进行节点比较,确保最优决策。

- 全局选择:通过计算前沿优先级分数,选择整个搜索树中最有潜力的节点进行扩展,克服UCT的短视性。

3. 训练策略:

DeepSearch采用了一种迭代训练方法,结合了渐进过滤和重放缓冲区管理。具体步骤包括:

- 初始化:从初始策略模型开始,使用验证集识别困难样本。

- 迭代训练:在每一轮迭代中,对困难样本应用MCTS搜索,对简单样本使用直接回滚策略。

- 重放缓冲区更新:缓存已验证的正确轨迹,确保在后续训练中保留这些知识。

- 策略更新:使用Tree-GRPO目标函数进行策略更新,结合全局和局部的反馈信号。

研究结果

1. 数学推理基准测试性能:

在AIME2024、AIME2025、AMC2023、MATH500、Minerva和Olympiad等数学推理基准测试上,DeepSearch-1.5B模型实现了62.95%的平均准确率,超过了所有基线模型,包括之前表现最好的Nemotron-Research-Reasoning-Qwen-1.5B v2模型(61.70%)。这一结果展示了DeepSearch在提升模型推理能力方面的有效性。

2. 训练效率分析:

与传统的扩展训练方法相比,DeepSearch在保持高性能的同时,显著降低了计算成本。

具体而言,DeepSearch仅使用了50个额外的RLVR训练步骤就达到了62.95%的准确率,而扩展训练方法需要数千步才能达到类似的性能,且计算成本高出5.7倍。这一结果表明,DeepSearch通过系统性的探索和智能的节点选择,实现了更高的训练效率。

3. 组件贡献分析:

通过逐步添加全局前沿选择、基于熵的路径选择和自适应重放缓冲区等组件,DeepSearch的性能逐步提升。

具体而言,全局前沿选择策略在减少迭代次数和提高轨迹奖励方面表现尤为突出,展示了其在扩大推理覆盖范围和提供细粒度反馈信号方面的重要性。

研究局限

1. 评估基准的局限性:

尽管DeepSearch在数学推理基准测试上表现出色,但这些基准主要关注于数学问题的解决,可能无法全面反映模型在其他复杂推理任务上的表现。未来研究需要扩展评估基准,涵盖更多类型的推理任务,以全面评估DeepSearch的泛化能力。

2. 计算资源的限制:

尽管DeepSearch在保持高性能的同时降低了计算成本,但其训练过程仍然需要大量的计算资源,特别是对于大规模的语言模型而言。未来研究需要进一步优化搜索策略和训练算法,以降低计算成本,提高训练效率。

3. 模型复杂度的增加:

DeepSearch通过引入MCTS和多种选择策略,增加了模型的复杂度。

这可能导致模型在部署和推理阶段面临更高的计算和存储需求。未来研究需要探索如何在保持模型性能的同时,降低模型的复杂度,提高其实用性。

未来研究方向

1. 扩展评估基准:

未来的研究应扩展评估基准,涵盖更多类型的复杂推理任务,如科学推理、逻辑推理和常识推理等。这将有助于全面评估DeepSearch在不同推理任务上的表现,验证其泛化能力。

2. 优化搜索策略:

未来的研究可以进一步优化搜索策略,如引入更复杂的节点选择和评估机制,提高搜索的效率和准确性。

同时,可以探索如何将MCTS与其他搜索算法相结合,以进一步提升模型的推理能力。

3. 降低计算成本:

未来的研究应致力于降低DeepSearch的计算成本,如通过优化搜索树的构建和管理、减少冗余计算等方式。同时,可以探索如何利用硬件加速和分布式计算等技术,提高训练和推理的效率。

4. 实际应用探索:

未来的研究应探索DeepSearch在实际应用中的潜力,如将其应用于教育、科学计算和自动化推理等领域。

通过实际场景的测试和反馈,不断优化和改进DeepSearch框架,提高其实用性和可靠性。

5. 跨领域迁移学习:

未来的研究可以探索如何将DeepSearch框架应用于其他领域,如视觉推理、多模态推理等。通过跨领域迁移学习,利用数学推理领域的研究成果,加速其他领域推理模型的发展。