LLaVA-NeXT-Interleave论文阅读

20

1.摘要

background

当前的大型多模态模型(LMMs)虽然在单图像任务上取得了巨大成功,但对于更复杂、更贴近现实世界的多图像场景(如视频、3D环境理解)的探索仍然不足。传统方法通常为每一种场景(多图、视频、3D)训练一个专门的模型,这种方式不仅耗时耗力,而且导致了技术和知识的碎片化,模型无法跨场景泛化。因此,迫切需要一个统一的框架来让单个LMM能够有效处理这些多样化的视觉输入。

innovation

论文的核心创新在于一个视角上的转变:它提出交错的图文序列(interleaved image-text format)可以作为一个通用数据模板来统一处理看似不同的视觉任务。

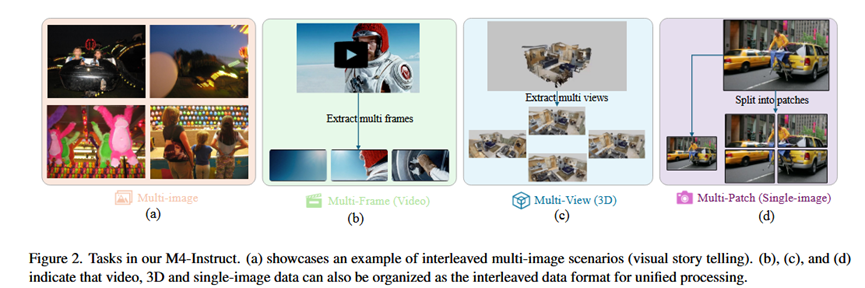

1.统一的数据范式: 论文将多图像、多帧(视频)、多视角(3D)以及多图块(高分辨率单图)这四种场景(统称为M4)全部转换为统一的图文交错格式进行处理。例如,视频被看作是一系列有序的图像帧,3D场景被看作是多个不同视角的图像。

2.构建高质量数据集 (M4-Instruct): 为了实现这一构想,研究者们精心整理和构建了一个名为M4-Instruct的大规模指令微调数据集,包含约118万个样本,覆盖了M4四大领域下的14种任务和41个数据集,为模型提供了学习这些综合能力的基础。

3.构建综合性基准 (LLaVA-Interleave Bench): 鉴于现有基准无法全面评估多图像能力,论文还整理了一个新的评测基准LLaVA-Interleave Bench,用于全面衡量模型在多图像场景下的性能。

4.好处与对比: 相比于为视频、3D等分别训练专用模型(如Video-LLaMA等),这种统一训练的单一模型 (LLaVA-NeXT-Interleave) 更加高效和可扩展。更重要的是,通过在多样化任务上联合训练,模型能够涌现出新的能力,例如将在多图任务中学到的“找不同”能力迁移到视频任务中,这是专用模型无法做到的。

2. 方法 Method

总体 Pipeline:整个方法的pipeline围绕着“数据统一 -> 模型训练”展开。

输入: 任意属于M4场景的数据(多张图片、一个视频、一个3D场景的多张视图、一张高分辨率图片)。

输出: 针对用户指令的文本回答。

各部分详解:

1.数据格式统一: 这是方法的核心。所有不同来源的视觉数据都被预处理成图文交错的序列。

多图像 (Multi-image): 文本 <图片1> 文本 <图片2> ...

多帧/视频 (Multi-frame): 从视频中采样N帧,按时间顺序排列为 <图片1> <图片2> ... <图片N>,并与文本指令结合。

多视角/3D (Multi-view): 捕获3D场景的N个不同视角的图像,排列为 <视角图片1> <视角图片2> ...。

多图块/单图 (Multi-patch): 沿用LLaVA-NeXT的anyres技术,将一张高分辨率大图切分成多个图块,也视为一个多图序列。

2.模型架构:模型直接沿用了LLaVA-NeXT的成熟架构,由三部分组成:

视觉编码器: SigLIP,用于将每个图像(或图块)编码成视觉特征。

投影层: 一个简单的两层MLP,用于将视觉特征对齐到语言模型的嵌入空间。

大语言模型: Qwen 1.5(提供了0.5B, 7B, 14B多种尺寸),作为模型的大脑,处理交错的图文token序列并生成回答。

3.关键训练技术:

从单图模型继续训练: 训练并非从零开始,而是加载一个已经训练好的、强大的单图像模型(LLaVA-NeXT-Image)的权重作为初始化,再用M4-Instruct数据进行微调。这能有效继承单图像的强大能力。

混合数据格式训练: 在训练时,随机采用两种图片token的放置方式:一种是严格按照文本中的<image>占位符插入(interleaved format),另一种是将所有图片token前置到文本的开头(in-the-front format)。这增强了模型在推理时对不同输入格式的鲁棒性。

多场景数据联合训练: 将M4四大场景的数据混合在一起进行联合指令微调。这是实现知识迁移和能力涌现的关键。

3. 实验 Experimental Results

数据集:

训练: M4-Instruct (约118万样本)。

评测: 自建的LLaVA-Interleave Bench,以及多个现有的多图、视频(NExT-QA, MVBench, VCG等)和3D(ScanQA, 3D-LLM等)基准。

实验结论:

1.全能SOTA性能: 在多图像、视频和3D三大领域的多个基准测试上,LLaVA-NeXT-Interleave这一个通用模型的性能全面超越了之前的各种专用SOTA模型。这证明了统一框架的有效性。

2.保持单图能力: 在增加多模态能力的同时,模型在传统的单图像基准测试上保持了与原版LLaVA-NeXT相当的顶尖性能,没有出现能力退化。

3.消融实验验证:

证明了从强大的单图模型 checkpoints 继续训练,比从更早期的 checkpoints 开始训练效果更好。

证明了联合训练(例如在训练视频任务时混入单图和多图数据)可以反过来提升视频任务的性能,证实了跨领域知识迁移的优势。

4.能力涌现: 实验展示了模型具备了训练数据中未明确教授的新能力。例如,模型能将在多图中学到的“写推文”能力直接应用到视频上,或者将在单图中学到的“找笑点”能力应用到多张图片上。

4. 总结 Conclusion

本文的核心信息是,多模态的“大一统”是可行的。通过一个简单而强大的思想——将所有视觉输入都视为图文交错序列——我们可以用一个模型、一套数据解决之前需要多个专门模型才能处理的问题。这种数据驱动的统一方法不仅提升了效率和性能,还促进了知识在不同模态间的迁移,催生了新的应用可能。