多线程核心知识点与高并发应用指南

摘要

本文系统梳理Java多线程与高并发核心技术,涵盖基础概念(线程生命周期、创建方式)、核心机制(锁实现、线程通信)、高并发实战(线程池优化、分布式锁)及性能优化技巧(锁粒度控制、JUC工具类)。结合电商秒杀、实时计算等实战案例,助力开发者构建高并发系统。

一、基础概念篇

1.1 多线程核心概念

1.1.1 进程与线程的区别

对比维度 | 进程 (Process) | 线程 (Thread) |

定义 | 操作系统资源分配的基本单位 | CPU调度的基本单位,隶属于进程 |

资源占用 | 独立内存空间、文件描述符等 | 共享进程资源(堆、方法区) |

切换开销 | 高(涉及上下文切换) | 低(仅切换程序计数器等少量寄存器) |

通信方式 | 管道、消息队列、共享内存等 | 共享变量、wait/notify机制 |

安全性 | 进程间隔离,崩溃不影响其他进程 | 线程崩溃可能导致整个进程终止 |

1.1.2 并发与并行的本质

概念 | 定义 | 实现条件 |

并发 | 多个任务在同一时间段内交替执行(单核CPU时间片轮转) | 依赖任务调度算法 |

并行 | 多个任务在同一时刻真正同时执行(多核CPU物理并行) | 需要多核/多CPU硬件支持 |

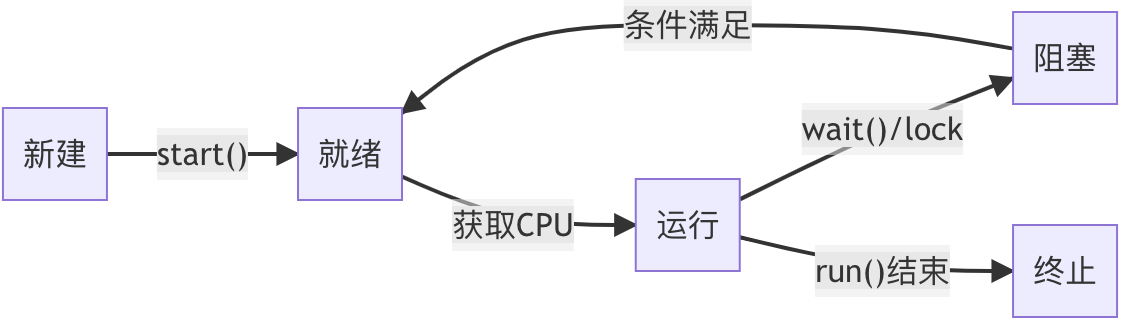

1.1.3 线程生命周期

状态 | 触发条件 | 转换关系 |

新建 | new Thread()创建对象 | → 就绪(调用start()) |

就绪 | 线程已启动,等待CPU调度 | → 运行(获取CPU时间片) |

运行 | 正在执行run()方法 | → 阻塞(等待I/O/锁等)或 → 终止 |

阻塞 | 调用sleep()/wait()或竞争锁失败 | → 就绪(条件满足后) |

终止 | run()方法执行完毕或抛出未捕获异常 | 不可逆状态 |

1.2 Java线程实现方式

实现方式 | 继承关系 | 返回值支持 | 异常处理 | 资源消耗 | 适用场景 |

1. 继承Thread类 | 必须继承Thread | 不支持 | 需自行处理 | 每个线程独立对象 | 简单线程任务 |

2. 实现Runnable接口 | 可实现任意接口 | 不支持 | 需自行处理 | 可共享Runnable对象 | 多线程资源共享场景 |

3. Callable/Future机制 | 实现Callable接口 | 支持Future返回值 | 可捕获ExecutionException | 需配合线程池使用 | 需要返回值的异步任务 |

4. 线程池创建方式 | 基于Runnable/Callable | 支持Future | 统一由线程池管理 | 复用线程降低开销 | 高并发请求处理 |

二、核心技术篇

2.1 线程安全问题深度解析

2.1.1 原子性问题

- 典型示例:i++不安全示例

- 问题本质:i++操作包含读取-修改-写入三个步骤,非原子操作

- 并发风险:多线程同时执行时可能导致最终结果小于预期值

- 解决方案:

- 使用AtomicInteger等原子类

- 使用synchronized同步代码块

- 使用ReentrantLock显式锁

2.1.2 可见性问题(JMM内存模型)

JMM核心概念

- 主内存与工作内存:

- 所有共享变量存储在主内存

- 每个线程有独立的工作内存

- 线程操作变量时需从主内存拷贝到工作内存

- 典型示例:

// 无volatile修饰

boolean flag = true;

// 线程1

while(flag) { /* 可能永不停止 */ }

// 线程2

flag = false; // 修改可能对其他线程不可见- 现象:线程2修改变量后线程1不可见

- 解决方案:

- volatile关键字:

- 强制读写直接操作主内存

- 通过MESI协议保证缓存一致性

- 同步机制:synchronized的锁内存语义

- final变量:构造函数完成后的安全发布

2.1.3 有序性问题(指令重排序)

- 指令重排序:编译器/处理器优化可能导致代码执行顺序改变

重排序类型 | 说明 | 具体示例场景 |

编译器优化 | 编译阶段代码顺序调整 | 将相邻的独立变量声明合并处理 |

处理器优化 | CPU硬件级指令并行执行 | 乱序执行计算密集型指令掩盖内存访问延迟 |

内存系统 | 缓存和缓冲区引起的执行顺序变化 | 写操作先进入缓冲区而读操作直接访问缓存 |

- 解决方案:通过volatile/happens-before原则禁止重排序

2.1.4 综合对比表

问题类型 | 硬件根源 | 产生原因 | 典型表现 | 解决方案 |

原子性 | CPU时间片切换 | 操作被中断 | 计数不准确 | 同步机制/原子类 |

可见性 | 多级缓存架构 | 缓存不一致 | 读取过期数据 | volatile/同步机制 |

有序性 | 指令级并行优化 | 指令重排序 | 对象未初始化完成 | volatile/happens-before |

2.2 Java锁机制全解

2.2.1 锁分类体系

1. 底层实现维度(JVM优化机制)

锁类型 | 实现原理 | 适用场景 | 性能特点 |

无锁 | CAS原子操作(如Atomic类) | 低竞争简单操作 | 零阻塞开销 |

偏向锁 | 记录首个获取锁的线程ID | 单线程重复访问 | 零开销 |

轻量级锁 | CAS自旋尝试获取锁 | 短时间锁竞争 | 低开销 |

重量级锁 | 操作系统Monitor对象+线程阻塞 | 长时间锁竞争 | 高开销 |

2. 使用场景维度(并发控制策略)

锁类型 | 并发特性 | 典型实现 | 适用场景 |

共享锁 | 允许多线程同时读取 | ReentrantReadWriteLock读锁 | 缓存系统 |

排他锁 | 独占访问 | synchronized/ReentrantLock | 数据修改操作 |

3. 其他分类维度

- 公平性:公平锁(按申请顺序)与非公平锁(允许插队)

- 可重入性:可重入锁(如synchronized)与不可重入锁

- 操作方式:自旋锁(忙等待)与阻塞锁(挂起线程)

2.2.2 synchronized实现原理

1. 对象头结构

Java对象头包含两部分信息:

- Mark Word:存储对象运行时数据(哈希码、GC分代年龄、锁状态等)

- Klass Pointer:指向对象类型元数据的指针

对象头与锁机制关联性总结

关联维度 | 具体表现 |

状态管理 | 通过标志位标识锁状态(无锁/偏向锁/轻量级锁/重量级锁) |

数据存储 | 存储线程ID、锁记录指针、Monitor指针等关键数据 |

系统协作 | 与GC子系统交互,处理哈希码冲突 |

性能优化 | 支持锁升级流程(无锁→偏向锁→轻量级锁→重量级锁) |

2. 锁升级流程

- 无锁 → 偏向锁:首次线程访问时记录线程ID

- 偏向锁 → 轻量级锁:出现竞争时通过CAS自旋尝试获取

- 轻量级锁 → 重量级锁:自旋超过阈值(默认10次)后升级

3. 内存语义

- 进入同步块:清空工作内存,强制从主内存加载变量

- 退出同步块:刷新修改到主内存

2.2.3 ReentrantLock

ReentrantLock是Java提供的显式可重入互斥锁,通过灵活的锁获取策略(公平/非公平)、中断响应、超时控制和多条件变量等特性,为复杂并发场景提供比synchronized更精细的线程控制能力。

- ReentrantLock核心特性对比表

特性分类 | ReentrantLock具体实现 | 与synchronized对比 | 适用场景 |

可重入性 | 通过state计数器记录重入次数,同一线程可多次获取锁 | 与synchronized行为一致 | 嵌套方法调用场景 |

锁获取方式 | 显式调用lock()/unlock(),需在finally中确保释放 | synchronized自动释放 | 需要精确控制锁生命周期的场景 |

公平性策略 | 构造参数控制: - new ReentrantLock(true) 公平锁 - new ReentrantLock() 非公平锁(默认) | synchronized仅为非公平锁 | 公平锁:交易系统等需严格顺序的场景 |

中断响应 | lockInterruptibly()支持等待过程中响应中断 | synchronized阻塞时无法中断 | 需要处理取消操作的长时间任务 |

超时控制 | tryLock(timeout, unit)支持限时等待 | 无等效机制 | 避免死锁的临界区操作 |

条件变量 | 支持创建多个Condition对象实现精细等待/通知 | 仅有一个wait/notify队列 | 生产者-消费者等多条件协作场景 |

性能表现 | 高竞争场景下吞吐量更高 | JDK6后性能接近,但灵活性不足 | 高并发竞争场景 |

核心架构设计:

1. AQS依赖关系

- 基于AbstractQueuedSynchronizer(AQS)框架实现

- 通过继承AQS的Sync内部类完成同步控制

2. 状态管理机制

- volatile int state字段:0表示锁未被占用,≥1表示锁被占用,数值表示重入次数

- exclusiveOwnerThread:记录当前持有锁的线程

3. AQS

- 基础架构定位:AQS是Java并发包的同步基础设施,采用模板方法模式封装线程排队、阻塞/唤醒机制。ReentrantLock/Semaphore等同步器均基于其实现,开发者只需关注状态管理逻辑。

- 核心思想:通过共享资源状态管理和线程等待队列实现高效的线程同步机制

- AQS核心组件设计

组件分类 | 功能描述 | 实现方式 | 典型实现案例 |

状态管理 | 通过volatile int state记录同步状态,支持原子操作(CAS) | - 独占模式:state=0表示未锁定,>0表示锁定状态 - 共享模式:state表示可用资源数量 | ReentrantLock:state记录重入次数 Semaphore:state记录剩余许可数 |

等待队列 | 基于CLH变种的双向FIFO队列,管理竞争线程的阻塞/唤醒 | - 节点封装线程引用和状态(WAITING/CANCELLED) - 自旋+CAS实现无锁队列操作 | ReentrantLock:独占模式使用单队列 Semaphore:共享模式使用多队列 |

条件队列 | 单向链表实现条件等待/通知机制,支持多条件变量 | 与主队列联动,通过ConditionObject管理独立等待队列 | ReentrantLock:支持多Condition Semaphore:无条件队列 |

模板方法 | 子类需实现资源获取/释放逻辑(tryAcquire/tryRelease等) | - 独占模式:tryAcquire/tryRelease - 共享模式:tryAcquireShared/tryReleaseShared | ReentrantLock:实现独占模式方法 Semaphore:实现共享模式方法 |

AQS将同步器的实现分解为状态管理与线程调度两个维度:开发者通过重写tryAcquire/tryRelease等模板方法,定义如何通过CAS操作state字段实现业务特定的状态转换规则;AQS框架则基于这些状态变更,自动处理线程的排队、阻塞与唤醒机制。

2.3 线程间通信

Java线程间通信主要机制的对比:

机制类型 | 实现方式 | 特点 | 适用场景 |

wait/notify | Object类的wait()/notify()/notifyAll()方法 | - 必须配合synchronized使用 - 基于对象监视器 - 简单但功能有限 | 简单的生产者-消费者模式 线程间基本同步 |

Condition | Lock.newCondition()创建的Condition对象 | - 更精细的线程控制 - 支持多个等待队列 - 支持中断和超时 | 需要复杂等待条件的场景 读写锁实现 |

CountDownLatch | CountDownLatch类 | - 一次性使用 - 主线程等待多个子线程完成 - 基于AQS实现 | 并行任务初始化 多服务启动检查 |

CyclicBarrier | CyclicBarrier类 | - 可重复使用 - 线程互相等待 - 支持回调函数 | 分阶段任务处理 多线程数据计算 |

BlockingQueue | 各种BlockingQueue实现类 | - 内置线程安全 - 提供阻塞操作 - 多种实现选择 | 生产者-消费者模式 任务队列 |

- 补充说明:

- wait/notify是最基础的线程通信机制,但功能较为有限,容易出现死锁等问题。

- Condition提供了比wait/notify更强大的功能,可以创建多个等待队列,支持更复杂的条件判断。

- CountDownLatch适合"主等子"的场景,而CyclicBarrier适合"线程互等"的场景。

- BlockingQueue是最常用的线程通信方式之一,内部已经实现了线程安全和阻塞逻辑,开发效率高。

三、高并发实战篇

1. 线程池深度优化

- 核心参数对比:

参数名称 | 作用 | 推荐设置 | 注意事项 |

corePoolSize | 核心线程数,即使空闲也不会被回收 | CPU核心数+1 | 设置过小会导致频繁创建线程 |

maximumPoolSize | 最大线程数 | corePoolSize*2 | 需考虑系统资源限制 |

keepAliveTime | 非核心线程空闲存活时间 | 30-60秒 | 根据任务特性调整 |

workQueue | 任务队列 | LinkedBlockingQueue | 队列大小需合理设置 |

threadFactory | 线程工厂 | 自定义命名 | 便于问题排查 |

handler | 拒绝策略 | CallerRunsPolicy | 根据业务容忍度选择 |

补充说明:线程池参数设置需要结合实际业务场景,对于CPU密集型任务,线程数不宜过多;对于IO密集型任务,可以适当增加线程数。监控线程池运行状态是调优的关键。

2. 并发容器解析

容器类型 | 线程安全机制 | 适用场景 | 性能特点 |

ConcurrentHashMap | CAS+synchronized | 高并发读写 | O(1)时间复杂度 |

CopyOnWriteArrayList | 写时复制 | 读多写少 | 写操作性能较差 |

ConcurrentLinkedQueue | CAS无锁 | 高并发队列 | 弱一致性 |

BlockingQueue | 锁机制 | 生产者消费者 | 支持阻塞操作 |

补充说明:JDK1.8后的ConcurrentHashMap取消了分段锁设计,改为CAS+synchronized实现,在保证线程安全的同时提升了并发性能。CopyOnWrite容器适合配置类数据的存储,但要注意内存消耗问题。

3. 分布式锁实战

实现方式 | 原理 | 优点 | 缺点 |

Redis锁 | SETNX+过期时间 | 性能高 | 非强一致 |

Zookeeper | 临时顺序节点 | 可靠性高 | 性能较低 |

数据库锁 | 乐观锁/悲观锁 | 实现简单 | 性能差 |

补充说明:Redisson提供的分布式锁支持自动续期和可重入特性,是Redis分布式锁的较佳实现。Zookeeper通过临时节点和Watcher机制实现锁的释放通知,适合对一致性要求高的场景。

4. 高并发设计模式

模式名称 | 应用场景 | 实现方式 | 效果 |

缓存模式 | 读多写少 | 多级缓存 | 降低DB压力 |

异步模式 | 耗时操作 | MQ+回调 | 提升吞吐量 |

限流模式 | 流量控制 | 令牌桶/漏桶 | 保护系统 |

降级模式 | 异常情况 | 备用方案 | 保证可用性 |

补充说明:高并发系统设计需要考虑缓存击穿、雪崩等问题,合理使用布隆过滤器、本地缓存等方案。异步化处理可以显著提升系统吞吐量,但要注意消息丢失和顺序问题。

四、性能优化篇

4.1 锁性能优化技巧

4.1.1 锁消除与锁粗化

锁消除:JVM在JIT编译时通过逃逸分析,发现某些锁对象不可能被共享访问时,自动移除这些锁操作。典型场景包括:

- 方法内部创建的局部对象锁

- 明确不会逃逸出当前线程的对象

- StringBuffer等线程安全类的局部使用

锁粗化:将多个连续的加锁/解锁操作合并为一个更大范围的锁操作,减少锁获取/释放的开销。适用于:

- 循环体内重复加锁同一对象

- 相邻代码块使用相同锁对象

- 锁操作频繁但临界区执行时间短的场景

4.1.2 减小锁粒度案例

减小锁粒度是通过缩小锁的作用范围来提高并发度:

- 分段锁:如ConcurrentHashMap将数据分为多个Segment,每个Segment独立加锁

- 锁分解:将一个大锁拆分为多个小锁,如读写分离

- 对象锁替代类锁:使用实例锁而非静态锁

- 热点分离:识别高频访问的共享变量单独加锁

4.1.3 读写分离实践

读写锁(ReentrantReadWriteLock)实现:

- 读锁可被多个线程同时持有(共享锁)

- 写锁独占且排斥所有读锁(排他锁)

- 适合读多写少场景,如缓存系统

优化实践:

private final ReentrantReadWriteLock rwl = new ReentrantReadWriteLock();

private final Lock readLock = rwl.readLock();

private final Lock writeLock = rwl.writeLock();public Object get(String key) {readLock.lock();try { /* 读操作 */ } finally { readLock.unlock(); }

}public void put(String key, Object value) {writeLock.lock();try { /* 写操作 */ } finally { writeLock.unlock(); }

}4.2 JUC工具类应用

4.2.1 ThreadLocal内存泄漏防范

内存泄漏风险:

- ThreadLocalMap的Entry是弱引用Key,但Value是强引用

- 线程池场景下线程长期存活会导致Value无法回收

解决方案:

- 使用后显式调用remove()清理

- 使用static final修饰ThreadLocal实例

- 继承InheritableThreadLocal时注意父子线程传递问题

4.2.2 Fork/Join框架使用

Fork/Join是Java7引入的并行任务框架,核心组件:

- ForkJoinPool:特殊线程池,默认并行度=CPU核心数

- ForkJoinTask:可分解任务基类

- RecursiveAction/RecursiveTask:无返回值/有返回值任务

问题类型 | 具体表现 | 解决方案 |

任务划分不当 | 任务粒度太细导致上下文切换频繁,或太粗无法充分利用并行性 | 设置合理的阈值(THRESHOLD),小任务直接顺序执行 |

工作窃取不平衡 | 某些线程任务队列长期为空,其他线程队列积压 | 确保任务划分均匀,避免耗时IO操作 |

递归深度过大 | 栈溢出或性能下降 | 限制递归深度,改用迭代方式实现任务分解 |

共享状态冲突 | 多线程访问共享变量导致数据不一致 | 避免共享可变状态,使用线程安全数据结构 |

异常处理缺失 | 子任务异常导致主任务无法完成 | 重写getException()方法处理任务异常 |

4.2.3 CompletableFuture异步编排

CompletableFuture是Java 8引入的异步编程工具,实现了Future和CompletionStage接口,提供了比传统Future更强大的任务编排能力。其核心特性包括:

- 异步执行任务

- 链式调用

- 多任务组合

- 异常处理

- 支持定制线程池

与Fork/Join设计原理对比:

特性 | CompletableFuture | Fork/Join | 适用场景差异 |

任务类型 | 异步回调 | 分治任务 | 事件驱动 vs 计算密集型 |

线程模型 | 工作窃取+固定池 | 纯工作窃取 | IO密集型 vs CPU密集型 |

结果处理 | 链式组合 | 递归合并 | 流水线 vs 树形结构 |

异常处理 | 显式捕获 | 隐式传播 | 业务异常 vs 计算异常 |

性能特点 | 低延迟 | 高吞吐 | 毫秒级响应 vs 秒级批处理 |

4.3 线上问题排查工具表

工具 | 主要功能 | 使用场景 | 关键命令/操作 |

jstack | 线程分析 | 死锁检测 | jstack -l <pid> |

Arthas | 动态诊断 | 线程池监控 | thread -n 3、watch |

JProfiler | 性能分析 | 锁竞争分析 | 锁持有时间统计、调用树分析 |

五、高并发场景下的多线程应用

5.1 电商系统应用

- 商品库存扣减:使用分布式锁(Redis/Zookeeper)防止超卖

- 订单处理:线程池异步处理订单创建、支付回调等

- 秒杀系统:多级缓存+异步队列削峰

5.2. 大数据处理

- ETL管道:Flink/Kafka多线程实时数据处理

- 并行计算:Spark多线程任务拆分执行

- OLAP分析:ClickHouse多线程查询优化

5.3. 物联网系统

- 设备消息处理:EMQTTD多线程处理海量设备连接

- 实时监控:多线程采集和分析设备数据

- 命令下发:异步线程池处理设备控制指令

技术展望与未来方向

随着Java技术的持续演进,并发编程领域正在经历重大变革。虚拟线程(Project Loom)的引入将彻底改变传统线程模型,使开发者能够以极低成本创建数百万个轻量级线程,显著提升系统吞吐量。响应式编程(如Reactor框架)与异步非阻塞模型的结合,正在重塑高并发系统的设计范式。关注以下技术演进:

- 虚拟线程实践:在Spring Boot 3+环境中尝试使用Thread.startVirtualThread()替代传统线程池,特别适合IO密集型场景

- 响应式编程深化:掌握Flux和Mono的背压处理机制,构建弹性分布式系统

- AI辅助开发:利用代码生成工具快速实现并发逻辑