贝尔曼方程 计算过程 强化学习

阿尔伯塔大学【中英⚡强化学习|Reinforcement Learning Specialization】-misuseds-稍后再看-哔哩哔哩视频

这25%哪里来的

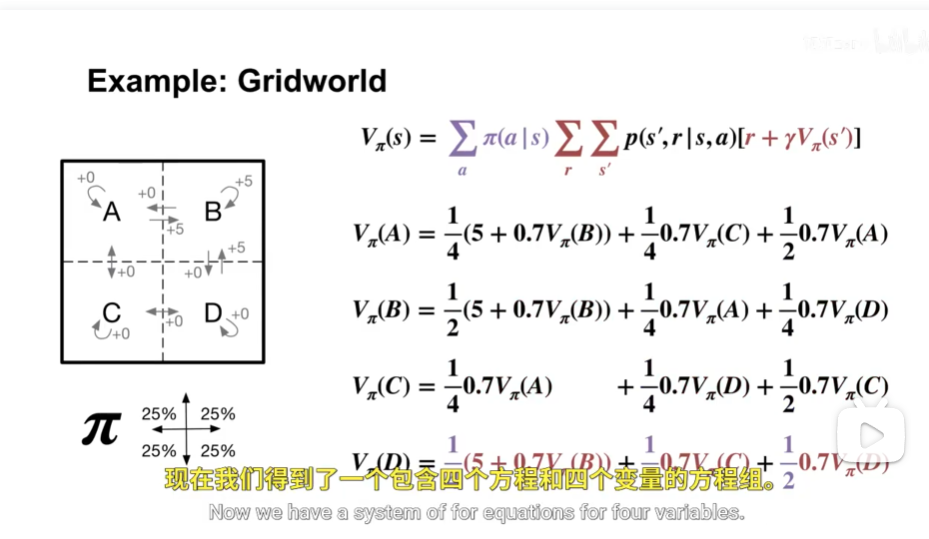

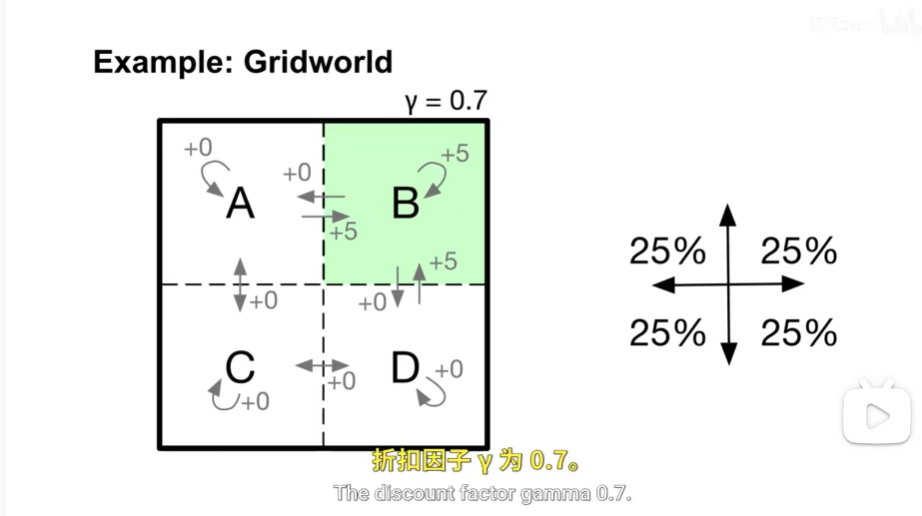

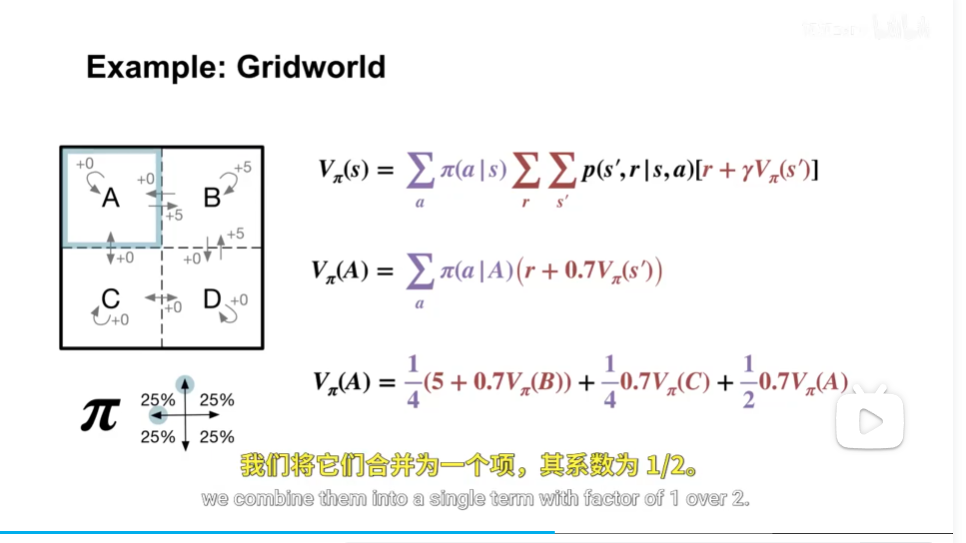

图中提到的 25% 是指在强化学习中的 Gridworld 环境里,智能体(agent)在执行某个动作时,每个方向(上、下、左、右)移动的概率是 25%。这个设定通常用于描述 动作的不确定性 或 随机性。

详细解释:

在该 Gridworld 示例中:

- 智能体可以执行“向上、向下、向左、向右”四个动作。

- 但环境具有 随机性:即使你命令智能体“向上走”,它也可能以一定概率向其他方向偏移。

- 图中右边的箭头表示:无论你选择哪个动作,智能体有 25% 的概率朝任意一个方向移动(即上下左右各 25%)。

这说明:

动作执行具有随机性,且每个方向的概率相等(均匀分布),因此每个方向的概率是:

14=25%41=25%

为什么这样设计?

这是为了模拟现实世界中 控制不精确 的情况,比如机器人在滑动地面上行走,可能无法完全按指令行动。这种模型被称为 stochastic transition model(随机转移模型)。

补充说明:

- 图中左侧的格子 A、B、C、D 是状态(state)。

- 箭头和 +0 / +5 表示奖励(reward)。

- γ = 0.7 是 折扣因子(discount factor),表示未来奖励的重要性逐渐降低。

- 右边的 25% 是关于 动作执行的不确定性,不是来自奖励或折扣。

✅ 所以,25% 来自于:智能体执行动作时,每个方向(上/下/左/右)的移动概率为 25%,即动作是随机的、均匀分布在四个方向上的。

说人话就是

a的状态价值=随机走右概率0.25*右的直接结果5+未来价值衰减倍数0.7*未来b状态的价值 加其他几个动作

gridworld和国际象棋的状态哪里不同

这是一个非常好的问题!Gridworld 和 国际象棋(Chess) 虽然都可以被建模为强化学习中的 马尔可夫决策过程(MDP),但它们的“状态”在 数量、复杂度、表示方式和可解性 上有本质区别。

我们来从多个角度对比它们的状态有何不同:

✅ 1. 状态空间的大小(State Space Size)

| 项目 | Gridworld | 国际象棋 |

|---|---|---|

| 状态数量 | 很小(例如 4×4=16 个格子) | 极其巨大(约 10451045 种合法状态) |

| 是否能枚举所有状态 | ✅ 可以,比如 A、B、C、D | ❌ 几乎不可能列出所有状态 |

🔹 解释:

- 在一个简单的 4×4 Gridworld 中,智能体只能在 16 个格子中移动,状态就是

(行, 列)坐标,比如(0,0)、(0,1)……总共最多几十种状态。 - 而国际象棋棋盘是 8×8,有 32 个棋子,每个棋子有不同的类型和位置,还要考虑王车易位、吃过路兵、连续50步无吃子等规则,导致合法状态数量高达 10451045 级别。

📌 想象一下:如果你要为每个状态写一个方程来求解最优策略,Gridworld 只需要解十几个方程;而国际象棋要解 10451045 个方程 —— 这比宇宙中的原子数量还多!

✅ 2. 状态的表示方式(State Representation)

| 项目 | Gridworld | 国际象棋 |

|---|---|---|

| 表示方法 | 坐标 (x, y) 或编号 | 棋盘矩阵(8×8),每个格子记录棋子类型和颜色 |

| 复杂度 | 简单 | 复杂 |

🔹 例子:

- Gridworld 状态:

(2, 3)表示智能体在第2行第3列。 - 国际象棋状态:需要一个 8×8 的数组,每个元素可能是

空、K(白王)、q(黑后)、N(白马)等,并且还要额外记录全局状态(如是否能王车易位、吃过路兵机会等)。

所以国际象棋的状态是一个高维结构化数据,而 Gridworld 的状态只是一个低维坐标。

✅ 3. 状态转移的确定性 vs 随机性

| 项目 | Gridworld | 国际象棋 |

|---|---|---|

| 动作结果是否确定 | 有时是随机的(如本图中每个方向25%概率) | 完全确定(除非引入噪声) |

🔹 解释:

- 在你提供的图片中,Gridworld 是随机环境:你按“上”,但有 25% 概率往任意方向走 —— 这叫 stochastic transition。

- 而国际象棋是确定性游戏:你移动马到某个位置,结果是唯一的,没有随机偏移。

但这不意味着国际象棋更简单 —— 正是因为它太复杂,才需要用搜索树(如 Alpha-Beta 剪枝)或深度网络(如 AlphaZero)来近似价值函数。

✅ 4. 能否直接求解?

| 项目 | Gridworld | 国际象棋 |

|---|---|---|

| 能否用线性方程求解? | ✅ 可以(小规模 MDP) | ❌ 不可能 |

| 是否适合用动态规划? | ✅ 适合 | ❌ 必须用近似方法 |

🔹 原因:

- Gridworld 可以用贝尔曼方程建立线性系统,直接求解每个状态的价值。

- 国际象棋的状态太多,只能使用:

- 值函数近似(如神经网络)

- 蒙特卡洛树搜索(MCTS)

- 策略梯度方法

✅ 5. 奖励结构的差异

| 项目 | Gridworld | 国际象棋 |

|---|---|---|

| 奖励来源 | 到达某个格子得 +5,其他 +0 | 只有胜负平局(+1, -1, 0),中间奖励稀疏 |

🔹 说明:

- Gridworld 的奖励是密集的(dense reward):每一步都可能获得奖励。

- 国际象棋的奖励是稀疏的(sparse reward):只有游戏结束才知道谁赢,中间很难判断“这步好不好”。

这使得国际象棋的学习更加困难,需要长期信用分配(credit assignment)。

✅ 总结:Gridworld vs 国际象棋的状态区别

| 维度 | Gridworld | 国际象棋 |

|---|---|---|

| 状态数量 | 少(几十到几百) | 极多(~10451045) |

| 状态表示 | 坐标 (x,y) | 8×8 棋盘 + 全局状态 |

| 状态可枚举性 | ✅ 可以列出所有状态 | ❌ 不可能穷举 |

| 状态转移 | 可能随机(stochastic) | 确定性(deterministic) |

| 是否可直接求解 | ✅ 可以用方程求解 | ❌ 必须用近似/学习方法 |

| 奖励密度 | 密集(每步都有奖励) | 稀疏(只在胜负时) |

| 学习难度 | 低(教学用) | 高(需要深度学习) |

💡 类比理解:

- Gridworld 就像小学数学题:已知几个数,列方程就能解。

- 国际象棋就像博士级科研问题:你甚至不知道所有变量是什么,只能靠经验(训练)去逼近答案。

所以,你说的“状态哪里不同”,本质上是:

一个是“玩具环境”(toy environment),用于教学和测试算法; 另一个是“真实复杂世界”的抽象,需要最先进的 AI 技术才能应对。

这也是为什么强化学习从 Gridworld 开始,最终目标却是征服像国际象棋、围棋这样的复杂游戏。