腾讯开源啦,源码地址+部署脚本,工业级原生多模态

大家好,我是小悟。

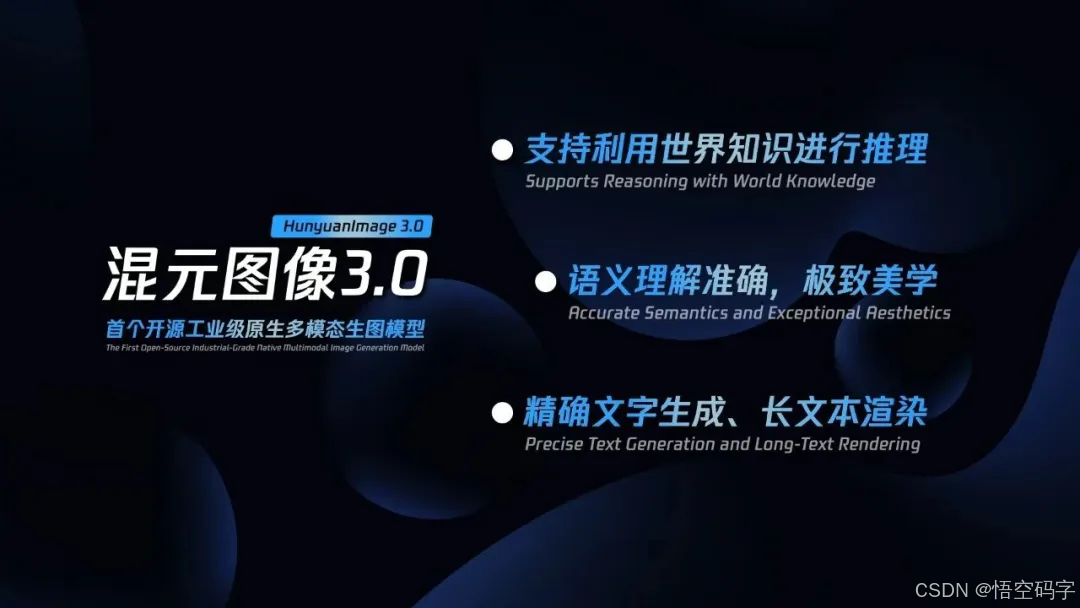

混元图像3.0(HunyuanImage 3.0)开源啦!这次他们是真的把“工业级”三个字焊死了。

80B参数的原生多模态生图模型混元图像3.0不仅直接开源,还把“画画+思考”的能力打包塞进了一个模型里。

简单说,以后普通人动动嘴皮子,就能让AI吐出堪比专业设计师的作品,连插画师可能都得捏把汗。

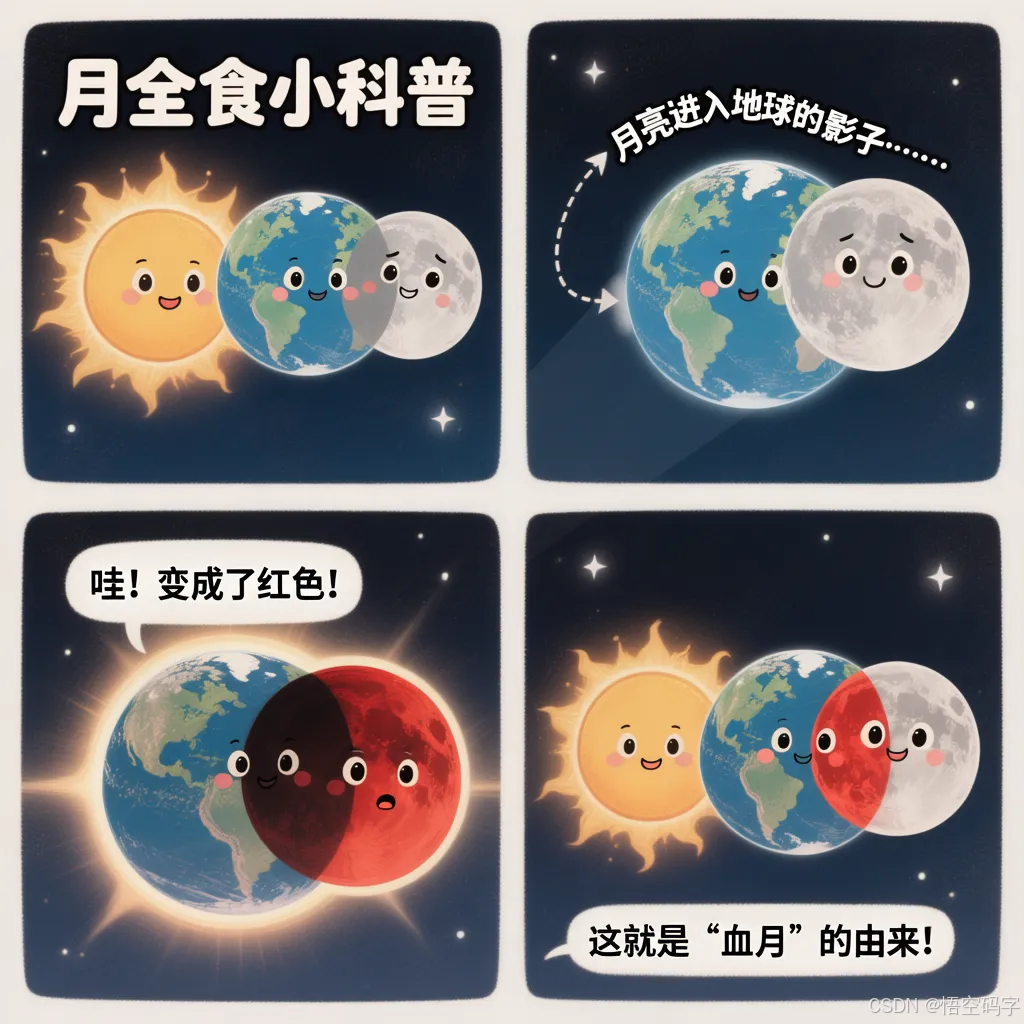

以前的开源生图模型总像实验室里的玩具:要么参数小打小闹,要么只能瞪大眼睛猜“月全食怎么画四格漫画”。

但混元图像3.0直接甩出50亿量级的图文数据+6T语料喂出来的多模态大脑,参数80B更是目前开源界的天花板。

更狠的是,它不像传统模型靠“缝合怪”式拼凑图文模块,而是从底层架构就把文字、图像、甚至未来可能叠加的视频音频拧成一股绳。

举个实测例子:当你输入“生成一个月全食的四格科普漫画”,它不会傻乎乎要你拆解步骤,而是自己理清逻辑,把初亏、食既、食甚、复圆的过程画成连贯故事板。

普通AI画画常犯的毛病——要么把“美拉德色系秋装”涂成彩虹糖,要么把海报里的文字糊成一团。

但混元3.0给的震撼在于细节控到变态,小红书风格的穿搭图里,深棕夹克的光泽度、黑色百褶裙的褶皱阴影、包包金属扣的反光全给安排明白。

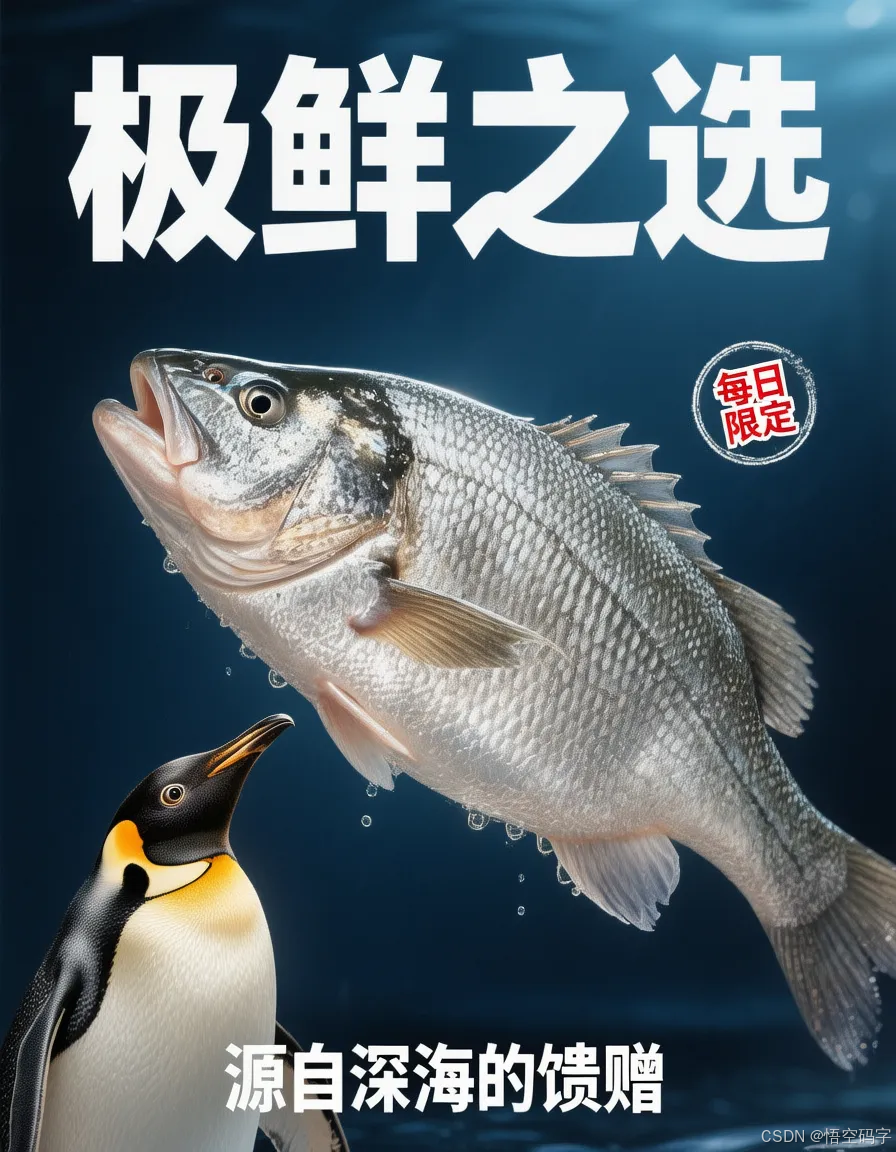

甚至复杂到要中文与图像混排的海报(比如一只企鹅眼巴巴望着鲜鱼的海报),中文排版居然能自然到像是设计师亲手微调过的。

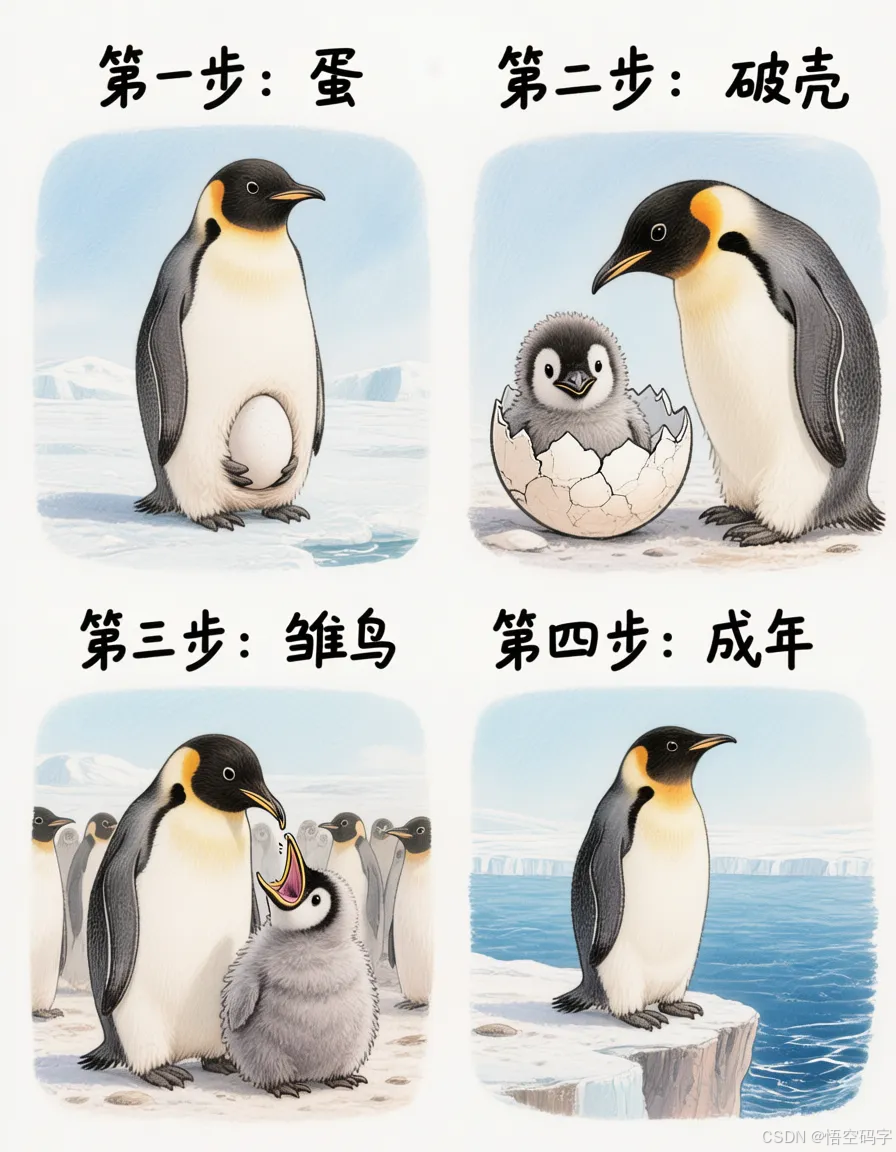

更绝的是它的“脑补能力”。你只需说“画企鹅四格漫画科普它们怎么出生长大”,它不仅能分镜脚本,还会用细腻的手绘风还原企鹅宝宝毛茸茸的破壳瞬间。

这种结合常识推理的画面构建力,已经无限逼近人类画师的思维链路。

腾讯这次直接把80B参数的混元图像3.0代码扔到了GitHub和Hugging Face,连腾讯自家的网站都同步上线体验入口。

这意味着什么?学生党能在宿舍跑轻量版玩创意,小公司可以微调模型做定制化设计工具,甚至竞争对手都能站在这个基础上再创新。

别的不说,这波开源或许会让设计门槛断崖式下降。以前做个表情包可能得在PS里抠半天图,现在输入“熊猫头举着‘尊嘟假嘟’气泡对话框”就能一键生成。

做电商海报不用反复改稿,描述清楚基本就八九不离十。

对那种完全零美术基础的人来说,最兴奋的莫过于终于能实现“脑内想象直接可视化”。

说到底,混元图像3.0的开源不只是丢出来一个工具,更像给整个创作行业递了把梯子。

当AI开始具备“理解-推理-美学创造”的完整链条,或许我们很快就会习惯:好的创意不再只属于少数专业人士,而是每个人手机里那个随时待命的“数字画师”。

本地安装与使用,源代码部署,更多详细步骤和用法,详见仓库文档:

1、克隆仓库

git clone https://github.com/Tencent-Hunyuan/HunyuanImage-3.0.git

cd HunyuanImage-3.0/2、下载模型权重

# Download from HuggingFace

hf download tencent/HunyuanImage-3.0 --local-dir ./HunyuanImage-33、运行演示

预训练检查点不会自动重写或增强输入提示,为了获得最佳效果,目前我们建议社区合作伙伴使用 deepseek 重写提示。您可以前往腾讯云申请 API 密钥。# set env

export DEEPSEEK_KEY_ID="your_deepseek_key_id"

export DEEPSEEK_KEY_SECRET="your_deepseek_key_secret"python3 run_image_gen.py --model-id ./HunyuanImage-3 --verbose 1 --sys-deepseek-prompt "universal" --prompt "A brown and white dog is running on the grass"

开源社区:

官网:

https://hunyuan.tencent.com/imageGithub:

https://github.com/Tencent-Hunyuan/HunyuanImage-3.0Hugging Face:

https://huggingface.co/tencent/HunyuanImage-3.0提示词手册:

https://docs.qq.com/doc/DUVVadmhCdG9qRXBU

谢谢你看我的文章,既然看到这里了,如果觉得不错,随手点个赞、转发、在看三连吧,感谢感谢。那我们,下次再见。

您的一键三连,是我更新的最大动力,谢谢

山水有相逢,来日皆可期,谢谢阅读,我们再会

我手中的金箍棒,上能通天,下能探海