【人工智能通识专栏】第三十三讲:知识库的构建与应用

欢迎关注【人工智能通识】专栏

目录

11.2.1 理解知识库的概念

11.2.2 使用Cherry Studio 构建知识库

11.2.3 基于知识库的本地模型

本章参考文献

如果把Deepseek模型看作在公共图书馆读尽万卷书的博学通才,本地知识库就像是收藏专有数据档案资料的私家书房。通过搭建本地知识库让DeepSeek模型与私有知识相结合,模型就能将分散的文档、数据转化为可交互的智能知识体系,对于涉及私有知识的特定问题就能给出更有针对性、更可靠的回答。

11.2.1 理解知识库的概念

知识库(Knowledge Base)是存储和管理知识的系统,通常包含结构化和非结构化的信息,用于帮助用户或系统快速查找和获取相关知识。通俗地说,知识库就是存放着文档、数据库、规则、案例、常见问答(FAQ)的“知识仓库”。

本地知识库(Local Knowledge Base)是部署在本地的专属资料库,存储着个人的文档、笔记、代码,以及企业的业务资料和技术资料,也被称为个人知识库。搭建本地知识库不仅可以系统管理海量的碎片化数据,提高私有知识的提取和检索效率,还能利用大语言模型的深度分析能力,减少大模型的幻觉问题。此外,本地知识库的数据可以保存在本地的计算机或服务器上,减少隐私泄露风险。

基于本地知识库的Deepseek模型通过检索增强生成(RAG)技术,结合了大语言模型智能推理与私有知识精准检索,全程在本地设备高效运行。其核心工作包括以下阶段。

1. 生成向量数据库:通过嵌入模型(Embedding)将非结构化的文本数据转换为高维语义向量,存储到本地向量数据库并构建高效索引。

2. 精准检索:将用户提出的问题也转换为语义向量,在本地向量数据库中进行快速搜索,精准匹配到若干个最相关的文本片段。

3. 知识增强提问:整合用户问题与私有知识,即将检索到的文本片段作为专业的上下文注入原始问题,作为增强的模型输入。

4. 答案生成:Deepseek模型接收增强的模型输入,理解上下文中的私有知识,进行分析和推理,生成答案并输出。

Deepseek模型与本地知识库相结合,具有广泛而实用的应用场景。

1. 海量文档管理:对海量零散文档内容进行高效管理和深度理解,支持自然语言提问。

2. 专业知识调用:企业通过私有的垂直领域知识库(标准规范、设计文档、数据报表),为大模型注入Know-How知识,提升团队协作效率。

3. 隔离敏感数据:在内网隔离环境中使用和分析敏感数据文件,满足数据合规要求。

4. 流程自动化嵌入:将本地知识库与企业管理信息系统集成,可以基于历史记录和操作手册自动提供流程指引,包括自动客服、IT运维、财务审核、操作指南。

11.2.2 使用Cherry Studio 构建知识库

搭建基于Deepseek模型的本地知识库,可以采用不同的技术方案。Cherry Studio可以通过图形化界面配置嵌入模型和知识库,无需手动编程,非常适合个人用户快速构建基于私有数据的问答系统。

配置嵌入模型

本书2.4节中详细介绍了Cherry Studio的软件安装与模型配置。构建本地知识库,除了配置Deepseek模型,还要使用嵌入模型将文本转化为数字向量。

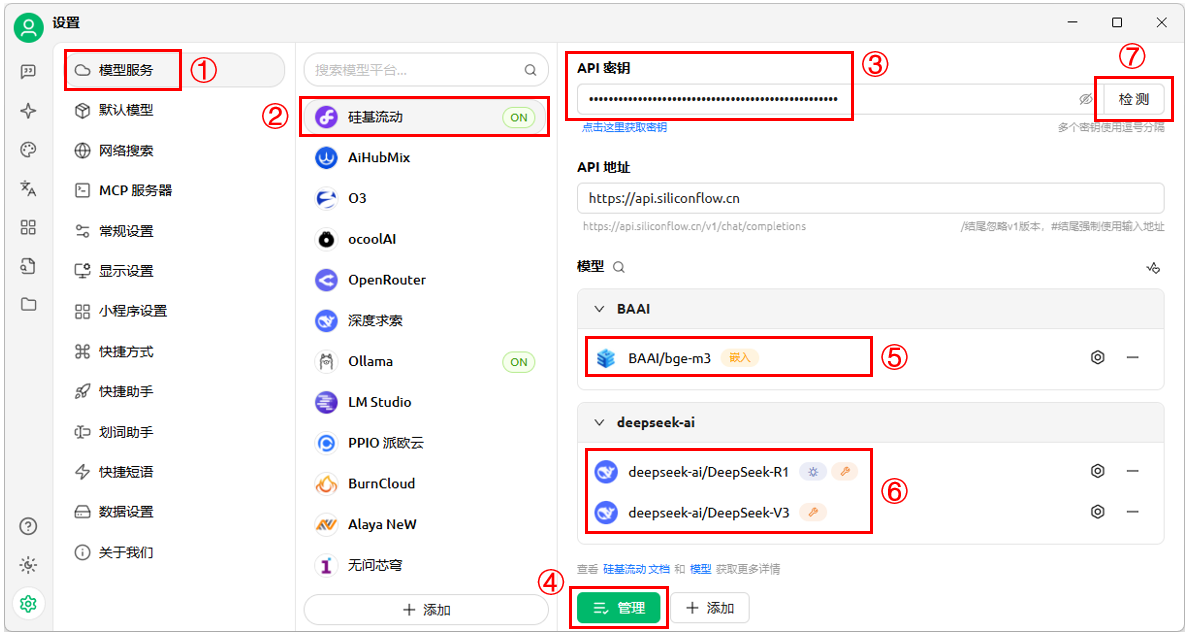

1. 打开Cherry Studio程序,点击左侧边栏“设置”按钮进入如图11-11所示的设置页面。

(1)从左侧菜单中选择“模型服务”(图11-11①)、模型接入服务商(图11-11②),启用所选的接入服务商。使用内置服务商时,软件自动设置“API地址”。

(2)在“API密钥”填写模型接入服务商的API Key(图11-11③)。

2. 管理和添加模型。

(1)点击“管理”按钮(图11-11④)进入模型管理页面,将获取服务商支持的所有模型。

(2)选择Deepseek-R1和Deepseek-V3大语言模型(图11-11⑥)。

(3)选择BAAI/bge-m3嵌入模型(图11-11⑤)。bge-m3是领先的多语言嵌入模型,也可以选择“BAAI/bge-large-zh-v1.5”或“Pro/BAAI/bge-m3”模型。

3. 测试模型连接。点击“API密钥”后的“检测”按钮(图11-11⑦),选择模型进行检测,连接成功将显示“连接成功”。

图11-11:Cherry Studio的模型配置

构建本地知识库

1. 新建知识库。

(1)添加知识库:打开CherryStudio程序,点击左侧边栏的知识库按钮,进入知识库管理页面,再点击“添加”按钮,在“添加知识库”弹窗填写知识库名称,例如“XDgrad”。

(2)配置模型:点击“嵌入模型”下拉框选择嵌入模型,例如选择“BAAI/bge-m3”模型。类似地,可以选择重排序模型,也可以忽略。

(3)如图11-12所示,点击“确定”完成创建知识库。

图11-12:Cherry Studio创建知识库

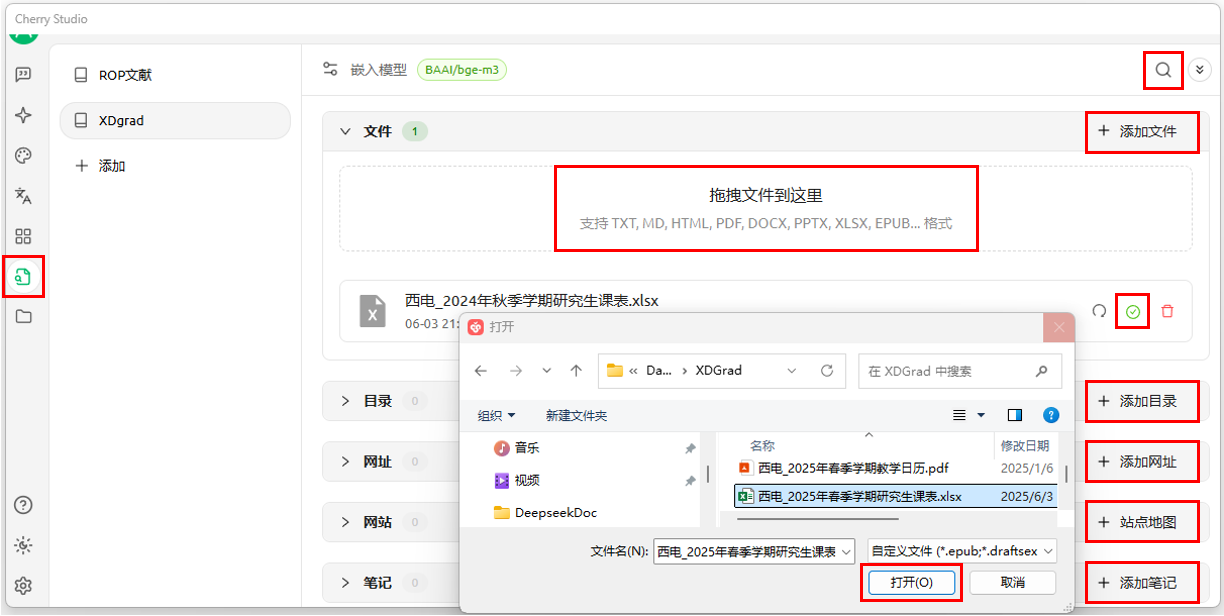

2. 导入文献资料。

Cherry Studio支持的文件格式包括:pdf、docx、pptx、xlsx、txt、md、mdx等。如图11-13所示,支持多种方式添加资料。

(1)添加文件:在“知识库”管理页面,点击“添加文件”,打开文件夹选择要添加的文件。也可以直接从文件夹拖拽要添加的文件到“拖拽文件到这里”区域。

(2)添加文件夹目录:在“知识库”管理页面,点击“添加目录”可以添加整个文件夹,该目录下的文件(支持的文件格式)都被自动添加。

(3)添加网址链接:在“知识库”管理页面,点击“添加网址” 可以添加一个或多个URL,多个网址之间用回车分隔。

(4)添加网站:在“知识库”管理页面,点击“站点地图”可以输入站点地图URL,支持xml格式的站点地图,如https://docs.siliconflow.cn/sitemap.xml。

(5)纯文本笔记:在“知识库”管理页面,点击“添加笔记”弹出文本编辑窗,可以直接输入或粘贴纯文本内容。

文献资料导入知识库后,系统自动进行向量化处理,完成后显示绿色标记。在Cherry Studio知识库中添加的数据全部存储在本地。

注意:(1)导入知识库的文档插图暂不支持转换为向量。(2)使用网址或网站链接作为知识来源时,需要网站的权限许可。

3. 搜索知识库内容

在“知识库”管理页面,点击右上角搜索图标,输入查询内容即可搜索知识库。

图11-13:向知识库添加文件与内容

基于本地知识库的Deepseek对话

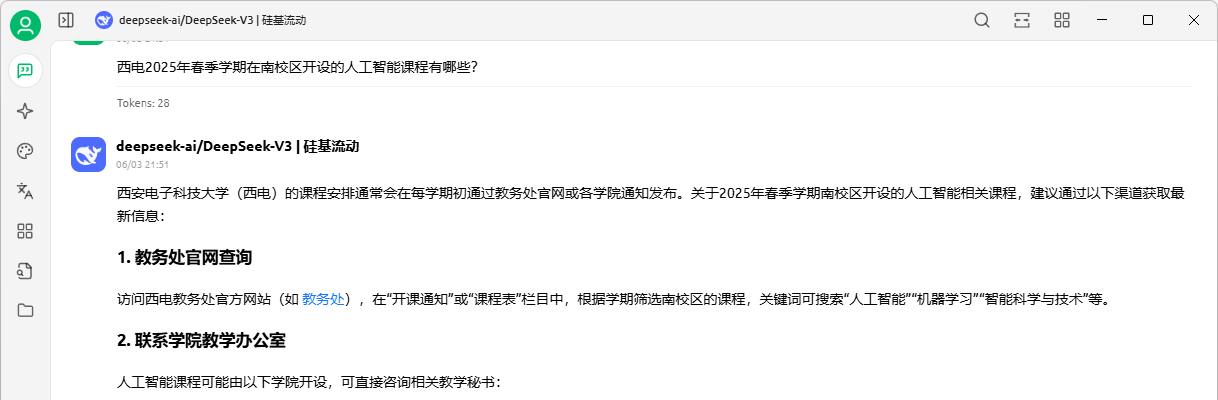

首先,我们不使用本地知识库,直接与DeepSeek模型对话。在CherryStudio聊天窗口输入问题:【西电2024-2025学年开设的数据挖掘相关课程有哪些?】,DeepSeek模型的回答如图11-14所示。这是由于该问题与私有数据相关,靠分析推理无法得出答案,因此DeepSeek模型不能回答。即使开启联网搜索功能,DeepSeek模型也无法有效回答。

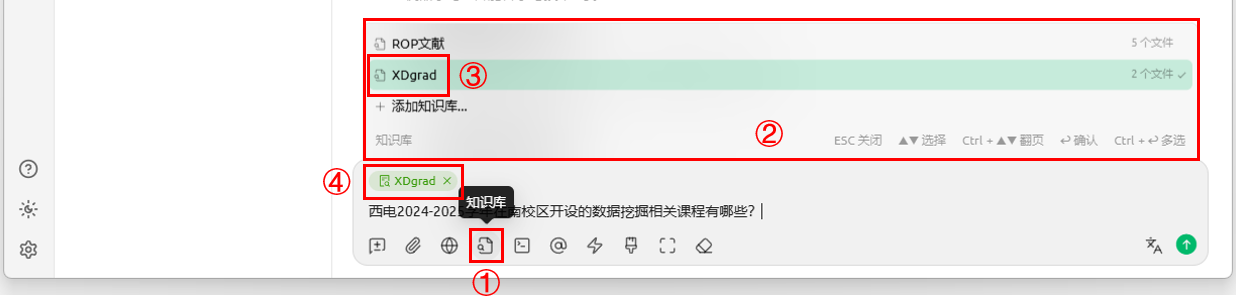

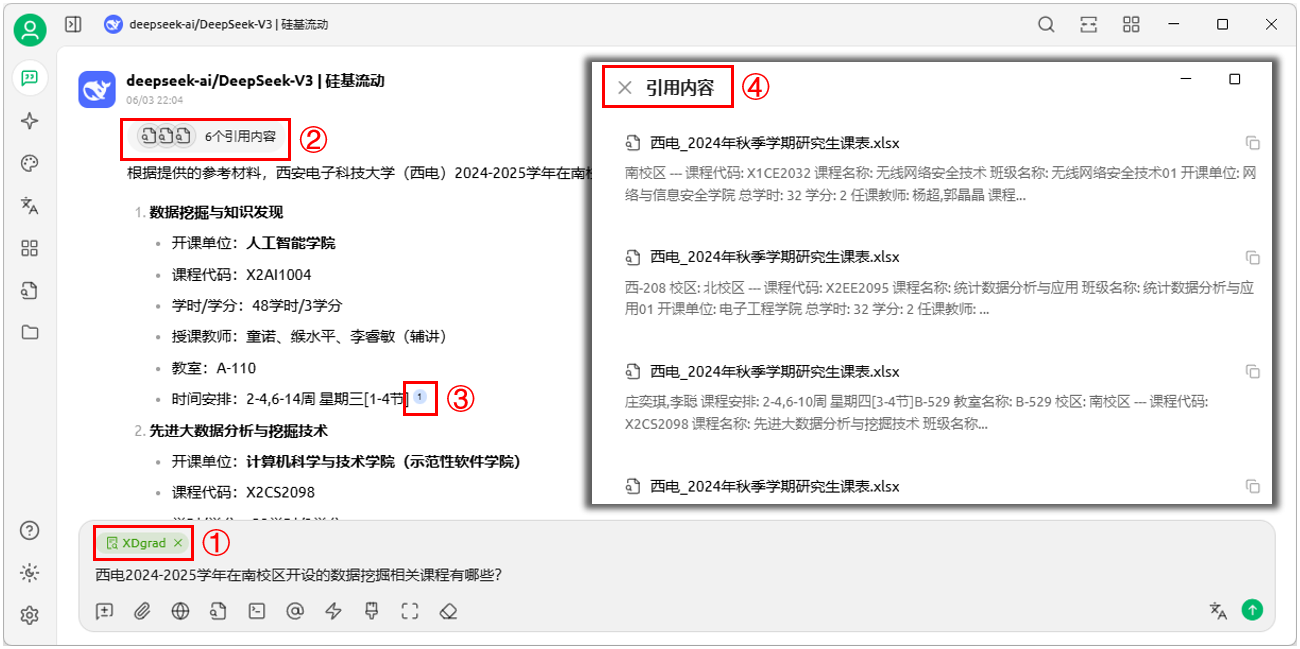

开启本地知识库。如图11-15所示,点击聊天输入框下方的知识库按钮(图11-15①),弹出本地知识库选项框(图11-15②),点击选择要开启的知识库XDgrad(图11-15③)。

本地知识库XDgrad开启后,在对话输入框左上角显示有XDgrad标志(图11-16①)。如图11-16所示,再次在CherryStudio聊天窗口输入同样的问题:【西电2024-2025学年开设的数据挖掘相关课程有哪些?】。

DeepSeek模型从本地知识库XDgrad中检索到6条引用内容(图11-16②),可以准确回答提出的问题。对每条引用都给出了参考文献编号(图11-16③),参考文献都来自本地知识库。点击引用编号,可以唤出引用内容窗口(图11-16④),显示具体的引用文件与内容。

图11-14:未开启本地知识库时的问答

图11-15:开启Cherry Studio本地知识库

图11-16:开启本地知识库后的问答

11.2.3 基于知识库的本地模型

本地知识库的数据保存在本地,但在提问过程中仍然存在数据上传的泄漏风险。本地部署模型与本地知识库相结合,可以保障数据完全本地化,构建安全、高效的智能系统。

本节在Cherry Studio构建本地知识库的基础上,配置Ollama本地部署的Deepseek模型,实现本地模型与本地搜索的结合。

部署Deepseek本地模型和本地知识库

1. 通过Ollama安装Deepseek模型,详见本章11.1.1节。注意要启动Ollama本地服务。

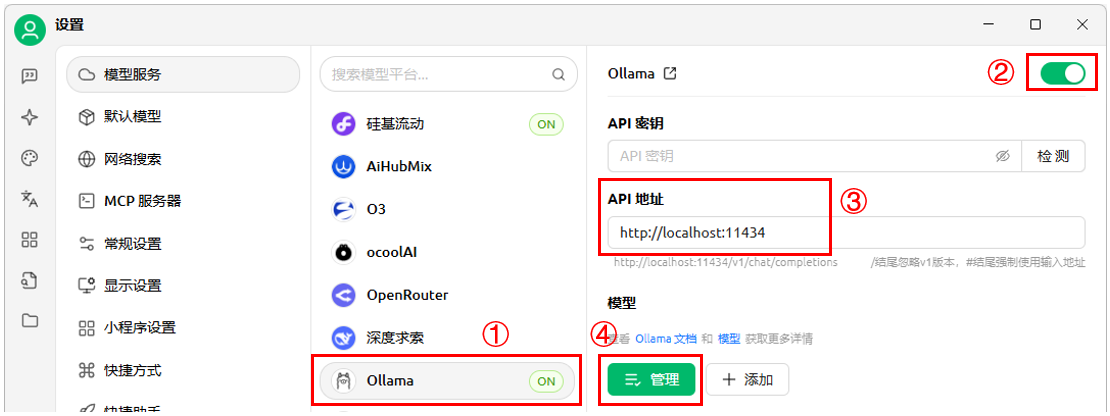

2. 在CherryStudio中添加Ollama作为模型服务商。

(1)在CherryStudio左侧导航栏中点击“设置”按钮,选择“模型服务→Ollama”进入如图11-17所示的模型配置页面。

(2)打开Ollama服务商最右侧的开关,启用Ollama模型。

(3)默认Ollama不需要API密钥,可以将“API密钥”栏留空。在“API地址”栏填写默认的绑定地址`http://localhost:11434`或`http://127.0.0.1:11434`。如果用户修改了 Ollama 的监听地址,则填写相应的修改地址。

3. 添加Deepseek本地模型。

点击“管理”按钮,Ollama模型窗口中显示已安装的本地模型。如图11-18所示,点击模型deepseek-r1:7b后面的加号`+`以启用模型(启用后变为减号`–`,背景变为浅绿色)。

完成以上配置,就可以在Cherry Studio中开始与本地模型对话了。

4. 添加bge-m3嵌入模型。

(1)在命令行窗口输入`ollama run bge-m3`,如果本地没有该模型Ollama就会自动下载和安装bge-m3模型。安装完成后显示“success”,说明安装成功。

说明:安装后显示“Error:”bge-m3” does not support generate”不是安装错误,而是说明bge-m3模型不支持generate生成任务。

(2)如图11-18所示,点击bge-m3模型后面的加号`+`以启用该模型。

5. 测试模型连接。点击“API密钥”后的“检测”按钮,选择模型进行检测,连接成功将显示“连接成功”。

6. 在CherryStudio中构建本地知识库,详见本章11.2.2节。

于是,通过Ollama提供本地Deepseek模型和bge-m3嵌入模型的运行支持,Cherry Studio通过图形化界面配置模型和知识库,就实现了基于本地知识库的Deepseek模型本地部署。

使用基于本地知识库的Deepseek本地模型

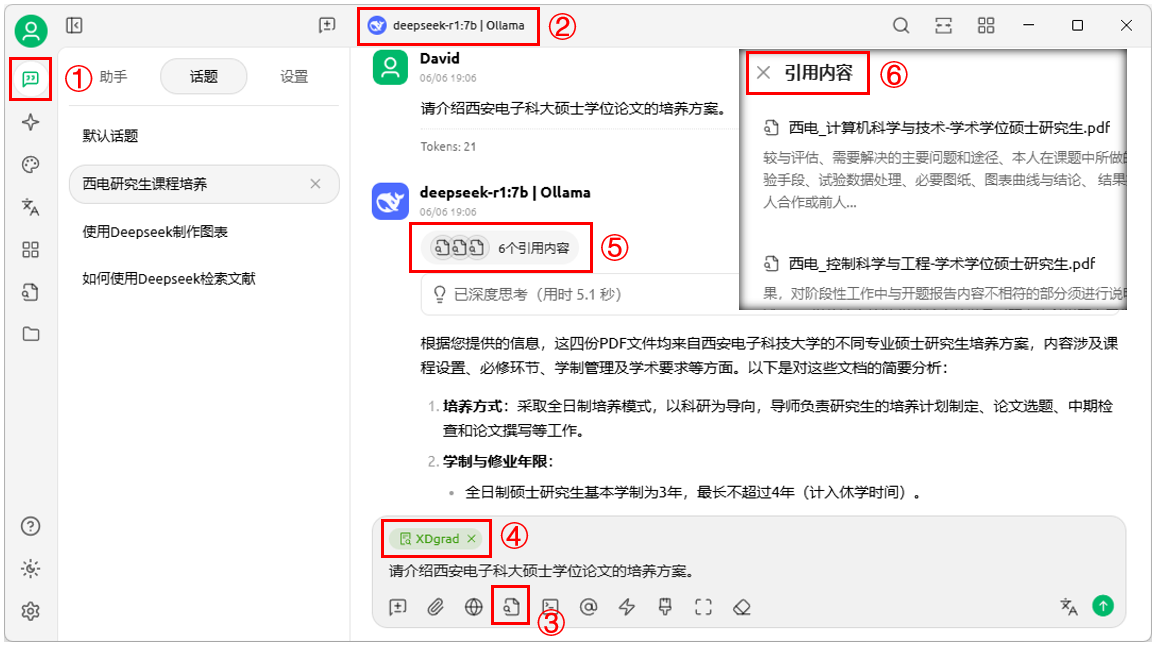

1. 打开Cherry Studio应用程序,点击左侧工具栏在的助手按钮(图11-19①),进入聊天页面。

2. 开启Deepseek本地模型。点击页面上方的模型按钮(图11-19②),切换为由Ollama部署的deepseek-r1:7b本地模型。

3. 开启本地知识库。点击对话输入框下方的知识库按钮(图11-19③),在知识库选项中选择要开启的本地知识库XDgrad,输入框左上角就会显示XDgrad标志(图11-19④)。

4. 对话聊天。在对话框输入问题,就可以在Cherry Studio中与Deepseek本地模型对话。

本地模型从本地知识库XDgrad中检索到引用内容(图11-19⑤),可以准确回答提出的问题。点击引用内容,可以唤出引用内容窗口(图11-19⑥)显示具体的引用文件与内容。

需要指出的是,本地部署大语言模型与构建企业级知识库都是涉及多重技术栈的复杂系统工程,本文提供的案例只供个人用户快速体验。

图11-17:Cherry Studio配置Ollama模型

图11-18:启用Ollama部署的本地模型

图11-19:本地模型结合本地知识库

本章小结

本章围绕本地部署与知识库应用展开,展示了DeepSeek如何实现离网运行、私有化管理与知识融合。通过这些方法,可以构建更为安全、高效、可控的智能系统,使其真正融入科研与学习工作流。

在下一章中,我们将进一步探讨智能体与工作流的构建,打造能够自主感知、执行和协作的智能系统。

本章参考文献

1. Ollama (2025), Ollama User Documentation, https://github.com/ollama/ollama/tree/main/docs

2. Open WebUI (2025). Open WebUI Documentation. https://docs.openwebui.com/

往期回顾:

【人工智能通识专栏】第三十讲:Deepseek辅助文献阅读

【人工智能通识专栏】第三十一讲:文献分析与综述

【人工智能通识专栏】第三十二讲:本地化部署模型

版权声明:

本文版权属于 AI小书房(aixiaoshufang@163.com),转载必须标注原文链接:

https://blog.csdn.net/AI_zhiyu/article/details/152413555

Copyright@AI小书房 2025