碎片笔记|生成模型原理解读:AutoEncoder、GAN 与扩散模型图像生成机制

前言:本篇博客简要介绍不同生成模型架构的图像生成原理,主要包括AutoEncoder、GAN 和 Diffusion Models 三类。

目录

- AutoEocoder(自编码器)

- VAE(Variational Autoencoder,变分自编码器)

- GAN(Generative Adversarial Network,生成对抗网络)

- Diffusion Model(扩散模型)

- Latent Diffusion Model(LDM,潜空间扩散模型)

AutoEocoder(自编码器)

AutoEncoder主要用于图像重建任务,是典型的Encoder-Decoder架构。

生成原理:图像 xxx 首先经由 Encoder 编码成 latentlatentlatent,然后latentlatentlatent送入Decoder得到重建图像。

VAE(Variational Autoencoder,变分自编码器)

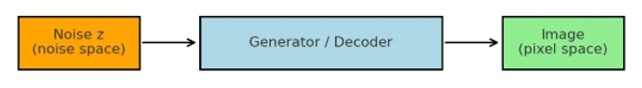

VAE是AutoEncoder的变体,旨在提升AutoEncoder的图像生成能力,因此对于训练完毕的VAE,可以直接使用其Decoder生成图像。

生成原理:随机生成噪声向量 latentlatentlatent 送入Decoder即可生成图像。

GAN(Generative Adversarial Network,生成对抗网络)

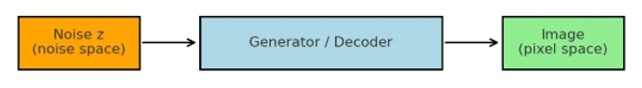

GAN(Generative Adversarial Network,生成对抗网络)是一种生成模型,由 生成器(Generator) 和 判别器(Discriminator) 构成,生成器负责生成图像,判别器负责区分真图像与生成图像。训练过程中,判别器对生成图像与真实图像进行判别,生成器根据判别结果不断优化,从而生成逼真的图像。两者通过对抗训练提升生成效果。

生成原理:随机生成噪声向量 latentlatentlatent(通常服从标准正态分布)作为输入送入生成器,生成器输出图像。

Diffusion Model(扩散模型)

Diffusion Model(扩散模型)是一种基于逐步去噪生成图像的概率模型,通过学习数据分布的反向扩散过程来生成图像。

生成原理:首先从标准正态噪声图像开始,经过训练好的去噪网络(通常是 U-Net 结构)逐步迭代去噪,最终得到高质量图像。生成过程可以视作“从纯噪声到图像”的逐步逆扩散过程。

Latent Diffusion Model(LDM,潜空间扩散模型)

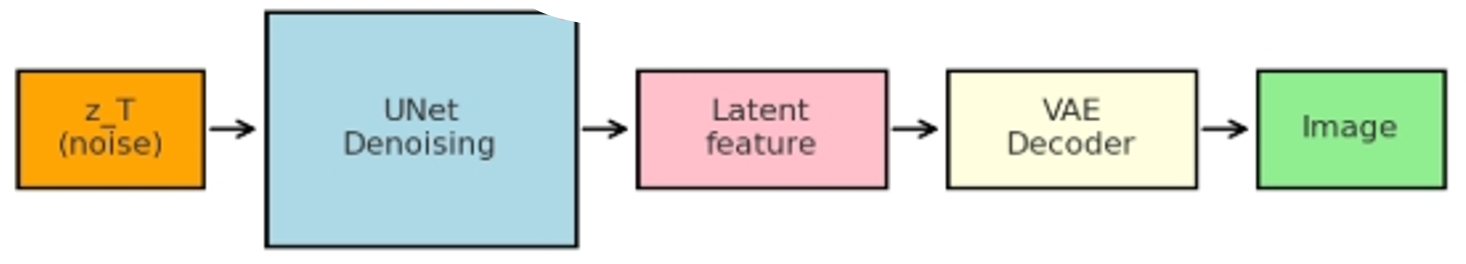

LDM 是 Diffusion Model 的一种变体,将扩散过程放在 潜在空间(latent space) 而非原始像素空间,从而大幅降低计算开销,同时保持生成图像质量。

训练过程:原始图像先通过 AutoEncoder 的 Encoder 映射到潜在向量空间,然后在潜在空间中进行逐步扩散/去噪训练,学习潜在向量的分布。有些训练会将重建的潜向量通过 Decoder 映射回图像空间,计算像素级重建损失,但核心训练是潜在空间去噪。

生成原理:生成图像时,先在潜在空间中选取随机噪声向量开始迭代去噪,得到潜在向量(和随机噪声的维度相同),再通过 Decoder 映射回像素空间得到最终图像。

特点:相比像素空间扩散,LDM 计算更高效,同时可以更容易地结合文本、图像等条件生成图像。

根据生成任务的类型,DM 提供两种不同的输入方式:

| 模式 | 输入 | 随机噪声 | 条件 | Encoder | Decoder |

|---|---|---|---|---|---|

| Text-to-Image | 文本 prompt | √ | 文本 | ✗ | √ |

| Image-to-Image | 参考图像 (+可选文本) | √(加在潜向量上) | 图像 / 文本 | √ | √ |