InfiniBand技术解析(2):为什么它是高性能计算的 “超级血管”?

目录

一、从场景痛点到技术定位:为什么需要InfiniBand?

二、InfiniBand的核心价值:破解传统网络的三大瓶颈

三、三大技术基石:支撑“超级血管”的核心能力

3.1 RDMA:“零拷贝、绕CPU”的通信革命

3.2 低延迟架构:从硬件到协议的全链路优化

3.3 高吞吐量设计:带宽与效率的双重突破

四、小结与展望:“超级血管”的现在与未来

当一块GPU能实现每秒万亿次计算时,千卡GPU集群却未必能发挥千倍性能——在AI大模型训练现场,常出现这样的场景:数千块顶级GPU整齐排列,却因数据无法及时同步,相当部分的算力在空转等待;在超算中心,气象模拟任务因节点间通信延迟过高,原本预计数天完成的计算被迫大幅延长。这些问题的核心,并非算力不足,而是连接算力的“血管”不够强大——传统网络无法支撑大规模计算集群的高效协同,而InfiniBand,正是为解决这一痛点而生的“超级血管”。

一、从场景痛点到技术定位:为什么需要InfiniBand?

在高性能计算与AI训练的核心场景中,“协同效率”决定了整体计算能力的上限。以千亿参数大模型训练为例,每一次迭代都需要数千块GPU交换海量的参数梯度数据:若数据同步延迟过高,GPU就会从“满负荷计算”切换为“空转等待”,算力利用率将显著下降;若同步过程占用过多CPU资源,原本用于模型计算的算力会被分流,训练周期将大幅延长。

传统TCP/IP以太网在这类场景中暴露出三大短板:其一,CPU开销过高——以太网的TCP协议栈处理、数据从内核态到用户态的拷贝,会占用大量算力,当集群规模扩大到千节点级,CPU资源会被通信任务严重挤占;其二,延迟与抖动不可控——以太网采用“尽力而为”的数据包传输模式,拥塞时会出现丢包重传,延迟会显著增加且波动较大,无法满足协同计算对延迟稳定性的要求;其三,吞吐量存在瓶颈——即使采用高速以太网,受限于协议开销与拥塞控制,实际可用吞吐量往往难以达到理论峰值,难以支撑千卡GPU集群的海量数据传输需求。

正是这些短板,催生了对“高性能互连技术”的需求,而InfiniBand的定位,就是数据中心的“超级血管”——它并非简单的“更快的以太网”,而是一套基于“通道式、交换式结构”的专用互连技术,通过硬件级优化,实现“低延迟、高吞吐量、低CPU开销”的端到端通信,为大规模计算集群打通高效协同的“血液循环”。

二、InfiniBand的核心价值:破解传统网络的三大瓶颈

InfiniBand对传统TCP/IP网络瓶颈的破解,并非局部优化,而是从架构层面的重构,其核心价值体现在三个维度,恰好对应传统网络的三大痛点。

对于“CPU开销过高”的问题,InfiniBand通过“协议全卸载”实现“CPU极低参与”——它将TCP/IP协议栈的处理流程,从CPU转移到专用硬件“主机通道适配器(HCA)”中。HCA内置独立的处理器与内存,能自主完成数据包封装、流量控制、错误校验等任务,CPU只需通过简单的API下发指令,后续所有通信流程均由HCA完成。这种设计,让网络通信对CPU的占用率大幅降低,释放CPU与GPU的计算资源,让算力专注于核心任务。

针对“延迟与抖动不可控”的短板,InfiniBand构建了“端到端无损通信架构”——从发送端HCA到交换机,再到接收端HCA,每一个环节都通过硬件机制确保数据传输的稳定性。不同于以太网依赖上层软件重传解决丢包,InfiniBand在链路层就通过“基于信用的流量控制”杜绝拥塞:接收端HCA会实时向发送端反馈缓冲区状态,发送端仅在获得足够信用值时才发送数据,从源头避免数据包丢失;同时,InfiniBand交换机采用“无阻塞交换架构”,每个端口都能以线速转发数据,不会因内部缓存不足导致延迟飙升。这种设计,让InfiniBand的端到端延迟稳定在微秒级别,为协同计算提供了“可预测的时间基准”。

面对“吞吐量瓶颈”的限制,InfiniBand通过“高带宽链路+高效协议”实现吞吐量突破。在物理层,InfiniBand的带宽演进速度领先:从EDR的100Gbps,到NDR的400Gbps,再到XDR的800Gbps,单链路带宽持续提升;同时,InfiniBand支持“链路聚合”技术,将多根物理链路捆绑为一条逻辑链路,实现更高带宽。在协议层,InfiniBand针对并行计算优化了数据传输模式,例如支持“多播”与“集合通信”,可一次性将数据发送到多个节点,避免重复传输——在AI训练的参数广播场景中,这种模式能显著提升数据传输效率,让千节点集群的吞吐量接近理论上限。

三、三大技术基石:支撑“超级血管”的核心能力

InfiniBand的高性能并非偶然,而是由三大技术基石共同支撑——RDMA、低延迟架构、高吞吐量设计,这三大基石相互协同,构成了“超级血管”的核心能力。

3.1 RDMA:“零拷贝、绕CPU”的通信革命

RDMA(远程直接内存访问)是InfiniBand性能的“灵魂”,其核心思想是“让数据直接在远程节点的内存间传输,绕开CPU与操作系统内核”。在传统TCP/IP通信中,数据需要经过多次拷贝,每一次拷贝都需CPU参与,延迟与开销显著;而在InfiniBand的RDMA模式下,数据传输路径被简化,仅需一次硬件级的数据搬运,全程无需CPU干预。

实现这一突破的关键,在于InfiniBand的内存管理机制:应用程序将需要远程访问的本地内存注册,HCA会为该区域分配访问密钥;当远程节点需要读取该内存时,只需向本地HCA发送携带密钥的RDMA读取指令,本地HCA验证有效性后,直接从指定内存区域读取数据,并通过网络发送到远程节点的应用内存中;整个过程中,本地与远程CPU都无需参与数据处理。

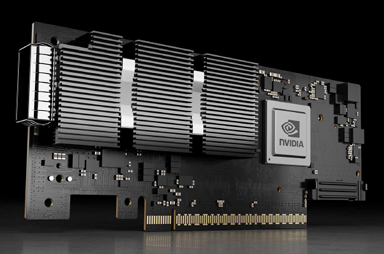

下图为NVDIA ConnectX-7 智能网卡 (HCA) ,它可提供超低延迟、400Gb/s 的吞吐量和创新的 NVIDIA 网络计算加速引擎,可以进一步加速应用。ConnectX-7 可为超级计算机、人工智能和超大规模云数据中心提供所需的可扩展性和功能丰富的技术。

NVDIA ConnectX-7 400G Adapters(HCA)

这种“零拷贝、绕CPU”的模式,不仅显著降低了数据传输延迟,更彻底消除了CPU的通信开销。在AI训练场景中,GPU可通过RDMA直接从远程GPU的内存中拉取参数梯度,无需CPU中转,数据同步延迟大幅降低,GPU算力利用率得到显著提升。

3.2 低延迟架构:从硬件到协议的全链路优化

InfiniBand的微秒级延迟,是硬件设计到协议栈的“全链路优化”结果。在硬件层面,InfiniBand HCA采用“用户态驱动”设计,避免了传统内核态驱动的上下文切换开销;同时,HCA内置高速缓存与专用数据通路,数据从内存到网络接口的传输路径被优化到最短。

在网络层面,InfiniBand交换机的“无阻塞设计”与“低延迟转发”是关键。传统以太网交换机常采用“共享缓存”架构,容易因流量不均导致延迟增加;而InfiniBand交换机为每个端口配置独立的缓存,且转发芯片采用“直通”转发模式——交换机在接收完数据包的头部后即可开始转发,这一设计将交换机的转发延迟降至极低水平。

NVIDIA Quantum-X800 InfiniBand交换机

在协议层面,InfiniBand简化了通信流程,摒弃了TCP协议中复杂的握手、窗口等机制,转而采用更高效的通信协议;同时,通过硬件中断异步通知机制,进一步减少了软件层面的延迟开销。这些全链路的优化,共同将InfiniBand的端到端延迟压缩至微秒级,成为支撑实时协同计算的关键。

3.3 高吞吐量设计:带宽与效率的双重突破

InfiniBand的高吞吐量,不仅体现在物理带宽的提升,更在于“带宽利用率”的优化——它通过“链路聚合、高效协议、硬件加速”的组合,让实际可用吞吐量接近理论上限。在物理带宽层面,InfiniBand的链路速率持续迭代,每一代的带宽都实现显著提升,且支持“多链路聚合”,满足千节点集群的海量数据传输需求。

在协议效率层面,InfiniBand针对并行计算场景优化了数据传输模式。例如,在“集合通信”场景中,传统以太网需要通过“点对点”的方式逐节点传输数据,效率较低;而InfiniBand支持“硬件级多播”技术,可一次性将数据发送到多个节点,大幅减少数据传输次数,显著提升传输效率。

此外,InfiniBand还通过“MPI硬件加速”进一步提升吞吐量。MPI是HPC与AI训练的主流通信协议,传统以太网需要通过软件实现MPI的复杂逻辑,开销较大;而InfiniBand HCA内置MPI加速引擎,可直接在硬件中完成MPI的核心操作,减少软件开销,提升通信效率。这种“硬件+协议”的双重优化,让InfiniBand在大规模集群中仍能保持很高的带宽利用率。

四、小结与展望:“超级血管”的现在与未来

作为高性能计算的“超级血管”,InfiniBand的核心价值在于:它通过RDMA、低延迟架构、高吞吐量设计的协同,解决了传统网络无法支撑大规模计算集群高效协同的痛点,让千卡GPU、万节点超算的“算力聚合”成为可能——在超算中心,它支撑着复杂科学计算任务的快速完成;在AI领域,它大幅缩短了大模型的训练周期;在金融等领域,它为对延迟敏感的应用提供高性能数据传输。

但InfiniBand的演进并未停止。未来,它将朝着“更低延迟、更高带宽、更优成本”的方向发展:在延迟层面,通过芯片工艺升级与协议简化,追求更低的端到端延迟;在带宽层面,更高速率的标准将逐步商用,支撑更大规模集群的数据传输需求;在成本层面,随着规模化应用与技术迭代,InfiniBand有望向更多对性能有高要求的场景渗透。