UNet改进(42):结合2D Sinusoidal Positional Encoding与Frequency Attention模型

一、为什么需要位置编码和频率注意力?

1.1 位置信息的重要性

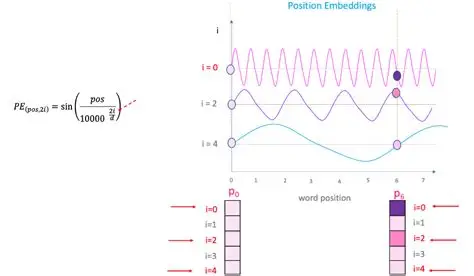

在自然语言处理中,Transformer 使用位置编码来为词序列注入顺序信息。类似地,图像中的像素也具有强烈的空间关系。传统CNN通过卷积核的局部感受野逐步捕获空间信息,但这种捕获是隐式的、局部的。显式地引入位置编码,可以帮助网络更好地理解像素的绝对或相对位置,尤其对于分割任务中物体的边界定位非常关键。

1.2 频率域视角的补充

图像可以视为不同频率信号的叠加:低频对应平滑区域,高频对应边缘和纹理。频率注意力机制通过对特征图进行通道级的权重调整,使网络能够自适应地强调或抑制不同频率成分,从而增强对关键特征的提取能力。

二、核心模块解析

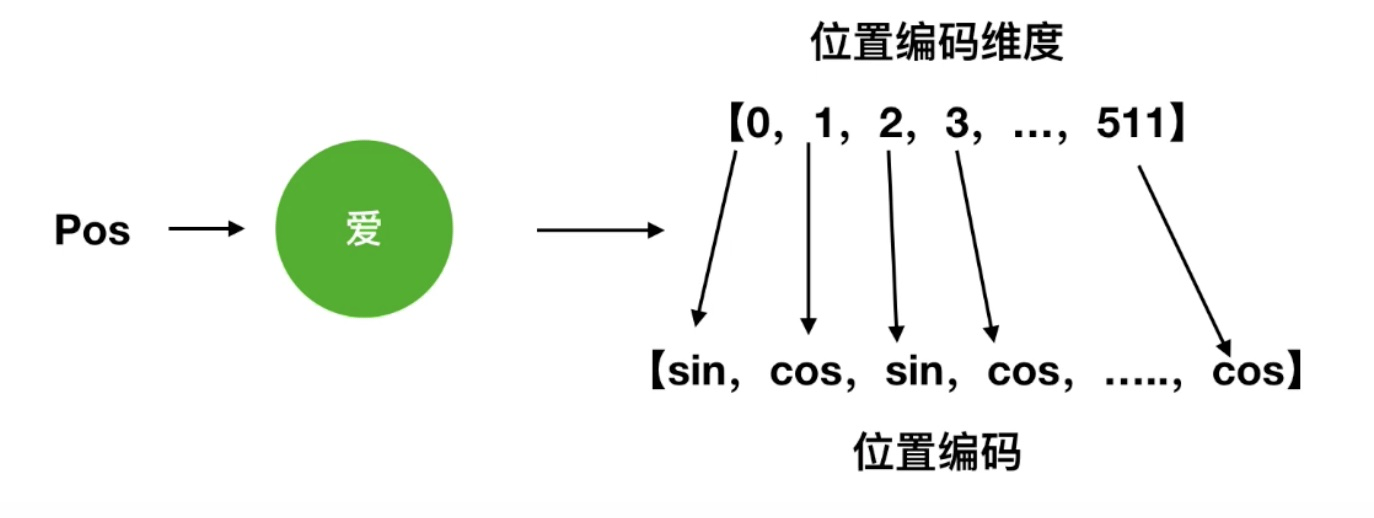

2.1 二维正弦位置编码(PositionalEncoding2D)

我们借鉴Transformer中的正弦编码方式,将其扩展至二维空间。每个位置 (h, w)