数据中心的技术困境与需求侧的演进压力

目录

一、数据中心的基础认知:数字世界的 “算力底座”

二、Scale - Up 与 Scale - Out:数据中心的两种架构范式

2.1 Scale - Up:单节点性能的 “极致堆砌”

2.2 Scale - Out:分布式集群的 “协同进化”

三、传统数据中心网络的设计逻辑:互联网时代的适配与局限

3.1 传统网络的设计核心:高吞吐量与弹性扩展的适配

3.2 新业务的算力爆发:从 “独立任务” 到 “协同计算” 的范式革命

四、Scale - Out 的代价:网络成为新的性能瓶颈

4.1 通信开销的指数级增长

4.2 存储与计算的 “跨节点割裂”

4.3 一致性与通信效率的矛盾

五、需求侧剧变:加剧网络瓶颈的刚性压力

5.1 云计算的 “资源池化” 需求

5.2 AI 训练的 “大规模协同” 需求

5.3分布式存储与高性能计算的 “低延迟” 诉求

六、结语:从 “网络瓶颈” 到 “架构革命” 的演进方向

一、数据中心的基础认知:数字世界的 “算力底座”

数据中心作为数字世界的“算力底座”,是支撑数字经济运行的核心基础设施,其本质是集中部署IT设备与配套设施的专用场所。它由IT资源层与物理设施层共同构成:前者包括服务器、存储和网络设备,承担数据的计算、存储与传输任务;后者则涵盖供电、制冷与安防等系统,确保IT设备持续稳定运行。数据中心的核心价值在于充当数字世界的算力枢纽——它不仅处理数据、运行各类应用程序,还持久化存储海量信息,并作为连接用户终端、云平台与企业分支的通信枢纽,让数字服务真正流动起来。

二、Scale - Up 与 Scale - Out:数据中心的两种架构范式

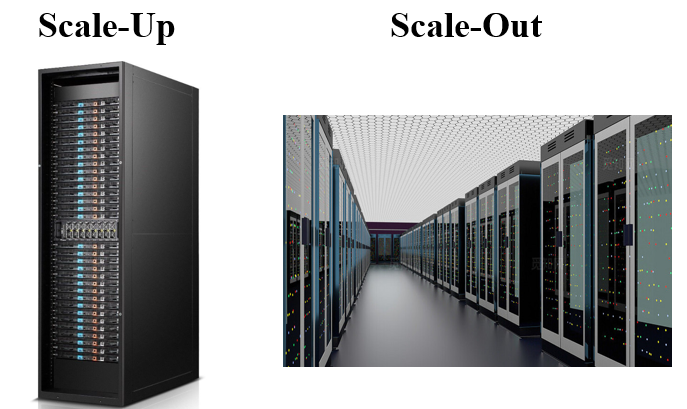

在数据中心演进过程中,Scale - Up(纵向扩展) 与 Scale - Out(横向扩展) 是两种截然不同的系统扩展思路,分别对应不同时代的业务需求:

| 维度 | Scale-Up(纵向扩展) | Scale-Out(横向扩展) |

| 核心思想 | 打造更强大的单一实体 | 组合众多普通实体形成分布式系统 |

| 关键技术 | 更快的CPU、更大的内存、更快的I/O总线 | 负载均衡、分布式软件、高速网络 |

| 优势 | 数据共享简单、延迟极低、一致性易保证 | 成本效益高、扩展灵活、容错性强 |

| 瓶颈 | 物理极限、成本高昂、存在单点故障 | 严重依赖网络性能、软件复杂度高、数据一致性挑战大 |

2.1 Scale - Up:单节点性能的 “极致堆砌”

Scale - Up 通过升级单个服务器的硬件配置提升系统能力,例如增加 CPU 核心数、扩展内存容量、堆叠 GPU 数量或更换高速存储介质(如从机械硬盘升级为 SSD)。其技术本质是 “集中式资源聚合”,将更多计算、存储能力封装在单一节点内,通过优化节点内部硬件互联(如 PCIe 5.0、NVLink)降低数据交互延迟。

Scale-Up架构通过提升单节点硬件配置实现性能突破,在金融交易、核心数据库等对延迟极度敏感的场景中曾占据主导地位。然而,其受限于物理上限、扩容需停机、成本非线性增长等固有缺陷,难以适应互联网时代的弹性需求。

2.2 Scale - Out:分布式集群的 “协同进化”

Scale - Out 通过添加全新服务器节点扩展系统能力,每个节点是独立的计算单元,通过网络连接形成集群,协同完成任务。其技术本质是“去中心化的负载分摊”:流量通过负载均衡器分发到多个节点,数据通过分片或复制分布在不同节点,实现 “多节点并行处理”。

Scale-Out架构通过添加标准化服务器节点形成分布式集群,完美契合了互联网业务的“爆发式增长”特性。其核心优势体现在三方面:弹性扩容能力可应对流量脉冲,数据分片技术破解了存储困局,多节点冗余确保了高可用性。正是这些特质使得Scale-Out成为过去二十年的主流选择,支撑了从电商平台到社交媒体的各类互联网服务。

三、传统数据中心网络的设计逻辑:互联网时代的适配与局限

Scale - Out 架构的胜利,离不开传统数据中心网络的支撑 —— 作为互联网时代的卓越产物,传统数据中心网络的设计逻辑与互联网业务特性高度适配,但也为新业务的爆发埋下了局限的种子。

3.1 传统网络的设计核心:高吞吐量与弹性扩展的适配

传统数据中心网络以 “高吞吐量” 与 “弹性扩展” 为核心设计目标,完美匹配互联网业务的 “无状态、易并行” 特性:

- 面向无状态 Web 请求:互联网服务的核心是处理海量独立的 Web 请求(如用户浏览网页、刷新信息流),这类请求无需节点间协同 —— 用户 A 的请求可由节点 1 处理,用户 B 的请求可由节点 2 处理,节点间几乎无需数据交互。网络只需通过 “链路聚合”“多路径转发” 等技术,将流量高效分发到不同节点,即可支撑亿级并发;

- “尽力而为” 的交付假设:传统网络的核心设计假设是 “网络只需尽力交付数据,较高的延迟与抖动可被上层软件掩盖”。例如,TCP 协议通过重传机制解决数据包丢失问题,应用层通过 “重试逻辑” 应对临时延迟 —— 用户浏览网页时,即使某一次数据包传输延迟 100 毫秒,也可通过重试或缓存机制避免明显感知,不会影响服务可用性。

这套体系的成功,本质是 “网络设计” 与 “业务特性” 的精准匹配:无状态业务对节点协同需求低,上层软件可容忍网络的不稳定性,使得传统网络能以较低成本支撑 Scale - Out 架构的弹性扩展。

3.2 新业务的算力爆发:从 “独立任务” 到 “协同计算” 的范式革命

随着人工智能(AI)、高性能计算(HPC)等新业务崛起,算力需求呈现 “爆炸式增长”—— 以大模型训练为例,千亿参数模型的算力需求是单块顶级 GPU 算力的 10 万倍以上,远超单卡算力遵循的摩尔定律(每 18 - 24 个月翻倍)。为填补这一算力鸿沟,分布式并行计算成为唯一可行路径,也彻底改变了计算的核心范式:

- 从 “处理海量独立任务” 转向 “协同解决单一复杂问题”:互联网时代的计算是 “并行处理独立任务”(如 1000 个节点分别处理 1000 个用户的请求),而新业务的计算是 “协同完成一个任务”(如 1000 块 GPU 共同训练一个大模型、100 个节点协同模拟一次气象变化);

- 协同需求倒逼网络性能升级:在 “协同计算” 范式下,节点间需实时同步海量数据(如 AI 训练中的参数梯度传输、HPC 中的中间计算结果交互),且对时序一致性要求极高 —— 若某节点的参数传输延迟 1 毫秒,可能导致整个集群的 GPU 等待,算力利用率从 90% 骤降至 50%。此时,传统网络 “高延迟、高抖动” 的短板被无限放大,“上层软件掩盖” 的假设彻底失效。

四、Scale - Out 的代价:网络成为新的性能瓶颈

Scale - Out 的胜利虽解决了 “弹性扩容” 与 “成本控制” 问题,却将性能压力从 “单节点内部” 转移到了 “节点之间的网络” 上。随着摩尔定律推动单服务器性能持续提升(如 CPU 核心数从 4 核增至 128 核、GPU 算力从 TFLOPS 级跃升至 PFLOPS 级),Scale - Out 系统的整体性能不再取决于单台服务器的速度,而是服务器之间网络的通信效率,传统网络架构的瓶颈被彻底放大:

4.1 通信开销的指数级增长

Scale - Out 集群中,节点间通信频率随节点数量呈 “指数级上升”—— 一个 1000 节点的集群,潜在通信连接数超过 50 万;而 AI 训练集群中,1024 块 GPU 的全互联通信量可达每秒 TB 级。此时,传统 TCP/IP 协议栈与 Socket 接口的 “软件开销” 成为致命短板:

CPU 需全程参与 TCP 连接管理、流量控制、差错恢复,同时完成 “用户态 - 内核态” 的数据拷贝,原本用于计算的资源被大量挤占;网络硬件本可支持微秒级传输,但协议栈的软件处理将延迟放大到毫秒级,例如跨节点数据传输延迟从硬件的 10 微秒增至软件处理后的 500 微秒,差距达 50 倍。

4.2 存储与计算的 “跨节点割裂”

Scale - Out 架构下,计算与存储常分离部署(如存算分离架构),计算节点访问远程存储数据需通过网络传输,“存储 IO 延迟” 与 “网络延迟” 深度绑定。例如某电商平台的订单数据库采用 Scale - Out 分片部署,跨区域节点访问数据时,网络延迟达 30 毫秒,直接导致用户下单响应时间变长,转化率下降 10%。

4.3 一致性与通信效率的矛盾

Scale - Out 的分布式特性需解决 “数据一致性” 问题(如 CAP 定理中的取舍),需通过共识协议(如 Paxos、Raft)实现多节点数据同步。但这些协议会增加网络通信次数 —— 例如 Raft 协议需经过 “领导者选举 - 日志复制 - 提交” 三步通信,进一步加剧网络负载,形成 “一致性开销” 与 “通信效率” 的恶性循环。

五、需求侧剧变:加剧网络瓶颈的刚性压力

随着云计算、AI、高性能计算等新型业务崛起,需求侧对数据中心的要求从 “弹性扩容” 升级为 “高效协同”,进一步放大了网络瓶颈的矛盾:

5.1 云计算的 “资源池化” 需求

云计算需将成百上千台服务器的计算、存储资源虚拟化为 “统一资源池”,为用户提供 “仿佛本地主机” 的体验。这要求不同节点的资源(如虚拟机内存、存储卷)能像 “单机内部部件” 一样快速调度,跨节点通信延迟需控制在微秒级 —— 否则用户使用云主机时,会感受到明显的卡顿,例如远程桌面操作延迟超过 50 毫秒,用户体验将大幅下降。

5.2 AI 训练的 “大规模协同” 需求

千亿参数大模型训练需数千块 GPU 协同工作,每一步计算都伴随海量参数的跨卡、跨服务器传输。若网络延迟高,GPU 会频繁 “等待数据”,算力利用率从 90% 暴跌至 30%;同时,CPU 被协议栈占用的资源会进一步分流 AI 计算资源,导致训练周期从 10 天延长至 30 天,研发效率大幅降低。

5.3分布式存储与高性能计算的 “低延迟” 诉求

分布式数据库、存算分离架构需存储节点与计算节点的 IO 延迟从毫秒级压至微秒级,否则会影响交易处理速度;高性能计算(如气象模拟、分子动力学)的多节点并行计算,依赖节点间 “无阻碍” 的高速通信,网络延迟每增加 1 微秒,整体计算效率会下降 2% - 3%。

六、结语:从 “网络瓶颈” 到 “架构革命” 的演进方向

Scale - Out 的胜利是互联网时代 “需求驱动技术” 的必然结果,但其带来的网络瓶颈,与新型业务 “低延迟、高协同” 的需求形成尖锐矛盾。这种矛盾并非局部优化可解决,而是需要从 “通信范式” 到 “资源架构” 的底层变革 —— 从早期的 DPDK、智能网卡 “硬件卸载” 减轻 CPU 负担,到 RDMA 技术实现 “内存直接交互” 绕开协议栈,再到 CXL 技术推动计算、存储、网络资源的 “一体化融合”,数据中心正朝着 “打破网络瓶颈、实现高效协同” 的方向演进,最终目标是让 Scale - Out 系统的网络效率,能匹配单节点的性能增长,释放分布式架构的全部潜力。