【征文计划】从掌心到像素:深度解析Rokid UXR 2.0的手势识别与自定义交互实战

目录

- 【征文计划】从掌心到像素:深度解析Rokid UXR 2.0的手势识别与自定义交互实战

- 一、引言:为何手势是空间计算的“终极语言”?

- 二、原理解析:Rokid手势识别的技术内核

- 三、源码与配置分析:如何让Unity“理解”手势?

- 四、进阶实战:自定义手势与骨骼数据驱动

- 五、掌控交互空间:自定义远近场规则

- 六、优化与避坑指南

- 七、总结与展望

【征文计划】从掌心到像素:深度解析Rokid UXR 2.0的手势识别与自定义交互实战

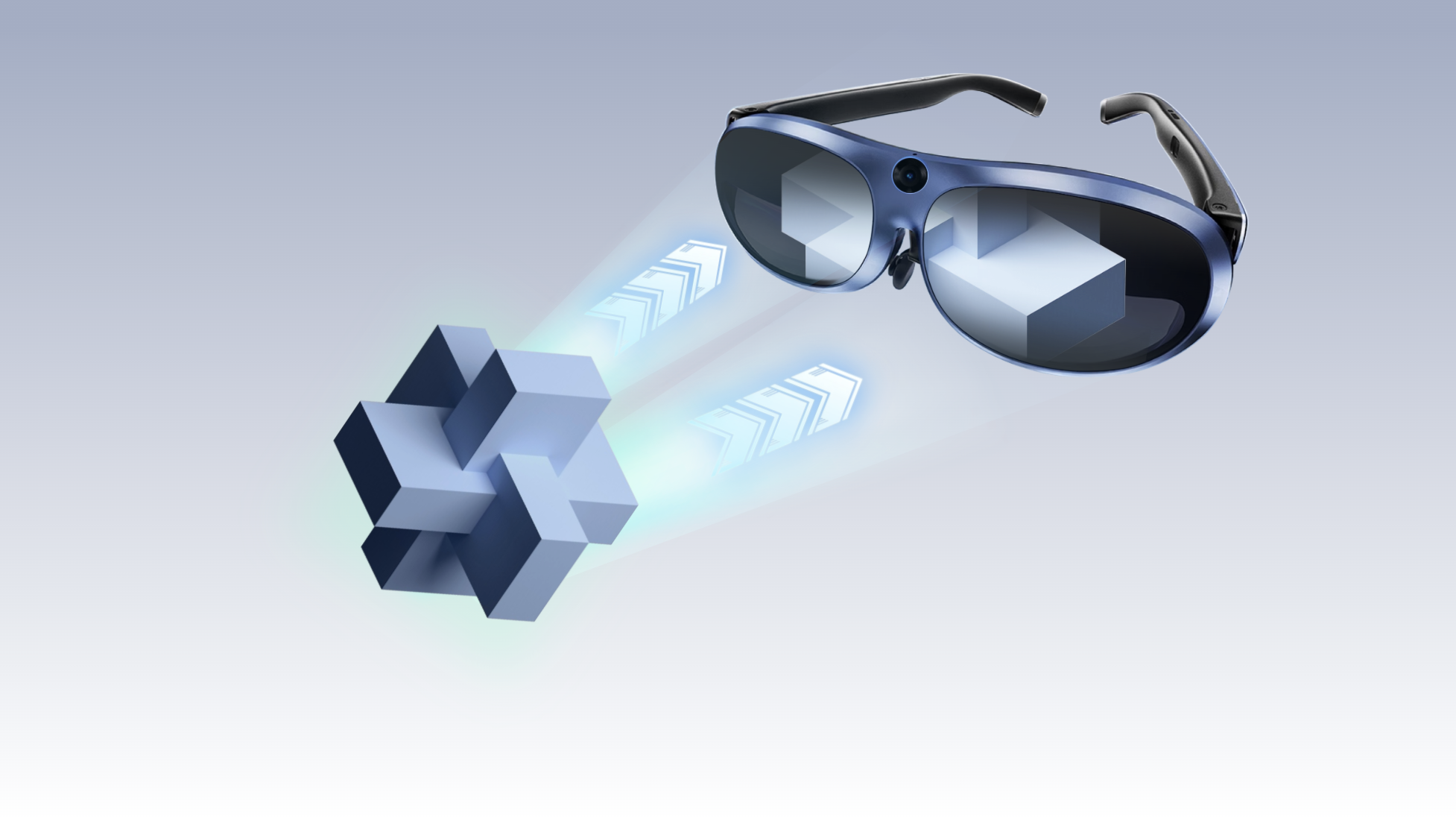

想象一下,在空气中轻轻一捏,就能抓取一个虚拟的立方体;张开手掌,菜单界面便如影随形。这不再是科幻电影的桥段,而是Rokid UXR 2.0 SDK为我们带来的现实。今天,就让我们一同潜入代码深处,不仅揭开其手势识别技术的神秘面纱,更要突破默认设定的边界,探索如何自定义专属手势与交互规则,真正释放空间计算的无限潜力。

一、引言:为何手势是空间计算的“终极语言”?

在AR/VR的世界里,传统的控制器或触摸屏打破了沉浸感。我们渴望的,是一种更自然、更直觉的交互方式——就像我们在现实中用手直接操控物体一样。手势识别,因此成为了空间计算中至关重要的“无声语言”。

Rokid UXR 2.0 SDK将手势识别作为其多模态交互体系的核心一环,它提供的不仅仅是一套预定义的手势库,更是一套从底层数据到高层交互的完整工具链。无论是使用开箱即用的基础手势,还是创造独一无二的交互逻辑,UXR 2.0都为我们铺平了道路。

二、原理解析:Rokid手势识别的技术内核

尽管官方文档未透露底层算法的全部细节,但我们可以根据其架构和API设计,勾勒出技术实现的轮廓。

- 核心工作流程

一个完整的手势识别流程,可以抽象为以下 pipeline:

[眼镜端双摄图像输入] -> [图像预处理与增强] -> [手部检测与21+关键点定位] -> [手势分类与姿态估计] -> [Unity引擎中的交互事件派发]

图像输入:依赖于Rokid Max Pro眼镜集成的双目摄像头,提供立体视觉数据,这对于估算手部的深度信息至关重要。

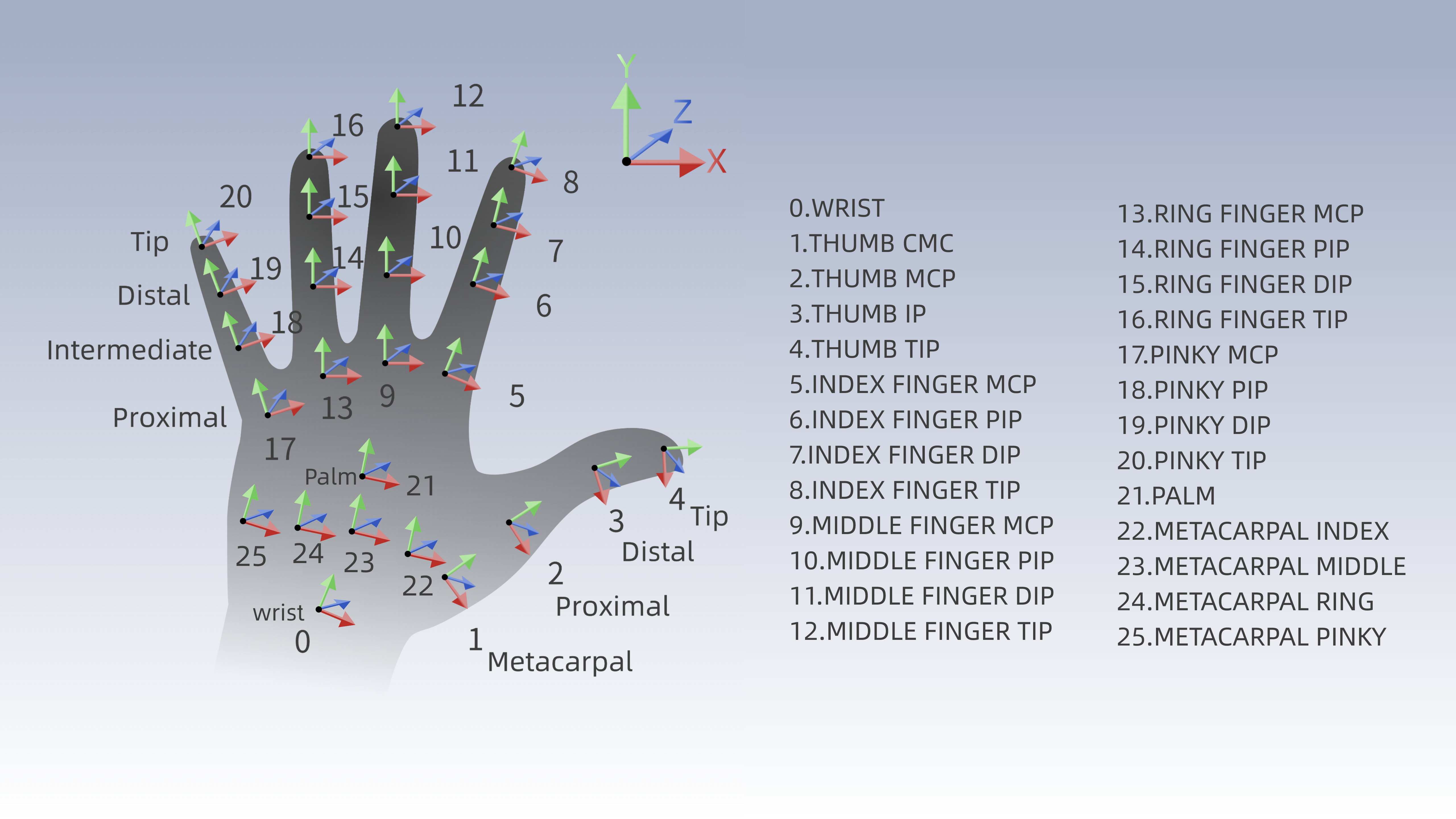

手部检测与关键点:这是技术的核心。系统需要首先在图像中定位手部区域,进而识别出21个骨骼关节点(如INDEX_FINGER_TIP、WRIST、PALM等)。

手势分类:基于关节点形成的空间向量、角度和形状,通过一个预先训练好的机器学习模型来判断当前的手势状态(如握拳、张开、捏合等)。

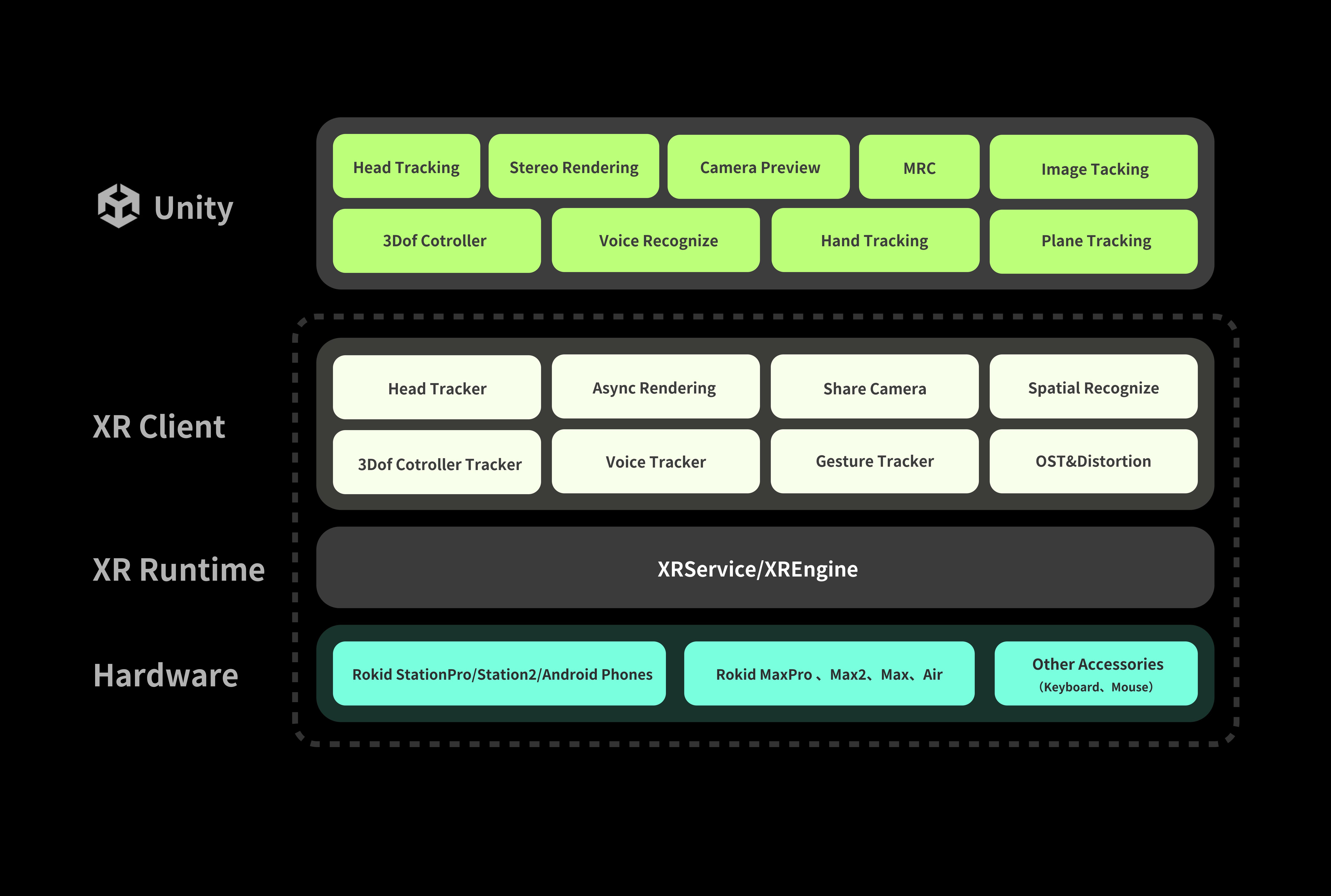

- UXR SDK的抽象层:

RKInput与InputModuleManager

Rokid的精妙之处在于,它将复杂的底层感知技术封装成了一个对Unity开发者极其友好的抽象层。这个抽象层的核心就是 RKInput预制体和其上的 InputModuleManager脚本。

InputModuleManager 像一个交互模式的总调度中心。在其 DefaultInitModule 列表中,我们可以勾选希望启用的交互方式。对于手势识别,我们必须确保 Gesture 模块被启用。

设计思想:这种模块化设计意味着手势、射线、TouchPad等交互模式并非割裂的,而是可以动态切换、互为补充的。系统会根据用户的行为(如摊开手掌面向摄像头)智能地切换到最合适的交互模式。

三、源码与配置分析:如何让Unity“理解”手势?

让我们深入到项目配置和代码层面,看看如何搭建起手势交互的桥梁。

- 环境搭建与SDK导入

手势识别的基石是正确的开发环境。这包括:

Unity环境:2021/2022 LTS版本,并安装Android Build Support。

SDK导入:通过Unity Package Manager (UPM),从Rokid的NPM仓库 (https://npm.rokid.com) 添加 com.rokid.xr.unity 包。

关键配置:在 Plugins/Android/ 下的Gradle配置文件中,必须确保引入了核心依赖 com.rokid.uxrplugin:rkuxrplugin:2.5.3。

这些步骤确保了Unity项目能够调用Rokid设备底层的SLAM、手势识别等原生能力。

- 交互配置的两种场景

UXR SDK为UI和3D物体提供了不同的交互路径。

场景一:与UI交互(以PointableUI为例)

这是最简单快捷的方式。你不需要理解底层事件,SDK已经为你封装好了。

- 拖入预制体:将

PointableUI预制体拖入场景。 - 创建UI元素:在

PointableUI的Canvas下创建一个Button或Image。 - 编写响应逻辑:直接使用UGUI自带的事件接口,例如:

using UnityEngine;

using UnityEngine.EventSystems;

using UnityEngine.UI;public class GestureUIHandler : MonoBehaviour, IPointerEnterHandler, IPointerClickHandler

{private Image image;void Start(){image = GetComponent<Image>();}// 当手势射线悬停时触发public void OnPointerEnter(PointerEventData eventData){image.color = Color.cyan; // 改变颜色给予反馈}// 当做出“点击”手势时触发public void OnPointerClick(PointerEventData eventData){image.color = Color.green;Debug.Log("手势点击了UI!");}

}

场景二:与3D物体交互(以Cube为例)

与3D物体的交互需要更多组件,但提供了更细粒度的控制。

-

创建Cube并调整其位置和大小。

-

挂载核心组件:

RayInteractable:标记该物体可被射线交互。

ColliderSurface&Box Collider:提供物理碰撞区域,让手势射线有“物”可撞。

InteractableUnityEventWrapper:核心事件中转站,将SDK的交互事件转换为Unity熟悉的UnityEvent。 -

编写事件监听脚本:通过代码监听

InteractableUnityEventWrapper的事件。

using Rokid.UXR.Interaction;

using UnityEngine;public class GestureCubeController : MonoBehaviour

{private MeshRenderer meshRenderer;private InteractableUnityEventWrapper eventWrapper;void Start(){meshRenderer = GetComponent<MeshRenderer>();eventWrapper = GetComponent<InteractableUnityEventWrapper>();// 监听选择事件(通常是手势“按下”)eventWrapper.WhenSelect.AddListener(OnCubeSelected);// 监听取消选择事件(手势“释放”)eventWrapper.WhenUnselect.AddListener(OnCubeUnselected);}private void OnCubeSelected(){meshRenderer.material.color = Color.red;Debug.Log("抓住了立方体!");}private void OnCubeUnselected(){meshRenderer.material.color = Color.white;Debug.Log("释放了立方体。");}

}

四、进阶实战:自定义手势与骨骼数据驱动

这才是真正展现开发者创造力的舞台。UXR 2.0 SDK 提供了 GesEventInput 这个强大的入口,让我们能够获取原始手势类型、掌心朝向,甚至是21个骨骼点的精确位姿数据。

- 获取预定义手势状态

你可以轻松查询到手部的宏观状态,这是实现条件分支逻辑的基础。

using Rokid.UXR.Module;

using UnityEngine;public class BasicGestureReader : MonoBehaviour

{void Update(){// 获取右手当前手势GestureType rightHandGesture = GesEventInput.Instance.GetGestureType(HandType.RightHand);// 获取右手掌心朝向(面向自己还是远离自己)HandOrientation rightPalmOrientation = GesEventInput.Instance.GetHandOrientation(HandType.RightHand);if (rightHandGesture == GestureType.Pinch && rightPalmOrientation == HandOrientation.Palm){// 当右手做出“捏合”手势且掌心面向自己时,触发特殊逻辑Debug.Log("特殊手势触发!");}}

}

- 深度自定义:基于骨骼点数据创造全新手势

预定义的四种手势(OpenPinch, Pinch, Palm, Grip)远非极限。通过 GetSkeletonPose API,我们可以计算手指的角度、方向、距离,来定义任何你能想象到的手势。

案例:创建一个“胜利(V)”手势检测器

“胜利”手势的特点是食指和中指伸直并分开,其余手指弯曲。我们可以通过计算指尖与手掌的方向向量的点积来判断。

using Rokid.UXR.Module;

using UnityEngine;public class VictoryGestureDetector : MonoBehaviour

{public HandType handToDetect = HandType.RightHand;void Update(){if (IsVictoryGesture(handToDetect)){Debug.Log($"检测到{handToDetect}的胜利手势!");// 触发你的自定义事件,比如播放一个庆祝动画、切换武器等}}private bool IsVictoryGesture(HandType hand){// 1. 获取关键骨骼点的位置和方向Vector3 indexTip = GetBonePosition(SkeletonIndexFlag.INDEX_FINGER_TIP, hand);Vector3 middleTip = GetBonePosition(SkeletonIndexFlag.MIDDLE_FINGER_TIP, hand);Vector3 ringTip = GetBonePosition(SkeletonIndexFlag.RING_FINGER_TIP, hand);Vector3 pinkyTip = GetBonePosition(SkeletonIndexFlag.PINKY_TIP, hand);Vector3 palm = GetBonePosition(SkeletonIndexFlag.PALM, hand);// 2. 计算从掌心到各指尖的方向向量Vector3 indexDir = (indexTip - palm).normalized;Vector3 middleDir = (middleTip - palm).normalized;Vector3 ringDir = (ringTip - palm).normalized;Vector3 pinkyDir = (pinkyTip - palm).normalized;Vector3 handForward = (GetBonePosition(SkeletonIndexFlag.MIDDLE_FINGER_MCP, hand) - GetBonePosition(SkeletonIndexFlag.WRIST, hand)).normalized;// 3. 逻辑判断:食指和中指应基本伸直(方向与手背方向大致相反),无名指和小指应弯曲(方向与手背方向大致相同)float dotIndex = Vector3.Dot(indexDir, handForward);float dotMiddle = Vector3.Dot(middleDir, handForward);float dotRing = Vector3.Dot(ringDir, handForward);float dotPinky = Vector3.Dot(pinkyDir, handForward);// 4. 设定阈值进行判断if (dotIndex < -0.3f && dotMiddle < -0.3f && dotRing > 0.2f && dotPinky > 0.2f){return true;}return false;}private Vector3 GetBonePosition(SkeletonIndexFlag boneIndex, HandType hand){return GesEventInput.Instance.GetSkeletonPose(boneIndex, hand).position;}

}

这段代码展示了如何利用底层骨骼数据,通过向量运算,创造出SDK原本不支持的“胜利”手势。你可以依此类推,定义“OK”、“摇滚”甚至更复杂的手势。

五、掌控交互空间:自定义远近场规则

UXR 2.0 SDK默认提供了自适应的远近场切换(例如,手远离时是射线,靠近物体时自动切换为直接交互)。但在某些特定应用场景(如始终需要射线操作的射击游戏),你可能需要手动控制。

方案:禁用自适应,强制使用远场射线交互

-

找到并修改

RKHand预制体:

将Roikd Unity XR SDK/Runtime/Resources/Prefabs/Interactor/中的RKHand预制体复制到Assets/Resources/Prefabs/Interactor/下(Resources文件夹需自行创建)。

打开这个副本,找到其子物体LeftHandInteractors和RightHandInteractors。

移除它们身上的InteractorStateChange脚本。这个脚本正是负责自动远近场切换的逻辑核心。 -

激活远场交互器:

在LeftHandInteractors和RightHandInteractors下,确保RayInteractor(远场射线交互器)处于启用状态,而PokeInteractor(近场直接交互器)可以被禁用。

现在,你的应用将始终使用射线进行交互,不再自动切换。

动态切换控制:如果你只是想在某些剧情或模式下临时禁用自动切换,你可以通过代码获取 InteractorStateChange 组件,并调用其 OnPokeInteractorUnHover(强制远场)和 OnPokeInteractorHover(强制近场)方法来实现运行时控制。

六、优化与避坑指南

- 性能考量:手势识别是计算密集型任务。在真机上,需注意控制同一帧内处理的交互物体数量,避免过高的Draw Call。频繁计算所有骨骼点的复杂自定义手势也会增加CPU负担,建议优化算法或降低检测频率。

- 用户体验:

提供即时反馈:当手势射线悬停在可交互物体上时,改变其颜色或大小。

手势的容错性:自定义手势的阈值需要反复测试调整,以适应不同用户的手型和使用环境。 - 常见问题:

手势无法切换/无响应:检查RKInput上的InputModuleManager是否勾选了Gesture;确认3D物体已正确挂载所有必要组件。

自定义手势不触发:使用Debug.DrawLine等Gizmo绘制功能,可视化骨骼点和向量,辅助调试你的手势判断逻辑。

七、总结与展望

通过本次深度解析,我们看到Rokid UXR 2.0 SDK通过高度封装的 RKInput 系统和清晰的事件机制,极大地降低了手势识别技术的应用门槛。而 GesEventInput API和 RKHand 预制体的可定制性,则为我们打开了一扇通往无限创意交互的大门。

未来,当手势识别技术与“大模型”结合,我们可以想象更强大的场景:通过自然语言描述一个手势(如“给我做一个施法的手势”),大模型便能自动生成对应的骨骼点判断代码。Rokid已经为我们搭好了坚实而灵活的舞台,剩下的,就等待各位开发者用代码和创意,去上演更多精彩的空间交互盛宴。