【论文精读】Group Collaborative Learning for Co-Salient Object Detection

论文标题:Group Collaborative Learning for Co-Salient Object Detection

作者:Qi Fan, Deng-Ping Fan, Huazhu Fu, Chi Keung Tang, Ling Shao, Yu-Wing Tai

发表会议:CVPR 2021

论文链接:https://arxiv.org/abs/2104.01108

代码地址:https://github.com/fanq15/GCoNet

一、研究背景与动机:从“单图显著性”到“共显著性”的跨越

在计算机视觉领域,显著性目标检测(Salient Object Detection, SOD) 是一项基础任务,其目标是自动识别图像中最吸引人注意的物体。然而,现实世界中的许多应用需求并不仅限于单张图像的分析。例如,在一个包含多张图片的相册中,我们希望自动找出所有图片中“共同出现”的显著物体——如一群朋友合影中的每个人、旅行相册里的地标建筑,或产品图集中同一型号的手机。

为此,共显著性目标检测(Co-Salient Object Detection, CoSOD) 应运而生。它旨在从一组相关的图像中检测出共享的显著物体。与传统SOD相比,CoSOD不仅要识别显著性,更要挖掘图像组之间的一致性(consistency),即哪些物体是“共现”的,哪些是“独有”的。

尽管已有不少方法尝试通过跨图像线索(inter-image cues)或语义关联来提升CoSOD性能,但大多数现有模型仍存在一个根本性局限:它们仅在单个图像组内部进行学习。这种“孤立学习”方式带来了三大问题:

- 缺乏负样本关系:仅使用正样本(同一组内相似前景)训练,容易导致模型过拟合,对异常图像(outliers)鲁棒性差。

- 数据信息不足:每个图像组通常只有20~40张图,难以支撑一个判别性强的表示学习。

- 高层语义缺失:单独的组内学习难以捕捉区分噪声物体所需的高层语义信息。

为解决上述问题,本文提出了一种全新的组协同学习框架(Group Collaborative Learning Network, GCoNet),首次在组间(inter-group) 层面引入协同学习机制,同时优化组内紧凑性(intra-group compactness) 与组间可分性(inter-group separability),从而实现更鲁棒、更精准的共显著性检测。

二、核心思想:组协同学习的双重机制

GCoNet的核心思想是:不仅要让同一组内的共显著物体特征尽可能接近(紧凑),还要让不同组之间的特征尽可能分离(可分)。这一思想源于经典的模式识别准则——类内紧凑、类间分离。

为了实现这一目标,GCoNet设计了三个关键模块:

- 组亲和模块(Group Affinity Module, GAM):负责组内协同学习,提取组内共识特征。

- 组协作模块(Group Collaborating Module, GCM):负责组间协同学习,增强不同组之间的区分能力。

- 辅助分类模块(Auxiliary Classification Module, ACM):引入高层语义监督,提升特征表示能力。

这三大模块协同工作,共同构建了一个高效、实时的共显著性检测框架。

三、方法详解:GCoNet架构与核心模块

3.1 整体架构:双组协同训练流程

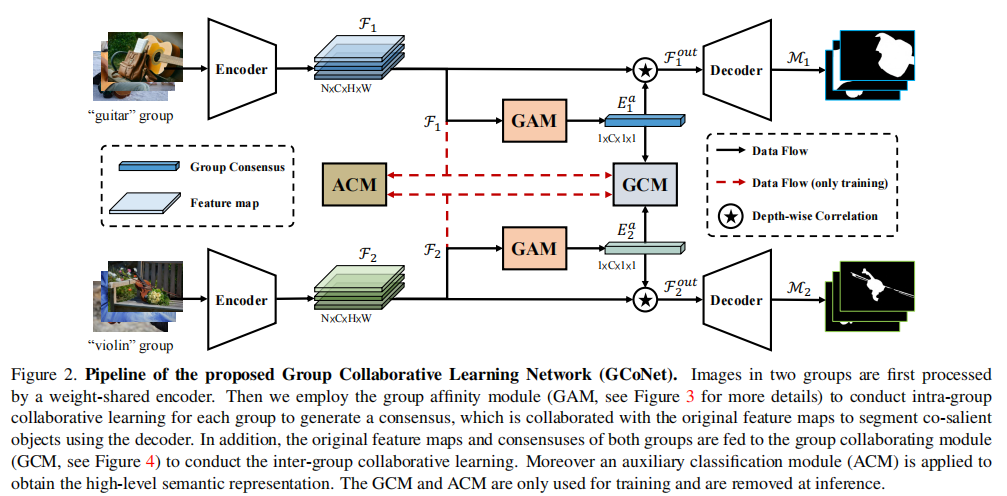

图示:两个图像组(“吉他”和“小提琴”)分别通过共享编码器提取特征。GAM生成组内共识,GCM实现组间协作,ACM提供分类监督。GCM和ACM仅在训练时使用,推理时可移除,无额外计算开销。

GCoNet的整体流程如下:

- 输入:两个图像组(例如,“吉他”组和“小提琴”组),每组包含N张图像。

- 特征提取:使用共享权重的编码器(如VGG-16 + FPN)提取两组图像的特征图

。

。 - 组内共识生成:通过组亲和模块(GAM),将每组内的所有图像特征聚合为一个共识特征(consensus)

,代表该组共显著物体的共享属性。

,代表该组共显著物体的共享属性。 - 组间协作学习:将两组的原始特征和共识特征输入组协作模块(GCM),进行组间交互学习。

- 高层语义增强:通过辅助分类模块(ACM),对每张图像进行分类监督,提升特征的判别性。

- 解码输出:将融合后的特征送入解码器,生成最终的共显著性图

。

。

3.2 组亲和模块(GAM):挖掘组内一致性

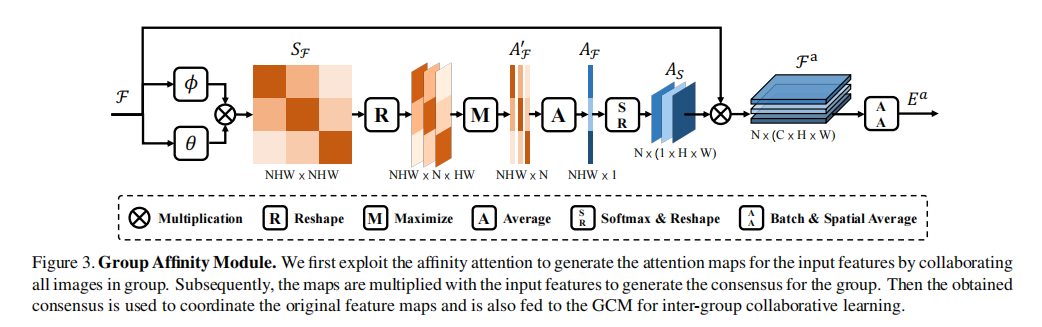

GAM的目标是从组内所有图像中提炼出共显著物体的共享特征。其核心思想是计算图像间的全局亲和度(global affinity)。

图示:通过深度相关(depth-wise correlation)和全局亲和计算,生成注意力图,最终聚合为组共识。

具体步骤如下:

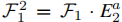

像素级相关性计算:对组内任意两张图像的特征

,通过线性嵌入函数

,通过线性嵌入函数 计算其像素级相关性:

计算其像素级相关性:

亲和图构建:将所有图像对的相关性拼接,形成亲和图

。

。像素级全局亲和图构建:对每张图像的每个像素,从

中取其在其他所有图像中的最大相关值得到

中取其在其他所有图像中的最大相关值得到 ,求平均值得到全局亲和图

,求平均值得到全局亲和图 。

。注意力图生成:

经Softmax归一化,然后reshape得到亲和注意力图

经Softmax归一化,然后reshape得到亲和注意力图  。

。共识特征提取:将注意力图与原始特征相乘,得到加权特征图

,再通过在批次维度和空间维度上的平均池化生成最终的共识特征

,再通过在批次维度和空间维度上的平均池化生成最终的共识特征

。

。损失函数(采用Soft IoU Loss):共识特征提取后结合原始特征图,通过解码器获得每张图片的共显著图

, 使用真实标注

, 使用真实标注 进行监督:

进行监督:

GAM的优势在于其全局视角:它不仅关注局部图像对的相似性,还通过全局优化避免了偶然共现物体的干扰,从而更准确地定位共显著区域。

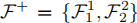

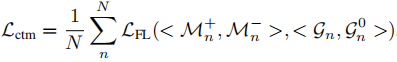

3.3 组协作模块(GCM):增强组间可分性

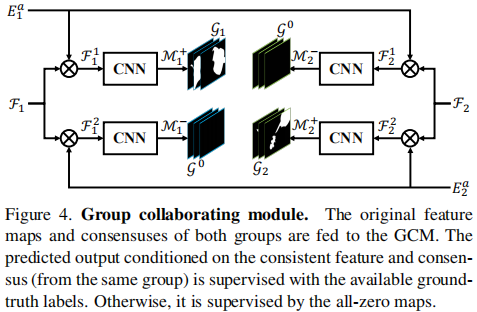

GCM是本文最具创新性的模块,旨在显式地学习不同图像组之间的差异,从而提升模型对噪声和干扰物体的鲁棒性。

图示:通过组内与组外特征的交叉乘法,生成预测图。组内预测用真实标签监督,组间预测用零图监督,强制模型学习组间差异。

其工作原理如下:

1. 组内与组外交互:

组内乘法:

,

,

组外乘法:

,

,

2. 监督信号设计:

对组内表示

,使用真实标注

,使用真实标注 进行监督。

进行监督。对组间表示

,使用全零图

,使用全零图 进行监督。

进行监督。

3. 损失函数采用Focal Loss:

GCM的巧妙之处在于:它迫使模型认识到“用吉他组的共识去激活小提琴组的特征是错误的”,从而增强了共识特征的判别能力。

3.4 辅助分类模块(ACM):引入高层语义

为了进一步提升特征的语义判别性,GCoNet引入了一个辅助分类模块(ACM)。

- 在骨干网络后添加一个全局平均池化层和全连接层,对每张图像进行分类。

- 使用交叉熵损失

进行监督。

进行监督。 - 该模块不增加推理开销(仅在训练时使用),却能有效提升特征的聚类性和可分性。

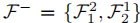

3.5 端到端训练与损失函数

GCoNet采用端到端联合训练,总损失函数为:

![]()

其中:

:显著性损失(Soft IoU Loss)

:显著性损失(Soft IoU Loss) :组协作损失(Focal Loss)

:组协作损失(Focal Loss) :分类损失(Cross-Entropy)

:分类损失(Cross-Entropy)

四、实验分析:全面验证GCoNet的有效性

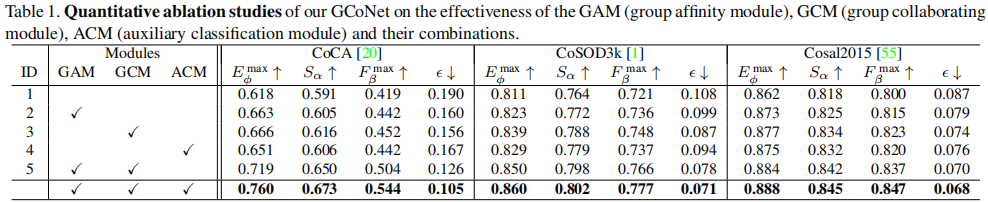

4.1 消融实验:各模块贡献分析

作者在CoCA、CoSOD3k和Cosal2015三个数据集上进行了详细的消融实验。

结果表明:

- GAM 显著提升组内一致性。

- GCM 大幅增强组间可分性,尤其在复杂场景(如CoCA)上效果显著。

- ACM 能提供“零成本”的性能提升。

GAM模块的有效性

GAM模块是本文模型的核心组件,其设计旨在捕捉图像组内共同显著对象的共性特征,从而提升组内紧凑性。相较于仅通过平均池化操作提取基础共识的基准模型,GAM在所有指标和数据集上均取得性能提升。为深入理解GAM模块的工作原理,文中展示了该模块学习到的注意力掩码可视化结果。

图示:通过组内协同学习,在每组所有图像上由GAM学习得到的亲和注意力图的可视化结果。这些注意力图对具有共享属性的共显著区域非常敏感,有助于共识表示的学习。

结果表明:文中提出的全局协同注意力能有效减轻共现噪声的影响,并聚焦于图像组内的共显著区域。例如,在猴子组和自行车组中,部分图像里都存在一些同时出现的人物,但GAM模块并未受到不利影响。GAM的全局视角使其能够检测到最普遍存在的共同物体,而局部的成对协同注意力则无法在局部视野中将它们区分开来。

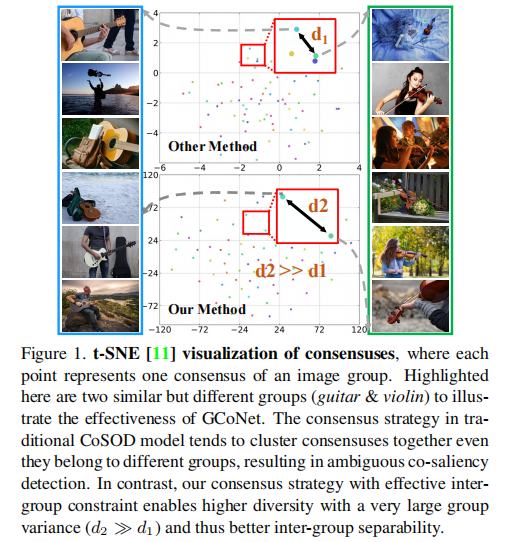

4.2 t-SNE可视化:直观展示组间可分性

文中通过t-SNE将共识特征可视化,清晰地展示了GCM的效果。

左侧(传统方法):不同组的共识特征混杂在一起,难以区分。

右侧(GCoNet):不同组的共识特征被有效分离,组间方差 d2≫d1,可分性更强。

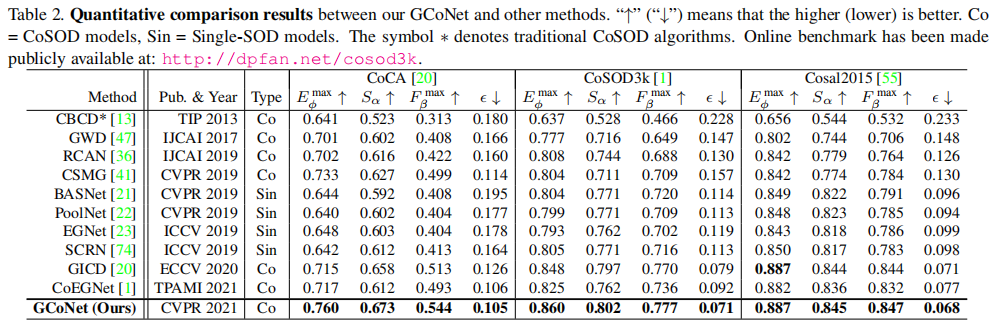

4.3 与SOTA方法对比:全面超越

GCoNet在三个基准数据集上全面超越了10个前沿模型,包括传统方法(CBCD*)、深度CoSOD模型(GICD、CoEGNet等)和单图SOD模型(BASNet、PoolNet等)。

在最具挑战性的CoCA数据集上,GCoNet的 达到0.760,远超第二名的0.717,证明其在复杂多物体场景下的强大鲁棒性。

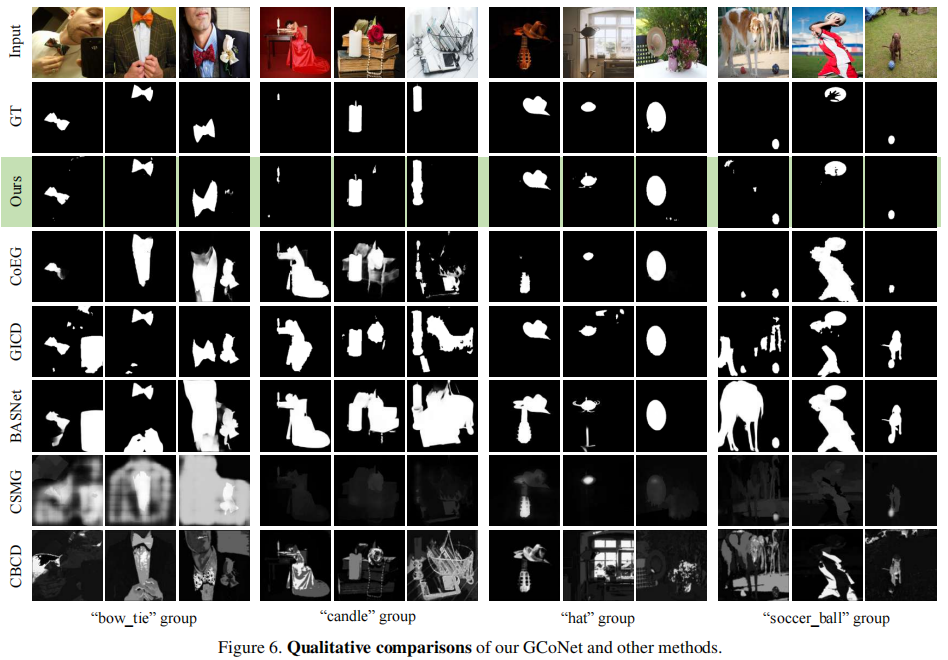

4.4 定性结果:视觉对比

文中通过可视化直观的展示了不同方法在复杂场景下的检测结果。

从左到右:输入图、真实标注、GCoNet、CoEGNet、GICD、BASNet、CSMG、CBCD。

GCoNet能准确分割出共显著物体(如领结、蜡烛、帽子、足球),而其他方法易受背景或其他显著物体干扰。

五、总结与启示

5.1 主要贡献回顾

- 提出组协同学习框架(GCoNet):首次在CoSOD中引入组间协同学习,同时优化组内紧凑性与组间可分性。

- 设计GAM与GCM模块:GAM通过全局亲和度提取共识,GCM通过组间交叉监督增强判别性。

- 引入辅助分类模块(ACM):低成本提升特征语义表示能力。

- 实现SOTA性能:在三个基准上全面超越现有方法,且推理速度达16ms/组,满足实时需求。

5.2 启示与展望

GCoNet的成功表明,跨组信息的利用是提升CoSOD性能的关键。未来工作可进一步探索:

- 更复杂的组间关系建模(如图神经网络)。

- 自监督或弱监督学习,减少对标注数据的依赖。

- 将该框架扩展到视频共显著性检测或跨模态共显著性任务。

GCoNet不仅为CoSOD领域树立了新的标杆,其“组协同学习”的思想也为多图像协同理解任务提供了新的研究范式。