强化学习原理(三)

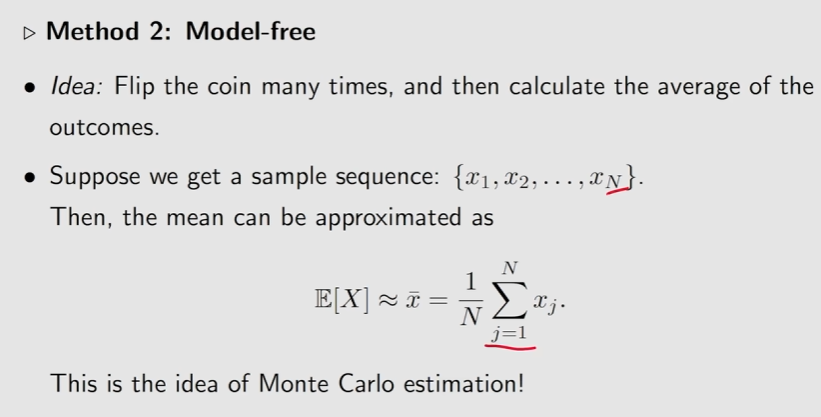

一、蒙特卡洛方法

1、Motivation example

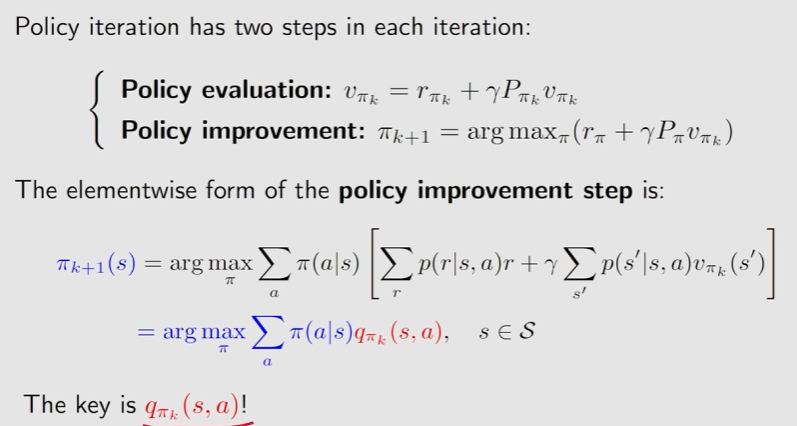

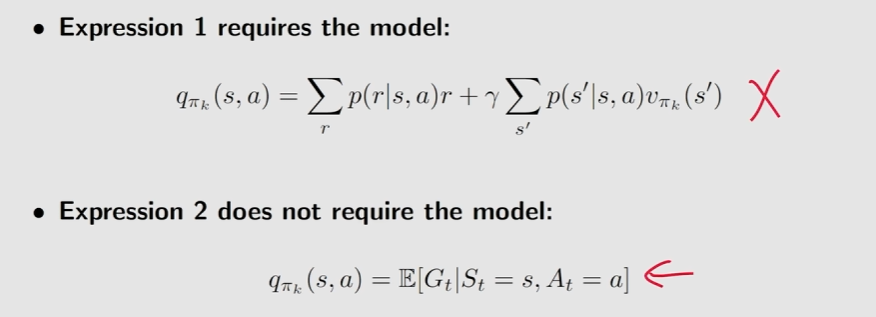

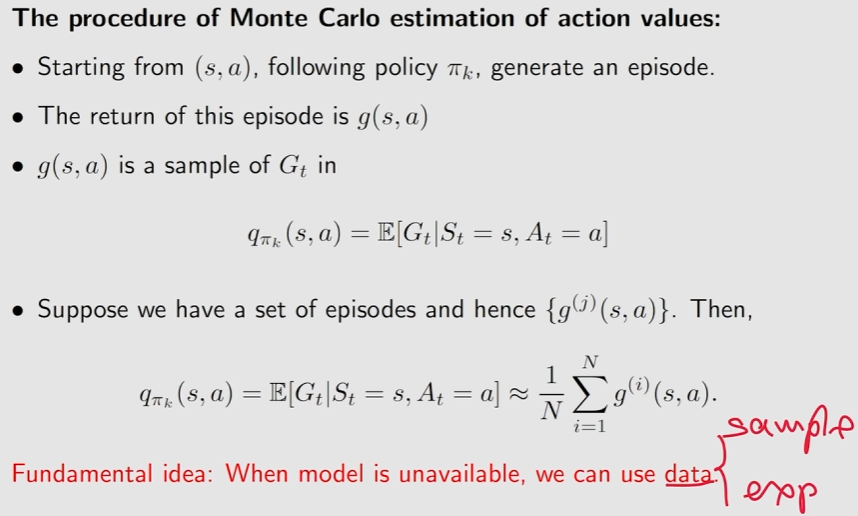

2、The simplest MC-based RL algorithm

将policy iteration算法转换为model-free

在没有模型的时候就依赖于数据,强化学习中称为experience

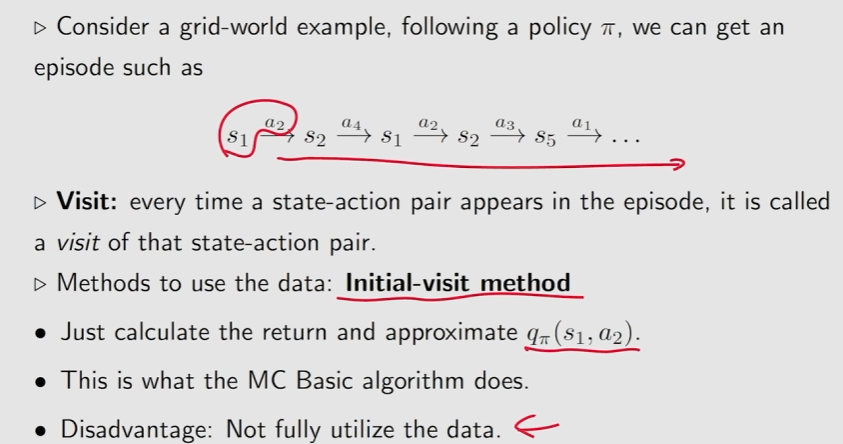

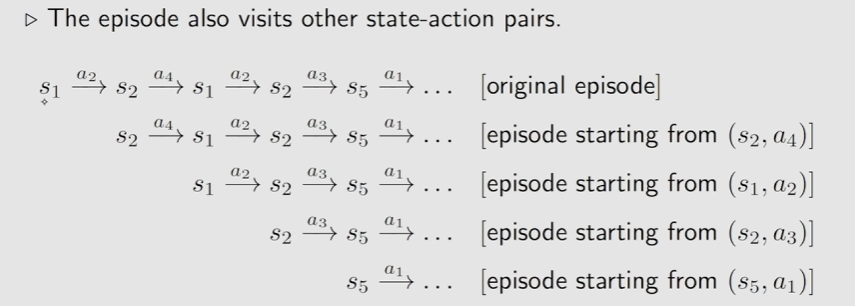

3、Use data more efficiently(MC Exploring Starts)

使用除开始时的(s,a)后面所得到的return来估计最初(s,a)的action value

使用除开始时的(s,a)后面所得到的return来估计最初(s,a)的action value

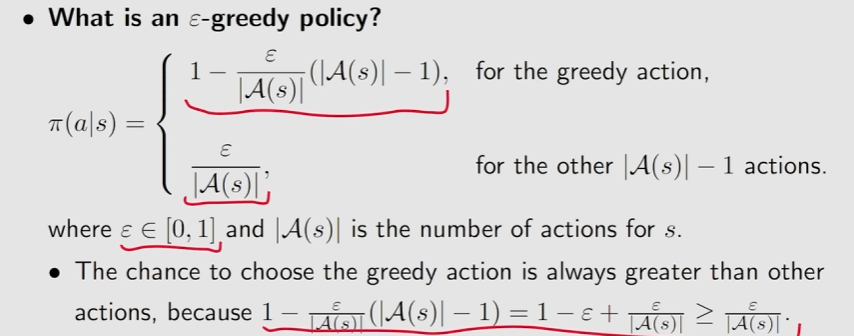

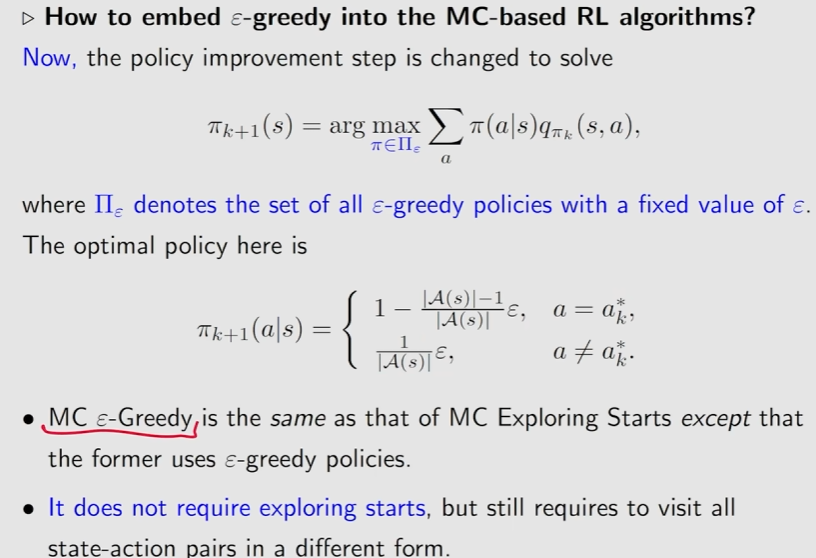

4、MC without exploring starts

Greedy-policy:

将最大的概率还是留给了greedy action

二、随机近似与随机梯度下降

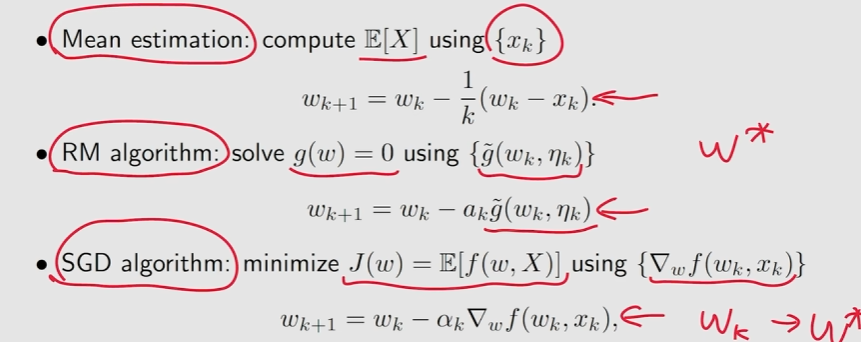

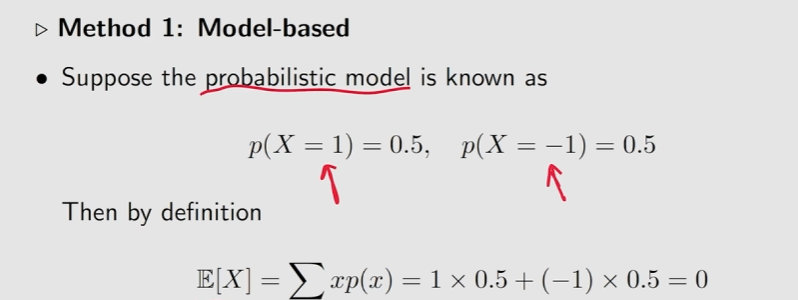

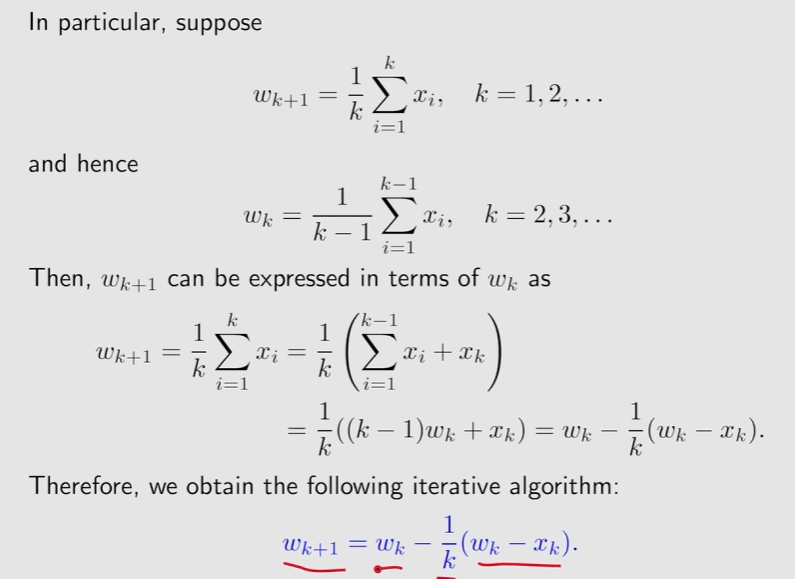

1、Motivating examples:

这个算法代表了一种增量式的计算思想

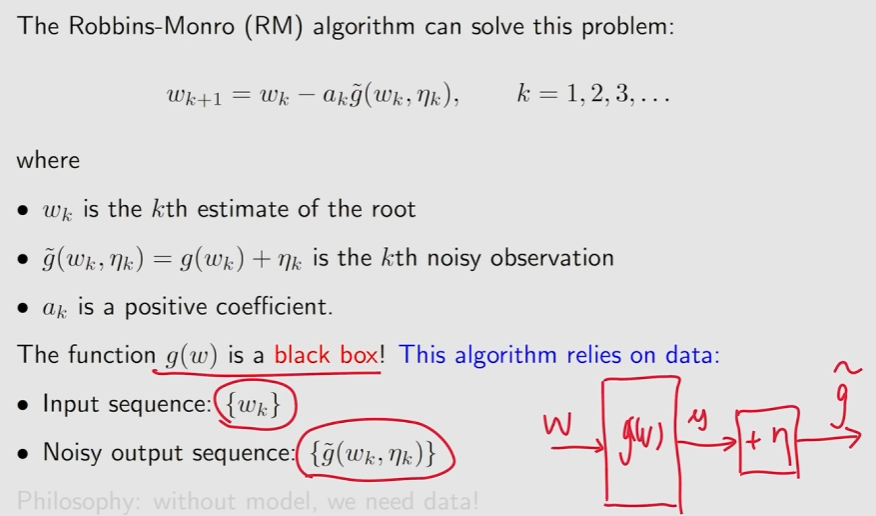

2、Robbins-Monro algorithm

随机近似(SA):代表了一类用于方程求解或优化问题的随机迭代算法

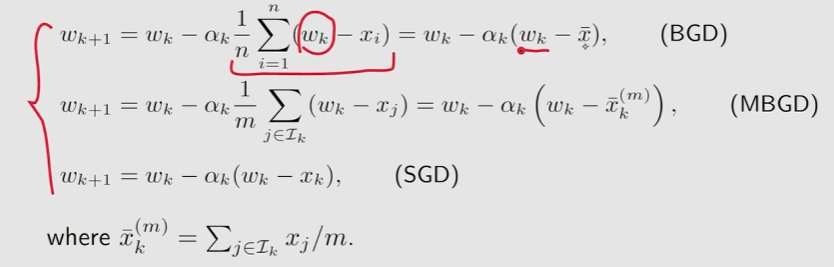

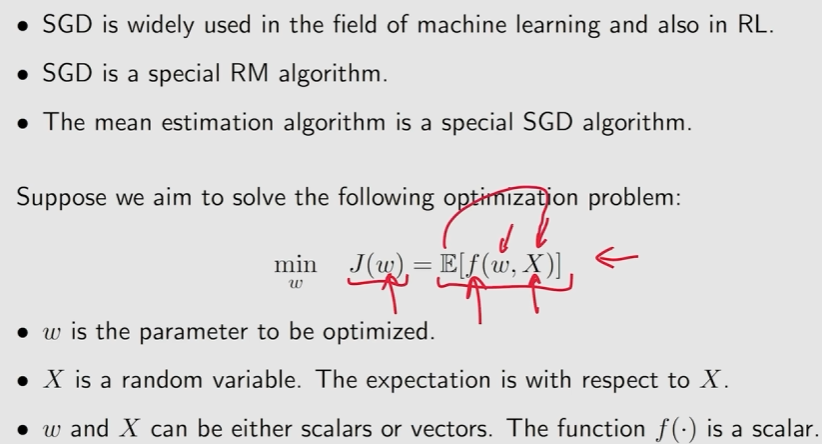

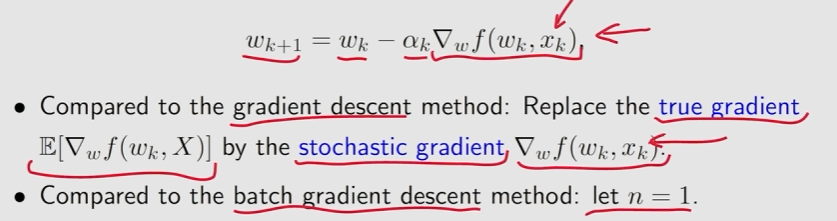

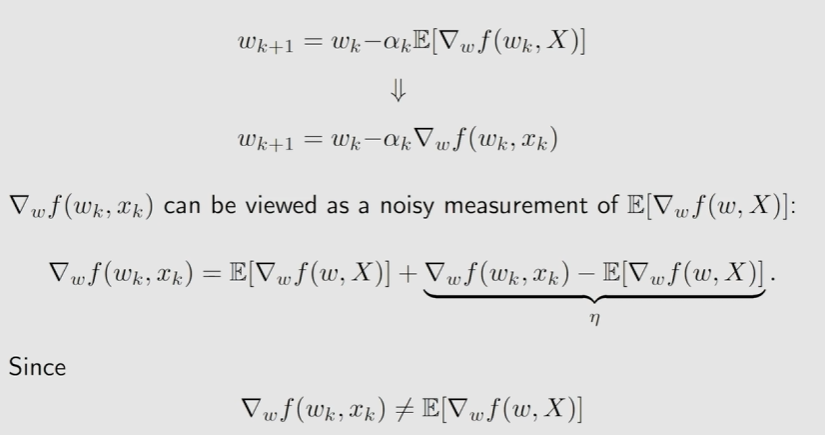

3、Stochastic gradient descent

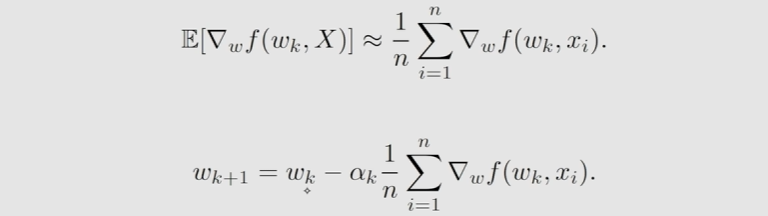

Batch Gradient Descent(BGD):

Stochastic Gradient Descent(SGD):

From GD to SGD:会存在一个误差项。

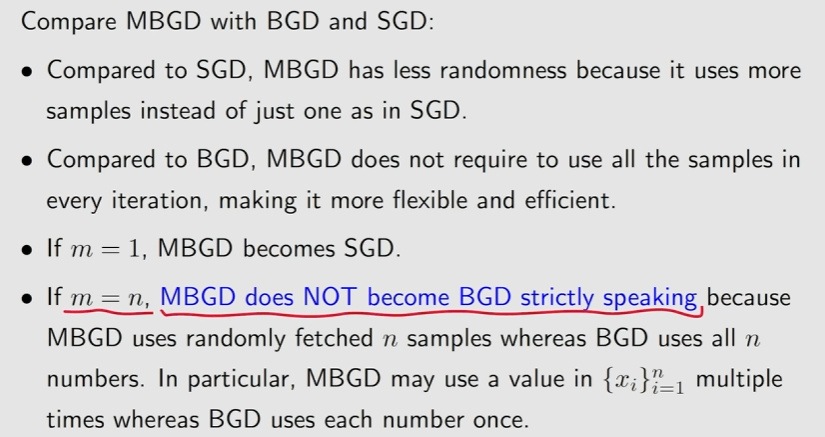

4、BGD,MBGD,SGD