【AI论文】潜在区域划分网络:生成建模、表征学习与分类的统一原理

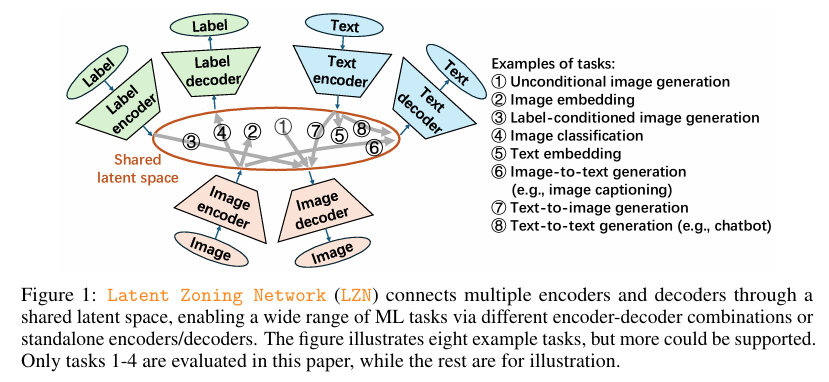

摘要:生成建模、表征学习与分类是机器学习(ML)领域的三大核心问题,然而目前针对这些问题的前沿(SoTA)解决方案在很大程度上仍是相互独立的。在本文中,我们提出这样一个问题:是否存在一种统一原理能够同时解决这三大问题?这种统一有望简化机器学习流程,并促进不同任务之间产生更强大的协同效应。为此,我们引入了潜在区域划分网络(Latent Zoning Network,LZN),以此作为迈向这一目标的一步。LZN的核心在于创建一个共享的高斯潜在空间,该空间可对所有任务的相关信息进行编码。每种数据类型(例如图像、文本、标签)都配备有一个编码器,用于将样本映射到互不重叠的潜在区域,同时配备一个解码器,用于将潜在变量映射回原始数据。机器学习任务可通过这些编码器和解码器的组合来表达:例如,标签条件下的图像生成任务使用标签编码器和图像解码器;图像嵌入任务使用图像编码器;分类任务则使用图像编码器和标签解码器。我们通过三个复杂程度递增的场景证明了LZN的潜力:(1)LZN可增强现有模型(图像生成):当与前沿的Rectified Flow模型结合时,LZN在不修改训练目标的情况下,将CIFAR10数据集上的FID值从2.76降低至2.59。(2)LZN可独立解决任务(表征学习):LZN能够在无需辅助损失函数的情况下实现无监督表征学习,在ImageNet数据集下游线性分类任务上的表现分别超越开创性的MoCo和SimCLR方法9.3%和0.2%。(3)LZN可同时解决多个任务(联合生成与分类):通过图像和标签的编码器/解码器,LZN通过设计即可同时执行这两项任务,在CIFAR10数据集上改善了FID值,并达到了前沿的分类准确率。相关代码及训练好的模型可在Github 获取,Huggingface链接:Paper page,论文链接:2509.15591

研究背景和目的

研究背景:

在机器学习领域,生成建模、表示学习和分类是三个核心任务,它们在各自领域内取得了显著进展,但现有解决方案往往相互独立,缺乏统一框架。生成建模技术,如扩散模型和自回归变换器,在图像生成、文本生成等方面表现出色;表示学习技术,如CLIP,支持信息检索等任务;分类技术则是对象识别和情感分析等任务的基础。然而,这些任务在底层技术上存在显著差异,导致任务间的协同作用难以充分发挥。例如,生成建模通常需要复杂的条件输入处理,而分类任务则专注于从输入中提取判别性特征。这种分离不仅增加了模型设计的复杂性,还限制了模型在多任务场景下的泛化能力。

研究目的:

本研究旨在提出一种统一的原则,即隐空间分区网络(Latent Zoning Network, LZN),以简化机器学习流程,促进生成建模、表示学习和分类任务之间的协同作用。具体目标包括:

- 统一框架:开发一个共享的隐空间,编码所有任务共有的信息,通过不同的编码器和解码器组合实现多种任务。

- 简化模型设计:减少为不同任务设计独立模型的复杂性,提高模型设计的效率和可维护性。

- 增强任务协同:通过隐空间的共享和编码器-解码器组合,促进任务间的信息共享和协同作用,提高模型在多任务场景下的性能。

- 验证有效性:在图像生成、表示学习和联合生成与分类等任务中验证LZN框架的有效性和优越性。

研究方法

1. 隐空间设计:

LZN框架的核心是一个共享的隐空间,遵循高斯先验分布,便于生成任务的采样。每个数据类型(如图像、文本、标签)配备一个编码器,将样本映射到隐空间中的不同区域(隐分区),并配备一个解码器,将隐变量映射回数据。这种设计使得不同任务可以表达为编码器和解码器的组合。

2. 原子操作:

LZN框架依赖于两个原子操作:隐计算和隐对齐。

- 隐计算:给定一批样本,使用编码器计算每个样本的锚点,并通过流匹配(Flow Matching, FM)将锚点映射到隐分区。这一过程确保隐变量遵循高斯分布,并且不同样本的隐分区不相交。

- 隐对齐:对齐不同编码器生成的隐分区,以便在不同数据类型之间进行转换。这一过程通过软近似和优化最大分配概率来实现,确保隐变量在不同数据类型间的一致性和可转换性。

3. 模型训练与推理:

在训练过程中,LZN框架通过最小化重构误差和隐对齐损失来优化编码器和解码器。推理阶段,根据任务需求选择合适的编码器和解码器组合,生成或分类数据。例如,在图像生成任务中,使用标签编码器和图像解码器;在分类任务中,使用图像编码器和标签解码器。

4. 实验设置:

实验在多个图像数据集上进行,包括CIFAR10、AFHQ-Cat、CelebA-HQ和LSUN-Bedroom。使用ResNet-50作为基础架构,评估LZN框架在不同任务上的性能。具体实验包括:

- 增强现有任务:将LZN与Rectified Flow模型结合,改进图像生成质量。

- 独立解决任务:使用LZN实现无监督表示学习,并在ImageNet上进行线性分类评估。

- 同时解决多个任务:联合执行条件生成和分类任务,评估LZN在多任务场景下的性能。

研究结果

1. 增强现有任务:

在CIFAR10数据集上,将LZN与Rectified Flow模型结合,FID分数从2.76降低到2.59,显著提高了生成图像的质量。此外,LZN还显著降低了重构误差,表明其能够捕捉图像的关键特征。在AFHQ-Cat、CelebA-HQ和LSUN-Bedroom等高分辨率数据集上,LZN同样展示了优越的性能。

2. 独立解决任务:

在无监督表示学习任务中,LZN在ImageNet数据集上的线性分类准确率达到了69.5%,超过了MoCo和SimCLR等经典方法。这表明LZN能够学习到更具判别性的图像表示,适用于下游分类任务。

3. 同时解决多个任务:

在联合生成与分类任务中,LZN在CIFAR10数据集上同时实现了高质量的图像生成和分类。与仅执行分类任务的模型相比,LZN的分类准确率相当,同时生成图像的质量也有所提升。这表明LZN能够有效地促进不同任务之间的协同作用。

研究局限

1. 训练效率:

LZN框架的训练过程需要反向传播通过FM轨迹,计算成本较高。尽管采用了多种优化策略,但在大规模数据集上的训练时间仍然较长。未来需要进一步探索提高训练效率的方法。

2. 纯生成建模:

尽管LZN框架理论上可以用于纯生成建模,但在复杂数据集上的实验结果表明,其生成图像的质量仍有待提高。这可能是由于隐分区的近似计算和严格的无间隙要求导致的。未来需要更深入地探索如何提高LZN在纯生成建模任务上的性能。

3. 性能提升:

尽管LZN在多个任务上展示了优越的性能,但与最先进的方法相比,仍存在一定差距。未来需要结合更先进的架构设计和训练技巧,进一步提升LZN的性能。

4. 多模态和多任务:

本研究主要关注图像领域的多任务学习,未来需要探索LZN在多模态数据(如图像、文本、音频)和更多任务类型(如检测、分割)上的应用。这有助于进一步验证LZN框架的通用性和有效性。

未来研究方向

1. 提高训练效率:

借鉴大型语言模型(LLMs)的训练技巧,探索更高效的训练方法,如梯度累积、混合精度训练等,以降低LZN框架的训练成本。

2. 纯生成建模优化:

深入研究纯生成建模任务,优化隐分区的计算和生成过程,提高生成图像的质量和多样性。例如,可以探索使用更复杂的流匹配方法或引入额外的生成对抗网络(GAN)损失函数。

3. 结合先进架构:

将LZN框架与更先进的神经网络架构(如Vision Transformer、Swin Transformer)结合,利用这些架构的强大表示学习能力,进一步提升LZN在多任务学习中的性能。

4. 多模态和多任务扩展:

将LZN框架扩展到多模态数据和多任务学习场景中,支持从多种输入源(如自然语言、图像、代码)生成高质量的输出。同时,探索LZN在跨领域任务(如硬件设计、业务流程管理)中的应用潜力。

5. 用户交互和反馈机制:

开发更友好的用户交互界面和反馈机制,使用户能够更方便地提供需求、评估生成结果、修正错误等。通过用户反馈不断优化模型性能,提高生成代码的实用性和用户满意度。

6. 可解释性和可信度研究:

研究如何提高LZN框架生成结果的可解释性和可信度,使用户能够更容易地理解模型决策过程、验证生成结果的正确性。这有助于推动LZN框架在实际项目中的广泛应用。