Qwen-image-edit在ComfyUI部署使用

背景

今天在做产品宣传图片、公司海报的时候,使用了Qwen-image-edit模型,它的生图,以及编辑能力确实很好用。就顺手把它部署到我的AI主机里面。

本文旨在ComfyUI中调用模型服务的功能学习。

- 关键词:ComfyUI,Qwen image edit

- 目的:模型调用,ComfyUI版本升级

- 难度:低;

模型介绍

项目地址

github仓库:https://github.com/QwenLM/Qwen-Image

huggingface社区:https://huggingface.co/Qwen/Qwen-Image-Edit

modelscope魔搭社区:https://www.modelscope.cn/models/Qwen/Qwen-Image-Edit

技术报告

https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen-Image/Qwen_Image.pdf

免费试用

https://chat.qwen.ai/

阿里云百炼接入

https://help.aliyun.com/zh/model-studio/qwen-image-edit-guide

comfyui接入

https://docs.comfy.org/tutorials/image/qwen/qwen-image-edit

安装部署

油管视频

https://www.youtube.com/watch?v=TZIijn-tvoc&t=710s

B站视频

https://www.bilibili.com/video/BV16SeqzVEm2/

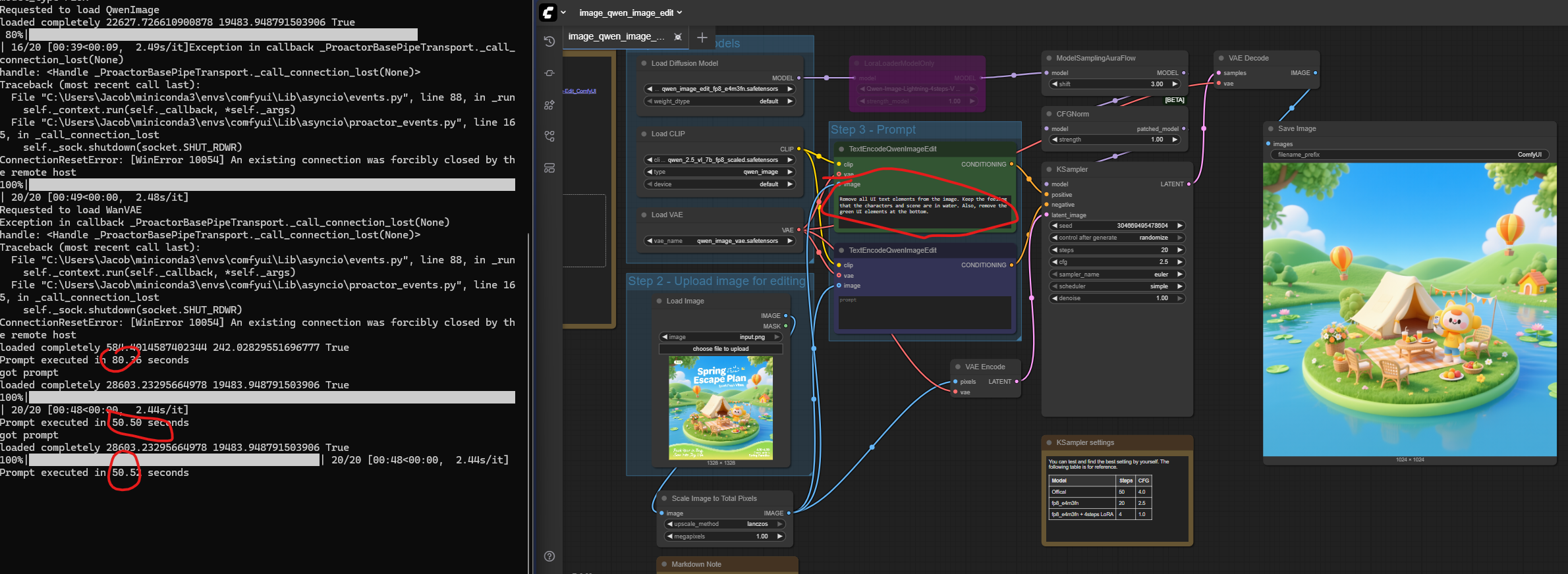

参照comfyui官方给的文章,现在我们来快速接入

升级comfy ui

https://docs.comfy.org/installation/update_comfyui#manual-installation

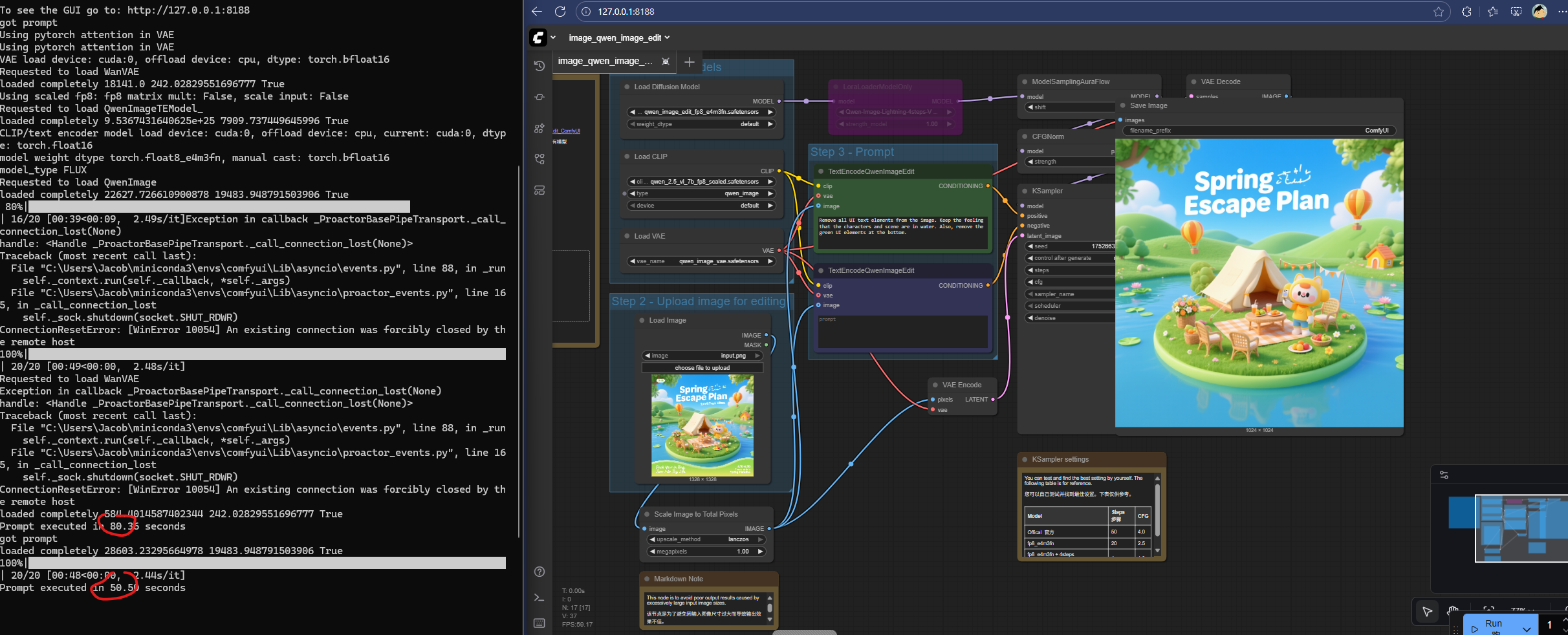

运行comfyui,查看打印

Checkpoint files will always be loaded safely.

Total VRAM 32607 MB, total RAM 48273 MB

pytorch version: 2.9.0.dev20250810+cu128

Set vram state to: NORMAL_VRAM

Device: cuda:0 NVIDIA GeForce RTX 5090 : cudaMallocAsync

Using pytorch attention

Python version: 3.12.11 | packaged by Anaconda, Inc. | (main, Jun 5 2025, 12:58:53) [MSC v.1929 64 bit (AMD64)]

ComfyUI version: 0.3.59和https://github.com/comfyanonymous/ComfyUI/releases/tag/v0.3.59的版本对的上,确实更新到最新release。

加载workflow json文件,运行ok。50~80秒跑完demo,需要占用20GB内存。

跑了几次,后续时间稳定在50s左右,效果有时候不好。针对demo图片的prompt 如下

Remove all UI text elements from the image. Keep the feeling that the characters and scene are in water. Also, remove the green UI elements at the bottom.

“移除图像中的所有界面文字元素。保留角色和场景处于水中的感觉。同时移除底部的绿色界面元素。”

比如这张,没有完全按照prompt去除上面的字体。

这一轮结果处理还是符合预期的。

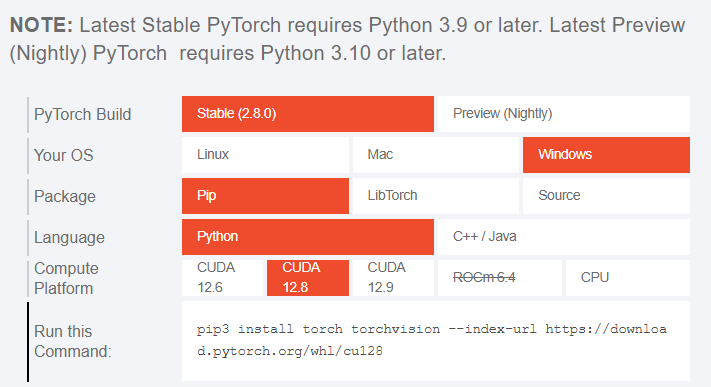

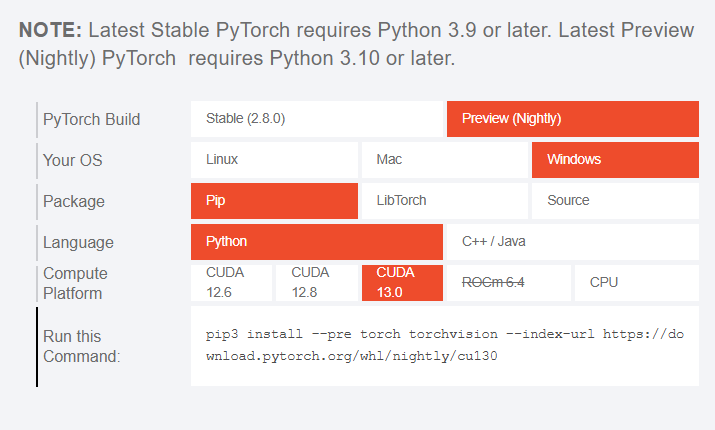

最后,RTX5090显卡已经出了一些时间了,CUDA已经从12.8升级到12.9,到最新的13.0了。当前torch稳定版已经支持12.8和12.9了。13.0停留在dev版本。

https://pytorch.org/

CUDA12.8

CUDA 13.0

我快速pip uninstall 卸载了原来dev的库,并升级了下torch的三个库

pip uninstall torch torchvision torchaudio

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu128Checkpoint files will always be loaded safely.

Total VRAM 32607 MB, total RAM 48273 MB

pytorch version: 2.8.0+cu128

Set vram state to: NORMAL_VRAM

Device: cuda:0 NVIDIA GeForce RTX 5090 : cudaMallocAsync

Using pytorch attention

Python version: 3.12.11 | packaged by Anaconda, Inc. | (main, Jun 5 2025, 12:58:53) [MSC v.1929 64 bit (AMD64)]

ComfyUI version: 0.3.59

ComfyUI frontend version: 1.26.13