SkyDiffusion:用 BEV 视角打开街景→航拍图像合成新范式

Junyan Ye、Jun He、Weijia Li 等中山大学与上海人工智能实验室的研究者提出 SkyDiffusion,首次将“曲面 BEV 视角变换 + 多图融合”与“条件扩散模型”结合,实现无需相机参数、无需文本或语义图的纯街景→高分辨率航拍图像合成,在灾难响应、无人机低空影像和历史遥感补洞三大场景均刷新 SOTA,并开源了包含 2 万张跨视角图像的 Ground2Aerial-3 数据集与完整代码。

0. 快速导航

- 研究背景:跨视角合成的痛点

- SkyDiffusion 框架一览

- Curved-BEV:让街景“抬头”看高楼

- BEV-Controlled Diffusion:用鸟瞰 latent 控制航拍生成

- Ground2Aerial-3 数据集:灾难、无人机、历史影像三大任务

- 实验结果:SOTA 全面超越

- 消融与可视化

- 结论与展望

- 代码与数据

1. 研究背景:跨视角合成的痛点

地对空图像合成侧重于从相应的地面街景图像生成逼真的航空图像,同时保持一致的内容布局,模拟自上而下的视图。显着的视点差异导致视图之间的域间隙,密集的城市场景限制了街景的可见范围,使得这种交叉视图生成任务特别具有挑战性。

| 场景 | 街景(Street View) | 航拍(Aerial / Satellite) | 核心难点 |

|---|---|---|---|

| 视野 | 水平≤ 120° | 俯视≈ 90° | 几何域差异巨大 |

| 遮挡 | 高楼、树冠 | 屋顶为主 | 单张街景看不见“屋顶” |

| 用途 | 导航、AR | 灾害评估、城市规划 | 要求内容一致+逼真 |

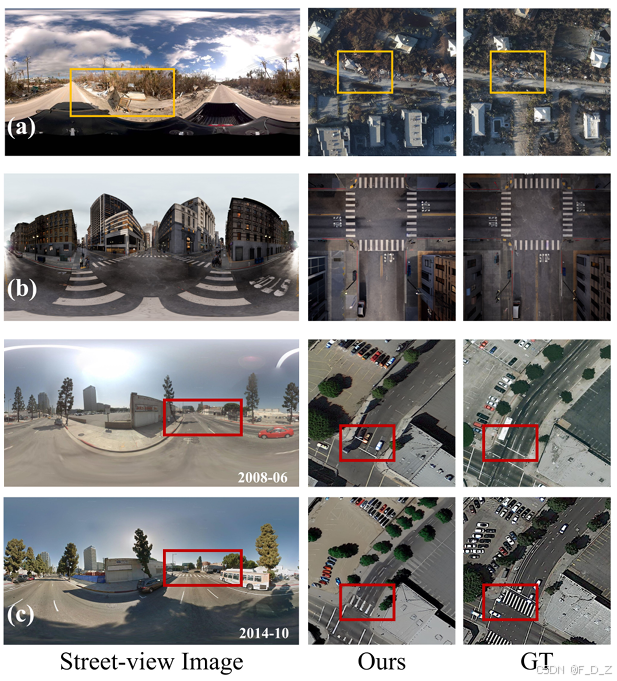

(a) 跨视图领域差异的挑战;(b) 密集场景中遮挡的挑战;© 将我们的地面到空中图像合成方法与现有的跨视图合成方法进行比较。

总结:给定一张或几张街景,如何合成同位置、同内容、高分辨率的航拍图?

现有方法要么语义对不齐(GAN),要么需要额外文本或语义图(Diffusion),且普遍忽略密集城区遮挡问题。

2. SkyDiffusion 框架一览

SkyDiffusion,是一种利用扩散模型和鸟瞰图(BEV)范式从街景图像合成航空图像的新型交叉视图生成方法。SkyDiffusion 中的 Curved-BEV 方法将街景图像转换为 BEV 视角,有效弥合了域差距,并采用“multi-to-one”映射策略来解决密集城市场景中的遮挡问题。

两大创新点

- Curved-BEV:无相机参数、无深度估计,把“向上弯曲”的 BEV 面投射到球面全景,远距离高楼也能映射。

- Multi-to-One BEV:多张街景→统一航拍坐标系,扩大可见范围,解决遮挡。

3. Curved-BEV:让街景抬头看高楼

3.1 几何建模

传统 BEV 假设地面平面 z=0,导致建筑上层信息全部丢失。

作者将 BEV 面改为向上弯曲的四次曲面:

z=(x2+y2dmax)4⋅λz = \left(\frac{\sqrt{x^2+y^2}}{d_{\max}}\right)^4 \cdot \lambda z=(dmaxx2+y2)4⋅λ

- λ=2(郊区)或 10(城市单张)或 0(城市多图融合)

- 把球面全景 (θ,φ) 与曲面 (x,y,z) 一一对应,无需相机内外参。

3.2 Multi-to-One 融合

给定 N 张街景,按相机位置偏移 (Δx,Δy) 把各自 BEV 投到统一航拍格网;重叠区取最近相机像素。

k∗=argmini(x−xcami)2+(y−ycami)2k^* = \arg\min_i \sqrt{(x-x_{\mathrm{cam}_i})^2 + (y-y_{\mathrm{cam}_i})^2} k∗=argimin(x−xcami)2+(y−ycami)2

效果:在 VIGOR-Chicago 上,BEV 感知半径从~50 m 扩展到>150 m。

4. BEV-Controlled Diffusion:用鸟瞰 latent 控制航拍生成

4.1 条件注入架构

- 轻量 BEV Encoder:4 块卷积+Spatial Attention,抑制曲面扭曲误差

- 零卷积注入:复制 Stable Diffusion v1.5 的 Encoder&Middle Block,权重锁预训练,只训练零卷积与 BEV 编码器

- Classifier-Free Guidance:训练时 10% 丢弃 BEV 条件,推理阶段 guidance scale=9

4.2 训练目标

L=Ex0,t,cbev,ε[∥ε−εθ(xt,t,cbev)∥22]L = \mathbb{E}_{x_0,t,c_{\mathrm{bev}},\varepsilon} \big[\|\varepsilon - \varepsilon_\theta(x_t,t,c_{\mathrm{bev}})\|_2^2\big] L=Ex0,t,cbev,ε[∥ε−εθ(xt,t,cbev)∥22]

- 街景只做条件输入,不提供像素级重建约束

- 文本描述仅用于 CFG,不作为优化目标 → 避免文本-几何错位

5. Ground2Aerial-3 数据集:灾难、无人机、历史影像三大任务

| 子集 | 场景 | 数量 | 分辨率 | 独特价值 |

|---|---|---|---|---|

| Disaster | 飓风 Ian(2022)破坏区 | 2.7 k | 0.3 m | 快速灾情评估 |

| UAV | MatrixCity 虚拟城 | 4.3 k | 0.05 m | 车道级自动驾驶 |

| Historical | 波士顿+洛杉矶 2007-2014 | 11.9 k | 0.3 m | 补全历史遥感空缺 |

划分:按区域 4:1 训练/测试,同一航拍图不会跨集出现,避免信息泄漏。

对齐:街景中心列指向真北,航拍图中心与街景中心经纬度对齐。

6. 实验结果:SOTA 全面超越

6.1 定量指标

在郊区 CVUSA 和 CVACT 数据集上,SkyDiffusion 取得了突出的成绩。与最先进的方法相比,它降低了 25.72% 的 FID,提高了 7.68% 的 SSIM,证明了其在合成逼真一致的卫星图像方面的优越性。在城市 VIGOR-Chicago 数据集中,与最先进的方法相比,降低了 14.98%的 FID,提高了 9.41%的 SSIM。

6.2 视觉对比

- GAN 系(SelectionGAN、CUT):纹理虚假、道路中断

- Diffusion 系(Instruct-p2p、ControlNet):逼真但内容与街景无关——树少一排、楼缺一角

- SkyDiffusion:道路走向、树木排布、建筑轮廓与真图几乎一一对应,屋顶纹理自然合理

7. 消融与可视化

Curved-BEV 模块的消融研究。“基线”表示直接使用街景图像,“BEV”和“C-BEV”表示使用标准 BEV 或 Curved-BEV 变换,“Multi”代表多对一。

可视化亮点

- Multi-to-One:在 VIGOR 密集区,把 3 张街景的 BEV 融合后,原本被树挡住的十字路口成功出现在航拍结果中。

- 灾难场景:橙色框内屋顶破损、道路积水痕迹与灾后真图位置一致,可辅助快速定位重灾区。

- 历史影像:2008→2014 道路新增斑马线、环岛,SkyDiffusion 都能按年代语义生成,不会“穿越”未来建筑。

8. 结论与展望

SkyDiffusion 首次将“曲面 BEV + 多图融合”与“扩散模型条件生成”无缝结合,实现:

- 无需相机参数的精确几何对齐;

- 无需文本或语义图的纯街景→航拍合成;

- 跨场景泛化:郊区、城市、灾难、无人机、历史影像全线 SOTA。

未来工作

- 拓展到视频航拍生成,赋予时序一致性;

- 引入可学习曲面参数λ,让 BEV 形状随场景自适应;

- 与NeRF 或 3D Gaussian Splatting结合,实现交互式视角漫游。

9. 代码与数据

- 开源代码(PyTorch + Diffusers):

https://github.com/SkyDiffusion/SkyDiffusion - Ground2Aerial-3 下载:

https://huggingface.co/datasets/SkyDiffusion/G2A-3 - 预训练权重:SD v1.5 + Curved-BEV 模块已上传,支持 512×512 推理,单卡 A100 仅需 2.1 GB 显存。

Ye J., He J., Li W. et al. “Leveraging BEV Paradigm for Ground-to-Aerial Image Synthesis.” arXiv:2408.01812, 2025.