每天五分钟深度学习:softmax回归的交叉熵损失的前向传播

本文重点

神经网络非常善于处理分类问题,一般来说要想让神经网络完成多分类问题,我们常常使用softmax回归,它可以将神经网络的输出以概率的形式表示。分类问题一般使用交叉熵损失函数来进行优化,所以本文我们来看一下softmax回归在神经网络中的应用,以及交叉熵损失的计算。

softmax回归

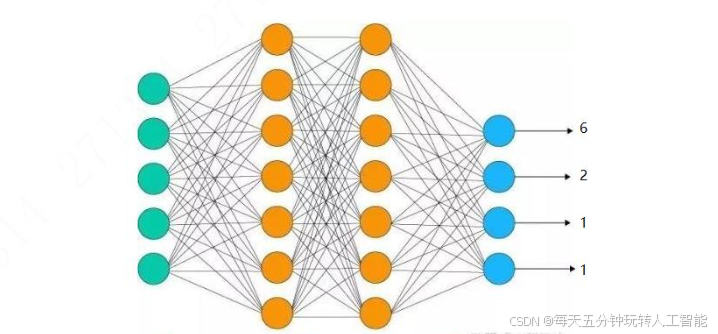

如图所示,现在我们搭建了一个可以解决4分类问题的神经网络,也就是说神经网络的输出层有4个神经元

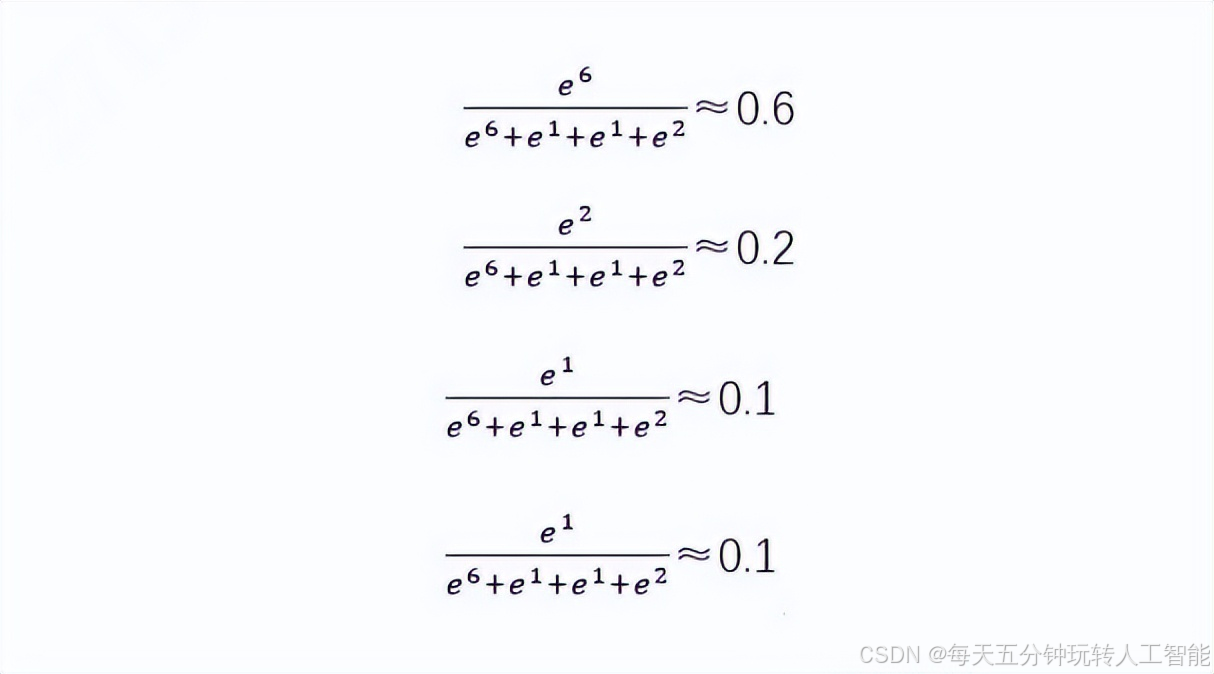

softmax的原理非常简单,如图所示我们可以看到输入样本x到神经网络中,神经网络的输出层的每个神经元分别输出6、2、1、1此时softmax还没有发挥作用呢?现在我们使用softmax进行处理:

如上公式所示,我们通过softmax来将神经网络的输出变为了概率了,这就是softmax的全部,没有什么特殊的计算方式,就是做了一个归一化操作,下面我们看一下交叉熵损失如何计算softmax的损失。

交叉熵损失

在分类问题中,交叉熵损失是最常用的损失,交叉熵损失函数我们可以分为二分类的交叉熵损失,以及多分类的交叉熵损失。

二分