大模型如何让机器人实现“从冰箱里拿一瓶可乐”?

在具身智能的研究领域中,大模型正逐渐成为推动这一领域发展的关键力量。它的地位相当于人类的大脑,是排兵布阵的最高统帅,就像钢铁侠战衣中的贾维斯。

可以说,当具身智能遇上大模型,机器人正从"程序执行者"进化为"环境思考者"。

本文将从算法架构层面解析大模型如何突破传统机器人三阶闭环的技术边界,并探讨其对产业生态的重构效应。

输入层“革命”

具身智能系统的输入一般来自两个部分:

第一个是人类的自然语言的指令,这部分的输入主要是作为人机交互而存在。

另一部分的输入则是来自于具身智能系统的主动环境感知,就和我们人类一样,我们在和他人对话的过程中,一方面要接受来自他人的语言,一方面自己也在主动的“察言观色”,这一部分主动“察言观色”的输入,则是属于具身智能系统的主动环境感知。

人机交互

以复杂的指令 “请帮我从厨房的冰箱里拿一瓶可乐,然后放到客厅的茶几上,并且告诉我冰箱里还有多少瓶饮料” 为例。

传统方法:基于关键词正则匹配

# 规则式解析(易失效)

if "冰箱" in text and "可乐" in text:

execute(fetch_from_fridge())

传统方案的局限:

语音识别与语义理解分步处理,存在误差累积(如“可乐”误识别为“颗粒”)

依赖预定义关键词库,无法处理隐含需求(如“剩余饮料统计”)

大模型方案:

语音转文本:首先通过语音识别技术将语音指令转换为文本形式,如Whisper V3实时转录。

语义解耦:然后基于Transformer的自注意力机制,构建三维语义网。包括目标物体(可乐)、起始位置(冰箱)、目标位置(茶几)以及额外的任务要求(告知冰箱里剩余饮料数量)。

这一过程涉及到对语言的深度理解和语义分析,大模型通过其预训练的海量数据和参数,能够准确地识别和理解指令中的各种信息。

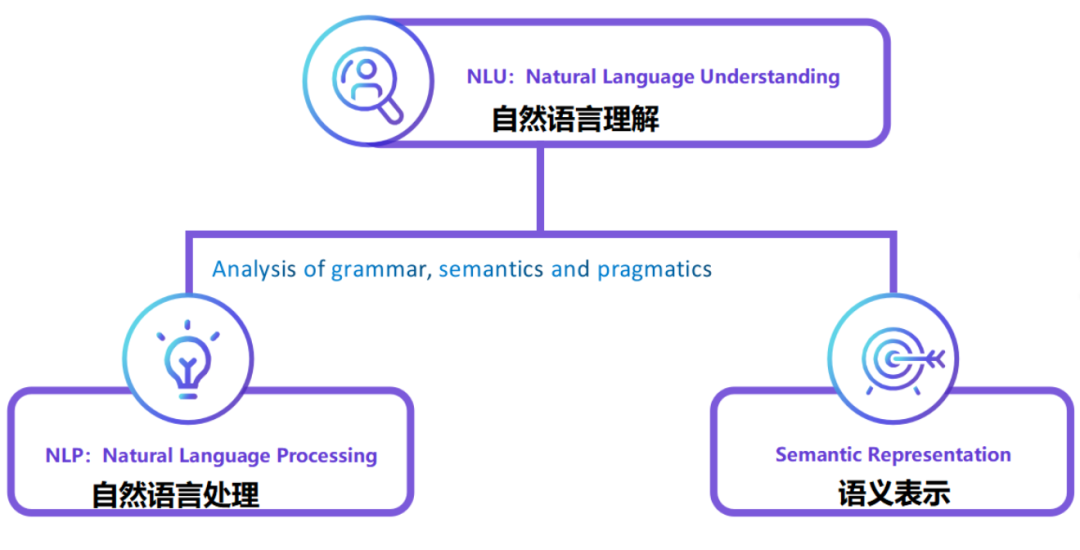

(自然语言指令理解的一般处理方式)

原理层面,大模型在具身智能感知领域带来“革命性的变化”,主要体现在语音识别和语义理解两方面。

高精度语音识别:大模型通过端到端的语音识别技术(如:SpeechLMs),能够直接将语音信号转换为文本,避免了传统方法中语音转文字过程中可能出现的信息丢失和误差累积问题。

强大的语义理解:大模型通过预训练的海量数据,具备了强大的语义理解能力,能够处理复杂的自然语言指令。

多语言多口音支持:大模型通过多语言预训练,使得具身智能系统能够更好地适应不同用户的需求,提供更加个性化的服务(如:该指令是方言时),从而进一步拓展了大模型在具身智能系统中的应用价值。

主动环境感知

环境感知数据的理解:大模型具备强大的环境感知数据理解能力。它通过多模态数据处理技术,能同时分析视觉图像、听觉声音等多种感知数据。

比如,识别厨房、冰箱、可乐、客厅、茶几这些物体和场景,还能通过观察人类表情来判断情绪等;利用听觉感知去理解这条语音指令,同时也能分析周围的环境音效,像冰箱门打开的声音等。

在技术实现上,大模型常采用多模态融合的方法。以视觉语言模型CLIP为例,它通过联合训练图像和文本,能帮机器人识别图像里的物体并进行描述,让机器人更清楚周围环境。

大模型处理多模态感知数据的优势明显:

在视觉方面,借助卷积神经网络(CNN)提取图像特征、识别物体,让机器人找到冰箱和可乐。

在听觉方面,通过语音识别和语义理解技术,解析出指令内容。

在触觉方面,分析触觉传感器的数据,让机器人在拿取可乐时知道抓得是否牢固,会不会掉落。

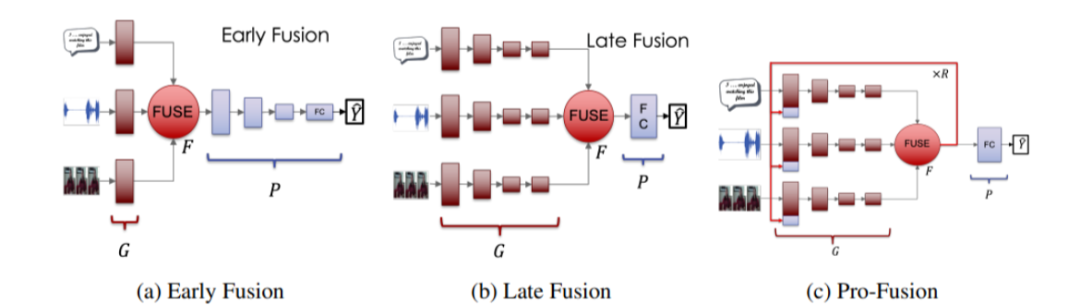

多模态大模型一般采用Transformer架构和多头自注意力机制,把视觉、听觉、触觉等不同模态的数据融合起来处理。这样,机器人就能更全面、准确地感知世界,按照指令,先去厨房冰箱拿可乐,再放到客厅茶几上,最后统计冰箱里剩余饮料的数量,完成一系列复杂任务。

(多模态融合框架)

控制层“革命”

大模型在具身智能系统的控制环节中,通过精确的运动控制和高效的任务执行,确保机器人能够准确、高效地完成各种复杂任务。

以下将从运动控制和任务执行两个方面,详细探讨大模型在控制环节中的具体作用。

运动控制

我们依旧以“请帮我从厨房的冰箱里拿一瓶可乐,然后放到客厅的茶几上,并且告诉我冰箱里还有多少瓶饮料”这一指令为例。

大模型根据任务目标和环境信息生成运动控制指令:

当具身智能体接收到指令后,大模型会结合环境感知数据,如厨房和客厅的布局、冰箱和茶几的位置等,规划出一条最优的行走路径。

例如,在复杂的地形上,大模型可以通过深度强化学习(DRL)算法,结合地形感知规划器和步态控制器,规划机器人的行走路径,使其能够避开障碍物并保持平衡。

大模型在实时调整运动参数方面也具有显著优势:

在执行任务过程中,机器人需要根据实时反馈的运动数据和环境变化,动态调整速度、力度等参数。

例如,当机器人从冰箱中取出可乐时,大模型会根据力传感器的反馈数据,调整机器人的抓取力度,确保可乐瓶不会滑落或损坏。在机器人行走过程中,大模型会根据环境感知数据,如地面的平整度和障碍物的位置,实时调整机器人的行走速度和步态,以确保机器人能够平稳地移动到客厅的茶几旁。

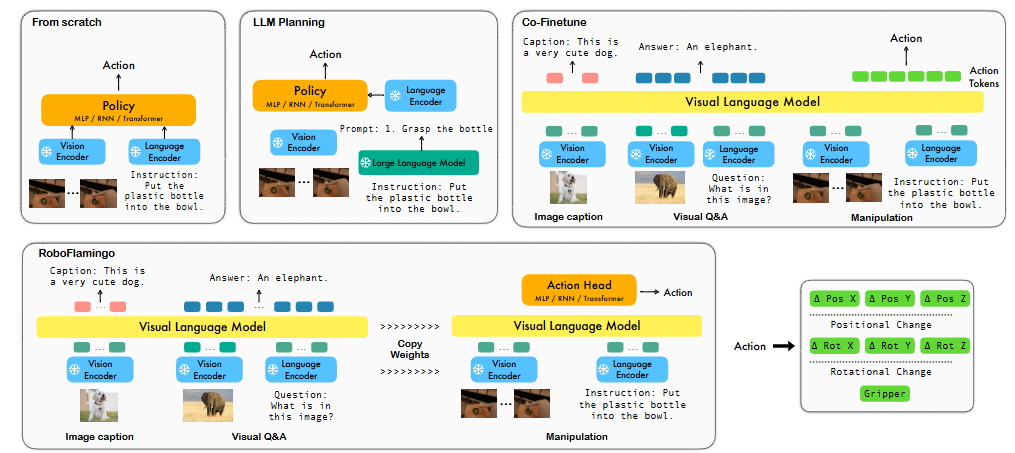

(基于大模型的机器人控制框架)

任务执行

在任务执行方面,大模型同样展现出强大的能力。

首先,大模型会将任务分解为多个子任务,如打开冰箱、取出可乐、关闭冰箱、行走至客厅、放置可乐、统计冰箱中的饮料数量等。

然后,大模型会根据任务的优先级和资源分配,合理安排具身智能体的行动顺序。例如,在打开冰箱后,大模型会优先控制机器人取出可乐,然后再关闭冰箱,以确保任务的高效完成。

同时,在执行任务过程中,大模型会根据实时反馈的数据和环境变化,动态调整任务规划。例如,当机器人在行走过程中遇到障碍物时,大模型会重新规划路径,确保机器人能够顺利到达客厅的茶几旁。在统计冰箱中的饮料数量时,大模型会根据视觉感知数据,识别饮料瓶的种类和数量,并将结果反馈给用户。

仅在拿可乐这个简单的交互指令中,大模型不仅能够规划最优的行走路径,实时调整运动参数,还能够分解任务、合理安排行动顺序,并根据实时反馈数据动态调整任务规划,确保任务的高效、稳定完成。

由此可见,大模型在具身智能系统的控制环节中,通过运动控制和任务执行的协同作用,为机器人提供了强大的决策和执行能力。

反馈层“革命”

在具身智能系统中,反馈环节是确保任务顺利完成的关键。大模型通过与人类和环境的交互,不断优化自身的行为策略。

以下将从对人类指令的反馈和对环境反馈的利用两个方面,详细探讨大模型在反馈环节中的具体作用。

对人类指令的反馈

大模型能够使具身智能体向人类反馈任务执行情况,实现人机之间的有效互动。

例如,在执行“请帮我从厨房的冰箱里拿一瓶可乐,然后放到客厅的茶几上,并且告诉我冰箱里还有多少瓶饮料”这一指令时,具身智能体可以通过自然语言向用户汇报任务进度和遇到的问题。

具体来说,当机器人从冰箱中取出可乐后,它会用自然语言向用户汇报:“我已经从冰箱里拿了一瓶可乐,接下来我会把它放到客厅的茶几上。”

如果在执行过程中遇到问题,如冰箱门无法打开,机器人会及时向用户反馈:“冰箱门似乎被卡住了,我无法打开。”

大模型在理解人类反馈意见后,能够调整后续任务执行,进一步优化任务完成效果。

例如,用户可能会根据机器人的反馈,提供额外的指令或建议,如“你可以尝试用更大的力气打开冰箱门。” 大模型会根据这些反馈,调整机器人的动作参数,如增加开门的力度,以完成任务。

甚至未来还能调动异常处理逻辑:

若冰箱无可乐→调用LLM生成替代方案(如"建议购买清单")

茶几被占用→触发空间拓扑重建(如寻找相邻台面)

这种人机之间的有效互动,使得具身智能体能够更好地适应复杂多变的任务需求。

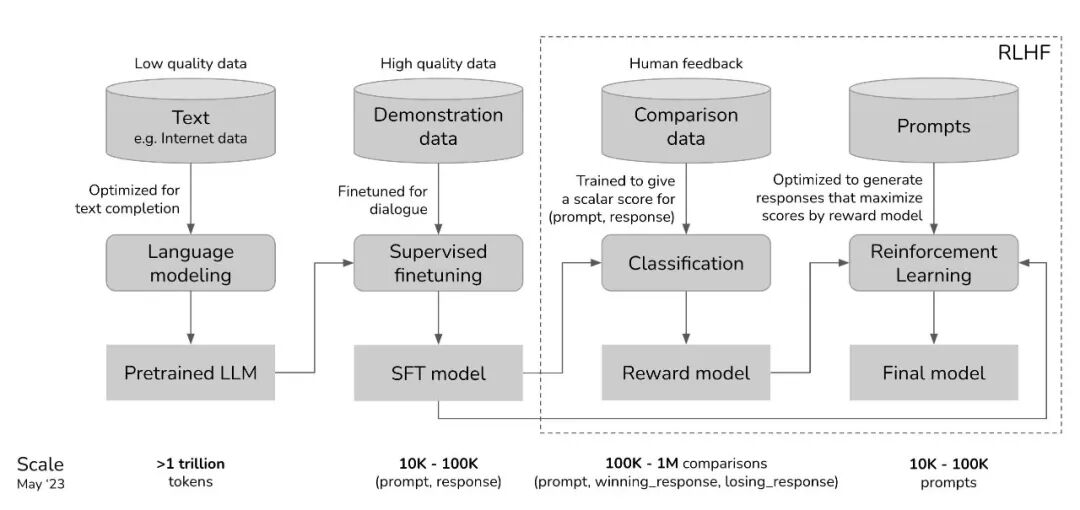

(基于人类反馈的具身智能大模型学习训练框架)

对环境反馈的利用

大模型能够利用机器人从环境中获取的反馈信息,如传感器检测到的物体位置变化、环境温度变化等,来优化自身的行为策略。

例如,在执行上述指令时,机器人通过视觉传感器检测到冰箱门的位置和状态,如果冰箱门没有完全关闭,机器人会根据这一反馈信息,调整关门的动作力度和角度,确保冰箱门能够顺利关闭。

大模型通过学习环境反馈,使具身智能体能够更好地适应不同的环境条件,提高任务完成的准确性和效率。

例如,如果机器人在行走过程中检测到地面湿滑,大模型会根据这一反馈,调整机器人的行走速度和步态,防止机器人滑倒。

在统计冰箱中的饮料数量时,机器人通过视觉传感器检测到饮料瓶的位置和数量,并将这些信息反馈给大模型,大模型会根据这些数据,准确地统计出饮料的数量,并将结果反馈给用户。

综上所述,大模型在具身智能系统的反馈环节中,通过与人类和环境的交互,不断优化自身的行为策略,确保任务的高效、准确完成。

大模型在具身智能系统中

其他潜在作用

学习与优化

在具身智能系统中,大模型可以利用强化学习等机器学习方法,帮助具身智能体更快地学习新任务和技能。

例如,通过深度强化学习,大模型可以根据具身智能体在环境中的表现,调整其行为策略,使其能够更有效地完成任务。

情感交互与社交能力

大模型能够赋予具身智能体一定的情感交互能力,使其能够识别和回应人类的情感表达,从而使机器人更加“人性化”。

例如,大模型可以通过分析人类的语音语调、面部表情等信息,判断人类的情感状态,并生成相应的回应。这部分的功能已经有了一些产品及应用,比如蔚来汽车的Nomi情感机器人,就能够在独自一人驾车时主动与司机交流,缓解一些开车的烦闷。

(蔚来汽车的NOMI情感机器人)

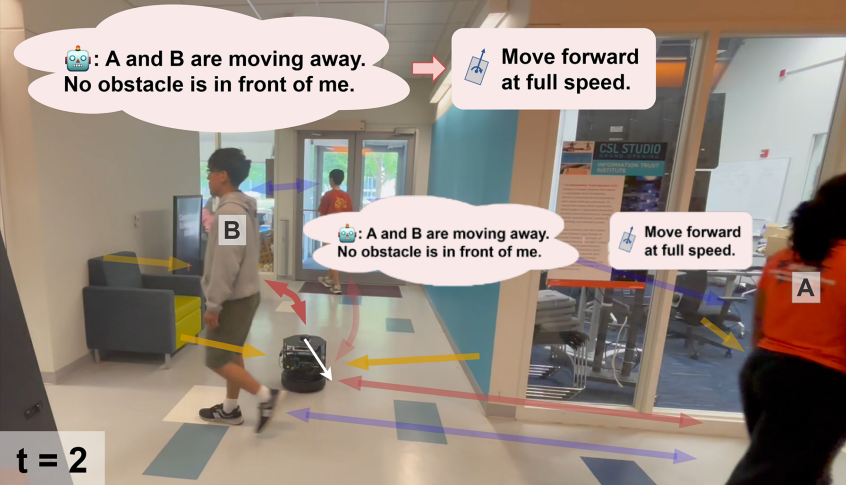

此外,大模型在促进具身智能体之间的社交协作方面也具有潜力。

例如,多个机器人之间可以通过大模型进行信息交流和任务协作,共同完成复杂的任务(如此前Figure AI部署了Helix模型后的机器人协作演示)。这种社交协作能力,使得具身智能系统能够更好地适应复杂多变的环境,提高任务完成的效率和质量。

面临的挑战与展望

尽管大模型在具身智能系统中具有广泛的应用前景,但在实际应用中仍面临一些挑战,譬如:大模型的实时性要求较高、计算资源消耗较大、数据隐私和安全问题等。

随着技术的不断进步,未来大模型将有望推动具身智能系统在更多领域的应用。例如马斯克旗下的Neuralink和SpaceX就一直在医疗康复、太空探索这两个高精尖领域探索。

我个人认为,或许未来,当你说“拿可乐”时,它不只是执行动作,而是真正理解:

“

打开哪个冰箱门(而不是微波炉)

拿取后要关门(节能意识)

行动时避开地面玩具(安全考量)

报告库存时自动分类(区分可乐/雪碧/矿泉水)

……

这才是具身智能的革命——让机器从“机械执行”进化到“像人一样思考着行动”。

其实在大模型学习过程中,很多人都会遇到共性问题:比如零基础刚接触编程环境搭建总出错,或是实战时卡在模型微调参数调试,又或是不确定自己的研究方向该侧重路线里的哪个模块。如果遇到这些困惑,不妨跟着老师系统的进行学习 —— 他们能根据你的基础(不管是学生还是职场转型)和目标(论文、竞赛或就业),帮你梳理适合的学习侧重点,还会分享一些脑图里没详细展开的实操资源,比如环境配置避坑手册、常用数据集获取渠道。另外,和同阶段学习者一起交流也很有帮助,大家可以组队打卡、分享实验心得,遇到难题时一起讨论,比独自摸索效率高很多。要是你也想获得这样的学习支持,随时能找到对应的沟通渠道,为自己的大模型学习之路多一份保障。

学习路线图内容非常多,详情请咨询☟☟☟

也能带着打天池、kaggle等竞赛

另外如果你想发高区论文的话我们也有对应的指导方式,大家需要的话可以添加助教老师,通过后咨询即可!欢迎大家前来咨询!