rook-ceph自定义添加osd流程

背景

还是那个不知道cluster.yaml在哪里的环境,在这个配置不明的环境中原本只有一个osd,并且其他集群不作为存储节点,基于此来进行操作配置。

流程

最方便的cluster.yaml文件不知道跑哪里去,还是只能用那个crd文件来改。

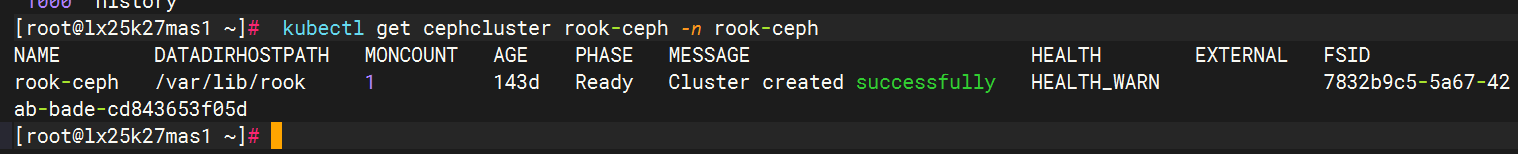

kubectl get cephcluster rook-ceph -n rook-ceph

kubectl get cephcluster rook-ceph -n rook-ceph -o yaml > cephcluster.yaml

cat cephcluster.yaml查看配置

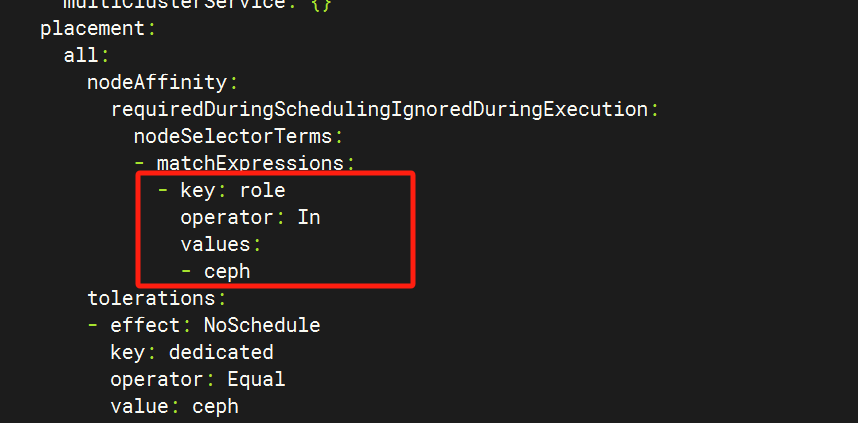

有个亲和力设置,那也就是说存储节点需要配置个role=ceph的标签

kubectl label node lx25k27sha1 role=ceph

kubectl label node lx25k27har1 role=ceph

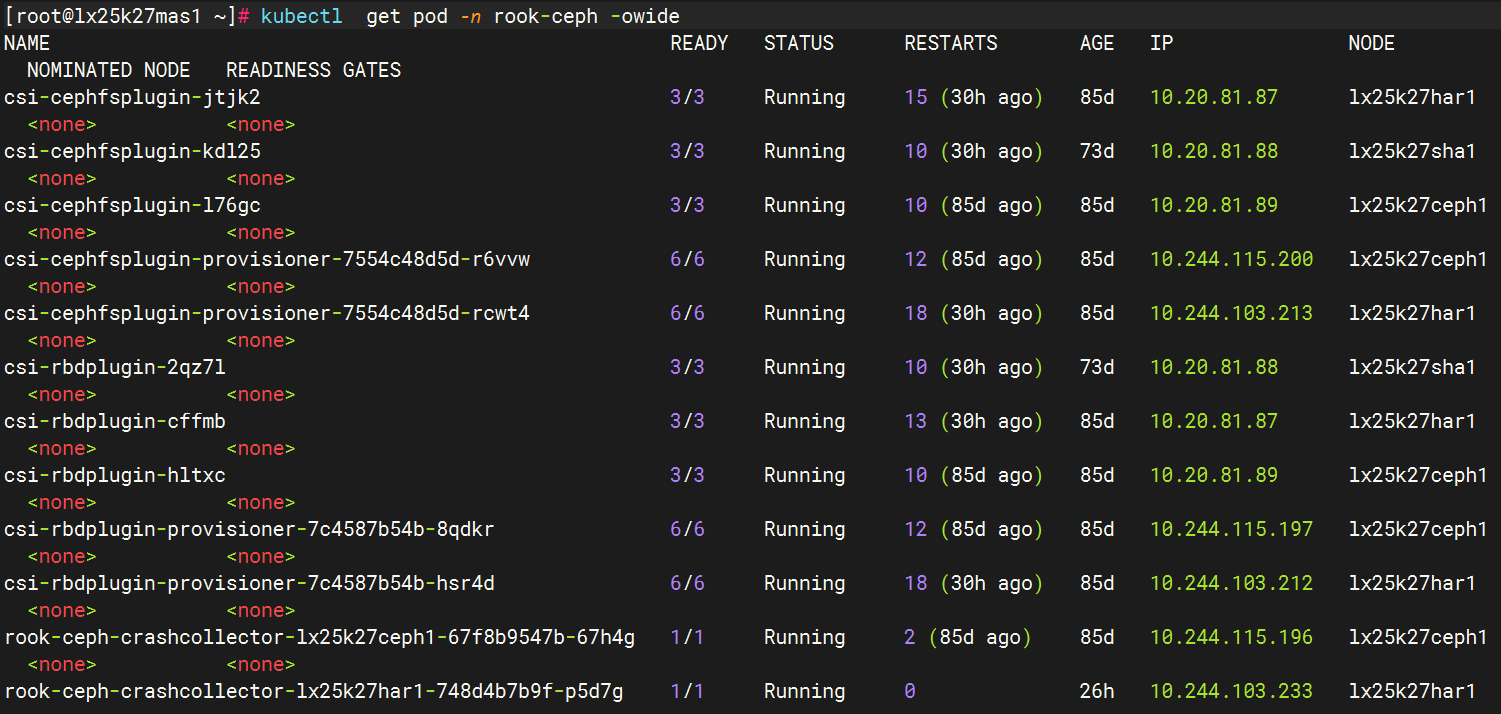

然后查看pod就可以看见在这些节点重新启动了各自存储的plugin

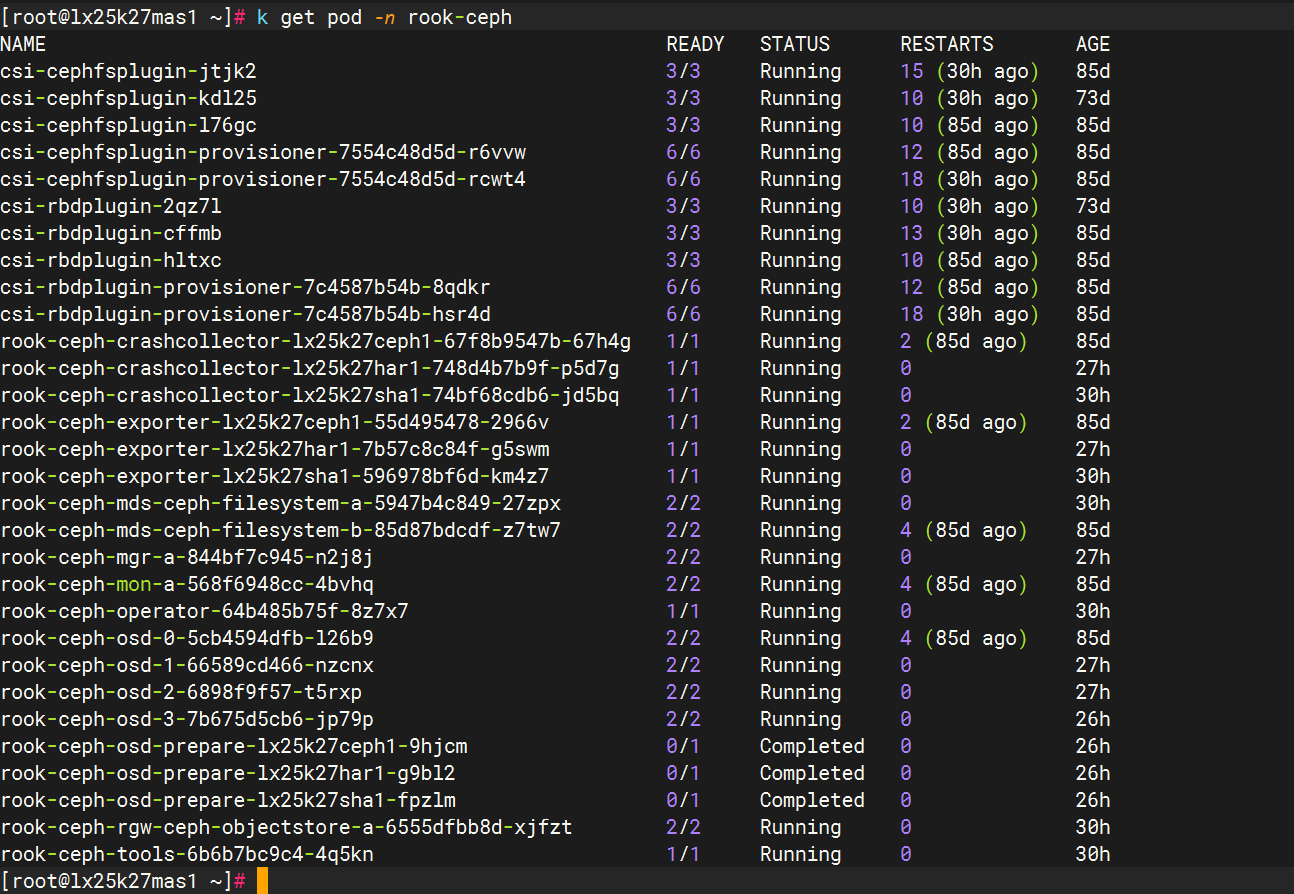

kubectl get pod -n rook-ceph

接着在node里面加入新盘osd初始化配置,配置文件有时间限制,超时会导致apply命令失败,可以重新导出

kubectl get cephcluster rook-ceph -n rook-ceph -o yaml > cephcluster.yaml

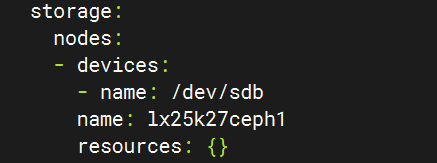

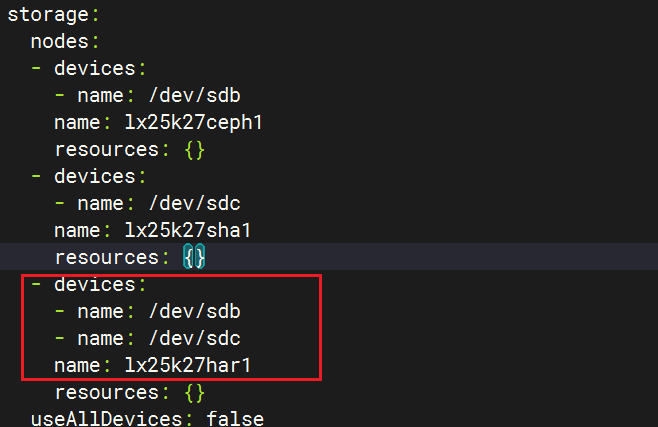

配置文件中找到storage

原来新盘初始化是要自己手动配置,我们仿照以上格式把其他盘也加入进来

只需要在node下添加

node:- devices: #设备配置- name: /dev/sdb #设备块位置name: lx25k27ceph1 #设备块在哪个node上,是主机名

如果是一个node多块盘,只需要在-name中多加上个存储盘的位置即可。

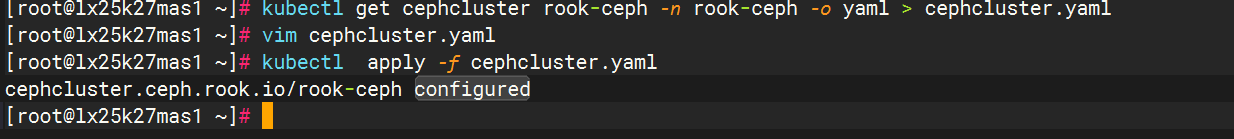

kubectl apply -f cephcluster.yaml

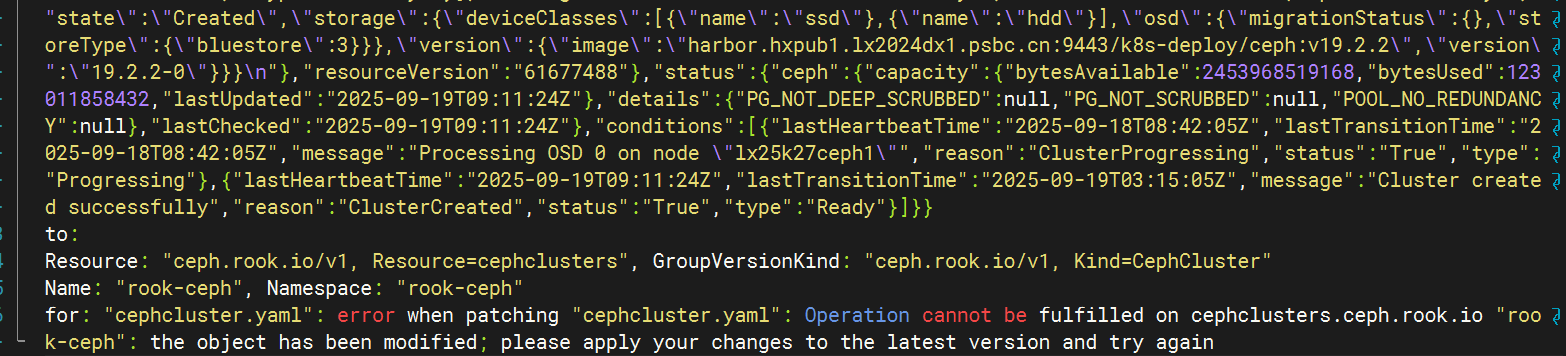

配置花费时间太久就会报错

在短时间内配置完成就可以apply,关于这个时效超时看rook-ceph CRD资源配置时效问题。

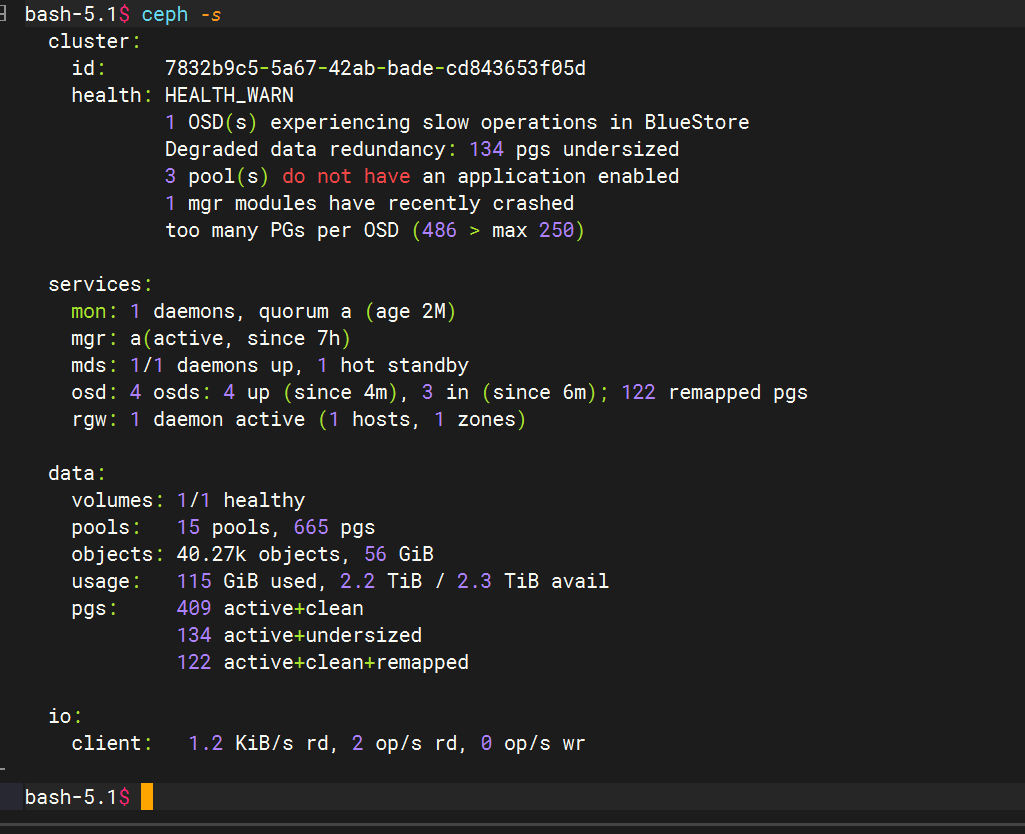

接着到web上或者tools看下集群状态

看下pod状态

完成配置