有方向的微小目标检测

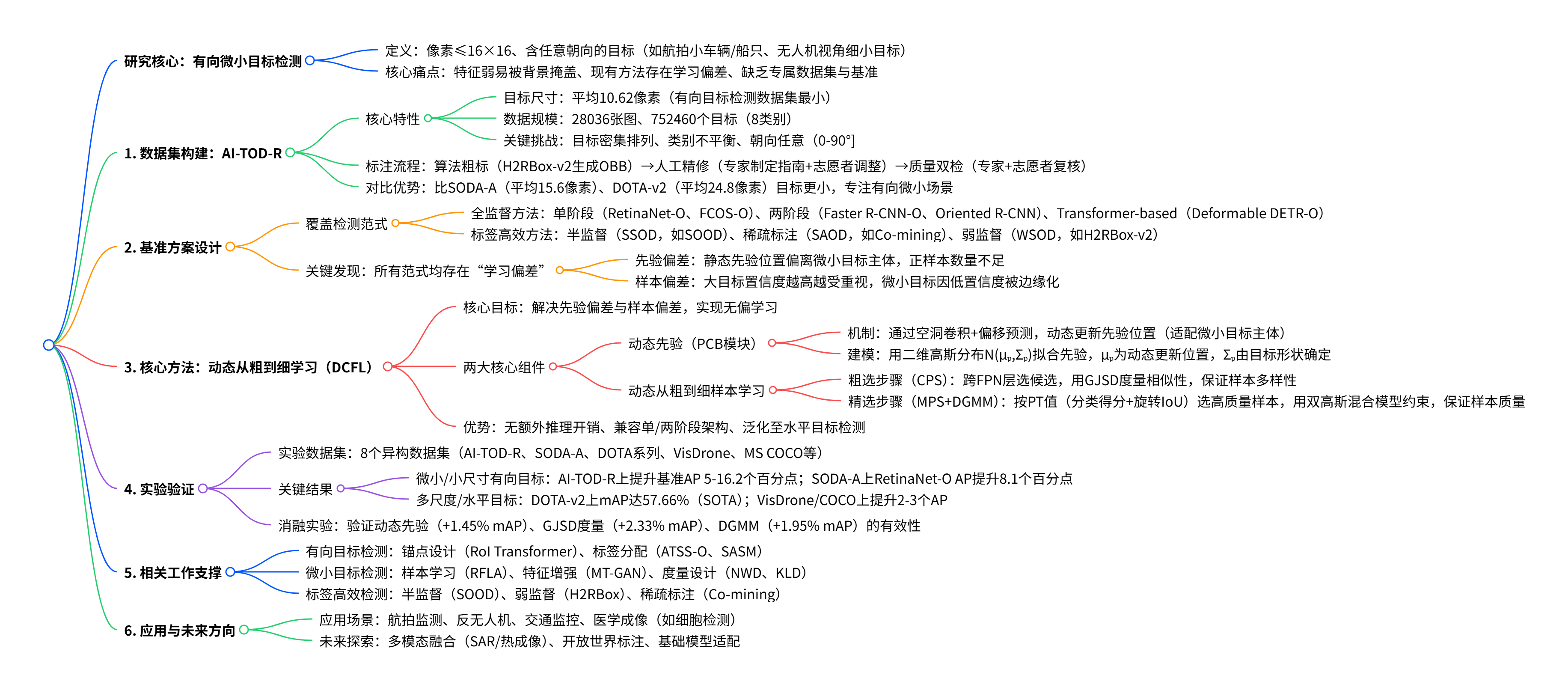

这份文档主要围绕 “有方向的微小目标检测” 展开,简单来说,就是解决怎么在图片里精准找到那些又小、还可能歪着放的物体(比如航拍图里的小车辆、小船只,或者无人机拍的图里的细小目标),还专门做了数据集、测试标准和新方法,下面用大白话拆成几个核心部分讲:

首先,得先搞清楚 “有方向的微小目标” 是啥 —— 就是那些像素特别少(平均才 10.6 像素,比指甲盖在手机屏上还小),而且不是正正方方放着的物体(比如歪着的小船、斜着的油罐)。之前没专门针对这类目标的数据集,研究起来很不方便,所以作者先做了个叫 AI-TOD-R 的数据集:里面有 2.8 万张图、75 万个带方向标注的小目标,是目前同类数据集里目标最小的,还解决了标注难的问题(先用算法粗标,再人工改,最后专家复查,保证 accuracy)。

然后,作者用这个数据集搭了个 “测试标准”( benchmark ),测了各种主流的检测方法 —— 不管是 “一步到位” 的检测算法(比如 RetinaNet)、“两步走” 的算法(比如 Faster R-CNN),还是不用太多标注的 “高效标注” 算法(比如只用 10% 标注图就能训的方法)。测完发现一个大问题:所有方法都有 “偏见”—— 大目标越训越准,小目标却总被忽略,要么没选到足够多的小目标样本,要么对小目标的预测信心特别低,导致漏检、错检。

为了解决这个 “偏见”,作者搞了个叫 DCFL 的新方法,核心就是 “动态地从粗到细学”:

- 先解决 “找不准小目标” 的问题 —— 以前算法用固定的 “参考点” 找目标,小目标容易被漏掉,DCFL 改成 “动态参考点”,能跟着小目标的位置调整,更精准地对准小目标的核心区域;

- 再解决 “样本选得差” 的问题 —— 分两步选样本:第一步 “粗选”,从多个图层里找足够多可能是小目标的候选样本,保证数量;第二步 “精选”,用数学模型(高斯混合模型)挑出质量高的样本,保证训得准;

- 还不用额外加计算量,训完后推理速度和原来一样快,能直接嵌到各种主流检测算法里。

最后,作者在 8 个不同数据集上测了 DCFL—— 不管是专门的小目标数据集(AI-TOD-R)、航拍大场景数据集(DOTA),还是普通照片数据集(COCO),DCFL 都能让小目标的检测 accuracy 涨不少,比如在 AI-TOD-R 上,把原来的算法 accuracy 提了 5 个百分点,还能兼顾大目标的检测效果,证明这个方法又好用又通用。

总结下来,这份文档干了三件事:做了个专门的小目标数据集,测了现有方法的问题,提了个能解决 “偏见” 的新方法,让找又小又歪的物体变得更准了。

code are available at https://chasel-tsui.github.io/AI-TOD-R/.

有向微小目标的外观信息有限,但在实际应用中却十分普遍,检测这类目标仍是一个复杂且尚未得到充分研究的问题。为此,本研究系统地提出了一个新的数据集、一套基准方案以及一种动态从粗到细的学习策略。我们提出的数据集 AI-TOD-R,是所有有向目标检测数据集中目标尺寸最小的。基于 AI-TOD-R,我们构建了一套涵盖多种检测范式的基准方案,包括全监督方法和标签高效型方法。通过研究发现,多种学习流程中均存在一种学习偏差:置信度高的目标会变得愈发置信,而脆弱的有向微小目标则会进一步被边缘化,这严重影响了其检测性能。为缓解该问题,我们提出了动态从粗到细学习(DCFL)策略,以实现无偏学习。DCFL 会动态更新先验位置,使其更贴合有向微小目标的有限区域,并以平衡不同目标形状样本数量与质量的方式分配样本,从而减轻先验设置和样本选择中的偏差。在 8 个具有挑战性的目标检测数据集上进行的大量实验表明,DCFL 实现了最先进的精度、较高的效率和出色的通用性。该数据集、基准方案及代码可在https://chasel-tsui.github.io/AI-TOD-R/获取。